Programa

Pra muita gente, modelos de linguagem grandes (LLMs) são usados principalmente como interfaces conversacionais. Você faz uma pergunta, o modelo responde e aí a interação acaba.

Mas os LLMs podem fazer mais: eles estão sendo colocados em sistemas que conseguem planejar, lembrar e agir sozinhos, criando o que chamamos de agentes LLM. Os sistemas agênicos estão ficando cada vez mais populares nas análises modernas e nos fluxos de trabalho empresariais.

Ao final deste artigo, você vai entender o que são agentes LLM, como eles são criados, os diferentes tipos de agentes e onde eles podem agregar valor.

Pra aproveitar ao máximo as informações deste artigo, combine-o com o Fundamentos de IA para atualizar seus conhecimentos sobre IA e LLMs no programa de atualização de conhecimentos.

O que é um agente LLM?

Vamos falar sobre como os agentes LLM são diferentes dos modelos de linguagem padrão.

Sua interface LLM normal, tipo um chatbot, só consegue receber comandos e mandar respostas geradas com base no seu treinamento, sem ações ou estado externos. Um agente LLM, por outro lado, usa um LLM como seu principal mecanismo de raciocínio (como um cérebro) e o envolve com componentes de apoio que permitem que ele raciocine, planeje e execute.

Os agentes LLM mudam o foco da automação para a autonomia.

A automação permite que os LLMs recebam entradas e sigam uma série de etapas para gerar uma saída. Com a autonomia, estamos dando ao LLM um conjunto de ferramentas e a capacidade de decidir a melhor forma de chegar a uma solução com base no que ele sabe sobre a situação. Isso dá mais flexibilidade e complexidade para o LLM agir de forma “independente”.

Pense em um LLM simples como um consultor especialista que responde a perguntas com base em seu conhecimento. Um agente LLM é como aquele especialista que lidera uma equipe: ele decide quais perguntas fazer, quais membros da equipe (ferramentas) consultar e como juntar as respostas deles para chegar a uma solução.

Componentes principais de um agente LLM

Um agente LLM tem vários componentes principais:

- O próprio LLM (o cérebro)

- Lógica de planejamento

- Memória

- Ferramentas

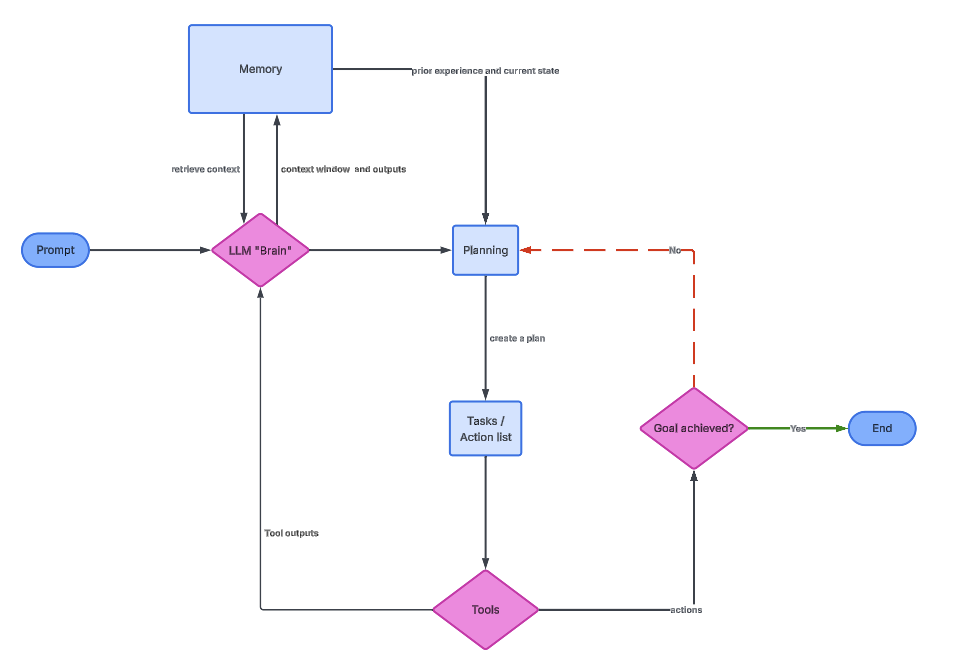

O gráfico a seguir mostra como cada um deles se relaciona.

O Cérebro LLM

O LLM é tipo o cérebro do agente. Ele entende o que o usuário quer, pensa nas etapas do meio e decide o que fazer. Na prática, o LLM é chamado várias vezes, não só uma vez.

Cada vez que o LLM é chamado, ele recebe um contexto que pode incluir a meta original, ações anteriores, resultados de ferramentas e memórias relevantes. Com base nessas informações, ele decide a próxima ação. Isso faz com que o LLM funcione mais como um controlador do que como um gerador de texto estático.

Para quem trabalha com dados, é importante entender que o LLM não executa diretamente códigos ou consultas. Ele gera instruções organizadas que outros componentes entendem. A qualidade de um agente geralmente depende de como essas instruções são restritas e validadas.

Lógica de planejamento

A lógica de planejamento é o jeito que permite que os agentes resolvam problemas complicados, dividindo-os em etapas mais fáceis de lidar. Sem planejamento, um agente tentaria resolver tudo em uma única resposta, o que muitas vezes leva a erros ou alucinações.

Na fase de planejamento, o agente divide um objetivo geral em tarefas menores. Por exemplo, “Analisar a rotatividade de clientes” pode virar “carregar dados de clientes”, “calcular a taxa de rotatividade”, “identificar tendências” e “resumir as conclusões”. Cada subtarefa é então executada sequencialmente ou condicionalmente.

Uma técnica popular é a Cadeia de Pensamento (CoT), que incentiva o modelo a raciocinar explicitamente, encadeando uma série de ações como prompts sequenciais.

O ReAct (raciocínio e ação) vai ainda mais longe e mistura traços de raciocínio com ações chamadas por ferramentas e observações externas. Esse feedback externo ajuda os agentes a manterem os pés no chão e a se corrigirem quando os resultados intermediários não correspondem às expectativas.

Memória

A memória permite que um agente mantenha a continuidade entre interações e ações, reutilizando informações anteriores. Sem memória, cada passo seria isolado, fazendo com que o agente tivesse que redescobrir o mesmo conhecimento várias vezes.

A memória de curto prazo geralmente fica na janela de contexto do LLM. Inclui mensagens recentes, raciocínio intermediário e resultados das ferramentas. Assim como a RAM na arquitetura dos computadores, essa memória é rápida, mas limitada, e some quando o contexto é ultrapassado.

A memória de longo prazo é implementada externamente, muitas vezes usando bancos de dados vetoriais. Técnicas como RAG (Retrieval-Augmented Generation) permitem que o agente recupere documentos relevantes ou interações anteriores e os insira no contexto atual.

Ferramentas

As ferramentas ampliam as capacidades de um agente além da linguagem. Eles permitem que o agente interaja com o mundo real, incluindo bancos de dados, APIs e mecanismos de computação.

Do ponto de vista do agente, as ferramentas são funções chamáveis com entradas e saídas definidas. O LLM decide quando usar uma ferramenta, quais argumentos fornecer e como interpretar o resultado. Essa tomada de decisão é o que diferencia os agentes dos fluxos de trabalho programados.

As ferramentas podem incluir recursos como pesquisas no Google, execução de SQL, interpretadores Python e APIs. O agente tem acesso às mesmas ferramentas tecnológicas que nós e pode juntá-las para criar soluções.

A imagem acima mostra a arquitetura geral do agente LLM. O Cérebro fornece informações de memória e planejamento, que então iniciam uma série de tarefas usando ferramentas.

Tipos de agentes LLM

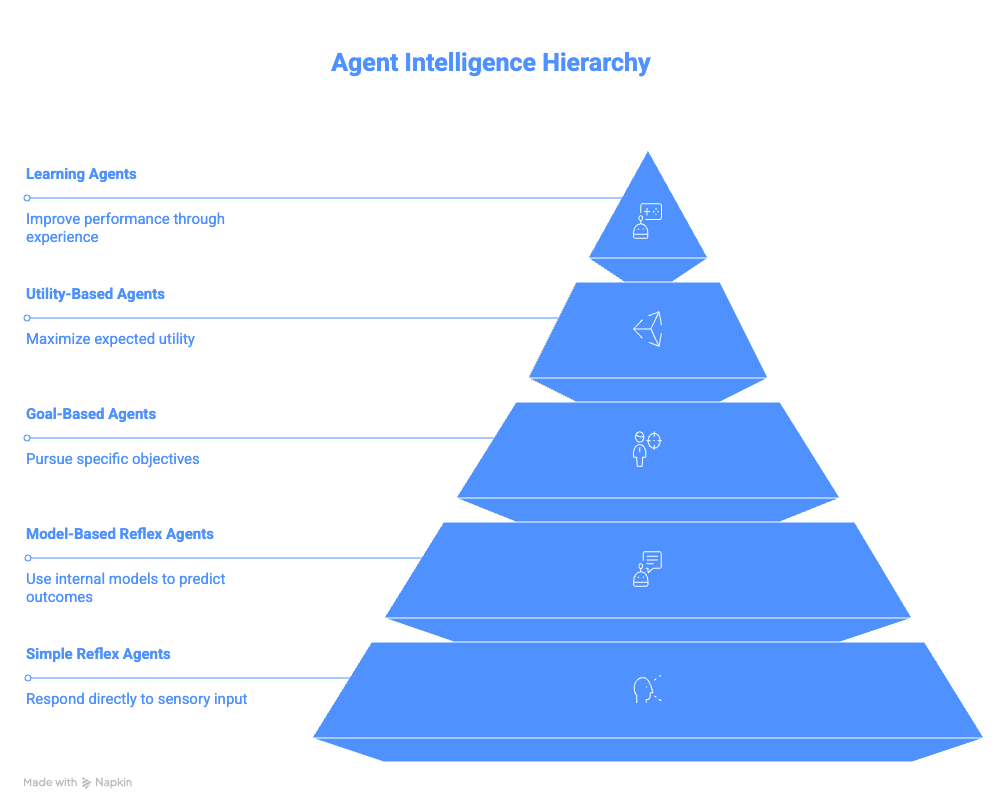

Essa seção resume as diferentes categorias de agentes, desde os agentes reflexos mais básicos até os agentes de aprendizagem complexos.

Agentes Reflexos Simples

Os agentes reflexos simples funcionam com regras diretas de condição-ação. Eles não pensam na história, nas consequências futuras ou em outras opções. Se uma condição for atendida, a ação correspondente é executada imediatamente.

Essa simplicidade faz com que sejam fáceis de implementar, mas são super frágeis. Qualquer entrada inesperada ou sinal ausente pode causar um comportamento incorreto. Eles também não conseguem se adaptar a ambientes em mudança.

O exemplo do bot de cancelamento de inscrição por e-mail mostra bem essa limitação. Ele faz o que precisa ser feito rapidinho, mas não tem muita consciência, o que pode levar a resultados indesejáveis.

Agentes reflexivos baseados em modelos

Os agentes reflexos baseados em modelos são melhores que os agentes reflexos simples porque mantêm uma representação interna do ambiente. Esse modelo interno permite que eles raciocinem sobre coisas que não são visíveis imediatamente.

Ao acompanhar um estado ao longo do tempo, esses agentes podem lidar com observabilidade parcial. Eles lembram do que já aconteceu e usam essas informações para orientar ações futuras.

Assistentes IDE como Copilot ou Cursor AI são ótimos exemplos. Eles ficam ligados nos arquivos, variáveis e funções durante uma sessão, o que permite sugestões mais inteligentes do que só comparar padrões. Eles também fazem a ponte para a próxima categoria de agentes.

Agentes baseados em objetivos

Os agentes baseados em metas são projetados em torno de resultados, e não de gatilhos. Eles planejam e avaliam as ações com base no quanto elas aproximam o sistema de um objetivo desejado, em vez de serem puramente reativas.

Esses agentes criam planos que podem envolver várias etapas e ramificações condicionais. Se uma abordagem não der certo, eles podem tentar um caminho alternativo. Isso faz com que eles sejam bem mais flexíveis do que os agentes baseados em reflexos.

Por exemplo, criar um itinerário de viagem mostra como uma única meta de alto nível pode ser dividida em várias ações coordenadas entre sistemas.

O agente não está só respondendo a um simples pedido de “me dê um itinerário” e repetindo informações. Em vez disso, pode dividir a meta em pequenos subproblemas, como:

- Como a gente viaja entre as cidades?

- Quais são os melhores restaurantes em cada cidade?

- Como podemos combinar diferentes atividades juntos?

O objetivo de criar um itinerário é alcançado combinando as soluções de cada um desses problemas.

Agentes baseados em utilidade

Os agentes baseados em utilidade ampliam os agentes baseados em objetivos ao introduzir a otimização. Em vez de só alcançar um objetivo, eles avaliam diferentes resultados usando uma “função de utilidade”.

Uma função de utilidade dá notas para os resultados com base em critérios como custo, tempo, risco ou preferência do usuário. O agente então escolhe a sequência de ações que maximiza a utilidade geral.

Essa abordagem é comum em sistemas de recomendação e problemas de otimização. Pode ser coisas como encontrar a melhor rota para um lugar, recomendar os produtos certos ou até mesmo fazer a melhor análise para mostrar a um usuário específico.

Agentes de Aprendizagem

Os agentes de aprendizagem são feitos pra melhorar seu comportamento com o tempo, sem precisar de uma reprogramação explícita.

A cada vez que faz algo, o agente recebe um feedback e usa essa informação para melhorar o seu desempenho. Eles funcionam em ambientes onde não se sabe de antemão qual é o comportamento ideal e não precisam ser reprogramados explicitamente para cada situação nova.

Existem dois componentes principais: um “Crítico” e um “Elemento de Aprendizagem”. O “crítico” avalia os resultados e dá feedback. O “Elemento de Aprendizagem” usa esse feedback para ajustar decisões futuras. Com o tempo, o agente fica mais alinhado com as preferências do usuário ou com as limitações do ambiente.

Por exemplo, imagine um agente LLM que resume as notícias diárias para você. Ele pode observar o seu comportamento e se adaptar às suas preferências. Se o agente perceber que você raramente abre resumos de “Esportes”, mas tem interesse em “Comida e Bebida”, ele pode parar de fornecer resumos de esportes e, em vez disso, focar no seu interesse por cozinhas ou restaurantes específicos.

Resumo dos agentes LLM

A tabela a seguir mostra as diferençasentre os tipos de agentes LLM.

|

Agente |

Ideia central |

Memória |

Planejamento |

Aprendizagem |

Complexidade |

Exemplo |

|

Agente Reflexo Simples |

Mapeia diretamente uma condição para uma ação |

Não |

Nenhum |

Não |

Muito baixo |

Arquivar automaticamente os e-mails que têm a palavra “cancelar inscrição”. |

|

Agente Reflexivo Baseado em Modelo |

Mantém um modelo interno do ambiente |

Sim (rastreamento de estado) |

Mínimo |

Não |

Baixo |

O assistente IDE lembra as variáveis ou arquivos definidos antes numa sessão |

|

Agente baseado em objetivos |

Toma medidas para atingir um objetivo específico |

Sim |

Sim |

Não |

Médio |

Reservar voos, hotéis e transporte para uma viagem de negócios |

|

Agente baseado em utilidade |

Escolhe o melhor resultado com base nas preferências |

Sim |

Sim |

Não |

Médio a alto |

Agente de viagens otimizando custo x duração x conforto |

|

Agente de Aprendizagem |

Melhora o comportamento com base no feedback ao longo do tempo |

Sim |

Sim |

Sim |

Alto |

Agente de notícias que adapta o conteúdo com base nos padrões de engajamento do usuário |

Estruturas populares para a criação de agentes LLM

Essa seção apresenta estruturas comuns usadas para criar sistemas de agentes LLM.

LangChain

LangChain oferece uma estrutura modular para a criação de sistemas baseados em LLM. A ideia principal é que fluxos de trabalho complexos podem ser criados juntando componentes simples. Ele pega o desafio de se comunicar com diferentes LLMs e resume esse processo para o usuário por meio de objetos Python.

O conceito principal do LangChain é o de “cadeias”, que juntam prompts, modelos e analisadores em fluxos de trabalho que podem ser repetidos. Por exemplo, a ideia é que você pegue um PromptTemplate, que é alimentado ao LLM e processado por um OutputParser.

LCEL (LangChain Expression Language) oferece uma sintaxe declarativa que permite aos usuários usar pipes (|) para compor cadeias visualmente. Então, em vez dos fluxos de trabalho clássicos do Python, que exigem que você insira prompts explicitamente no seu modelo, você pode simplesmente escrever um chain = prompt | model o e deixar o LangChain cuidar do modelo.

Para funcionalidades mais complexas, o LangChain permite que os usuários adicionem ferramentas como a Wikipedia, Python REPLse Pesquisa do Google aos seus agentes.

LangGraph baseia-se na funcionalidade do LangChain e combina esses conceitos com a memória para oferecer suporte a arquiteturas de agentes com estado e nível de produção, com controle explícito sobre o fluxo de execução.

Além do LangGraph, o ecossistema do LangChain cresceu ainda mais para incluir maneiras de observar os agentes com mais facilidade (LangSmith) e até interfaces de arrastar e soltar (LangFlow).

LlamaIndex

O LlamaIndex é ótimo pra fluxos de trabalho focados em documentos, oferecendo OCR e análise super precisos pra mais de 90 tipos de arquivos não estruturados, com a opção de combinar com fluxos de trabalho com agentes pra recuperação e extração inteligentes.

Seus conectores de dados facilitam a ingestão de várias fontes, enquanto suas estruturas de indexação otimizam a recuperação. O VectorStoreIndex é a escolha mais comum para pesquisa semântica.

Os mecanismos de consulta organizam a recuperação e a geração, enquanto os roteadores fazem decisões tipo um agente, escolhendo a fonte de dados mais adequada para uma determinada consulta.

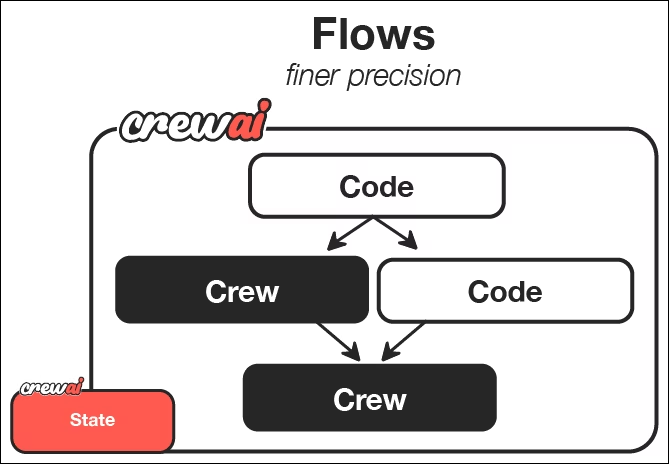

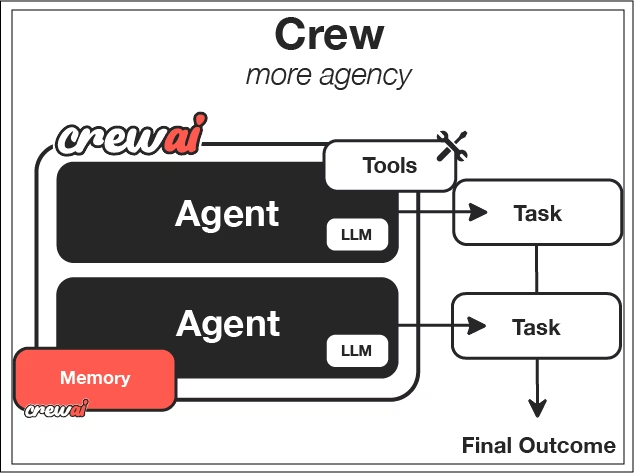

CrewAI

O CrewAI foi criado pra facilitar a colaboração. Em vez de um único agente, permite que vários agentes com funções distintas trabalhem juntos.

Ele se concentra na ideia de “Equipes”, que são um conjunto definido de agentes. Cada agente recebe uma personalidade, um objetivo e uma história, que moldam seu comportamento.

As tarefas definem o que precisa ser feito e o que é sucesso. Você define como será uma tarefa individual, fornece alguns parâmetros, o resultado esperado e quais agentes devem trabalhar nessa tarefa.

Os processos decidem como as tarefas são feitas: uma atrás da outra, de um jeito hierárquico ou usando padrões de orquestrador-trabalhador, onde um agente principal divide tarefas complexas de um jeito dinâmico, imitando equipes humanas.

Da documentação do CrewAI, dá pra ver que os fluxos são uma forma de organizar e acionar as equipes. Cada equipe usa agentes LLM com funções e tarefas definidas para fazer trabalhos específicos e criar os resultados desejados.

Escolhendo a estrutura certa

A escolha de uma estrutura depende do seu domínio de problemas e restrições. Cada uma das estruturas apresentadas tem seus próprios pontos fortes:

- LangChain: Oferece flexibilidade e controle com a melhor visibilidade de como cada ferramenta funciona.

- LlamaIndex: É ótimo pra fluxos de trabalho que giram em torno de documentos, onde analisar informações é super importante.

- CrewAI: É ótimo quando a colaboração e a divisão de funções são importantes, e você não está tão focado em como exatamente os agentes fazem o trabalho.

Pense na complexidade dos seus dados, no nível de autonomia necessário e nas limitações operacionais. Não existe uma escolha universalmente correta.

Para ajudar na sua decisão, você também pode dar uma olhada nos nossos artigos comparando o LangChain com o Llamaindex, respectivamente, CrewAI com LangGraph.

Casos de uso do agente LLM

Os casos de uso dos agentes LLM são basicamente infinitos e só limitados pela sua imaginação.

Assistentes de codificação

Os assistentes de codificação modernos usam fluxos de trabalho agenticos para planejar, executar e verificar as alterações. Eles podem dar uma olhada no código, criar soluções, fazer testes e corrigir erros de forma iterativa.

Por exemplo, Cursor se integra ao seu IDE de forma nativa e ajuda você a completar linhas ou corrigir alterações em pipelines com implicações a jusante. Claude Code pode te ajudar a escrever testes, criar scripts inteiros ou avaliar inconsistências no seu código em um repositório. A gente pode usar o GitHub Copilot pra ajudar a escrever pull requests e testar código como parte de um fluxo de trabalho de solicitação.

Isso muda o papel do desenvolvedor de escrever cada linha para supervisionar e orientar sistemas inteligentes. Para quem trabalha com dados, isso pode acelerar bastante a experimentação e a criação de protótipos.

Recomendo que você faça o curso Desenvolvimento de Software com GitHub Copilot se quiser começar a usar assistentes de codificação com tecnologia LLM.

Inteligência Empresarial

Os sistemas de BI agentic permitem que os usuários façam perguntas em linguagem natural e recebam insights úteis. O agente pode traduzir perguntas para SQL, fazer consultas e explicar os resultados.

Você pode conversar com seus dados como se estivesse falando com um membro sênior da equipe e obter novos insights e visualizações em tempo real. Isso reduz a dependência de painéis e permite análises exploratórias para membros da equipe sem conhecimentos técnicos.

Documentação e síntese de informações

Os agentes de pesquisa automatizam a coleta e a síntese de informações. Eles pesquisam na web, pegam fontes e resumem o que acham; alguns sistemas têm filtros básicos de qualidade das fontes. Eles podem até dar uma olhada na documentação interna hospedada em sites como o Notion ou nas mensagens do Slack.

Com acesso a todas essas fontes de informação, os agentes LLM podem não só sintetizar informações rapidamente, mas também gerar documentos completos e resumos para as equipes compartilharem informações rapidinho.

Isso é super importante em áreas que mudam rápido, onde os conjuntos de dados estáticos ficam obsoletos rapidinho. Os agentes fornecem informações atualizadas constantemente.

Pra mais ideias sobre como as pessoas estão usando os agentes de IA, dá uma olhada no nosso guia sobre os 10 principais projetos de agentes de IA.

Principais desafios nos fluxos de trabalho de agentes

Embora os fluxos de trabalho agenticos sejam incríveis e super poderosos, eles têm seus próprios desafios. Os agentes podem ter alucinações sobre etapas, interpretar mal os resultados das ferramentas ou entrar em loops longos ou indesejados. Barreiras de proteção, validação e observabilidade são essenciais para sistemas de produção.

Cada ação do agente geralmente precisa de uma chamada LLM. Tarefas complexas podem envolver dezenas de chamadas, aumentando a latência e os custos da API. Além disso, você pode estar pagando por infraestrutura extra, tipo armazenamento em nuvem, computação em nuvem e outros custos para dar suporte ao agente LLM.

Os sistemas autônomos são mais difíceis de depurar do que o código determinístico. Entender por que um agente tomou uma decisão requer rastrear o estado, a memória e as etapas do raciocínio.

Dependendo da estrutura de agente que você usa, isso pode ser bem complicado. Algumas estruturas, como a CrewAI, são bem mais complexas por causa de sua complexidade adicional em relação a uma estrutura mais simples como a LangChain, que foca em simplificar o acesso aos seus LLMs.

Conclusão

Estamos mudando de chatbots isolados para fluxos de trabalho totalmente autônomos que podem raciocinar, planejar e agir. Embora ainda seja cedo, esse paradigma já está mudando a forma como os sistemas de dados são criados e usados.

Para quem quer trabalhar com dados, aprender sobre agentes LLM hoje é uma grande vantagem para os trabalhos do futuro. Esses sistemas são o futuro da automação inteligente.

Comece a praticar e a construir esses agentes LLM com nosso Designing Agentic Systems with LangChain !

Perguntas frequentes sobre o LLM Agent

Os agentes LLM escrevem e executam código por conta própria?

Os agentes LLM não executam código por conta própria. Eles decidem quando chamar ferramentas, como interpretadores Python, mecanismos SQL ou ambientes de execução em sandbox, que então executam o código e devolvem os resultados ao agente.

Quais são os principais componentes de um agente LLM?

Os componentes principais são o cérebro LLM, a lógica de planejamento, a memória e as ferramentas. Esses componentes trabalham juntos em um ciclo de feedback para permitir um comportamento autônomo.

Que tipos de agentes LLM são mais usados hoje em dia?

A maioria dos sistemas de produção usa agentes baseados em objetivos ou utilidade porque eles equilibram autonomia e controle. Os agentes de aprendizagem estão surgindo, mas são mais difíceis de implementar com segurança em grande escala.

Quais são os maiores desafios com os agentes LLM?

Os principais desafios incluem questões de confiabilidade, como alucinações, maior latência, aumento dos custos devido a múltiplas chamadas de modelo, bem como maior complexidade de depuração em comparação com o software tradicional.

Qual é a diferença entre um agente LLM e um chatbot?

Um chatbot responde a uma única pergunta e foca em um único objetivo. Um agente LLM pode dividir uma meta em etapas, agir usando ferramentas, ver os resultados e ajustar seu comportamento até que a tarefa seja concluída.

Sou um cientista de dados com experiência em análise espacial, machine learning e pipelines de dados. Trabalhei com GCP, Hadoop, Hive, Snowflake, Airflow e outros processos de engenharia/ciência de dados.