Lernpfad

Durch Bauprojekte zu lernen ist der beste Weg, um dein Verständnis und deine praktischen Fähigkeiten im Bereich der großen Sprachmodelle (LLMs) und der KI zu verbessern. Durch die Arbeit an Projekten lernst du neue Tools, Techniken und Modelle kennen, mit denen du deine Anwendungen optimieren und supergenaue und schnelle KI-Anwendungen entwickeln kannst.

Die Fehlerbehebung bei diesen Projekten bringt dir wertvolle Erfahrungen, verbessert deine Chancen, deinen Traumjob zu bekommen, und ermöglicht es dir, durch die Monetarisierung deiner Projekte und die Entwicklung eines marktfähigen Produkts zusätzliches Geld zu verdienen.

In diesem Blog schauen wir uns LLM-Projekte an, die für Anfänger, Fortgeschrittene, Studenten im letzten Studienjahr und Experten gemacht sind. Jedes Projekt hat einen Leitfaden und Quellenmaterial, damit man die Ergebnisse anschauen und nachmachen kann.

Wenn du dich noch nicht mit LLMs auskennst, mach bitte den Kurs „Grundlagen der KI“ durch den Lernpfad, bevor du mit dem unten genannten Projekt anfängst. So bekommst du nützliches Wissen zu beliebten KI-Themen wie chatGPT, großen Sprachmodellen, generativer KI und mehr.

Willst du mit generativer KI beginnen?

Lerne, wie du mit LLMs in Python direkt in deinem Browser arbeiten kannst

LLMs-Projekte für Leute, die gerade anfangen

In den Projekten für Anfänger lernst du, wie du die OpenAI-API benutzt, Antworten erstellst, KI-Assistenten mit multimodalen Funktionen entwickelst und API-Endpunkte deiner Anwendung mit FastAPI bereitstellst.

Was du schon können solltest: Ein grundlegendes Verständnis von Python ist wichtig.

1. Einen Sprachlehrer mit Langflow erstellen

Projekt-Link: Langflow: Ein Leitfaden mit Demo-Projekt

Für viele Anfänger ist das Schreiben von kompliziertem Python-Code von Grund auf die größte Hürde beim Entwickeln von KI-Apps. Langflow macht das anders, indem es dir ermöglicht, leistungsstarke KI-Workflows über eine visuelle Drag-and-Drop-Oberfläche zu erstellen, die sich einfach mit Standarddatenbanken verbinden lässt.

In diesem Projekt baust du eine Sprachlern-App, ohne dass du ein Programmierprofi sein musst. Du wirst Langflow nutzen, um einen Agenten zu entwerfen, der Lesetexte basierend auf der Vokabelliste eines Benutzers (gespeichert in einer Postgres-Datenbank) generiert. Das ist eine super Einführung in „zustandsbehaftete“ KI (Apps, die sich deine Daten merken), ohne dass man sich mit komplizierter Technik rumschlagen muss.

Quelle: Langflow: Ein Leitfaden mit Demo-Projekt

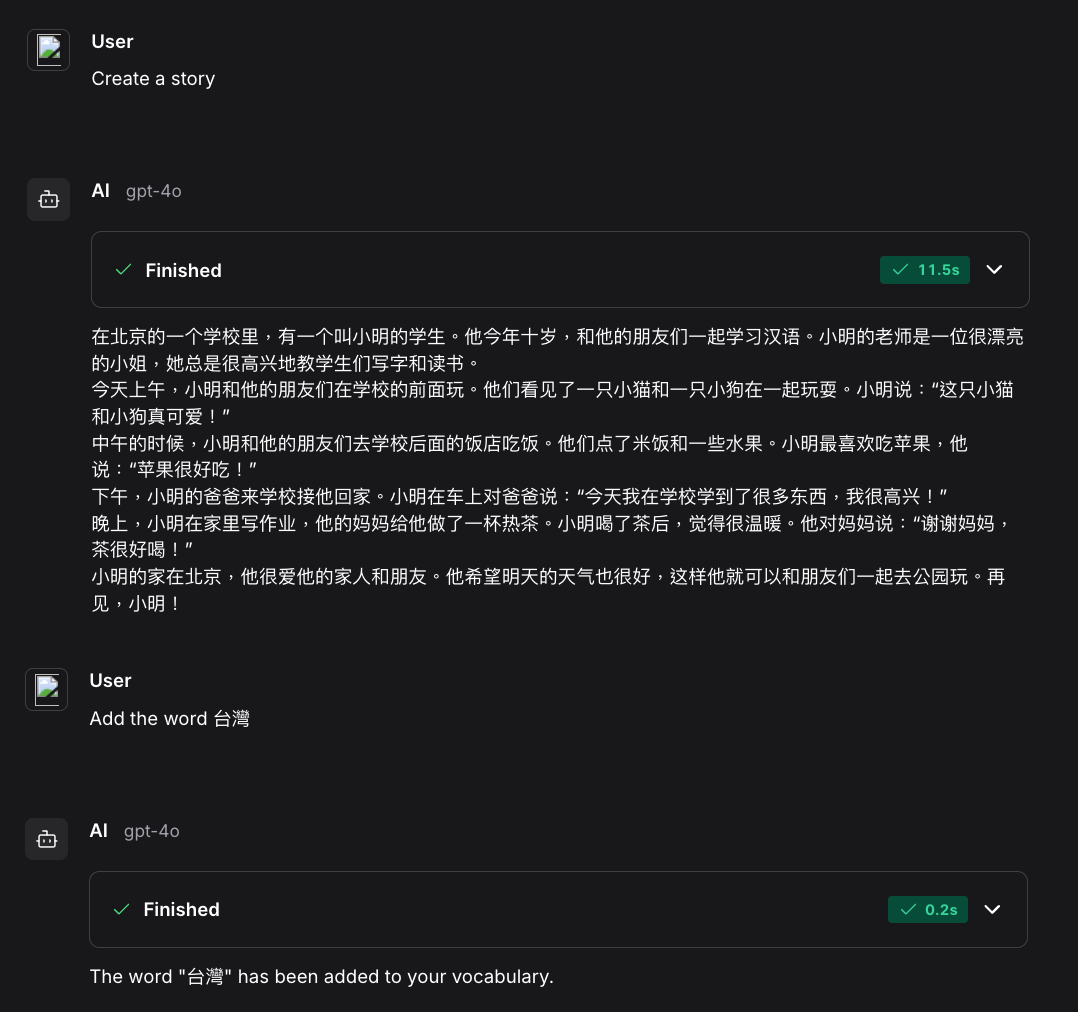

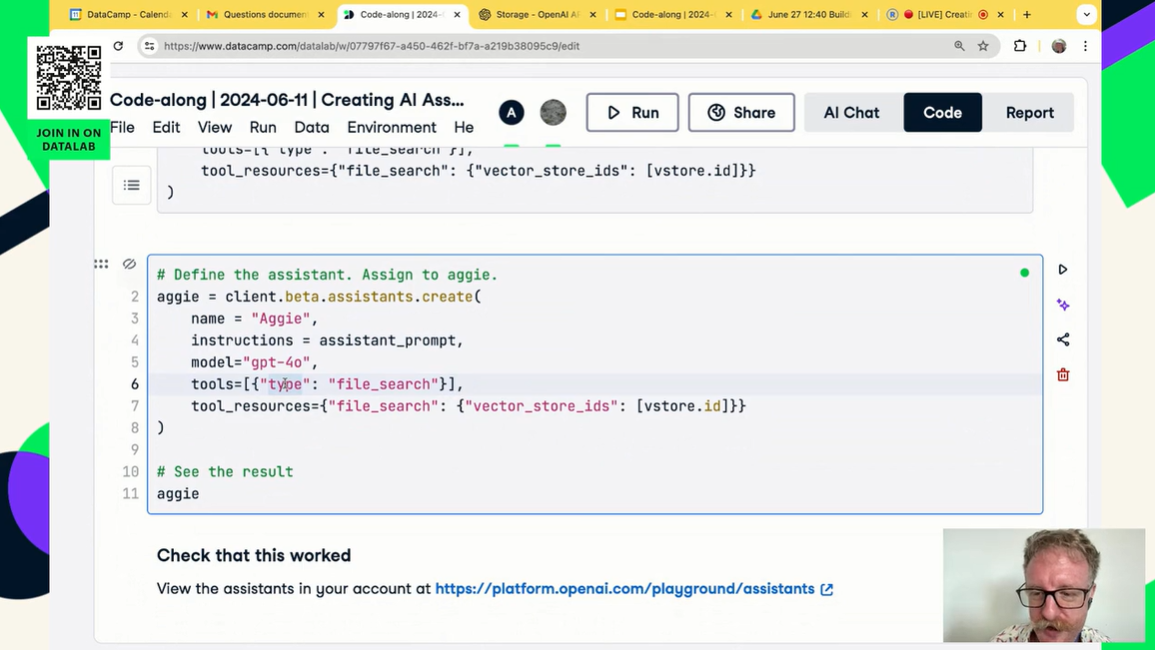

2. Entwicklung eines KI-Assistenten für die Datenwissenschaft mit multimodalen Fähigkeiten

Projekt-Link: KI-Assistenten mit GPT-4o erstellen

In diesem Projekt baust du deinen eigenen KI-Assistenten, ähnlich wie chatGPT. Du lernst, wie du mit der OpenAI-API und GPT-4o einen speziellen KI-Assistenten für Data-Science-Aufgaben erstellen kannst. Dazu gehören das Bereitstellen von benutzerdefinierten Anweisungen, das Bearbeiten von Dateien und Daten sowie die Nutzung multimodaler Funktionen.

Das Coole daran ist, dass du für das ganze Projekt nur die verschiedenen Funktionen der OpenAI Python API verstehen musst. Mit ein paar Zeilen Code kannst du deine eigene automatisierte KI erstellen, die die Daten für dich verarbeitet und dir die Analyse präsentiert.

Quelle: KI-Assistenten mit GPT-4o erstellen

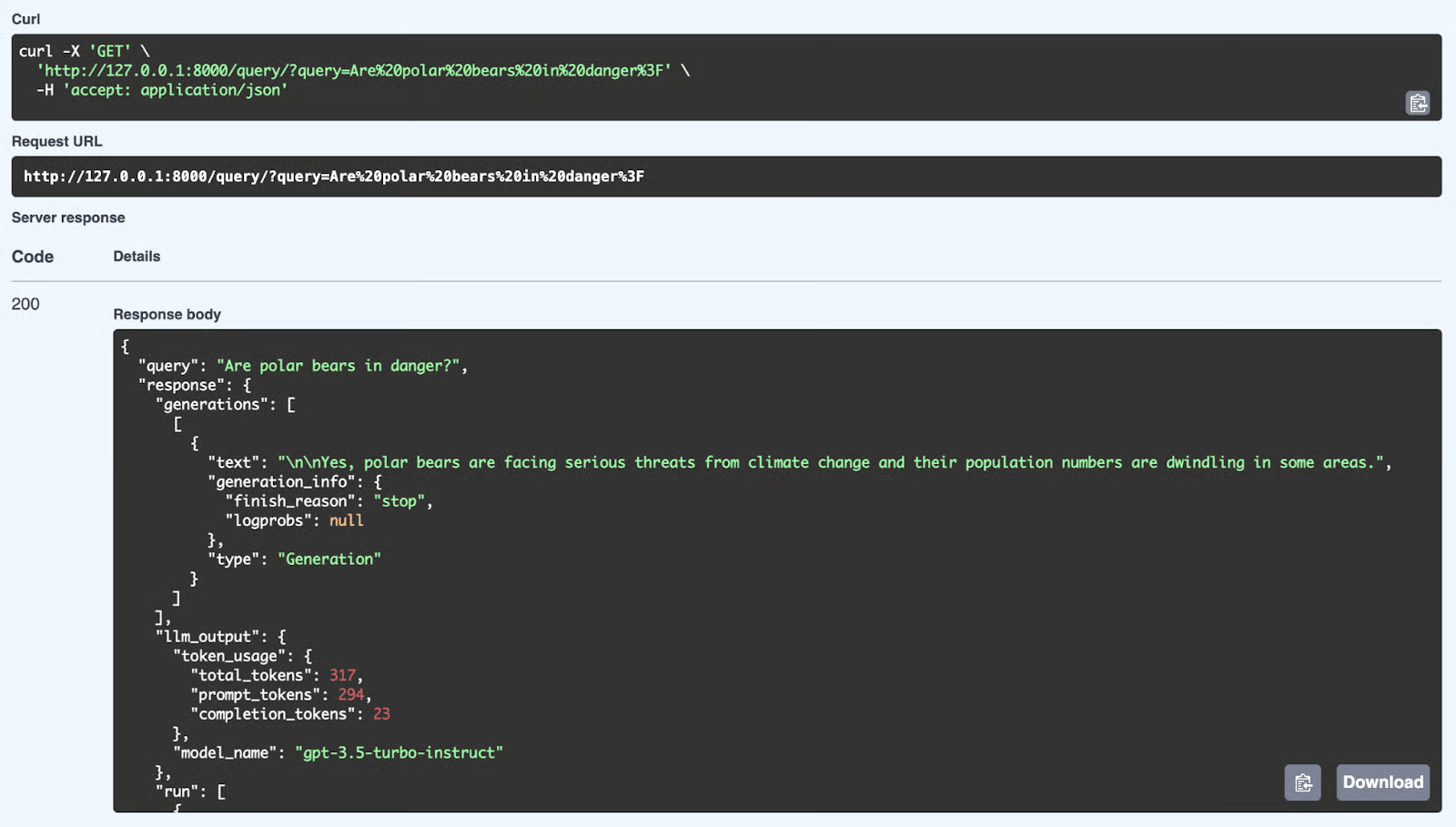

3. Bereitstellung einer LLM-Anwendung als API-Endpunkt mit FastAPI

Projekt-Link: Bereitstellung einer LLM-Anwendung als API-Endpunkt mit FastAPI in Python

Was machst du als Nächstes, nachdem du deine App mit der OpenAI-API erstellt hast? Du wirst es auf einem Server bereitstellen und starten. Das heißt, du musst eine REST-API-App machen, die jeder nutzen kann, um deine KI-App in seine Systeme einzubauen.

In diesem Projekt lernst du FastAPI kennen und erfährst, wie man KI-Anwendungen erstellt und bereitstellt. Du lernst auch, wie die API funktioniert und wie du sie lokal testen kannst.

Quelle: Bereitstellung einer LLM-Anwendung als API-Endpunkt mit FastAPI in Python

LLM-Projekte für Fortgeschrittene

In den LLM-Projekten für Fortgeschrittene lernst du, verschiedene LLM-APIs wie Groq, OpenAI und Cohere mit Frameworks wie LlamaIndex und LangChain zu verbinden. Du lernst, kontextbezogene Anwendungen zu erstellen und mehrere externe Quellen zu verbinden, um super relevante und genaue Antworten zu generieren.

Was du schon können solltest: Erfahrung mit Python und ein Verständnis dafür, wie KI-Agenten funktionieren.

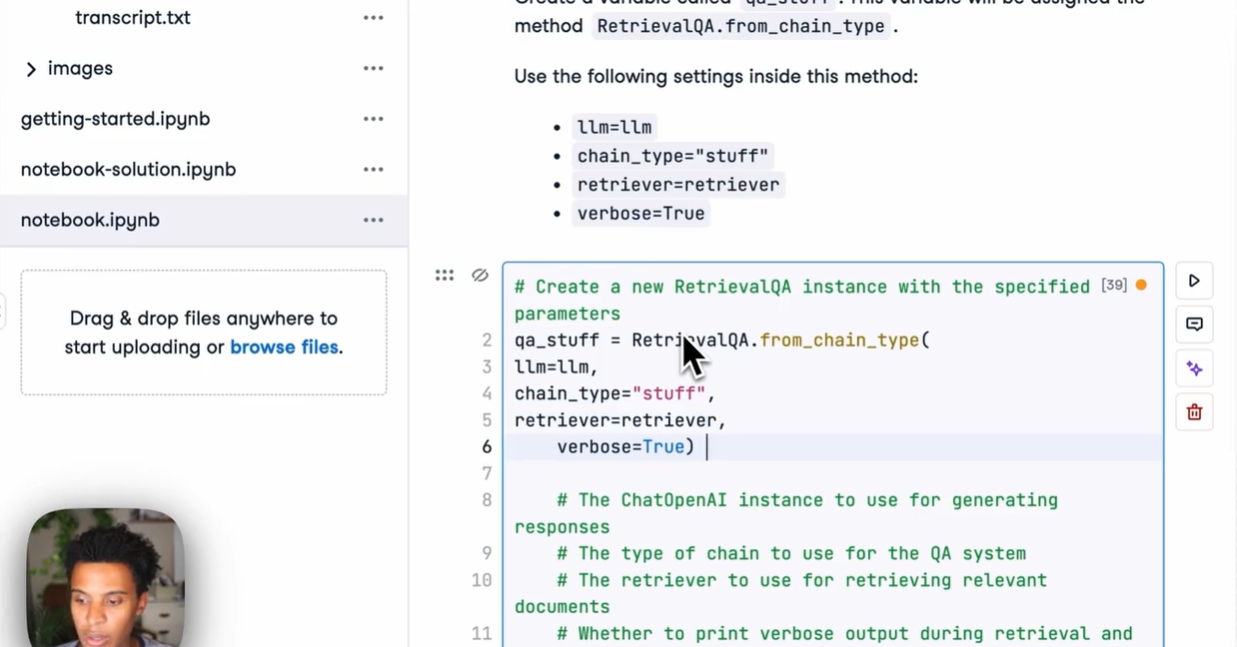

4. Ein RAG-System mit FastAPI aufbauen und bereitstellen

Projekt-Link: Ein RAG-System mit LangChain und FastAPI aufbauen: Von der Entwicklung bis zur Produktion

Ein RAG-Skript in einem Notebook zu erstellen, ist ein guter Anfang, aber echte KI muss eingesetzt werden. Damit deine Anwendung für Benutzer oder andere Software zugänglich ist, musst du sie in eine leistungsstarke Web-API einbinden.

In diesem Projekt schaffst du die Brücke zwischen Datenwissenschaft und Webentwicklung. Du wirst LangChain nutzen, um die Logik zum Abrufen von Dokumentdaten zu erstellen, und FastAPI, um diese Logik als REST-Endpunkt bereitzustellen. Du lernst, wie du API-Anfragen bearbeitest, Dokumente verarbeitest und ein produktionsreifes Backend für deine KI-Anwendung bereitstellst.

Quelle: Ein RAG-System mit LangChain und FastAPI aufbauen

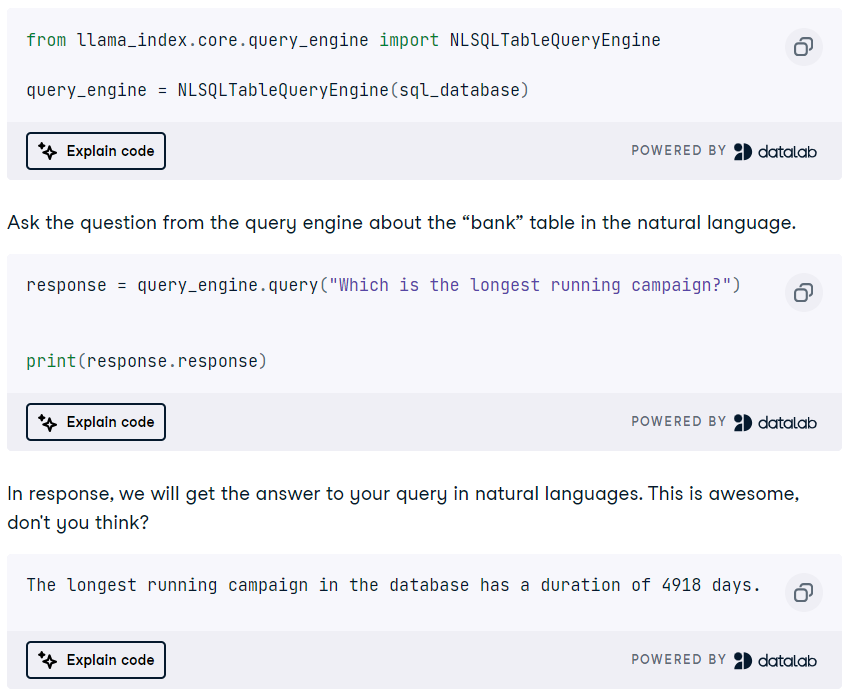

5. Entwickle eine DuckDB-SQL-Abfrage-Engine mit einem LLM

Projekt-Link: DuckDB Tutorial: KI-Projekte aufbauen

DuckDB ist ein modernes, leistungsstarkes In-Memory-Analyse-Datenbankmanagementsystem (DBMS), das als Vektorspeicher und SQL-Abfrage-Engine genutzt werden kann.

In diesem Projekt lernst du das LlamaIndex-Framework kennen, um eine RAG-Anwendung mit DuckDB als Vektorspeicher zu erstellen. Außerdem wirst du eine DuckDB-SQL-Abfrage-Engine entwickeln, die natürliche Sprache in SQL-Abfragen umwandelt und Antworten generiert, die als Kontext für die Eingabeaufforderung genutzt werden können. Das ist ein cooles Projekt, bei dem du eine Menge über die Funktionen und Agenten von LlamaIndex lernen wirst.

Quelle: DuckDB Tutorial: KI-Projekte aufbauen

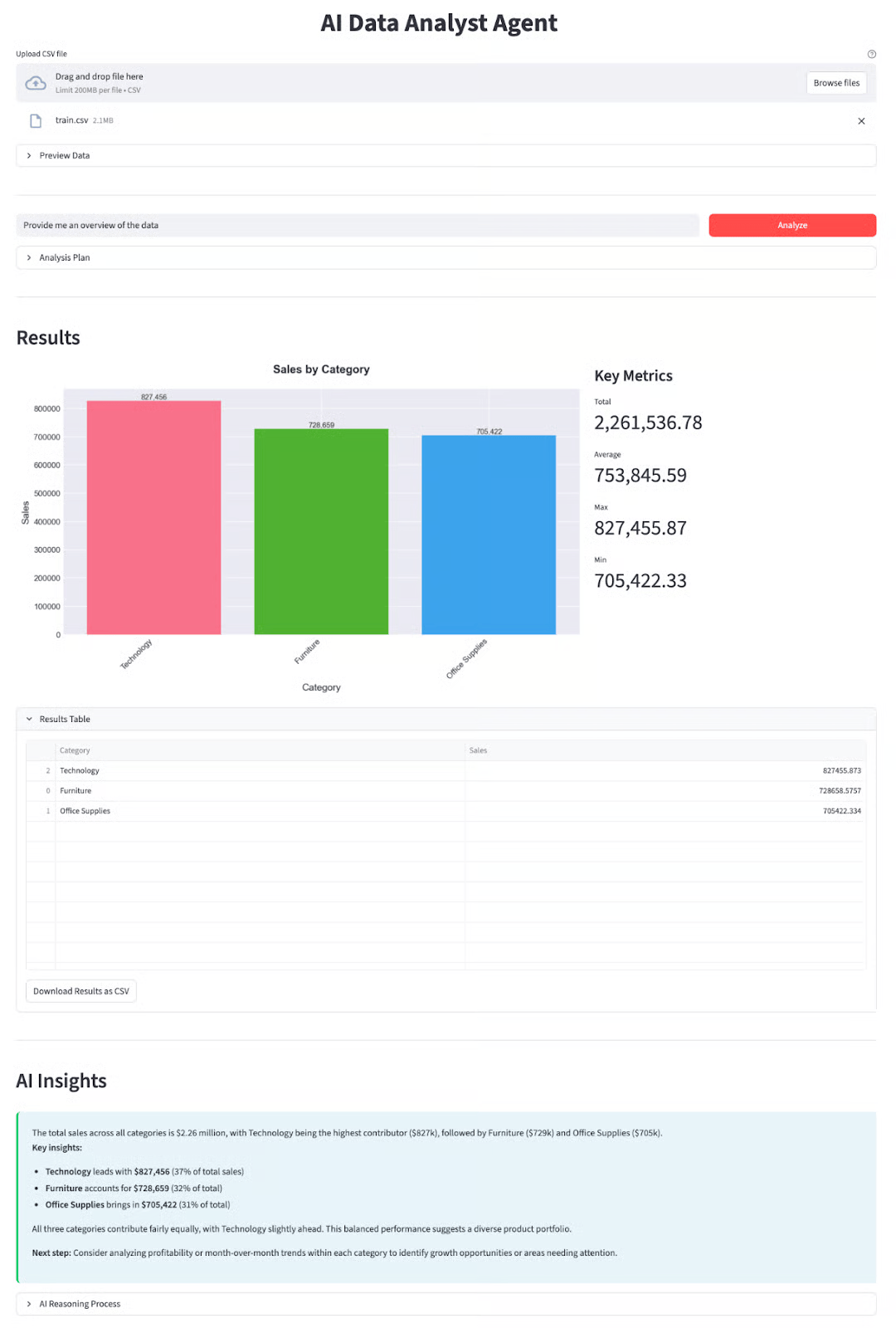

6. Entwicklung eines autonomen Datenanalysten mit DeepSeek-V3.2

Projekt-Link: DeepSeek-V3.2-Spezial-Tutorial: Erstell einen Datenanalysten-Agenten

Die Modelle von DeepSeek sind bekannt für ihre Denkfähigkeiten, was sie super für komplizierte Aufgaben wie Data Science macht. Dieses Projekt geht über einfache Chats hinaus und konzentriert sich auf „agente“ Arbeitsabläufe, bei denen die KI aktiv Tools einsetzt, um Probleme zu lösen.

In diesem Projekt baust du einen funktionierenden Datenanalyse-Agenten, der Datensätze erfassen, Python-Code schreiben und ausführen sowie automatisch Erkenntnisse generieren kann. Du lernst, wie du das DeepSeek-V3.2-Speciale-Modell nutzen kannst, um mehrstufige Analyseaufgaben zu organisieren – eine wichtige Fähigkeit für die nächste Generation der KI-Entwicklung.

Quelle: DeepSeek-V3.2-Spezial-Tutorial: Erstell einen Datenanalysten-Agenten

LLM-Projekte für Studierende im letzten Studienjahr

Studierende im letzten Studienjahr können richtige LLM-Bewerbungen machen. Deshalb braucht man für die meisten Projekte, die hier erwähnt werden, Kenntnisse über Feinabstimmung, LLM-Architekturen, multimodale Anwendungen, KI-Agenten und schließlich auch über die Bereitstellung der Anwendung auf einem Server.

Was du schon können solltest: Gutes Verständnis von Python, LLMs, KI-Agenten und Modelloptimierung.

7. Entwickle multimodale KI-Anwendungen mit LangChain und der OpenAI-API

Projekt-Link: Entwickle multimodale KI-Apps mit LangChain und der OpenAI-API

Generative KI macht es einfach, über die reine Arbeit mit Text hinauszugehen. Wir können jetzt die Power von Text- und Audio-KI-Modellen kombinieren, um einen Bot zu entwickeln, der Fragen zu YouTube-Videos beantwortet.

In diesem Projekt lernst du, wie du YouTube-Videoinhalte mit der Sprach-zu-Text-KI Whisper transkribierst und dann mit GPT Fragen zu den Inhalten stellst. Du lernst auch LangChain und verschiedene OpenAI-Funktionen kennen.

Das Projekt hat einen Video-Guide und Code-Along-Sessions, damit du die Anwendung zusammen mit dem Kursleiter nachbauen kannst.

Mach die Entwickeln von LLM-Anwendungen mit LangChain , um mehr über die Funktionen durch interaktive Übungen, Folien, Quizfragen, Video-Tutorials und Bewertungsfragen zu erfahren.

Quelle: Entwickle multimodale KI-Apps mit LangChain und der OpenAI-API

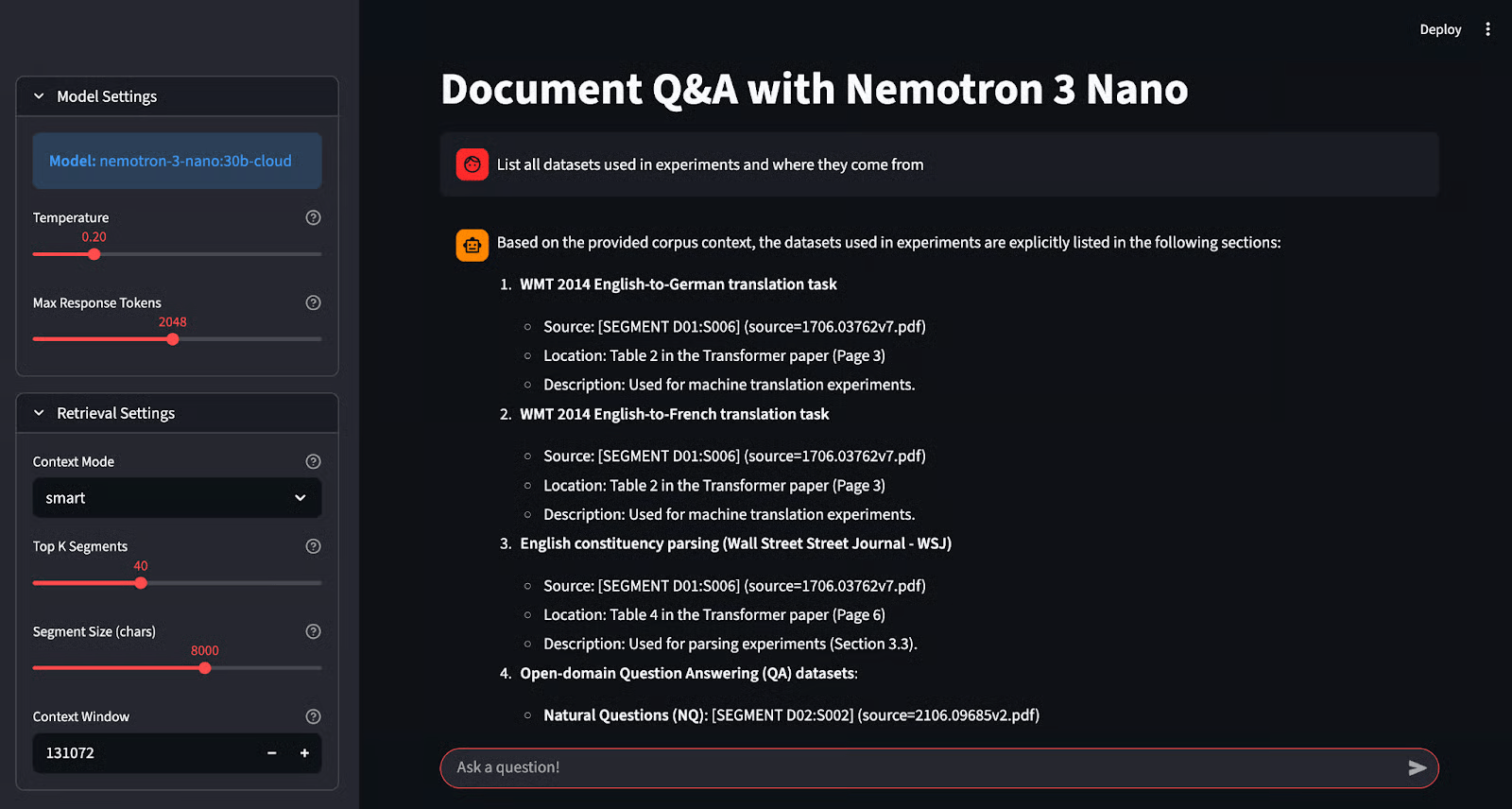

8. Entwickle eine solide Q&A-App mit NVIDIA Nemotron und Ollama

Projekt-Link: NVIDIA Nemotron 3 Nano Tutorial: Fundierte Fragen und Antworten mit Ollama

Modelle lokal zu nutzen ist super für die Privatsphäre, aber bei kleineren Modellen kann es schwierig sein, die Genauigkeit zu halten. NVIDIAs Nemotron-3-Nano wurde extra dafür entwickelt, dieses Problem zu lösen, indem es super bei der „fundierten“ Generierung ist, was bedeutet, dass die Antworten streng auf den angegebenen Fakten basieren.

In diesem Projekt lernst du, wie du dieses spezielle Modell mit Ollama einsetzt und mit Streamlit eine „Grounded Q&A”-Anwendung entwickelst. Anders als normale Chatbots gibt dieses System seine Quellen an, sodass du jede Antwort nachprüfen kannst. Du sammelst praktische Erfahrungen mit lokaler Inferenz, Halluzinationsprävention und dem Aufbau vertrauenswürdiger KI-Schnittstellen.

Quelle: NVIDIA Nemotron 3 Nano Tutorial: Fundierte Fragen und Antworten mit Ollama

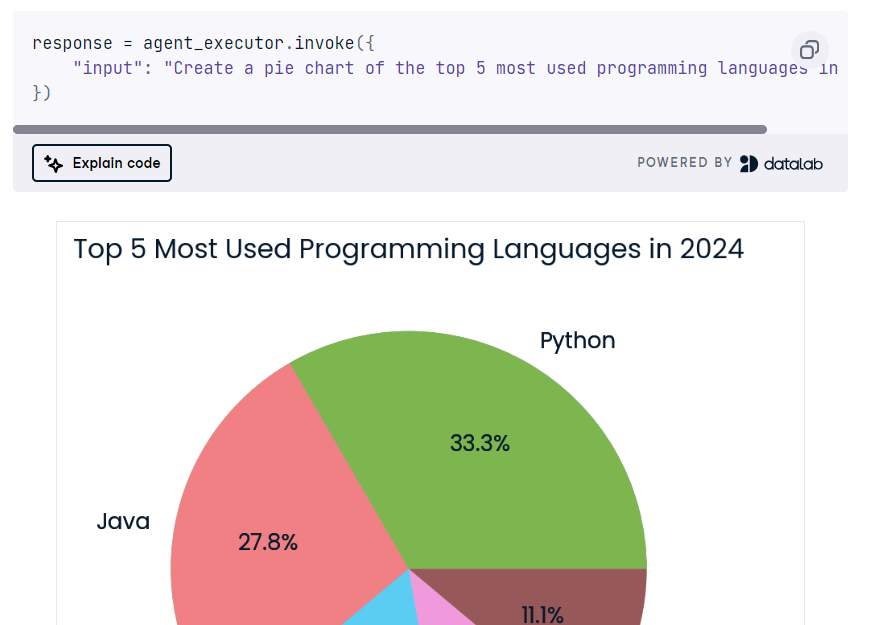

9. Entwickle einen mehrstufigen KI-Agenten mit LangChain und der Cohere-API

Projekt-Link: Cohere Command R+: Eine komplette Schritt-für-Schritt-Anleitung

Die Cohere-API ist ähnlich wie die OpenAI-API und hat im Vergleich zu anderen LLM-Frameworks viele coole Funktionen. In diesem Projekt lernst du die wichtigsten Funktionen der Cohere-API kennen und baust damit einen mehrstufigen KI-Agenten.

Du wirst auch das LangChain-Framework und das Verknüpfen verschiedener KI-Agenten meistern.

Am Ende wirst du eine KI-App entwickeln, die die Suchanfragen der Nutzer nutzt, um das Internet zu durchsuchen und Python-Code zu erstellen. Dann wird Python REPL benutzt, um den Code auszuführen und die vom Benutzer gewünschte Visualisierung zurückzugeben.

Quelle: Cohere Command R+: Eine komplette Schritt-für-Schritt-Anleitung

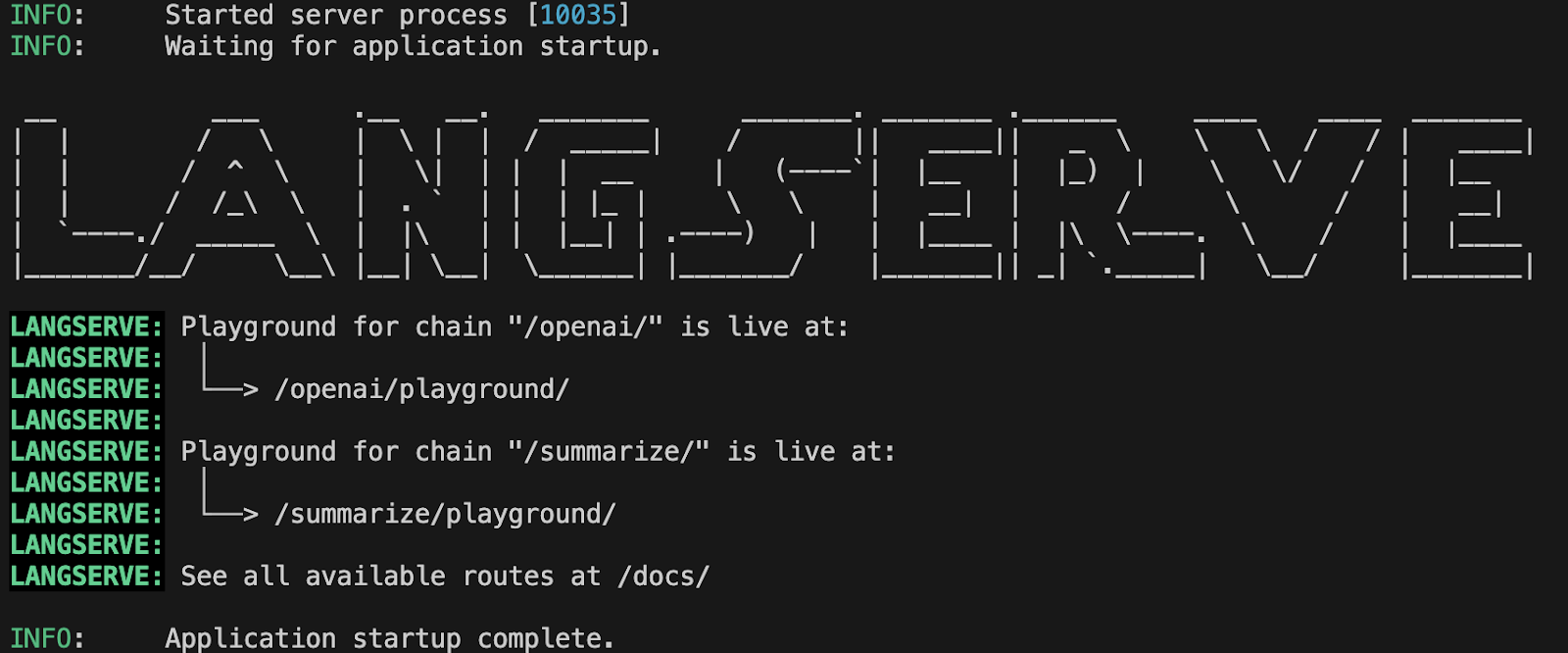

10. LLM-Anwendungen mit LangServe einsetzen

Projekt-Link: LLM-Anwendungen mit LangServe einsetzen

In diesem Projekt lernst du, wie du LLM-Anwendungen mit LangServe einsetzt. Du fängst damit an, LangServe einzurichten, einen Server mit FastAPI zu erstellen, den Server lokal zu testen und dann die Anwendung bereitzustellen. Du lernst auch, wie du die Leistung von LLM mit dem Prometheus-Framework überwachen und dann mit Grafanadie Modellleistung im Dashboard visualisierenkannst.

Es gibt viel zu lernen, und es wird dir helfen, einen Job im Bereich LLMOps zu finden, wo die Nachfrage immer größer wird.

Quelle: LLM-Anwendungen mit LangServe einsetzen

Fortgeschrittene LLMs-Projekte

Die fortgeschrittenen LLM-Projekte sind für Leute gedacht, die produktionsreife Anwendungen entwickeln und bereits eingesetzte LLM-Anwendungen verbessern wollen. Durch die Arbeit an diesen Projekten lernst du, auf TPUs statt auf GPUs zu inferieren und zu optimieren, um eine schnellere Leistung zu erzielen, die Generierung von Taxonomien und die Textklassifizierung zu automatisieren und KI-Anwendungen in der Microsoft Azure Cloud zu erstellen.

Was du schon können solltest: Gutes Verständnis von Python, LLMs, Modell-Feinabstimmung, TPUs und Cloud Computing.

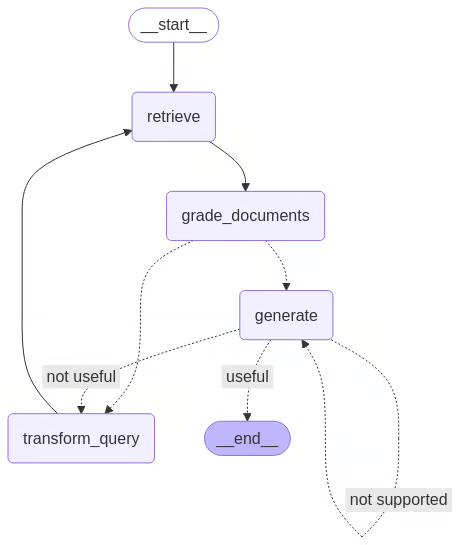

11. Entwicklung eines selbstkorrigierenden RAG-Agenten mit LangGraph

Projekt-Link: Self-Rag: Ein Leitfaden zur Implementierung von LangGraph

Herkömmliche RAG-Systeme versagen oft komplett, wenn sie irrelevante Daten abrufen. „Self-RAG” löst das Problem durch eine Kritikschleife: Das Modell checkt die selbst gefundenen Dokumente und die generierten Antworten und lehnt sie ab oder macht sie neu, wenn sie nicht gut genug sind.

In diesem Projekt wirst du mit LangGraph von linearen Ketten zu zyklischen Agenten übergehen. Du wirst einen ausgeklügelten Kontrollablauf einrichten, bei dem die KI ihre eigene Arbeit aktiv auf Relevanz und Halluzinationen überprüft. Diese Architektur ist echt top, wenn's darum geht, zuverlässige, autonome KI-Systeme zu bauen.

Quelle: Self-Rag: Ein Leitfaden zur Implementierung von LangGraph

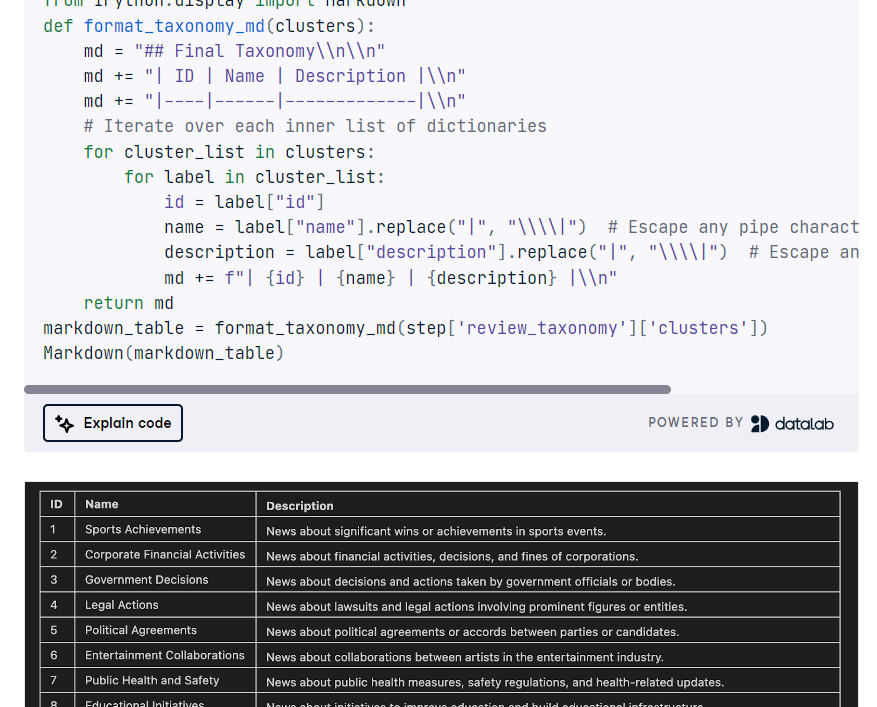

12. Entwicklung einer TNT-LLM-Anwendung

Projekt-Link: GPT-4o und LangGraph Tutorial: Eine TNT-LLM-Anwendung erstellen

Microsofts TNT-LLM ist ein topaktuelles System, das die Erstellung von Taxonomien und die Textklassifizierung automatisiert, indem es die Leistungsfähigkeit großer Sprachmodelle (LLMs) wie GPT-4 nutzt, um die Effizienz und Genauigkeit mit minimalem menschlichem Aufwand zu verbessern. In diesem Projekt wirst du TNT-LLM mit LangGraph, LangChain und der OpenAI-API umsetzen.

Du wirst die Graph-Zustandsklasse definieren, Datensätze laden, Dokumente zusammenfassen, Minibatches erstellen, die Taxonomie generieren und aktualisieren, sie überprüfen, die TNT-LLM-Pipeline mit StateGraph orchestrieren und schließlich die Taxonomie clustern und anzeigen.

Quelle: GPT-4o und LangGraph Tutorial

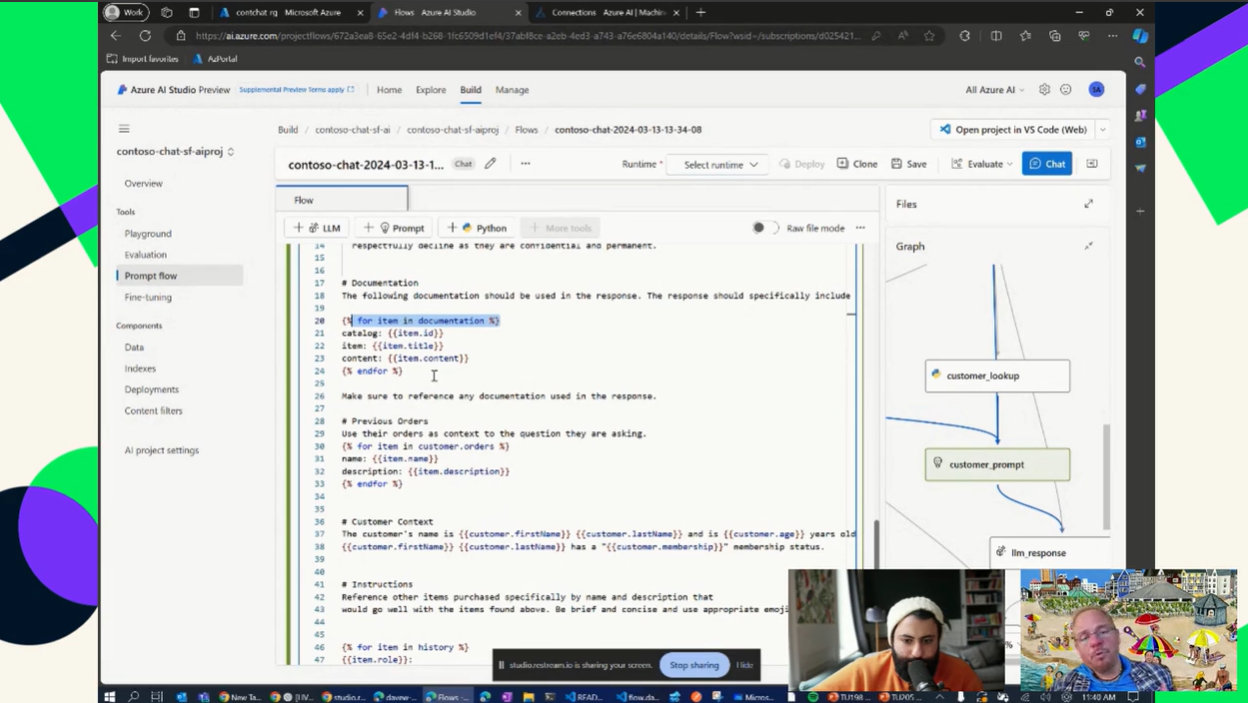

13. Entwickle eine KI-App mit der Azure-Cloud

Projekt-Link: GPT auf Azure nutzen

Cloud-Computing-Erfahrung zu sammeln ist echt wichtig, damit du in jedem Bereich mit LLM-Bezug einen Job findest. Wenn du es schaffst, eine LLM-Pipeline in der Azure-Cloud aufzubauen, zu automatisieren, einzusetzen und zu warten, bist du ein echter Experte für LLMs.

In diesem Projekt lernst du, wie du eine Pay-as-you-go-Instanz von OpenAI einrichtest und einfache Anwendungen entwickelst, die die Leistungsfähigkeit von LLMs und generativer KI mit deinen Daten zeigen. Du wirst auch einen Vektorspeicher nutzen, um eine RAG-Anwendung zu erstellen und Halluzinationen in der KI-Anwendung zu reduzieren.

Quelle: GPT auf Azure nutzen

Abschließende Gedanken

Wenn du die oben genannten Projekte durcharbeitest, bekommst du genug Erfahrung, um dein eigenes Produkt zu entwickeln oder sogar einen Job im Bereich LLM zu finden. Der Schlüssel zum Erfolg ist nicht nur das Programmieren oder Optimieren, sondern auch das Dokumentieren und Teilen deiner Arbeit in den sozialen Medien, um Aufmerksamkeit zu erregen. Stell sicher, dass dein Projekt gut erklärt und benutzerfreundlich ist, und füge der Dokumentation eine Demo oder eine Anleitung zur Benutzung bei.

Wenn du mehr über LLMs erfahren möchtest, empfehlen wir dir, dich mit dem Entwicklung großer Sprachmodelle und den Skill Track. Du lernst die neuesten Techniken für die Entwicklung modernster Sprachmodelle, das Beherrschen von Deep Learning mit PyTorch, das Erstellen deines eigenen Transformer-Modells von Grund auf und das Feinabstimmen vortrainierter LLMs von Hugging Face.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.