programa

Históricamente, muchos modelos de aprendizaje automático se diseñaban para el aprendizaje de tareas específicas, lo que requería grandes conjuntos de datos para cada nueva tarea. Dadas las limitaciones técnicas de la época, el enfoque más eficaz era entrenar modelos de aprendizaje automático con un enorme conjunto de datos de tareas específicas. Como resultado, los modelos de última generación fueron extremadamente eficaces a la hora de predecir el resultado del problema para el que fueron entrenados. Sin embargo, estos modelos estaban aún muy lejos de los humanos y de nuestra asombrosa capacidad para aprender nuevas tareas basándonos en nuestra experiencia previa.

Añadir estrategias de aprendizaje adaptativo a los modelos de aprendizaje automático es la misión central del metaaprendizaje, un subcampo del aprendizaje automático que se centra en mejorar la forma en que los modelos aprenden nuevas tareas de forma eficiente. El metaaprendizaje se centra en enseñar a los modelos a adaptarse rápidamente con un reentrenamiento y una intervención humana limitados, y a mejorar su rendimiento a lo largo del tiempo.

En este artículo, ofreceremos una introducción al metaaprendizaje y cómo está revolucionando el aprendizaje automático. Cubriremos los aspectos técnicos de los modelos de metaaprendizaje, los enfoques y aplicaciones más comunes, así como las ventajas y los retos. Después, te animo a que pruebes nuestro curso de Fundamentos de la IA para que seas realmente hábil a la hora de hablar de los diferentes conceptos relacionados en la IA.

¿Qué es el metaaprendizaje?

La investigación en metaaprendizaje se remonta a la década de 1980, pero el campo cobró relevancia en la década de 2010, con el auge de las redes neuronales, y, más recientemente, tras el desarrollo de la IA generativa. El metaaprendizaje, como subcampo del aprendizaje automático, se centra en enseñar a los modelos a aprender nuevas tareas de forma rápida y eficaz. Se inspira en la capacidad humana de "aprender a aprender", por así decirlo.

Imagina que quieres aprender a resolver problemas matemáticos rápidamente. Un enfoque tradicional sería memorizar las soluciones de muchos problemas diferentes, de modo que cuando veas uno conocido, puedas recordar la respuesta inmediatamente. Sin embargo, este enfoque se resiste cuando te encuentras con un problema nuevo.

En cambio, ¿qué pasaría si te centraras en aprender estrategias para resolver problemas en general, en lugar de memorizar soluciones concretas? Podrías estudiar técnicas de resolución de problemas, identificar patrones y desarrollar una intuición para abordar nuevos retos. De este modo, cuando te enfrentes a un problema nuevo, podrás adaptarte rápidamente y aplicar el método adecuado, aunque nunca antes hayas visto ese problema exacto.

Ésta es la esencia del metaaprendizaje. El aprendizaje automático tradicional memoriza patrones de grandes conjuntos de datos para una sola tarea, mientras que el metaaprendizaje entrena modelos para adaptarse rápidamente a nuevas tareas aprendiendo a aprender eficazmente.

Cómo funciona el metaaprendizaje

Puedes pensar en los modelos de metaaprendizaje como un sistema que incluye un subsistema de aprendizaje que se adapta dinámicamente explotando la experiencia de episodios de aprendizaje anteriores o de tareas diferentes.

A diferencia de los modelos tradicionales de aprendizaje automático que sólo tienen en cuenta una única tarea con un conjunto de datos fijo y grande, los metamodelos se exponen a una serie de tareas para extraer patrones generalizables. Normalmente, cada problema se asocia a un conjunto de datos de entrenamiento más pequeño y específico de la tarea.

El objetivo del metaentrenamiento es extraer información general sobre el proceso de aprendizaje en tareas individuales para mejorar la capacidad del modelo de abordar tareas nuevas con poco reentrenamiento.

El desarrollo de modelos de metaaprendizaje sigue un proceso de dos pasos que remuestrea el proceso de entrenamiento del aprendizaje automático tradicional:

- Metaformación. En esta fase, el modelo se entrena en múltiples tareas, y cada tarea consiste en una muestra de datos de entrenamiento (juntos forman el conjunto de datos de metaentrenamiento) y, en muchos casos, metadatos del modelo, como parámetros del modelo y medidas de rendimiento. El objetivo es descubrir patrones comunes y generalizables para dotar al modelo de amplios conocimientos que puedan utilizarse en tareas novedosas.

- Metapruebas. Durante la metaprueba, el modelo se expone a nuevas tareas que nunca se han encontrado durante el entrenamiento. El objetivo es evaluar su rendimiento midiendo lo bien y lo rápido que se adapta a nuevos entornos y tareas.

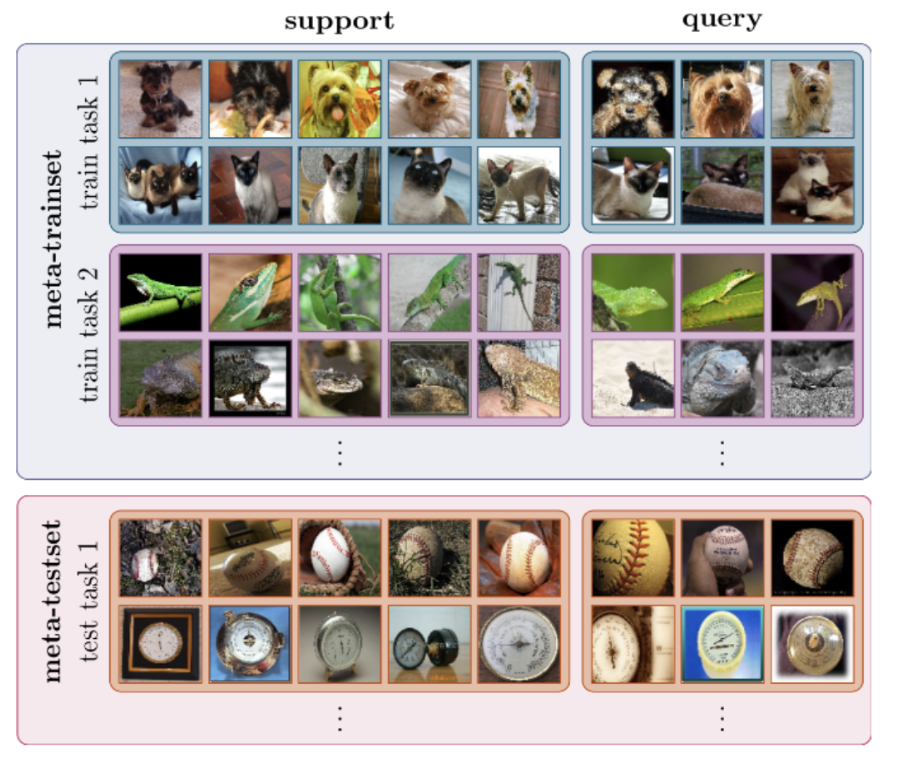

El proceso de metaformación y metaprueba se ilustra en la siguiente imagen.

Metaaprendizaje para la clasificación de imágenes. Fuente: Dida

El metaaprendizaje puede utilizarse para resolver cualquier tipo de aprendizaje automático, ya sea aprendizaje supervisado, aprendizaje no supervisado o aprendizaje de refuerzo.

Enfoques comunes del metaaprendizaje

Existen varios enfoques del metaaprendizaje. A continuación encontrarás los tres más comunes:

Metaaprendizaje basado en modelos

Los modelos de metaaprendizaje basados en modelos están diseñados específicamente para un aprendizaje rápido, es decir, pueden actualizar rápidamente sus parámetros con unos pocos pasos de entrenamiento. Esta actualización rápida puede lograrse mediante su arquitectura interna o controlada por otro modelo de metaaprendizaje.

Aquí tienes una lista de las estrategias de metaaprendizaje basadas en modelos más comunes:

- Redes neuronales mejoradas con memoria (MANN). Presentados por investigadores de Google en un artículo de 2016, los MANN son modelos neuronales equipados con un módulo de memoria externa que les permite codificar y recuperar rápidamente información nueva y hacer predicciones precisas tras sólo unas pocas muestras. A medida que se introducen nuevos datos en el modelo, estas redes cambian su sesgo mediante actualizaciones de peso, pero también modulan su salida aprendiendo a almacenar rápidamente en caché representaciones en almacenes de memoria.

- Meta Redes. Las MetaRedes, o MetaNets, son un tipo de modelo de metaaprendizaje propuesto por Munkhdalai y Yu en un artículo de 2017. Las meta-redes constan de dos modelos: un metaaprendiz y un aprendiz base. El aprendiz base funciona como una red neuronal tradicional: toma una tarea de entrada y envía metainformación sobre el espacio de tareas actual al metaaprendiz. Esta información la utiliza el metaaprendiz para actualizar rápidamente los pesos del modelo.

Metaaprendizaje basado en métricas

El metaaprendizaje basado en métricas se centra en el aprendizaje de una métrica de distancia que calcula la similitud o disimilitud entre pares de puntos de datos. Se obtiene una puntuación alta cuando los objetos son similares y una puntuación baja cuando las imágenes o los objetos son diferentes.

La idea central de este planteamiento es similar a la de los algoritmos del vecino más próximo, como K-NN o K-means, que utilizan la distancia entre puntos de datos para hacer clasificaciones o agrupaciones.

En comparación con los problemas de clasificación tradicionales, en los que se necesitan muchos datos de entrenamiento, los modelos basados en métricas pueden funcionar con sólo unas pocas instancias.

Algunos de los modelos más comunes que aprovechan las estrategias de metaaprendizaje basadas en métricas son:

- Red neuronal siamesa convolucional. Las redes siamesas son un tipo de red neuronal diseñada para tareas que implican la medición de similitudes o el aprendizaje métrico, como la verificación facial. El modelo consta de dos redes gemelas y sus salidas se entrenan conjuntamente encima con una función para aprender la relación entre pares de muestras de datos de entrada. Las redes gemelas son similares y comparten los mismos pesos y parámetros de red.

- Redes coincidentes. Desarrolladas por investigadores de Google en un artículo de 2016, las redes de coincidencia utilizan una distancia métrica llamada similitud coseno entre dos muestras para hacer clasificaciones. La arquitectura de la red de emparejamiento utiliza redes neuronales aumentadas de memoria que comprenden una memoria externa y un mecanismo de atención para acceder a la memoria.

- Redes prototípicas. Presentadas en un artículo de Snell et al., 2017, las redes prototípicas aprenden un espacio métrico en el que la clasificación puede ejecutarse calculando las distancias a las representaciones prototípicas de cada clase. Se basan en la premisa de que existe una incrustación en la que varios puntos se agrupan en torno a una única representación prototipo para cada clase.

Metaaprendizaje basado en la optimización

Las redes neuronales utilizan la retropropagación de gradientes para reducir progresivamente el error del modelo y mejorar su rendimiento. La función de optimización se encarga de encontrar la forma más eficaz de recalcular los pesos y sesgos de la red. Sin embargo, la mayoría de las funciones de optimización populares están diseñadas para tratar grandes cantidades de datos de entrenamiento, en lugar de pequeños conjuntos de datos.

El metaaprendizaje basado en la optimización se centra en diseñar funciones de optimización innovadoras que puedan actualizar los parámetros del modelo sólo con un pequeño conjunto de datos de entrenamiento, de modo que puedan adaptarse rápidamente a nuevas tareas.

Entre los modelos de metaaprendizaje basados en la optimización más populares están:

- Metaaprendiz LSTM. Este enfoque, presentado por Ravi y Larochelle en 2017, utiliza redes de memoria a largo-corto plazo (LSTM) para entrenar a un metaaprendiz que puede aprender el algoritmo de optimización exacto utilizado para entrenar a otro clasificador de red neuronal aprendiz, acelerando así la actualización de los parámetros para una convergencia rápida del entrenamiento en escenarios de nuevas tareas con datos de entrenamiento limitados.

- Metaaprendizaje Diagnóstico por Modelos (MAML). Presentado por Finn et al. en un artículo de 2017, MAML es compatible con cualquier modelo entrenado con descenso de gradiente y aplicable a una variedad de problemas de aprendizaje diferentes, como la clasificación, la regresión y el aprendizaje por refuerzo. MAML se basa en la suposición de que entrenar los parámetros iniciales del modelo en unas pocas actualizaciones de gradiente dará como resultado un aprendizaje rápido en una nueva tarea. El objetivo es determinar los parámetros del modelo que son sensibles a los cambios en una tarea, de modo que pequeños cambios en esos parámetros produzcan grandes mejoras en la función de pérdida de la tarea.

- Reptil. Desarrollado por OpenAI, Reptile es un algoritmo de metaaprendizaje de primer orden basado en gradientes. Muestrea repetidamente una tarea, realizando el descenso de gradiente estocástico sobre ella, y actualizando los parámetros iniciales hacia los parámetros finales aprendidos sobre esa tarea. Reptile es la aplicación del algoritmo del Descenso más Corto al entorno del metaaprendizaje, y es matemáticamente similar a MAML, con una eficacia y un rendimiento computacionales parecidos.

Metaaprendizaje y otros tipos de aprendizaje

A diferencia de los métodos tradicionales de aprendizaje supervisado, que exigen grandes cantidades de datos, el metaaprendizaje ofrece un cambio de paradigma, que permite a los modelos de IA generalizar las tareas, adaptarse rápidamente con un mínimo de datos y mejorar el rendimiento con el tiempo.

Analicemos algunas de las aplicaciones más prometedoras:

Aprendizaje con pocos disparos

El aprendizaje de pocos ejemplos es un subcampo del aprendizaje automático en el que los modelos aprenden a reconocer patrones y a hacer predicciones basándose en un número limitado de ejemplos de entrenamiento. El aprendizaje de pocos disparos enfatiza la generalización sobre la memorización, desafiando la necesidad de un ajuste fino exhaustivo. Para los defensores de este enfoque, la clave reside en la capacidad de discernir la estructura y los rasgos subyacentes que definen una categoría.

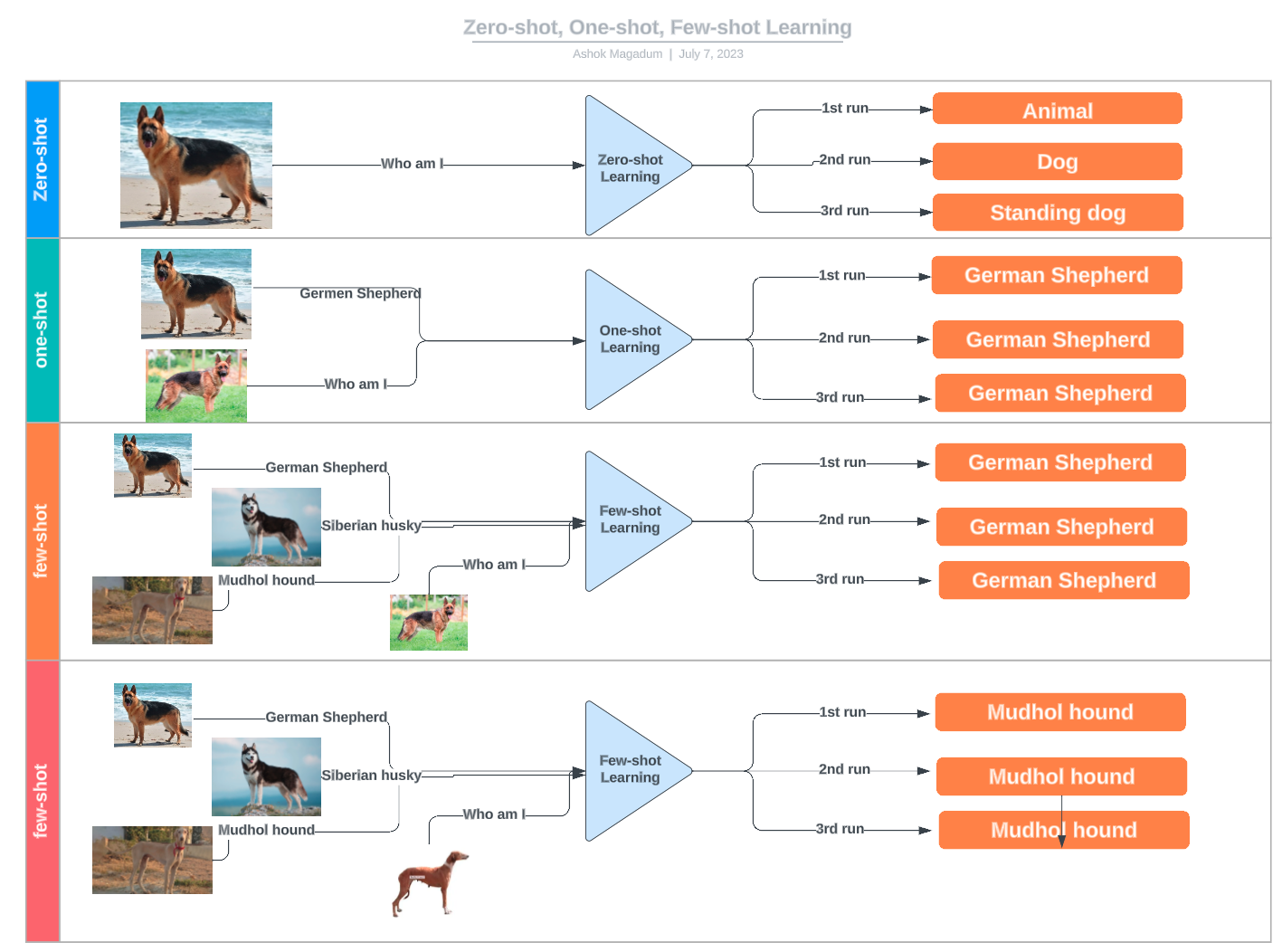

El aprendizaje de pocos disparos se engloba bajo el paraguas más amplio del aprendizaje de n disparos, que engloba diversas técnicas basadas en el número de ejemplos proporcionados:

- Aprendizaje a tiro cero: No se dan ejemplos; el modelo se basa únicamente en conocimientos previos o descripciones.

- Aprendizaje de una sola vez: Sólo se proporciona un ejemplo por clase.

- Aprendizaje en dos tiempos: Para el entrenamiento se utilizan dos ejemplos por clase.

- Aprendizaje de pocos disparos: Se dispone de un pequeño número de ejemplos (normalmente entre 3 y 10) para cada clase.

Ejemplos de aprendizaje de cero disparos, un disparo y pocos disparos. Fuente: LinkedIn

Aprendizaje por transferencia

El aprendizaje por transferencia permite reutilizar un modelo entrenado para una tarea para otra diferente pero relacionada, a menudo mediante el ajuste fino de un modelo preentrenado. El metaaprendizaje, en cambio, se centra en enseñar a los modelos a adaptarse rápidamente a nuevas tareas con un reentrenamiento mínimo. Aunque el metaaprendizaje puede mejorar el aprendizaje por transferencia en algunos casos, como optimizando los hiperparámetros o seleccionando la mejor estrategia de ajuste fino, no es un componente necesario del aprendizaje por transferencia. Muchos enfoques de aprendizaje por transferencia se basan únicamente en técnicas convencionales de ajuste, en lugar de en el metaaprendizaje.

Sistemas de recomendación

Los sistemas de recomendación utilizan las opiniones de los usuarios para encontrar nuevos artículos relevantes para ellos o para otros, partiendo del supuesto de que es probable que los usuarios que tienen preferencias similares en el pasado tengan preferencias similares en el futuro.

El objetivo de un sistema de recomendación es proporcionar a los usuarios recomendaciones personalizadas basadas en sus preferencias y su comportamiento anterior. El metaaprendizaje puede ayudar a conseguir este objetivo aprendiendo a optimizar el algoritmo de recomendación para cada usuario.

Los sistemas de meta-recomendación constan de dos capas: un sistema de recomendación base y un optimizador de meta-nivel. El sistema recomendador básico genera recomendaciones para los usuarios basándose en su comportamiento anterior, mientras que el optimizador de metanivel aprende a optimizar el sistema recomendador básico para cada usuario.

Aprendizaje automático de máquinas (AutoML)

El aprendizaje automático de máquinas, también conocido como AutoML, es el proceso de automatizar el proceso completo de construcción de modelos de aprendizaje automático. Esto incluye tareas como el preprocesamiento de datos, la ingeniería de rasgos, la selección de modelos y el ajuste de hiperparámetros.

Las técnicas de metaaprendizaje pueden apoyar estos procesos, por ejemplo automatizando la optimización y adaptación de hiperparámetros, o incluso encontrando el modelo más adecuado para resolver una tarea específica.

Ventajas y retos del metaaprendizaje

Hay varias razones de peso por las que los investigadores del aprendizaje automático recurren cada vez más a estrategias de metaaprendizaje para desarrollar sus modelos.

-

Eficacia de la formación: El metaaprendizaje reduce el tiempo de entrenamiento al evitar la necesidad de entrenar modelos con conjuntos de datos enormes y permite el ajuste fino con datos limitados.

-

Reducir los costes operativos: El metaaprendizaje reduce los costes al evitar la necesidad de entrenar modelos desde cero, donde tanto la adquisición de los datos como el uso de recursos informáticos para entrenar un modelo pueden resultar caros.

-

Mayor adaptabilidad y reutilización: El metaaprendizaje es una técnica clave que permite a los modelos adaptarse a múltiples escenarios y tareas, aumentando así su potencial y usabilidad.

-

Rendimiento del modelo: Además de mejorar la adaptabilidad, el metaaprendizaje también puede mejorar la precisión de los modelos de aprendizaje automático existentes.

Sin embargo, el metaaprendizaje no es una estrategia única. Tiene limitaciones y escollos potenciales que deben abordarse con cuidado. Algunos de los retos más comunes en el metaaprendizaje son:

-

Desajuste de dominio: Es más probable que el metaaprendizaje funcione bien cuando las tareas de origen y de destino están relacionadas en cierta medida. Si la nueva tarea es muy diferente, el conocimiento generalizable transferido puede no ser suficiente para realizar la nueva tarea con precisión, e incluso puede reducir el rendimiento en todas las tareas.

-

Escasez de datos: Siempre se necesita una cierta cantidad de datos de entrenamiento. Si los datos de entrenamiento son muy limitados o la calidad de los datos es mala, es probable que el modelo no se ajuste lo suficiente.

-

Sobreajuste: El metaaprendizaje tampoco es inmune al sobreajuste. Si el modelo se afina demasiado en una tarea, puede aprender características específicas de la tarea que no se generalicen bien a los nuevos datos.

-

Complejidad y coste: A veces, la tarea objetivo es tan compleja que el proceso de ajuste puede ser difícil, costoso computacionalmente y llevar mucho tiempo.

Orientaciones futuras y oportunidades de investigación

El metaaprendizaje es un enfoque de diseño fundamental para aumentar la eficacia y el potencial de las redes neuronales. Es justo decir que la actual revolución de la IA no habría sido posible sin las numerosas técnicas de aprendizaje por transferencia disponibles.

El campo está evolucionando rápidamente, con algunas áreas que requieren más investigación, entre ellas:

- Eficacia de la muestra. ¿Cuántos datos se necesitan para que un modelo sea eficaz en nuevas tareas? Esta es una cuestión central en el metaaprendizaje. Aunque las estrategias de aprendizaje a corto plazo demuestran que es posible que un modelo aprenda con datos limitados, todavía hay un amplio margen de mejora para hacer que los modelos sean más eficientes y versátiles.

- Diversidad de tareas. Las técnicas de metaaprendizaje tienden a funcionar mejor cuando las tareas en cuestión están relacionadas de algún modo. Sin embargo, es crucial seguir investigando para avanzar en modelos de metaaprendizaje que puedan generalizar en una amplia gama de tareas sin sobreajustarse.

- Técnicas avanzadas. El metaaprendizaje es un catalizador central de la innovación en algunas de las tecnologías más prometedoras y valiosas de la actualidad, como el aprendizaje por refuerzo, la robótica y los transformadores.

Conclusión

A medida que los modelos de aprendizaje automático se hacen más grandes y complejos, encontrar técnicas novedosas para hacerlos más eficientes y versátiles es crucial para que la industria de la IA cumpla sus promesas, haga que los números funcionen y avance en la sostenibilidad del sector.

El metaaprendizaje tiene mucho que decir al respecto. Este campo de investigación está evolucionando rápidamente, ofreciendo un conjunto de técnicas y estrategias que son cruciales para hacer avanzar las capacidades de la IA. Permanece atento a DataCamp para conocer las últimas novedades en metaaprendizaje, IA y mucho más:

-

¿Qué es el aprendizaje de pocos disparos? Obtener información con datos limitados

-

¿Qué es el Aprendizaje Profundo? Un tutorial para principiantes

-

Comprender la superalineación: Alinear la IA con los valores humanos

-

¿Qué es la alineación de la IA? Garantizar que la IA funcione para la humanidad

-

¿Qué es el aprendizaje por transferencia en la IA? Guía introductoria con ejemplos

Soy analista de datos autónomo y colaboro con empresas y organizaciones de todo el mundo en proyectos de ciencia de datos. También soy instructor de ciencia de datos con más de 2 años de experiencia. Escribo regularmente artículos relacionados con la ciencia de datos en inglés y español, algunos de los cuales se han publicado en sitios web consolidados como DataCamp, Towards Data Science y Analytics Vidhya Como científico de datos con formación en ciencias políticas y derecho, mi objetivo es trabajar en la interacción de las políticas públicas, el derecho y la tecnología, aprovechando el poder de las ideas para promover soluciones y narrativas innovadoras que puedan ayudarnos a abordar retos urgentes, como la crisis climática. Me considero autodidacta, aprendiz constante y firme partidaria de la multidisciplinariedad. Nunca es demasiado tarde para aprender cosas nuevas.

Preguntas frecuentes sobre metaaprendizaje

¿Qué es el metaaprendizaje?

El metaaprendizaje es un subcampo del aprendizaje automático centrado en enseñar a los modelos a aprender nuevas tareas de forma rápida y eficaz. Se inspira en la capacidad humana de "aprender a aprender".

¿Cuáles son las estrategias de metaaprendizaje más comunes?

Según cómo se implemente el metaaprendizaje, podemos identificar tres enfoques principales: el metaaprendizaje basado en modelos, el basado en métricas y el basado en optimizaciones.

¿Cuáles son las aplicaciones del metaaprendizaje?

Algunas de las aplicaciones más prometedoras del metaaprendizaje en la IA son el aprendizaje de pocos puntos, el aprendizaje por transferencia, los sistemas de recomendación y el aprendizaje automático de máquinas (AutoML).

¿Cuál es la diferencia entre metaaprendizaje y aprendizaje por transferencia?

El aprendizaje por transferencia es una técnica en la que un modelo entrenado en una tarea se utiliza como punto de partida para un modelo en una segunda tarea. Esto implica utilizar los parámetros del modelo preentrenado de la tarea general como inicialización para el ajuste fino de los parámetros del modelo para la tarea específica. En cambio, el metaaprendizaje se centra en el aprendizaje de estrategias para hacer que un modelo se adapte rápidamente a nuevas tareas.

¿Cuáles son las ventajas del metaaprendizaje?

El aprendizaje por transferencia es una gran técnica de optimización, que puede aumentar la eficacia de la formación y el rendimiento de los modelos, mejorar la adaptabilidad y la reutilización, y reducir los costes operativos.