Lernpfad

In der Vergangenheit wurden viele Modelle für maschinelles Lernen für aufgabenspezifisches Lernen entwickelt, sodass für jede neue Aufgabe große Datensätze benötigt wurden. Angesichts der damaligen technischen Beschränkungen war es am effektivsten, maschinelle Lernmodelle mit einem riesigen, aufgabenspezifischen Datensatz zu trainieren. Das Ergebnis war, dass die Modelle auf dem neuesten Stand der Technik das Ergebnis des Problems, für das sie trainiert wurden, sehr gut vorhersagen konnten. Diese Modelle waren jedoch noch weit entfernt vom Menschen und seiner erstaunlichen Fähigkeit, neue Aufgaben auf der Grundlage seiner bisherigen Erfahrungen zu lernen.

Das Hinzufügen von adaptiven Lernstrategien zu maschinellen Lernmodellen ist die zentrale Aufgabe des Meta-Lernens, einem Teilbereich des maschinellen Lernens, der sich darauf konzentriert, wie Modelle effizient neue Aufgaben lernen. Beim Meta-Lernen geht es darum, den Modellen beizubringen, sich mit begrenztem Nachschulungsaufwand und menschlichen Eingriffen schnell anzupassen und ihre Leistung im Laufe der Zeit zu verbessern.

In diesem Artikel geben wir eine Einführung in das Meta-Lernen und zeigen, wie es das maschinelle Lernen revolutioniert. Wir werden die technischen Aspekte von Meta-Lernmodellen, die gängigsten Ansätze und Anwendungen sowie die Vorteile und Herausforderungen behandeln. Danach empfehle ich dir, unseren Lernpfad KI-Grundlagen auszuprobieren, damit du wirklich über die verschiedenen und verwandten Konzepte der KI sprechen kannst.

Was ist Meta Learning?

Die Forschung im Bereich des Meta-Lernens reicht bis in die 1980er Jahre zurück, aber das Feld gewann in den 2010er Jahren mit dem Aufkommen neuronaler Netze und in jüngerer Zeit mit der Entwicklung der generativen KI an Bedeutung. Meta-Lernen als Teilgebiet des maschinellen Lernens konzentriert sich darauf, Modellen beizubringen, wie sie neue Aufgaben schnell und effizient lernen können. Es ist inspiriert von der Fähigkeit des Menschen, sozusagen "das Lernen zu lernen".

Stell dir vor, du willst lernen, wie du Matheaufgaben schnell lösen kannst. Eine traditionelle Herangehensweise wäre, sich die Lösungen für viele verschiedene Probleme einzuprägen, damit du die Antwort sofort abrufen kannst, wenn du ein bekanntes Problem siehst. Dieser Ansatz ist jedoch problematisch, wenn du auf ein brandneues Problem stößt.

Wie wäre es stattdessen, wenn du dich darauf konzentrierst, Strategien zum Lösen von Problemen im Allgemeinen zu lernen, anstatt spezielle Lösungen auswendig zu lernen? Du könntest Problemlösungstechniken studieren, Muster erkennen und ein Gespür dafür entwickeln, wie du an neue Herausforderungen herangehst. Auf diese Weise kannst du dich bei einem neuen Problem schnell anpassen und die richtige Methode anwenden, auch wenn du das Problem noch nie gesehen hast.

Das ist die Essenz des Meta-Lernens. Beim traditionellen maschinellen Lernen werden Muster aus großen Datensätzen für eine einzige Aufgabe gespeichert, während beim Meta-Lernen Modelle so trainiert werden, dass sie sich schnell an neue Aufgaben anpassen, indem sie lernen, wie man effektiv lernt.

Wie Meta Learning funktioniert

Du kannst dir Meta-Lernmodelle als ein System vorstellen, das ein lernendes Teilsystem enthält, das sich dynamisch anpasst, indem es die Erfahrungen aus früheren Lernepisoden oder aus verschiedenen Aufgaben nutzt.

Im Gegensatz zu traditionellen maschinellen Lernmodellen, die nur eine einzige Aufgabe mit einem festen und großen Datensatz betrachten, werden Metamodelle mit einer Reihe von Aufgaben konfrontiert, um verallgemeinerbare Muster zu extrahieren. Normalerweise ist jedes Problem mit einem kleineren, aufgabenspezifischen Trainingsdatensatz verbunden.

Das Ziel des Meta-Trainings ist es, allgemeine Informationen über den Lernprozess bei einzelnen Aufgaben zu extrahieren, um die Fähigkeit des Modells zu verbessern, neue Aufgaben mit wenig Nachschulung zu bewältigen.

Die Entwicklung von Meta-Learning-Modellen erfolgt in einem zweistufigen Prozess, der den Trainingsprozess des traditionellen maschinellen Lernens nachahmt:

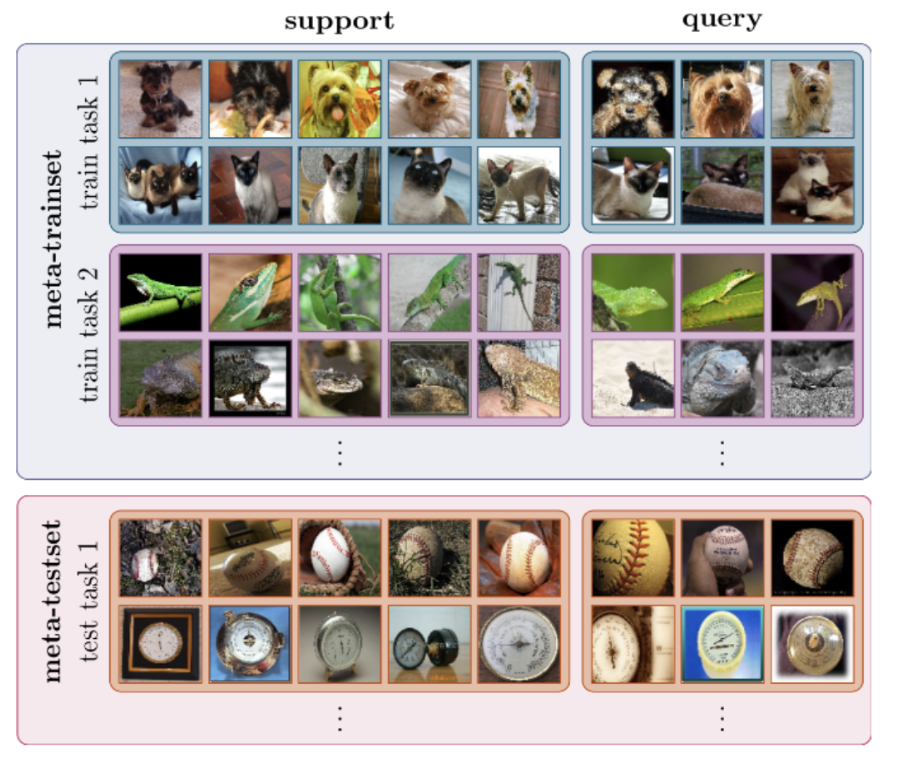

- Meta-Training. In dieser Phase wird das Modell an mehreren Aufgaben trainiert, wobei jede Aufgabe aus einer Trainingsdatenprobe (zusammen bilden sie den Meta-Train-Datensatz) und in vielen Fällen aus Modell-Metadaten wie Modellparametern und Leistungskennzahlen besteht. Das Ziel ist es, gemeinsame, verallgemeinerbare Muster zu entdecken, um das Modell mit breitem Wissen auszustatten, das bei neuen Aufgaben verwendet werden kann.

- Meta-Prüfung. Während des Metatests wird das Modell neuen Aufgaben ausgesetzt, die es während des Trainings noch nicht kennengelernt hat. Das Ziel ist es, seine Leistung zu bewerten, indem wir messen, wie gut und wie schnell er sich an neue Umgebungen und Aufgaben anpasst.

Der Prozess des Meta-Trainings und Meta-Tests wird in der folgenden Abbildung dargestellt.

Meta-Lernen für die Bildklassifizierung. Quelle: Dida

Meta-Lernen kann für jede Art von maschinellem Lernen eingesetzt werden, egal ob überwachtes Lernen, unüberwachtes Lernen oder Reinforcement Learning.

Gemeinsame Ansätze zum Meta-Lernen

Es gibt verschiedene Ansätze für das Metalernen. Im Folgenden findest du die drei gängigsten davon:

Modellbasiertes Meta-Lernen

Modellbasierte Meta-Learning-Modelle sind speziell für schnelles Lernen konzipiert, d.h. sie können ihre Parameter mit wenigen Trainingsschritten schnell aktualisieren. Diese schnelle Aktualisierung kann durch seine interne Architektur erreicht oder durch ein anderes Meta-Lernmodell gesteuert werden.

Hier ist eine Liste der gängigsten modellbasierten Metalernstrategien:

- Gedächtniserweiterte neuronale Netze (MANNs). MANNs sind neuronale Modelle, die mit einem externen Speichermodul ausgestattet sind, das es ihnen ermöglicht, neue Informationen schnell zu kodieren und abzurufen und schon nach wenigen Stichproben genaue Vorhersagen zu treffen, wie Google-Forscher in einem Papier aus dem Jahr 2016 berichten. Wenn neue Daten in das Modell eingespeist werden, ändern diese Netze ihre Ausrichtung durch Aktualisierungen der Gewichte, aber auch indem sie lernen, Repräsentationen schnell im Speicher zwischenzuspeichern.

- Meta Networks. Meta Networks oder MetaNets sind eine Art Meta-Lernmodell, das von Munkhdalai und Yu in einer Veröffentlichung von 2017 vorgeschlagen wurde. Metanetzwerke bestehen aus zwei Modellen: einem Meta-Lernenden und einem Basis-Lernenden. Der Basis-Lerner funktioniert wie ein herkömmliches neuronales Netz: Er nimmt eine Eingabeaufgabe entgegen und sendet Metainformationen über den aktuellen Aufgabenraum an den Meta-Lerner. Diese Informationen werden vom Meta-Learner genutzt, um die Gewichte des Modells schnell zu aktualisieren.

Metrik-basiertes Meta-Lernen

Metrikbasiertes Meta-Lernen konzentriert sich auf das Erlernen einer Abstandsmetrik, die die Ähnlichkeit oder Unähnlichkeit zwischen Paaren von Datenpunkten berechnet. Eine hohe Punktzahl wird vergeben, wenn die Objekte ähnlich sind, und eine niedrige, wenn die Bilder oder Objekte unterschiedlich sind.

Der Kerngedanke dieses Ansatzes ähnelt den Nearest Neighbour-Algorithmen wie K-NN oder K-Means, die den Abstand zwischen Datenpunkten zur Klassifizierung oder Clusterbildung nutzen.

Im Vergleich zu traditionellen Klassifizierungsproblemen, für die eine große Anzahl von Trainingsdaten erforderlich ist, können metrikbasierte Modelle mit nur wenigen Instanzen arbeiten.

Einige der gängigsten Modelle, die metrikbasierte Meta-Lernstrategien nutzen, sind:

- Faltungsorientiertes Siamesisches Neuronales Netz. Siamesische Netze sind eine Art von neuronalen Netzen, die für Aufgaben entwickelt wurden, bei denen es um Ähnlichkeitsmessung oder metrisches Lernen geht, wie z.B. bei der Gesichtsverifikation. Das Modell besteht aus zwei Zwillingsnetzen, deren Ausgänge gemeinsam mit einer Funktion trainiert werden, um die Beziehung zwischen Paaren von Eingabedaten zu lernen. Die Zwillingsnetzwerke sind ähnlich und haben die gleichen Gewichte und Netzwerkparameter.

- Passende Netzwerke. Das von Google-Forschern in einer Veröffentlichung aus dem Jahr 2016 entwickelte Matching-Netzwerk verwendet eine metrische Distanz namens Kosinusähnlichkeit zwischen zwei Proben, um Klassifizierungen vorzunehmen. Die Matching-Netzwerk-Architektur verwendet gedächtniserweiterte neuronale Netze mit einem externen Speicher und einem Aufmerksamkeitsmechanismus für den Zugriff auf den Speicher.

- Prototypische Netzwerke. Snell et al. (2017) stellen vor, dass prototypische Netze einen metrischen Raum erlernen, in dem die Klassifizierung durch die Berechnung von Distanzen zu prototypischen Repräsentationen der einzelnen Klassen erfolgen kann. Sie basieren auf der Prämisse, dass es eine Einbettung gibt, bei der sich mehrere Punkte um eine einzige prototypische Darstellung für jede Klasse gruppieren.

Optimierungsbasiertes Meta-Lernen

Neuronale Netze verwenden Backpropagation von Gradienten, um den Fehler des Modells schrittweise zu reduzieren und seine Leistung zu verbessern. Die Optimierungsfunktion ist dafür verantwortlich, den effektivsten Weg zur Neuberechnung der Gewichte und Verzerrungen des Netzes zu finden. Die meisten gängigen Optimierungsfunktionen sind jedoch auf große Mengen von Trainingsdaten ausgelegt und nicht auf kleine Datensätze.

Optimierungsbasiertes Meta-Lernen konzentriert sich auf die Entwicklung innovativer Optimierungsfunktionen, die die Parameter des Modells nur mit einem kleinen Trainingsdatensatz aktualisieren können, sodass sie sich schnell an neue Aufgaben anpassen können.

Zu den beliebtesten optimierungsbasierten Metalernmodellen gehören:

- LSTM-Meta-Lerner. Dieser von Ravi und Larochelle 2017 vorgestellte Ansatz nutzt LSTM-Netzwerke (Long-Short-Term-Memory), um einen Meta-Learner zu trainieren, der genau den Optimierungsalgorithmus erlernen kann, der für das Training eines anderen Klassifizierers eines neuronalen Lernnetzes verwendet wird, wodurch die Aktualisierung der Parameter für eine schnelle Trainingskonvergenz in Szenarien mit neuen Aufgaben und begrenzten Trainingsdaten beschleunigt wird.

- Modell-Agnostisches Meta-Lernen (MAML). Das von Finn et al. 2017 vorgestellte MAML ist mit jedem Modell kompatibel, das mit Gradientenabstieg trainiert wurde, und lässt sich auf eine Vielzahl verschiedener Lernprobleme anwenden, darunter Klassifizierung, Regression und Verstärkungslernen. MAML basiert auf der Annahme, dass das Training der Anfangsparameter des Modells mit nur wenigen Gradienten-Updates zu einem schnellen Lernen für eine neue Aufgabe führt. Ziel ist es, die Modellparameter zu bestimmen, die auf Veränderungen in einer Aufgabe so empfindlich reagieren, dass kleine Änderungen dieser Parameter zu großen Verbesserungen in der Verlustfunktion der Aufgabe führen.

- Reptil. Reptile wurde von OpenAI entwickelt und ist ein gradientenbasierter Meta-Lernalgorithmus erster Ordnung. Dabei wird eine Aufgabe wiederholt gesampelt, ein stochastischer Gradientenabstieg durchgeführt und die Anfangsparameter in Richtung der endgültigen Parameter aktualisiert, die für diese Aufgabe gelernt wurden. Reptile ist die Anwendung des Shortest-Descent-Algorithmus auf die Meta-Lernumgebung und ist mathematisch ähnlich wie MAML, mit ähnlicher Recheneffizienz und Leistung.

Meta-Lernen und andere Arten des Lernens

Im Gegensatz zu den traditionellen überwachten Lernmethoden, die riesige Datenmengen benötigen, bietet das Meta-Lernen einen Paradigmenwechsel, der es KI-Modellen ermöglicht, Aufgaben zu verallgemeinern, sich mit minimalen Daten schnell anzupassen und ihre Leistung im Laufe der Zeit zu verbessern.

Analysieren wir einige der vielversprechendsten Anwendungen:

Lernen mit wenigen Schüssen

Few-Shot-Learning ist ein Teilbereich des maschinellen Lernens, bei dem Modelle lernen, Muster zu erkennen und Vorhersagen auf der Grundlage einer begrenzten Anzahl von Trainingsbeispielen zu treffen. Beim Few-Shot-Lernen wird der Schwerpunkt auf die Verallgemeinerung statt auf das Auswendiglernen gelegt, was die Notwendigkeit einer umfangreichen Feinabstimmung in Frage stellt. Für die Befürworter dieses Ansatzes liegt der Schlüssel in der Fähigkeit, die zugrunde liegende Struktur und die Merkmale zu erkennen, die eine Kategorie definieren.

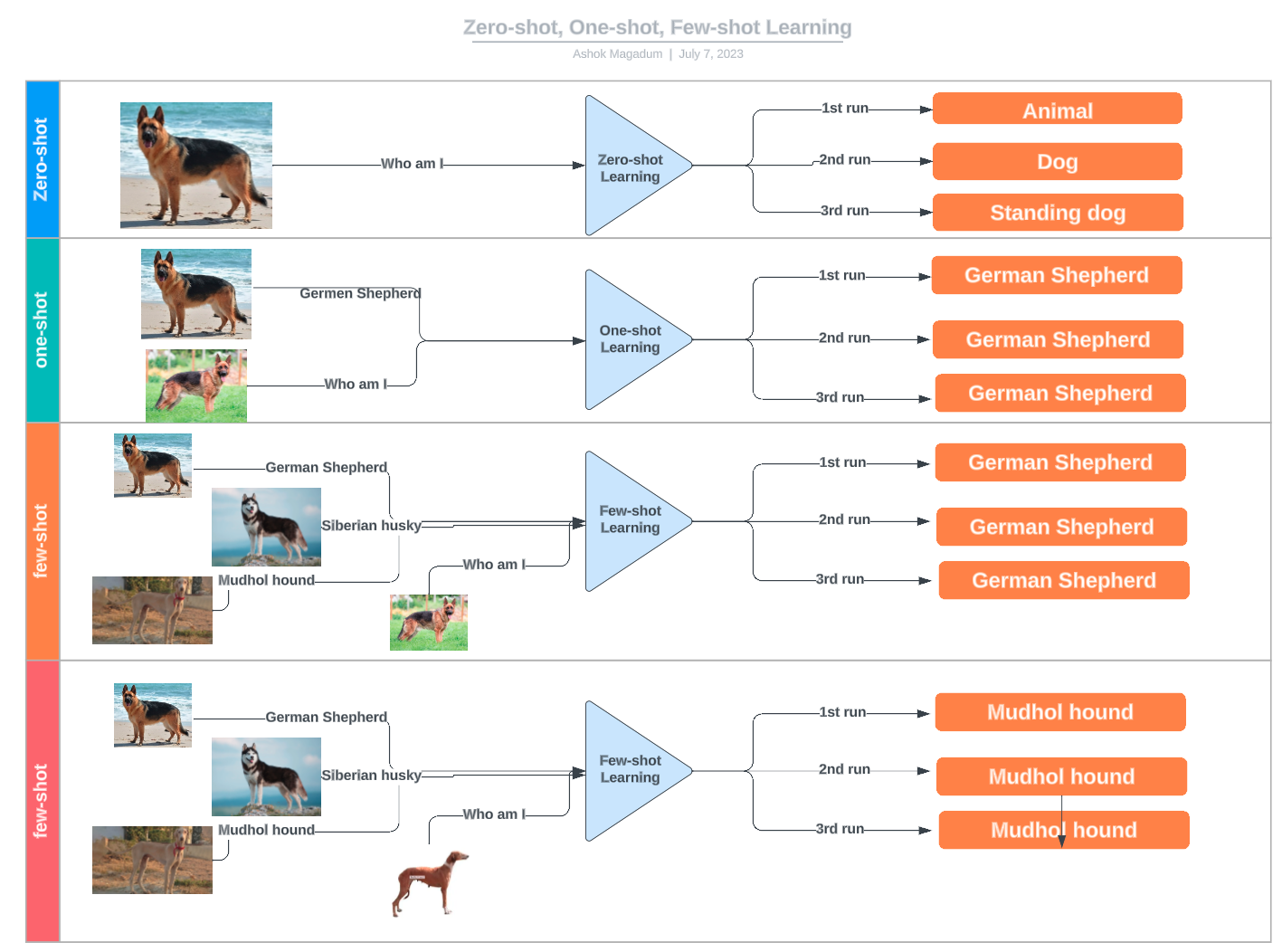

Das Few-Shot-Lernen fällt unter den weiter gefassten Begriff des n-Shot-Lernens und umfasst verschiedene Techniken, die auf der Anzahl der bereitgestellten Beispiele basieren:

- Zero-Shot Learning: Es werden keine Beispiele gegeben; das Modell verlässt sich ausschließlich auf Vorwissen oder Beschreibungen.

- Lernen auf einen Schlag: Es wird nur ein Beispiel pro Klasse angegeben.

- Zwei-Schuss-Lernen: Zwei Beispiele pro Klasse werden für das Training verwendet.

- Lernen mit wenigen Schüssen: Für jede Klasse gibt es eine kleine Anzahl von Beispielen (normalerweise zwischen 3 und 10).

Beispiele für Null-Schuss-, Ein-Schuss- und Wenig-Schuss-Lernen. Quelle: LinkedIn

Lernen übertragen

Beim Transfer-Lernen kann ein Modell, das für eine Aufgabe trainiert wurde, für eine andere, aber verwandte Aufgabe verwendet werden, oft durch Feinabstimmung eines zuvor trainierten Modells. Beim Meta-Lernen hingegen geht es darum, den Modellen beizubringen, wie sie sich schnell und mit minimaler Umschulung an neue Aufgaben anpassen können. Obwohl Meta-Lernen in einigen Fällen das Transfer-Lernen verbessern kann, z. B. durch die Optimierung von Hyperparametern oder die Auswahl der besten Feinabstimmungsstrategie, ist es kein notwendiger Bestandteil des Transfer-Lernens. Viele Transfer-Learning-Ansätze verlassen sich ausschließlich auf konventionelle Feinabstimmungstechniken und nicht auf Meta-Lernen.

Empfehlungssysteme

Empfehlungssysteme nutzen das Feedback der Nutzer/innen, um neue relevante Artikel für sie selbst oder für andere zu finden. Dabei wird davon ausgegangen, dass Nutzer/innen, die in der Vergangenheit ähnliche Vorlieben hatten, wahrscheinlich auch in Zukunft ähnliche Vorlieben haben werden.

Das Ziel eines Empfehlungssystems ist es, den Nutzern personalisierte Empfehlungen zu geben, die auf ihren Vorlieben und ihrem bisherigen Verhalten basieren. Meta-Lernen kann helfen, dieses Ziel zu erreichen, indem es lernt, wie der Empfehlungsalgorithmus für jeden Nutzer optimiert werden kann.

Meta-Empfehlungssysteme bestehen aus zwei Schichten: einem Basis-Empfehlungssystem und einem Optimierer auf der Meta-Ebene. Das Basis-Recommender-System generiert Empfehlungen für die Nutzer/innen auf der Grundlage ihres bisherigen Verhaltens, während der Meta-Level-Optimierer lernt, wie er das Basis-Recommender-System für jede/n Nutzer/in optimieren kann.

Automatisiertes maschinelles Lernen (AutoML)

Automatisiertes maschinelles Lernen, auch AutoML genannt, ist der Prozess der Automatisierung des gesamten Prozesses der Erstellung von maschinellen Lernmodellen. Dazu gehören Aufgaben wie die Vorverarbeitung der Daten, das Feature Engineering, die Modellauswahl und die Abstimmung der Hyperparameter.

Meta-Learning-Techniken können diese Prozesse unterstützen, indem sie zum Beispiel die Optimierung und Anpassung von Hyperparametern automatisieren oder sogar das am besten geeignete Modell zur Lösung einer bestimmten Aufgabe finden.

Vorteile und Herausforderungen von Meta Learning

Es gibt mehrere zwingende Gründe, warum Forscher/innen, die sich mit maschinellem Lernen befassen, zunehmend auf Meta-Learning-Strategien zurückgreifen, um ihre Modelle zu entwickeln.

-

Trainingseffizienz: Meta-Lernen verkürzt die Trainingszeit, da die Modelle nicht mit großen Datensätzen trainiert werden müssen, und ermöglicht eine Feinabstimmung mit begrenzten Daten.

-

Senkung der Betriebskosten: Meta-Lernen senkt die Kosten, weil es nicht mehr nötig ist, Modelle von Grund auf zu trainieren, wobei sowohl die Beschaffung der Daten als auch der Einsatz von Rechenressourcen zum Trainieren eines Modells teuer sein können.

-

Verbesserte Anpassungsfähigkeit und Wiederverwendbarkeit: Meta-Lernen ist eine Schlüsseltechnik, die es den Modellen ermöglicht, sich an verschiedene Szenarien und Aufgaben anzupassen und so ihr Potenzial und ihre Nutzbarkeit zu erhöhen.

-

Modellleistung: Neben der Verbesserung der Anpassungsfähigkeit kann Meta-Lernen auch die Genauigkeit bestehender maschineller Lernmodelle verbessern.

Meta-Lernen ist jedoch keine Einheitsstrategie. Es gibt Grenzen und potenzielle Fallstricke, die sorgfältig beachtet werden müssen. Einige der häufigsten Herausforderungen beim Metalernen sind:

-

Die Domäne stimmt nicht überein: Meta-Lernen funktioniert eher, wenn die Ausgangs- und die Zielaufgaben in gewissem Maße miteinander verbunden sind. Wenn die neue Aufgabe sehr unterschiedlich ist, reicht das übertragene verallgemeinerbare Wissen möglicherweise nicht aus, um die neue Aufgabe genau auszuführen, und es kann sogar die Leistung in allen Aufgaben verringern.

-

Datenknappheit: Es ist immer eine bestimmte Menge an Trainingsdaten erforderlich. Wenn die Trainingsdaten extrem begrenzt sind oder die Qualität der Daten schlecht ist, wird das Modell wahrscheinlich nicht richtig angepasst.

-

Überanpassung: Auch Meta-Lernen ist nicht immun gegen Overfitting. Wenn das Modell für eine Aufgabe zu sehr verfeinert wird, kann es aufgabenspezifische Merkmale lernen, die sich nicht gut auf neue Daten übertragen lassen.

-

Komplexität und Kosten: Manchmal ist die Zielaufgabe so komplex, dass der Feinabstimmungsprozess schwierig, rechenintensiv und zeitaufwändig sein kann.

Zukünftige Richtungen und Forschungsmöglichkeiten

Meta-Lernen ist ein wichtiger Ansatz, um die Effizienz und das Potenzial neuronaler Netze zu erhöhen. Man kann mit Fug und Recht behaupten, dass die derzeitige KI-Revolution ohne die vielen verfügbaren Transfer-Learning-Techniken nicht möglich gewesen wäre.

Das Feld entwickelt sich rasant weiter und es gibt einige Bereiche, die noch weiter erforscht werden müssen, z. B:

- Beispielhafte Effizienz. Wie viele Daten werden benötigt, damit ein Modell bei neuen Aufgaben wirksam wird? Dies ist eine zentrale Frage beim Meta-Lernen. Die Strategien des Short-Shot-Learnings zeigen zwar, dass ein Modell auch mit begrenzten Daten lernen kann, aber es gibt noch viel Spielraum für Verbesserungen, um die Modelle effizienter und vielseitiger zu machen.

- Aufgabenvielfalt. Meta-Lerntechniken funktionieren in der Regel besser, wenn die Aufgaben irgendwie miteinander verbunden sind. Weitere Forschungen sind jedoch unerlässlich, um Meta-Lernmodelle zu entwickeln, die über eine breite Palette von Aufgaben verallgemeinert werden können, ohne sich zu sehr anzupassen.

- Fortgeschrittene Techniken. Meta-Lernen ist ein zentraler Katalysator für Innovationen in einigen der vielversprechendsten und wertvollsten Technologien von heute, darunter Reinforcement Learning, Robotik und Transformatoren.

Fazit

Da die Modelle des maschinellen Lernens immer größer und komplexer werden, ist es für die KI-Branche von entscheidender Bedeutung, neue Techniken zu finden, um sie effizienter und vielseitiger zu machen, damit sie ihre Versprechen einhalten, die Zahlen funktionieren und die Nachhaltigkeit in der Branche voranbringen kann.

Meta-Lernen hat in dieser Hinsicht eine Menge zu sagen. Dieser Forschungsbereich entwickelt sich schnell weiter und bietet eine Reihe von Techniken und Strategien, die für die Weiterentwicklung der KI entscheidend sind. Bleib auf dem Laufenden mit DataCamp, um die neuesten Nachrichten in Sachen Meta Learning, KI und vielem mehr zu erfahren:

Ich bin freiberufliche Datenanalystin und arbeite mit Unternehmen und Organisationen auf der ganzen Welt an Data-Science-Projekten zusammen. Ich bin auch Ausbilder für Data Science mit mehr als 2 Jahren Erfahrung. Ich schreibe regelmäßig datenwissenschaftliche Artikel in englischer und spanischer Sprache, von denen einige auf etablierten Websites wie DataCamp, Towards Data Science und Analytics Vidhya veröffentlicht wurden. Als Datenwissenschaftlerin mit einem Hintergrund in Politik- und Rechtswissenschaften ist es mein Ziel, an der Schnittstelle von Politik, Recht und Technologie zu arbeiten und die Macht der Ideen zu nutzen, um innovative Lösungen und Erzählungen voranzutreiben, die uns dabei helfen können, dringende Herausforderungen wie die Klimakrise anzugehen. Ich betrachte mich als Autodidakt, der ständig lernt und ein überzeugter Verfechter der Multidisziplinarität ist. Es ist nie zu spät, neue Dinge zu lernen.

Meta Learning FAQs

Was ist Meta-Lernen?

Meta-Lernen als Teilgebiet des maschinellen Lernens konzentriert sich darauf, Modellen beizubringen, wie sie neue Aufgaben schnell und effizient lernen können. Es ist inspiriert von der Fähigkeit des Menschen, "das Lernen zu lernen".

Was sind die gängigsten Metalernstrategien?

Je nachdem, wie das Meta-Lernen umgesetzt wird, können wir drei Hauptansätze unterscheiden: modellbasiertes, metrikbasiertes und optimierungsbasiertes Meta-Lernen.

Was sind die Anwendungen des Meta-Lernens?

Einige der vielversprechendsten Anwendungen des Meta-Lernens in der KI sind das few-shot learning, das Transfer-Lernen, Empfehlungssysteme und das automatisierte maschinelle Lernen (AutoML).

Was ist der Unterschied zwischen Metalernen und Transferlernen?

Transfer-Lernen ist eine Technik, bei der ein Modell, das für eine Aufgabe trainiert wurde, als Ausgangspunkt für ein Modell für eine zweite Aufgabe verwendet wird. Dabei werden die vortrainierten Modellparameter der allgemeinen Aufgabe als Initialisierung für die Feinabstimmung der Modellparameter für die spezifische Aufgabe verwendet. Im Gegensatz dazu geht es beim Meta-Lernen darum, Strategien zu erlernen, mit denen ein Modell schnell an neue Aufgaben angepasst werden kann.

Was sind die Vorteile des Meta-Lernens?

Transferlernen ist eine großartige Optimierungstechnik, mit der die Trainingseffizienz und die Modellleistung erhöht, die Anpassungsfähigkeit und Wiederverwendbarkeit verbessert und die Betriebskosten gesenkt werden können.