Cours

De nos jours, de nombreux secteurs d'activité traitent de très grands ensembles de données de différents types. Le traitement manuel de toutes ces informations peut prendre beaucoup de temps et ne pas apporter de valeur ajoutée à long terme. De nombreuses stratégies, de la simple automatisation aux techniques d'apprentissage automatique, sont appliquées pour un meilleur retour sur investissement. Ce blog conceptuel abordera l'un des concepts les plus importants : la classification dans l'apprentissage automatique.

Nous commencerons par définir ce qu'est la classification dans l'apprentissage automatique avant de clarifier les deux types d'apprenants dans l'apprentissage automatique et la différence entre la classification et la régression. Ensuite, nous aborderons quelques scénarios du monde réel dans lesquels la classification peut être utilisée. Ensuite, nous présenterons les différents types de classification et nous nous plongerons dans quelques exemples d'algorithmes de classification. Enfin, nous vous proposerons des exercices pratiques sur la mise en œuvre de quelques algorithmes.

Devenez un scientifique ML

Qu'est-ce que la classification dans l'apprentissage automatique ?

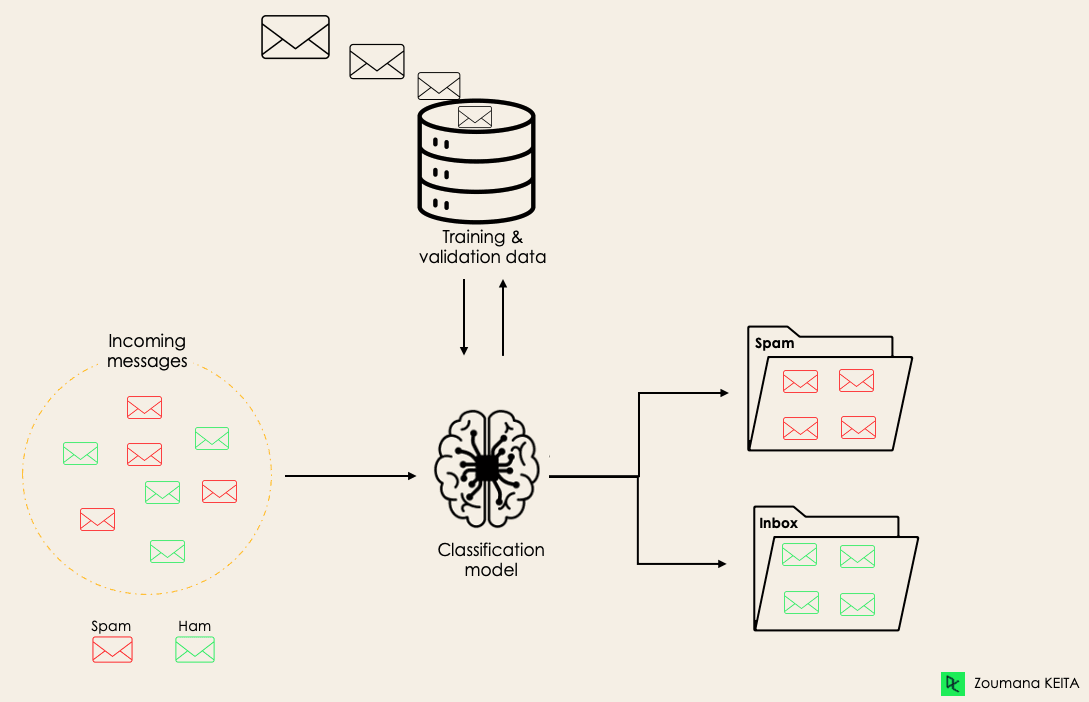

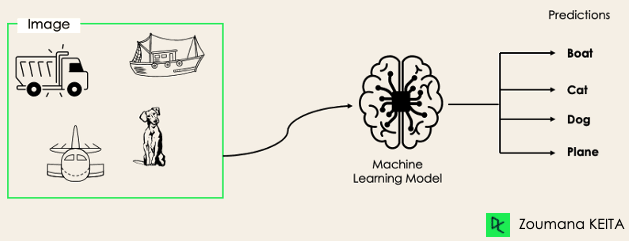

La classification est une méthode d'apprentissage automatique supervisée dans laquelle le modèle tente de prédire l'étiquette correcte d'une donnée d'entrée. Dans la classification, le modèle est entièrement formé à l'aide des données d'apprentissage, puis il est évalué sur des données de test avant d'être utilisé pour effectuer des prédictions sur de nouvelles données inédites.

Par exemple, un algorithme peut apprendre à prédire si un courriel donné est du spam ou du ham (pas de spam), comme illustré ci-dessous.

Avant de nous plonger dans le concept de classification, nous allons d'abord comprendre la différence entre les deux types d'apprenants dans la classification : les apprenants paresseux et les apprenants enthousiastes. Nous clarifierons ensuite l'erreur de conception entre la classification et la régression.

Avant de nous plonger dans le concept de classification, nous allons d'abord comprendre la différence entre les deux types d'apprenants dans la classification : les apprenants paresseux et les apprenants enthousiastes. Nous clarifierons ensuite l'erreur de conception entre la classification et la régression.

Apprenants paresseux contre apprenants paresseux. Des apprenants enthousiastes

Il existe deux types d'apprenants dans la classification de l'apprentissage automatique : les apprenants paresseux et les apprenants enthousiastes.

Les apprenants enthousiastes sont des algorithmes d'apprentissage automatique qui construisent d'abord un modèle à partir de l'ensemble de données d'apprentissage avant de faire des prédictions sur les futurs ensembles de données. Ils passent plus de temps au cours du processus de formation en raison de leur volonté d'obtenir une meilleure généralisation au cours de la formation grâce à l'apprentissage des poids, mais ils ont besoin de moins de temps pour faire des prédictions.

La plupart des algorithmes d'apprentissage automatique sont des apprenants enthousiastes, dont voici quelques exemples :

- Régression logistique.

- Machine à vecteur de support.

- Arbres de décision.

- Réseaux neuronaux artificiels.

Les apprenants paresseux ou les apprenants basés sur les instances, en revanche, ne créent pas de modèle immédiatement à partir des données d'apprentissage, et c'est de là que vient l'aspect paresseux. Ils se contentent de mémoriser les données d'apprentissage et, à chaque fois qu'il est nécessaire de faire une prédiction, ils recherchent le plus proche voisin à partir de l'ensemble des données d'apprentissage, ce qui les rend très lents lors de la prédiction. En voici quelques exemples :

- Voisin le plus proche (K-Nearest Neighbor).

- Raisonnement à partir de cas.

Toutefois, certains algorithmes, tels que BallTrees et KDTrees, peuvent être utilisés pour améliorer la latence de prédiction.

Classification par apprentissage automatique Vs. Régression

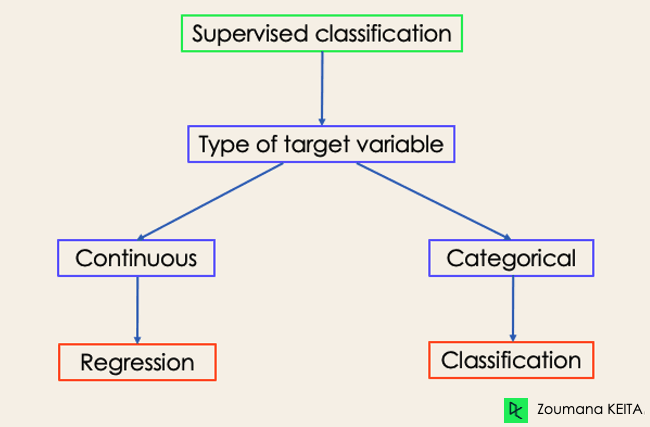

Il existe quatre grandes catégories d'algorithmes d'apprentissage automatique : supervisé, non supervisé, semi-supervisé et par renforcement.

Bien que la classification et la régression appartiennent toutes deux à la catégorie de l'apprentissage supervisé, elles ne sont pas identiques.

- La tâche de prédiction est une classification lorsque la variable cible est discrète. L'identification du sentiment sous-jacent d'un texte en est une application.

- La tâche de prédiction est une régression lorsque la variable cible est continue. Un exemple peut être la prédiction du salaire d'une personne en fonction de son diplôme, de son expérience professionnelle antérieure, de sa situation géographique et de son niveau d'ancienneté.

Si vous souhaitez en savoir plus sur la classification, des cours sur l' apprentissage supervisé avec scikit-learn et l'apprentissage supervisé en R pourraient vous être utiles. Ils vous permettent de mieux comprendre comment chaque algorithme aborde les tâches et les fonctions Python et R nécessaires à leur mise en œuvre.

En ce qui concerne la régression, Introduction à la régression en R et Introduction à la régression avec statsmodels en Python vous aideront à explorer différents types de modèles de régression ainsi que leur mise en œuvre en R et en Python.

classification par apprentissage automatique dans la vie réelle

classification par apprentissage automatique dans la vie réelle

Apprentissage automatique supervisé La classification a différentes applications dans de multiples domaines de notre vie quotidienne. Vous trouverez ci-dessous quelques exemples.

Soins de santé

La formation d'un modèle d'apprentissage automatique sur les données historiques des patients peut aider les spécialistes de la santé à analyser avec précision leurs diagnostics :

- Pendant la pandémie de COVID-19, des modèles d'apprentissage automatique ont été mis en œuvre pour prédire efficacement si une personne était atteinte ou non du COVID-19.

- Les chercheurs peuvent utiliser des modèles d'apprentissage automatique pour prédire les nouvelles maladies les plus susceptibles d'apparaître à l'avenir.

L'éducation

L'éducation est l'un des domaines où l'on trouve le plus de données textuelles, vidéo et audio. Ces informations non structurées peuvent être analysées à l'aide des technologies du langage naturel afin d'effectuer différentes tâches telles que :

- Le classement des documents par catégorie.

- Identification automatique de la langue sous-jacente des documents des étudiants lors de leur inscription.

- Analyse des sentiments des étudiants à l'égard d'un professeur.

Transport

Le transport est l'élément clé du développement économique de nombreux pays. En conséquence, les industries utilisent des modèles de machine et d'apprentissage profond :

- Prévoir quel lieu géographique connaîtra une augmentation du volume de trafic.

- Prévoir les problèmes potentiels qui peuvent survenir dans des lieux spécifiques en raison des conditions météorologiques.

Agriculture durable

L'agriculture est l'un des piliers les plus précieux de la survie de l'humanité. L'introduction de la durabilité peut contribuer à améliorer la productivité des agriculteurs à un niveau différent sans nuire à l'environnement :

- En utilisant des modèles de classification pour prédire quel type de terre convient à un type de semence donné.

- Prévoir les conditions météorologiques pour les aider à prendre des mesures préventives adéquates.

Différents types de tâches de classification dans l'apprentissage automatique

L'apprentissage automatique comporte quatre tâches principales de classification : les classifications binaires, multi-classes, multi-labels et déséquilibrées.

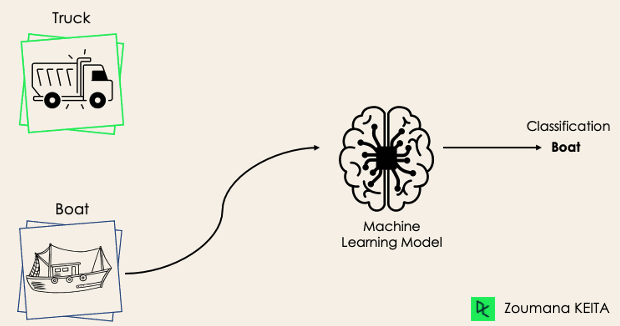

Classification binaire

Dans une tâche de classification binaire, l'objectif est de classer les données d'entrée dans deux catégories qui s'excluent mutuellement. Dans ce cas, les données d'apprentissage sont étiquetées dans un format binaire : vrai et faux ; positif et négatif ; O et 1 ; spam et non spam, etc. en fonction du problème abordé. Par exemple, nous pourrions vouloir détecter si une image donnée est un camion ou un bateau.

Les algorithmes de régression logistique et de machines à vecteurs de support sont conçus à l'origine pour les classifications binaires. Toutefois, d'autres algorithmes tels que les K-voisins les plus proches et les arbres de décision peuvent également être utilisés pour la classification binaire.

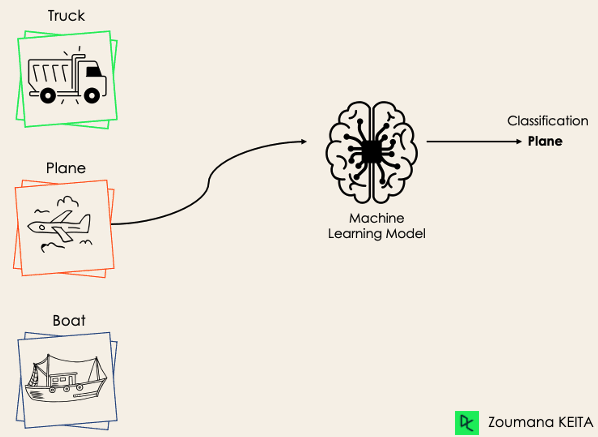

Classification multi-classes

La classification multi-classes, quant à elle, comporte au moins deux étiquettes de classe mutuellement exclusives, l'objectif étant de prédire à quelle classe appartient un exemple d'entrée donné. Dans le cas suivant, le modèle a correctement classé l'image comme étant un avion.

La plupart des algorithmes de classification binaire peuvent également être utilisés pour la classification multi-classes. Ces algorithmes comprennent, sans s'y limiter, les éléments suivants

- Forêt aléatoire

- Naive Bayes

- Voisins les plus proches (K-Nearest Neighbors)

- Renforcement du gradient

- SVM

- Régression logistique.

Mais attendez ! N'avez-vous pas dit que les SVM et la régression logistique ne prennent pas en charge la classification multi-classe par défaut ?

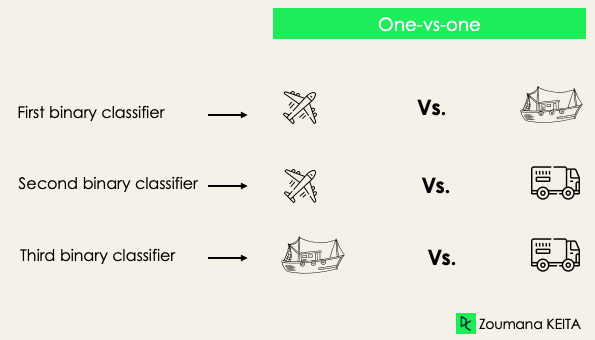

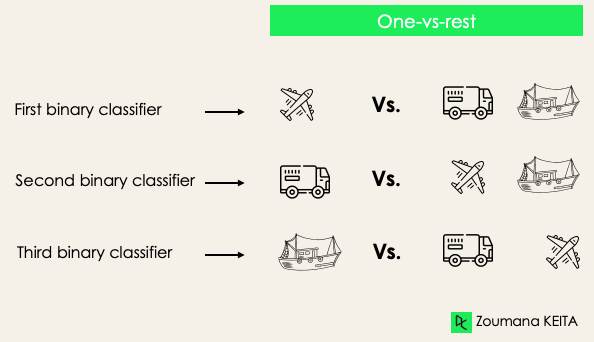

→ C'est exact. Cependant, nous pouvons appliquer des approches de transformation binaire telles que "un contre un" et "un contre tous" pour adapter les algorithmes de classification binaire natifs aux tâches de classification multi-classes.

Un contre un: cette stratégie permet de former autant de classificateurs qu'il y a de paires d'étiquettes. Si nous avons une classification à trois classes, nous aurons trois paires d'étiquettes, donc trois classificateurs, comme indiqué ci-dessous.

En général, pour N étiquettes, nous aurons Nx(N-1)/2 classificateurs. Chaque classificateur est formé sur un seul ensemble de données binaires et la classe finale est prédite par un vote majoritaire entre tous les classificateurs. L'approche un-vers-un fonctionne mieux pour les SVM et les autres algorithmes à noyau.

Un contre le reste: à ce stade, nous commençons par considérer chaque étiquette comme une étiquette indépendante et nous considérons le reste combiné comme une seule étiquette. Avec 3 classes, nous aurons trois classificateurs.

En général, pour N étiquettes, nous aurons N classificateurs binaires.

Classification multi-label

Dans les tâches de classification multi-labels, nous essayons de prédire 0 ou plusieurs classes pour chaque exemple d'entrée. Dans ce cas, il n'y a pas d'exclusion mutuelle car l'exemple d'entrée peut avoir plus d'une étiquette.

Un tel scénario peut être observé dans différents domaines, tels que l'étiquetage automatique dans le traitement du langage naturel, où un texte donné peut contenir plusieurs sujets. Comme dans le cas de la vision par ordinateur, une image peut contenir plusieurs objets, comme illustré ci-dessous : le modèle prédit que l'image contient : un avion, un bateau, un camion et un chien.

Il n'est pas possible d'utiliser des modèles de classification multi-classes ou binaires pour effectuer une classification multi-labels. Cependant, la plupart des algorithmes utilisés pour ces tâches de classification standard ont leurs versions spécialisées pour la classification multi-labels. Nous pouvons citer :

- Arbres de décision multi-labels

- Renforcement du gradient multi-label

- Forêts aléatoires multi-labels

Classification déséquilibrée

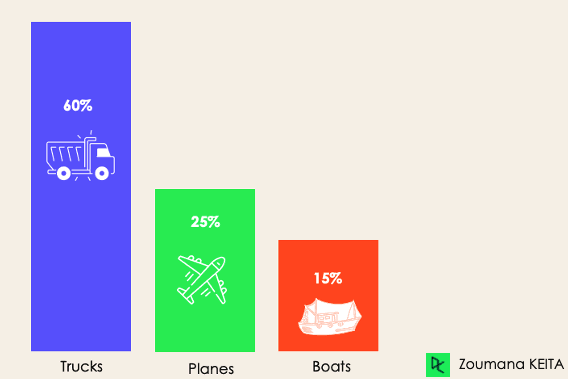

Pour la classification déséquilibrée, le nombre d'exemples est réparti de manière inégale dans chaque classe, ce qui signifie que les données d'apprentissage peuvent contenir plus d'exemples d'une classe que des autres. Considérons le scénario de classification à 3 classes suivant, dans lequel les données d'apprentissage contiennent : 60 % des camions, 25 % des avions et 15 % des bateaux.

Le problème de classification déséquilibrée peut se produire dans le scénario suivant :

- Détection des transactions frauduleuses dans les industries financières

- Diagnostic des maladies rares

- Analyse du taux d'attrition des clients

L'utilisation de modèles prédictifs conventionnels tels que les arbres de décision, la régression logistique, etc. pourrait ne pas être efficace dans le cas d'un ensemble de données déséquilibré, parce qu'ils pourraient être biaisés en prédisant la classe avec le plus grand nombre d'observations, et en considérant les classes avec moins d'observations comme du bruit.

Cela signifie-t-il que ces problèmes ne se posent plus ?

Bien sûr que non ! Nous pouvons utiliser plusieurs approches pour résoudre le problème du déséquilibre dans un ensemble de données. Les approches les plus couramment utilisées comprennent les techniques d'échantillonnage ou l'exploitation de la puissance des algorithmes sensibles aux coûts.

Techniques d'échantillonnage

Ces techniques visent à équilibrer la distribution de l'original par :

- Suréchantillonnage basé sur les grappes :

- Sous-échantillonnage aléatoire : élimination aléatoire des exemples de la classe majoritaire.

- SMOTE Oversampling : réplication aléatoire d'exemples de la classe minoritaire.

Algorithmes sensibles aux coûts

Ces algorithmes prennent en compte le coût des erreurs de classification. Ils visent à minimiser le coût total généré par les modèles.

- Arbres de décision sensibles aux coûts.

- Régression logistique sensible aux coûts.

- Machines à vecteurs de support sensibles aux coûts.

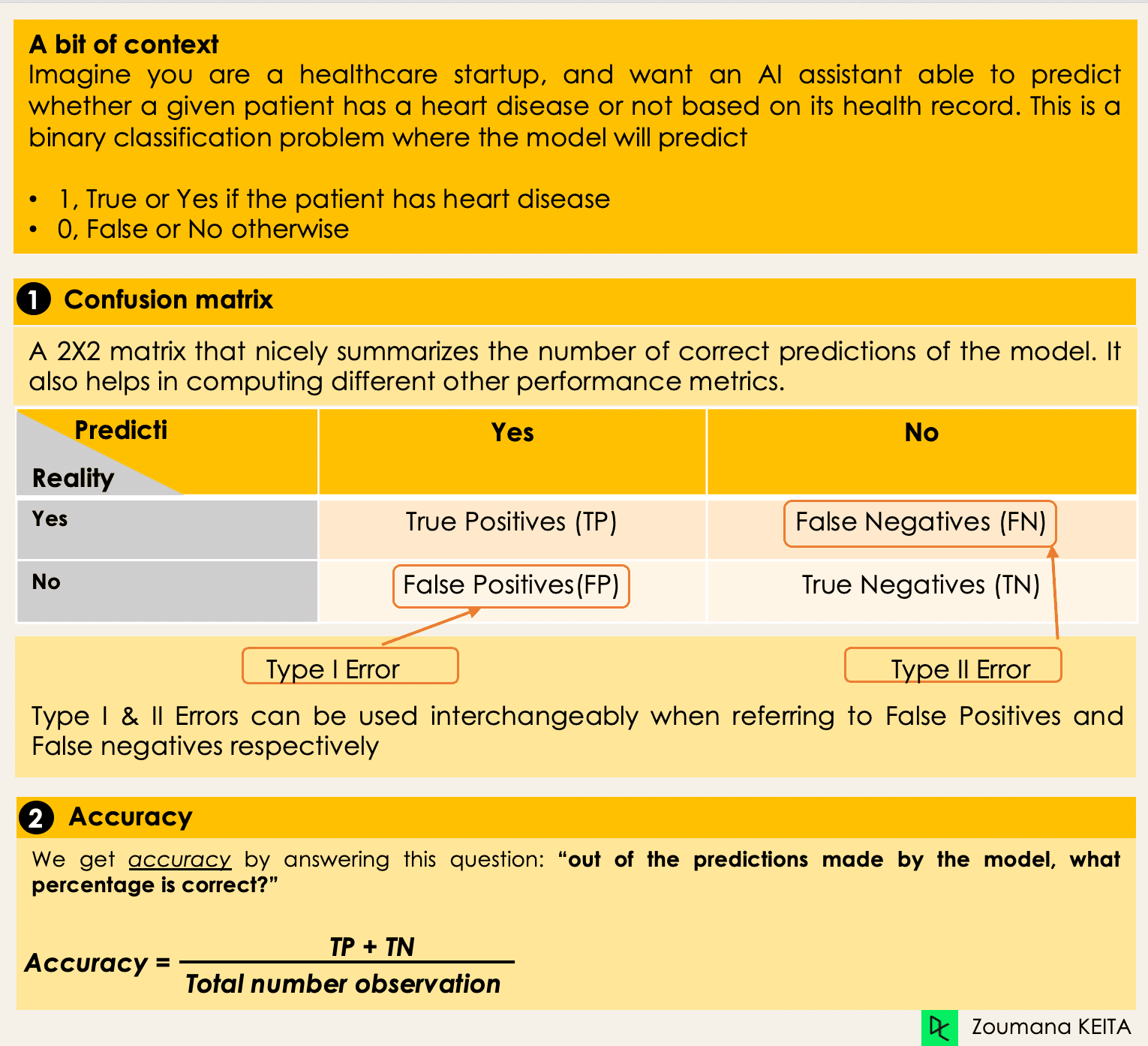

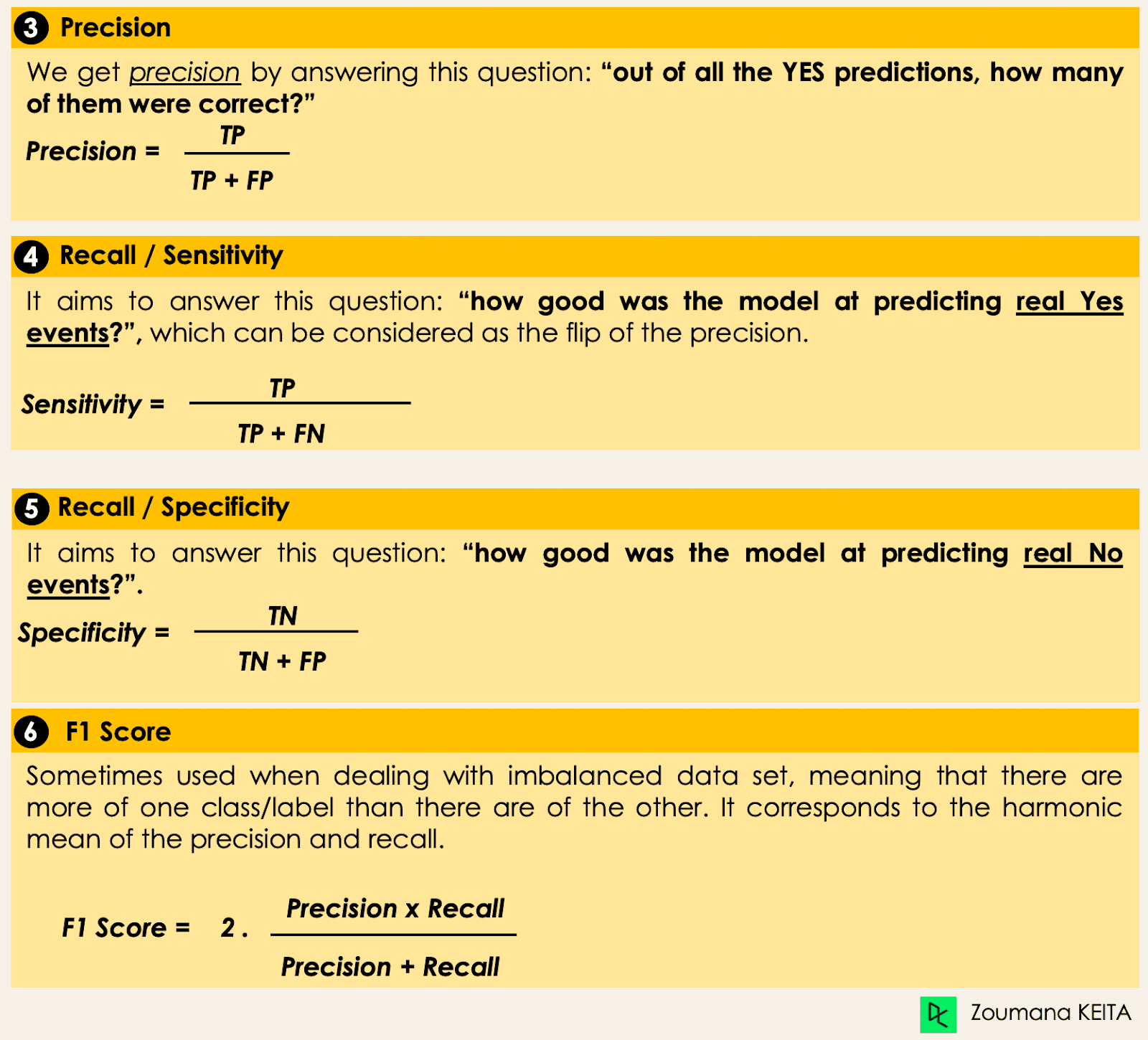

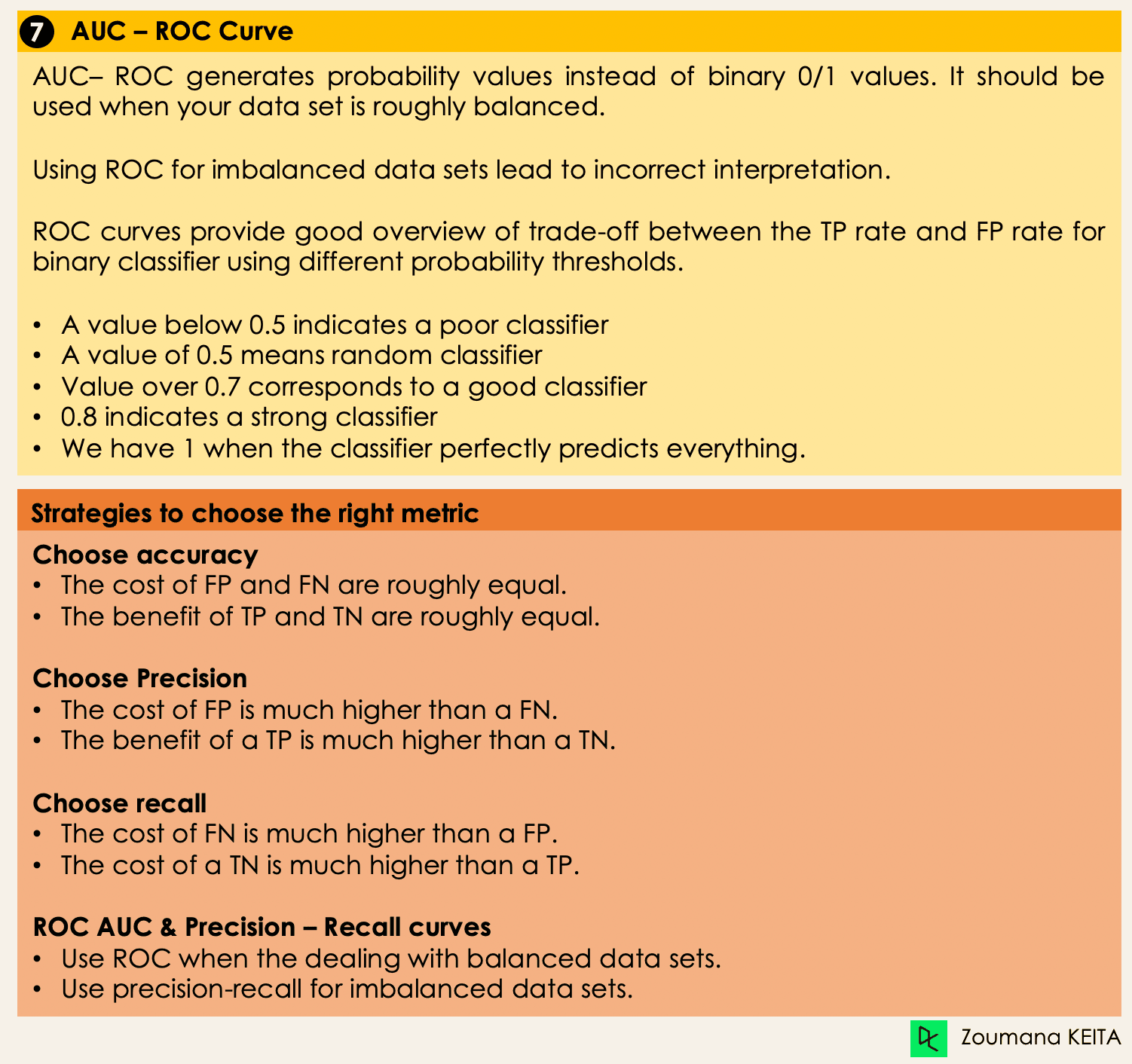

Métriques d'évaluation des algorithmes de classification par apprentissage automatique

Maintenant que nous avons une idée des différents types de modèles de classification, il est crucial de choisir les bonnes mesures d'évaluation pour ces modèles. Dans cette section, nous aborderons les mesures les plus couramment utilisées : exactitude, précision, rappel, score F1, aire sous la courbe ROC (Receiver Operating Characteristic) et AUC (Area Under the Curve).

Plongée dans les algorithmes de classification

Nous avons maintenant tous les outils en main pour procéder à la mise en œuvre de certains algorithmes. Cette section présente quatre algorithmes et leur mise en œuvre sur l' ensemble de données des prêts afin d'illustrer certains des concepts abordés précédemment, en particulier pour les ensembles de données déséquilibrés utilisant une tâche de classification binaire. Par souci de simplicité, nous nous concentrerons sur quatre algorithmes seulement.

L'objectif n'est pas d'obtenir le meilleur modèle possible, mais d'illustrer la manière d'entraîner chacun des algorithmes suivants. Le code source est disponible sur DataLab, où vous pouvez tout exécuter en un seul clic.

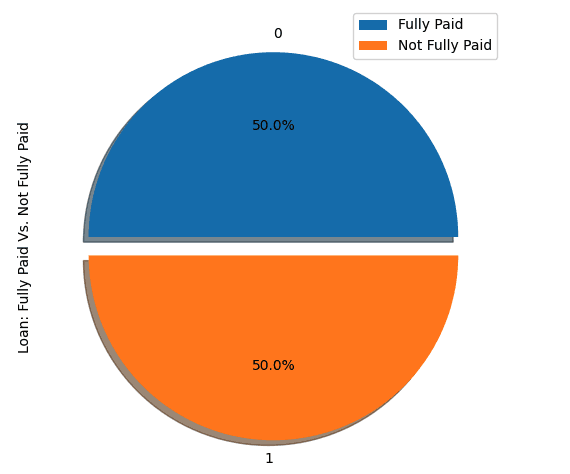

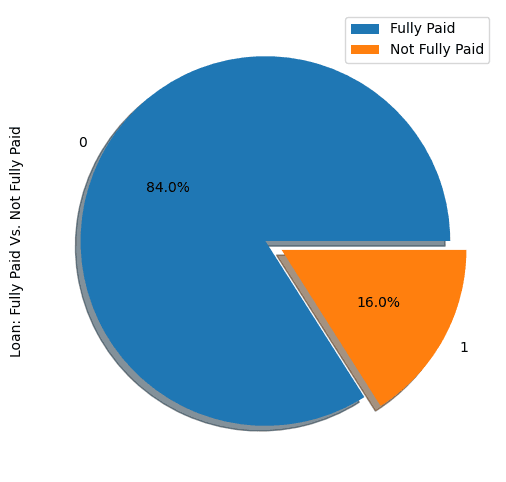

Répartition des prêts dans l'ensemble de données

- Examinez les cinq premières observations de l'ensemble de données.

import pandas as pd

loan_data = pd.read_csv("loan_data.csv")

loan_data.head()

- Profil des emprunteurs dans l'ensemble de données.

import matplotlib.pyplot as plt

# Helper function for data distribution

# Visualize the proportion of borrowers

def show_loan_distrib(data):

count = ""

if isinstance(data, pd.DataFrame):

count = data["not.fully.paid"].value_counts()

else:

count = data.value_counts()

count.plot(kind = 'pie', explode = [0, 0.1],

figsize = (6, 6), autopct = '%1.1f%%', shadow = True)

plt.ylabel("Loan: Fully Paid Vs. Not Fully Paid")

plt.legend(["Fully Paid", "Not Fully Paid"])

plt.show()

# Visualize the proportion of borrowers

show_loan_distrib(loan_data)

Le graphique ci-dessus montre que 84 % des emprunteurs ont remboursé leur prêt et que seuls 16 % ne l'ont pas remboursé, ce qui rend l'ensemble des données vraiment déséquilibré.

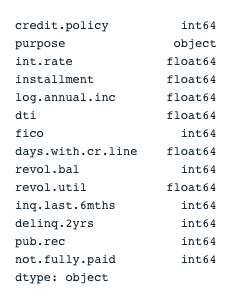

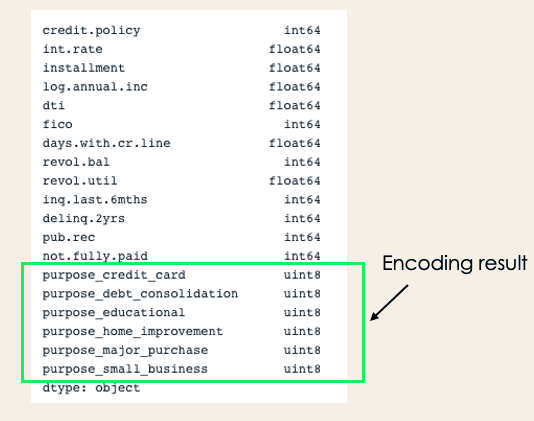

Types de variables

Avant d'aller plus loin, nous devons vérifier le type des variables afin d'encoder celles qui doivent l'être.

Nous remarquons que toutes les colonnes sont des variables continues, à l'exception de l'attribut " objet", qui doit être codé.

# Check column types

print(loan_data.dtypes)

encoded_loan_data = pd.get_dummies(loan_data, prefix="purpose",

drop_first=True)

print(encoded_loan_data.dtypes)Séparer les données en formation et en test

X = encoded_loan_data.drop('not.fully.paid', axis = 1)

y = encoded_loan_data['not.fully.paid']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.30,

stratify = y, random_state=2022)Application des stratégies d'échantillonnage

Nous étudierons ici deux stratégies d'échantillonnage : le sous-échantillonnage aléatoire et le suréchantillonnage SMOTE.

Sous-échantillonnage aléatoire

Nous sous-échantillonnerons la classe majoritaire, qui correspond à la classe "entièrement payée" (classe 0).

X_train_cp = X_train.copy()

X_train_cp['not.fully.paid'] = y_train

y_0 = X_train_cp[X_train_cp['not.fully.paid'] == 0]

y_1 = X_train_cp[X_train_cp['not.fully.paid'] == 1]

y_0_undersample = y_0.sample(y_1.shape[0])

loan_data_undersample = pd.concat([y_0_undersample, y_1], axis = 0)

# Visualize the proportion of borrowers

show_loan_distrib(loan_data_undersample)Suréchantillonnage SMOTE

Effectuer un suréchantillonnage sur la classe minoritaire

smote = SMOTE(sampling_strategy='minority')

X_train_SMOTE, y_train_SMOTE = smote.fit_resample(X_train,y_train)

# Visualize the proportion of borrowers

show_loan_distrib(y_train_SMOTE)Après avoir appliqué les stratégies d'échantillonnage, nous observons que l'ensemble des données est réparti de manière égale entre les différents types d'emprunteurs.

Application de certains algorithmes de classification par apprentissage automatique

Cette section applique ces deux algorithmes de classification à l'ensemble de données échantillonnées SMOTE smote. La même approche de formation peut être appliquée aux données sous-échantillonnées.

Régression logistique

Il s'agit d'un algorithme explicable. Il classe un point de données en modélisant sa probabilité d'appartenance à une classe donnée à l'aide de la fonction sigmoïde.

X = loan_data_undersample.drop('not.fully.paid', axis = 1)

y = loan_data_undersample['not.fully.paid']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.15, stratify = y, random_state=2022)

logistic_classifier = LogisticRegression()

logistic_classifier.fit(X_train, y_train)

y_pred = logistic_classifier.predict(X_test)

print(confusion_matrix(y_test,y_pred))

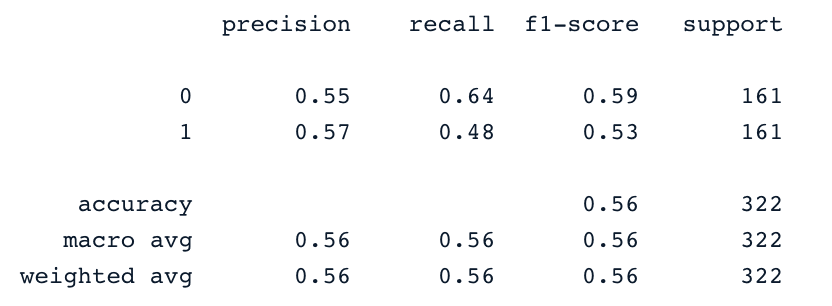

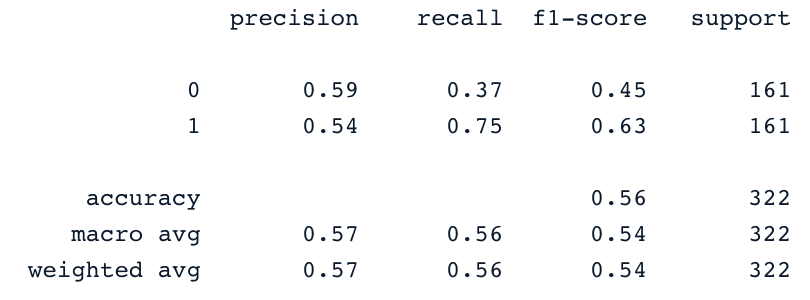

print(classification_report(y_test,y_pred))Machines à vecteurs de support

Cet algorithme peut être utilisé pour la classification et la régression. Il apprend à dessiner l'hyperplan (frontière de décision) en utilisant le principe de maximisation de la marge. Cette limite de décision est tracée à travers les deux vecteurs de soutien les plus proches.

Les SVM proposent une stratégie de transformation appelée "kernel tricks", utilisée pour projeter des données séparables non apprenantes dans un espace de dimension supérieure afin de les rendre linéairement séparables.

from sklearn.svm import SVC

svc_classifier = SVC(kernel='linear')

svc_classifier.fit(X_train, y_train)

# Make Prediction & print the result

y_pred = svc_classifier.predict(X_test)

print(classification_report(y_test,y_pred))

Ces résultats peuvent bien sûr être améliorés grâce à une ingénierie des caractéristiques plus poussée et à un réglage plus fin. Mais elles sont meilleures que l'utilisation des données déséquilibrées d'origine.

XGBoost

Cet algorithme est une extension d'un algorithme bien connu appelé arbres boostés par le gradient. Il s'agit d'un excellent candidat, non seulement pour lutter contre l'overfitting, mais aussi pour la vitesse et la performance.

Pour ne pas allonger le texte, vous pouvez vous référer à Machine Learning with Tree-Based Models in Python et Machine Learning with Tree-Based Models in R. Grâce à ces cours, vous apprendrez à utiliser Python et R pour mettre en œuvre des modèles basés sur les arbres.

Algorithmes et techniques de classification émergents

Au fur et à mesure de l'évolution de l'apprentissage automatique, de nouveaux algorithmes et techniques de classification sont apparus, offrant de meilleures performances, une plus grande évolutivité et une plus grande facilité d'interprétation. Nous examinerons ici certaines des avancées les plus notables qui ont gagné en popularité depuis 2022, notamment les transformateurs, les méthodes d'ensemble profondes et les techniques d'IA explicable (XAI).

1. Transformateurs pour la classification

Les transformateurs, conçus à l'origine pour des tâches de traitement du langage naturel telles que la traduction et la génération de textes, ont récemment été adaptés à diverses tâches de classification dans différents domaines. La principale innovation des transformateurs réside dans l'utilisation de mécanismes d'auto-attention, qui permettent aux modèles d'évaluer efficacement l'importance des différentes parties des données d'entrée.

- Transformateurs de vision (ViT): Les ViT ont révolutionné la classification des images en les traitant comme des séquences de taches, de la même manière que les mots sont traités dans un texte. Cette approche a permis d'obtenir des performances de pointe en matière de classification d'images.

- Transformateurs tabulaires: Ces modèles se sont également révélés prometteurs dans le traitement des données structurées, offrant une alternative aux méthodes traditionnelles telles que les forêts aléatoires et les machines à gradient de croissance pour les tâches de classification tabulaire.

Les transformateurs excellent dans le traitement de grands ensembles de données complexes et ont été largement adoptés dans des secteurs tels que les soins de santé, la finance et le commerce électronique pour des tâches telles que la reconnaissance d'images, la détection de la fraude et les systèmes de recommandation.

2. Méthodes d'ensemble profondes

Les méthodes d'ensemble profond combinent les prévisions de plusieurs modèles pour améliorer la robustesse, la précision et l'estimation de l'incertitude. En exploitant les points forts de différents modèles, ces méthodes peuvent souvent être plus performantes que les modèles individuels, en particulier dans les tâches de classification complexes.

- Empilage et mélange : Il s'agit de techniques d'ensemble traditionnelles dans lesquelles les prédictions de plusieurs classificateurs de base sont combinées à l'aide d'un méta-classificateur ou d'une moyenne pondérée. Des avancées récentes ont permis d'intégrer des modèles d'apprentissage profond dans ces ensembles, ce qui a donné lieu à des classificateurs plus puissants.

- Ensemble de réseaux neuronaux: Cette approche consiste à former plusieurs réseaux neuronaux avec des initialisations ou des architectures différentes et à calculer la moyenne de leurs prédictions. Elle s'est avérée efficace pour réduire les surajustements et améliorer la généralisation, en particulier dans des tâches difficiles telles que la classification des images et de la parole.

- Ensembles axés sur la diversité: Ces ensembles s'attachent à maximiser la diversité des modèles individuels afin de réduire la corrélation de leurs erreurs. Des techniques telles que le bagging, le boosting et la décorrélation des sorties ont été adaptées pour fonctionner avec des modèles d'apprentissage profond, fournissant des solutions robustes pour les ensembles de données déséquilibrés ou bruyants.

3. Techniques d'IA explicable (XAI)

Les modèles d'apprentissage automatique devenant de plus en plus complexes, le besoin d'interprétabilité et de transparence s'est accru. Des techniques d'IA explicable (XAI) ont été développées pour rendre le processus décisionnel des modèles de classification plus compréhensible pour les humains, ce qui est crucial pour gagner la confiance des systèmes d'IA, en particulier dans les domaines à fort enjeu tels que les soins de santé et la finance.

- SHAP (SHapley Additive exPlanations): Les valeurs SHAP fournissent une mesure unifiée de l'importance des caractéristiques en attribuant une valeur de contribution à chaque caractéristique d'une prédiction. Cette méthode est applicable à différents types de modèles, y compris les modèles d'apprentissage profond, et permet de comprendre quelles sont les caractéristiques qui influencent le plus les décisions du modèle.

- LIME (Local Interpretable Model-Agnostic Explanations): LIME explique les prédictions individuelles en approximant le modèle localement à l'aide d'un modèle interprétable. Cette technique est particulièrement utile pour comprendre des modèles complexes tels que les réseaux neuronaux et les machines à renforcement du gradient dans un contexte de classification.

- Explications contrefactuelles: Cette méthode consiste à trouver la plus petite modification des données d'entrée qui changerait le résultat de la classification. Il s'agit d'une approche pratique pour fournir des informations exploitables, par exemple dans le cadre de l'évaluation du crédit, où l'on peut vouloir savoir quels changements conduiraient à l'approbation d'un prêt.

Ces techniques XAI sont de plus en plus intégrées dans les modèles de classification non seulement pour améliorer la transparence, mais aussi pour se conformer aux exigences réglementaires, telles que le règlement général sur la protection des données (RGPD) en Europe, qui impose des explications pour les décisions automatisées.

Conclusion

Ce blog conceptuel a couvert l'aspect principal des classifications dans l'apprentissage automatique et vous a également fourni quelques exemples de différents domaines auxquels elles sont appliquées. Enfin, il couvre la mise en œuvre de la régression logistique et de la machine à vecteurs de support après avoir exécuté les stratégies de sous-échantillonnage et de suréchantillonnage SMOTE afin de générer un ensemble de données équilibré pour l'entraînement des modèles.

Nous espérons que cela vous a aidé à mieux comprendre le sujet de la classification dans l'apprentissage automatique. Vous pouvez approfondir votre apprentissage en suivant la filière Machine Learning Scientist with Python, qui couvre à la fois l'apprentissage supervisé, l'apprentissage non supervisé et l'apprentissage profond. Il constitue également une bonne introduction au traitement du langage naturel, au traitement des images, à Spark et à Keras.

Obtenez une certification de haut niveau en matière d'IA

FAQ sur la classification

Quels sont les différents types de noyaux dans les SVM ?

Les noyaux les plus courants dans les SVM sont le noyau linéaire, le noyau polynomial, le noyau gaussien, la fonction de base radiale (RBF), le noyau RBF de Laplace, le noyau sigmoïde, le noyau d'Anova, le noyau de la fonction de Bessel.

Pourquoi utiliser la classification ?

La classification est une méthode d'apprentissage automatique supervisée utilisée pour prédire l'étiquette correcte d'une donnée d'entrée.

Quels algorithmes peuvent être utilisés à la fois pour la régression et la classification ?

Nous pouvons utiliser les SVM et les réseaux neuronaux.

Quel est le meilleur algorithme pour la classification multiclasse ?

Il existe de nombreux algorithmes, mais les plus populaires sont les suivants : k-voisins les plus proches, arbres de décision, Naive Bayes, Random Forest et Gradient Boosting.

Quel algorithme de classification est le meilleur pour un petit ensemble de données ?

Lorsque vous travaillez avec de petits ensembles de données, la régression logistique, les SVM et les Naive Bayes ont tendance à mieux se généraliser.