Kurs

Machine Learning Operations (MLOps) hat sich zu einem der angesagtesten Bereiche in der Tech-Branche entwickelt. Da Datenteams immer öfter Machine-Learning-Modelle in Produktionsumgebungen einsetzen, wird der Bedarf an MLOps-Fachkräften weiter steigen.

Wenn du eine Karriere als MLOps-Ingenieur anstrebst, helfen wir dir gerne dabei, diesen Sprung zu schaffen!

In diesem Artikel zeigen wir dir die wichtigsten MLOps-Interviewfragen mit ausführlichen Erklärungen und Antworten, damit du dich gut auf dein bevorstehendes Vorstellungsgespräch vorbereiten kannst.

Was ist MLOps und warum ist es wichtig?

MLOps, kurz für Machine Learning Operations, ist ein Bereich, der maschinelles Lernen mit DevOps-Praktiken kombiniert, um den Lebenszyklus von Modellen für maschinelles Lernen zu optimieren und zu automatisieren.

Das Hauptziel von MLOps ist es, die Lücke zwischen Datenwissenschaft und IT-Betrieb zu schließen und sicherzustellen, dass Machine-Learning-Modelle effektiv entwickelt, effizient in Produktionsumgebungen eingesetzt, überwacht und gewartet werden.

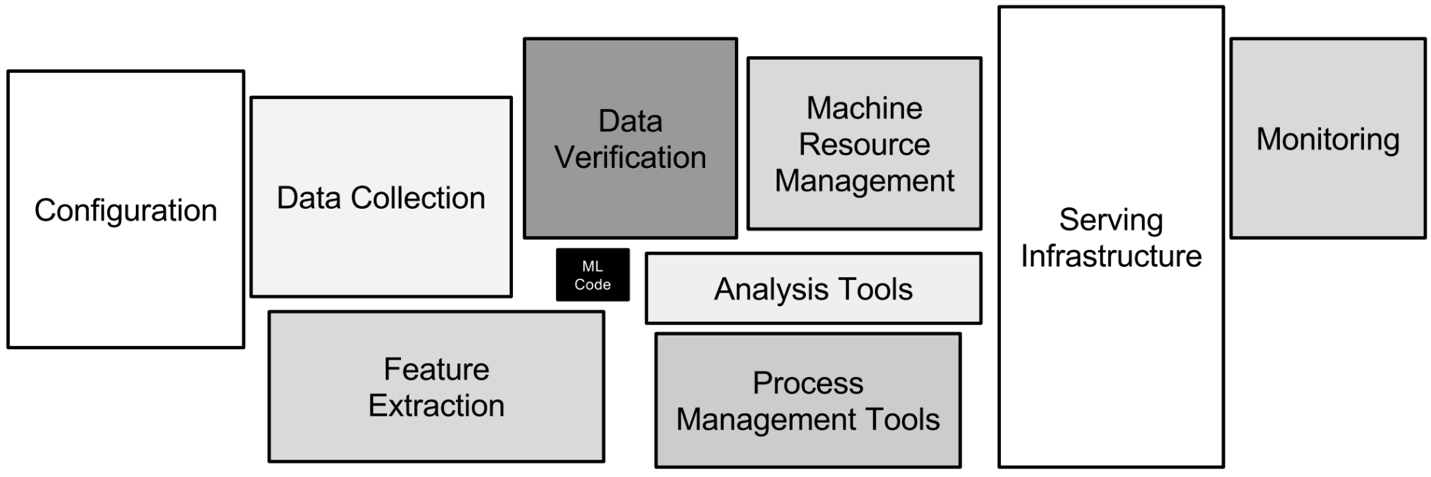

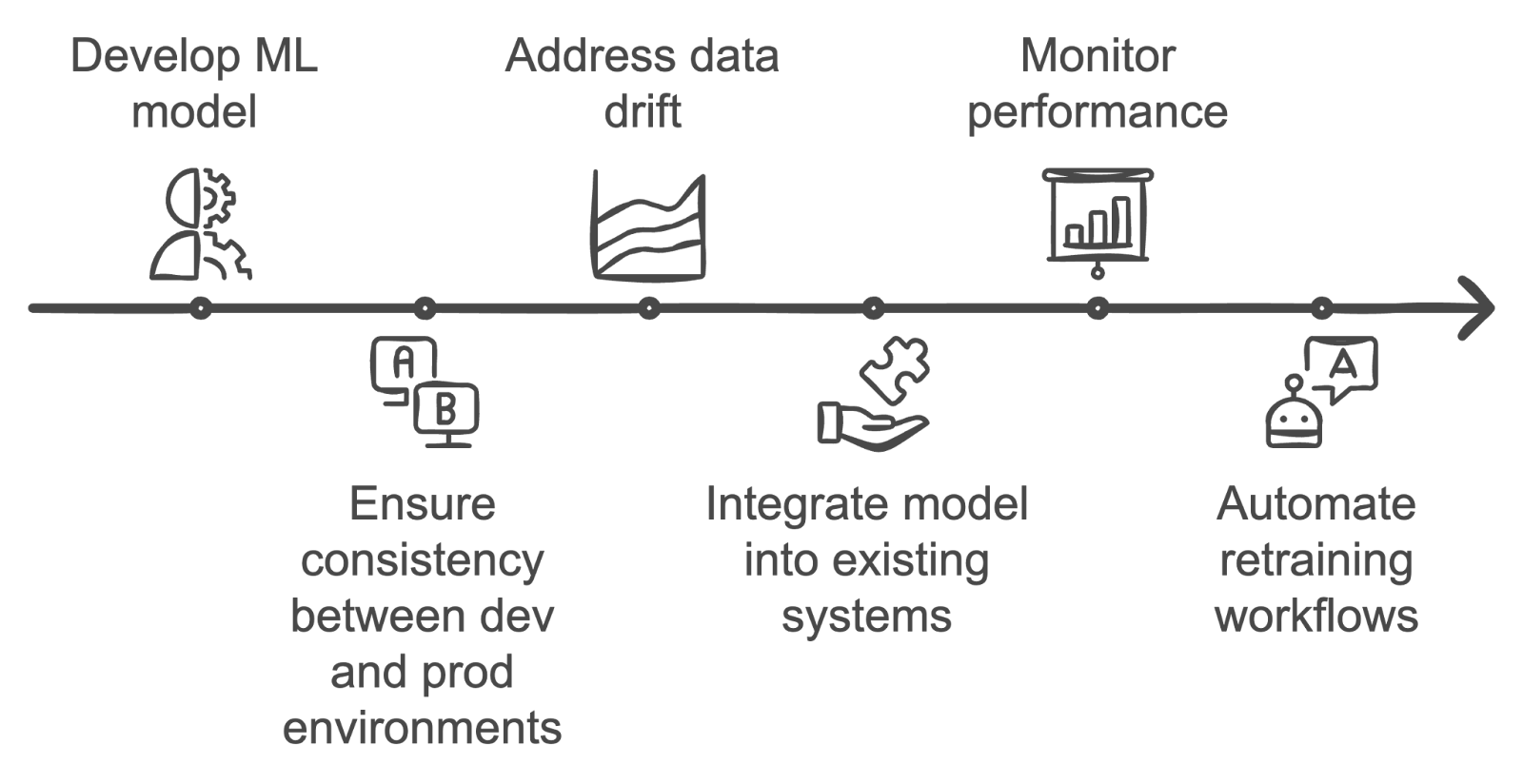

Die verschiedenen technischen Aspekte von MLOps. Bild vom Autor

Diese Aufgabe ist wichtig, weil sie es den Datenteams ermöglicht, Machine-Learning-Modelle in Produktionsumgebungen einzusetzen und gleichzeitig sicherzustellen, dass sie effektiv skaliert und gewartet werden können. Im Grunde genommen beschleunigt MLOps Innovationen, macht den Betrieb effizienter und hilft Firmen, das volle Potenzial ihrer datengesteuerten Initiativen auszuschöpfen.

Die für MLOps benötigten Fähigkeiten umfassen:

- Maschinelles Lernen: Verständnis von Modellentwicklung, -training und -bewertung.

- DevOps: Du kennst dich mit CI/CD-Pipelines, Infrastrukturautomatisierung und Überwachung aus.

- Datenverarbeitung: Kenntnisse in Datenpipelines, ETL-Prozessen und Datenspeicherlösungen.

- Programmierung: Gute Kenntnisse in Sprachen wie Python, R und ML-Frameworks wie TensorFlow, PyTorch.

- Cloud Computing: Du kennst dich mit Cloud-Plattformen wie AWS, GCP oder Azure aus.

Ja, ein MLOps-Ingenieur ist wie ein Einhorn! Und genau deshalb sind sie so gefragt und kriegen immer höhere Gehälter.

MLOps-Fähigkeiten heute aufbauen

Grundlegende MLOps-Interviewfragen

In diesem Abschnitt schauen wir uns grundlegende MLOps-Interviewfragen an, die dein Verständnis der Kernkonzepte und -prinzipien testen. Diese Fragen sollen dein Wissen über die grundlegenden Aufgaben und Herausforderungen von MLOps und deine Fähigkeit, dein Wissen effektiv zu vermitteln, testen.

Mach dich mit diesen Fragen vertraut, um eine solide Grundlage für fortgeschrittenere Themen zu schaffen und deine Kompetenz in diesem Bereich zu zeigen.

Was ist der Unterschied zwischen MLOps und DevOps?

Beschreibung: Diese Frage testet dein Verständnis der grundlegenden Unterschiede zwischen MLOps und DevOps, die oft verwechselt werden.

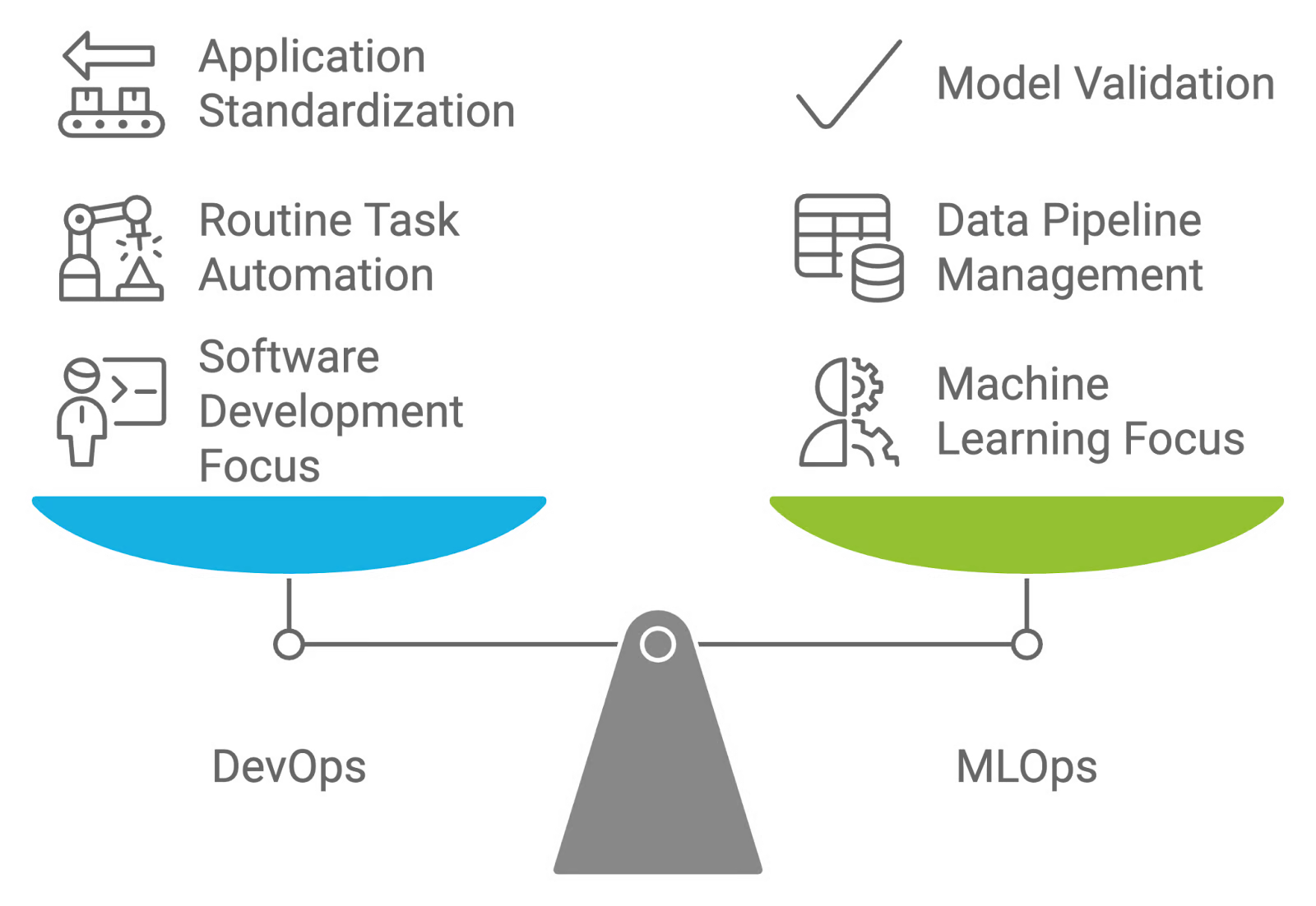

Antwort: MLOps und DevOps sind beide Strategien, bei denen Zusammenarbeit im Mittelpunkt steht, aber sie haben unterschiedliche Ziele. DevOps dreht sich um die Automatisierung der Entwicklung, des Testens und der Bereitstellung von Softwareanwendungen und standardisiert Umgebungen, um diese Prozesse zu optimieren.

Im Gegensatz dazu ist MLOps auf Machine-Learning-Workflows zugeschnitten und legt den Fokus auf die Verwaltung und Wartung von Datenpipelines und Modellen. Während DevOps darauf abzielt, Routineaufgaben zu automatisieren und die Anwendungsbereitstellung zu standardisieren, befasst sich MLOps mit dem experimentellen Charakter des maschinellen Lernens, einschließlich Aufgaben wie Datenvalidierung, Bewertung der Modellqualität und fortlaufende Modellvalidierung.

DevOps und MLOps vergleichen und gegenüberstellen. Bild vom Autor mit napkin.ai erstellt

Was ist Modell- oder Konzeptdrift?

Beschreibung: Diese Interviewfrage checkt, wie gut du weißt, wie sich Datenänderungen auf die Genauigkeit von Modellen auswirken und wie wichtig es ist, Modelle zu überwachen und zu aktualisieren.

Antwort: Modelldrift und Konzeptdrift sind Veränderungen in der Leistung von Modellen für maschinelles Lernen, die im Laufe der Zeit durch sich verändernde Datenmuster und zugrunde liegende Beziehungen entstehen:

- Modellabweichung: Das passiert, wenn ein Machine-Learning-Modell nicht mehr so gut funktioniert, weil die Daten, die es in der Praxis sieht, anders sind als die, mit denen es trainiert wurde. Das kann durch Änderungen in der Datenverteilung, den Merkmalen oder den Beziehungen zwischen Merkmalen und Zielvariablen passieren. Zum Beispiel könnte ein Modell, das mit alten Finanzdaten trainiert wurde, bei einer plötzlichen wirtschaftlichen Veränderung schlecht abschneiden.

- Konzept Drift: Das ist eine spezielle Art von Modelldrift, bei der sich die zugrunde liegende Verteilung oder Beziehung zwischen Eingabemerkmalen und Zielvariablen ändert. Diese Abweichung kann dazu führen, dass die Vorhersagen des Modells ungenauer werden, weil die Annahmen des Modells über die Daten nicht mehr stimmen. Wenn zum Beispiel ein Modell die Kundenabwanderung anhand von früheren Verhaltensmustern vorhersagt, muss es vielleicht angepasst werden, wenn sich das Kundenverhalten mit der Zeit stark ändert.

Welche Tests sollte man machen, bevor man ein ML-Modell in der Produktion einsetzt?

Beschreibung: Diese Interviewfrage checkt, wie gut du dich mit Testverfahren auskennst, um sicherzustellen, dass ein Machine-Learning-Modell zuverlässig ist und gut funktioniert, bevor es in einer Produktionsumgebung eingesetzt wird.

Antwort: Bevor ein ML-Modell in der Produktion eingesetzt wird, muss man verschiedene Tests machen. Diese Tabelle gibt einen guten Überblick über die verschiedenen Testarten, ihre Ziele ( ), die verwendeten Tools und wann sie im Entwicklungszyklus des maschinellen Lernens eingesetzt werden sollten:

|

Testtyp |

Ziel |

Verwendete Tools |

Wann man es benutzt |

|

Komponententests |

Überprüfe einzelne Modellkomponenten, wie Vorverarbeitungsschritte und Merkmalsextraktionsfunktionen. |

PyTest, unittest, scikit-learn (für Transformationen) |

Während der Entwicklung, wenn du Modellkomponenten einsetzt oder aktualisierst. |

|

Integrationstests |

Stell sicher, dass das Modell in der Produktionsumgebung richtig mit anderen Systemkomponenten und Datenquellen zusammenarbeitet. |

Docker, Kubernetes, Jenkins, Apache Kafka |

Nach dem Unit-Testing, wenn das Modell in einer produktionsähnlichen Umgebung eingesetzt wird. |

|

Leistungstests |

Schau dir die Genauigkeit, Präzision, den Recall und andere wichtige Kennzahlen des Modells mit einem Validierungsdatensatz an. |

Scikit-learn, TensorFlow, PyTorch, MLflow |

Nach den Integrationstests, um sicherzustellen, dass das Modell die erwarteten Leistungsstandards erfüllt. |

|

Stresstest |

Schau mal, wie das Modell mit hohen Lasten und großen Datenmengen klarkommt, um die Skalierbarkeit sicherzustellen. |

Apache JMeter, Locust, Dask |

Bevor du in Umgebungen mit viel Datenvolumen einsetzt oder wenn Skalierbarkeit wichtig ist. |

|

A/B-Test |

Vergleiche die Leistung des Modells mit bestehenden Modellen oder Basiswerten in einer Live-Umgebung. |

Optimizely, SciPy, Google Optimize |

Nach der Bereitstellung, wenn du die Leistung des Modells in der Produktion checkst und die Modellversionen optimierst. |

|

Robustheitstest |

Stell sicher, dass das Modell robust gegenüber Datenanomalien und Randfällen ist. |

Bibliotheken für Robustheit gegenüber Angriffen (z. B. CleverHans), benutzerdefinierte Skripte |

Nach den Leistungstests, um die Zuverlässigkeit unter ungewöhnlichen oder unerwarteten Bedingungen zu checken. |

Wie wichtig ist Versionskontrolle für MLOps?

Beschreibung: Diese Interviewfrage checkt, wie gut du die Rolle und Bedeutung der Versionskontrolle in MLOps-Praktiken verstehst. Es geht darum, wie das Verwalten verschiedener Versionen von Modellen, Daten und Code zu einer effektiven Modellbereitstellung und -wartung beiträgt.

Antwort: Versionskontrolle ist in MLOps echt wichtig, weil sie dabei hilft, Änderungen an Machine-Learning-Modellen, Datensätzen und Code während ihres ganzen Lebenszyklus zu verwalten und zu verfolgen. Mit Versionskontrollsystemen wie Git für Code und Tools wie DVC (Data Version Control) für Datensätze und Modelle kann man sicherstellen, dass alle Änderungen dokumentiert und rückgängig gemacht werden können.

Diese Vorgehensweise hilft dabei, Ergebnisse wiederholbar zu machen, erleichtert die Zusammenarbeit im Team und macht es einfacher, bei Problemen auf frühere Versionen zurückzugreifen. Es sorgt für Konsistenz und Zuverlässigkeit bei der Modellleistung, was wichtig ist, um hochwertige Bereitstellungen zu gewährleisten.

Wenn du mehr über dieses Konzept wissen willst, schau dir den vollständigen Leitfaden zur Datenversionskontrolle (DVC) an. Es bereitet dich auf solche Fragen während deines Vorstellungsgesprächs vor!

Wie kann man ML-Modelle verpacken?

Beschreibung: Diese Interviewfrage soll dein Wissen über verschiedene Methoden zum Verpacken von Machine-Learning-Modellen für den Einsatz checken. Es testet dein Verständnis dafür, wie man Modelle für die Integration in verschiedene Umgebungen und Anwendungen vorbereitet.

Antwort: Es gibt ein paar coole Möglichkeiten, Machine-Learning-Modelle zu packen:

- Container: Mit Tools wie Docker kann man Modelle zusammen mit ihren Abhängigkeiten und Umgebungseinstellungen in einen Container packen. Das sorgt dafür, dass das Modell auf verschiedenen Systemen und in verschiedenen Umgebungen immer gleich läuft.

- Serialisierungs-: Modelle können in Formate wie Pickle-Dateien (.pkl) für Python oder Joblib-Dateien umgewandelt werden. Diese Methode speichert das trainierte Modellobjekt, damit es später geladen und verwendet werden kann.

- Modellarchiv: Tools wie das SavedModel-Format von TensorFlow oder ONNX (Open Neural Network Exchange) bieten standardisierte Möglichkeiten zum Speichern von Modellen, sodass sie zwischen verschiedenen Frameworks und Plattformen kompatibel sind.

- APIs: Modelle als RESTful- oder gRPC-APIs einzusetzen, macht sie über das Netzwerk zugänglich. Dieser Ansatz packt das Modell in einen Dienst, der mit anderen Anwendungen zusammenarbeiten kann.

- Serverlose Funktionen: Plattformen wie AWS Lambda oder Google Cloud Functions können genutzt werden, um Modelle in serverlose Funktionen zu packen, was eine Ausführung nach Bedarf ermöglicht, ohne dass man sich um die Infrastruktur kümmern muss.

Eine super Möglichkeit, mehr über Verpackungsmodelle zu erfahren, ist, sich mit Containerisierung zu beschäftigen. Docker ist ein wichtiges Tool, das jeder MLOps-Ingenieur kennen sollte. Um dein Wissen aufzufrischen, schau dir den Kurs „Einführung in Docker“ an.

Warum ist Monitoring bei MLOps wichtig und welche Kennzahlen solltest du im Auge behalten?

Beschreibung: Diese Frage checkt, wie gut du dich mit Überwachungsmodellen in der Produktion auskennst und welche Metriken wichtig sind, um die Leistung und Zuverlässigkeit aufrechtzuerhalten.

Antwort: Überwachung ist bei MLOps super wichtig, damit die Modelle in der Produktion so laufen, wie man es erwartet. Zu den zu verfolgenden Kennzahlen gehören Genauigkeit, Präzision, Wiederauffindbarkeit und andere Leistungsindikatoren, um eine Verschlechterung des Modells zu erkennen.

Die Überwachung auf Datenabweichungen ist auch wichtig, weil Änderungen in den Datenmustern die Vorhersagen des Modells beeinflussen können. Außerdem helfen Infrastrukturkennzahlen wie Latenz und Ressourcennutzung (z. B. CPU, Speicher) dabei, dass das System skalierbar und reaktionsschnell bleibt.

Was sind ein paar typische Probleme bei der Bereitstellung von ML-Modellen?

Beschreibung: Diese Interviewfrage checkt, ob du potenzielle Hindernisse verstehst und wie man sie angeht, um eine erfolgreiche Modellimplementierung sicherzustellen.

Antwort: Häufige Probleme bei der Bereitstellung von ML-Modellen sind:

- Modellabweichung: Mit der Zeit kann die Leistung eines Modells durch Änderungen in Datenmustern oder Beziehungen nachlassen. Deshalb müssen die Modelle ständig überwacht und neu trainiert werden, damit sie genau bleiben.

- Datenqualität und Kompatibilität: Es ist echt wichtig, dass die Daten, die in der Produktion verwendet werden, genauso gut und im gleichen Format sind wie die Daten, die beim Training benutzt wurden. Unstimmige oder schlechte Daten können dazu führen, dass das Modell nicht richtig funktioniert.

- Skalierbarkeit: Modelle müssen unterschiedliche Lasten und große Datenmengen effizient verarbeiten können. Schlechte Infrastruktur oder nicht richtig optimierte Modelle können zu Performance-Problemen und langen Wartezeiten führen.

- Integrationsprobleme: Die Modelle müssen richtig in die bestehenden Systeme und Anwendungen eingebaut werden. Integrationsprobleme können durch unterschiedliche Datenformate, Schnittstellen oder die Kompatibilität der Infrastruktur entstehen.

- Sicherheit und Datenschutz: Es ist wichtig, dass Modelle und Daten vor unbefugtem Zugriff und Verstößen geschützt sind. Zu den Sicherheitsaspekten gehören der Schutz sensibler Daten und die Verwaltung von Zugriffskontrollen.

Alle Arbeitgeber suchen nach Leuten, die Probleme lösen können, vor allem wenn es um den Umgang mit Daten in einer Position wie MLOps geht. Um dich mit zwei super wichtigen Themen im Zeitalter des maschinellen Lernens vertraut zu machen, schau dir die Kurse „Einführung in die Datenqualität“ und „Einführung in die Datensicherheit“ an.

Was ist der Unterschied zwischen Canary- und Blue-Green-Bereitstellungsstrategien?

Beschreibung: Diese Interviewfrage checkt, ob du zwischen Canary- und Blue-Green-Bereitstellungsmethoden unterscheiden kannst und welche Vorteile sie für die Einführung neuer Änderungen haben.

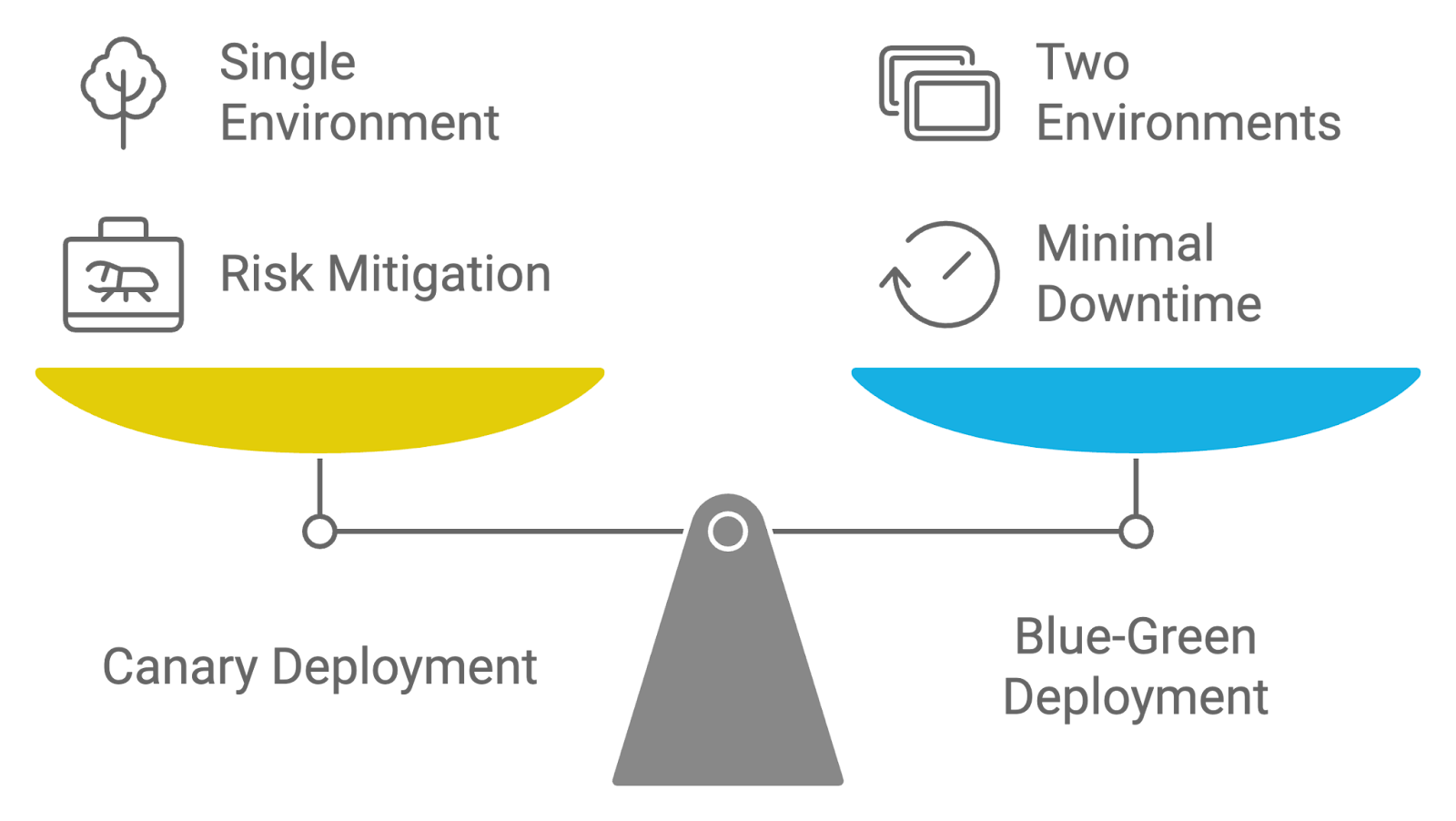

Antwort: Canary- und Blue-Green-Bereitstellungsstrategien werden beide benutzt, um die Einführung von Updates zu verwalten, aber sie haben unterschiedliche Ansätze:

- Canary-Bereitstellung: Bei dieser Strategie wird eine neue Version der Anwendung erst mal für eine kleine Gruppe von Nutzern freigegeben, bevor sie für alle Nutzer verfügbar gemacht wird. Der Begriff „Canary“ bedeutet, dass man eine kleine, repräsentative Probe nimmt, um die neue Version zu testen und zu sehen, wie sie läuft und was sie bewirkt. Wenn die neue Version gut läuft und keine großen Probleme auftauchen, wird sie nach und nach für alle anderen Nutzer freigegeben. Dieser Ansatz hilft dabei, Risiken zu minimieren, indem Teams Probleme frühzeitig erkennen und angehen können.

- Blau-Grün-Bereitstellung: Bei dieser Strategie werden zwei gleiche Produktionsumgebungen, die „Blue“ und „Green“ genannt werden, gepflegt. Immer ist eine Umgebung (z. B. Blau) aktiv und kümmert sich um den ganzen Datenverkehr, während die andere (z. B. Grün) im Leerlauf ist oder für die Bereitstellung genutzt wird. Wenn eine neue Version fertig ist, wird sie in der inaktiven Umgebung (Grün) bereitgestellt. Sobald die neue Version gründlich getestet und überprüft wurde, wird der Datenverkehr von der alten Umgebung (Blau) auf die neue (Grün) umgeschaltet. Dieser Ansatz reduziert Ausfallzeiten und ermöglicht ein schnelles Zurücksetzen, wenn Probleme auftreten.

Beide Strategien wollen die Risiken bei der Bereitstellung und Ausfallzeiten reduzieren, aber Canary-Bereitstellungen konzentrieren sich auf inkrementelle Releases und schrittweise Freigabe, während Blue-Green-Bereitstellungen für einen nahtlosen Wechsel zwischen den Umgebungen sorgen.

Vergleich von Bereitstellungsstrategien: Kanarienvogel gegen Blau-Grün. Bild vom Autor mit napkin.ai erstellt

Wie gehst du bei der Automatisierung des Modell-Retrainings in einer MLOps-Pipeline vor?

Beschreibung: Diese Frage testet dein Wissen über die Strategien und Tools, die verwendet werden, um die Umschulung von Modellen für maschinelles Lernen zu automatisieren, wenn neue Daten verfügbar werden.

Antwort: Um das erneute Trainieren von Modellen in MLOps zu automatisieren, muss man eine Pipeline einrichten, die das erneute Trainieren startet, wenn bestimmte Bedingungen erfüllt sind, wie zum Beispiel eine Leistungsverschlechterung oder wenn neue Daten da sind.

Tools wie Airflow oder Kubeflow können diese Abläufe organisieren und Aufgaben wie Datenerfassung, Feature Engineering, Modelltraining und Bewertung automatisch erledigen. Eine ständige Überwachung ist wichtig, um sicherzustellen, dass das Modell vor dem Einsatz die Leistungsschwellenwerte erfüllt. Versionierungstools wie DVC helfen dabei, verschiedene Modellversionen während des erneuten Trainings zu verfolgen.

Technische MLOps-Interviewfragen

In diesem Abschnitt schauen wir uns technische MLOps-Interviewfragen an, die deine praktischen Fähigkeiten und dein Verständnis für fortgeschrittene Konzepte testen.

Diese Fragen drehen sich um die technischen Aspekte beim Einsatz, der Verwaltung und Optimierung von Modellen für maschinelles Lernen und sollen zeigen, wie gut du mit den Tools, Techniken und Best Practices in diesem Bereich klarkommst.

Wie würdest du eine CI/CD-Pipeline für Machine-Learning-Modelle einrichten?

Beschreibung: Diese Frage testet dein Wissen über das Einrichten von CI/CD-Pipelines speziell für Machine-Learning-Workflows. Es checkt, wie gut du den Bereitstellungsprozess automatisieren und Modellaktualisierungen effizient verwalten kannst.

Antwort: Um CI/CD für Machine-Learning-Modelle einzusetzen, muss man Pipelines einrichten, die den Prozess von Codeänderungen bis zur Bereitstellung automatisch abwickeln.

Du kannst zum Beispiel Jenkins oder GitHub Actions nutzen, um Builds und Tests zu starten, wenn sich was am Modellcode oder an den Daten ändert. Die Pipeline umfasst Phasen wie:

- Build-: Den Code und die Modellartefakte zusammenstellen und verpacken.

- Test: Mach Unit-Tests, Integrationstests und Modellvalidierungsprüfungen.

- bereitstellen: Mach die Bereitstellung in Staging- oder Produktionsumgebungen automatisch.

- Monitor: Überwache die Leistung des Modells und die Daten ständig auf Anomalien.

Durch die Automatisierung dieser Schritte stellst du sicher, dass die Modelle mit minimalem manuellem Aufwand konsistent und zuverlässig aktualisiert werden.

Wenn du deine CI/CD-Kenntnisse verbessern willst, mach den Kurs „CI/CD für maschinelles Lernen”. Damit wirst du im Vorstellungsgespräch glänzen!

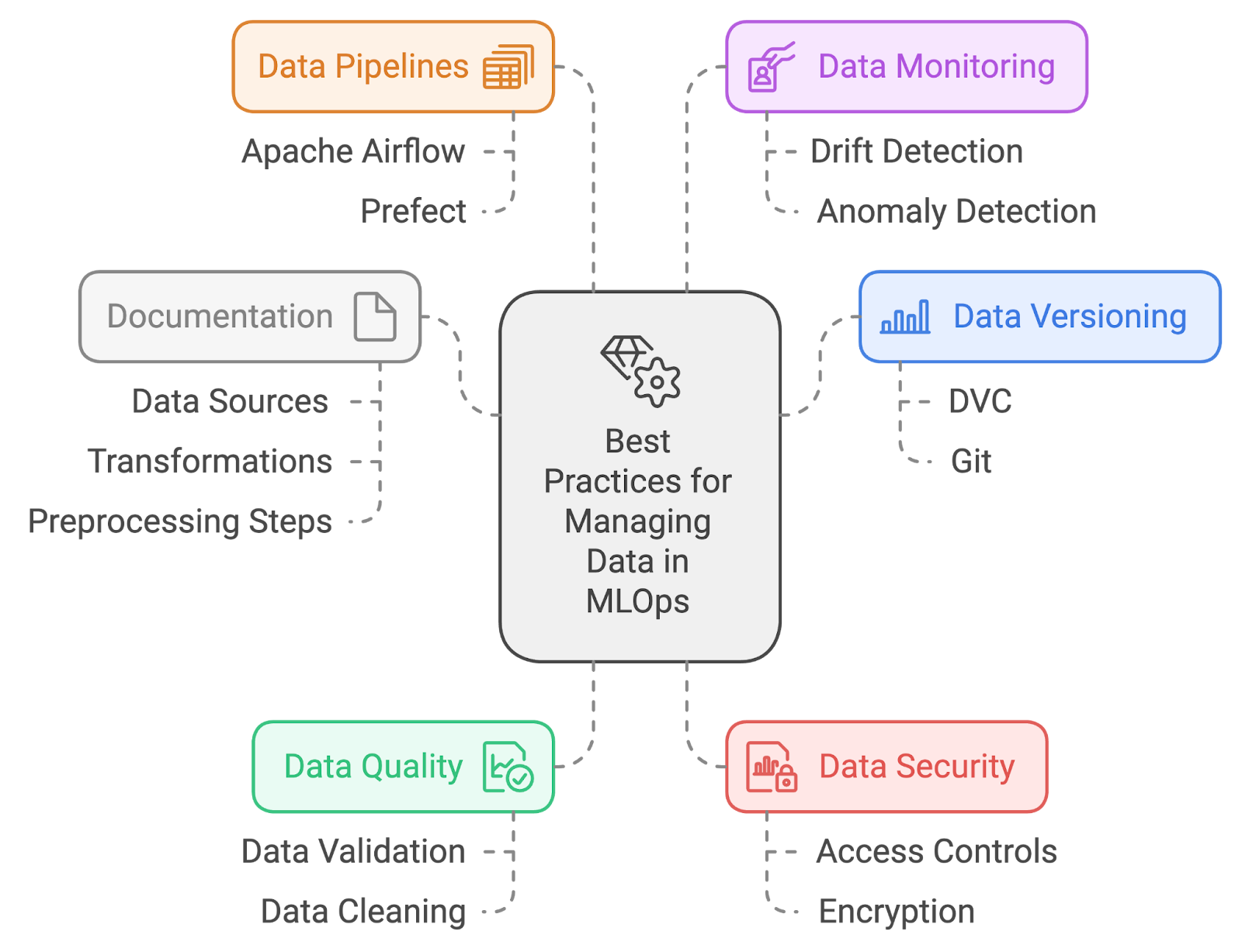

Was sind die besten Methoden für die Datenverwaltung in MLOps?

Beschreibung: Diese Interviewfrage dreht sich um dein Verständnis von effektiven Datenmanagementpraktiken innerhalb von MLOps. Es checkt, wie gut du mit Datenqualität, Versionierung und Organisation klarkommst, um robuste und zuverlässige Machine-Learning-Workflows zu unterstützen.

Antwort: Zu den besten Methoden für die Datenverwaltung in MLOps gehören:

- Datenversionierung: Benutz Tools wie DVC (Data Version Control) oder Git-LFS, um Änderungen an Datensätzen zu verfolgen und zu verwalten. Das sorgt für Reproduzierbarkeit und macht es einfach, bei Bedarf zu früheren Datenversionen zurückzukehren.

- Datenqualitäts: Mach strenge Datenvalidierungs- und -bereinigungsprozesse, um sicherzustellen, dass die Daten echt gut sind. Dazu gehört, vor dem Training der Modelle nach fehlenden Werten, Ausreißern und Unstimmigkeiten zu schauen.

- Datenschutz: Schütze sensible Daten, indem du Zugriffskontrollen und Verschlüsselung einsetzt. Sicher, dass die Datenschutzregeln eingehalten werden und dass niemand ohne Erlaubnis drauf zugreifen kann.

- Datenpipelines: Automatisiere die Datenerfassung, -vorverarbeitung und -umwandlung mit Tools wie Apache Airflow oder Prefect. So wird sichergestellt, dass die Daten immer gleich vorbereitet und für das Training und die Auswertung verfügbar sind.

- Datenüberwachungs: Überwache die Daten ständig auf Abweichungen und Anomalien. Mit Überwachungslösungen kann man besser sehen, wenn sich die Datenverteilung ändert, was die Leistung des Modells beeinflussen könnte.

- Dokumentation: Halte eine klare Dokumentation der Datenquellen, Transformationen und Vorverarbeitungsschritte bereit. Das macht die Wiederholbarkeit einfacher und hilft dabei, die Datenpipeline und ihre Auswirkungen auf die Modellergebnisse zu verstehen.

Die besten Methoden für die Datenverwaltung. Bild vom Autor mit napkin.ai erstellt

Wie gehst du mit Feature Engineering und Vorverarbeitung in einer MLOps-Pipeline um?

Beschreibung: Diese Frage schaut, wie du diese Prozesse in automatisierte Arbeitsabläufe einbaust.

Antwort: Bei der Feature-Engineering und Vorverarbeitung in einer MLOps-Pipeline geht's darum, diese Schritte zu automatisieren, damit alles konsistent und reproduzierbar bleibt. Du kannst Tools wie Apache Airflow oder Prefect nutzen, um Datenpipelines zu erstellen, die Aufgaben wie die folgenden erledigen:

- Datenbereinigung: Fehlende Werte und Ausreißer entfernen.

- Feature-Extraktion-: Neue Features aus Rohdaten machen.

- Normalisierungs: Skalierung der Funktionen auf einen einheitlichen Bereich.

- Transformations: Transformationen wie die Kodierung kategorialer Variablen anwenden.

Wie setzt man die Modellüberwachung in einer Produktionsumgebung um?

Beschreibung: Diese Frage checkt, wie gut du verstehst, wie man die Leistung und Zuverlässigkeit des Modells im Auge behält und sicherstellt, einschließlich der Tools und Strategien, die du für eine effektive Überwachung einsetzen würdest.

Antwort: Um die Modellüberwachung in einer Produktionsumgebung einzurichten, braucht man ein paar Vorgehensweisen, damit das Modell wie erwartet funktioniert und auch später zuverlässig bleibt:

- Definiere Leistungskennzahlen: Fang damit an, die wichtigen Kennzahlen zu finden, die zeigen, wie gut das Modell funktioniert, wie Genauigkeit, Präzision, Recall und Latenz. Diese Kennzahlen helfen dir bei der Überwachung und zeigen dir, wie gut das Modell funktioniert.

- Richte die Überwachungstools ein: Nutze Überwachungstools und -plattformen wie Prometheus und Grafana oder Cloud-native Lösungen, um diese Metriken in Echtzeit zu verfolgen und zu visualisieren. Mit dieser Konfiguration kannst du die Leistung des Modells ständig im Auge behalten.

- Alarme konfigurieren: Richte Warnmeldungen nach den Leistungskennzahlen ein. Lege Schwellenwerte fest, die Benachrichtigungen auslösen, wenn die Leistung des Modells nachlässt oder wenn Anomalien entdeckt werden, damit Probleme sofort angegangen werden können.

- Implementiere die Protokollierungs: Integriere eine umfassende Protokollierung, um detaillierte Infos über die Vorhersagen des Modells, Systeminteraktionen und eventuelle Fehler zu erfassen. Diese Infos sind echt wichtig, um Probleme zu lösen und das Verhalten des Modells zu verstehen.

- Analysiere und handle: Schau dir regelmäßig die gesammelten Leistungsdaten und Protokolle an, um Trends, Probleme oder Bereiche mit Verbesserungspotenzial zu erkennen. Nutze diese Analyse, um fundierte Entscheidungen über Anpassungen oder das erneute Trainieren des Modells zu treffen, damit es in der Produktion effektiv bleibt.

Der Kurs „Machine Learning Monitoring“ hilft dir dabei, solche Fragen genauer zu beantworten!

Wie stellst du sicher, dass Experimente im Bereich des maschinellen Lernens wiederholbar sind?

Beschreibung: Diese Frage geht darum, wie du sicherstellst, dass Experimente im Bereich maschinelles Lernen immer wieder gleich reproduziert werden können. Es checkt, wie gut du die Praktiken verstehst, die die Reproduzierbarkeit unterstützen.

Antwort: Die Reproduzierbarkeit von Machine-Learning-Experimenten sicherzustellen, bedeutet:

- Versionskontroll: Benutz Versionskontrollsysteme wie Git für Code und DVC für Daten, um Änderungen in Experimenten zu verfolgen und zu verwalten.

- Umweltmanagement: Benutz Tools wie Conda oder Docker, um einheitliche Entwicklungs- und Laufzeitumgebungen zu erstellen und zu verwalten.

- Zufallsgenerator-: Lege zufällige Startwerte für Algorithmen und Datensplits fest, um sicherzustellen, dass die Ergebnisse bei verschiedenen Durchläufen konsistent sind.

- Dokumentation: Halte alles genau fest, was du bei deinen Experimenten machst, wie die Einstellungen und Konfigurationen, damit man das Ganze nachmachen kann.

Was sind die Herausforderungen bei der Umsetzung von Modellen für maschinelles Lernen?

Beschreibung: Diese Frage checkt, wie gut du die besonderen Herausforderungen verstehst, die damit verbunden sind, wenn man Machine-Learning-Modelle von der Entwicklung in Produktionsumgebungen bringt.

Antwort: Die Umsetzung von Modellen für maschinelles Lernen bringt ein paar Herausforderungen mit sich. Eine der größten Herausforderungen ist es, die Konsistenz zwischen Entwicklungs- und Produktionsumgebungen sicherzustellen, was zu Problemen bei der Reproduzierbarkeit führen kann.

Ein weiteres Problem ist die Datenverschiebung, weil sich die Daten im Produktionsprozess mit der Zeit ändern können, was die Genauigkeit des Modells beeinträchtigt.

Außerdem ist es oft ziemlich kompliziert, Modelle in bestehende Systeme einzubauen, ihre Leistung zu checken und die Nachschulungsprozesse zu automatisieren. Das erfordert eine gute Zusammenarbeit zwischen den Teams für Datenwissenschaft und Technik.

Herausforderungen bei der Umsetzung von ML-Modellen meistern. Bild vom Autor mit napkin.ai erstellt

Wie setzt man das erneute Trainieren von Modellen in einer automatisierten MLOps-Pipeline um?

Beschreibung: Diese Frage checkt, wie gut du verstehst, wie man das erneute Trainieren von Modellen automatisiert, wenn neue Daten da sind oder die Leistung des Modells nachlässt.

Antwort: Um automatisiertes Modell-Retraining einzurichten, muss man eine Pipeline aufbauen, die die Modellleistung und Datenabweichungen im Auge behält. Wenn die Genauigkeit des Modells unter einen Schwellenwert fällt oder neue Daten da sind, können Tools wie Apache Airflow oder Kubeflow ein erneutes Training starten.

Beim Retraining werden neue Daten geholt, vorverarbeitet, das Modell mit denselben oder aktualisierten Hyperparametern trainiert und das neue Modell validiert. Nach dem erneuten Training wird das aktualisierte Modell automatisch in der Produktion eingesetzt.

Welche Tools benutzt du für die Erklärbarkeit von Modellen und warum ist das wichtig?

Beschreibung: Diese Frage testet dein Wissen über die Interpretierbarkeit von Modellen und wie du Transparenz bei Modellvorhersagen sicherstellst.

Antwort: Tools wie SHAP (SHapley Additive exPlanations) oder LIME (Local Interpretable Model-agnostic Explanations) sind echt beliebt, um Modelle verständlich zu machen.

Diese Tools helfen dabei, Modellvorhersagen aufzuschlüsseln, indem sie den Beitrag einzelner Merkmale zeigen. Erklärbarkeit ist bei MLOps echt wichtig, weil sie Vertrauen bei den Beteiligten schafft und sicherstellt, dass die Modelle den Vorschriften entsprechen, vor allem in Branchen wie dem Finanzwesen und dem Gesundheitswesen. Es hilft auch dabei, mögliche Verzerrungen oder datenbezogene Probleme innerhalb des Modells zu erkennen.

Fragen zum Thema Cloud und Infrastruktur MLOps für Vorstellungsgespräche

Dieser Abschnitt behandelt Interviewfragen, die sich auf Cloud- und Infrastrukturaspekte von MLOps konzentrieren. Diese Fragen checken, wie gut du dich mit dem Einsatz, der Verwaltung und der Skalierung von Machine-Learning-Modellen in Cloud-Umgebungen auskennst.

Wie setzt man ML-Modelle in der Cloud ein?

Beschreibung: Diese Frage checkt, wie gut du dich mit dem Einsatz von Machine-Learning-Modellen in einer Cloud-Umgebung auskennst. Es checkt, wie gut du Cloud-Plattformen, Bereitstellungsprozesse und Tools für die Verwaltung von Modellen in der Cloud verstehst.

Antwort: Um ML-Modelle auf der Cloud einzusetzen, musst du diese Schritte machen:

- Modellverpackung: Pack das Modell zusammen mit seinen Abhängigkeiten und Konfigurationen ein.

- Hochladen und Bereitstellungs: Lade das Paket auf eine Cloud wie AWS SageMaker, Google AI Platform oder Azure Machine Learning hoch. Benutz die Bereitstellungstools des Dienstes, um einen Endpunkt oder Dienst für den Modellzugriff zu erstellen.

- Konfigurations: Richte die automatische Skalierung ein, um unterschiedliche Auslastungen zu bewältigen, und konfiguriere Sicherheitsmaßnahmen wie Zugriffskontrollen und Verschlüsselung.

- Überwachungs: Beobachte die Leistung des Modells ständig mit Cloud-basierten Tools, um sicherzustellen, dass es die Leistungsziele erreicht, und um Probleme frühzeitig zu erkennen.

Was sind die Vorteile und Herausforderungen von serverlosen Architekturen für die Bereitstellung von ML-Modellen?

Beschreibung: Diese Frage geht darum, wie man Serverless Computing versteht und wie man es bei der Bereitstellung von ML-Modellen anwendet, und schaut, ob man die Vorteile gegen die Herausforderungen abwägen kann.

Antwort: Serverlose Architekturen haben ein paar Vorteile, wie zum Beispiel weniger Aufwand beim Betrieb, weil man sich nicht um die Server kümmern muss, und automatische Skalierung je nach Bedarf in Echtzeit, was zu Kostenersparnissen führen kann, weil die Gebühren auf der tatsächlichen Rechenleistung basieren.

Allerdings gibt es auch Probleme mit serverlosen Architekturen. Zum Beispiel gibt's Einschränkungen bei der Ausführungszeit und der Ressourcenzuteilung, die vielleicht nicht für alle Arten von ML-Modellen passen, vor allem nicht für die mit hohem Rechenaufwand.

Auch die Latenz bei Kaltstarts kann ein Problem sein, weil erste Anfragen nach einer längeren Pause zu Verzögerungen führen können. Trotz dieser Herausforderungen können serverlose Architekturen für bestimmte Workloads sehr effektiv sein, wenn diese Faktoren richtig gehandhabt werden.

Eine andere Möglichkeit, das zu zeigen, ist diese Tabelle, die die Vor- und Nachteile von serverlosen Architekturen anhand bestimmter Aspekte zusammenfasst:

|

Aspekt |

Vorteile von Serverless |

Nachteile von Serverless |

|

Betriebskosten |

Keine Serververwaltung nötig; weniger komplizierte Infrastruktur. |

Man braucht Kenntnisse über Cloud-Plattformen, um serverlose Umgebungen zu verwalten. |

|

Skalierung |

Die automatische Skalierung richtet sich nach dem Echtzeitbedarf, was zu Kosteneffizienz führt. |

Kann bei häufigen Skalierungen für die Budgetplanung unvorhersehbar sein. |

|

Kosteneffizienz |

Zahle nur für die Ressourcen, die du wirklich nutzt, und spare so vielleicht Kosten. |

Kann teuer werden, wenn viele Funktionen oft oder für längere Zeit genutzt werden. |

|

Ausführungslimits |

Perfekt für leichte oder kurze Aufgaben. |

Wegen der begrenzten Ausführungszeit und Ressourcenzuteilung kann es sein, dass ressourcenintensive ML-Modelle nicht gut funktionieren. |

|

Kaltstart |

Reduziert die Betriebskosten durch bedarfsgerechte Skalierung. |

Nach einer längeren Pause kann es zu Verzögerungen beim Kaltstart kommen, was sich auf Anwendungen auswirkt, die auf kurze Reaktionszeiten angewiesen sind. |

|

Eignung des ML-Modells |

Funktioniert gut für kleinere ML-Aufgaben, Inferenz oder Stapelverarbeitung. |

ML-Modelle, die viel Rechenleistung brauchen und lange laufen, sind nicht so gut geeignet. |

Wie schaffst du es, die Rechenressourcen für das Training von ML-Modellen in einer Cloud-Umgebung zu verwalten?

Beschreibung: Diese Frage checkt deine Strategien zur Optimierung und Verwaltung von Rechenressourcen beim Training von ML-Modellen in der Cloud. Es checkt, wie gut du Cloud-Ressourcen effizient nutzen kannst.

Antwort: Das Verwalten von Rechenressourcen umfasst:

- Instanzauswahl: Such dir die passenden Instanztypen (z. B. GPUs oder TPUs) je nach Trainingsanforderungen aus.

- Automatische Skalierung: Nutze Cloud-Funktionen, um Ressourcen dynamisch an die Anforderungen der Arbeitslast anzupassen.

- Kostenmanagement: Mach kostensparende Sachen, wie zum Beispiel Spot-Instanzen oder vorübergehende VMs zu nutzen.

- Überwachung und Optimierung: Schau dir regelmäßig an, wie die Ressourcen genutzt werden, zum Beispiel mit AWS CloudWatch oder Google Cloud Monitoring, und passe die Einstellungen an, je nachdem, wie die Leistung ist und was es kostet.

Wie stellst du die Datensicherheit und Compliance sicher, wenn du ML-Modelle in der Cloud einsetzt?

Beschreibung: Diese Frage geht darum, wie man bei der Nutzung von ML-Modellen in Cloud-Umgebungen die Datensicherheit und Compliance sicherstellt, mit Fokus auf bewährte Verfahren und gesetzliche Anforderungen.

Antwort: Datensicherheit und Compliance sicherstellen bedeutet:

- Verschlüsselungs: Verschlüsseln Sie Daten sowohl im Ruhezustand als auch während der Übertragung mithilfe von Cloud-Anbieterdiensten.

- Zugangskontroll: Mach strenge Identitäts- und Zugriffsmanagementrichtlinien, um den Zugriff einzuschränken.

- Regelmäßige Audits: Mach Sicherheits-Audits und Compliance-Checks, um Vorschriften wie die DSGVO oder HIPAA einzuhalten.

- Laufende Überwachung: Nutze Cloud-Sicherheitstools für die ständige Überwachung und Erkennung von Bedrohungen.

- Tipps und Tricks: Bleib auf dem Laufenden über die neuesten Sicherheitsempfehlungen und Richtlinien von Cloud-Anbietern.

Sicherheit und Compliance sind vielleicht das Letzte, worüber ein Ingenieur nachdenken will, aber sie werden immer wichtiger. Der Kurs „Understanding GDPR“ (Die DSGVO verstehen) und die anderen Kurse, die in diesem Artikel vorgeschlagen werden, sollten dir helfen, dich schnell zurechtzufinden.

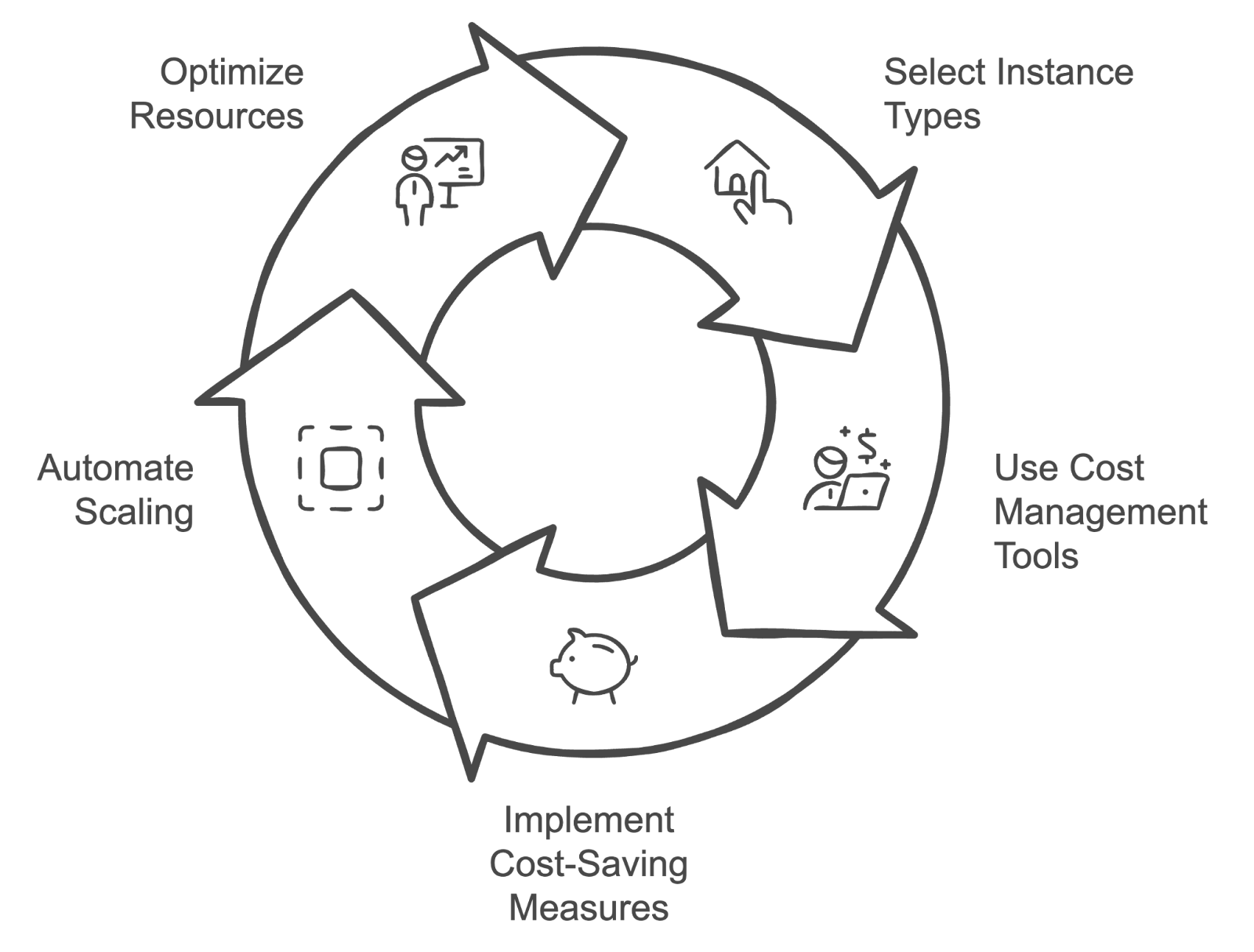

Welche Strategien nutzt du, um die Kosten der Cloud für das Training und die Bereitstellung von ML-Modellen zu verwalten?

Beschreibung: Diese Frage geht um Strategien, wie man die Cloud-Kosten für das Training und die Bereitstellung von ML-Modellen verwalten und optimieren kann, und testet, wie gut du dich mit Kostenmanagementtechniken auskennst.

Antwort: Strategien zur Verwaltung von Cloud-Kosten umfassen:

- Instanzauswahl: Such dir die richtigen Instanztypen und -größen aus, die zu deiner Arbeitslast passen, und vermeide Überprovisionierung.

- Tools für das Kostenmanagement: Nutze Tools wie AWS Cost Explorer oder Google Cloud Billing (wenn du diese Plattformen nutzt), um deine Ausgaben zu verfolgen und zu analysieren.

- Kostensparende Maßnahmen: Mach kostensparende Sachen wie reservierte Instanzen oder Spot-Instanzen.

- Automatische Skalierung: Nutze automatische Skalierung, um die Ressourcennutzung an den Bedarf anzupassen.

- Ressourcenoptimierung: Überprüfe und passe die Ressourcenzuteilung regelmäßig anhand von Leistungskennzahlen und Kostendaten an, um die Kosteneffizienz sicherzustellen.

Cloud-Kostenmanagement-Zyklus. Bild vom Autor mit napkin.ai erstellt

Was ist der Unterschied zwischen Edge- und Cloud-Bereitstellung in MLOps?

Beschreibung: Diese Frage geht darum, wie du die Vor- und Nachteile von Modellen auf Edge-Geräten im Vergleich zur Cloud verstehst.

Antwort: Bei der Cloud-Bereitstellung werden Modelle auf zentralen Servern ausgeführt, was Skalierbarkeit und einfachere Wartung bietet, aber auch potenzielle Latenzprobleme mit sich bringt.

Beim Edge-Deployment werden Modelle direkt auf Geräten wie Smartphones oder IoT-Geräten ausgeführt, was die Latenz reduziert und den Datenschutz verbessert, aber durch die Rechenressourcen eingeschränkt sein kann. Edge-Bereitstellung ist super für Echtzeit-Verarbeitungsanwendungen, während Cloud-Bereitstellung besser für Modelle ist, die viel Rechenleistung und Flexibilität brauchen.

Wie stellst du sicher, dass ML-Modelle in der Produktion immer verfügbar und fehlertolerant sind?

Beschreibung: Diese Frage checkt, wie gut du dich mit dem Aufbau robuster Systeme für den Einsatz von Machine-Learning-Modellen auskennst.

Antwort: Um eine hohe Verfügbarkeit zu haben, muss man Modelle über mehrere Verfügbarkeitszonen oder Regionen verteilen und automatische Failover-Mechanismen einrichten.

Lastenausgleicher können den Datenverkehr verteilen, um Engpässe zu vermeiden. Für die Fehlertoleranz können regelmäßige Backups, Redundanz und Zustandsprüfungen Systemausfälle verhindern. Die Nutzung von Cloud-Diensten wie AWS Elastic Load Balancing und Autoscaling-Funktionen hilft auch dabei, sicherzustellen, dass bei Ausfall einer Instanz andere ohne Ausfallzeiten übernehmen können.

Fragen zum Thema Verhalten und Problemlösung im Bereich MLOps

In diesem Abschnitt geht's um Verhaltensweisen und Problemlösungsansätze bei MLOps. Wir schauen uns an, wie die Kandidaten mit echten Herausforderungen umgehen, mit Teams zusammenarbeiten und verschiedene Probleme beim Einsatz und Management von Machine-Learning-Modellen lösen.

Erzähl mal von einer Situation, in der du ein Problem mit einem Modell in der Produktion lösen musstest. Was hast du gemacht?

Beschreibung: Diese Frage checkt, wie gut du Probleme in echten Situationen lösen kannst.

Beispielantwort: Es gab mal eine Situation, wo ein Modell, das in der Produktion eingesetzt wurde, plötzlich einen deutlichen Leistungsabfall zeigte. Als Erstes haben wir die Protokolle und Metriken des Modells überprüft, um irgendwelche Probleme zu finden. Es wurde klar, dass die Datenpipeline Daten einspeiste, deren Struktur sich durch die letzten Updates in den Quellsystemen geändert hatte.

Als Nächstes haben wir die Daten mit den erwarteten Eingaben des Modells abgeglichen und nach Abweichungen gesucht. Nachdem ich das Datenproblem bestätigt hatte, habe ich mich mit dem Datenentwicklungsteam abgestimmt, um die Datenpipeline zu reparieren. Dann hab ich einen Hotfix rausgebracht, um das Modell mit der korrigierten Eingabeverarbeitung zu aktualisieren.

Schließlich habe ich das Modell nach der Bereitstellung genau beobachtet, um sicherzustellen, dass die Leistung wieder auf das erwartete Niveau zurückkehrte, und habe die Ergebnisse und die Lösung an die Beteiligten weitergegeben.

Wie gehst du mit der Versionsverwaltung von Modellen in einer kollaborativen Umgebung um?

Beschreibung: Diese Frage checkt, wie du mit verschiedenen Versionen von Machine-Learning-Modellen umgehst, wenn du in einem Team arbeitest.

Beispielantwort: „Ich nutze Versionskontrollsysteme wie MLflow oder DVC, um verschiedene Modellversionen zu verwalten und zu verfolgen. Jede Version kriegt eine eigene Kennung und es gibt eine ausführliche Dokumentation für jedes Update, damit die Teammitglieder die Änderungen verstehen.

Außerdem stelle ich sicher, dass neue Modelle in einer Testumgebung gründlich geprüft werden, bevor sie in der Produktion eingesetzt werden. So kann man Störungen vermeiden und die Modellleistung aufrechterhalten.

Beschreib mal eine schwierige Situation, in der du mit Teams aus verschiedenen Abteilungen zusammenarbeiten musstest. Wie hast du eine effektive Zusammenarbeit geschafft?

Beschreibung: Diese Frage checkt, wie gut du mit verschiedenen Teams wie Datenwissenschaftlern, Ingenieuren und Produktmanagern zusammenarbeiten kannst und wie du Herausforderungen in einem funktionsübergreifenden Umfeld meisterst und löst.

Beispielantwort: Eine schwierige Situation war die Koordination zwischen Datenwissenschaftlern, Ingenieuren und Produktmanagern, um ein neues Modell mit komplizierten Abhängigkeiten einzusetzen. Der Schlüssel für eine gute Zusammenarbeit war, von Anfang an klare Kommunikationswege zu haben.

Es wurden regelmäßige Treffen geplant, um die Ziele abzustimmen, den Fortschritt zu verfolgen und eventuelle Hindernisse anzugehen. Um Wissenslücken zu schließen, habe ich Wissensaustausch-Sitzungen organisiert, in denen die Teammitglieder über ihre jeweiligen Fachgebiete reden konnten.

Außerdem hat die Verwendung von Projektmanagement-Tools zur Verfolgung von Aufgaben und Meilensteinen dazu beigetragen, dass alle über den Projektstatus auf dem Laufenden blieben. Dieser Ansatz hat dafür gesorgt, dass die Ideen von jedem Teammitglied berücksichtigt wurden und wir gemeinsam auf eine erfolgreiche Umsetzung hingearbeitet haben.

Wie gehst du vor, um ML-Modelle zu skalieren, damit sie mit einer höheren Nutzerlast klarkommen?

Beschreibung: Diese Frage geht um deine Strategien, wie du Machine-Learning-Modelle an wachsende Anforderungen anpasst, und checkt, wie gut du die technischen und operativen Aspekte der Skalierbarkeit verstehst.

Beispielantwort: Um ML-Modelle für mehr Nutzer zu skalieren, musst du ein paar wichtige Schritte machen.

Zuerst würde ich die Leistungskennzahlen des aktuellen Modells anschauen, um mögliche Engpässe zu finden. Um mit der steigenden Nachfrage klarzukommen, würde ich Cloud-basierte Auto-Scaling-Lösungen nutzen, um die Ressourcen je nach Traffic dynamisch anzupassen.

Außerdem kann die Optimierung des Modells selbst durch Techniken wie Quantisierung oder Pruning dazu beitragen, den Ressourcenverbrauch zu senken, ohne die Leistung zu beeinträchtigen.

Ich würde auch Lasttests machen, um mehr Traffic zu simulieren und sicherzustellen, dass das System robust ist.

Und zu guter Letzt würde ich eine ständige Überwachung einrichten, um immer auf dem Laufenden zu bleiben, wie die Modelle laufen, damit ich die Ressourcenzuteilung nach Bedarf anpassen und die Leistung bei unterschiedlichen Auslastungen aufrechterhalten kann.

Wie gehst du mit den Erwartungen der Stakeholder um, wenn die Modellleistung nicht den anfänglichen Prognosen entspricht?

Beschreibung: Diese Frage checkt, wie du mit Kommunikation und Erwartungen umgehst, wenn ein Modell nicht die erwarteten Ergebnisse liefert.

Beispielantwort: Wenn die Leistung des Modells nicht so läuft, wie man es sich vorstellt, setze ich voll auf offene Kommunikation mit allen Beteiligten. Ich erkläre die Einschränkungen des Modells und warum es so funktioniert, egal ob es an der Datenqualität, Überanpassung oder unrealistischen Erwartungen liegt.

Dann arbeite ich mit ihnen zusammen, um realistischere Ziele zu setzen, datengestützte Erkenntnisse zu liefern und Verbesserungen vorzuschlagen, wie zum Beispiel mehr Trainingsdaten zu sammeln oder die Modellarchitektur anzupassen.

Kannst du mal erzählen, wann du schon mal technische Schulden gegen die pünktliche Lieferung eines Projekts abwägen musstest?

Beschreibung: Diese Frage checkt, wie gut du Prioritäten setzen kannst, um die langfristige Codequalität zu sichern und kurzfristige Projekttermine einzuhalten.

Beispielantwort: Es gab mal eine Zeit, in der wir unter großem Zeitdruck standen, um ein Modell für eine neue Produktfunktion einzusetzen. Wir haben uns auf eine schnelle Lieferung konzentriert, indem wir ein paar nicht so wichtige Teile des Codes, wie zum Beispiel eine ausführliche Dokumentation und nicht unbedingt notwendige Tests, weggelassen haben.

Nach der Veröffentlichung haben wir uns Zeit genommen, um den Code nochmal zu checken und diese Probleme zu beheben, damit die technischen Schulden nach dem Start so gering wie möglich bleiben. So konnten wir den Termin einhalten und gleichzeitig die langfristige Stabilität des Projekts sichern.

Tipps zur Vorbereitung auf ein MLOps-Vorstellungsgespräch

Die Vorbereitung auf ein MLOps-Vorstellungsgespräch braucht eine Mischung aus technischem Wissen, Verständnis für die Unternehmensumgebung und einer klaren Darstellung deiner bisherigen Erfahrungen. Hier sind ein paar wichtige Tipps, die dir bei der Vorbereitung helfen:

Mach dich mit Konzepten und Tools vertraut

Stell sicher, dass du die wichtigsten MLOps-Konzepte gut verstehst. Mach dich mit den gängigen Tools und Plattformen für MLOps vertraut, wie MLflow, Kubernetes und Cloud-basierten Diensten wie AWS SageMaker oder Google AI Platform.

Der MLOps-Lernpfad ist echt super, weil er vier coole Kurse hat, die dich über die neuesten MLOps-Konzepte und -Praktiken auf dem Laufenden halten.

Verstehe die Technologieplattform des Unternehmens

Schau dir die spezifischen Technologien und Tools an, die das Unternehmen, bei dem du dich vorstellst, nutzt. Wenn du ihre Tech-Stack verstehst, kannst du deine Antworten besser auf ihre Umgebung abstimmen und zeigen, dass du gut zu ihnen passt. Schau dir ihre bevorzugten Cloud-Dienste, Versionskontrollsysteme und Modellmanagementpraktiken an, um zu zeigen, dass du bereit bist, dich nahtlos in ihren Arbeitsablauf zu integrieren.

Bereite Beispiele deiner bisherigen Arbeiten vor.

Sei bereit, über konkrete Projekte oder Erfahrungen zu reden, bei denen du MLOps-Praktiken angewendet hast. Bereite Beispiele vor, die deine Fähigkeiten zur Problemlösung, deine Fähigkeit zur Zusammenarbeit mit funktionsübergreifenden Teams und deine Erfahrung mit der Bereitstellung und Skalierung von Modellen (wenn möglich) hervorheben. Nutze diese Beispiele, um dein praktisches Wissen zu zeigen und wie du in früheren Jobs Herausforderungen erfolgreich gemeistert hast.

Übe das Programmieren

Mach regelmäßig Programmierübungen zu MLOps, wie zum Beispiel Skripte für die Modellbereitstellung schreiben, Workflows automatisieren oder Datenpipelines entwickeln.

Bleib auf dem Laufenden

Der Bereich MLOps entwickelt sich schnell weiter, deshalb ist es wichtig, immer über die neuesten Trends, Tools und Best Practices auf dem Laufenden zu bleiben. Folge Branchenblogs, mach bei relevanten Foren oder Webinaren mit und tausche dich mit der MLOps-Community aus, um dein Wissen aktuell und relevant zu halten.

Fazit

MLOps ist ein Bereich, der die Lücke zwischen Datenwissenschaft und Betrieb schließt und dafür sorgt, dass Machine-Learning-Modelle effektiv eingesetzt, gewartet und skaliert werden.

In diesem Beitrag haben wir eine Reihe von Interviewfragen behandelt, die allgemeine MLOps-Konzepte, technische Aspekte, Überlegungen zu Cloud und Infrastruktur sowie Verhaltenskompetenzen zur Problemlösung abdecken. Wenn du diese Fragen übst, steigert das deine Chancen auf Erfolg bei deinen Vorstellungsgesprächen erheblich und erhöht deine Chancen, den Job zu bekommen!

Schau dir die folgenden Ressourcen an, um weiterzulernen:

Fähigkeiten im Bereich Machine Learning aufbauen

FAQs

Welche Schlüsselkompetenzen sollte ein MLOps-Ingenieur bei einem Vorstellungsgespräch betonen?

Ein MLOps-Ingenieur sollte seine Kenntnisse in der Automatisierung betonen, vor allem bei CI/CD-Pipelines für Machine-Learning-Modelle, sowie seine Erfahrung mit Cloud-Plattformen wie AWS, GCP oder Azure. Kenntnisse über Containerisierungstools wie Docker und Kubernetes sind echt wichtig, um große Infrastrukturen zu verwalten. Zeig, dass du den ganzen Lebenszyklus des maschinellen Lernens verstehst, vom Modelltraining bis zur Bereitstellung und Überwachung, und bring auch deine Soft Skills wie Kommunikation und Zusammenarbeit zur Geltung, da MLOps Teamarbeit über mehrere Abteilungen hinweg erfordert.

Wie kann ich zeigen, dass ich Erfahrung mit großen Machine-Learning-Systemen habe?

Um deine Erfahrung mit großen ML-Systemen zu zeigen, erzähl mal von bestimmten Projekten, bei denen du mit großen Datensätzen gearbeitet oder die Modellleistung in der Produktion verbessert hast. Sag uns, welche Tools du benutzt hast, wie zum Beispiel Kubernetes für die Bereitstellung oder Spark für die verteilte Verarbeitung. Zeig deine Leistung mit messbaren Werten, wie zum Beispiel der Verkürzung der Inferenzzeit oder der Verwaltung von Datenmengen im Terabyte-Bereich. Das wird deine Fähigkeiten konkret zeigen.

Wie sollte ich mich auf ein technisches MLOps-Vorstellungsgespräch vorbereiten?

Um dich auf ein technisches MLOps-Vorstellungsgespräch vorzubereiten, solltest du deine Grundkenntnisse im Bereich maschinelles Lernen auffrischen und dich gleichzeitig auf dein Wissen über CI/CD-Pipelines und Cloud-Bereitstellungen konzentrieren. Probier mal aus, wie du Modelle mit Containern und Cloud-Plattformen einsetzt, und stell sicher, dass du weißt, wie du sie effektiv skalieren und überwachen kannst. Praktische Erfahrungen und Probeinterviews können dir helfen, deine technischen Fähigkeiten zur Problemlösung zu verbessern, vor allem in Sachen Automatisierung und Infrastruktur.

Was sind die häufigsten Fehler, die Leute bei einem MLOps-Vorstellungsgespräch machen, und wie kann ich die vermeiden?

Ein häufiger Fehler ist, sich zu sehr auf Algorithmen für maschinelles Lernen zu konzentrieren und dabei die operative Seite von MLOps zu vergessen. Die Kandidaten sollten ihr Verständnis von ML mit dem von Infrastrukturmanagement abgleichen. Es ist auch wichtig, die Überwachung und Wartung nicht zu vergessen, die für Produktionssysteme echt wichtig sind. Stütz deine Antworten immer mit praktischen Beispielen aus früheren Erfahrungen und vermeide theoretische oder zu allgemeine Antworten.

Wie kann ich bei einem MLOps-Vorstellungsgespräch punkten?

Um dich von anderen abzuheben, zeig dein funktionsübergreifendes Verständnis von MLOps, indem du erklärst, wie du mit Datenwissenschaftlern, Ingenieuren und DevOps-Teams zusammenarbeitest. Zeig, dass du Automatisierung und Skalierung von Systemen gut umsetzen kannst, und bring Beispiele aus der Praxis, wo du messbare Ergebnisse erzielt hast. Wenn du Interesse an neuen Trends wie serverlosen Architekturen oder Edge-Computing zeigst, kannst du auch einen starken Eindruck als zukunftsorientierter Kandidat hinterlassen.