Lernpfad

dbt Cloud hat sich als führender Managed Service für Datentransformationund unterstützt moderne Analyseteams mit skalierbaren, zuverlässigen und kollaborativen Arbeitsabläufen.

Es erweitert die Möglichkeiten von dbt Core und bietet eine gehostete Umgebung, die Deployments automatisiert, Jobs koordiniert, Anmeldedaten verwaltet und Funktionen für die Zusammenarbeit von Datenteams bereitstellt.

So können Unternehmen SQL-basierte Transformationen in einer sicheren, automatisierten und teamfreundlichen Umgebung verwalten.

In diesem Einführungs-Tutorial schauen wir uns an, was dbt Cloud ist, wie man es einrichtet und wie man es nutzen kann.

Wenn du neu im Framework bist und einen strukturierten Lernpfad bevorzugst, empfehle ich dir, mit unserer Einführung in dbt .

Was ist dbt Cloud und wie funktioniert es?

Schauen wir uns erstmal an, was dbt Cloud ist und welche Funktionen es hat.

Überblick über dbt Cloud

Im Grunde genommen hilft dbt Cloud Teams dabei, den ELT-Ansatz (Extract, Load, Transform) Ansatz zu nutzen. Anders als bei den üblichen ETL-Prozessen, wo die Transformationen vor dem Laden der Daten ins Warehouse passieren, macht dbt die Transformationen direkt im Warehouse, dank seiner Rechenleistung und Skalierbarkeit.

Quelle: dbt

dbt Cloud macht die Datenumwandlung einfacher, weil es:

- Bietet einen verwalteten Dienst für SQL-Transformationen mit dbt.

- Passt in moderne Pipelines, indem es Transformationen ins Warehouse verlagert.

- Standardisiert die Analyseentwicklung durch gemeinsame Arbeitsabläufe und Praktiken.

Kernkonzepte und Arbeitsablauf

dbt Cloud hat die gleichen Konzepte wie dbt Core.

Dazu gehören:

- Modelle: SQL-Dateien, die Transformationen festlegen.

- Quellen: Definitionen von Rohdatentabellen.

- Tests: Aussagen zur Datenqualität.

- Dokumentation: Automatisch erstellte Abstammungs- und Modelldokumente.

- Exposures: Definiere nachgelagerte BI- oder Berichtsabhängigkeiten.

Ein typischer dbt Cloud-Workflow sieht so aus: Entwickle Modelle > Transformationen testen > In Git speichern > Über Cloud-Jobs bereitstellen > Überwachung der Ausführung in dbt Cloud.

Einrichten deiner dbt Cloud-Umgebung

Um zu zeigen, wie dbt Cloud funktioniert, schauen wir uns mal ein praktisches Beispiel an, wie du selbst eine Umgebung einrichten kannst.

Der Einstieg in dbt Cloud ist echt einfach, weil es für schnelles Onboarding gemacht ist. Hier sind die Schritte, die du machen musst:

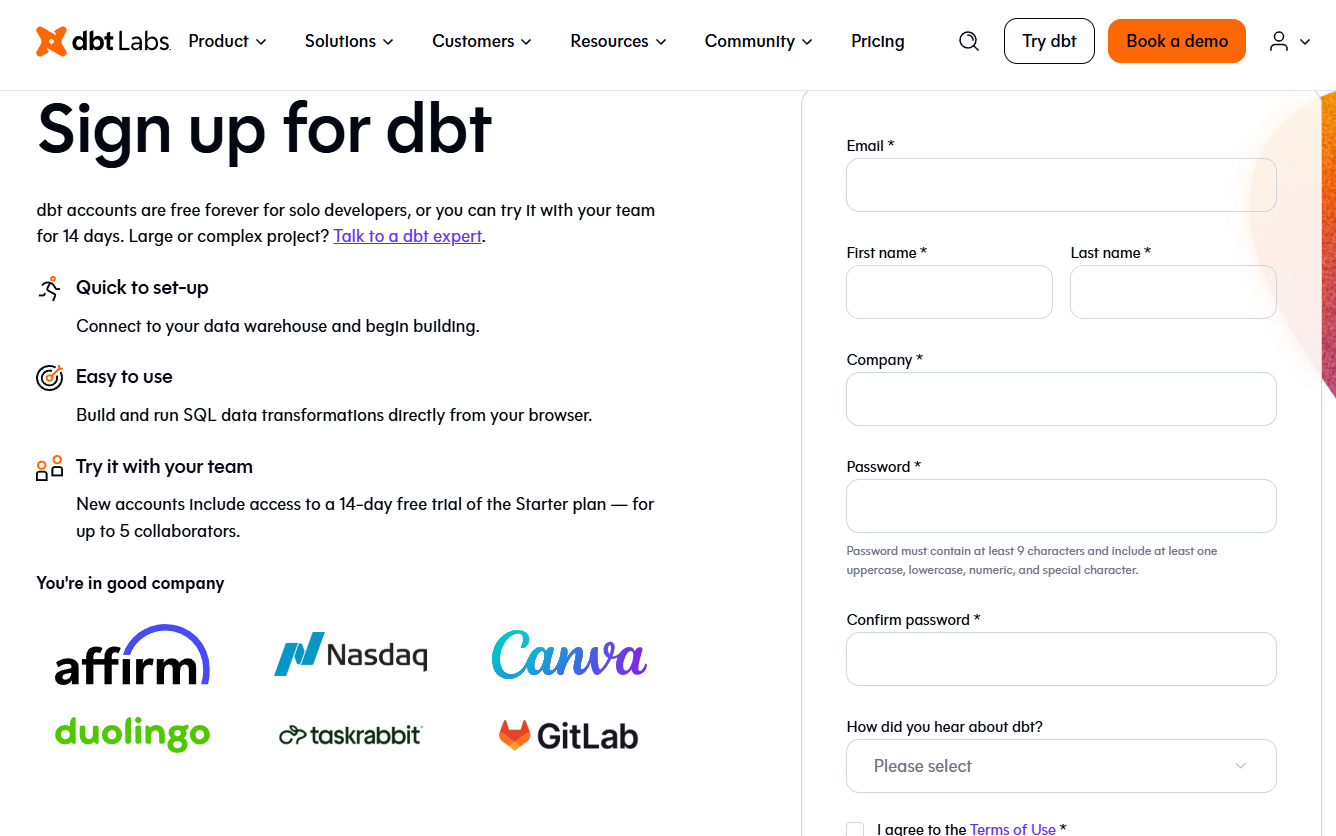

Erstellen und Einrichten eines Kontos

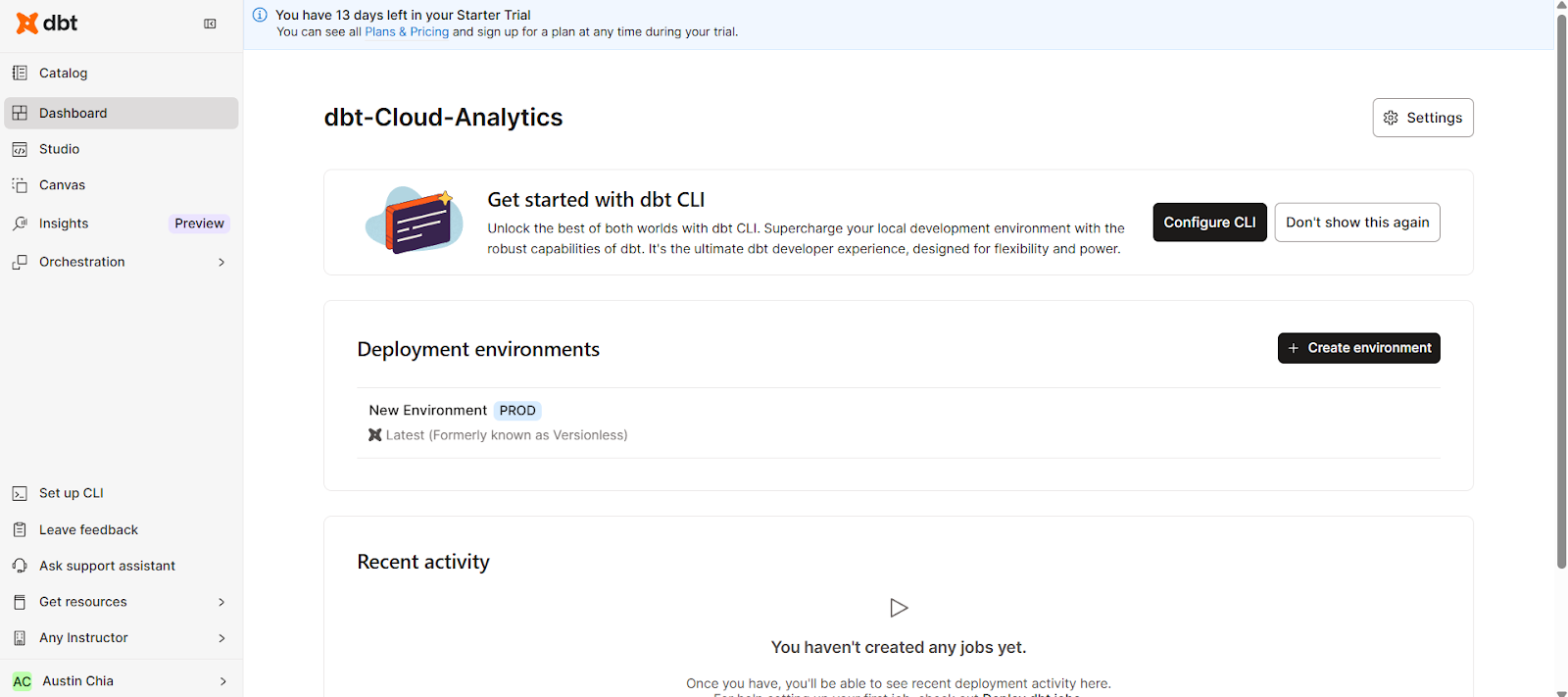

- Melde dich bei dbt Cloud an, um eine 14-tägige kostenlose Testversion des Starter-Tarifs zu nutzen.

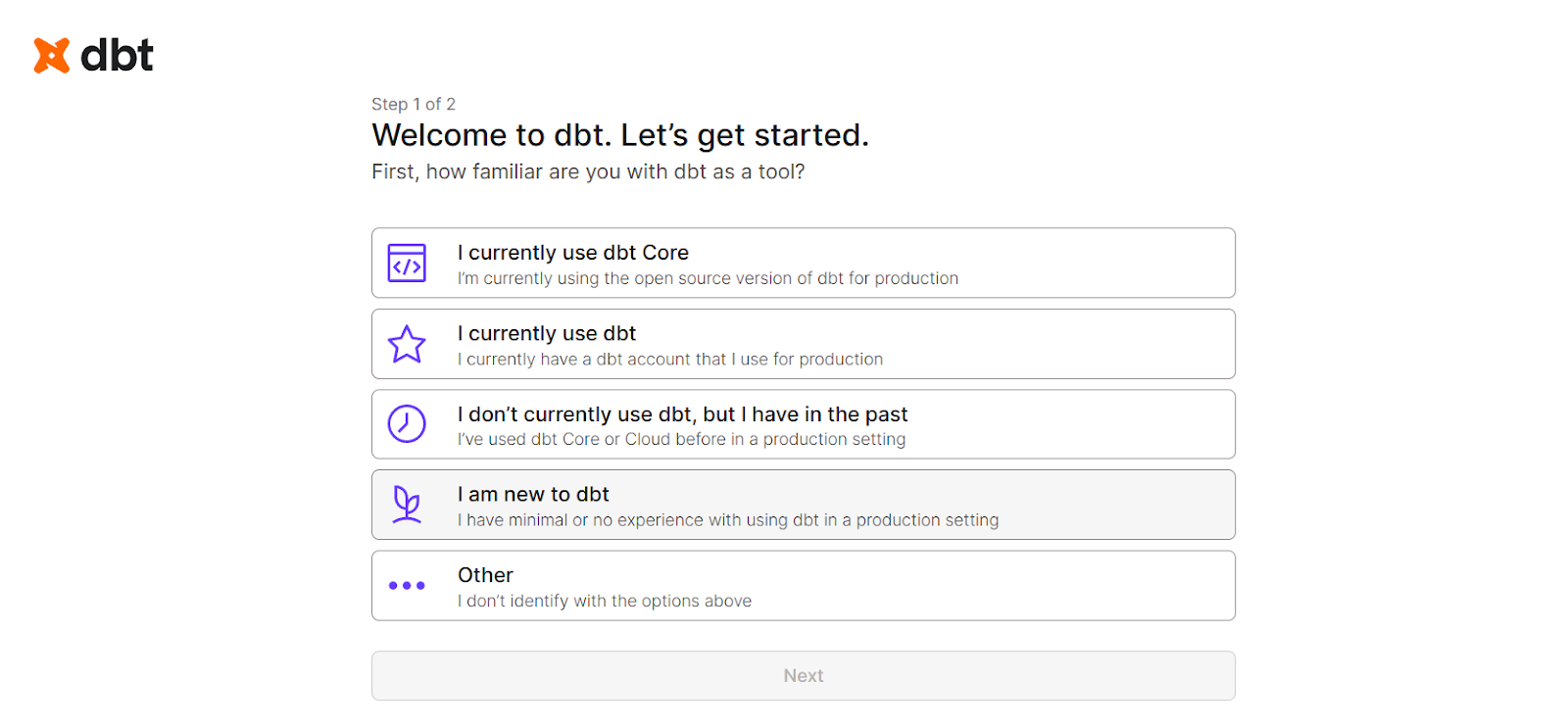

- Wähle die Startoptionen entsprechend deiner Erfahrung mit dbt aus.

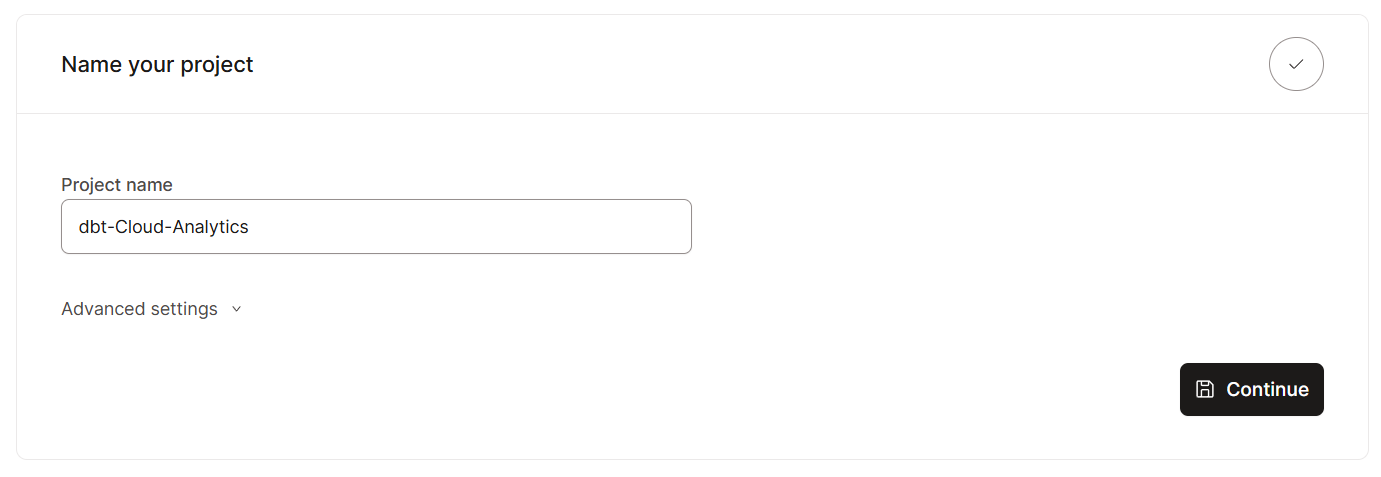

- Gib deinem Projekt einen Namen, zum Beispiel „dbt-Cloud-Analytics“.

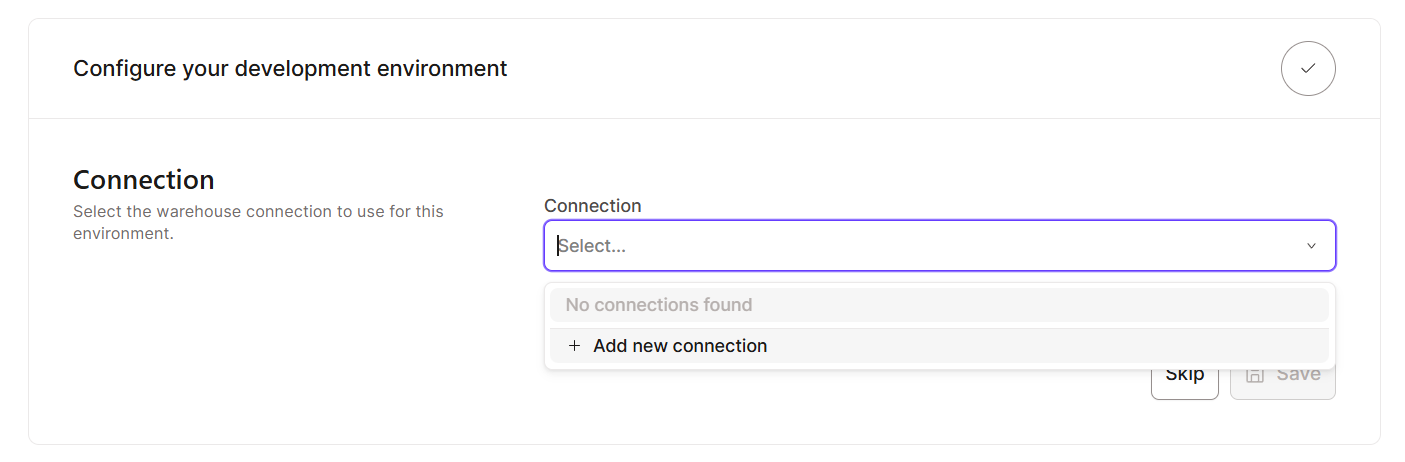

- Füge eine neue Verbindung hinzu.

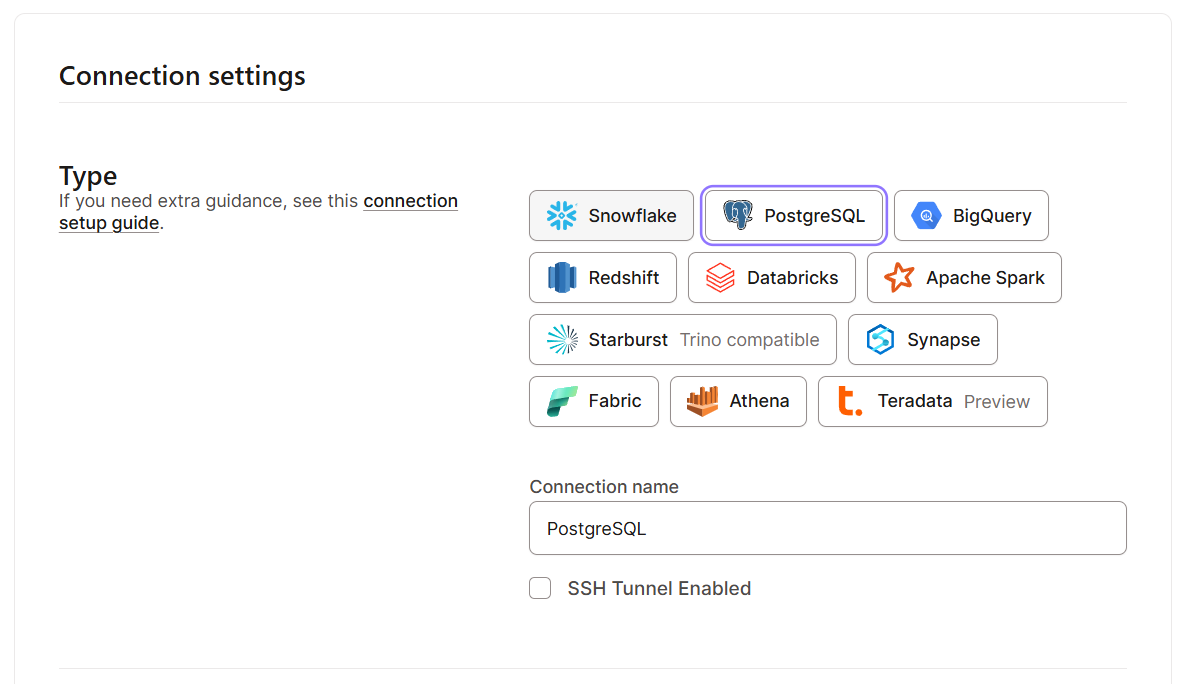

- Verbinde dich mit einem Data Warehouse deiner Wahl (wie Snowflake, BigQuery, PostgreSQL, Redshift oder Databricks). Ich werde eine lokale PostgreSQL-Datenbank nutzen.

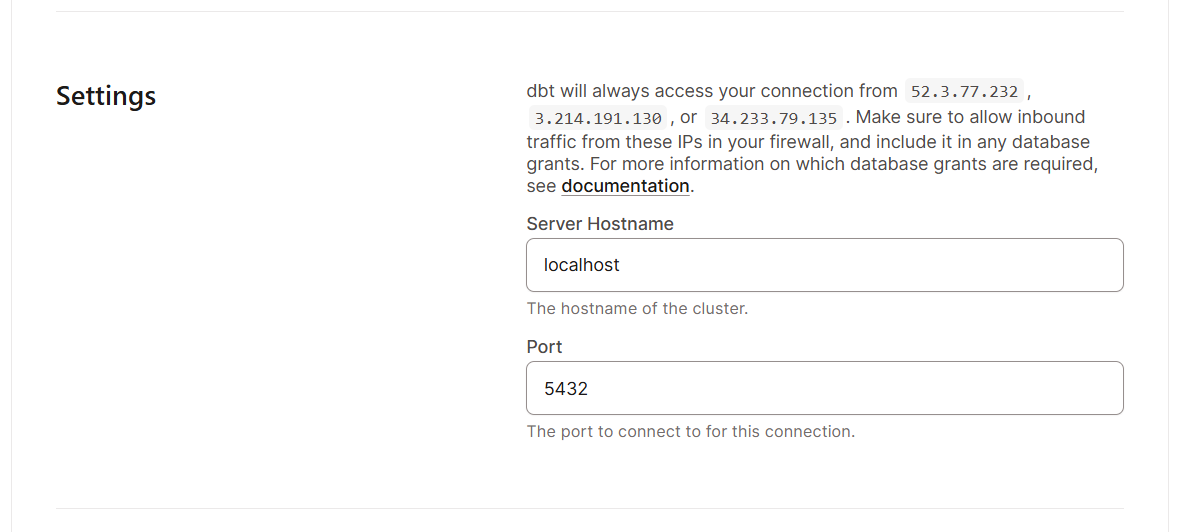

- Verbindungseinstellungen konfigurieren.

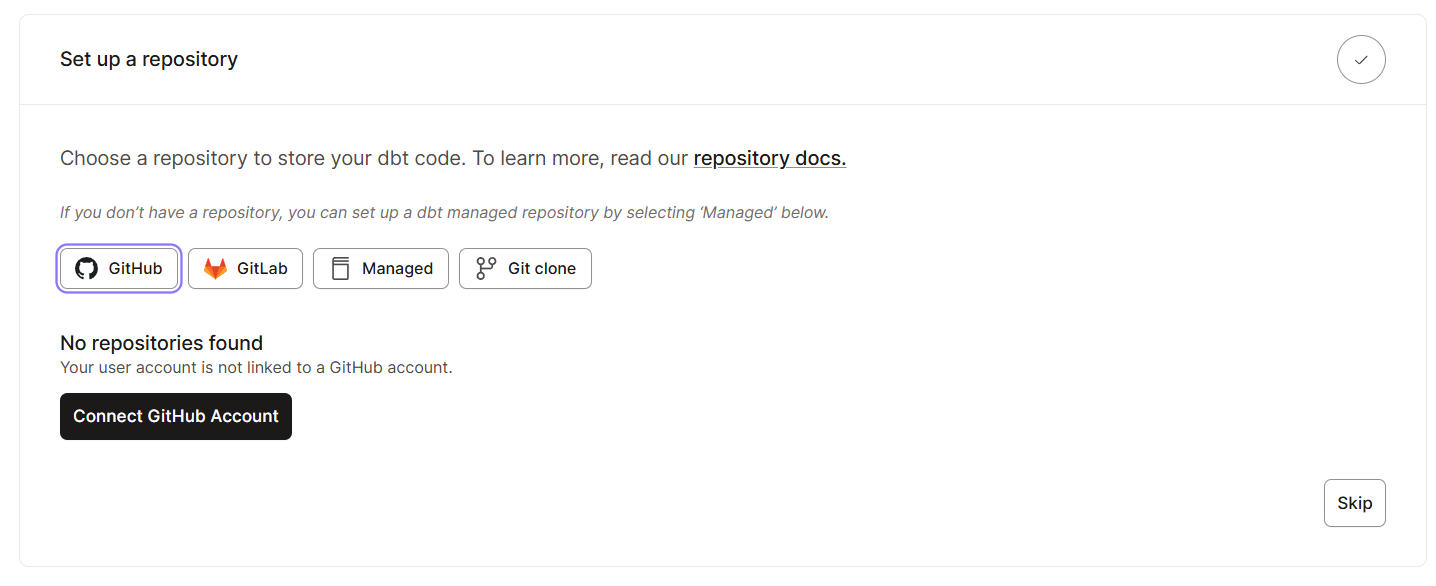

- Richte ein Git-Repository ein.

Die Benutzeroberfläche verstehen

Sobald du alle grundlegenden Einstellungen vorgenommen hast, schauen wir uns die Benutzeroberfläche an. Hier ist, was du in der dbt Cloud-Oberfläche erwarten kannst:

Die dbt Cloud-Benutzeroberfläche macht deinen Arbeitsablauf richtig effizient. Über die Navigationsleiste kommst du zu den folgenden wichtigen Bereichen:

- Katalog: Zeigt Projekte und Modelle an.

- Studio: Dient als Arbeitsschnittstelle zum Schreiben von Code-Dateien.

- Dashboard: Gibt dir einen zentralen Überblick über Jobs und Aktivitäten.

- Leinwand: Ermöglicht das Erstellen von Modellen per Drag & Drop (Funktion der Enterprise-Stufe).

- Einblicke: Bietet zusätzliche Infos zu den eingesetzten Umgebungen.

- Orchestrierung: Konfiguriert und plant dbt-Ausführungen.

Hier findest du alle wichtigen Infos, das Coding Studio und die Konfigurationseinstellungen in einer Weboberfläche.

Entwickeln in der dbt Cloud IDE

dbt Cloud bietet auch eine browserbasierte IDE, die speziell für Analytics Engineering entwickelt wurde und GitHub integriert. Es wurde entwickelt, um dbt-Projekte über deinen Browser zu erstellen, auszuführen, zu testen und zu verwalten.

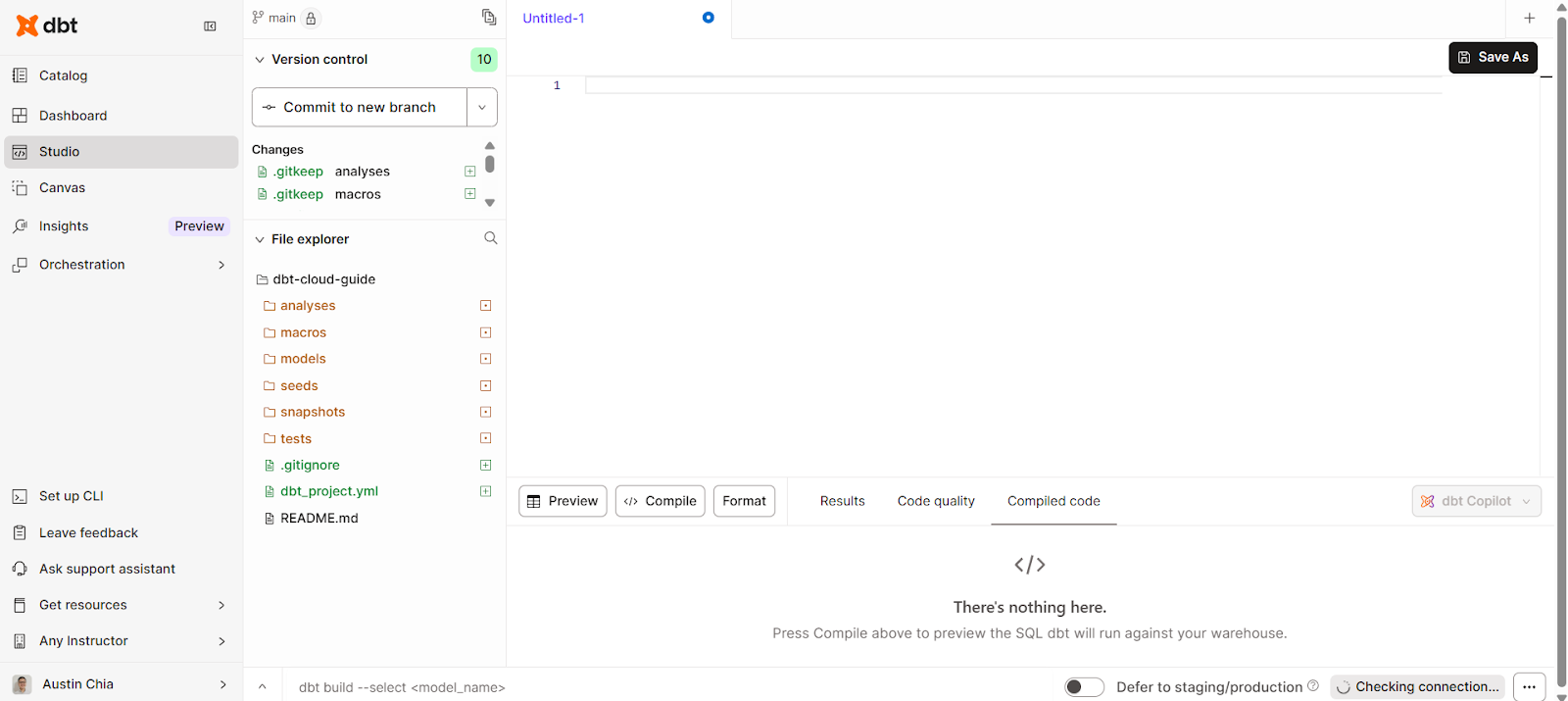

Sich in der Cloud-IDE zurechtfinden

Die dbt Cloud IDE braucht keine lokale Installation, was den Einstieg für Analysten einfacher macht. Um draufzugreifen, klick einfach auf den Reiter „Studio“ auf der linken Seite der Benutzeroberfläche.

Damit solltest du eine einfache Oberfläche zum Schreiben, Kompilieren und Ausführen von Code sehen.

Mit der dbt Cloud IDE kannst du diese Aufgaben erledigen:

- Echtzeit-Abfrageausführung mit Ergebnisvorschau.

- SQL-Autovervollständigung und Jinja-Vorlagen.

- Tools zum Markieren von Fehlern und zur Fehlerbehebung.

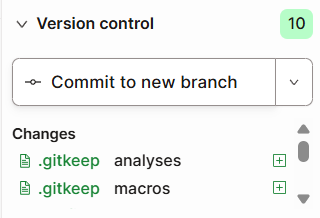

Integration der Versionskontrolle

Außerdem kannst du mit dbt Cloud auch GitHub einbinden, um die Versionskontrolle zu integrieren.

Mit dieser Funktion kannst du:

- Verbinde dbt Cloud mit GitHub, GitLab oder Bitbucket.

- Verwalte Zweige direkt aus der IDE.

- Speichere und synchronisiere Code-Änderungen mit deinem zentralen Repository.

- Mach die Zusammenarbeit mit Pull-Anfragen und Überprüfungen einfacher.

Datenmodelle in dbt Cloud erstellen und testen

Genau wie in dbt Core kannst du auch in dbt Cloud Datenmodelle erstellen und testen. Schauen wir uns mal ein paar Möglichkeiten an, wie das gemacht werden kann.

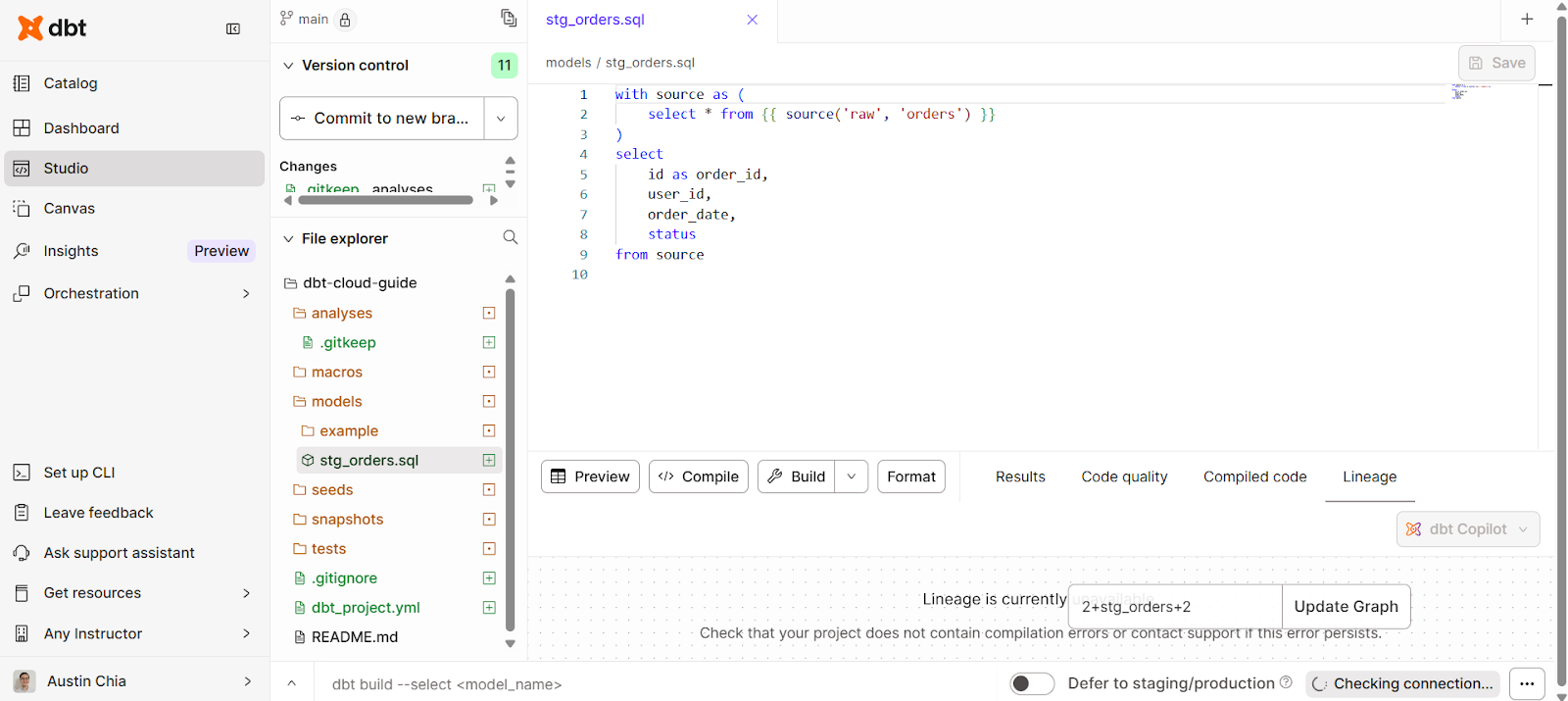

SQL-Transformationen schreiben

Wenn du mit Datenmodellen arbeitest, musst du wahrscheinlich ein paar Umwandlungen vornehmen. In der dbt Cloud IDE können wir SQL-Anweisungen direkt im Studio schreiben.

Du kannst ein Datenmodell erstellen, um es wie folgt umzuwandeln:

with source as (

select * from {{ source('raw', 'orders') }}

)

select

id as order_id,

user_id,

order_date,

status

from sourceSo sieht die Benutzeroberfläche aus:

Ein paar bewährte Vorgehensweisen, die du beachten solltest:

- Modelle nach Ebenen organisieren (Staging, Zwischenstufe, Marts).

- Benutze einheitliche Namenskonventionen.

- Logik über Makros wiederverwenden.

Automatisierte Tests und Validierung

Außerdem kannst du Tests in YAML für automatisierte Überprüfungen festlegen:

models:

- name: stg_orders

columns:

- name: order_id

tests:

- not_null

- unique

- name: status

tests:

- accepted_values:

values: ['completed', 'pending', 'cancelled']Das Testen deiner Daten sorgt für Vertrauen in die Transformationen. So stellst du sicher, dass alle Jobs, die du ausführst, Tests haben, um die Integrität zu halten.

Wenn du ein fortgeschrittener Benutzer bist, kannst du auch eigene Tests mit Jinja und SQL erstellen.

Planung und Koordination in dbt Cloud

In dbt Cloud helfen Jobplanung und -koordination dabei, die Automatisierung von Analysen zu unterstützen. Sie sorgen dafür, dass deine Transformationen konsistent, pünktlich und in der richtigen Umgebung mit minimalem manuellem Aufwand laufen.

Hier geht's darum, wie du Jobs planst, automatisch startest und ihre Leistung in Echtzeit im Auge behältst.

Jobplanung

In der dbt Cloud-Oberfläche kannst du:

- Erstell Jobs für Entwicklungs-, Staging- oder Produktionsumgebungen.

- Cron-Zeitpläne oder ereignisgesteuerte Auslöser einrichten.

- Aufgaben verketten (ausführen, testen, Snapshot erstellen).

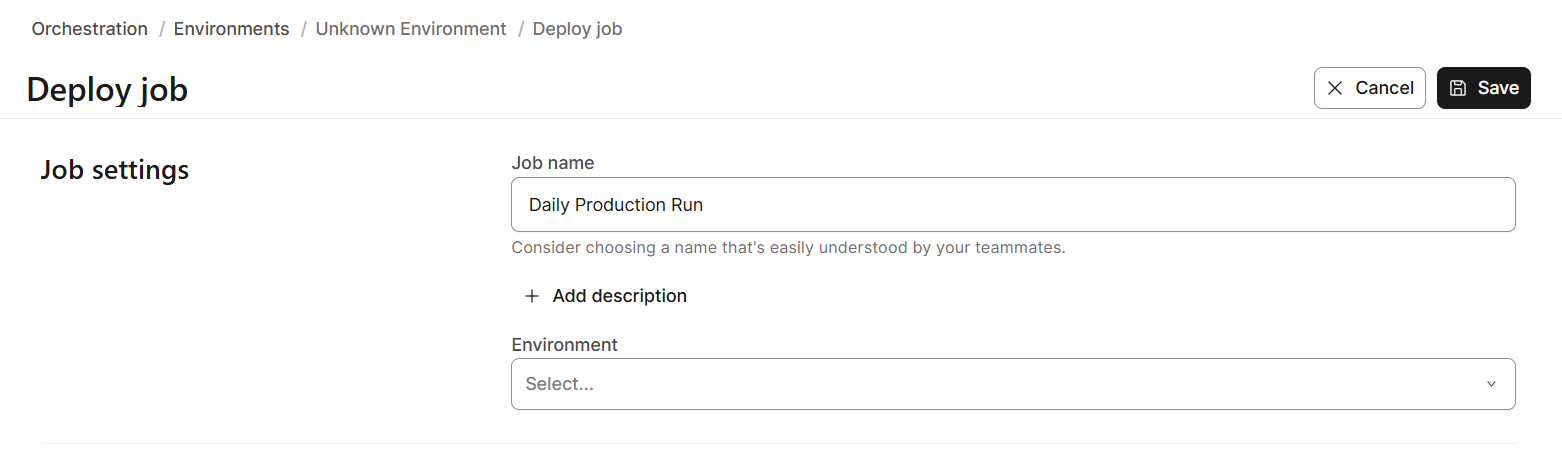

So erstellst du einen Job-Zeitplan in dbt Cloud:

- Geh zur Registerkarte „Orchestrierung“ und dann zu „Jobs“ in deinem Projekt.

- Klick auf „Job erstellen“ > „Job bereitstellen“ und gib ihm einen aussagekräftigen Namen (z. B. „Täglicher Produktionslauf“ oder „Inkrementelle Aktualisierung der Staging-Umgebung“).

- Wähl die Umgebung aus, in der der Job laufen soll – normalerweise Entwicklung, Staging oder Produktion.

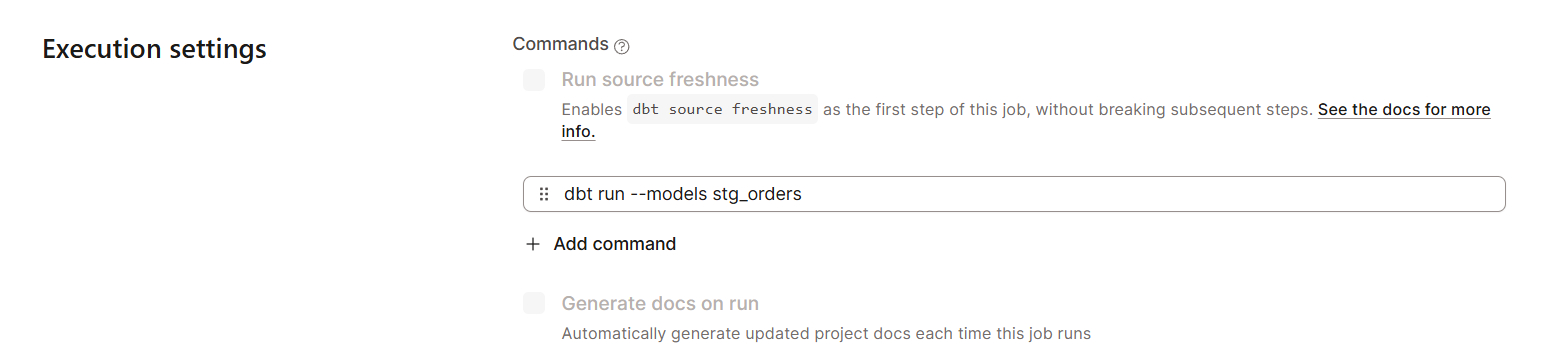

- Füge einen oder mehrere Befehle hinzu, zum Beispiel dbt run --models stg_orders.

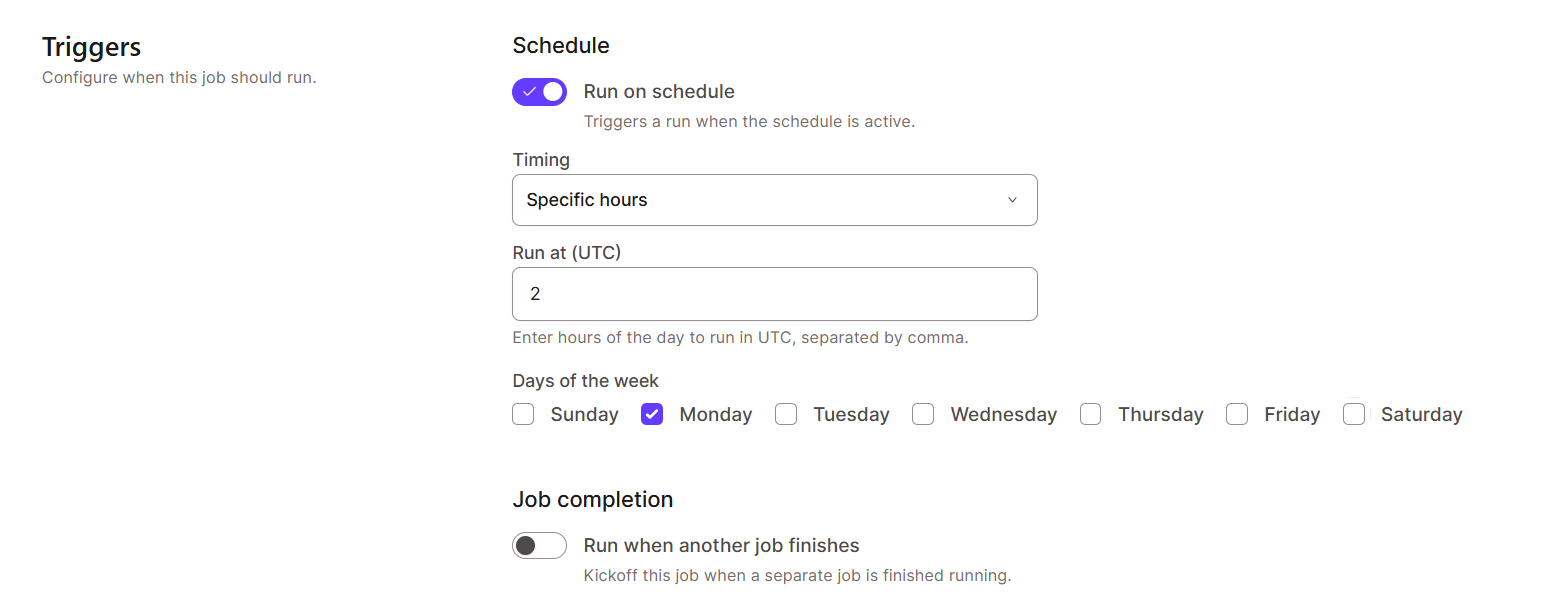

- Wähle unter „Zeitplan“ die Cron-Syntax aus oder benutze die visuelle Zeitauswahl, um festzulegen, wann der Job laufen soll (z. B. jede Nacht um 2 Uhr morgens, jeden Montagmorgen).

- Speicher den Job und schalte E-Mail- oder Slack-Benachrichtigungen für Status-Updates ein.

Echtzeitüberwachung und Protokollierung

dbt Cloud hat Überwachungs- und Protokollierungsfunktionen, damit du deine Daten besser im Blick behalten kannst. Das ist echt wichtig, um Probleme zu lösen und die Leistung zu verbessern.

Damit kannst du:

- Laufprotokolle direkt in der Benutzeroberfläche anzeigen.

- Protokolle für die externe Überwachung exportieren.

- Schick Benachrichtigungen an Slack, per E-Mail oder an PagerDuty.

Erweiterte Funktionen von dbt Cloud

Neben den grundlegenden Funktionen für Modellierung und Orchestrierung bietet dbt Cloud erweiterte Features, die moderne Analyse-Workflows intelligenter, konsistenter und automatisierter machen.

Sie haben zwei Hauptmerkmale: die dbt Semantic Layer und KI-gestützte Tools wie dbt Copilot und Fusion.

Die semantische Ebene von dbt nutzen

Die dbt Semantic Layer bietet eine zentrale, verwaltete Ebene, auf der Teams Geschäftsmetriken auf einheitliche und versionskontrollierte Weise definieren, verwalten und bereitstellen können.

Es hilft:

- Definier und verwalte Geschäftskennzahlen zentral.

- Sorg dafür, dass BI- und Analysetools einheitlich sind.

- Verhindere Metrik-Drift, indem du eine einzige Quelle der Wahrheit durchsetzt.

Diese einheitliche Ebene schließt die Lücke zwischen Datentransformation und Visualisierung, indem sie mit gängigen BI-Tools verbunden ist.

Ein praktisches Beispiel findest du in diesem Tutorial zur Implementierung einer semantischen Schicht mit dbt.

KI mit dbt Copilot und Fusion verbinden

Eine der neuesten Funktionen von dbt, dbt Copilot, ist ein KI-Assistent, der direkt in die IDE von dbt Cloud eingebaut ist. Es hilft Entwicklern dabei, dbt-Code mit Hilfe von Eingabeaufforderungen in natürlicher Sprache und kontextbezogenen Vorschlägen zu schreiben, zu debuggen und zu optimieren.

Mit dbt Copilot kannst du:

- Erstell SQL-Modelle oder Jinja-Makros aus einfachen Sprachbeschreibungen.

- Du bekommst Vorschläge zur automatischen Vervollständigung für dbt-Befehle, Tests und Konfigurationen.

- Modelle automatisch mit generierten Beschreibungen und Metadaten dokumentieren.

- Identifiziere und behebe häufige Syntax- oder Abhängigkeitsprobleme, bevor du Jobs ausführst.

Die Fusion-Engine ist eine neue Engine, die in Rust geschrieben wurde, um dbt Core zu ersetzen, und die viel mehr Funktionen hat.

Es gibt ein paar Anwendungsfälle, wie zum Beispiel:

- Fehlerhaften SQL-Code in deinen dbt-Modellen erkennen

- Ermöglicht die Vorschau von Inline-CTEs für schnelleres Debugging

- Modellverfolgung in deinem dbt-Projekt

Sicherheit und Compliance in der dbt Cloud

Bei Datenumwandlungs-Workflows sind Sicherheit und Governance einfach ein Muss. Deshalb hat dbt Cloud auch Sicherheitsfunktionen auf Unternehmensniveau eingebaut, um sensible Infos zu schützen, die Compliance zu wahren und die Verantwortlichkeit über alle Teams hinweg sicherzustellen.

Rollenbasierte Zugriffskontrolle

dbt Cloud nutzt rollenbasierte Zugriffskontrolle (RBAC), um Benutzerberechtigungen zu verwalten und den Zugriff auf wichtige Sachen wie Projekte, Umgebungen und Anmeldedaten zu beschränken.

Mögliche Aufgaben sind:

- Entwickler

- Rezensent

- Admin

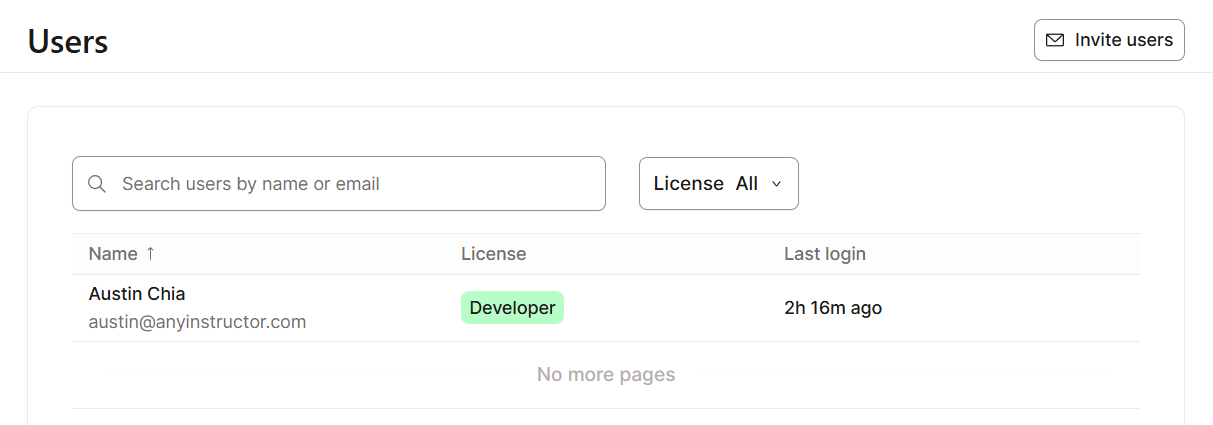

So richtest du die Zugriffskontrolle in dbt Cloud ein:

- Geh zum Bereich „Kontoeinstellungen“ und dann zu „Benutzer“.

- Weis den Benutzern vordefinierte Rollen zu oder erstelle eigene Rollen, um mehr Kontrolle zu haben.

- Lege fest, ob Leute Umgebungen und Job-Zeitpläne verwalten, Lagerzugangsdaten oder API-Token ändern und/oder Code-Bereitstellungen oder Merge-Anfragen genehmigen dürfen.

- Nutze Berechtigungen auf Projektebene, um den Zugriff für verschiedene Teams oder Abteilungen zu trennen.

Auditprotokollierung und Compliance

dbt Cloud hat umfassende Audit-Protokollierungs- und Compliance-Funktionen, die Unternehmen dabei helfen sollen, strenge Anforderungen an die Datenverwaltung zu erfüllen, die mit Standards wie SOC 2, DSGVO und anderen übereinstimmen.

Audit-Protokolle helfen auch bei der Untersuchung von Problemen, und SCIM-Unterstützung verbessert die Integration der Identitätsverwaltung.

Integration und Konnektivität von dbt Cloud

Eine der größten Stärken von dbt Cloud ist, dass es sich super in das größere Daten-Ökosystem einbinden lässt. Es lässt sich ganz einfach mit den gängigsten Data Warehouses, APIs, Orchestrierungstools und Überwachungsplattformen verbinden.

Das macht es zu einer guten Wahl für den Aufbau eines einheitlichen und automatisierten Analyse-Workflows, von der Erfassung bis zur Visualisierung. Schauen wir uns diese Punkte mal genauer an:

Verbindung zur Datenplattform

dbt Cloud funktioniert mit allen großen Cloud-Data-Warehouses und Lakehouses, sodass Teams Transformationen direkt in den Umgebungen machen können, wo ihre Daten schon sind.

Dadurch muss man keine Daten mehr verschieben oder duplizieren, sondern kann einfach die Leistung und Skalierbarkeit jeder Plattform nutzen.

Die Integrationsoptionen von dbt Cloud umfassen:

Du kannst auch mehrere Authentifizierungsoptionen pro Plattform haben, wie zum Beispiel Schlüsselpaar-Authentifizierung, OAuth oder Benutzername/Passwort.

API- und Webhook-Integration

Für Unternehmen, die Erweiterbarkeit und Automatisierung brauchen, bietet dbt Cloud auch eine starke REST-API und ein Webhook-Framework.

Die dbt Cloud API ermöglicht Entwicklern Folgendes:

- Jobläufe automatisch starten und überwachen.

- Hol dir Laufzeitartefakte wie Protokolle, Manifestdateien oder kompiliertes SQL.

- Mach die Bereitstellungsabläufe automatisch, indem du dbt Cloud in CI/CD-Pipelines einbindest (z. B. GitHub Actions, GitLab CI oder Azure DevOps).

- Verwalte Benutzer, Umgebungen und Projekte in großem Maßstab.

dbt Cloud-Webhooks bieten eine ereignisbasierte Integration, sodass externe Systeme auf wichtige dbt-Ereignisse wie Jobabschluss, Ausführungsfehler oder Bereitstellungsaktualisierungen reagieren können.

Die Webhooks kannst du für Folgendes nutzen:

- Senden von Echtzeit-Benachrichtigungen an Slack oder Microsoft Teams, wenn Jobs schiefgehen.

- Auslösen von Workflows für das Incident Management.

- Weiterleitung von Laufmetriken und Leistungsdaten an Überwachungssysteme.

- Automatisches Aktualisieren von Dashboards oder Metadatenkatalogen, wenn neue Modelle erstellt werden.

Leistungsoptimierung in dbt Cloud

Da Datenpipelines immer größer und komplexer werden, ist es wichtig, dass man sie gut im Blick hat, um die Zuverlässigkeit, Leistung und das Vertrauen zu sichern.

Aber was hat dbt Cloud denn so zu bieten? Es geht im Grunde um zwei Sachen: die Überwachung von Pipelines und die Optimierung von Modellen.

Überwachung von Datenumwandlungspipelines

Jeder Joblauf wird auf der Plattform protokolliert, verfolgt und angezeigt, sodass du den gesamten Status deiner Transformationen im Blick hast.

Zum Beispiel im Ausführungsverlauf zeigt dbt Cloud detaillierte Infos wie:

- Laufzeit: Gesamtzeit für den Auftrag, aufgeschlüsselt nach Modell und Schritt.

- Statusverfolgung: Echtzeit-Indikatoren, die zeigen, ob ein Lauf in der Warteschlange steht, läuft, abgeschlossen ist oder fehlgeschlagen ist.

- Ausführungsprotokolle: Detaillierte Protokolle mit SQL-Abfragen, Zeitstempeln und Zeilenzahlen.

dbt Cloud lässt sich auch ganz einfach mit Datenüberwachungstools wie Datadog verbinden.

Die Leistung des Modells verbessern

Große monolithische Transformationen sind echt schwer zu pflegen und zu optimieren. dbt macht die modulare Entwicklung einfacher, indem komplexe Logik in kleinere, wiederverwendbare Modelle aufgeteilt wird, die jeweils eine bestimmte Aufgabe erledigen.

Um die Leistung zu verbessern, kannst du diese bewährten Methoden anwenden:

- Verwende Common Table Expressions (CTEs) nur, wenn's echt nötig ist, und mach wiederholte Logik in Staging-Modellen um.

- Benennungskonventionen einführen (

stg_,int_,fct_,dim_), um den Zweck des Modells klarer zu machen. - Ich führe regelmäßig die Befehle „

dbt deps“ und „dbt docs generate“ aus, um Abhängigkeiten und Dokumentation zu überprüfen.

Du kannst auch inkrementelle Materialisierungen nutzen, um die Rechenkosten zu senken, wie im folgenden Beispiel gezeigt.

{{ config(materialized='incremental') }}

select *

from {{ source('raw', 'events') }}

{% if is_incremental() %}

where event_timestamp > (select max(event_timestamp) from {{ this }})

{% endif %}Mit dbt Mesh für die Zusammenarbeit an mehreren Projekten

Da Datenteams immer mehr Daten innerhalb einer Organisation austauschen müssen, solltest du auch die Kollaborationsoptionen von dbt Cloud in Betracht ziehen.

Umgang mit Umgebungen mit mehreren Projekten

dbt Mesh macht eine skalierbare Zusammenarbeit in großen Unternehmen möglich, indem es die gesamte Datenherkunft zentral verwaltet. Damit kann dein Team mehrere voneinander abhängige Projekte erstellen, die jeweils verschiedenen Geschäftsbereichen oder Datenbereichen zugeordnet sind.

Die wichtigsten Vorteile von dbt Mesh sind:

- Skalierbarkeit: Jedes Team kann sein eigenes dbt-Projekt haben und einsetzen, ohne dass es zu Abhängigkeitsengpässen kommt.

- Projektübergreifende Verweise: Teams können über klar definierte öffentliche Schnittstellen sicher auf Modelle aus anderen Projekten zugreifen.

- Verwaltung und Auffindbarkeit: Gemeinsam genutzte Modelle werden mit klaren Angaben zu Eigentumsverhältnissen, Dokumentation und Versionierung katalogisiert, was die Verantwortlichkeit und Transparenz fördert.

- Autonomie mit Ausrichtung: Teams können selbstständig innovativ sein und dabei die Datenstandards und Governance-Regeln des Unternehmens einhalten.

Im Grunde genommen ermöglicht dbt Mesh Teams, Modelle projektübergreifend zu nutzen und dabei ihre Unabhängigkeit zu behalten.

Zum Beispiel könnte das Finanzteam ein Projekt mit „wichtigen Finanzkennzahlen” verwalten, während das Marketingteam ein eigenes Projekt aufbaut, das auf diese Finanzmodelle zugreift, ohne Code oder Logik zu duplizieren.

dbt Mesh macht projektübergreifende Verweise über die Funktion „ ref() “ möglich, die um Projekt-Namespaces erweitert wurde. Zum Beispiel:

SELECT *

FROM {{ ref('finance_project', 'fct_revenue') }}Dadurch kann das Marketingmodell das Modell „ fct_revenue ” direkt aus dem Finanzprojekt heraus abfragen und dabei die von diesem Team definierte kanonische Version verwenden.

Versionierung und Verträge für Datenmodelle

Um Abwärtskompatibilität und Vertrauen zwischen Projekten zu sichern, hat dbt Mesh zwei wichtige Mechanismen eingeführt: Modellversionierung und Modellverträge.

Modellversionierung

Die Modellversionierung ist eine der Methoden, mit denen Teams ihre Modelle ändern können, ohne bestehende Abhängigkeiten zu zerstören. Du kannst mehrere Versionen desselben Modells über die Eigenschaft „ versions: “ in der YAML-Datei des Modells festlegen.

Zum Beispiel:

models:

- name: fct_revenue

versions:

- v: 1

description: "Initial revenue aggregation"

- v: 2

description: "Includes new discount and refund logic"Musterverträge

Musterverträge legen die Struktur, Datentypen und Einschränkungen eines Modells fest. Es ist wie eine Vereinbarung zwischen Leuten, die Daten machen, und denen, die sie nutzen.

Wenn ein Modell einen Vertrag hat, checkt dbt ihn vor der Ausführung, um sicherzustellen, dass Schemaänderungen (wie das Löschen von Spalten oder Typkonflikte) keine ungewollten Fehler weitergeben.

Beispiel für einen einfachen Vertrag:

models:

- name: fct_revenue

contract:

enforced: true

columns:

- name: customer_id

data_type: string

- name: total_revenue

data_type: numeric

- name: report_date

data_type: dateWenn jemand versucht, eine vertraglich vereinbarte Spalte zu löschen oder zu ändern, gibt dbt eine Fehlermeldung aus und schützt so abhängige Modelle und Dashboards.

Fazit

dbt Cloud macht dbt Core noch besser, indem es eine komplett verwaltete Plattform für Analytics Engineering bietet.

In diesem Leitfaden haben wir uns angesehen, wie es die Entwicklung über die Studio-IDE zentralisiert, die Orchestrierung übernimmt und neuere Tools wie dbt Mesh und die Semantic Layer unterstützt.

Durch die Zusammenführung dieser Tools auf einer einzigen Plattform können Teams mit dbt Cloud den ganzen Datenlebenszyklus von der Erfassung bis zur Dokumentation verwalten, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

Wenn du praktische Erfahrungen mit dbt sammeln möchtest, ist unser dbt Fundamentals Skill Track bietet dir einen praktischen Einstieg, um dein erstes Projekt zu erstellen.

dbt Cloud FAQ

Was sind die wichtigsten Unterschiede zwischen dbt Cloud und dbt Core?

dbt Core ist das Open-Source-Befehlszeilentool, das du lokal installierst, um dbt-Projekte manuell zu erstellen, zu testen und auszuführen.

dbt Cloud ist dagegen eine gehostete Plattform, die eine webbasierte IDE, Job-Planung, Tools für die Zusammenarbeit und Integrationen für CI/CD bietet. Damit wird es einfacher, dbt-Projekte in großem Maßstab ohne komplizierte Einrichtung zu verwalten.

Wie geht dbt Cloud mit Versionskontrolle und Zusammenarbeit um?

dbt Cloud lässt sich direkt mit Git-Plattformen wie GitHub, GitLab und Bitbucket verbinden. Damit können Entwickler direkt in der Web-IDE Code bearbeiten, Branches erstellen und Pull-Anfragen senden. Das sorgt für Versionskontrolle und Teamzusammenarbeit durch vertraute Git-Workflows.

Was sind die wichtigsten Funktionen der CI/CD-Fähigkeiten von dbt Cloud?

dbt Cloud macht das Testen und Bereitstellen automatisch, indem es bei jedem Pull-Request oder jeder Code-Zusammenführung Jobs ausführt. Es umfasst Prüfungen vor der Zusammenführung, kontinuierliche Integration zur Validierung von Modellen und automatisierte Bereitstellungen in Produktionsumgebungen, um zuverlässige und konsistente Datentransformationen zu gewährleisten.

Wie läuft die Jobplanung bei dbt Cloud ab?

Mit dbt Cloud kannst du Jobs über eine intuitive Oberfläche planen, wo du Laufzeiten, Umgebungen und Abhängigkeiten festlegen kannst. Es unterstützt zeitbasierte Planung (wie cron) und Job-Verkettung, was automatisierte Pipeline-Ausführungen und routinemäßige Modellaktualisierungen ohne manuelles Eingreifen ermöglicht.

Was sind die Vorteile der webbasierten IDE von dbt Cloud?

Die webbasierte IDE macht die Entwicklung einfacher, weil man dbt-Modelle direkt im Browser schreiben, testen und ausführen kann, ohne dass man lokal Software installieren muss. Es bietet sofortiges Feedback, integrierte Dokumentation und einfache Git-Versionsverwaltung.

Ich bin Austin, ein Blogger und Tech-Autor mit jahrelanger Erfahrung als Datenwissenschaftler und Datenanalyst im Gesundheitswesen. Ich habe meine Reise in die Welt der Technik mit einem Hintergrund in Biologie begonnen und helfe jetzt anderen mit meinem Technik-Blog, den gleichen Weg einzuschlagen. Meine Leidenschaft für Technologie hat dazu geführt, dass ich für Dutzende von SaaS-Unternehmen schreibe, um andere zu inspirieren und meine Erfahrungen zu teilen.