Curso

Tradicionalmente, los almacenes de datos han sido la solución para los datos estructurados y la inteligencia empresarial. Sin embargo, con el auge de los macrodatos, la IA y el aprendizaje automático, hasurgido una nueva arquitectura, el lago de datos, que combina los puntos fuertes de los almacenes y los lagos de datos.

En esta guía, exploraremos:

- Qué son los almacenes de datos y los lagos de datos, y en qué se diferencian.

- Características clave, ventajas y retos de cada arquitectura.

- Casos de uso en el mundo real en los que uno puede ser preferible al otro.

- Cuándo utilizar un enfoque híbrido que aproveche lo mejor de ambos mundos.

¡Vamos a sumergirnos!

¿Qué es un almacén de datos?

Un almacén de datos es un sistema centralizado que almacena, organiza y analiza datos para inteligencia empresarial (BI), elaboración de informes y análisis. Integra datos estructurados de múltiples fuentes y sigue un esquema muy organizado, garantizando coherencia y fiabilidad. Los almacenes de datos desempeñan un papel fundamental para ayudar a las empresas a tomar decisiones basadas en datos de forma eficiente.

Características

- Esquema en escritura: Los datos se transforman y estructuran antes de cargarse, ajustándose a un esquema predefinido para optimizar las consultas.

- Alto rendimiento: Optimizado para consultas complejas, permitiendo agregaciones, uniones y análisis rápidos.

- Conformidad con el ACID: Garantiza datos fiables, coherentes y precisos para aplicaciones de misión crítica.

- Gestión de datos históricos: Almacena años de datos para análisis de tendencias, previsiones y cumplimiento.

- Integración de datos: Combina datos de múltiples fuentes (ERP, CRM, bases de datos transaccionales) en un repositorio unificado.

- Seguridad y gobernanza: Proporciona control de acceso basado en roles (RBAC), cifrado de datos y funciones de cumplimiento para la seguridad de la empresa.

Casos prácticos

- Información financiera y cumplimiento de la normativa: Garantiza registros precisos y auditables para los requisitos normativos como SOX, HIPAA y GDPR.

- Cuadros de mando de inteligencia empresarial: Impulsa cuadros de mando de BI históricos y en tiempo real para la toma de decisiones basada en datos.

- Informes operativos: Admite consultas predefinidas y estructuradas para las operaciones empresariales cotidianas.

- Análisis de clientes: Permite la segmentación de clientes, el análisis del comportamiento, y la predicción de bajas utilizando conjuntos de datos estructurados.

- Cadena de suministro y logística: Optimiza la gestión de inventarios, la previsión de la demanda y la eficacia operativa con tendencias históricas.

Ejemplos de herramientas

- Copo de nieve: Un almacén de datos nativo en la nube conocido por su escalabilidad y facilidad de uso.

- Amazon Redshift: El servicio de almacenamiento de datos de AWS ofrece un rápido rendimiento de consulta e integración con otras herramientas de AWS.

- Google BigQuery: Un almacén de datos sin servidor, altamente escalable y diseñado para el análisis.

¿Qué es un lago de datos?

Un lago de datos es una arquitectura de datos moderna que combina la escalabilidad y flexibilidad de un lago de datos con el rendimiento estructurado y la fiabilidad de un almacén de datos. Permite a las organizaciones almacenar, gestionar y analizar datos estructurados, semiestructurados y no estructurados en un único sistema.

Características

- Esquema en lectura y esquema en escritura: Admite la ingestión de datos brutos para mayor flexibilidad y conjuntos de datos estructurados para el análisis tradicional.

- Diversos tipos de datos: Maneja datos estructurados (bases de datos), semiestructurados (JSON, XML) y no estructurados (imágenes, vídeos).

- Optimizado para cargas de trabajo modernas: Creado para el análisis, la IA, el aprendizaje automático y la ingestión de datos en flujo.

- Almacenamiento unificado: Combina la escalabilidad de los lagos de datos con el rendimiento de los almacenes de datos.

- Rentabilidad: Reduce los costes operativos consolidando el almacenamiento y el procesamiento.

- Gobernanza y seguridad integradas: Proporciona un control de acceso detallado, auditoría y funciones de cumplimiento para garantizar la integridad y privacidad de los datos.

Casos prácticos

- Análisis de grandes datos: Almacena y procesa grandes cantidades de datos estructurados y no estructurados para análisis a gran escala.

- Canalizaciones de IA y aprendizaje automático: Permite la ingeniería de características, la formación de modelos y la inferencia con una ingestión de datos flexible.

- Procesamiento de datos en tiempo real: Admite análisis en streaming para la detección de fraudes, sistemas de recomendación y aplicaciones IoT.

- Consolidación de datos empresariales: Unifica las cargas de trabajo operativas y analíticas, reduciendo la duplicación de datos y la complejidad.

Ejemplos de herramientas

- Databricks: Una plataforma analítica unificada conocida por implantar la arquitectura lakehouse con Delta Lake como base.

- Delta Lake: Una capa de almacenamiento de código abierto que proporciona fiabilidad y mejoras de rendimiento a los lagos de datos.

- Apache Iceberg: Un formato de tabla de alto rendimiento diseñado para el análisis multimodal a gran escala en lagos de datos.

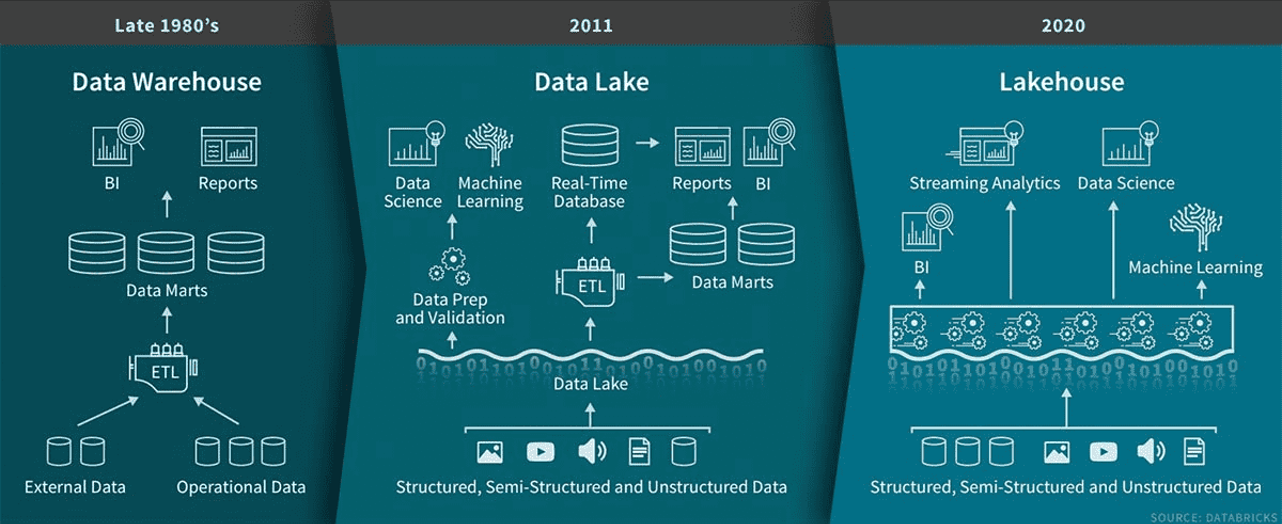

La evolución de la arquitectura de datos desde los almacenes de datos a finales de los años 80 a los lagos de datos en 2011 y, finalmente, a los lakehouses en 2020. Fuente de la imagen: Databricks.

Conviértete en Ingeniero de Datos

Diferencias entre Data Lakehouses y Data Warehouses

Comprender las diferencias clave entre los lagos de datos y los almacenes de datos puede ayudarte a determinar qué solución se adapta mejor a tus necesidades. A continuación encontrarás un desglose de sus principales distinciones.

Tipos de datos admitidos

Los lagos de datos manejan diversos tipos de datos, lo que los hace ideales para diversas cargas de trabajo. Apoyan:

- Datos estructurados: Operaciones de venta, bases de datos relacionales

- Datos semiestructurados: Perfiles de usuario JSON, lecturas de sensores

- Datos no estructurados: Registros IoT, imágenes, archivos de audio.

Los almacenes de datos almacenan principalmente datos estructurados y algunos semiestructuradospor lo que son más adecuados para los procesos empresariales tradicionales, como los informes financieros y los análisis.

Ejemplo: Una empresa minorista que utilice un lago de datos puede analizar registros de clics, datos de redes sociales y registros de transacciones para evaluar el sentimiento de los clientes.

Rentabilidad

Los lagos de datos aprovechan almacenamiento rentable en la nube (por ejemplo, Amazon S3, Azure Data Lake Storage) y admiten el esquema en lectura, reduciendo los costes de preprocesamiento ETL.

Los almacenes de datos suelen ser más caros debido al almacenamiento estructurado, el procesamiento ETL y losformatos propietarios.

Ejemplo: Una startup que necesite almacenamiento de bajo coste para datos brutos y procesados puede encontrar más asequible un lago de datos que un almacén de datos.

Rendimiento

Los lagos de datos admiten el procesamiento en tiempo real y por lotes, lo que los hace ideales para el análisis de grandes datos y el aprendizaje automático. Su arquitectura distribuida garantiza el procesamiento a alta velocidad de grandes conjuntos de datos.

Los almacenes de datos destacan por consultas basadas en SQL y cargas de trabajo transaccionales, proporcionando un rendimiento rápido y constante para los datos estructurados.

Ejemplo: Una institución financiera que realice detección de fraudes en tiempo real puede beneficiarse de la capacidad de un lago de datos para procesar datos en flujo.

Integración con el aprendizaje automático

Los lagos de datos se integran de forma nativa con herramientas de ML como TensorFlow, PyTorch y DatabricksML, permitiendo el entrenamiento directo de modelos en grandes conjuntos de datos.

Los almacenes de datos tienen soporte limitado de ML y a menudo requieren exportar los datos a sistemas externos para su análisis.

Ejemplo: Una empresa tecnológica que utilice Databricks puede desarrollar sistemas de recomendación basados en IA directamente dentro de un lago de datos.

Escalabilidad

Los almacenes de lago de datos escalan a petabytes de datos y admiten el procesamiento multimotor.

Almacenes de datos se adaptan bien a los datos estructurados pero tienen problemas con los conjuntos de datos masivos no estructurados.

Ejemplo: Un proveedor de telecomunicaciones puede escalar un almacén para procesar miles de millones de registros de llamadas al día, mientras que un almacén tradicional puede tener problemas con los registros IoT.

Tipos de usuarios

Los lagos de datos sirven científicos de datos, analistas e ingenieros que trabajan con análisis en tiempo real, pipelines de ML y análisis exploratorios.

Los almacenes de datos se dirigen principalmente a analistas empresariales y ejecutivos que confían en datos preprocesados y estructurados para la elaboración de informes y cuadros de mando.

Ejemplo: Un equipo de marketing puede utilizar un almacén de datos para cuadros de mando de BI, mientras que un equipo de ciencia de datos prefiere un almacén de lago de datos para el modelado predictivo.

Data Lakehouses vs Data Warehouses: Un resumen

Aquí tienes una tabla comparativa detallada de los data lakehouses frente a los data warehouses que incluye más detalles técnicos que los comentados anteriormente:

|

Función |

Data Lakehouse |

Almacén de datos |

|

Tipos de datos admitidos |

Estructurados, semiestructurados y no estructurados (JSON, imágenes, vídeos, registros IoT) |

Principalmente estructurado, con soporte semiestructurado limitado (JSON, XML) |

|

Formato de almacenamiento |

Formatos abiertos (Parquet, ORC, Delta, Iceberg) |

Formatos estructurados propietarios |

|

Gestión de esquemas |

Esquema en lectura y esquema en escritura (flexible) |

Esquema en escritura (estricto) |

|

Rendimiento de la consulta |

Optimizado para consultas por lotes y en tiempo real |

Optimizado para consultas SQL estructuradas |

|

Motor de procesamiento |

Admite varios motores (Spark, Presto, Trino, Dremio) |

Motores basados en SQL (Snowflake, Redshift, BigQuery) |

|

Eficiencia de costes |

Menor coste gracias al almacenamiento barato de objetos en la nube y a un menor preprocesamiento |

Mayores costes debido a ETL, almacenamiento estructurado y formatos propietarios |

|

Escalabilidad |

Se adapta fácilmente a diversas cargas de trabajo (estructuradas y no estructuradas) |

Se adapta bien a los datos estructurados, pero tiene dificultades con los conjuntos de datos masivos no estructurados |

|

Apoyo al Aprendizaje Automático (AM) |

Integración ML integrada con TensorFlow, PyTorch y Databricks ML |

Integración limitada de ML, a menudo requiere la exportación de datos |

|

Transmisión de datos en tiempo real |

Admite la ingesta y el análisis en tiempo real (Kafka, Spark Streaming) |

Soporte limitado en tiempo real, principalmente procesamiento por lotes |

|

Lo mejor para |

Cargas de trabajo AI/ML, análisis en tiempo real, big data, IoT |

Inteligencia empresarial, informes, análisis estructurados |

|

Seguridad y Gobernanza |

Seguridad avanzada, control de acceso y auditoría |

Fuertes controles de seguridad y cumplimiento para datos estructurados |

|

Ejemplos de casos prácticos |

Detección de fraudes, sistemas de recomendación, analítica IoT, entrenamiento de modelos de IA |

Informes financieros, cuadros de mando operativos, cumplimiento normativo |

|

Herramientas y plataformas populares |

Databricks, Snowflake (con Iceberg/Delta), Apache Hudi, Google BigLake |

Amazon Redshift, Google BigQuery, Snowflake, Microsoft Synapse |

Ventajas y desventajas de los almacenes de datos frente a los almacenes de datos. Lagunas de datos

En esta sección, desglosamos las principales ventajas e inconvenientes de cada arquitectura para ofrecer una visión equilibrada.

Pros y contras de los almacenes de datos

|

Pros ✅ |

Contras ❌ |

|

Optimizado para datos estructurados - Proporciona un alto rendimiento para consultas y análisis basados en SQL. |

Soporte limitado para datos no estructurados - Lucha con formatos como imágenes, vídeos, registros IoT. |

|

Rápido rendimiento de las consultas - Diseñado para agregaciones, uniones y consultas complejas con indexación y compresión. |

Costes elevados de almacenamiento y computación: caros en comparación con las soluciones de almacenamiento de objetos basadas en la nube. |

|

Cumplimiento de ACID - Garantiza la integridad, fiabilidad y coherencia de los datos, lo que es crucial para las aplicaciones financieras y normativas. |

Enfoque rígido de esquema en escritura - Los datos deben limpiarse y estructurarse antes de la ingestión, lo que aumenta la complejidad de ETL. |

|

Excelente para BI y elaboración de informes - Funciona perfectamente con Power BI, Tableau, Looker, permitiendo cuadros de mando en tiempo real. |

No es ideal para el aprendizaje automático: los flujos de trabajo de ML requieren la exportación de datos a plataformas externas para su preprocesamiento. |

|

Altamente seguro y gobernado - RBAC fuerte, encriptación y controles de cumplimiento (por ejemplo, GDPR, HIPAA). |

Difícil de escalar para los grandes datos - Lucha con conjuntos de datos masivos en comparación con arquitecturas más escalables. |

Pros y contras de los lagos de datos

|

Pros ✅ |

Contras ❌ |

|

Admite todos los tipos de datos - Puede manejar datos estructurados, semiestructurados y no estructurados en un sistema unificado. |

El rendimiento de las consultas puede ser más lento - Aunque está optimizado para el análisis a gran escala, puede requerir un ajuste adicional para las consultas de datos estructurados. |

|

Esquema flexible en lectura y esquema en escritura - Admite la ingestión de datos brutos para cargas de trabajo de ML, al tiempo que permite el almacenamiento estructurado para BI. |

Requiere más esfuerzo de gobernanza - Como los datos no siempre están preestructurados, hacer cumplir la calidad de los datos y el control de acceso es más complejo. |

|

Almacenamiento rentable - Utiliza almacenamiento de objetos en la nube (Amazon S3, Azure Data Lake) para un almacenamiento asequible y escalable. |

Curva de aprendizaje más pronunciada - Requiere familiaridad con herramientas de datos modernas como Apache Iceberg, Delta Lake y Hudi. |

|

Optimizado para cargas de trabajo de IA y ML - Se integra perfectamente con TensorFlow, PyTorch, Databricks ML y marcos de streaming en tiempo real. |

Desafíos para la coherencia de los datos - Lograr el cumplimiento de ACID en vastos conjuntos de datos distribuidos requiere configuraciones adicionales. |

|

Procesamiento de datos en tiempo real - Admite la ingesta de datos en flujo desde dispositivos IoT, registros y fuentes de eventos en tiempo real. |

Menos maduros que los almacenes de datos - Los almacenes tradicionales tienen un historial más largo de fiabilidad probada para el BI y los informes financieros. |

Cuándo utilizar un almacén de datos

Los almacenes de datos se adaptan mejor a los datos estructurados, la inteligencia empresarial y el cumplimiento normativo. Un almacén de datos es la elección adecuada si dependes de análisis muy organizados, rápidos y coherentes.

Análisis de datos estructurados

- Ideal para conjuntos de datos limpios y estructurados con requisitos de esquema bien definidos.

- Utilízalo cuando la coherencia y el rendimiento sean fundamentales para los análisis y los informes.

Ejemplo: Una empresa que utiliza un almacén de datos para analizar los datos de ventas estructurados de su amplia red de tiendas. Esto ayuda a controlar los niveles de inventario, identificar los productos más vendidos y optimizar los procesos de reposición en tiempo real.

Informes de inteligencia empresarial (BI)

- Lo mejor para generar cuadros de mando e informes para los responsables de la toma de decisiones.

- Admite herramientascomo Power BI y Tableau con un rendimiento de consulta optimizado.

Ejemplo: Una empresa de servicios financieros que elabora informes trimestrales de resultados para las partes interesadas.

Cumplimiento de la normativa

- Diseñado para industrias con requisitos estrictos de precisión de datos y auditoría.

- Proporciona almacenamiento fiable para registros financieros, datos sanitarios e informes de cumplimiento.

Ejemplo: Una institución financiera utiliza un almacén de datos para almacenar y analizar datos transaccionales, garantizando el cumplimiento de normativas como Basilea III y el GDPR. Este enfoque centralizado ayuda a gestionar los registros de auditoría y a evitar el fraude.

Análisis de datos históricos

- Utilízalo para el análisis de tendencias a largo plazo y la toma de decisiones estratégicas.

- Es ideal para industrias como la manufacturera o la energética, que necesitan una visión plurianual de los datos.

Ejemplo: Una empresa energética que analiza el uso histórico de la energía para optimizar la producción.

Cuándo utilizar un lago de datos

Un lago de datos es ideal cuando necesitas un sistema escalable y flexible que pueda manejar datos estructurados, semiestructurados y no estructurados, a la vez que admite IA, aprendizaje automático y análisis en tiempo real.

Almacenamiento unificado para datos diversos

- Lo mejor para combinar datos estructurados, semiestructurados y no estructurados en una sola plataforma.

- Reduce los silos y admite el acceso dinámico a los datos.

Ejemplo: Un servicio de streaming que almacena contenidos de vídeo, registros de actividad de los usuarios y metadatos.

Flujos de trabajo de aprendizaje automático e IA

- Perfecto para la exploración de datos brutos, el entrenamiento de modelos y la experimentación.

- Proporciona flexibilidad de lectura de esquemas para diversos conjuntos de datos.

Ejemplo: Una empresa que utiliza un lago de datos para procesar los datos brutos de los viajes, las valoraciones de los conductores y los registros GPS. Estos datos impulsan modelos de aprendizaje automático para la optimización de rutas, la fijación dinámica de precios y la detección de fraudes.

Transmisión de datos en tiempo real

- Utilízalo para aplicaciones que requieran una ingesta y un procesamiento de datos casi instantáneos.

- Admite casos de uso dinámicos como la detección de fraudes y el análisis del IoT.

Ejemplo: Los vehículos habilitados para IoT transmiten datos de sensores en tiempo real a una arquitectura de lago. Esto permite a la empresa controlar el rendimiento del vehículo, detectar anomalías y lanzar actualizaciones de software por aire.

Almacenamiento rentable de big data

- Reduce los gastos almacenando los datos en bruto sin un preprocesamiento exhaustivo.

- Escala eficientemente para organizaciones que generan grandes cantidades de datos.

Ejemplo: Una empresa de medios sociales que utiliza un lago de datos para almacenar y procesar grandes cantidades de contenido en bruto generado por los usuarios, como textos, imágenes y vídeos. Esta configuración les permite realizar análisis de sentimiento, detectar temas de tendencia y optimizar la orientación de los anuncios.

Soluciones híbridas: Combinar almacenes de datos y lagos de datos

Aunque los almacenes de datos y los almacenes lacustres tienen finalidades distintas, muchas organizaciones combinan arquitecturas para equilibrar rendimiento, coste y flexibilidad.

Un enfoque híbrido te permite almacenar datos estructurados en un almacén para un análisis rápido, al tiempo que aprovechas un lago para big data, IA y aprendizaje automático.

Un enfoque híbrido sigue una estrategia de dos niveles:

- Datos brutos y semiestructurados en el lago de datos (flexible, escalable, rentable)

-

- Almacena datos diversos (estructurados, semiestructurados, no estructurados) en almacenamiento de objetos en la nube (Amazon S3, Azure Data Lake, Google Cloud Storage).

- Utiliza el esquema en lectura para proporcionar flexibilidad a los científicos de datos y a los equipos de IA/ML.

- Admite la ingesta de datos en tiempo real desde dispositivos IoT, registros de eventos y plataformas de streaming.

- Datos estructurados y depurados en el almacén de datos (optimizados para análisis rápidos y BI)

-

- Los datos se filtran, transforman y estructuran antes de almacenarse en un almacén (Snowflake, Redshift, BigQuery, Synapse).

- Utiliza el esquema en escritura para reforzar la coherencia de los datos y optimizar el rendimiento de las consultas.

- Proporciona un acceso rápido a la inteligencia empresarial, cuadros de mando e informes operativos.

Una arquitectura de datos híbrida es beneficiosa cuando

- Necesitas informes BI de alta velocidad y almacenamiento de datos flexible para cargas de trabajo ML/AI.

- Tu empresa maneja datos estructurados y no estructurados, que requieren capacidades de esquema en escritura y esquema en lectura.

- Quieres optimizar los costes, utilizando un almacén para los análisis estructurados de alto valor y un lago para el almacenamiento rentable de datos brutos.

- Necesitas la ingesta y el procesamiento de datos en tiempo real, al tiempo que mantienes los registros históricos gobernados.

Conclusión

Esta guía explora las principales diferencias entre los almacenes de datos y los lagos de datos, sus puntos fuertes, retos y casos de uso, y cómo las organizaciones suelen combinar ambas arquitecturas para adoptar un enfoque híbrido.

Comprender estos conceptos es esencial para construir sistemas de datos eficientes y preparados para el futuro, a medida que evolucionan las arquitecturas de datos. Para profundizar en estos temas, consulta estos cursos:

- Conceptos de Almacenamiento de Datos - Una guía básica sobre los almacenes de datos, sus componentes y su papel en la analítica.

- Conceptos de Databricks - Aprende cómo Databricks permite una arquitectura de lago de datos para el procesamiento escalable de datos y el aprendizaje automático.

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Cómo migrar de un almacén de datos a un lago de datos?

Migrar implica:

- Evaluar los datos - Identificar las fuentes estructuradas y no estructuradas.

- Elección de una plataforma - Herramientas como Databricks, Apache Iceberg o Snowflake admiten lagos.

- Construcción de pipelines ETL - Utiliza Apache Spark o dbt para la transformación e ingestión.

- Optimizar el rendimiento - Implementar estrategias de indexación, almacenamiento en caché y partición.

¿Cómo funciona la gobernanza en un lago de datos en comparación con un almacén de datos?

Los almacenes de datos tienen un gobierno centralizado, con control de acceso basado en roles (RBAC) y esquemas predefinidos.

Los lagos de datos requieren:

- Controles de acceso de grano fino (por ejemplo, AWS Formación de Lagos, Catálogo Unity).

- Gestión de metadatos para rastrear los conjuntos de datos a través de las capas de almacenamiento.

- Control de la calidad de los datos para garantizar su coherencia en entornos de lectura de esquemas.

¿Cuáles son los mayores retos a la hora de adoptar un lago de datos?

- Ajuste del rendimiento de las consultas - Requiere técnicas de optimización como la indexación y el almacenamiento en caché.

- Problemas de consistencia de los datos - Necesita soporte para transacciones ACID (por ejemplo, Delta Lake, Apache Iceberg).

- Curva de aprendizaje - Los equipos deben adoptar nuevas herramientas más allá de los sistemas tradicionales basados en SQL.

¿Qué papel desempeñan la IA y el aprendizaje automático en el modelo de la casa del lago?

Las casas lago son ideales para la IA/ML porque

- Almacena datos estructurados, semiestructurados y no estructurados para entrenar modelos.

- Permite la ingeniería de características en tiempo real con Databricks ML y Spark.

- Admite el entrenamiento de modelos a la carta sin necesidad de exportar datos.

A diferencia de los almacenes, los almacenes de lago permiten a los científicos de datos trabajar directamente con los datos en bruto.

¿Cuál es el futuro de los almacenes y lagos de datos?

La industria está cambiando hacia arquitecturas híbridas y unificadas.

- Las plataformas en la nube están integrando funciones de lago en las soluciones de almacén.

- El almacenamiento de datos sin servidor está mejorando la escalabilidad y la rentabilidad.

- Las arquitecturas de malla de datos están descentralizando la propiedad de los datos entre los equipos.

Comprender estas tendencias ayudará a los profesionales de los datos a mantenerse a la vanguardia.

Sai es ingeniero de software con experiencia en Python, Java, plataformas en la nube y análisis de grandes datos, y tiene un máster en Ingeniería de Software por la UMBC. Experiencia en modelos de IA, sistemas IoT escalables y proyectos basados en datos en todos los sectores.