Kurs

Traditionell sind Data Warehouses die beste Lösung für strukturierte Daten und Business Intelligence. Mit dem Aufkommen von Big Data, KI und maschinellem Lernen ist jedoch eine neuere Architektur entstanden - das Data Lakehouse -, das die Stärken von Data Warehouses und Data Lakes kombiniert.

In diesem Leitfaden erfahren wir mehr darüber:

- Was Data Warehouses und Data Lakehouses sind und wie sie sich unterscheiden.

- Die wichtigsten Merkmale, Vorteile und Herausforderungen der einzelnen Architekturen.

- Reale Anwendungsfälle, in denen die eine der anderen vorzuziehen ist.

- Wann du einen hybriden Ansatz wählen solltest, der das Beste aus beiden Welten nutzt.

Lass uns eintauchen!

Was ist ein Data Warehouse?

Ein Data Warehouse ist ein zentrales System, das Daten für Business Intelligence (BI), Berichte und Analysen speichert, organisiert und analysiert. Es integriert strukturierte Daten aus verschiedenen Quellen und folgt einem hoch organisierten Schema, das Konsistenz und Zuverlässigkeit gewährleistet. Data Warehouses spielen eine zentrale Rolle dabei, dass Unternehmen datengestützte Entscheidungen effizient treffen können.

Eigenschaften

- Schema-on-write: Die Daten werden vor dem Laden umgewandelt und strukturiert und folgen einem vordefinierten Schema, um die Abfrage zu optimieren.

- Hohe Leistung: Optimiert für komplexe Abfragen, die schnelle Aggregationen, Joins und Analysen ermöglichen.

- ACID-Konformität: Sorgt für zuverlässige, konsistente und genaue Daten für unternehmenskritische Anwendungen.

- Verwaltung historischer Daten: Speichert jahrelange Daten für Trendanalysen, Prognosen und die Einhaltung von Vorschriften.

- Datenintegration: Kombiniert Daten aus verschiedenen Quellen (ERP, CRM, Transaktionsdatenbanken) in einem einheitlichen Repository.

- Sicherheit und Governance: Bietet rollenbasierte Zugriffskontrolle (RBAC), Datenverschlüsselung und Compliance-Funktionen für die Unternehmenssicherheit.

Anwendungsfälle

- Finanzberichterstattung und Einhaltung von Vorschriften: Gewährleistet genaue, prüfbare Aufzeichnungen für gesetzliche Anforderungen wie SOX, HIPAA und GDPR.

- Business Intelligence Dashboards: Ermöglicht Echtzeit- und historische BI-Dashboards für datengesteuerte Entscheidungen.

- Operative Berichterstattung: Unterstützt vordefinierte, strukturierte Abfragen für den täglichen Geschäftsbetrieb.

- Kundenanalytik: Ermöglicht Kundensegmentierung, Verhaltensanalyse und Abwanderungsvorhersage anhand strukturierter Datensätze.

- Lieferkette und Logistik: Optimiert die Bestandsverwaltung, die Bedarfsprognose und die betriebliche Effizienz anhand historischer Trends.

Beispiele für Werkzeuge

- Snowflake: Ein Cloud-natives Data Warehouse, das für seine Skalierbarkeit und Benutzerfreundlichkeit bekannt ist.

- Amazon Redshift: Der Data Warehousing Service von AWS bietet eine schnelle Abfrageleistung und die Integration mit anderen AWS-Tools.

- Google BigQuery: Ein serverloses, hoch skalierbares Data Warehouse, das für Analysen entwickelt wurde.

Was ist ein Data Lakehouse?

Ein Data Lakehouse ist eine moderne Datenarchitektur, die die Skalierbarkeit und Flexibilität eines Data Lakes mit der strukturierten Leistung und Zuverlässigkeit eines Data Warehouses kombiniert. Es ermöglicht Unternehmen, strukturierte, halbstrukturierte und unstrukturierte Daten in einem einzigen System zu speichern, zu verwalten und zu analysieren.

Eigenschaften

- Schema-on-read und Schema-on-write: Unterstützt die Aufnahme von Rohdaten für Flexibilität und strukturierte Datensätze für traditionelle Analysen.

- Vielfältige Datentypen: Verarbeitet strukturierte (Datenbanken), halbstrukturierte (JSON, XML) und unstrukturierte (Bilder, Videos) Daten.

- Optimiert für moderne Workloads: Entwickelt für Analytik, KI, maschinelles Lernen und Streaming Data Ingestion.

- Unified Storage: Kombiniert die Skalierbarkeit von Data Lakes mit der Leistung von Data Warehouses.

- Kosteneffizienz: Reduziert die Betriebskosten durch die Konsolidierung von Lagerung und Verarbeitung.

- Eingebaute Governance und Sicherheit: Bietet fein abgestufte Zugriffskontroll-, Prüfungs- und Compliance-Funktionen, um Datenintegrität und Datenschutz zu gewährleisten.

Anwendungsfälle

- Big Data-Analytik: Speichert und verarbeitet riesige Mengen strukturierter und unstrukturierter Daten für groß angelegte Analysen.

- KI und maschinelles Lernen in Pipelines: Ermöglicht Feature-Engineering, Modelltraining und Inferenz mit flexiblem Dateningestion.

- Datenverarbeitung in Echtzeit: Unterstützt Streaming-Analysen für Betrugserkennung, Empfehlungssysteme und IoT-Anwendungen.

- Konsolidierung von Unternehmensdaten: Vereinheitlicht operative und analytische Arbeitslasten und reduziert so Datenduplikate und Komplexität.

Beispiele für Werkzeuge

- Databricks: Eine einheitliche Analyseplattform, die für die Implementierung der Lakehouse-Architektur mit Delta Lake als Grundlage bekannt ist.

- Delta Lake: Eine Open-Source-Speicherschicht, die die Zuverlässigkeit und Leistung von Data Lakes verbessert.

- Apache Iceberg: Ein leistungsstarkes Tabellenformat, das für umfangreiche, multimodale Analysen in Data Lakes entwickelt wurde.

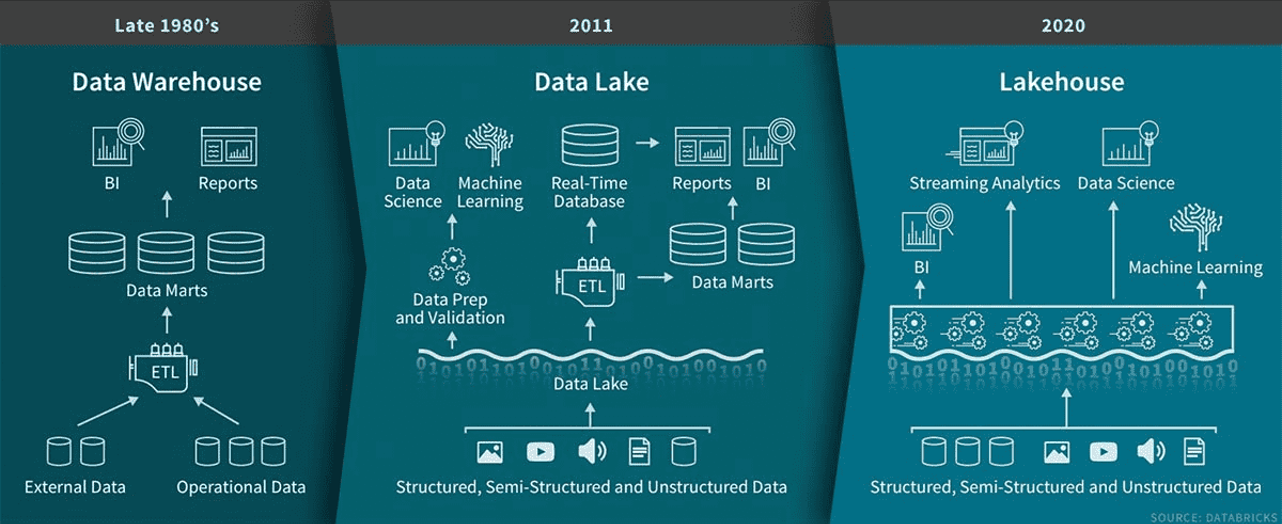

Die Entwicklung der Datenarchitektur von Data Warehouses in den späten 1980er Jahren zu Data Lakes im Jahr 2011 und schließlich zu Lakehouses im Jahr 2020. Bildquelle: Databricks.

Werde Dateningenieur

Unterschiede zwischen Data Lakehouses und Data Warehouses

Wenn du die wichtigsten Unterschiede zwischen Data Lakehouses und Data Warehouses kennst, kannst du herausfinden, welche Lösung am besten zu deinen Anforderungen passt. Im Folgenden findest du eine Aufschlüsselung der wichtigsten Unterschiede.

Unterstützte Datentypen

Data Lakehouses verarbeiten verschiedene Datentypen und sind daher ideal für unterschiedliche Arbeitslasten. Sie unterstützen:

- Strukturierte Daten: Verkaufstransaktionen, relationale Datenbanken

- Semi-strukturierte Daten: JSON-Benutzerprofile, Sensormesswerte

- Unstrukturierte Daten: IoT-Logs, Bilder, Audiodateien.

Data Warehouses speichern in erster Linie strukturierte und einige halbstrukturierte DatenDadurch eignen sie sich besser für traditionelle Geschäftsprozesse wie Finanzberichte und Analysen.

Beispiel: Ein Einzelhandelsunternehmen, das ein Data Lakehouse nutzt, kann Clickstream-Protokolle, Social-Media-Daten und Transaktionsdatensätze analysieren, um die Stimmung der Kunden zu bewerten.

Kosteneffizienz

Data Lakehouses nutzen die kostengünstigen Cloud-Speicher (z.B. Amazon S3, Azure Data Lake Storage) und unterstützen Schema-on-Read, was die Kosten für die ETL-Vorverarbeitung reduziert.

Data Warehouses sind aufgrund der strukturierten Speicherung, der ETL-Verarbeitung und derproprietären Formatein der Regel teurer.

Beispiel: Für ein Startup, das kostengünstigen Speicherplatz für Rohdaten und verarbeitete Daten benötigt, ist ein Data Lakehouse vielleicht günstiger als ein Data Warehouse.

Leistung

Data Lakehouses unterstützen Echtzeit- und Stapelverarbeitung und sind damit ideal für Big Data-Analysen und maschinelles Lernen. Ihre verteilte Architektur sorgt für eine schnelle Verarbeitung großer Datenmengen.

Data Warehouses zeichnen sich aus durch SQL-basierte Abfragen und transaktionalen Workloads und bieten eine schnelle, konsistente Leistung für strukturierte Daten.

Beispiel: Ein Finanzinstitut, das Betrug in Echtzeit aufdeckt, kann von der Fähigkeit eines Data Lakehouse profitieren, Streaming-Daten zu verarbeiten.

Integration mit maschinellem Lernen

Data Lakehouses lassen sich nativ in ML-Tools wie TensorFlow, PyTorch und DatabricksMLintegrierenund ermöglichen das direkte Modelltraining auf großen Datensätzen.

Data Warehouses haben begrenzte ML-Unterstützung und erfordern oft den Export von Daten in externe Systeme zur Analyse.

Beispiel: Ein Technologieunternehmen, das Databricks nutzt, kann KI-gestützte Empfehlungssysteme direkt in einem Data Lakehouse entwickeln.

Skalierbarkeit

Data Lakehouses skalieren auf Petabytes an Daten und unterstützen gleichzeitig die Verarbeitung mehrerer Maschinen.

Data Warehouses skalieren gut für strukturierte Daten haben aber Schwierigkeiten mit großen unstrukturierten Datenmengen.

Beispiel: Ein Telekommunikationsanbieter kann ein Seehaus so skalieren, dass es täglich Milliarden von Anrufdatensätzen verarbeiten kann, während ein traditionelles Lagerhaus mit IoT-Protokollen zu kämpfen hat.

Arten von Nutzern

Data Lakehouses dienen Datenwissenschaftler, Analysten und Ingenieure die mit Echtzeit-Analysen, ML-Pipelines und explorativen Analysen arbeiten.

Data Warehouses richten sich in erster Linie an Business-Analysten und Führungskräfte, die auf vorverarbeitete, strukturierte Daten für Berichte und Dashboards angewiesen sind.

Beispiel: Ein Marketingteam könnte ein Data Warehouse für BI-Dashboards nutzen, während ein Data Science Team ein Data Lakehouse für prädiktive Modellierung bevorzugt.

Data Lakehouses vs. Data Warehouses: Eine Zusammenfassung

Hier findest du eine detaillierte Tabelle zum Vergleich von Data Lakehouses und Data Warehouses, die noch mehr technische Details enthält als die zuvor besprochenen:

|

Feature |

Daten-See-Haus |

Data Warehouse |

|

Unterstützte Datentypen |

Strukturiert, halbstrukturiert und unstrukturiert (JSON, Bilder, Videos, IoT-Logs) |

Hauptsächlich strukturiert, mit begrenzter semi-strukturierter Unterstützung (JSON, XML) |

|

Speicherformat |

Offene Formate (Parkett, ORC, Delta, Iceberg) |

Proprietär strukturierte Formate |

|

Schema Management |

Schema-on-read & schema-on-write (flexibel) |

Schema-on-write (strict) |

|

Abfrageleistung |

Optimiert für Batch- und Echtzeit-Abfragen |

Optimiert für strukturierte SQL-Abfragen |

|

Verarbeitungsmaschine |

Unterstützt mehrere Engines (Spark, Presto, Trino, Dremio) |

SQL-basierte Engines (Snowflake, Redshift, BigQuery) |

|

Kosteneffizienz |

Geringere Kosten durch billigen Cloud-Objektspeicher und weniger Vorverarbeitungen |

Höhere Kosten aufgrund von ETL, strukturierter Speicherung und proprietären Formaten |

|

Skalierbarkeit |

Einfache Skalierung mit unterschiedlichen Arbeitslasten (strukturiert und unstrukturiert) |

Skaliert gut für strukturierte Daten, hat aber Probleme mit großen unstrukturierten Datensätzen |

|

Unterstützung für maschinelles Lernen (ML) |

Integrierte ML-Integration mit TensorFlow, PyTorch und Databricks ML |

Begrenzte ML-Integration, erfordert oft Datenexport |

|

Datenstreaming in Echtzeit |

Unterstützt Echtzeit-Ingestion und -Analysen (Kafka, Spark Streaming) |

Eingeschränkte Echtzeit-Unterstützung, hauptsächlich Stapelverarbeitung |

|

Am besten für |

KI/ML-Workloads, Echtzeit-Analysen, Big Data, IoT |

Business Intelligence, Berichterstattung, strukturierte Analysen |

|

Sicherheit & Governance |

Erweiterte Sicherheit, Zugangskontrolle und Auditing |

Starke Sicherheits- und Compliance-Kontrollen für strukturierte Daten |

|

Beispiele für Anwendungsfälle |

Betrugserkennung, Empfehlungssysteme, IoT-Analytik, KI-Modelltraining |

Finanzberichte, operative Dashboards, Einhaltung von Vorschriften |

|

Beliebte Tools & Plattformen |

Databricks, Snowflake (mit Iceberg/Delta), Apache Hudi, Google BigLake |

Amazon Redshift, Google BigQuery, Snowflake, Microsoft Synapse |

Vor- und Nachteile von Data Warehouses vs. Daten Lakehouses

In diesem Abschnitt gehen wir auf die wichtigsten Vor- und Nachteile jeder Architektur ein, um ein ausgewogenes Bild zu vermitteln.

Vor- und Nachteile von Data Warehouses

|

Pros ✅ |

Nachteile ❌ |

|

Optimiert für strukturierte Daten - Bietet eine hohe Leistung für SQL-basierte Abfragen und Auswertungen. |

Begrenzte Unterstützung für unstrukturierte Daten - Probleme mit Formaten wie Bildern, Videos und IoT-Logs. |

|

Schnelle Abfrageleistung - Entwickelt für Aggregationen, Joins und komplexe Abfragen mit Indizierung und Komprimierung. |

Hohe Speicher- und Rechenkosten - Teuer im Vergleich zu Cloud-basierten Objektspeicherlösungen. |

|

ACID-Konformität - Gewährleistet Datenintegrität, Zuverlässigkeit und Konsistenz, was für Finanz- und Regulierungsanwendungen entscheidend ist. |

Starrer Schema-on-write-Ansatz - Die Daten müssen vor der Aufnahme bereinigt und strukturiert werden, was die ETL-Komplexität erhöht. |

|

Hervorragend geeignet für BI und Reporting - Funktioniert nahtlos mit Power BI, Tableau und Looker und ermöglicht Dashboards in Echtzeit. |

Nicht ideal für maschinelles Lernen - ML-Workflows erfordern einen Datenexport an externe Plattformen zur Vorverarbeitung. |

|

Hohe Sicherheit und Kontrolle - Starke RBAC-, Verschlüsselungs- und Compliance-Kontrollen (z. B. GDPR, HIPAA). |

Schwierige Skalierung für Big Data - Probleme mit großen Datenmengen im Vergleich zu skalierbaren Architekturen. |

Vor- und Nachteile von Data Lakehouses

|

Pros ✅ |

Nachteile ❌ |

|

Unterstützt alle Datentypen - Kann strukturierte, halbstrukturierte und unstrukturierte Daten in einem einheitlichen System verarbeiten. |

Die Abfrageleistung kann langsamer sein - Sie ist zwar für umfangreiche Analysen optimiert, kann aber für strukturierte Datenabfragen zusätzliche Einstellungen erfordern. |

|

Flexibles Schema-on-read und Schema-on-write - Unterstützt die Aufnahme von Rohdaten für ML-Workloads und ermöglicht strukturierte Speicherung für BI. |

Erfordert mehr Aufwand für die Verwaltung - Da die Daten nicht immer vorstrukturiert sind, ist die Durchsetzung der Datenqualität und der Zugriffskontrolle komplexer. |

|

Kostengünstiger Speicher - Nutzt Cloud-Objektspeicher (Amazon S3, Azure Data Lake) für kostengünstigen, skalierbaren Speicher. |

Steilere Lernkurve - Erfordert Vertrautheit mit modernen Datentools wie Apache Iceberg, Delta Lake und Hudi. |

|

Optimiert für KI- und ML-Workloads - Nahtlose Integration mit TensorFlow, PyTorch, Databricks ML und Echtzeit-Streaming-Frameworks. |

Herausforderungen bei der Datenkonsistenz - Um die ACID-Konformität bei großen, verteilten Datenmengen zu erreichen, sind zusätzliche Konfigurationen erforderlich. |

|

Echtzeit-Datenverarbeitung - Unterstützt die Aufnahme von Streaming-Daten von IoT-Geräten, Protokollen und Echtzeit-Ereignisquellen. |

Weniger ausgereift als Data Warehouses - Traditionelle Warehouses haben eine längere Geschichte bewährter Zuverlässigkeit für BI und Finanzberichte. |

Wann wird ein Data Warehouse eingesetzt?

Data Warehouses eignen sich am besten für strukturierte Daten, Business Intelligence und die Einhaltung von Vorschriften. Ein Data Warehouse ist die richtige Wahl, wenn du auf gut organisierte, schnelle und konsistente Analysen angewiesen bist.

Strukturierte Datenanalytik

- Ideal für saubere, strukturierte Datensätze mit klar definierten Schemaanforderungen.

- Verwende sie, wenn Konsistenz und Leistung für Analysen und Berichte entscheidend sind.

Beispiel: Ein Unternehmen, das ein Data Warehouse nutzt, um strukturierte Verkaufsdaten aus seinem riesigen Filialnetz zu analysieren. Auf diese Weise kannst du den Lernpfad verfolgen, die meistverkauften Produkte identifizieren und die Auffüllprozesse in Echtzeit optimieren.

Business Intelligence (BI)-Berichte

- Am besten geeignet für die Erstellung von Dashboards und Berichten für Entscheidungsträger.

- Unterstützt Toolswie Power BI und Tableau mit optimierter Abfrageleistung.

Beispiel: Ein Finanzdienstleistungsunternehmen erstellt vierteljährliche Ergebnisberichte für seine Stakeholder.

Einhaltung von Vorschriften

- Entwickelt für Branchen mit strengen Anforderungen an die Datengenauigkeit und Prüfung.

- Ermöglicht die zuverlässige Speicherung von Finanzunterlagen, Gesundheitsdaten und Compliance-Berichten.

Beispiel: Ein Finanzinstitut nutzt ein Data Warehouse, um Transaktionsdaten zu speichern und zu analysieren und die Einhaltung von Vorschriften wie Basel III und GDPR sicherzustellen. Dieser zentralisierte Ansatz hilft bei der Verwaltung von Prüfpfaden und verhindert Betrug.

Analyse historischer Daten

- Nutze sie für langfristige Trendanalysen und strategische Entscheidungen.

- Sie ist ideal für Branchen wie die verarbeitende Industrie oder die Energiewirtschaft, die mehrjährige Dateneinblicke benötigen.

Beispiel: Ein Energieversorgungsunternehmen analysiert den historischen Stromverbrauch, um die Produktion zu optimieren.

Wann sollte man ein Data Lakehouse nutzen?

Ein Data Lakehouse ist ideal, wenn du ein skalierbares, flexibles System brauchst, das strukturierte, halbstrukturierte und unstrukturierte Daten verarbeiten kann und gleichzeitig KI, maschinelles Lernen und Echtzeit-Analysen unterstützt.

Einheitlicher Speicher für unterschiedliche Daten

- Am besten geeignet, um strukturierte, halbstrukturierte und unstrukturierte Daten in einer einzigen Plattform zu kombinieren.

- Reduziert Silos und unterstützt den dynamischen Datenzugriff.

Beispiel: Ein Streaming-Dienst, der Videoinhalte, Protokolle der Nutzeraktivitäten und Metadaten speichert.

Maschinelles Lernen und KI-Workflows

- Perfekt für die Erkundung von Rohdaten, Modelltraining und Experimente.

- Bietet Schema-on-read-Flexibilität für verschiedene Datensätze.

Beispiel: Ein Unternehmen, das ein Data Lakehouse nutzt, um rohe Fahrdaten, Fahrerbewertungen und GPS-Logs zu verarbeiten. Diese Daten bilden die Grundlage für maschinelle Lernmodelle zur Routenoptimierung, dynamischen Preisgestaltung und Betrugserkennung.

Datenstreaming in Echtzeit

- Für Anwendungen, die eine nahezu sofortige Dateneingabe und -verarbeitung erfordern.

- Unterstützt dynamische Anwendungsfälle wie Betrugserkennung und IoT-Analysen.

Beispiel: IoT-fähige Fahrzeuge streamen Sensordaten in Echtzeit an eine Lakehouse-Architektur. So kann ein Unternehmen die Leistung des Fahrzeugs überwachen, Anomalien erkennen und Software-Updates über die Luft verteilen.

Kostengünstige Speicherung von Big Data

- Reduziert die Kosten durch die Speicherung von Rohdaten ohne umfangreiche Vorverarbeitung.

- Skaliert effizient für Unternehmen, die große Datenmengen erzeugen.

Beispiel: Ein Social-Media-Unternehmen, das ein Data Lakehouse nutzt, um große Mengen an nutzergenerierten Inhalten wie Texte, Bilder und Videos zu speichern und zu verarbeiten. Auf diese Weise können sie Stimmungsanalysen durchführen, Trendthemen erkennen und die Anzeigenausrichtung optimieren.

Hybride Lösungen: Kombination von Data Warehouses und Data Lakehouses

Obwohl Data Warehouses und Lakehouses unterschiedlichen Zwecken dienen, kombinieren viele Unternehmen die Architekturen, um ein Gleichgewicht zwischen Leistung, Kosten und Flexibilität herzustellen.

Ein hybrider Ansatz ermöglicht es dir, strukturierte Daten in einem Warehouse für schnelle Analysen zu speichern und gleichzeitig ein Lakehouse für Big Data, KI und maschinelles Lernen zu nutzen.

Ein hybrider Ansatz verfolgt eine zweistufige Strategie:

- Rohe und halbstrukturierte Daten im Data Lakehouse (flexibel, skalierbar, kostengünstig)

-

- Speichert verschiedene Daten (strukturiert, halbstrukturiert, unstrukturiert) in Cloud Object Storage (Amazon S3, Azure Data Lake, Google Cloud Storage).

- Verwendet Schema-on-Read, um Datenwissenschaftlern und KI/ML-Teams Flexibilität zu bieten.

- Unterstützt die Aufnahme von Daten in Echtzeit von IoT-Geräten, Ereignisprotokollen und Streaming-Plattformen.

- Strukturierte und bereinigte Daten im Data Warehouse (optimiert für schnelle Analysen und BI)

-

- Die Daten werden gefiltert, umgewandelt und strukturiert, bevor sie in einem Warehouse (Snowflake, Redshift, BigQuery, Synapse) gespeichert werden.

- Verwendet das Schema-on-write, um die Datenkonsistenz zu gewährleisten und die Abfrageleistung zu optimieren.

- Bietet schnellen Zugriff auf Business Intelligence, Dashboards und operative Berichte.

Eine hybride Datenarchitektur ist von Vorteil, wenn:

- Du brauchst schnelle BI-Berichte und flexible Datenspeicher für ML/AI-Workloads.

- Dein Unternehmen verarbeitet strukturierte und unstrukturierte Daten und benötigt dafür Schema-on-Write- und Schema-on-Read-Funktionen.

- Du willst die Kosten optimieren, indem du ein Warehouse für strukturierte, hochwertige Analysen und ein Lakehouse für die kostengünstige Speicherung von Rohdaten nutzt.

- Du musst Daten in Echtzeit erfassen und verarbeiten und gleichzeitig die historischen Aufzeichnungen verwalten.

Fazit

In diesem Leitfaden wurden die wichtigsten Unterschiede zwischen Data Warehouses und Data Lakehouses, ihre Stärken, Herausforderungen und Anwendungsfälle untersucht und wie Unternehmen oft beide Architekturen in einem hybriden Ansatz kombinieren.

Das Verständnis dieser Konzepte ist entscheidend für den Aufbau effizienter, zukunftssicherer Datensysteme, wenn sich die Datenarchitekturen weiterentwickeln. Wenn du tiefer in diese Themen einsteigen willst, schau dir diese Kurse an:

- Data Warehousing Concepts - Ein grundlegender Leitfaden zu Data Warehouses, ihren Komponenten und ihrer Rolle in der Analytik.

- Databricks-Konzepte - Erfahre, wie Databricks eine Data-Lakehouse-Architektur für skalierbare Datenverarbeitung und maschinelles Lernen ermöglicht.

Werde Dateningenieur

FAQs

Wie migriere ich von einem Data Warehouse zu einem Data Lakehouse?

Die Migration beinhaltet:

- Daten auswerten - Identifiziere strukturierte und unstrukturierte Quellen.

- Auswahl einer Plattform - Tools wie Databricks, Apache Iceberg oder Snowflake unterstützen Lakehouses.

- Aufbau von ETL-Pipelines - Verwende Apache Spark oder dbt für Transformation und Ingestion.

- Optimieren der Leistung - Implementieren von Indizierungs-, Caching- und Partitionierungsstrategien.

Wie funktioniert die Governance in einem Data Lakehouse im Vergleich zu einem Data Warehouse?

Data Warehouses haben eine zentralisierte Verwaltung mit rollenbasierter Zugriffskontrolle (RBAC) und vordefinierten Schemata.

Data Lakehouses erfordern:

- Feinkörnige Zugriffskontrollen (z. B. AWS Lake Formation, Unity Catalog).

- Metadatenmanagement zur Verfolgung von Datensätzen über verschiedene Speicherebenen hinweg.

- Überwachung der Datenqualität auf Konsistenz in Schema-on-read-Umgebungen.

Was sind die größten Herausforderungen bei der Einführung eines Data Lakehouse?

- Tuning der Abfrageleistung - Erfordert Optimierungstechniken wie Indizierung und Caching.

- Datenkonsistenzprobleme - Benötigt ACID-Transaktionsunterstützung (z. B. Delta Lake, Apache Iceberg).

- Lernkurve - Die Teams müssen sich neue Tools aneignen, die über die traditionellen SQL-basierten Systeme hinausgehen.

Welche Rolle spielen KI und maschinelles Lernen im Seehaus-Modell?

Seehäuser sind ideal für AI/ML, weil sie:

- Speichere strukturierte, halbstrukturierte und unstrukturierte Daten für das Training von Modellen.

- Ermögliche die Entwicklung von Funktionen in Echtzeit mit Databricks ML und Spark.

- Unterstützt On-Demand-Modelltraining, ohne dass Daten exportiert werden müssen.

Im Gegensatz zu Warehouses können Datenwissenschaftler in Lakehouses direkt mit Rohdaten arbeiten.

Was ist die Zukunft von Data Lakehouses und Warehouses?

Die Branche verlagert sich auf hybride und vereinheitlichte Architekturen.

- Cloud-Plattformen integrieren die Funktionen von Lakehouse in Lagerlösungen.

- Serverloses Data Warehousing verbessert die Skalierbarkeit und Kosteneffizienz.

- Data Mesh-Architekturen dezentralisieren den Besitz von Daten in den Teams.

Wenn du diese Trends verstehst, kannst du als Datenexperte die Nase vorn haben.

Sai ist Software-Ingenieur mit Fachkenntnissen in Python, Java, Cloud-Plattformen und Big-Data-Analytik und hat einen Master in Software Engineering von der UMBC. Du hast Erfahrung mit KI-Modellen, skalierbaren IoT-Systemen und datengesteuerten Projekten in verschiedenen Branchen.