Cours

Traditionnellement, les entrepôts de données ont été la solution de choix pour les données structurées et l'intelligence économique. Cependant, avec l'essor du big data, de l'IA et de l'apprentissage automatique, une nouvelle architecture - le data lakehouse -est apparue, combinant les points forts des entrepôts de données et des lacs de données.

Dans ce guide, nous allons explorer :

- Ce que sont les entrepôts de données et les lacustres de données, et en quoi ils diffèrent.

- Caractéristiques principales, avantages et défis de chaque architecture.

- Cas d'utilisation réels où l'un peut être préférable à l'autre.

- Quand utiliser une approche hybride qui tire le meilleur des deux mondes.

Plongeons dans l'aventure !

Qu'est-ce qu'un entrepôt de données ?

Un entrepôt de données est un système centralisé qui stocke, organise et analyse les données à des fins de veille stratégique (BI), de reporting et d'analyse. Il intègre des données structurées provenant de sources multiples et suit un schéma hautement organisé, ce qui garantit la cohérence et la fiabilité. Les entrepôts de données jouent un rôle central en aidant les entreprises à prendre efficacement des décisions fondées sur des données.

Caractéristiques

- Schema-on-write : Les données sont transformées et structurées avant d'être chargées, en respectant un schéma prédéfini pour une interrogation optimisée.

- Haute performance : Optimisé pour les requêtes complexes, permettant des agrégations, des jointures et des analyses rapides.

- Conformité à l'ACID : Garantit des données fiables, cohérentes et précises pour les applications critiques.

- Gestion des données historiques : Stocke des années de données pour l'analyse des tendances, les prévisions et la conformité.

- Intégration des données: Combine des données provenant de sources multiples (ERP, CRM, bases de données transactionnelles) dans un référentiel unifié.

- Sécurité et gouvernance: Fournit des fonctions de contrôle d'accès basé sur les rôles (RBAC), de cryptage des données et de conformité pour la sécurité de l'entreprise.

Cas d'utilisation

- Information financière et conformité réglementaire: Garantir des enregistrements précis et vérifiables pour les exigences réglementaires telles que SOX, HIPAA et GDPR.

- Tableaux de bord de veille stratégique: Power BI permet de créer des tableaux de bord en temps réel et historiques pour une prise de décision fondée sur les données.

- Rapports opérationnels: Permet d'effectuer des requêtes prédéfinies et structurées pour les opérations commerciales quotidiennes.

- Analyse de la clientèle: Permet la segmentation de la clientèle, l'analyse du comportement, et la prédiction du désabonnement à l 'aide d'ensembles de données structurés.

- Chaîne d'approvisionnement et logistique: Optimise la gestion des stocks, la prévision de la demande et l'efficacité opérationnelle grâce aux tendances historiques.

Exemples d'outils

- Snowflake: Un entrepôt de données cloud-native connu pour son évolutivité et sa facilité d'utilisation.

- Amazon Redshift: Le service d'entreposage de données d'AWS offre des performances de requête rapides et une intégration avec d'autres outils AWS.

- Google BigQuery: Un entrepôt de données sans serveur, hautement évolutif, conçu pour l'analyse.

Qu'est-ce qu'un Data Lakehouse ?

Un data lakehouse est une architecture de données moderne qui combine l'évolutivité et la flexibilité d'un data lake avec la performance structurée et la fiabilité d'un data warehouse. Il permet aux organisations de stocker, de gérer et d'analyser des données structurées, semi-structurées et non structurées dans un système unique.

Caractéristiques

- Schéma en lecture et schéma en écriture : Prise en charge de l'ingestion de données brutes pour plus de souplesse et d'ensembles de données structurées pour l'analyse traditionnelle.

- Divers types de données: Traite les données structurées (bases de données), semi-structurées (JSON, XML) et non structurées (images, vidéos).

- Optimisé pour les charges de travail modernes: Construit pour l'analytique, l'IA, l'apprentissage automatique et l'ingestion de données en continu.

- Stockage unifié: Combine l'évolutivité des lacs de données avec la performance des entrepôts de données.

- Le rapport coût-efficacité: Réduit les coûts opérationnels en consolidant le stockage et le traitement.

- Gouvernance et sécurité intégrées: Fournit des fonctions de contrôle d'accès, d'audit et de conformité très fines pour garantir l'intégrité et la confidentialité des données.

Cas d'utilisation

- L'analyse de données massives (big data): Stocke et traite de grandes quantités de données structurées et non structurées en vue d'une analyse à grande échelle.

- Pipelines d'IA et d'apprentissage automatique: Permet l'ingénierie des caractéristiques, l'apprentissage de modèles et l'inférence grâce à l'ingestion flexible de données.

- Traitement des données en temps réel: Prend en charge l'analyse en continu pour la détection des fraudes, les systèmes de recommandation et les applications IoT.

- Consolidation des données d'entreprise: Unifie les charges de travail opérationnelles et analytiques, en réduisant la duplication et la complexité des données.

Exemples d'outils

- Les banques de données: Une plateforme d'analyse unifiée connue pour sa mise en œuvre de l'architecture Lakehouse avec Delta Lake comme base.

- Lac Delta: Une couche de stockage open-source qui améliore la fiabilité et les performances des lacs de données.

- L'iceberg Apache: Un format de tableau haute performance conçu pour l'analyse multimodale à grande échelle sur les lacs de données.

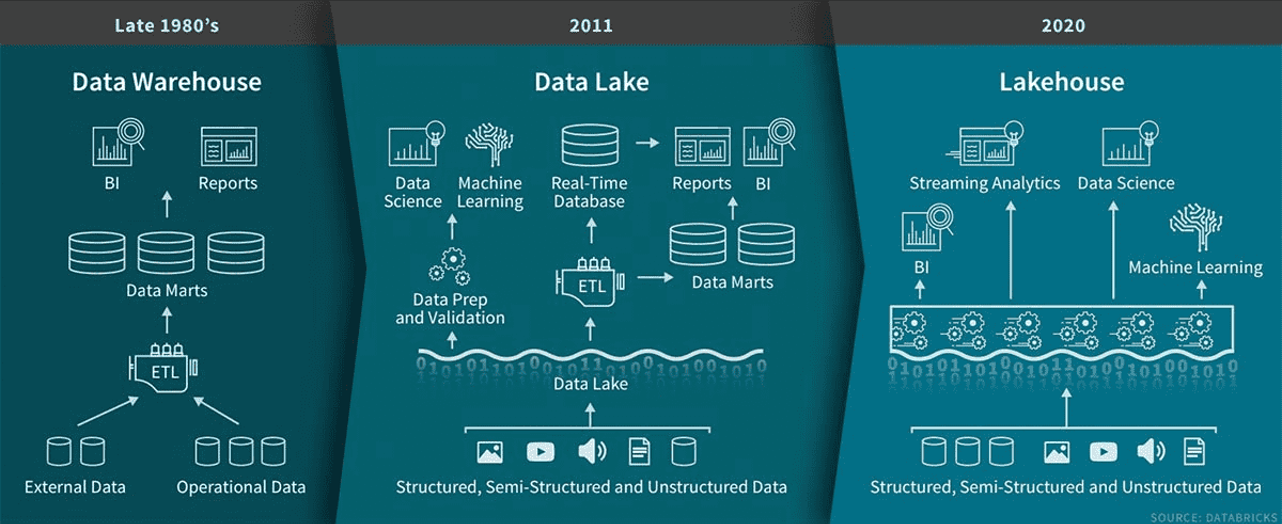

L'évolution de l'architecture des données, qui est passée des entrepôts de données à la fin des années 1980 aux lacs de données en 2011 et enfin aux entrepôts de données en 2020. Source de l'image : Databricks.

Devenez ingénieur en données

Différences entre les entrepôts de données et les lacs de données

Comprendre les principales différences entre les entrepôts de données et les lacs de données peut vous aider à déterminer quelle solution répond le mieux à vos besoins. Vous trouverez ci-dessous une ventilation de leurs principales distinctions.

Types de données pris en charge

Les entrepôts de données gèrent divers types de données, ce qui les rend idéaux pour diverses charges de travail. Ils soutiennent :

- Données structurées: Transactions de vente, bases de données relationnelles

- Données semi-structurées: Profils d'utilisateurs JSON, relevés de capteurs

- Données non structurées: Journaux, images et fichiers audio de l'IdO.

Les entrepôts de données stockent principalement les données structurées et certaines données semi-structuréesLes entrepôts de données stockent principalement des données structurées et certaines données semi-structurées, ce qui les rend plus adaptés aux processus commerciaux traditionnels tels que les rapports financiers et l'analyse.

Exemple : Une entreprise de vente au détail utilisant un data lakehouse peut analyser les logs de parcours de navigation, les données des médias sociaux et les enregistrements de transactions pour évaluer le sentiment des clients.

Rentabilité

Les entrepôts de données tirent parti stockage en nuage rentable (par exemple, Amazon S3, Azure Data Lake Storage) et prennent en charge les schémas en lecture, réduisant ainsi les coûts de prétraitement ETL.

Les entrepôts de données sont généralement plus coûteux en raison du stockage structuré, du traitement ETL et desformats propriétaires.

Exemple : Une startup qui a besoin d'un stockage à faible coût pour des données brutes et traitées peut trouver un lac de données plus abordable qu'un entrepôt de données.

Performance

Les entrepôts de données prennent en charge le traitement en temps réel et par lots, ce qui les rend idéaux pour l'analyse des grandes données et l'apprentissage automatique. Leur architecture distribuée garantit un traitement à grande vitesse des grands ensembles de données.

Les entrepôts de données excellent dans les domaines suivants requêtes basées sur SQL et les charges de travail transactionnelles, offrant des performances rapides et cohérentes pour les données structurées.

Exemple : Une institution financière qui détecte les fraudes en temps réel peut bénéficier de la capacité d'un data lakehouse à traiter les données en continu.

Intégration avec l'apprentissage automatique

Les data lakehouses s'intègrent nativement aux outils de ML tels que TensorFlow, PyTorch et DatabricksML, ce qui permet d'entraîner directement des modèles sur de grands ensembles de données.

Les entrepôts de données ont un support ML limité et nécessitent souvent l'exportation des données vers des systèmes externes pour l'analyse.

Exemple : Une entreprise technologique utilisant Databricks peut développer des systèmes de recommandation alimentés par l'IA directement au sein d'un lac de données.

Évolutivité

Les entrepôts de données s'étendent jusqu'à pétaoctets de données tout en prenant en charge le traitement multi-moteurs.

Les entrepôts de données s'adaptent bien aux données structurées mais se heurtent à des difficultés avec des ensembles massifs de données non structurées.

Exemple : Un fournisseur de services de télécommunications peut faire évoluer un entrepôt pour traiter des milliards d'enregistrements d'appels par jour, alors qu'un entrepôt traditionnel peut avoir du mal à traiter les enregistrements IoT.

Types d'utilisateurs

Les entrepôts de données (data lakehouses) servent les data scientists, les analystes et les ingénieurs qui travaillent sur des analyses en temps réel, des pipelines ML et des analyses exploratoires.

Les entrepôts de données s'adressent principalement analystes d'entreprise et aux dirigeants qui s'appuient sur des données structurées et prétraitées pour l'établissement de rapports et de tableaux de bord.

Exemple: Une équipe marketing peut utiliser un entrepôt de données pour les tableaux de bord BI, tandis qu'une équipe de science des données préfère un entrepôt de données pour la modélisation prédictive.

Entrepôts de données (Data Lakehouses) et entrepôts de données (Data Warehouses) : Un résumé

Voici un tableau comparatif détaillé des data lakehouses par rapport aux data warehouses qui comprend des détails techniques plus poussés que ceux évoqués précédemment :

|

Fonctionnalité |

La maison des données (Data Lakehouse) |

Entrepôt de données |

|

Types de données pris en charge |

Structuré, semi-structuré et non structuré (JSON, images, vidéos, journaux IoT) |

Principalement structuré, avec un support semi-structuré limité (JSON, XML) |

|

Format de stockage |

Formats ouverts (Parquet, ORC, Delta, Iceberg) |

Formats structurés propriétaires |

|

Gestion des schémas |

Schéma à la lecture et schéma à l'écriture (flexible) |

Schéma sur l'écriture (strict) |

|

Performance des requêtes |

Optimisé pour les requêtes par lots et en temps réel |

Optimisé pour les requêtes SQL structurées |

|

Moteur de traitement |

Supporte plusieurs moteurs (Spark, Presto, Trino, Dremio) |

Moteurs basés sur SQL (Snowflake, Redshift, BigQuery) |

|

Rapport coût-efficacité |

Coût réduit grâce à un stockage d'objets dans le cloud bon marché et à un prétraitement moins important. |

Coûts plus élevés en raison de l'ETL, du stockage structuré et des formats propriétaires |

|

Évolutivité |

S'adapte facilement à diverses charges de travail (structurées et non structurées) |

La mise à l'échelle est satisfaisante pour les données structurées, mais elle se heurte à des difficultés pour les ensembles massifs de données non structurées. |

|

Soutien à l'apprentissage automatique (ML) |

Intégration ML intégrée avec TensorFlow, PyTorch et Databricks ML |

Intégration limitée du ML, nécessite souvent l'exportation de données |

|

Flux de données en temps réel |

Prise en charge de l'ingestion et de l'analyse en temps réel (Kafka, Spark Streaming). |

Support en temps réel limité, principalement traitement par lots |

|

Meilleur pour |

Charges de travail AI/ML, analyse en temps réel, big data, IoT |

Intelligence économique, rapports, analyses structurées |

|

Sécurité et gouvernance |

Sécurité avancée, contrôle d'accès et audit |

Contrôles de sécurité et de conformité stricts pour les données structurées |

|

Exemples de cas d'utilisation |

Détection des fraudes, systèmes de recommandation, analyse de l'IoT, formation de modèles d'IA. |

Rapports financiers, tableaux de bord opérationnels, conformité réglementaire |

|

Outils et plateformes populaires |

Databricks, Snowflake (avec Iceberg/Delta), Apache Hudi, Google BigLake |

Amazon Redshift, Google BigQuery, Snowflake, Microsoft Synapse... |

Avantages et inconvénients des entrepôts de données vs. Les entrepôts de données

Dans cette section, nous décomposons les principaux avantages et inconvénients de chaque architecture afin d'offrir une vision équilibrée.

Avantages et inconvénients des entrepôts de données

|

Pour ✅ |

Cons ❌ |

|

Optimisé pour les données structurées - Fournit des performances élevées pour les requêtes et les analyses basées sur SQL. |

Prise en charge limitée des données non structurées - Difficultés avec les formats tels que les images, les vidéos et les journaux IoT. |

|

Performances de requête rapides - Conçu pour les agrégations, les jointures et les requêtes complexes avec indexation et compression. |

Coûts de stockage et de calcul élevés - Coûteux par rapport aux solutions de stockage d'objets basées sur le cloud. |

|

Conformité ACID - Garantit l'intégrité, la fiabilité et la cohérence des données, ce qui est crucial pour les applications financières et réglementaires. |

Approche rigide du schéma à l'écriture - Les données doivent être nettoyées et structurées avant d'être ingérées, ce qui accroît la complexité de l'ETL. |

|

Idéal pour la BI et la création de rapports - Fonctionne de manière transparente avec Power BI, Tableau, Looker, ce qui permet d'obtenir des tableaux de bord en temps réel. |

Pas idéal pour l'apprentissage automatique - les flux de travail d'apprentissage automatique nécessitent l'exportation des données vers des plateformes externes pour le prétraitement. |

|

Hautement sécurisé et gouverné - RBAC solide, cryptage et contrôles de conformité (par exemple, GDPR, HIPAA). |

Difficulté de mise à l'échelle pour les données volumineuses - Difficulté à gérer des ensembles de données volumineux par rapport à des architectures plus évolutives. |

Avantages et inconvénients des entrepôts de données

|

Pour ✅ |

Cons ❌ |

|

Prise en charge de tous les types de données - Peut traiter des données structurées, semi-structurées et non structurées dans un système unifié. |

Les performances des requêtes peuvent être plus lentes - Bien qu'il soit optimisé pour l'analyse à grande échelle, il peut nécessiter des réglages supplémentaires pour les requêtes de données structurées. |

|

Schéma flexible à la lecture et à l'écriture - Prise en charge de l'ingestion de données brutes pour les charges de travail ML tout en permettant un stockage structuré pour la BI. |

Nécessite plus d'efforts en matière de gouvernance - Les données n'étant pas toujours pré-structurées, l'application de la qualité des données et du contrôle d'accès est plus complexe. |

|

Stockage économique - Utilise le stockage d'objets dans le cloud (Amazon S3, Azure Data Lake) pour un stockage abordable et évolutif. |

Courbe d'apprentissage plus prononcée - Nécessite une bonne connaissance des outils de données modernes tels qu'Apache Iceberg, Delta Lake et Hudi. |

|

Optimisé pour les charges de travail d'IA et de ML - S'intègre de manière transparente avec TensorFlow, PyTorch, Databricks ML et les frameworks de streaming en temps réel. |

Défis liés à la cohérence des données - La mise en conformité avec la norme ACID de vastes ensembles de données distribuées nécessite des configurations supplémentaires. |

|

Traitement des données en temps réel - Prise en charge de l'ingestion de données en continu à partir d'appareils IoT, de journaux et de sources d'événements en temps réel. |

Moins mûrs que les entrepôts de données - Les entrepôts traditionnels ont fait leurs preuves depuis plus longtemps en matière de BI et de reporting financier. |

Quand utiliser un entrepôt de données ?

Les entrepôts de données sont les mieux adaptés aux données structurées, à la veille stratégique et à la conformité réglementaire. Un entrepôt de données est le bon choix si vous avez besoin d'analyses très organisées, rapides et cohérentes.

Analyse de données structurées

- Idéal pour les ensembles de données propres et structurés avec des exigences de schéma bien définies.

- À utiliser lorsque la cohérence et la performance sont essentielles pour les analyses et les rapports.

Exemple : Une entreprise qui utilise un entrepôt de données pour analyser les données de vente structurées de son vaste réseau de magasins. Cela permet de suivre les niveaux de stocks, d'identifier les produits les plus vendus et d'optimiser les processus de réapprovisionnement en temps réel.

Rapports d'intelligence économique (BI)

- Idéal pour générer des tableaux de bord et des rapports à l'intention des décideurs.

- Prend en charge des outilstels que Power BI et Tableau avec des performances de requête optimisées.

Exemple : Une société de services financiers qui crée des rapports trimestriels sur les résultats à l'intention des parties prenantes.

Conformité réglementaire

- Conçu pour les industries ayant des exigences strictes en matière de précision des données et d'audit.

- Fournit un stockage fiable pour les dossiers financiers, les données sur les soins de santé et les rapports de conformité.

Exemple : Une institution financière utilise un entrepôt de données pour stocker et analyser les données transactionnelles, garantissant ainsi la conformité avec des réglementations telles que Bâle III et GDPR. Cette approche centralisée permet de gérer les pistes d'audit et de prévenir la fraude.

Analyse des données historiques

- A utiliser pour l'analyse des tendances à long terme et la prise de décision stratégique.

- Il est idéal pour les industries telles que l'industrie manufacturière ou l'énergie qui ont besoin de données pluriannuelles.

Exemple : Une entreprise du secteur de l'énergie qui analyse l'historique de la consommation d'énergie pour optimiser la production.

Quand utiliser un Data Lakehouse ?

Un data lakehouse est idéal lorsque vous avez besoin d'un système évolutif et flexible qui peut gérer des données structurées, semi-structurées et non structurées tout en prenant en charge l'IA, l'apprentissage automatique et l'analyse en temps réel.

Stockage unifié pour des données diverses

- Le meilleur moyen de combiner des données structurées, semi-structurées et non structurées en une seule plateforme.

- Réduit les silos et favorise l'accès dynamique aux données.

Exemple : Un service de diffusion en continu qui stocke du contenu vidéo, des journaux d'activité des utilisateurs et des métadonnées.

L'apprentissage automatique et les flux de travail de l'IA

- Parfait pour l'exploration de données brutes, la formation de modèles et l'expérimentation.

- Fournit une flexibilité de lecture des schémas pour divers ensembles de données.

Exemple : Une entreprise qui utilise un entrepôt de données pour traiter les données brutes des trajets, les évaluations des conducteurs et les enregistrements GPS. Ces données alimentent des modèles d'apprentissage automatique pour l'optimisation des itinéraires, la tarification dynamique et la détection des fraudes.

Flux de données en temps réel

- A utiliser pour les applications nécessitant l'ingestion et le traitement de données quasi instantanées.

- Prend en charge les cas d'utilisation dynamiques tels que la détection des fraudes et l'analyse de l'IdO.

Exemple : Les véhicules équipés de l'IdO transmettent des données de capteurs en temps réel à une architecture de type "lakehouse". Cela permet à l'entreprise de surveiller les performances du véhicule, de détecter les anomalies et d'effectuer des mises à jour logicielles en temps réel.

Stockage rentable des données volumineuses

- Réduit les dépenses en stockant des données brutes sans traitement préalable important.

- S'adapte efficacement aux organisations qui génèrent de grandes quantités de données.

Exemple : Entreprise de médias sociaux qui utilise un centre de données pour stocker et traiter de grandes quantités de contenus bruts générés par les utilisateurs, tels que des textes, des images et des vidéos. Cette configuration leur permet d'effectuer une analyse des sentiments, de détecter les sujets en vogue et d'optimiser le ciblage des publicités.

Solutions hybrides : Combiner les entrepôts de données et les lacs de données

Bien que les entrepôts de données et les entrepôts lacustres servent des objectifs différents, de nombreuses organisations combinent les architectures pour équilibrer les performances, les coûts et la flexibilité.

Une approche hybride vous permet de stocker des données structurées dans un entrepôt pour une analyse rapide tout en tirant parti d'un lac pour le big data, l'IA et l'apprentissage automatique.

Une approche hybride suit une stratégie à deux niveaux :

- Données brutes et semi-structurées dans le lac de données (flexible, évolutif, rentable)

-

- Stocke des données diverses (structurées, semi-structurées, non structurées) dans un stockage d'objets dans le cloud (Amazon S3, Azure Data Lake, Google Cloud Storage).

- Utilise le schéma sur lecture pour offrir de la flexibilité aux scientifiques des données et aux équipes d'IA/ML.

- Prise en charge de l'ingestion de données en temps réel à partir d'appareils IoT, de journaux d'événements et de plateformes de diffusion en continu.

- Données structurées et nettoyées dans l'entrepôt de données (optimisées pour l'analyse rapide et la BI)

-

- Les données sont filtrées, transformées et structurées avant d'être stockées dans un entrepôt (Snowflake, Redshift, BigQuery, Synapse).

- Utilise le schéma sur l'écriture pour assurer la cohérence des données et optimiser les performances des requêtes.

- Fournit un accès rapide à l'intelligence économique, aux tableaux de bord et aux rapports opérationnels.

Une architecture de données hybride est bénéfique lorsque :

- Vous avez besoin de rapports BI à grande vitesse et d'un stockage de données flexible pour les charges de travail ML/AI.

- Votre entreprise traite des données structurées et non structurées, ce qui nécessite des capacités de schéma à l'écriture et de schéma à la lecture.

- Vous souhaitez optimiser les coûts, en utilisant un entrepôt pour les analyses structurées à forte valeur ajoutée et un lac pour le stockage rentable des données brutes.

- Vous avez besoin d'ingérer et de traiter des données en temps réel tout en conservant des enregistrements historiques régis.

Conclusion

Ce guide explore les principales différences entre les entrepôts de données et les lacustres de données, leurs forces, leurs défis et leurs cas d'utilisation, et la façon dont les organisations combinent souvent les deux architectures dans le cadre d'une approche hybride.

Il est essentiel de comprendre ces concepts pour construire des systèmes de données efficaces et à l'épreuve du temps, à mesure que les architectures de données évoluent. Pour approfondir ces sujets, consultez ces cours :

- Concepts d'entreposage de données - Un guide fondamental sur les entrepôts de données, leurs composants et leur rôle dans l'analyse.

- Concepts Databricks - Découvrez comment Databricks permet une architecture data lakehouse pour le traitement de données évolutif et l'apprentissage automatique.

Devenez ingénieur en données

FAQ

Comment migrer d'un data warehouse vers un data lakehouse ?

La migration implique :

- Évaluation des données - Identifier les sources structurées et non structurées.

- Choix d'une plateforme - Des outils tels que Databricks, Apache Iceberg ou Snowflake prennent en charge les labyrinthes.

- Construction de pipelines ETL - Utilisez Apache Spark ou dbt pour la transformation et l'ingestion.

- Optimiser les performances - Mettre en œuvre des stratégies d'indexation, de mise en cache et de partitionnement.

Comment fonctionne la gouvernance dans un lac de données par rapport à un entrepôt de données ?

Les entrepôts de données ont une gouvernance centralisée, avec un contrôle d'accès basé sur les rôles (RBAC) et des schémas prédéfinis.

Les entrepôts de données (data lakehouses) requièrent :

- Contrôles d'accès précis (par exemple, AWS Lake Formation, Unity Catalog).

- Gestion des métadonnées pour suivre les ensembles de données à travers les couches de stockage.

- Contrôle de la qualité des données pour la cohérence dans les environnements de lecture de schémas.

Quels sont les plus grands défis à relever lors de l'adoption d'un data lakehouse ?

- Optimisation des performances des requêtes - nécessite des techniques d'optimisation telles que l'indexation et la mise en cache.

- Problèmes de cohérence des données - Nécessité d'une prise en charge des transactions ACID (par exemple, Delta Lake, Apache Iceberg).

- Courbe d'apprentissage - Les équipes doivent adopter de nouveaux outils au-delà des systèmes traditionnels basés sur SQL.

Quel rôle l'IA et l'apprentissage automatique jouent-ils dans le modèle de la maison lacustre ?

Les lagunes sont idéales pour l'IA/ML parce qu'elles.. :

- Stockez des données structurées, semi-structurées et non structurées pour les modèles de formation.

- Permettez l'ingénierie des fonctionnalités en temps réel avec Databricks ML et Spark.

- Supporter l'entraînement des modèles à la demande sans nécessiter d'exportation de données.

Contrairement aux entrepôts, les entrepôts lacustres permettent aux scientifiques de travailler directement avec les données brutes.

Quel est l'avenir des entrepôts de données ?

Le secteur évolue vers des architectures hybrides et unifiées.

- Les plateformes cloud intègrent les fonctionnalités de l'entrepôt dans les solutions d'entreposage.

- L'entreposage de données sans serveur améliore l'évolutivité et la rentabilité.

- Les architectures de maillage de données décentralisent la propriété des données au sein des équipes.

Comprendre ces tendances aidera les professionnels des données à garder une longueur d'avance.

Sai est un ingénieur logiciel avec une expertise en Python, Java, plateformes cloud et analyse de big data et un master en génie logiciel de l'UMBC. Expérimenté dans les modèles d'IA, les systèmes IoT évolutifs et les projets axés sur les données dans tous les secteurs d'activité.