Cursus

Meta AI vient de présenter Llama 3.3, un modèle de 70 milliards de paramètres qui offre des performances comparables à celles du Llama 3.1 405B, beaucoup plus grand, mais avec des exigences de calcul bien moindres.

Nous trouvons cela particulièrement intéressant car cela rend l'IA de haute qualité plus accessible aux développeurs qui n'ont pas accès à du matériel coûteux.

Conçu pour des tâches textuelles telles que le chat multilingue, l'aide au codage et la génération de données synthétiques, Llama 3.3 se concentre uniquement sur les entrées et sorties de texte. Il n'est pas conçu pour gérer les images ou l'audio.

Dans ce blog, nous allons vous expliquer ce qui distingue ce modèle et vous aider à décider s'il convient à vos projets.

Développer des applications d'IA

Qu'est-ce que Llama 3.3 ?

Llama 3.3 est le dernier grand modèle linguistique de Meta AI, et nous le considérons comme un pas en avant pour rendre l'IA avancée plus accessible à une variété de projets. Avec 70 milliards de paramètres, il offre des performances comparables à celles du Llama 3.1 405B, beaucoup plus grand, mais avec des exigences matérielles considérablement réduites. Cela signifie que nous pouvons explorer des applications d'IA sophistiquées sans avoir besoin d'installations spécialisées et coûteuses.

Le modèle est conçu spécifiquement pour les entrées et sorties de texte, il ne gère donc pas les images, le son ou d'autres médias. Nous l'avons trouvé particulièrement efficace pour des tâches telles que le chat multilingue, l'assistance au codage et la génération de données synthétiques. Avec la prise en charge de huit langues, dont l'anglais, l'espagnol, l'hindi et l'allemand, il s'agit d'une option solide pour les projets nécessitant des capacités multilingues.

Ce qui nous frappe, c'est l'accent mis sur l'efficacité. Llama 3.3 est optimisé pour fonctionner sur les GPU courants, ce qui le rend pratique pour les déploiements locaux et plus facile à expérimenter. Il intègre également des techniques d'alignement pour garantir que ses réponses sont utiles et sûres, ce qui, nous le savons, est essentiel pour les applications sensibles.

Dans cette section, nous avons décrit les bases de ce qu'est le Llama 3.3, mais nous irons plus loin dans les sections suivantes. Nous verrons comment il fonctionne, comment commencer à l'utiliser et quelles sont ses performances dans les tests de référence, afin que vous puissiez déterminer s'il est adapté à votre travail.

Comment fonctionne Llama 3.3 ?

Voici comment fonctionne Llama 3.3, décomposé d'une manière que nous espérons logique, que vous soyez familier avec les grands modèles de langage ou que vous commenciez à les explorer.

Architecture : Efficace et évolutif

Au cœur de Llama 3.3 se trouve une architecture basée sur des transformateurs avec 70 milliards de paramètres. Si vous ne connaissez pas, les paramètres sont essentiellement les "boutons" que le modèle ajuste pendant la formation pour apprendre les modèles et les relations dans le texte. C'est ce qui permet à Llama 3.3 de générer des réponses cohérentes et adaptées au contexte.

La particularité de Llama 3.3 réside dans l'utilisation de la méthode GQA (Grouped-Query Attention). Cela rend le modèle plus efficace en lui permettant de traiter le texte plus rapidement et avec moins de ressources informatiques. C'est pourquoi il peut atteindre des performances similaires à celles de la Llama 3.1 405B, beaucoup plus grande, tout en étant beaucoup moins exigeant sur le plan matériel.

Formation et perfectionnement

Pour entraîner un modèle tel que Llama 3.3, il faut d'abord l'exposer à un vaste ensemble de données - 15 000 milliards de tokens de texte provenant de sources publiques. C'est ce qui donne au modèle sa large compréhension du langage et de la connaissance.

Mais nous savons que la formation brute ne suffit pas à rendre un modèle utile dans les scénarios du monde réel. C'est là qu'intervient le réglage fin:

- Réglage fin supervisé (SFT): Dans ce cas, le modèle apprend à partir d'exemples de bonnes réponses soigneusement sélectionnés. Considérez cela comme un "étalon-or" de la façon dont il devrait se comporter.

- Apprentissage par renforcement avec retour d'information humain (RLHF): Il s'agit de recueillir les commentaires des humains sur les performances du modèle et d'utiliser ces commentaires pour affiner son comportement.

Cette double approche garantit que le Llama 3.3 répond aux attentes des humains, tant en termes d'utilité que de sécurité.

Conçu pour un matériel accessible

Llama 3.3 est conçu pour fonctionner localement sur les postes de travail courants des développeurs, ce qui le rend accessible aux développeurs ne disposant pas d'une infrastructure de niveau entreprise. Contrairement à des modèles plus importants comme le Llama 3.1 405B, il nécessite beaucoup moins de puissance de calcul tout en conservant d'excellentes performances.

Cette efficacité est largement due à l'attention groupée (GQA), qui optimise la façon dont le modèle traite le texte en réduisant l'utilisation de la mémoire et en accélérant l'inférence.

Le modèle prend également en charge les techniques de quantification, stelles que la précision 8 bits et 4 bits, par le biais d'outils tels que bitsandbytes. Ces techniques réduisent considérablement les besoins en mémoire sans sacrifier les performances.

En outre, il s'adapte bien à toutes les configurations matérielles, des simples GPU aux systèmes distribués, offrant une grande flexibilité pour les expériences locales et les déploiements plus importants.

En pratique, cela signifie que nous pouvons expérimenter ou déployer Llama 3.3 sur des configurations matérielles plus abordables, en évitant les coûts élevés généralement associés aux modèles d'IA avancés. Il s'agit donc d'un choix pratique pour les développeurs et les équipes qui cherchent à concilier performance et accessibilité.

Llama 3.3 Benchmarks

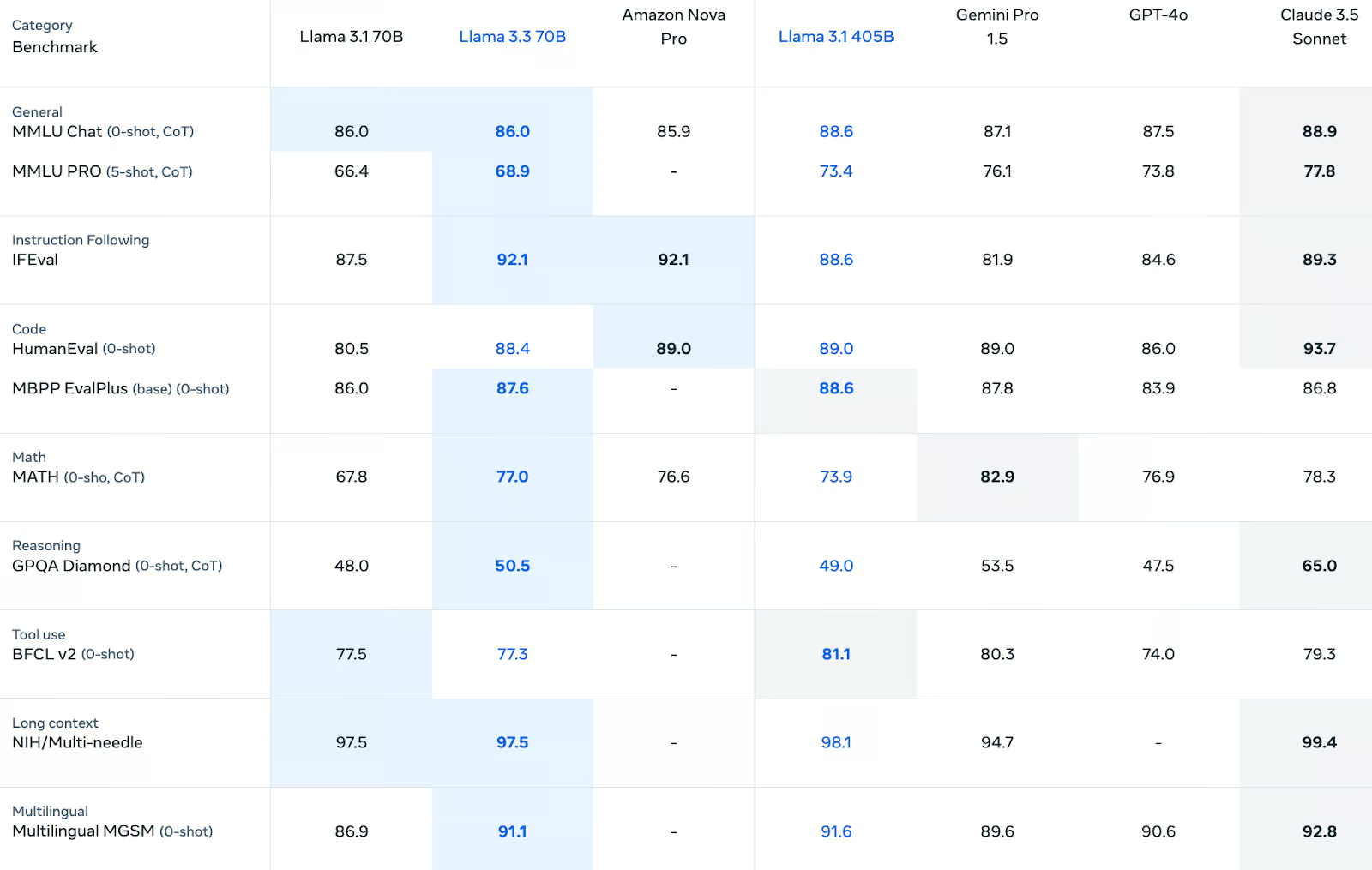

Llama 3.3 obtient de bons résultats sur une série de critères, avec des résultats remarquables dans le suivi des instructions, le codage et le raisonnement multilingue. Bien qu'il ne soit pas toujours plus performant que des modèles plus grands comme le Llama 3.1 405B ou le Claude 3.5 Sonnet, il fournit des résultats fiables et compétitifs dans la plupart des catégories. Pour les développeurs à la recherche d'un modèle équilibré qui gère efficacement diverses tâches, Llama 3.3 est une option solide.

Connaissances générales et raisonnement

Dans les tâches de connaissances générales, Llama 3.3 donne de bons résultats. Il obtient unscore de 86,0 sur Chat MMLU (0-shot, CoT), égalant son prédécesseur Llama 3.1 70B et restant compétitif par rapport à l'Amazon Nova Pro (85,9). Cependant, il est légèrement inférieur au Llama 3.1 405B (88.6) et au Claude 3.5 Sonnet (88.9).

Sur le plus difficile MMLU PRO (5 coups, CoT) le Llama 3.3 s'améliore par rapport au Llama 3.1 70B avec un score de 68.9mais elle reste derrière la Llama 3.1 405B (73.4) et Claude 3.5 Sonnet (77.8).

Pour les tâches de raisonnement, le Llama 3.3 obtient un score de 50,5 sur le GPQA Diamond (0-shot, CoT), soit une légère amélioration par rapport au Llama 3.1 70B (48,0). Bien que cela le place derrière certains concurrents comme Claude 3.5 Sonnet (65.0), cela démontre un certain progrès dans le raisonnement structuré.

Instruction suivante

Le lama 3.3 excelle dans les tâches de suivi des instructions, obtenant un score de 92,1 sur le site IFEval, qui mesure le degré d'adhésion d'un modèle aux instructions de l'utilisateur. Ce résultat le place devant Llama 3.1 405B (88.6) et GPT-4o (84.6), et proche de Claude 3.5 Sonnet (89.3). Ses performances dans cette catégorie mettent en évidence ses capacités d'alignement, qui sont essentielles pour des applications telles que les chatbots et les assistants dédiés à des tâches spécifiques.

Capacités de codage

Les tests de codage sont un point fort de Llama 3.3. Sur HumanEval (0-shot), il obtient un score de 88,4, légèrement derrière Llama 3.1 405B (89,0) et à égalité avec Gemini Pro 1.5. De même, dans MBPP EvalPlus (base), il obtient 87,6, soit une légère amélioration par rapport à Llama 3.1 70B (86,0). Ces résultats confirment son efficacité dans la génération de code et la résolution de tâches liées à la programmation.

Raisonnement mathématique et symbolique

Dans le domaine du raisonnement symbolique, le lama 3.3 progresse de manière significative. Il obtient un score de77,0 sur le benchmarkMATH (0-shot, CoT), surpassant le Llama 3.1 70B (67,8) et l'Amazon Nova Pro (76,6). Cependant, il se situe derrière Gemini Pro 1.5 (82,9). Bien qu'il ne soit pas le leader dans cette catégorie, il est suffisamment performant pour de nombreuses tâches de raisonnement structuré.

Capacités multilingues

Llama 3.3 démontre une force significative dans le raisonnement multilingue, obtenant un score de 91,1 sur MGSM (0-shot). Il s'agit d'une amélioration substantielle par rapport au Llama 3.1 70B (86.9) et il se rapproche du Claude 3.5 Sonnet (92.8). Ses performances dans cette catégorie en font un excellent choix pour les applications multilingues telles que la traduction et l'assistance clientèle internationale.

Utilisation d'outils et performance en contexte long

Pour l'utilisation d'outils, le lama 3.3 obtient 77,3 sur BFCL v2 (0 coup), ce qui est comparable au lama 3.1 70B (77,5), mais inférieur au lama 3.1 405B (81,1). En ce qui concerne le traitement des entrées à contexte long, il obtient 97,5 sur NIH/Multi-Needle, ce qui correspond au Llama 3.1 70B et le place légèrement derrière le Llama 3.1 405B (98,1). Ces résultats indiquent de fortes capacités pour les flux de travail assistés par des outils et des scénarios d'entrée étendus.

Cas d'utilisation du lama 3.3

Llama 3.3 ouvre un large éventail de possibilités pour les développeurs et les chercheurs, grâce à son équilibre entre performances élevées et efficacité matérielle. Nous apprécions le fait qu'il fonctionne efficacement sur des stations de travail de développeur standard, ce qui en fait une option abordable pour ceux qui n'ont pas accès à une infrastructure de niveau entreprise. Voici quelques-uns des domaines dans lesquels il peut être utile.

1. Chatbots et assistants multilingues

L'un des points forts de Llama 3.3 est sa capacité à gérer plusieurs langues. Avec la prise en charge de huit langues principales, dont l'anglais, l'espagnol, le français et l'hindi, il est idéal pour créer des chatbots ou des assistants virtuels multilingues.

Ce qui nous frappe, c'est que vous n'avez pas besoin d'un centre de données pour commencer. Les développeurs peuvent créer des prototypes et déployer ces systèmes sur leur propre matériel, qu'il s'agisse d'assistance à la clientèle, d'outils éducatifs ou d'autres applications conversationnelles.

Par exemple, nous pourrions utiliser Llama 3.3 pour créer un chatbot de service à la clientèle qui répond aux questions en plusieurs langues, tout en fonctionnant efficacement sur un seul GPU.

2. Aide au codage et développement de logiciels

Avec d'excellents résultats sur des tests de codage tels que HumanEval et MBPP EvalPlus, Llama 3.3 est un assistant fiable pour générer du code, déboguer ou même compléter des scripts partiellement écrits.

Ce que nous trouvons particulièrement intéressant, c'est la façon dont il fonctionne sur le matériel personnel. Au lieu de dépendre de systèmes cloud coûteux, vous pouvez exécuter Llama 3.3 localement pour automatiser les tâches répétitives, générer du code boilerplate ou créer des tests unitaires. Pour les équipes ou les développeurs solitaires, cela rend l'aide au codage de l'IA avancée à la fois pratique et abordable.

3. Génération de données synthétiques

La génération d'ensembles de données synthétiques est un autre domaine dans lequel Llama 3.3 excelle. Que vous construisiez un chatbot, entraîniez un classificateur ou travailliez sur un projet NLP, la possibilité de générer des données étiquetées de haute qualité peut vous faire gagner beaucoup de temps et d'efforts.

Nous pensons que ce cas d'utilisation est particulièrement utile pour les petites équipes qui ont besoin de données spécifiques à un domaine mais qui n'ont pas les ressources nécessaires pour les collecter manuellement. Comme Llama 3.3 fonctionne sur du matériel de niveau développeur, vous pouvez générer des données localement, ce qui réduit les coûts et simplifie le flux de travail.

4. Création de contenu multilingue et localisation

Les capacités multilingues de Llama 3.3 en font également un candidat de choix pour la création de contenu. Nous voyons son potentiel dans la production de matériel de marketing localisé, la traduction de documents techniques ou la création de blogs multilingues. Les développeurs peuvent affiner le modèle pour en adapter le ton ou le style, afin que le résultat corresponde au public visé.

Par exemple, vous pouvez utiliser Llama 3.3 pour rédiger une description de produit en plusieurs langues, améliorant ainsi le processus de localisation sans avoir besoin d'une équipe de traducteurs dédiée.

5. Recherche et expérimentation

Pour les chercheurs, Llama 3.3 constitue une plate-forme solide pour explorer la modélisation linguistique, l'alignement ou les techniques d'ajustement. Ce qui la rend particulièrement attrayante, c'est son efficacité : vous n'avez pas besoin d'accéder à une infrastructure cloud massive pour expérimenter l'IA avancée.

Il s'agit donc d'un outil idéal pour les projets universitaires ou la recherche industrielle, en particulier lorsqu'il s'agit d'explorer des domaines tels que l'alignement de la sécurité ou la formation de modèles spécialisés plus petits par le biais de la distillation.

6. Applications basées sur la connaissance

Les fortes capacités de traitement de texte de Llama 3.3 se prêtent également à des applications telles que la réponse à des questions, le résumé et la génération de rapports. Ces tâches nécessitent souvent de traiter efficacement de grands volumes de texte, ce que Llama 3.3 est capable de faire, même sur du matériel personnel.

Par exemple, nous pourrions l'utiliser pour résumer automatiquement les commentaires des clients ou générer de la documentation interne, ce qui permettrait de gagner du temps tout en préservant l'exactitude des données.

7. Déploiement flexible pour les petites équipes

Enfin, nous pensons que Llama 3.3 est une excellente option pour les startups, les développeurs solitaires ou les petites équipes qui veulent des capacités d'IA avancées sans les coûts d'une infrastructure d'entreprise. Sa capacité à fonctionner sur des serveurs locaux ou même sur un seul poste de travail en fait une solution pratique pour les systèmes de production légers.

Comment accéder à Llama 3.3

Meta fournit un accès à Llama 3.3 par le biais de son site web dédié : Téléchargements de lamas. Vous trouverez ici des liens vers la carte de modèle officielle, des détails sur les licences et de la documentation supplémentaire pour vous aider à démarrer.

Pour des conseils plus approfondis, nous vous recommandons d'explorer les ressources officielles :

- Carte modèle et instructions d'utilisation sur GitHub: Dépôt Meta GitHub.

- Modèle Hugging Face page: Llama 3.3-70B sur Hugging Face.

Ces plateformes fournissent une documentation détaillée et des forums communautaires où vous pouvez poser des questions ou résoudre des problèmes.

Prix de Llama 3.3

De notre point de vue, cette tarification rend Llama 3.3 particulièrement attrayante pour les développeurs travaillant avec un budget limité ou pour les projets de mise à l'échelle avec des demandes de jetons élevées. Que vous l'exploitiez localement ou par l'intermédiaire d'une plateforme, ces tarifs compétitifs garantissent que l'IA de haute qualité est accessible sans se ruiner.

Coût des jetons d'entrée

Pour le traitement d'un million de jetons d'entrée, le prix de Llama 3.3 est de 0,1 dollar, ce qui correspond à son prédécesseur, Llama 3.1 70B. Comparé à d'autres modèles, ce taux est l'un des plus bas :

- Amazon Nova Pro facture 0,80 $, ce qui le rend huit fois plus cher pour le même volume.

- Le GPT-4o et le Claude 3.5 Sonnet coûtent respectivement 2,5 et 3,0 dollars, ce qui les place nettement au-dessus du Llama 3.3.

Ce faible coût d'entrée rend Llama 3.3 particulièrement adapté aux applications qui nécessitent le traitement de grandes quantités de texte, telles que les chatbots ou les outils d'analyse de texte.

Coûts des jetons de sortie

Pour 1 million de jetons de sortie, le prix de Llama 3.3 est de 0,4 $, ce qui correspond au coût de Llama 3.1 70B. Voici ce qu'il en est :

- Le prix de l'Amazon Nova Pro est de 1,8 $, soit quatre fois plus que celui de la Llama 3.3.

- GPT-4o coûte 10,0 $ et Claude 3.5 Sonnet 15,0 $, ce qui fait de Llama 3.3 une option économique par une large marge.

Pour les applications qui génèrent un volume important de texte, telles que la création de données synthétiques ou la génération de contenu, Llama 3.3 permet de réaliser d'importantes économies.

Conclusion

Nous considérons Llama 3.3 comme un exemple convaincant de la manière dont les grands modèles linguistiques peuvent concilier capacité et accessibilité.

En tant que modèle à 70 milliards de paramètres, il offre des performances comparables à celles du modèle Llama 3.1 405B, beaucoup plus grand, mais avec des exigences de calcul bien moindres.

Pour les développeurs qui n'ont pas accès à du matériel d'entreprise, ce modèle représente un moyen pratique d'intégrer une IA de haute qualité dans leurs flux de travail.

FAQ

En quoi Llama 3.3 est-il différent de Llama 3.2 ?

Llama 3.3 améliore Llama 3.2 avec un meilleur réglage (SFT et RLHF), des fonctions de sécurité étendues, un support multilingue (8 langues), une fenêtre de contexte plus longue (128k tokens), et des performances de référence plus élevées. Il ajoute également des capacités d'utilisation d'outils, une efficacité énergétique améliorée et un cadre d'IA responsable robuste, ce qui le rend plus puissant et plus polyvalent.

En quoi le Llama 3.3 est-il différent du Llama 405B ?

Llama 3.3 offre des performances comparables à celles de Llama 3.1 405B, mais il est nettement plus efficace et nécessite beaucoup moins de puissance de calcul pour fonctionner.

Quelles sont les langues prises en charge par Llama 3.3 ?

Llama 3.3 est compatible avec l'anglais, le français, l'allemand, l'hindi, l'italien, le portugais, l'espagnol et le thaï. Les développeurs peuvent l'adapter à d'autres langues, mais des garanties supplémentaires sont nécessaires.

Quels sont les points de référence dans lesquels Llama 3.3 excelle ?

Llama 3.3 obtient des scores élevés dans des tests de référence tels que MMLU, HumanEval et MGSM, et surpasse de nombreux autres modèles dans des catégories telles que le raisonnement, le codage et les capacités multilingues.

Llama 3.3 peut-il fonctionner sur du matériel de développement standard ?

Oui, Llama 3.3 est conçu pour fonctionner sur des GPU courants et des stations de travail de niveau développeur, ce qui le rend accessible aux développeurs ne disposant pas d'une infrastructure de niveau entreprise.

Je suis rédacteur et éditeur dans le domaine de la science des données. Je suis particulièrement intéressé par l'algèbre linéaire, les statistiques, R, etc. Je joue également beaucoup aux échecs !