Programa

A Meta AI acaba de apresentar o Llama 3.3, um modelo de 70 bilhões de parâmetros que oferece desempenho comparável ao Llama 3.1 405B, muito maior, mas com demandas computacionais muito menores.

Achamos isso especialmente interessante porque torna a IA de alta qualidade mais acessível aos desenvolvedores que não têm acesso a hardware caro.

Projetado para tarefas baseadas em texto, como bate-papo multilíngue, assistência à codificação e geração de dados sintéticos, o Llama 3.3 se concentra apenas em entradas e saídas de texto - não foi desenvolvido para lidar com imagens ou áudio.

Neste blog, mostraremos a você o que faz esse modelo se destacar e o ajudaremos a decidir se ele é adequado para seus projetos.

Desenvolver aplicativos de IA

O que é o Llama 3.3?

O Llama 3.3 é o mais recente modelo de linguagem grande do Meta AI e o consideramos um passo para tornar a IA avançada mais acessível para uma variedade de projetos. Com 70 bilhões de parâmetros, ele oferece desempenho equivalente ao do Llama 3.1 405B, muito maior, mas com requisitos de hardware significativamente reduzidos. Isso significa que podemos explorar aplicativos sofisticados de IA sem precisar de configurações caras e especializadas.

O modelo foi projetado especificamente para entradas e saídas de texto, portanto, não lida com imagens, áudio ou outras mídias. Descobrimos que ele é particularmente eficaz para tarefas como bate-papo multilíngue, assistência de codificação e geração de dados sintéticos. Com suporte para oito idiomas, incluindo inglês, espanhol, hindi e alemão, ele é uma opção interessante para projetos que exigem recursos multilíngues.

O que mais se destaca para nós é o foco na eficiência. O Llama 3.3 foi otimizado para ser executado em GPUs comuns, o que o torna prático para implementações locais e mais fácil de experimentar. Ele também incorpora técnicas de alinhamento para garantir que suas respostas sejam úteis e seguras, o que sabemos ser essencial para aplicativos confidenciais.

Nesta seção, descrevemos os conceitos básicos do que é o Llama 3.3, mas vamos nos aprofundar nas próximas seções. Abordaremos como ele funciona, como começar a usá-lo e seu desempenho em benchmarks, para que você possa determinar se ele é adequado para o seu trabalho.

Como o Llama 3.3 funciona?

Veja como a Llama 3.3 funciona, dividida de uma forma que esperamos que faça sentido, quer você esteja familiarizado com modelos de linguagem grandes ou esteja apenas começando a explorá-los.

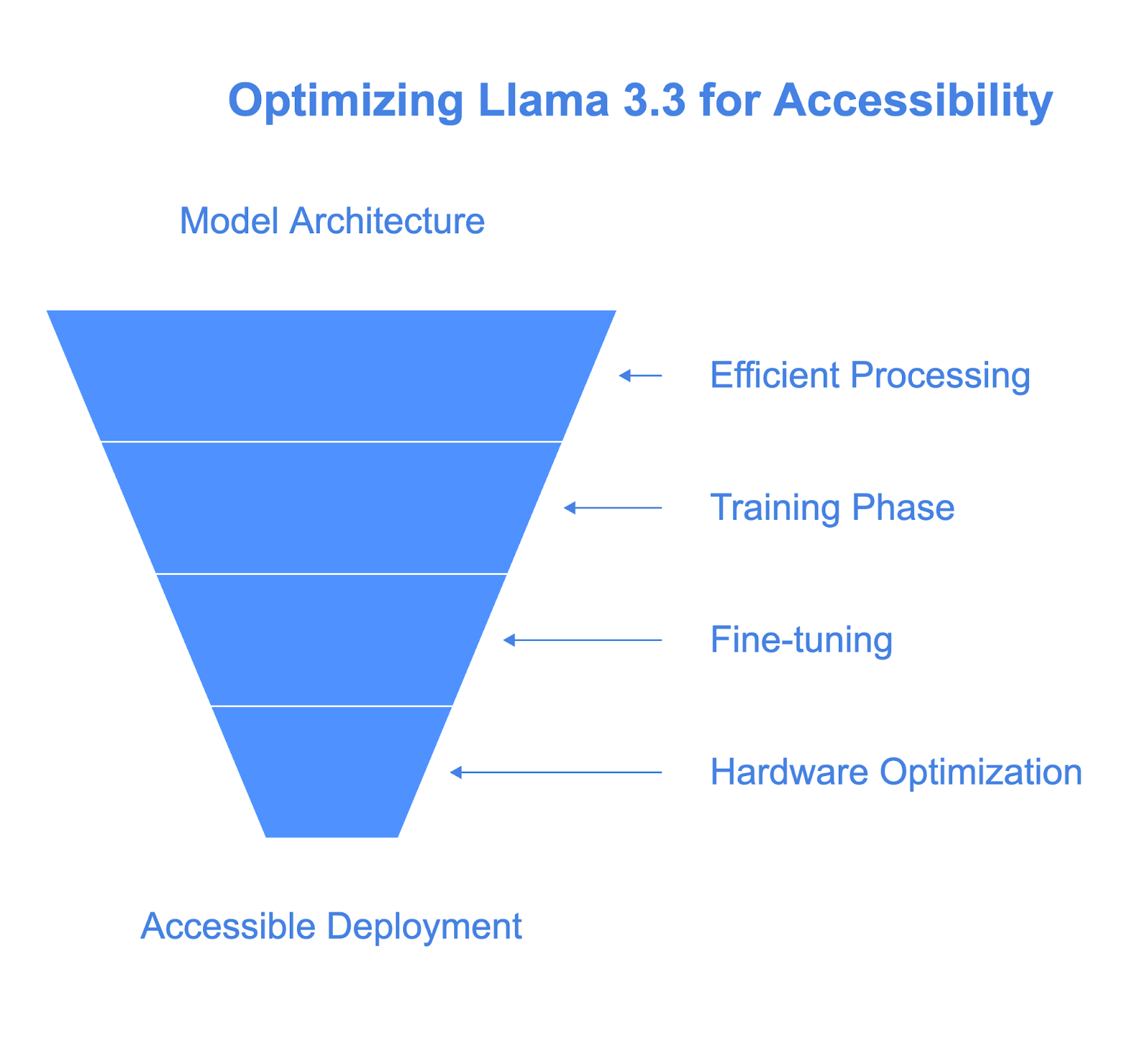

Arquitetura: Eficiente e dimensionável

No centro do Llama 3.3 está uma arquitetura baseada em transformadores com 70 bilhões de parâmetros. Se você não estiver familiarizado, os parâmetros são essencialmente os "botões" que o modelo ajusta durante o treinamento para aprender padrões e relacionamentos no texto. É isso que permite à Llama 3.3 gerar respostas coerentes e contextualmente relevantes.

O que há de diferente no Llama 3.3 é o uso do GQA (Grouped-Query Attention). Isso torna o modelo mais eficiente, permitindo que ele processe o texto mais rapidamente e com menos recursos computacionais. É por isso que ele pode atingir um desempenho semelhante ao do Llama 3.1 405B, que é muito maior, embora exija muito menos do hardware.

Treinamento e ajuste fino

O treinamento de um modelo como o Llama 3.3 começa com a exposição a um vasto conjunto de dados - 15 trilhões de tokens de texto de fontes disponíveis publicamente. Isso dá ao modelo uma ampla compreensão da linguagem e do conhecimento.

Mas sabemos que o treinamento bruto não é suficiente para tornar um modelo útil em cenários do mundo real. É aí que entra o ajuste fino:

- Ajuste fino supervisionado (SFT): Aqui, o modelo aprende com exemplos cuidadosamente selecionados de boas respostas. Pense nisso como um "padrão ouro" de como você deve se comportar.

- Aprendizagem por reforço com feedback humano (RLHF): Isso envolve a coleta de feedback de humanos sobre o desempenho do modelo e o uso desse feedback para refinar seu comportamento.

Essa abordagem dupla garante que a Llama 3.3 se alinhe às expectativas humanas, tanto em termos de utilidade quanto de segurança.

Projetado para hardware acessível

O Llama 3.3 foi projetado para ser executado localmente em estações de trabalho comuns de desenvolvedores, tornando-o acessível para desenvolvedores sem infraestrutura de nível empresarial. Ao contrário de modelos maiores, como o Llama 3.1 405B, ele requer uma potência computacional significativamente menor, mantendo um bom desempenho.

Essa eficiência se deve em grande parte ao Grouped-Query Attention (GQA), que otimiza a forma como o modelo processa o texto, reduzindo o uso da memória e acelerando a inferência.

O modelo também oferece suporte a técnicas de quantização, como precisão de 8 e 4 bits, por meio de ferramentas como bitsandbytes. Essas técnicas reduzem consideravelmente os requisitos de memória sem sacrificar muito o desempenho.

Além disso, ele é bem dimensionado em configurações de hardware, desde GPUs individuais até sistemas distribuídos, oferecendo flexibilidade tanto para experimentos locais quanto para implementações maiores.

Na prática, isso significa que podemos experimentar ou implementar a Llama 3.3 em configurações de hardware mais acessíveis, evitando os altos custos normalmente associados a modelos avançados de IA. Isso o torna uma opção prática para desenvolvedores e equipes que buscam equilibrar desempenho e acessibilidade.

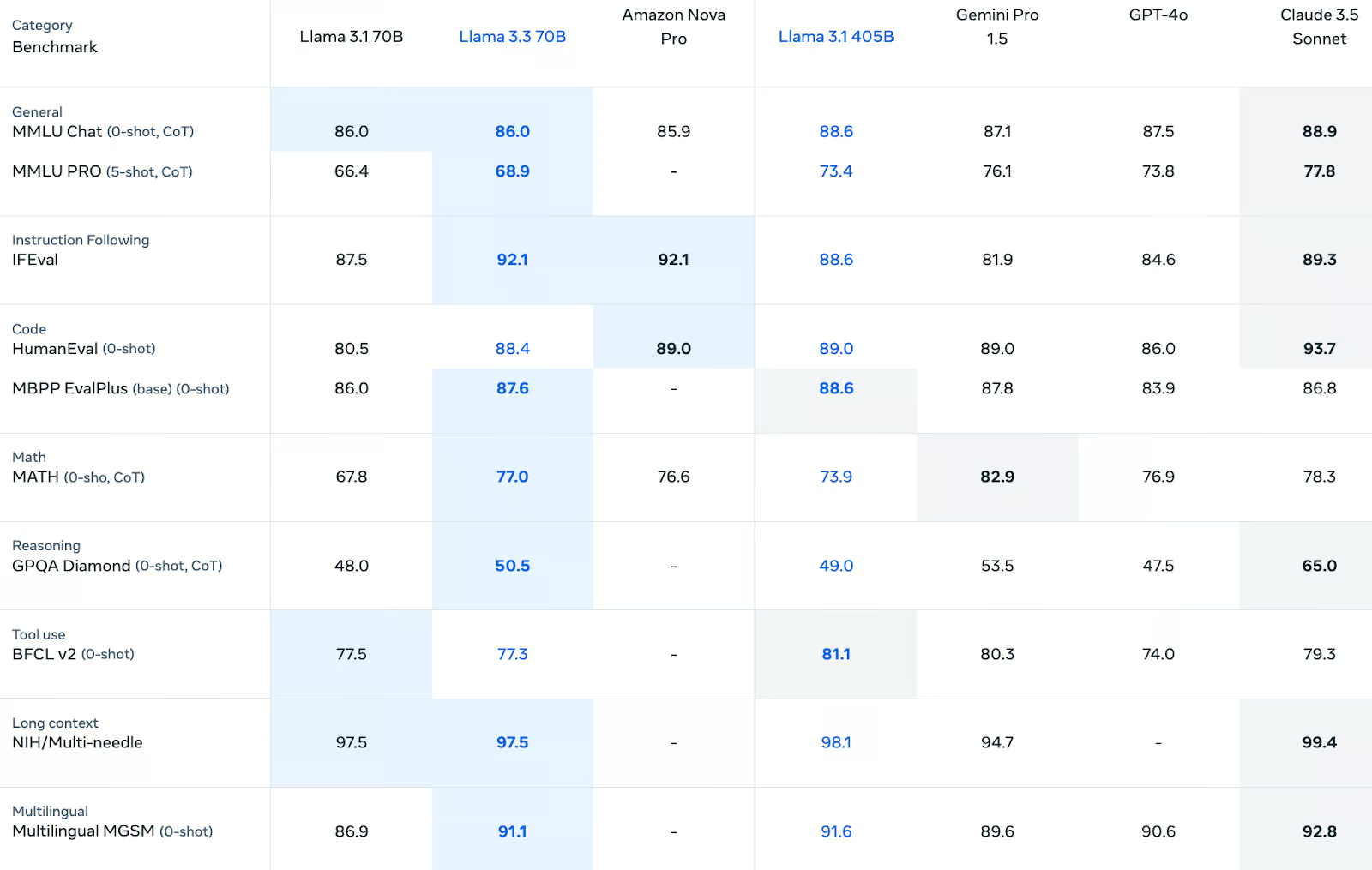

Benchmarks do Llama 3.3

O Llama 3.3 apresenta um bom desempenho em vários benchmarks, com resultados de destaque em acompanhamento de instruções, codificação e raciocínio multilíngue. Embora não supere consistentemente os modelos maiores, como o Llama 3.1 405B ou o Claude 3.5 Sonnet, ele oferece resultados confiáveis e competitivos na maioria das categorias. Para os desenvolvedores que procuram um modelo equilibrado que lide com diversas tarefas de forma eficaz, o Llama 3.3 é uma boa opção.

Conhecimento geral e raciocínio

Em tarefas de conhecimento geral, o Llama 3.3 oferece resultados sólidos. Ele atinge umapontuação de 86,0 no MMLU Chat (0-shot, CoT), igualando seu antecessor Llama 3.1 70B e permanecendo competitivo com o Amazon Nova Pro (85,9). No entanto, ele fica um pouco abaixo dos maiores Llama 3.1 405B (88,6) e Claude 3.5 Sonnet (88,9).

No mais desafiador MMLU PRO (5 disparos, CoT) a Llama 3.3 melhorou em relação à Llama 3.1 70B com uma pontuação de 68.9mas continua atrás do Llama 3.1 405B (73,4) e do Claude 3.5 Sonnet (77,8).

Para tarefas de raciocínio, a Llama 3.3 obteve 50,5pontos no GPQA Diamond (0-shot, CoT), uma ligeira melhora em relação à Llama 3.1 70B (48,0). Embora isso o coloque atrás de alguns concorrentes, como o Claude 3.5 Sonnet (65,0), ele demonstra algum progresso no raciocínio estruturado.

Instruções a seguir

A Llama 3.3 é excelente em tarefas de acompanhamento de instruções, com pontuação de 92,1 no IFEval, que mede a aderência de um modelo às instruções do usuário. Esse resultado o coloca à frente do Llama 3.1 405B (88,6) e do GPT-4o (84,6), e próximo do Claude 3.5 Sonnet (89,3). Seu desempenho nessa categoria destaca seus recursos de alinhamento, que são cruciais para aplicativos como chatbots e assistentes para tarefas específicas.

Recursos de codificação

Os benchmarks de codificação são um ponto forte do Llama 3.3. No HumanEval (0-shot), ele obteve 88,4 pontos, um pouco atrás do Llama 3.1 405B (89,0) e no mesmo nível do Gemini Pro 1.5. Da mesma forma, no MBPP EvalPlus (base), você obtém 87,6, uma ligeira melhoria em relação ao Llama 3.1 70B (86,0). Esses resultados confirmam sua eficácia na geração de código e na solução de tarefas relacionadas à programação.

Raciocínio matemático e simbólico

No raciocínio simbólico, o Llama 3.3 mostra um progresso significativo. Ele pontua 77,0 no benchmarkMATH (0-shot, CoT), superando o Llama 3.1 70B (67,8) e o Amazon Nova Pro (76,6). No entanto, ele fica atrás do Gemini Pro 1.5 (82,9). Embora não seja o líder nessa categoria, ele tem um desempenho suficientemente bom para muitas tarefas de raciocínio estruturado.

Recursos multilíngues

A Llama 3.3 demonstra uma força significativa no raciocínio multilíngue, com pontuação de 91,1 no MGSM (0-shot). Essa é uma melhoria substancial em relação ao Llama 3.1 70B (86,9) e o coloca próximo ao Claude 3.5 Sonnet (92,8). Seu desempenho nessa categoria o torna uma ótima opção para aplicativos multilíngues, como tradução e suporte global ao cliente.

Uso de ferramentas e desempenho em contextos longos

Para o uso de ferramentas, a Llama 3.3 alcança 77,3 no BFCL v2 (0-shot), comparável à Llama 3.1 70B (77,5), mas não chega perto da Llama 3.1 405B (81,1). Ao lidar com entradas de contexto longo, ele pontua 97,5 no NIH/Multi-Needle, igualando-se ao Llama 3.1 70B e ligeiramente atrás do Llama 3.1 405B (98,1). Esses resultados indicam recursos sólidos para fluxos de trabalho assistidos por ferramentas e cenários de entrada estendidos.

Casos de uso do Llama 3.3

O Llama 3.3 abre uma ampla gama de possibilidades para desenvolvedores e pesquisadores, graças ao seu equilíbrio entre alto desempenho e eficiência de hardware. Gostamos do fato de ele ser executado com eficiência em estações de trabalho padrão para desenvolvedores, o que o torna uma opção acessível para quem não tem acesso à infraestrutura de nível empresarial. Aqui estão algumas das áreas em que ele pode ser útil.

1. Chatbots e assistentes multilíngues

Um dos pontos fortes do Llama 3.3 é sua capacidade de lidar com vários idiomas. Com suporte para oito idiomas principais, incluindo inglês, espanhol, francês e hindi, é ideal para criar chatbots ou assistentes virtuais multilíngues.

O que nos chama a atenção é que você não precisa de um data center para começar. Os desenvolvedores podem criar protótipos e implementar esses sistemas em seu próprio hardware, seja para suporte ao cliente, ferramentas educacionais ou outros aplicativos de conversação.

Por exemplo, podemos usar o Llama 3.3 para criar um chatbot de atendimento ao cliente que responda a consultas em vários idiomas, tudo isso executado com eficiência em uma única GPU.

2. Suporte à codificação e desenvolvimento de software

Com pontuações fortes em benchmarks de codificação como o HumanEval e o MBPP EvalPlus, o Llama 3.3 é um assistente confiável para gerar código, depurar ou até mesmo concluir scripts parcialmente escritos.

O que consideramos particularmente valioso é o fato de ele funcionar bem em hardware pessoal. Em vez de depender de sistemas de nuvem caros, você pode executar o Llama 3.3 localmente para automatizar tarefas repetitivas, gerar código padrão ou criar testes de unidade. Para equipes ou desenvolvedores individuais, isso torna o suporte avançado à codificação de IA prático e acessível.

3. Geração de dados sintéticos

Outra área em que a Llama 3.3 se destaca é na geração de conjuntos de dados sintéticos. Se você estiver criando um chatbot, treinando um classificador ou trabalhando em um projeto de PNL, a capacidade de gerar dados rotulados e de alta qualidade pode economizar muito tempo e esforço.

Acreditamos que esse caso de uso é especialmente valioso para equipes menores que precisam de dados específicos do domínio, mas não têm os recursos para coletá-los manualmente. Como o Llama 3.3 é executado em hardware de nível de desenvolvedor, você pode gerar dados localmente, reduzindo custos e simplificando o fluxo de trabalho.

4. Criação e localização de conteúdo multilíngue

Os recursos multilíngues do Llama 3.3 também o tornam um forte candidato para a criação de conteúdo. Vemos seu potencial na produção de materiais de marketing localizados, na tradução de documentos técnicos ou na criação de blogs multilíngues. Os desenvolvedores podem fazer o ajuste fino do modelo para adaptar seu tom ou estilo, garantindo que o resultado corresponda ao público-alvo.

Por exemplo, você pode usar a Llama 3.3 para redigir uma descrição de produto em vários idiomas, melhorando o processo de localização sem precisar de uma equipe dedicada de tradutores.

5. Pesquisa e experimentação

Para os pesquisadores, a Llama 3.3 oferece uma plataforma sólida para explorar técnicas de modelagem de linguagem, alinhamento ou ajuste fino. O que o torna particularmente atraente é sua eficiência - você não precisa de acesso a uma infraestrutura de nuvem maciça para fazer experiências com IA avançada.

Isso o torna uma excelente ferramenta para projetos acadêmicos ou pesquisas do setor, especialmente ao explorar áreas como alinhamento de segurança ou treinamento de modelos menores e especializados por meio de destilação.

6. Aplicativos baseados em conhecimento

Os sólidos recursos de processamento de texto do Llama 3.3 também se prestam a aplicativos como resposta a perguntas, resumo e geração de relatórios. Essas tarefas geralmente exigem o manuseio eficiente de grandes volumes de texto, algo que o Llama 3.3 consegue gerenciar bem, mesmo em hardware pessoal.

Por exemplo, poderíamos usá-lo para resumir automaticamente o feedback do cliente ou gerar documentação interna, economizando tempo e mantendo a precisão.

7. Implementação flexível para equipes pequenas

Por fim, acreditamos que o Llama 3.3 é uma ótima opção para startups, desenvolvedores individuais ou pequenas equipes que desejam recursos avançados de IA sem os custos de uma infraestrutura de nível empresarial. Sua capacidade de ser executado em servidores locais ou até mesmo em uma única estação de trabalho o torna uma solução prática para sistemas de produção leves.

Como acessar o Llama 3.3

A Meta fornece acesso ao Llama 3.3 por meio de seu site dedicado: Llama Downloads. Aqui, você encontrará links para o cartão de modelo oficial, detalhes de licenciamento e documentação adicional para ajudá-lo a começar.

Para obter orientações mais detalhadas, recomendamos que você explore os recursos oficiais:

- Cartão de modelo e instruções de uso no GitHub: Meta GitHub Repository.

- Página do modelo Hugging Face: Llama 3.3-70B em Hugging Face.

Essas plataformas fornecem documentação detalhada e fóruns da comunidade onde você pode fazer perguntas ou solucionar problemas.

Preços do Llama 3.3

Do nosso ponto de vista, esse preço torna a Llama 3.3 particularmente atraente para os desenvolvedores que trabalham com orçamento limitado ou projetos de dimensionamento com altas demandas de token. Independentemente de você estar executando a IA localmente ou por meio de uma plataforma, essas taxas competitivas garantem que a IA de alta qualidade seja acessível sem gastar muito.

Custos de tokens de entrada

Para processar 1 milhão de tokens de entrada, o preço do Llama 3.3 é de US$ 0,1, o que corresponde ao seu antecessor, o Llama 3.1 70B. Em comparação com outros modelos, essa é uma das taxas mais baixas:

- O Amazon Nova Pro cobra US$ 0,80, o que o torna oito vezes mais caro para o mesmo volume.

- O GPT-4o e o Claude 3.5 Sonnet custam US$ 2,5 e US$ 3,0, respectivamente, o que os coloca significativamente acima do Llama 3.3.

Esse baixo custo de entrada torna o Llama 3.3 particularmente adequado para aplicativos que exigem o processamento de grandes quantidades de texto, como chatbots ou ferramentas de análise de texto.

Custos de token de saída

Para 1 milhão de tokens de saída, o preço da Llama 3.3 é de US$ 0,4, novamente igual ao custo da Llama 3.1 70B. Veja como você se compara:

- O preço do Amazon Nova Pro é de US$ 1,8, quatro vezes mais alto que o do Llama 3.3.

- O GPT-4o cobra US$ 10,0 e o Claude 3.5 Sonnet cobra US$ 15,0, tornando o Llama 3.3 uma opção econômica por uma ampla margem.

Para aplicativos que geram um grande volume de texto, como a criação de dados sintéticos ou a geração de conteúdo, o Llama 3.3 oferece uma economia significativa de custos.

Conclusão

Para nós, o Llama 3.3 é um exemplo convincente de como modelos de linguagem grandes podem equilibrar capacidade e acessibilidade.

Como um modelo de 70 bilhões de parâmetros, ele oferece desempenho comparável ao do Llama 3.1 405B, muito maior, mas com requisitos computacionais muito menores.

Para os desenvolvedores sem acesso a hardware de nível empresarial, esse modelo representa uma maneira prática de integrar IA de alta qualidade em seus fluxos de trabalho.

Perguntas frequentes

Qual é a diferença entre a Llama 3.3 e a Llama 3.2?

A Llama 3.3 aprimora a Llama 3.2 com melhor ajuste fino (SFT e RLHF), recursos de segurança expandidos, suporte multilíngue (8 idiomas), uma janela de contexto mais longa (128 mil tokens) e melhor desempenho de benchmark. Ele também adiciona recursos de uso de ferramentas, maior eficiência energética e uma estrutura robusta de IA responsável, tornando-o mais avançado e versátil.

Qual é a diferença entre a Llama 3.3 e a Llama 405B?

A Llama 3.3 oferece um desempenho comparável ao da Llama 3.1 405B, mas é significativamente mais eficiente, exigindo muito menos poder computacional para ser executada.

Quais idiomas são compatíveis com o Llama 3.3?

O Llama 3.3 suporta nativamente inglês, francês, alemão, hindi, italiano, português, espanhol e tailandês. Os desenvolvedores podem ajustá-lo para outros idiomas, mas são necessárias proteções adicionais.

Em quais benchmarks o Llama 3.3 se destaca?

O Llama 3.3 obtém pontuações altas em benchmarks como MMLU, HumanEval e MGSM, superando muitos outros modelos em categorias como raciocínio, codificação e recursos multilíngues.

A Llama 3.3 pode ser executada no hardware padrão do desenvolvedor?

Sim, o Llama 3.3 foi projetado para ser executado em GPUs comuns e estações de trabalho de nível de desenvolvedor, tornando-o acessível para desenvolvedores sem infraestrutura de nível empresarial.