Lernpfad

Meta AI hat gerade Llama 3.3 vorgestellt, ein Modell mit 70 Milliarden Parametern, das eine vergleichbare Leistung wie das viel größere Llama 3.1 405B bietet, aber einen viel geringeren Rechenaufwand erfordert.

Wir finden das besonders interessant, weil es hochwertige KI für Entwickler/innen zugänglicher macht, die keinen Zugang zu teurer Hardware haben.

Llama 3.3 wurde für textbasierte Aufgaben wie mehrsprachige Chats, Codierungshilfen und die Generierung synthetischer Daten entwickelt und konzentriert sich ausschließlich auf Texteingaben und -ausgaben - es ist nicht für die Verarbeitung von Bildern oder Audiodaten ausgelegt.

In diesem Blog erklären wir dir, was dieses Modell auszeichnet und helfen dir zu entscheiden, ob es für deine Projekte geeignet ist.

KI-Anwendungen entwickeln

Was ist Llama 3.3?

Llama 3.3 ist das neueste große Sprachmodell von Meta AI und wir sehen es als einen Schritt, um fortgeschrittene KI für eine Vielzahl von Projekten zugänglicher zu machen. Mit 70 Milliarden Parametern bietet es die gleiche Leistung wie das viel größere Llama 3.1 405B, aber mit deutlich geringeren Hardwareanforderungen. Das bedeutet, dass wir anspruchsvolle KI-Anwendungen erforschen können, ohne dass wir teure, spezialisierte Einrichtungen benötigen.

Das Modell ist speziell für Texteingaben und -ausgaben konzipiert und kann daher keine Bilder, Audios oder andere Medien verarbeiten. Wir haben festgestellt, dass sie sich besonders gut für Aufgaben wie mehrsprachige Chats, Codierungshilfe und die Generierung synthetischer Daten eignet. Mit der Unterstützung von acht Sprachen, darunter Englisch, Spanisch, Hindi und Deutsch, ist es eine gute Option für Projekte, die mehrsprachige Funktionen erfordern.

Was uns auffällt, ist sein Fokus auf Effizienz. Llama 3.3 ist für den Betrieb auf gängigen Grafikprozessoren optimiert, was es praktisch für den lokalen Einsatz und einfacher zum Experimentieren macht. Es beinhaltet auch Abgleichtechniken, um sicherzustellen, dass seine Antworten hilfreich und sicher sind, was, wie wir wissen, für sensible Anwendungen unerlässlich ist.

In diesem Abschnitt haben wir die Grundlagen von Llama 3.3 umrissen, aber wir werden in den nächsten Abschnitten noch tiefer gehen. Wir erklären dir, wie es funktioniert, wie du es einsetzen kannst und wie es in Benchmarks abschneidet, damit du herausfinden kannst, ob es das Richtige für deine Arbeit ist.

Wie funktioniert Llama 3.3?

Im Folgenden wird die Funktionsweise von Llama 3.3 aufgeschlüsselt. Wir hoffen, dass es sinnvoll ist, wenn du mit großen Sprachmodellen vertraut bist oder sie gerade erst kennenlernst.

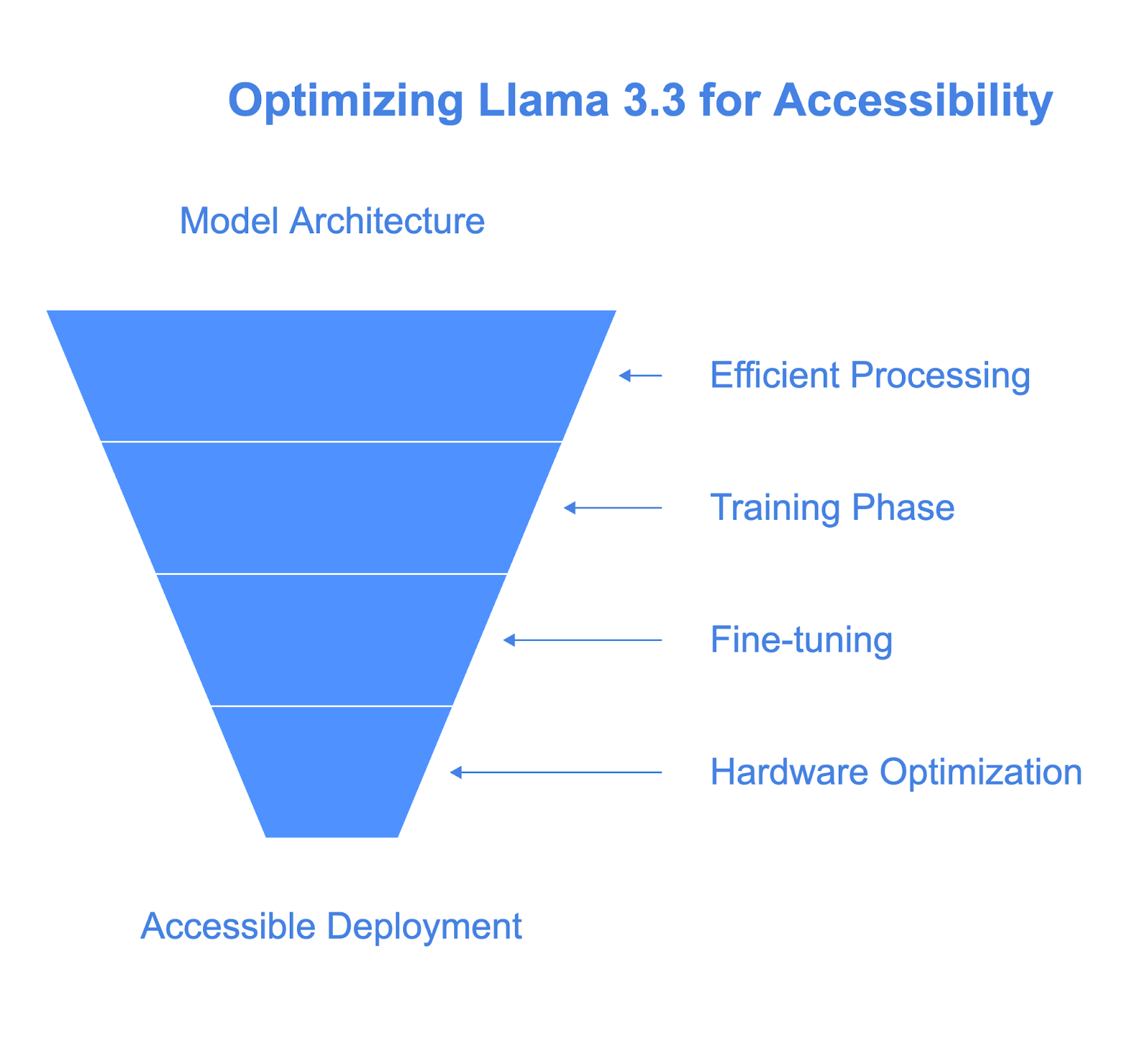

Architektur: Effizient und skalierbar

Das Herzstück von Llama 3.3 ist eine transformatorbasierte Architektur mit 70 Milliarden Parametern. Falls du damit nicht vertraut bist: Parameter sind im Wesentlichen die "Knöpfe", die das Modell während des Trainings anpasst, um Muster und Beziehungen im Text zu lernen. So kann Llama 3.3 kohärente, kontextbezogene Antworten geben.

Das Besondere an Llama 3.3 ist die Verwendung von Grouped-Query Attention (GQA). Dadurch wird das Modell effizienter, da es den Text schneller und mit weniger Rechenressourcen verarbeiten kann. Deshalb kann es eine ähnliche Leistung wie das viel größere Llama 3.1 405B erreichen und ist dabei weit weniger anspruchsvoll an die Hardware.

Ausbildung und Feinabstimmung

Um ein Modell wie Llama 3.3 zu trainieren, wird es zunächst mit einem riesigen Datensatz - 15 Billionen Text-Token aus öffentlich zugänglichen Quellen - konfrontiert. Dadurch erhält das Modell sein breites Verständnis von Sprache und Wissen.

Aber wir wissen, dass ein einfaches Training nicht ausreicht, um ein Modell in der realen Welt nützlich zu machen. Das ist der Punkt, an dem die Feinabstimmung einsetzt:

- Überwachte Feinabstimmung (SFT): Hier lernt das Modell aus sorgfältig ausgewählten Beispielen für gute Antworten. Sieh dies als einen "Goldstandard" dafür, wie es sich verhalten sollte.

- Verstärkungslernen mit menschlichem Feedback (RLHF): Dazu gehört, dass wir Feedback von Menschen über die Leistung des Modells sammeln und dieses Feedback nutzen, um sein Verhalten zu verbessern.

Dieser doppelte Ansatz stellt sicher, dass Llama 3.3 die Erwartungen der Menschen erfüllt, sowohl in Bezug auf die Nützlichkeit als auch auf die Sicherheit.

Entwickelt für barrierefreie Hardware

Llama 3.3 ist so konzipiert, dass es lokal auf gängigen Entwickler-Workstations läuft und somit auch für Entwickler ohne Unternehmensinfrastruktur zugänglich ist. Im Gegensatz zu größeren Modellen wie dem Llama 3.1 405B benötigt es deutlich weniger Rechenleistung bei gleichbleibend starker Performance.

Diese Effizienz ist größtenteils auf die Grouped-Query Attention (GQA) zurückzuführen, die die Textverarbeitung des Modells optimiert, indem sie den Speicherverbrauch reduziert und die Inferenz beschleunigt.

Das Modell unterstützt auch Quantisierungstechniken, such 8-Bit- und 4-Bit-Präzision, durch Tools wie bitsandbytes. Diese Techniken senken den Speicherbedarf erheblich, ohne dass die Leistung darunter leidet.

Außerdem lässt es sich gut über verschiedene Hardwarekonfigurationen hinweg skalieren, von einzelnen GPUs bis hin zu verteilten Systemen, und bietet so Flexibilität sowohl für lokale Experimente als auch für größere Einsätze.

In der Praxis bedeutet das, dass wir mit Llama 3.3 auf günstigerer Hardware experimentieren oder es einsetzen können, um die hohen Kosten zu vermeiden, die normalerweise mit fortgeschrittenen KI-Modellen verbunden sind. Das macht sie zu einer praktischen Wahl für Entwickler und Teams, die ein Gleichgewicht zwischen Leistung und Barrierefreiheit suchen.

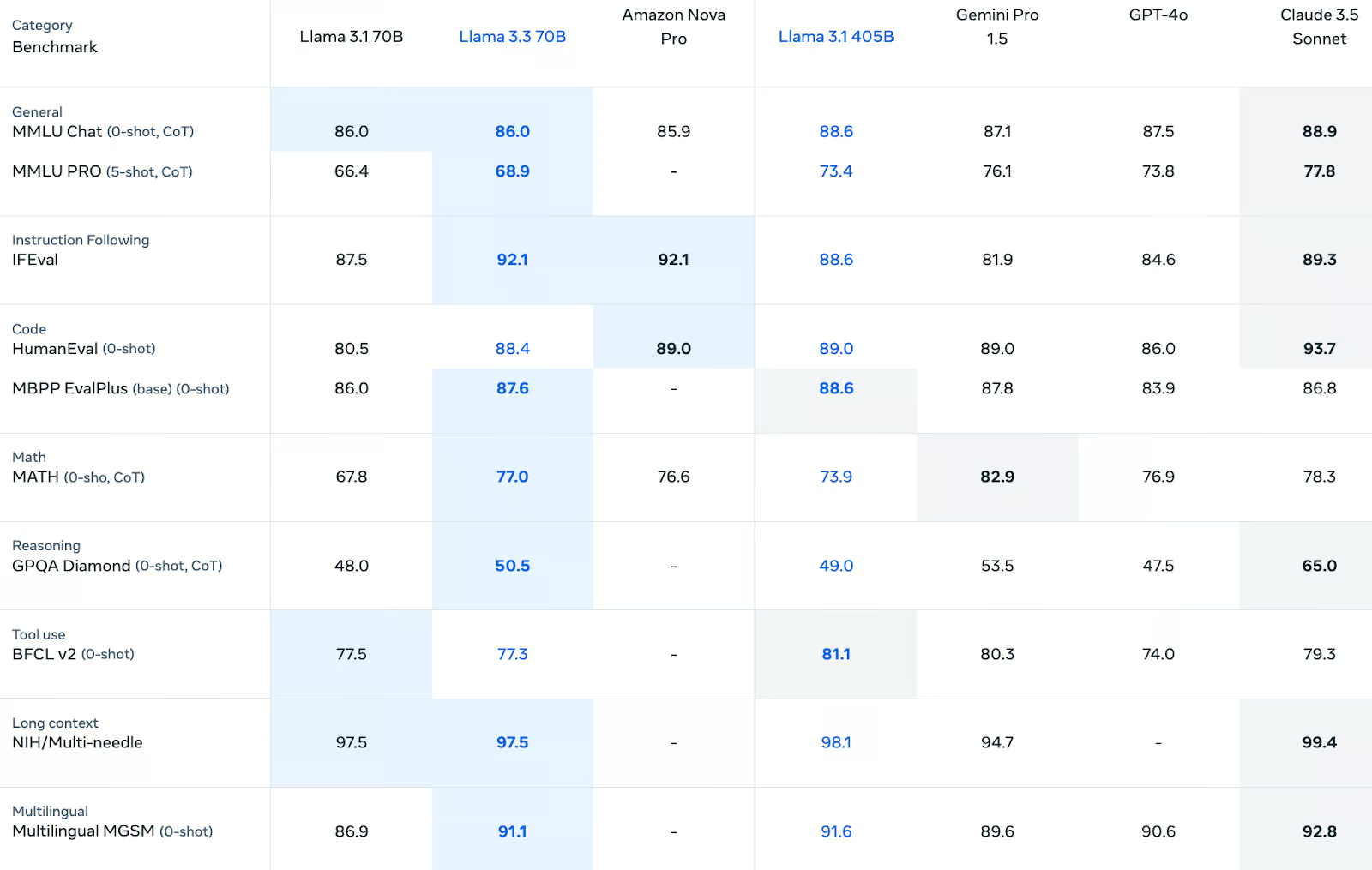

Llama 3.3 Benchmarks

Llama 3.3 schneidet bei einer Vielzahl von Benchmarks gut ab, mit herausragenden Ergebnissen beim Befolgen von Anweisungen, beim Codieren und beim mehrsprachigen Denken. Er übertrifft zwar nicht durchgehend größere Modelle wie das Llama 3.1 405B oder das Claude 3.5 Sonnet, aber er liefert in den meisten Kategorien zuverlässige und konkurrenzfähige Ergebnisse. Für Entwickler/innen, die ein ausgewogenes Modell suchen, das verschiedene Aufgaben effektiv bewältigt, ist Llama 3.3 eine gute Wahl.

Allgemeinwissen und logisches Denken

Bei allgemeinen Wissensaufgaben liefert Llama 3.3 solide Ergebnisse. Im MMLU-Chat (0-Schuss, CoT) erreicht es einenWert von 86,0 und liegt damit gleichauf mit seinem Vorgänger Llama 3.1 70B und konkurrenzfähig mit Amazon Nova Pro (85,9). Allerdings liegt er etwas hinter dem größeren Llama 3.1 405B (88,6) und dem Claude 3.5 Sonnet (88,9) zurück.

Auf der anspruchsvolleren MMLU PRO (5-Schuss, CoT) Benchmark verbessert sich Llama 3.3 gegenüber Llama 3.1 70B mit einem Ergebnis von 68.9aber es bleibt sowohl hinter Llama 3.1 405B (73,4) als auch hinter Claude 3.5 Sonnet (77,8).

Bei den Aufgaben zum logischen Denken erreicht Llama 3.3 im GPQA Diamond (0-Schuss, CoT)einen Wert von 50,5, eine leichte Verbesserung gegenüber Llama 3.1 70B (48,0). Damit liegt er zwar hinter einigen Konkurrenten wie Claude 3.5 Sonnet (65,0), aber er zeigt einige Fortschritte beim strukturierten Denken.

Folgende Anweisung

Llama 3.3 schneidet bei der Befolgung von Anweisungen hervorragend ab: 92,1Punkte im IFEval, das misst, wie gut sich ein Modell an die Anweisungen des Benutzers hält. Mit diesem Ergebnis liegt er vor Llama 3.1 405B (88,6) und GPT-4o (84,6) und knapp vor Claude 3.5 Sonnet (89,3). Seine Leistung in dieser Kategorie unterstreicht seine Anpassungsfähigkeit, die für Anwendungen wie Chatbots und aufgabenspezifische Assistenten entscheidend ist.

Codierfähigkeiten

Codier-Benchmarks sind eine Stärke von Llama 3.3. Auf HumanEval (0-Schuss) erreicht er 88,4 und liegt damit knapp hinter Llama 3.1 405B (89,0) und gleichauf mit Gemini Pro 1.5. Auch in MBPP EvalPlus (Basis) erreicht es 87,6, eine leichte Verbesserung gegenüber Llama 3.1 70B (86,0). Diese Ergebnisse bestätigen seine Effektivität bei der Erstellung von Code und beim Lösen von Programmieraufgaben.

Mathematik und symbolisches Denken

Im Bereich des symbolischen Denkens zeigt Llama 3.3 deutliche Fortschritte. Es erzielt 77,0 Punkteim MATH (0-shot, CoT) Benchmark und übertrifft damit Llama 3.1 70B (67,8) und Amazon Nova Pro (76,6). Allerdings liegt es hinter Gemini Pro 1.5 (82,9). Obwohl er in dieser Kategorie nicht führend ist, ist er für viele strukturierte Aufgaben gut genug.

Mehrsprachige Fähigkeiten

Llama 3.3 zeigt eine deutliche Stärke im mehrsprachigen Denken und erreicht 91,1Punkte im MGSM (0-Schuss). Das ist eine deutliche Verbesserung gegenüber Llama 3.1 70B (86,9) und liegt nahe an Claude 3.5 Sonnet (92,8). Seine Leistung in dieser Kategorie macht ihn zu einer guten Wahl für mehrsprachige Anwendungen wie Übersetzungen und globalen Kundensupport.

Werkzeuggebrauch und Leistung im Langzeitkontext

Bei der Verwendung von Werkzeugen erreicht Llama 3.3 77,3 auf BFCL v2 (0-Schuss), vergleichbar mit Llama 3.1 70B (77,5), aber weniger als Llama 3.1 405B (81,1). Bei der Verarbeitung von Eingaben mit langem Kontext erzielt 97,5 Punkteauf NIH/Multi-Needle und liegt damit gleichauf mit Llama 3.1 70B und leicht hinter Llama 3.1 405B (98,1). Diese Ergebnisse deuten auf starke Fähigkeiten für toolgestützte Arbeitsabläufe und erweiterte Eingabeszenarien hin.

Llama 3.3 Anwendungsfälle

Llama 3.3 eröffnet Entwicklern und Forschern dank seiner Ausgewogenheit zwischen starker Leistung und Hardware-Effizienz eine breite Palette von Möglichkeiten. Wir finden es gut, dass die Software auf Standard-Entwicklerarbeitsplätzen läuft, was sie auch für diejenigen interessant macht, die keinen Zugang zu einer unternehmensweiten Infrastruktur haben. Hier sind einige der Bereiche, in denen es nützlich sein kann.

1. Mehrsprachige Chatbots und Assistenten

Eine der Stärken von Llama 3.3 ist die Fähigkeit, mit mehreren Sprachen umzugehen. Mit der Unterstützung von acht Kernsprachen - darunter Englisch, Spanisch, Französisch und Hindi - ist sie ideal für den Aufbau mehrsprachiger Chatbots oder virtueller Assistenten.

Was uns auffällt, ist, dass du kein Rechenzentrum brauchst, um loszulegen. Entwickler können diese Systeme auf ihrer eigenen Hardware prototypisch entwickeln und einsetzen, sei es für den Kundensupport, für Bildungstools oder für andere dialogorientierte Anwendungen.

Mit Llama 3.3 können wir zum Beispiel einen Kundenservice-Chatbot erstellen, der Anfragen in mehreren Sprachen beantwortet und dabei effizient auf einer einzigen GPU läuft.

2. Codierungsunterstützung und Softwareentwicklung

Llama 3.3 hat bei Codier-Benchmarks wie HumanEval und MBPP EvalPlus sehr gut abgeschnitten und ist ein zuverlässiger Assistent für das Erstellen von Code, das Debuggen oder sogar das Vervollständigen von teilweise geschriebenen Skripten.

Was wir besonders wertvoll finden, ist, wie gut es auf persönlicher Hardware funktioniert. Anstatt dich auf teure Cloud-Systeme zu verlassen, kannst du Llama 3.3 lokal ausführen, um sich wiederholende Aufgaben zu automatisieren, Boilerplate-Code zu generieren oder Unit-Tests zu erstellen. Das macht fortgeschrittene KI-Unterstützung sowohl für Teams als auch für Einzelentwickler/innen praktisch und erschwinglich.

3. Synthetische Daten erzeugen

Ein weiterer Bereich, in dem Llama 3.3 glänzt, ist die Erstellung synthetischer Datensätze. Egal, ob du einen Chatbot baust, einen Klassifikator trainierst oder an einem NLP-Projekt arbeitest, die Möglichkeit, hochwertige, beschriftete Daten zu generieren, kann viel Zeit und Mühe sparen.

Wir denken, dass dieser Anwendungsfall besonders für kleinere Teams wertvoll ist, die domänenspezifische Daten benötigen, aber nicht die Ressourcen haben, diese manuell zu sammeln. Da Llama 3.3 auf entwicklungsfähiger Hardware läuft, kannst du Daten lokal erzeugen, was die Kosten reduziert und den Arbeitsablauf vereinfacht.

4. Erstellung und Lokalisierung mehrsprachiger Inhalte

Die mehrsprachigen Fähigkeiten von Llama 3.3 machen es auch zu einem starken Kandidaten für die Erstellung von Inhalten. Wir sehen ihr Potenzial bei der Erstellung lokalisierter Marketingmaterialien, der Übersetzung technischer Dokumente oder der Erstellung mehrsprachiger Blogs. Die Entwickler können das Modell feinabstimmen, um den Ton oder den Stil anzupassen und sicherzustellen, dass das Ergebnis zur Zielgruppe passt.

Mit Llama 3.3 kannst du zum Beispiel eine Produktbeschreibung in mehreren Sprachen verfassen und so den Lokalisierungsprozess verbessern, ohne dass du ein eigenes Übersetzerteam brauchst.

5. Forschung und Experimentieren

Für Forscherinnen und Forscher bietet Llama 3.3 eine solide Plattform, um Sprachmodellierungs-, Alignment- oder Feinabstimmungstechniken zu erforschen. Was sie besonders attraktiv macht, ist ihre Effizienz - du brauchst keinen Zugang zu einer großen Cloud-Infrastruktur, um mit fortschrittlicher KI zu experimentieren.

Das macht es zu einem großartigen Werkzeug für akademische Projekte oder die Industrieforschung, vor allem wenn es darum geht, Bereiche wie die Sicherheitsausrichtung oder die Ausbildung kleinerer, spezialisierter Modelle durch Destillation zu untersuchen.

6. Wissensbasierte Anwendungen

Die starken Textverarbeitungsfunktionen von Llama 3.3 eignen sich auch für Anwendungen wie die Beantwortung von Fragen, Zusammenfassungen und die Erstellung von Berichten. Diese Aufgaben erfordern oft den effizienten Umgang mit großen Textmengen, was Llama 3.3 auch auf privater Hardware gut bewältigen kann.

Wir könnten es zum Beispiel nutzen, um Kundenfeedback automatisch zusammenzufassen oder interne Dokumentationen zu erstellen, um Zeit zu sparen und gleichzeitig die Genauigkeit zu wahren.

7. Flexibler Einsatz für kleine Teams

Wir sind der Meinung, dass Llama 3.3 eine großartige Option für Startups, Einzelentwickler oder kleine Teams ist, die fortschrittliche KI-Funktionen benötigen, ohne die Kosten für eine Infrastruktur auf Unternehmensniveau zu tragen. Seine Fähigkeit, auf lokalen Servern oder sogar einer einzelnen Workstation zu laufen, macht es zu einer praktischen Lösung für leichtgewichtige Produktionssysteme.

Wie man auf Llama 3.3 zugreift

Meta bietet den Zugang zu Llama 3.3 über ihre eigene Website an: Llama Downloads. Hier findest du Links zur offiziellen Modellkarte, zu Lizenzierungsdetails und zu zusätzlicher Dokumentation, die dir den Einstieg erleichtert.

Für eine ausführliche Anleitung empfehlen wir die offiziellen Ressourcen:

- Modellkarte und Gebrauchsanweisung auf GitHub: Meta GitHub Repository.

- Hugging Face Modellseite: Llama 3.3-70B auf Hugging Face.

Diese Plattformen bieten eine ausführliche Dokumentation und Community-Foren, in denen du Fragen stellen oder Probleme beheben kannst.

Llama 3.3 Preisgestaltung

Aus unserer Sicht macht diese Preisgestaltung Llama 3.3 besonders attraktiv für Entwickler, die mit einem geringen Budget arbeiten oder Projekte mit hohen Token-Anforderungen skalieren. Egal, ob du es lokal oder über eine Plattform betreibst, diese wettbewerbsfähigen Tarife stellen sicher, dass du hochwertige KI nutzen kannst, ohne die Bank zu sprengen.

Input Token Kosten

Für die Verarbeitung von 1 Million Input-Token kostet Llama 3.3 $0,1, was dem Preis seines Vorgängers Llama 3.1 70B entspricht. Im Vergleich zu anderen Modellen ist dies einer der niedrigsten Preise:

- Amazon Nova Pro kostet $0,80 und ist damit achtmal teurer für das gleiche Volumen.

- GPT-4o und Claude 3.5 Sonnet kosten $2,5 bzw. $3,0 und sind damit deutlich teurer als Llama 3.3.

Dank dieser geringen Eingabekosten eignet sich Llama 3.3 besonders für Anwendungen, die große Textmengen verarbeiten müssen, wie z. B. Chatbots oder Textanalysetools.

Output Token Kosten

Für 1 Million Output-Token kostet Llama 3.3 $0,4, was wiederum dem Preis von Llama 3.1 70B entspricht. Hier ist der Vergleich:

- Der Preis von Amazon Nova Pro liegt bei 1,8 Dollar und ist damit mehr als viermal so hoch wie der von Llama 3.3.

- GPT-4o kostet $10,0 und Claude 3.5 Sonnet kostet $15,0, so dass Llama 3.3 mit großem Abstand die günstigste Option ist.

Für Anwendungen, die ein hohes Textvolumen generieren, wie z.B. die Erstellung synthetischer Daten oder von Inhalten, bietet Llama 3.3 erhebliche Kosteneinsparungen.

Fazit

Wir sehen Llama 3.3 als ein überzeugendes Beispiel dafür, wie große Sprachmodelle ein Gleichgewicht zwischen Leistungsfähigkeit und Zugänglichkeit herstellen können.

Als 70-Milliarden-Parameter-Modell liefert es eine vergleichbare Leistung wie das viel größere Llama 3.1 405B, aber mit weitaus geringerem Rechenaufwand.

Für Entwickler/innen, die keinen Zugang zu Hardware auf Unternehmensebene haben, ist dieses Modell eine praktische Möglichkeit, hochwertige KI in ihre Arbeitsabläufe zu integrieren.

FAQs

Wie unterscheidet sich Llama 3.3 von Llama 3.2?

Llama 3.3 verbessert Llama 3.2 durch eine bessere Feinabstimmung (SFT und RLHF), erweiterte Sicherheitsfunktionen, mehrsprachige Unterstützung (8 Sprachen), ein größeres Kontextfenster (128k Token) und eine bessere Benchmark-Leistung. Außerdem bietet sie neue Funktionen für die Nutzung von Werkzeugen, eine verbesserte Energieeffizienz und ein robustes Framework für verantwortungsvolle KI, was sie noch leistungsfähiger und vielseitiger macht.

Wie unterscheidet sich Llama 3.3 von Llama 405B?

Llama 3.3 bietet eine vergleichbare Leistung wie Llama 3.1 405B, ist aber deutlich effizienter und benötigt viel weniger Rechenleistung für den Betrieb.

Welche Sprachen werden von Llama 3.3 unterstützt?

Llama 3.3 unterstützt von Haus aus Deutsch, Englisch, Französisch, Hindi, Italienisch, Portugiesisch, Spanisch und Thailändisch. Entwickler können es für andere Sprachen anpassen, aber es sind zusätzliche Sicherheitsvorkehrungen erforderlich.

Bei welchen Benchmarks schneidet Llama 3.3 besonders gut ab?

Llama 3.3 erreicht hohe Punktzahlen in Benchmarks wie MMLU, HumanEval und MGSM und übertrifft viele andere Modelle in Kategorien wie logisches Denken, Codierung und Mehrsprachigkeit.

Kann Llama 3.3 auf Standard-Entwicklerhardware laufen?

Ja, Llama 3.3 ist so konzipiert, dass es auf gewöhnlichen Grafikprozessoren und Workstations für Entwickler läuft, so dass es auch für Entwickler ohne Unternehmensinfrastruktur zugänglich ist.