programa

Meta AI acaba de presentar Llama 3.3, un modelo de 70.000 millones de parámetros que ofrece un rendimiento comparable al de Llama 3.1 405B, mucho mayor, pero con demandas computacionales mucho menores.

Esto nos parece especialmente interesante porque hace que la IA de alta calidad sea más accesible a los desarrolladores que no tienen acceso a hardware caro.

Diseñado para tareas basadas en texto, como el chat multilingüe, la ayuda a la codificación y la generación de datos sintéticos, Llama 3.3 se centra únicamente en las entradas y salidas de texto: no está diseñado para manejar imágenes o audio.

En este blog, te explicaremos en qué destaca este modelo y te ayudaremos a decidir si es adecuado para tus proyectos.

Desarrollar aplicaciones de IA

¿Qué es Llama 3.3?

Llama 3.3 es el último gran modelo lingüístico de Meta AI, y lo consideramos un paso adelante para que la IA avanzada sea más accesible a una gran variedad de proyectos. Con 70.000 millones de parámetros, ofrece un rendimiento equiparable al del mucho mayor Llama 3.1 405B, pero con unos requisitos de hardware significativamente reducidos. Esto significa que podemos explorar sofisticadas aplicaciones de IA sin necesidad de costosos montajes especializados.

El modelo está diseñado específicamente para entradas y salidas de texto, por lo que no maneja imágenes, audio u otros medios. Hemos comprobado que es especialmente eficaz para tareas como el chat multilingüe, la ayuda a la codificación y la generación de datos sintéticos. Con soporte para ocho idiomas, entre ellos inglés, español, hindi y alemán, es una opción sólida para proyectos que requieran capacidades multilingües.

Lo que más nos llama la atención es su enfoque en la eficacia. Llama 3.3 está optimizada para ejecutarse en GPU comunes, lo que la hace práctica para implantaciones locales y más fácil de experimentar. También incorpora técnicas de alineación para garantizar que sus respuestas sean útiles y seguras, lo que sabemos que es esencial para las aplicaciones sensibles.

En esta sección hemos esbozado lo básico de lo que es Llama 3.3, pero profundizaremos más en las secciones siguientes. Explicaremos cómo funciona, cómo empezar a utilizarlo y cómo se comporta en las pruebas comparativas, para que puedas determinar si es adecuado para tu trabajo.

¿Cómo funciona Llama 3.3?

He aquí cómo funciona Llama 3.3, desglosado de un modo que esperamos tenga sentido tanto si estás familiarizado con los grandes modelos lingüísticos como si acabas de empezar a explorarlos.

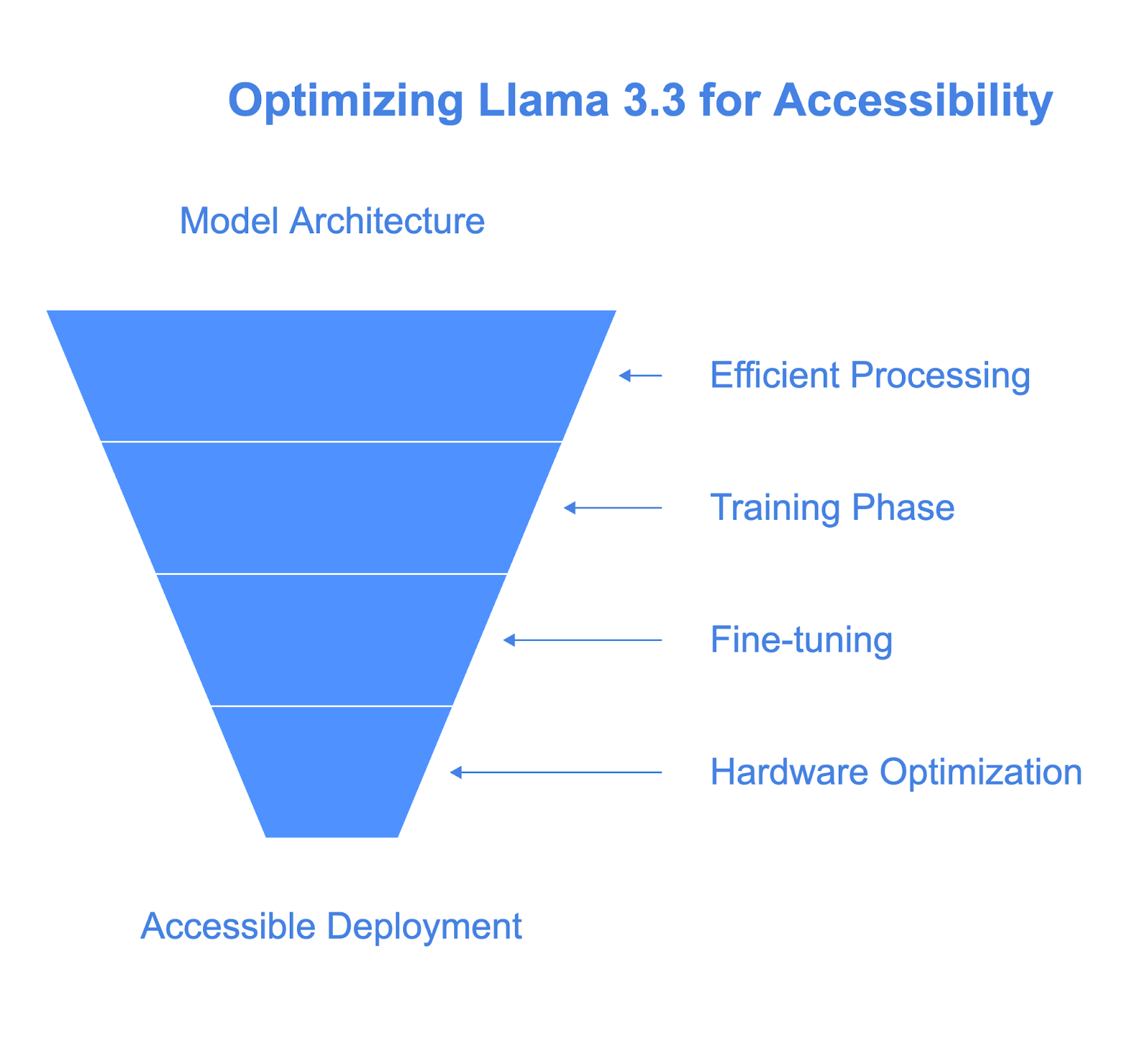

Arquitectura: Eficaz y escalable

En el corazón de Llama 3.3 hay una arquitectura basada en transformadores con 70.000 millones de parámetros. Si no estás familiarizado, los parámetros son esencialmente los "mandos" que el modelo ajusta durante el entrenamiento para aprender patrones y relaciones en el texto. Esto es lo que permite a Llama 3.3 generar respuestas coherentes y contextualmente relevantes.

Lo que es diferente en Llama 3.3 es su uso de la Atención a las Consultas Agrupadas (GQA). Esto hace que el modelo sea más eficaz, ya que le permite procesar el texto más rápidamente y con menos recursos informáticos. Por eso puede alcanzar un rendimiento similar al de la Llama 3.1 405B, mucho mayor, siendo mucho menos exigente con el hardware.

Formación y puesta a punto

Para entrenar un modelo como Llama 3.3 hay que exponerlo a un amplio conjunto de datos: 15 billones de tokens de texto de fuentes públicas. Esto confiere al modelo su amplia comprensión del lenguaje y del conocimiento.

Pero sabemos que la formación bruta no basta para que un modelo sea útil en situaciones reales. Ahí es donde entra en juego el ajuste fino:

- Ajuste fino supervisado (SFT): Aquí, el modelo aprende de ejemplos cuidadosamente seleccionados de buenas respuestas. Piensa que esto proporciona un "patrón oro" de cómo debe comportarse.

- Aprendizaje por refuerzo con retroalimentación humana (RLHF): Esto implica recoger las opiniones de los humanos sobre el funcionamiento del modelo y utilizarlas para perfeccionar su comportamiento.

Este doble enfoque garantiza que Llama 3.3 se ajuste a las expectativas humanas, tanto en términos de utilidad como de seguridad.

Diseñado para herrajes accesibles

Llama 3.3 está diseñado para ejecutarse localmente en estaciones de trabajo comunes de desarrolladores, lo que lo hace accesible para desarrolladores sin infraestructura de nivel empresarial. A diferencia de los modelos más grandes, como Llama 3.1 405B, requiere mucha menos potencia de cálculo manteniendo un gran rendimiento.

Esta eficacia se debe en gran parte a la Atención a las Consultas Agrupadas (GQA), que optimiza la forma en que el modelo procesa el texto reduciendo el uso de memoria y acelerando la inferencia.

El modelo también admite técnicas de cuantización, sómo precisión de 8 y 4 bits, mediante herramientas como bitsandbytes. Estas técnicas reducen considerablemente los requisitos de memoria sin sacrificar mucho rendimiento.

Además, se adapta bien a distintas configuraciones de hardware, desde una sola GPU a sistemas distribuidos, ofreciendo flexibilidad tanto para experimentos locales como para grandes despliegues.

En la práctica, esto significa que podemos experimentar o desplegar Llama 3.3 en configuraciones de hardware más asequibles, evitando los elevados costes que suelen asociarse a los modelos avanzados de IA. Esto lo convierte en una opción práctica para desarrolladores y equipos que buscan equilibrar el rendimiento con la accesibilidad.

Puntos de referencia de Llama 3.3

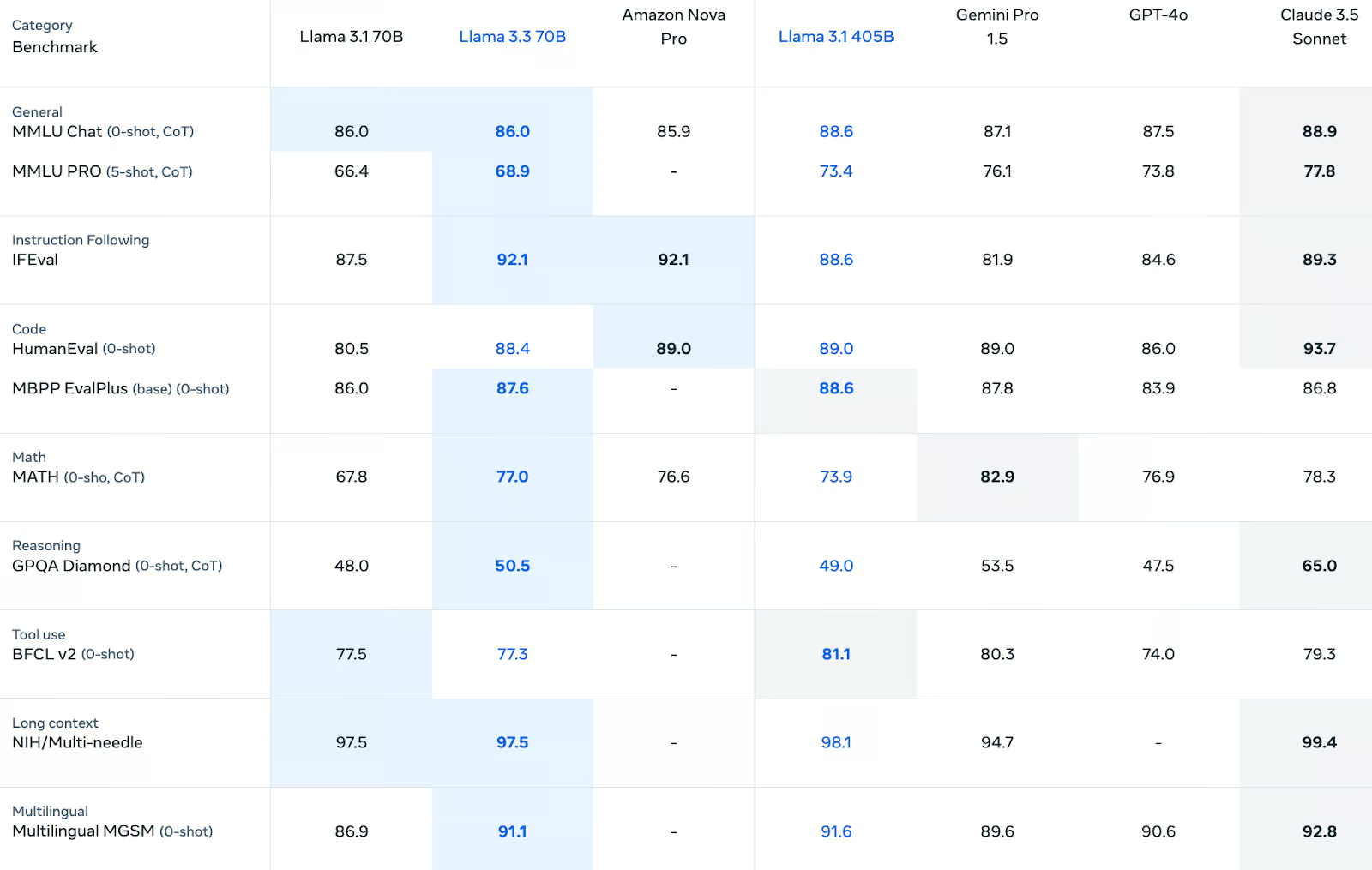

Llama 3.3 obtiene buenos resultados en una serie de pruebas, destacando en el seguimiento de instrucciones, la codificación y el razonamiento multilingüe. Aunque no supera sistemáticamente a modelos más grandes como Llama 3.1 405B o Claude 3.5 Sonnet, ofrece resultados fiables y competitivos en la mayoría de las categorías. Para los desarrolladores que busquen un modelo equilibrado que maneje diversas tareas con eficacia, Llama 3.3 es una opción sólida.

Conocimientos generales y razonamiento

En tareas de conocimientos generales, Llama 3.3 ofrece resultados sólidos. Alcanza unapuntuación de 86,0 en MMLU Chat (0 disparos, CoT), igualando a su predecesor Llama 3.1 70B y manteniéndose competitivo con Amazon Nova Pro (85,9). Sin embargo, se queda ligeramente por debajo de las más grandes Llama 3.1 405B (88,6) y Claude 3.5 Sonnet (88,9).

En el más difícil MMLU PRO (5 disparos, CoT) Llama 3.3 mejora a Llama 3.1 70B con una puntuación de 68.9pero sigue por detrás de Llama 3.1 405B (73,4) y Claude 3.5 Sonnet (77,8).

En las tareas de razonamiento, Llama 3.3 obtiene una puntuación de 50,5 en el GPQA Diamante (0 tiros, CoT), una ligera mejora respecto a Llama 3.1 70B (48,0). Aunque esto lo sitúa por detrás de algunos competidores como Claude 3.5 Sonnet (65,0), demuestra cierto progreso en el razonamiento estructurado.

Instrucción siguiente

Llama 3.3 destaca en las tareas de seguimiento de instrucciones, con una puntuación de 92,1 en IFEval, que mide lo bien que un modelo sigue las instrucciones del usuario. Este resultado lo sitúa por delante de Llama 3.1 405B (88,6) y GPT-4o (84,6), y cerca de Claude 3.5 Sonnet (89,3). Su rendimiento en esta categoría pone de relieve sus capacidades de alineación, que son cruciales para aplicaciones como los chatbots y los asistentes para tareas específicas.

Capacidad de codificación

Los puntos de referencia de codificación son un punto fuerte de Llama 3.3. En HumanEval (0 disparos), obtiene una puntuación de 88,4, ligeramente por detrás de Llama 3.1 405B (89,0) y a la par que Gemini Pro 1.5. Del mismo modo, en MBPP EvalPlus (base), consigue 87,6, una ligera mejora respecto a Llama 3.1 70B (86,0). Estos resultados confirman su eficacia para generar código y resolver tareas relacionadas con la programación.

Matemáticas y razonamiento simbólico

En razonamiento simbólico, Llama 3.3 muestra progresos significativos. Obtiene 77,0 puntos en la prueba de referenciaMATH (0 disparos, CoT), superando a Llama 3.1 70B (67,8) y Amazon Nova Pro (76,6). Sin embargo, queda por detrás de Géminis Pro 1,5 (82,9). Aunque no es el líder en esta categoría, rinde lo suficientemente bien para muchas tareas de razonamiento estructurado.

Capacidad multilingüe

Llama 3.3 demuestra una fuerza significativa en el razonamiento multilingüe, con una puntuación de 91,1 en MGSM (0 tiros). Esto supone una mejora sustancial respecto a Llama 3.1 70B (86,9) y la sitúa cerca de Claude 3.5 Sonnet (92,8). Su rendimiento en esta categoría lo convierte en una gran elección para aplicaciones multilingües como la traducción y la atención al cliente global.

Uso de herramientas y rendimiento en contextos largos

Para el uso de herramientas, Llama 3.3 alcanza 77,3 en BFCL v2 (0 disparos), comparable a Llama 3.1 70B (77,5), pero no llega a Llama 3.1 405B (81,1). En el manejo de entradas de contexto largo, obtiene una puntuaciónde 97,5 en NIH/Multi-Needle, igual que Llama 3.1 70B y ligeramente por detrás de Llama 3.1 405B (98,1). Estos resultados indican una gran capacidad para los flujos de trabajo asistidos por herramientas y los escenarios de entrada ampliados.

Casos prácticos de Llama 3.3

Llama 3.3 abre un amplio abanico de posibilidades para desarrolladores e investigadores, gracias a su equilibrio entre un gran rendimiento y la eficiencia del hardware. Apreciamos que se ejecute eficazmente en estaciones de trabajo de desarrollador estándar, lo que la convierte en una opción accesible para quienes no tienen acceso a una infraestructura de nivel empresarial. Éstas son algunas de las áreas en las que puede ser útil.

1. Chatbots y asistentes multilingües

Uno de los puntos fuertes de Llama 3.3 es su capacidad para manejar varios idiomas. Con soporte para ocho idiomas principales -incluidos inglés, español, francés e hindi- es ideal para crear chatbots o asistentes virtuales multilingües.

Lo que nos llama la atención es que no necesitas un centro de datos para empezar. Los desarrolladores pueden crear prototipos y desplegar estos sistemas en su propio hardware, ya sea para atención al cliente, herramientas educativas u otras aplicaciones conversacionales.

Por ejemplo, podríamos utilizar Llama 3.3 para crear un chatbot de atención al cliente que responda a consultas en varios idiomas, todo ello ejecutándose eficientemente en una sola GPU.

2. Soporte de codificación y desarrollo de software

Con buenas puntuaciones en pruebas comparativas de codificación como HumanEval y MBPP EvalPlus, Llama 3.3 es un asistente fiable para generar código, depurar o incluso completar guiones escritos parcialmente.

Lo que nos parece especialmente valioso es lo bien que funciona en el hardware personal. En lugar de depender de costosos sistemas en la nube, puedes ejecutar Llama 3.3 localmente para automatizar tareas repetitivas, generar código repetitivo o crear pruebas unitarias. Para equipos o desarrolladores en solitario, esto hace que el soporte avanzado de codificación de IA sea práctico y asequible.

3. Generación de datos sintéticos

Otra área en la que Llama 3.3 brilla es en la generación de conjuntos de datos sintéticos. Tanto si estás construyendo un chatbot, entrenando un clasificador o trabajando en un proyecto de PNL, la capacidad de generar datos etiquetados de alta calidad puede ahorrarte mucho tiempo y esfuerzo.

Creemos que este caso de uso es especialmente valioso para los equipos más pequeños que necesitan datos específicos de un dominio, pero no disponen de recursos para recopilarlos manualmente. Como Llama 3.3 se ejecuta en hardware de nivel de desarrollador, puedes generar datos localmente, reduciendo costes y simplificando el flujo de trabajo.

4. Creación y localización de contenidos multilingües

Las capacidades multilingües de Llama 3.3 también lo convierten en un firme candidato para la creación de contenidos. Vemos su potencial en la producción de materiales de marketing localizados, la traducción de documentos técnicos o la creación de blogs multilingües. Los desarrolladores pueden ajustar el modelo para adaptar su tono o estilo, asegurándose de que el resultado coincide con el público al que va dirigido.

Por ejemplo, puedes utilizar Llama 3.3 para redactar la descripción de un producto en varios idiomas, mejorando el proceso de localización sin necesidad de un equipo dedicado de traductores.

5. Investigación y experimentación

Para los investigadores, Llama 3.3 proporciona una plataforma sólida para explorar técnicas de modelado, alineación o ajuste del lenguaje. Lo que la hace especialmente atractiva es su eficiencia: no necesitas acceso a una infraestructura masiva en la nube para experimentar con IA avanzada.

Esto lo convierte en una gran herramienta para proyectos académicos o de investigación industrial, especialmente cuando se exploran áreas como la alineación de seguridad o el entrenamiento de modelos más pequeños y especializados mediante destilación.

6. Aplicaciones basadas en el conocimiento

Las potentes capacidades de procesamiento de texto de Llama 3.3 también se prestan a aplicaciones como la respuesta a preguntas, el resumen y la generación de informes. Estas tareas a menudo requieren manejar grandes volúmenes de texto de forma eficiente, algo que Llama 3.3 puede gestionar bien incluso en hardware personal.

Por ejemplo, podríamos utilizarlo para resumir automáticamente las opiniones de los clientes o generar documentación interna, ahorrando tiempo y manteniendo la precisión.

7. Despliegue flexible para equipos pequeños

Por último, pensamos que Llama 3.3 es una gran opción para las empresas de nueva creación, los desarrolladores en solitario o los equipos pequeños que quieren capacidades avanzadas de IA sin los costes de una infraestructura de nivel empresarial. Su capacidad para funcionar en servidores locales o incluso en un único puesto de trabajo lo convierte en una solución práctica para sistemas de producción ligeros.

Cómo acceder a Llama 3.3

Meta proporciona acceso a Llama 3.3 a través de su sitio web específico: Llama Downloads. Aquí encontrarás enlaces a la ficha de modelo oficial, detalles de la licencia y documentación adicional para ayudarte a empezar.

Para una orientación más detallada, te recomendamos que explores los recursos oficiales:

- Modelo de ficha e instrucciones de uso en GitHub: Meta Repositorio GitHub.

- Modelo Cara Abrazada página: Llama 3.3-70B en Cara de Abrazo.

Estas plataformas proporcionan documentación detallada y foros comunitarios donde puedes hacer preguntas o solucionar problemas.

Llama 3.3 Precios

Desde nuestro punto de vista, este precio hace que Llama 3.3 sea especialmente atractiva para los desarrolladores que trabajan con un presupuesto reducido o que escalan proyectos con grandes demandas de tokens. Tanto si la gestionas localmente como a través de una plataforma, estas tarifas competitivas garantizan el acceso a una IA de alta calidad sin arruinarte.

Costes de las fichas de entrada

Para procesar 1 millón de tokens de entrada, Llama 3.3 tiene un precio de 0,1 $, que coincide con el de su predecesora, Llama 3.1 70B. En comparación con otros modelos, ésta es una de las tarifas más bajas:

- Amazon Nova Pro cobra 0,80 $, lo que lo hace ocho veces más caro por el mismo volumen.

- GPT-4o y Claude 3.5 Sonnet cuestan 2,5 y 3,0 $, respectivamente, lo que los sitúa significativamente por encima de Llama 3.3.

Este bajo coste de entrada hace que Llama 3.3 sea especialmente adecuado para aplicaciones que requieren procesar grandes cantidades de texto, como los chatbots o las herramientas de análisis de texto.

Costes de las fichas de salida

Por 1 millón de tokens de salida, Llama 3.3 tiene un precio de 0,4 $, igualando de nuevo el coste de Llama 3.1 70B. He aquí cómo se compara:

- Amazon Nova Pro tiene un precio de 1,8 $, más de cuatro veces superior al de Llama 3.3.

- GPT-4o cobra 10,0 $, y Claude 3.5 Sonnet cobra 15,0 $, por lo que Llama 3.3 es una opción económica por un amplio margen.

Para aplicaciones que generan un gran volumen de texto, como la creación de datos sintéticos o la generación de contenidos, Llama 3.3 ofrece un importante ahorro de costes.

Conclusión

Consideramos que Llama 3.3 es un ejemplo convincente de cómo los grandes modelos lingüísticos pueden equilibrar la capacidad con la accesibilidad.

Como modelo de 70.000 millones de parámetros, ofrece un rendimiento comparable al mucho mayor Llama 3.1 405B, pero con unos requisitos computacionales mucho menores.

Para los desarrolladores sin acceso a hardware de nivel empresarial, este modelo representa una forma práctica de integrar IA de alta calidad en sus flujos de trabajo.

Preguntas frecuentes

¿En qué se diferencia Llama 3.3 de Llama 3.2?

Llama 3.3 mejora a Llama 3.2 con un mejor ajuste fino (SFT y RLHF), funciones de seguridad ampliadas, soporte multilingüe (8 idiomas), una ventana de contexto más larga (128k tokens) y un mayor rendimiento en las pruebas comparativas. También añade capacidades de uso de herramientas, una mayor eficiencia energética y un sólido marco de IA responsable, lo que la hace más potente y versátil.

¿En qué se diferencia Llama 3.3 de Llama 405B?

Llama 3.3 ofrece un rendimiento comparable a Llama 3.1 405B, pero es significativamente más eficiente, ya que requiere mucha menos potencia de cálculo para funcionar.

¿Qué idiomas admite Llama 3.3?

Llama 3.3 es compatible de forma nativa con el inglés, francés, alemán, hindi, italiano, portugués, español y tailandés. Los desarrolladores pueden ajustarlo para otros idiomas, pero se necesitan salvaguardas adicionales.

¿En qué pruebas destaca Llama 3.3?

Llama 3.3 obtiene puntuaciones altas en pruebas de referencia como MMLU, HumanEval y MGSM, y supera a muchos otros modelos en categorías como razonamiento, codificación y capacidades multilingües.

¿Puede funcionar Llama 3.3 en hardware estándar para desarrolladores?

Sí, Llama 3.3 está diseñado para ejecutarse en GPU comunes y estaciones de trabajo de nivel de desarrollador, lo que lo hace accesible para desarrolladores sin infraestructura de nivel empresarial.