Curso

Imagine que você é proprietário de uma empresa de comércio eletrônico. Para otimizar seu site e gerar mais vendas, você pode acompanhar o comportamento do cliente. Isso envolve o rastreamento de cada clique, consulta de pesquisa e compra, que fornecem dados valiosos.

No entanto, os dados que você está coletando estão espalhados por vários sistemas (por exemplo, plataformas de análise da Web, bancos de dados de transações, registros de suporte ao cliente etc.), o que é um grande problema.

Para atenuar esse problema, todos os dados coletados devem ser consolidados em um único local, e é aí que a ingestão de dados se torna útil.

Por meio da ingestão de dados, você pode extrair todos esses dados para um data warehouse central, o que permite reunir insights em tempo real com mais rapidez e realizar análises quando necessário.

Neste artigo, exploraremos os fundamentos da ingestão de dados e as técnicas usadas para facilitar o processo. Você conhecerá as ferramentas que ajudam a simplificar a ingestão de dados, os desafios comuns que surgem e as práticas recomendadas para otimizar o processo em termos de escalabilidade, eficiência e qualidade dos dados.

Vamos nos aprofundar no assunto!

O que é ingestão de dados?

A ingestão de dados é o processo de coleta, importação e carregamento de dados de várias fontes em um sistema centralizado (por exemplo, um data warehouse, data lake ou plataforma de nuvem). Esse processo permite que você consolide dados de diferentes sistemas e os disponibilize para processamento e análise adicionais.

A ingestão eficiente de dados é importante porque forma a base para outras operações orientadas por dados, como análise, visualização e compartilhamento.

Tipos de ingestão de dados

Tecnicamente, a ingestão de dados pode ser amplamente categorizada em dois tipos principais:

- Ingestão de lotes

- Ingestão em tempo real

Cada abordagem atende a necessidades diferentes e é adequada para vários casos de uso, dependendo da velocidade e do volume de dados que estão sendo processados.

Ingestão de dados em lote

A ingestão em lote refere-se ao processo de coleta e processamento de dados em intervalos programados. Por exemplo, você pode coletar e processar dados por hora, diariamente ou até mesmo semanalmente. Essa abordagem é normalmente usada quando não são necessários insights instantâneos e ajuda a gerenciar grandes volumes de dados com eficiência.

Exemplos de casos de uso de ingestão em lote:

- Relatórios: Coleta de dados periodicamente para gerar relatórios de desempenho comercial.

- Sincronizações periódicas de dados: Sincronizar dados entre sistemas em intervalos regulares para mantê-los atualizados.

- Análise de dados financeiros no final do dia: Agregação de dados de transações para analisar o desempenho financeiro após o horário comercial.

Ingestão de dados em tempo real

A ingestão de dados em tempo real (ou streaming) envolve a coleta e o processamento contínuos de dados à medida que são gerados. Esse método permite que você obtenha percepções quase instantâneas, o que é ideal para cenários em que é necessário tomar decisões urgentes.

Exemplos de casos de uso de ingestão em tempo real:

- Detecção de fraudes: Monitoramento de transações em tempo real para identificar e responder a atividades suspeitas.

- Processamento de dados de sensores de IoT: Coleta e processamento de dados de dispositivos conectados, como sensores de temperatura ou de movimento, em tempo real.

- Painéis de análise em tempo real: Fornecer dados atualizados para painéis que monitoram os principais indicadores de desempenho (KPIs) e outras métricas.

Se você quiser saber mais sobre a diferença entre batching e streaming, dimensionamento de sistemas de streaming e aplicativos do mundo real, recomendo ocurso Streaming Concepts (Conceitos de streaming ).

Torne-se um engenheiro de dados

Técnicas de ingestão de dados

Várias técnicas facilitam a ingestão de dados. Cada um deles foi projetado para atender a diferentes casos de uso e necessidades de processamento de dados.

A escolha da técnica que você escolher depende de três fatores:

- Os requisitos específicos da empresa.

- A complexidade dos dados.

- A infraestrutura existente.

Nesta seção, abordarei três técnicas de ingestão de dados e quando elas são mais eficazes.

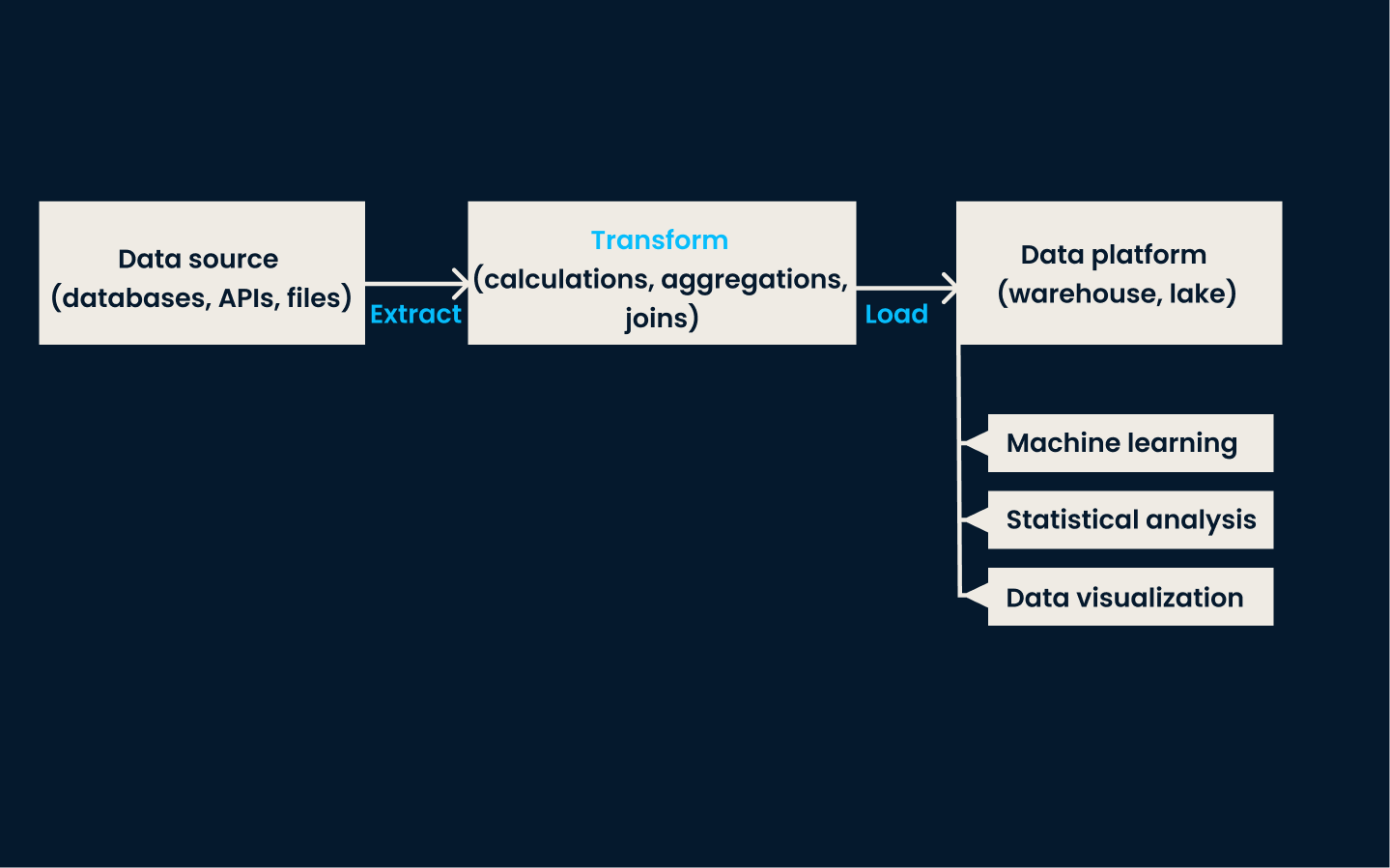

ETL (Extrair, Transformar, Carregar)

A ETL é uma técnica de ingestão de dados tradicional e amplamente usada. Nessa abordagem, os dados são extraídos de vários sistemas de origem, transformados em um formato consistente e limpo e, por fim, carregados em um sistema de armazenamento de dados, como um data warehouse .

Esse método é altamente eficaz para casos de uso que exigem dados consistentes e estruturados para relatórios, análises e tomada de decisões.

Quando você deve usar o ETL:

- Quando os dados precisam ser pré-processados (limpos ou transformados) antes de serem carregados no sistema de armazenamento.

- Cenários em que os dados estruturados são uma prioridade, como a geração de relatórios comerciais ou a adesão a requisitos rigorosos de qualidade de dados.

- Ao lidar com bancos de dados relacionais ou ambientes de dados de menor escala que priorizam dados limpos e prontos para análise.

Arquitetura do pipeline de ETL.

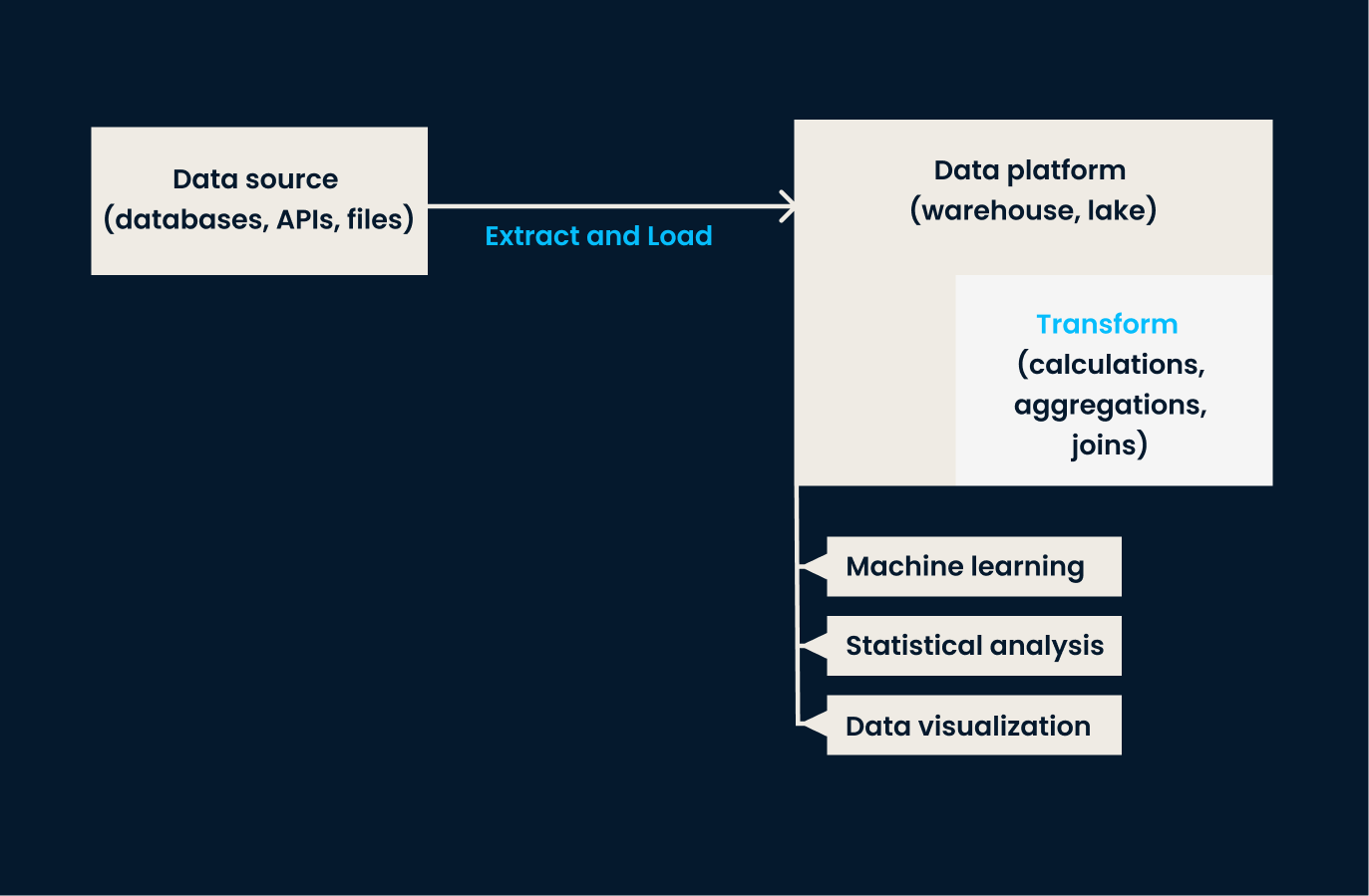

ELT (Extrair, Carregar, Transformar)

O ELT inverte a ordem das operações em comparação com o ETL. Nessa abordagem, os dados são extraídos dos sistemas de origem e carregados diretamente no sistema de destino (geralmente um lago de dados ou uma plataforma baseada em nuvem). Uma vez no sistema de armazenamento de destino, os dados são transformados conforme necessário, geralmente no ambiente de destino .

A abordagem ELT é particularmente eficaz ao lidar com grandes volumes de dados não estruturados ou semiestruturados, em que a transformação pode ser adiada até que a análise seja necessária.

Quando usar o ELT:

- Ao trabalhar com lagos de dados ou armazenamento em nuvem, que podem lidar com dados brutos em escala.

- Ao lidar com dados diversos, não estruturados ou semiestruturados que talvez não precisem de transformação imediata.

- Quando a flexibilidade é necessária, pois o ELT permite que as transformações de dados sejam realizadas sob demanda no ambiente de armazenamento.

Arquitetura do pipeline ELT.

Captura de dados de modificação (CDC)

O CDC é uma técnica para identificar e capturar alterações (por exemplo, inserções, atualizações, exclusões) feitas nos dados dos sistemas de origem e, em seguida, replicar essas alterações em tempo real para os sistemas de destino.

Essa técnica garante que os sistemas de destino estejam sempre atualizados sem recarregar todo o conjunto de dados. O CDC é altamente eficaz para manter a sincronização em tempo real entre bancos de dados e garantir a consistência entre os sistemas.

Quando usar o CDC:

- Quando a sincronização de dados em tempo real é essencial, como em negociações de alta frequência, transações de comércio eletrônico ou relatórios operacionais.

- Quando você precisa manter os sistemas de destino atualizados com tempos mínimos de atraso ou de atualização de dados.

- Quando for necessário evitar a sobrecarga de reanexar conjuntos de dados inteiros.

Fontes de dados para ingestão

Já estabelecemos que a ingestão de dados envolve a extração de informações de várias fontes. Mas ainda não discutimos quais são essas estruturas, e é isso que faremos nesta seção.

As fontes de dados para ingestão geralmente se enquadram em três tipos principais:

- Estruturado

- Semi-estruturado

- Dados não estruturados

Como você aprenderá quando examinarmos as diferentes fontes, cada uma delas exige diferentes técnicas de manuseio e processamento para ser utilizada de forma eficaz.

Fontes de dados estruturados

Os dados estruturados são altamente organizados e seguem um esquema predefinido, o que facilita o processamento e a análise. Normalmente, ele é armazenado em bancos de dados relacionais, que armazenam e fornecem acesso a pontos de dados relacionados. Os dados são organizados em tabelas com linhas e colunas claramente definidas.

Devido a essa natureza organizada, os dados estruturados são os mais simples de serem ingeridos.

As ferramentas tradicionais, como MySQL e PostgreSQL, são normalmente usadas para lidar com dados estruturados. Essas ferramentas baseadas em SQL simplificam o processo de validação durante a ingestão, impondo regras rígidas de esquema. Quando os dados são ingeridos nesses sistemas, elesautomaticamente garantem que eles sigam a estrutura definida pelas tabelas do banco de dados.

Por exemplo, se uma coluna for definida para aceitar somente valores inteiros, o MySQL ou o PostgreSQL rejeitará todos os dados que não atenderem a esse requisito.

Outros aspectos a serem observados sobre os dados estruturados são:

- Normalmente, é coletado em grandes volumes (e em um formato previsível).

- Em geral, ele é ingerido por meio de processos em lote, que permitem atualizações periódicas para atualizar os dados conforme necessário.

Fontes de dados semiestruturados

Os dados semiestruturados, embora ainda estejam organizados até certo ponto, não estão em conformidade com um esquema rígido e predefinido como os dados estruturados. Em vez disso, ele usa tags ou marcadores para fornecer alguma organização, mas a estrutura permanece flexível.

Esse tipo de dados é normalmenteencontrado em formatos como arquivos JSON, arquivos CSV e bancos de dados NoSQL, e é comumente usado em aplicativos da Web, APIs e sistemas de registro.

Como a estrutura pode variar,os dados semiestruturadosoferecem flexibilidade no armazenamento e no processamento, tornando-os adequados para sistemas que lidam com formatos de dados em evolução ou inconsistentes.

O tratamento de dados semiestruturados requer ferramentas para analisar e extrair informações significativas das tags ou marcadores incorporados. Por exemplo, um arquivo JSON pode conter uma coleção de pares de valores-chave, e o processo de ingestão envolveria a análise desses pares e sua transformação em um formato adequado.

Os dados semiestruturados geralmente são ingeridos em ambientes flexíveis, como lagos de dados ou plataformas de nuvem, onde podem ser armazenados em sua forma bruta e processados posteriormente, conforme necessário.

Outros aspectos a serem observados sobre os dados semiestruturados incluem:

- Dependendo do caso de uso, ele pode ser ingerido em tempo real ou por meio de lotes programados.

- Ele requer transformação durante a ingestão para garantir que possa ser processado ou analisado de forma eficaz.

Fontes de dados não estruturados

Os dados não estruturados são o tipo mais complexo de gerenciar porque não têm nenhum formato ou estrutura organizacional específica. Essa categoria inclui dados como:

- Imagens

- Vídeos

- Áudio

- Documentos

Diferentemente dos dados estruturados ou semiestruturados, os dados não estruturados não têm linhas, colunas ou tags claras para definir seu conteúdo, o que torna o processamento e a análise mais desafiadores.

Apesar de sua complexidade, os dados não estruturados podem conter insights valiosos, principalmente quando analisados por meio de tecnologias avançadas, como aprendizado de máquina ou processamento de linguagem natural.

Como os dados não estruturados não são organizados de uma forma pré-definida, são necessárias ferramentas especializadas para lidar com o processo de ingestão. Essas ferramentas podem extrair informações relevantes de fontes brutas e não estruturadas e transformá-las em formatos que podem ser analisados.

Por fim, os dados não estruturados são normalmente armazenados em lagos de dados, onde podem ser processados conforme necessário.

Tabela de comparação: Estruturado vs. Estruturado. Semi-estruturado vs. Dados não estruturados

|

Recurso |

Dados estruturados |

Dados semiestruturados |

Dados não estruturados |

|

Definição |

Dados altamente organizados com um esquema predefinido (por exemplo, linhas e colunas). |

Dados parcialmente organizados com tags ou marcadores para flexibilidade (por exemplo, JSON, CSV). |

Dados sem nenhuma estrutura ou organização predefinida (por exemplo, imagens, vídeos). |

|

Exemplos |

Bancos de dados relacionais como MySQL, PostgreSQL. |

Arquivos JSON, bancos de dados NoSQL, registros CSV. |

Imagens, vídeos, arquivos de áudio, documentos de texto. |

|

Facilidade de processamento |

Mais fácil de processar devido ao seu esquema rígido. |

Dificuldade moderada; requer análise e transformação. |

Mais desafiador devido à falta de estrutura. |

|

Armazenamento |

Bancos de dados relacionais ou data warehouses. |

Lagos de dados, bancos de dados NoSQL, armazenamento em nuvem. |

Lagos de dados ou armazenamento especializado para arquivos brutos. |

|

Abordagem de ingestão |

Normalmente, é ingerido em lotes. |

Flexível; pode ser ingerido em tempo real ou em lotes. |

Principalmente ingerido em formato bruto para processamento posterior. |

|

Ferramentas utilizadas |

Ferramentas baseadas em SQL, como MySQL, PostgreSQL. |

Ferramentas que lidam com esquemas flexíveis, como MongoDB, Google BigQuery. |

Ferramentas avançadas como Hadoop, Apache Spark ou ferramentas de processamento baseadas em IA/ML. |

|

Exemplos de casos de uso |

Geração de relatórios, sistemas transacionais. |

Respostas de API, registros de aplicativos da Web. |

Reconhecimento de imagens, análise de fala, análise de sentimentos. |

Desafios na ingestão de dados

A ingestão de dados traz vários desafios que você deve enfrentar para garantir um gerenciamento de dados eficiente e eficaz. Nesta seção, discutiremos quais são esses desafios e as soluções que podem ser empregadas para superá-los.

Manuseio de grandes volumes de dados

Um dos principais desafios da ingestão de dados é o grande volume de dados que precisa ser processado. À medida que as empresas crescem, a quantidade de dados que elas geram e coletam pode aumentar exponencialmente, principalmente com o aumento dos fluxos de dados em tempo real de fontes como dispositivos de IoT e plataformas de mídia social.

O dimensionamento dos processos de ingestão de dados para lidar com esses volumes crescentes pode ser difícil, especialmente com dados de streaming que exigem ingestão contínua.

As equipes devem garantir que sua infraestrutura possa suportar a ingestão de dados em lote e em tempo real em escalasem degradação. O curso Streaming Concepts é uma ótima maneira de você começar.

Qualidade e consistência dos dados

A qualidade e a consistência dos dados são outro desafio significativo, especialmente quando os dados são ingeridos de várias fontes diferentes. Cada fonte pode ter diferentes formatos, níveis de integridade ou até mesmo informações conflitantes.

A ingestão de dados sem abordar essas inconsistências pode levar a conjuntos de dados imprecisos ou incompletos, o que acaba afetando a análise downstream.

As verificações de validação de dados devem ser implementadas durante a ingestão para garantir que somente dados de alta qualidade entrem no sistema. Além disso, as equipes precisam manter a consistência em várias fontes para evitar discrepâncias nos dados.

Recomendo que você se aprofunde nesse tópico com o excelente curso Introduction to Data Quality.

Segurança e conformidade

Quando dados confidenciais são ingeridos, a segurança e a conformidade tornam-se as principais prioridades. As equipes que lidam com informações pessoais (por exemplo, nomes de clientes, endereços, detalhes de pagamento etc.) devem proteger esses dados durante todo o processo de ingestão.

Por exemplo, uma empresa de serviços financeiros deve aderir a regulamentações rigorosas, como o GDPR ou a HIPAA, ao ingerir dados de clientes para evitar repercussões legais. A falta de segurança dos dados durante a ingestão pode resultar em violações de dados, comprometendo a confiança do cliente e levando a penalidades financeiras substanciais.

Para resolver isso, as equipes devem implementar criptografia e controles de acesso seguro durante o processo de ingestão. Isso garante que os dados confidenciais sejam protegidos contra acesso não autorizado. Além disso, os dados devem ser ingeridos de forma que estejam em conformidade comtodos os padrões normativos relevantes, com auditorias regulares para verificar a conformidade contínua.

Descubra como manter os dados seguros e protegidos com o curso interativo de segurança de dados para iniciantes.

Requisitos de latência

Em cenários em que são necessários insights imediatos, atrasos na ingestão de dados podem resultar em informações desatualizadas ou irrelevantes. A ingestão de dados de baixa latência requer a capacidade de processar e disponibilizar dados para análise quase instantaneamente, o que pode ser um desafio ao lidar com grandes volumes de dados.

As equipes devem otimizar cuidadosamente seus sistemas para reduzir a latência e garantir que os dados estejam disponíveis quando necessário.

Práticas recomendadas para ingestão de dados

Existem algumas práticas recomendadas para garantir uma ingestão de dados eficiente e eficaz.

Priorizar a qualidade dos dados

Os dados ingeridos serão usados para análises, relatórios e tomada de decisões, portanto, devem atender a padrões predefinidos de precisão e integridade.

A implementação de verificações de validação de dados durante a ingestão pode ajudar a verificar se os dados estão em conformidade com os formatos e padrões de qualidade esperados. Eue escrevi sobre isso antes em um tutorial de Great Expectations.

Por exemplo, se você espera que os dados estejam em um determinado intervalo ou atendam a critérios específicos, use regras de validação para rejeitar ou sinalizar automaticamente qualquer dado que não atenda a esses padrões. Isso minimiza os erros e garante que somente dados confiáveis sejam processados no downstream.

Escolha a abordagem correta de ingestão

Outra prática recomendada é garantir que você selecione a abordagem de ingestão adequada às suas necessidades comerciais.

A ingestão em lote é normalmente usada para dados menos sensíveis ao tempo, como relatórios históricos ou periódicos. Por outro lado, a ingestão em tempo real é usada para aplicativos que exigem acesso instantâneo aos dados mais recentes, como detecção de fraudes ou monitoramento de IoT.

Avalie suas necessidades com base na frequência e na urgência das atualizações de dados.

Garantir a escalabilidade

Seu volume de dados crescerá com o tempo. Portanto, é importante selecionar ferramentas e infraestrutura escaláveis para lidar com quantidades crescentes de dados sem comprometer o desempenho. Isso permite que você expanda seus pipelines de dados e recursos de processamento para acomodar o crescimento futuro.

Use a compactação de dados

Menos espaço de armazenamento necessário significa custos de infraestrutura mais baixos. A compactação também acelera a transferência de dados, o que significa que a ingestão será mais rápida, principalmente ao lidar com grandes conjuntos de dados ou fluxos de alto volume. Essa prática é especialmente vantajosa quando você lida com dados semiestruturados ou não estruturados, pois eles geralmente são grandes.

Ferramentas de ingestão de dados

Como você pode ver, a ingestão de dados é um conceito simples, mas pode ser bastante difícil de implementar por conta própria. Quais são as melhores ferramentas para ajudar você com a ingestão de dados? Elaborei uma lista dos mais usados.

Apache Kafka

O Apache Kafka é uma plataforma de streaming distribuído que se destaca na ingestão de dados em tempo real. Ele foi projetado para lidar com fluxos de dados de alta taxa de transferência e baixa latência, o que o torna ideal para casos de uso que exigem acesso instantâneo a grandes volumes de dados gerados continuamente.

Um benefício significativo do Kafka é que ele permite que as empresas processem, armazenem e encaminhem dados de streaming para vários sistemas em tempo real. Ele é amplamente usado em cenários como detecção de fraude, processamento de dados de IoT e análise em tempo real.

O curso Introduction to Kafka pode ensinar a vocêcomo criar, gerenciar e solucionar problemas do Kafka para desafios de streaming de dados do mundo real.

Apache Nifi

O Apache Nifi é uma ferramenta de ingestão de dados conhecida por sua interface visual fácil de usar. Sua interface acessível permite que as empresas projetem, monitorem e gerenciem fluxos de dados usando um mecanismo de arrastar e soltar.

O Nifi é compatível com muitas fontes de dados, incluindo dados em lote e em tempo real, e pode ser integrado a sistemas como o Hadoop, bancos de dados relacionais e armazenamentos NoSQL. Sua capacidade de automatizar fluxos de trabalho de ingestão de dados e lidar com tarefas complexas de roteamento e transformação de dados faz dele uma ferramenta flexível e avançada para as necessidades de ingestão de dados em pequena escala e em nível empresarial.

Amazon Kinesis

O Amazon Kinesis é um serviço nativo da nuvem da AWS especializado em ingestão, processamento e análise de dados de fluxo contínuo. Ele foi projetado para aplicativos que exigem processamento quase em tempo real de fluxos de dados de alto rendimento, como:

- Feeds de vídeo

- Dados de fluxo de cliques

- Dados do sensor de IoT

Um dos benefícios do Kinesis é sua capacidade de integração com outros serviços da AWS para armazenamento, análise e aprendizado de máquina.

Essa ferramenta é particularmente adequada para organizações que utilizam a infraestrutura de nuvem e buscam uma solução totalmente gerenciada para lidar com os requisitos de ingestão de dados sem se preocupar com problemas de hardware ou escalabilidade.

Google Cloud Dataflow

O Google Cloud Dataflow é um serviço totalmente gerenciado fornecido pelo Google Cloud que oferece suporte ao processamento de dados em lote e em tempo real. Ele foi desenvolvido com base no Apache Beam, um modelo de programação unificado de código aberto, e permite que os usuários criem pipelines de dados complexos que podem lidar com processamento em lote em grande escala e dados de streaming em tempo real.

O Dataflow automatiza o gerenciamento e o dimensionamento de recursos, tornando-o ideal para empresas que desejam processar e analisar dados sem o gerenciamento manual da infraestrutura.

Airbyte

A Airbyte é uma plataforma de ingestão de dados de código aberto que simplifica a integração de dados de várias fontes em soluções de armazenamento. Ele oferece conectores pré-construídos para centenas de fontes e destinos de dados e suporta a ingestão em lote e em tempo real.

O interessante do Airbyte é que ele é altamente personalizável, o que permite que os usuários estendam os conectores para atender às suas necessidades. A Airbyte é uma solução flexível para empresas que desejam gerenciar e otimizar os fluxos de trabalho de ingestão de dados. Além disso, ele oferece um serviço de nuvem gerenciado para aqueles que buscam uma solução sem intervenção.

Conclusão

Neste artigo, exploramos os fundamentos da ingestão de dados, seus tipos e as técnicas que a possibilitam. Você aprendeu sobre ingestão em lote e em tempo real e abordagens populares como ETL, ELT e Change Data Capture (CDC). Também abordamos as práticas recomendadas, as várias fontes de dados e os desafios que as organizações enfrentam durante a execução.

Para obter mais insights sobre ferramentas de gerenciamento e ingestão de dados, recomendo que você explore os seguintes recursos:

Torne-se um engenheiro de dados

Perguntas frequentes

Como a ingestão de dados difere da integração de dados?

A ingestão de dados concentra-se na coleta e importação de dados de várias fontes para um sistema centralizado, enquanto a integração de dados combina e harmoniza dados de diferentes fontes para fornecer uma visão unificada. A integração geralmente envolve a transformação de dados para garantir a compatibilidade entre sistemas, o que vai além do escopo da ingestão.

Qual é a diferença entre um pipeline de dados e a ingestão de dados?

A ingestão de dados é um componente de um pipeline de dados. Enquanto a ingestão trata da coleta e da transferência de dados para um sistema de destino, um pipeline de dados abrange todo o processo, incluindo ingestão, transformação, validação e carregamento de dados para uso ou análise posterior.

Qual é a função da governança de dados na ingestão de dados?

A governança de dados garante que os dados ingeridos estejam em conformidade com as políticas organizacionais, os padrões de qualidade e os requisitos regulamentares. Ele define regras para validação de dados, controle de acesso e documentação, ajudando a manter a confiança e a segurança no processo de ingestão.