Kurs

Stell dir vor, du besitzt ein E-Commerce-Unternehmen. Um deine Website zu optimieren und mehr Umsatz zu generieren, kannst du das Kundenverhalten verfolgen. Dazu gehört, dass du jeden Klick, jede Suchanfrage und jeden Kauf verfolgst, was wertvolle Daten liefert.

Die Daten, die du sammelst, sind jedoch über mehrere Systeme verstreut (z. B. Webanalyseplattformen, Transaktionsdatenbanken, Kundensupportprotokolle usw.), was ein großes Problem darstellt.

Um dieses Problem zu entschärfen, sollten alle gesammelten Daten an einem Ort konsolidiert werden, und genau hier kommt die Datenaufnahme ins Spiel.

Durch die Datenaufnahme kannst du all diese Daten in ein zentrales Data Warehouse einspeisen, wodurch du schneller Erkenntnisse in Echtzeit gewinnen und bei Bedarf Analysen durchführen kannst.

In diesem Artikel befassen wir uns mit den Grundlagen der Datenaufnahme und den Techniken, die zur Vereinfachung des Prozesses eingesetzt werden. Du erfährst mehr über Tools, die bei der Dateneingabe helfen, über häufige Herausforderungen und Best Practices zur Optimierung des Prozesses für Skalierbarkeit, Effizienz und Datenqualität.

Lass uns eintauchen!

Was ist Data Ingestion?

Die Datenaufnahme ist der Prozess des Sammelns, Importierens und Ladens von Daten aus verschiedenen Quellen in ein zentrales System (z. B. ein Data Warehouse, einen Data Lake oder eine Cloud-Plattform). Dieser Prozess ermöglicht es dir, Daten aus verschiedenen Systemen zu konsolidieren und sie für die weitere Verarbeitung und Analyse zur Verfügung zu stellen.

Eine effiziente Datenerfassung ist wichtig, weil sie die Grundlage für andere datengesteuerte Vorgänge wie Analysen, Visualisierung und gemeinsame Nutzung bildet.

Arten der Dateneingabe

Technisch gesehen kann die Datenaufnahme in zwei Haupttypen unterteilt werden:

- Batch-Ingestion

- Echtzeit-Ingestion

Jeder Ansatz erfüllt unterschiedliche Bedürfnisse und eignet sich für verschiedene Anwendungsfälle, abhängig von der Geschwindigkeit und dem Volumen der zu verarbeitenden Daten.

Batch-Dateneingabe

Unter Batch-Ingestion versteht man das Sammeln und Verarbeiten von Daten in geplanten Intervallen. Du kannst zum Beispiel stündlich, täglich oder sogar wöchentlich Daten sammeln und verarbeiten. Dieser Ansatz wird in der Regel verwendet, wenn keine sofortigen Erkenntnisse erforderlich sind, und er hilft, große Datenmengen effizient zu verwalten.

Beispiele für Anwendungsfälle der Batch-Ingestion:

- Berichten: Regelmäßiges Sammeln von Daten, um Berichte über die Unternehmensleistung zu erstellen.

- Regelmäßige Datenabgleiche: Synchronisiere die Daten in regelmäßigen Abständen zwischen den Systemen, um sie auf dem neuesten Stand zu halten.

- Analyse der Finanzdaten am Ende des Tages: Aggregieren von Transaktionsdaten zur Analyse der finanziellen Leistung nach Geschäftsschluss.

Datenerfassung in Echtzeit

Bei der Datenerfassung in Echtzeit (oder Streaming) werden die Daten kontinuierlich erfasst und verarbeitet, sobald sie anfallen. Mit dieser Methode erhältst du nahezu sofortige Einblicke, was ideal für Szenarien ist, in denen zeitkritische Entscheidungen getroffen werden müssen.

Beispiele für den Einsatz von Echtzeit-Ingestion:

- Betrugsaufdeckung: Überwachung von Transaktionen in Echtzeit, um verdächtige Aktivitäten zu erkennen und darauf zu reagieren.

- IoT-Sensordatenverarbeitung: Sammeln und Verarbeiten von Daten von angeschlossenen Geräten wie Temperatur- oder Bewegungssensoren in Echtzeit.

- Live-Analyse-Dashboards: Bereitstellung aktueller Daten für Dashboards, die wichtige Leistungsindikatoren (KPIs) und andere Kennzahlen verfolgen.

Wenn du mehr über den Unterschied zwischen Batching und Streaming, die Skalierung von Streaming-Systemen und reale Anwendungen erfahren möchtest, empfehle ich dir denKurs Streaming-Konzepte.

Werde Dateningenieur

Techniken für die Datenerfassung

Verschiedene Techniken erleichtern die Datenerfassung. Jede ist für unterschiedliche Anwendungsfälle und Datenverarbeitungsanforderungen konzipiert.

Für welche Technik du dich entscheidest, hängt von 3 Faktoren ab:

- Die spezifischen Anforderungen des Unternehmens.

- Die Komplexität der Daten.

- Die Infrastruktur ist vorhanden.

In diesem Abschnitt gehe ich auf drei Dateneingabeverfahren ein und zeige, wann sie am effektivsten sind.

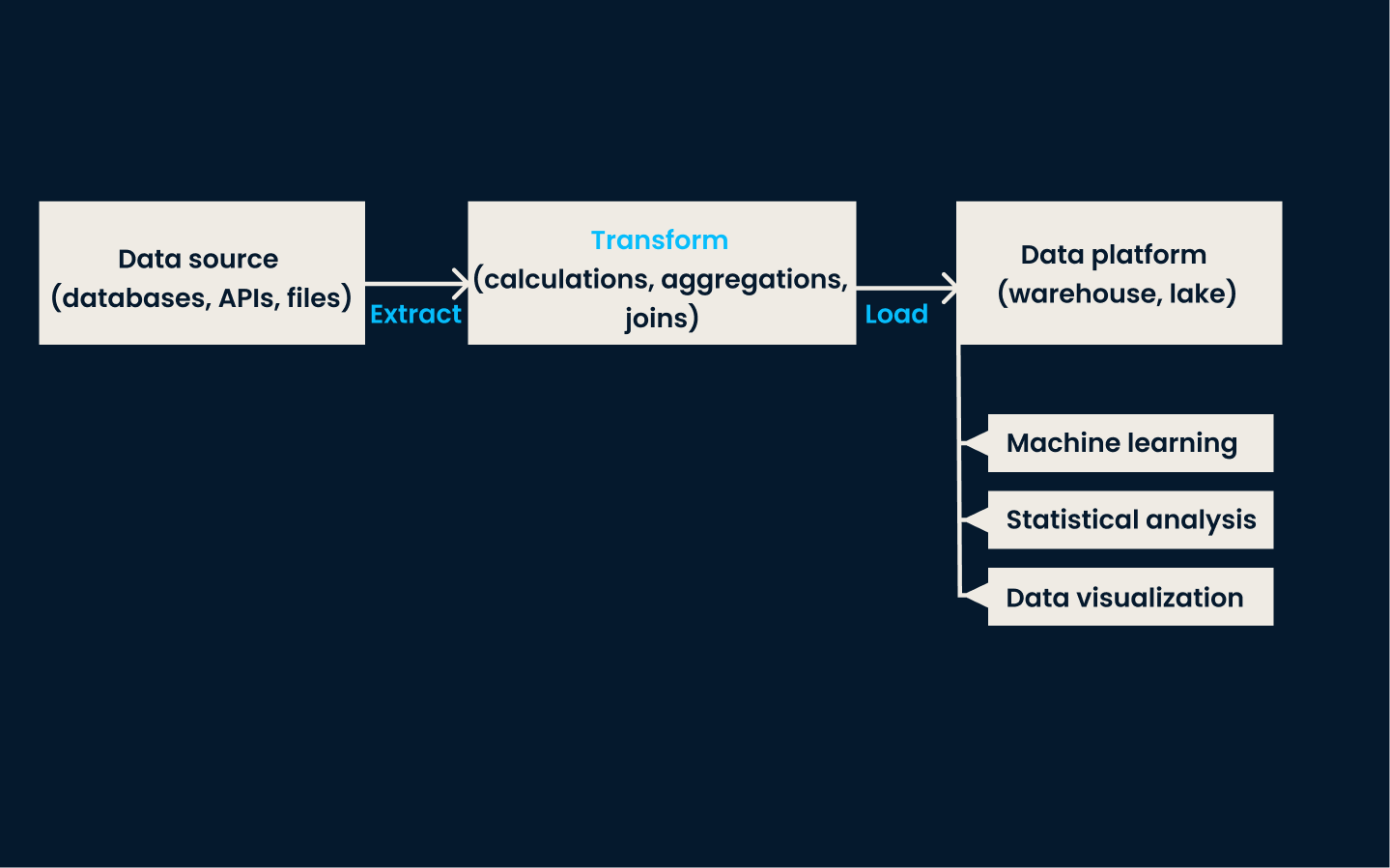

ETL (Extrahieren, Transformieren, Laden)

ETL ist eine traditionelle und weit verbreitete Technik zur Dateneingabe. Bei diesem Ansatz werden die Daten aus verschiedenen Quellsystemen extrahiert, in ein konsistentes und sauberes Format umgewandelt und schließlich in ein Datenspeichersystem, wie z.B. ein Data Warehouse ,geladen.

Diese Methode ist sehr effektiv für Anwendungsfälle, die konsistente, strukturierte Daten für Berichte, Analysen und Entscheidungen benötigen.

Wann du ETL verwenden solltest:

- Wenn Daten vorverarbeitet (bereinigt oder umgewandelt) werden müssen, bevor sie in das Speichersystem geladen werden.

- Szenarien, in denen strukturierte Daten Priorität haben, z. B. bei der Erstellung von Geschäftsberichten oder bei der Einhaltung strenger Datenqualitätsanforderungen.

- Wenn du mit relationalen Datenbanken oder kleineren Datenumgebungen arbeitest, bei denen saubere, auswertbare Daten im Vordergrund stehen.

ETL-Pipeline-Architektur.

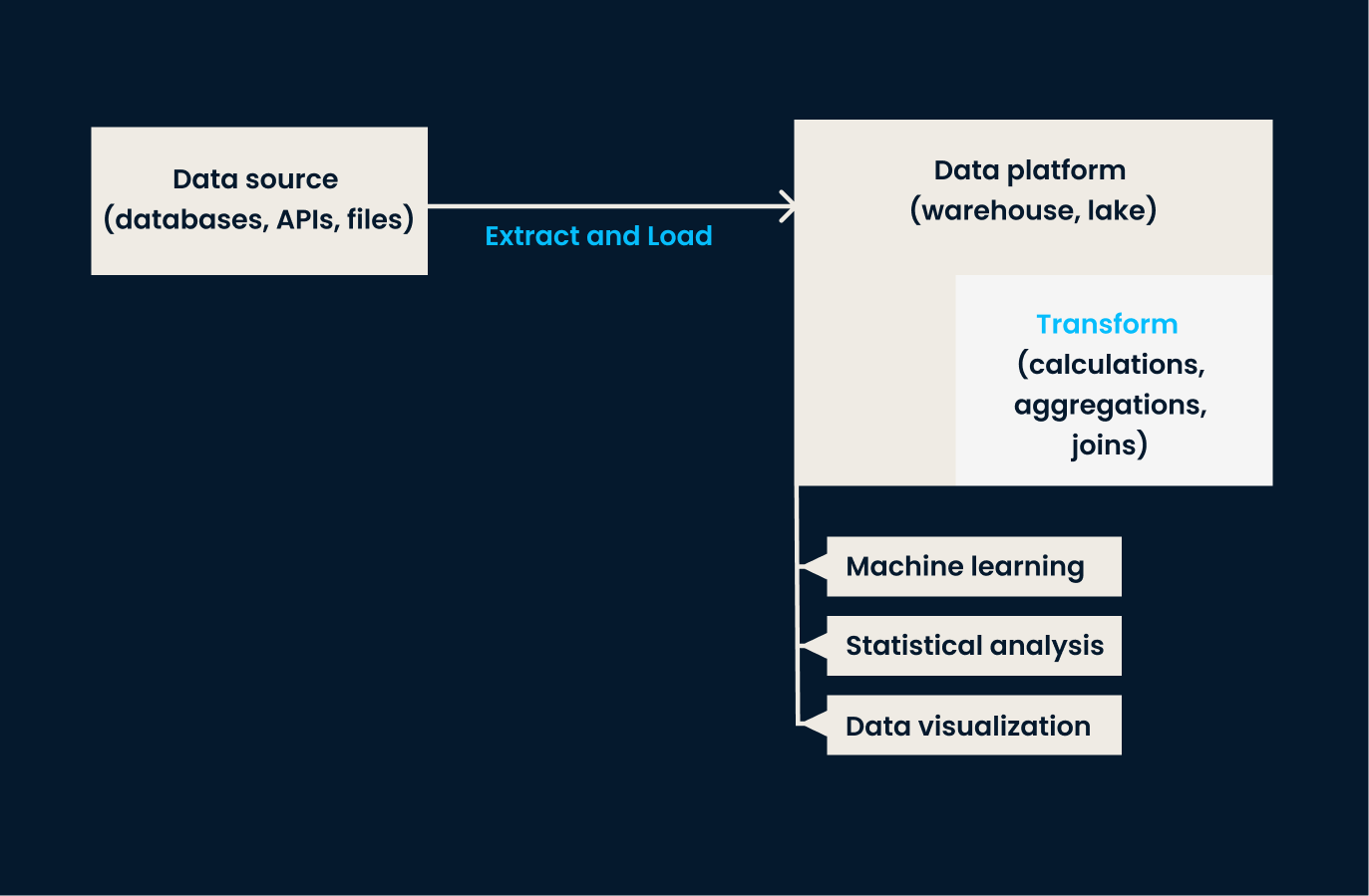

ELT (Extrahieren, Laden, Transformieren)

ELT kehrt die Reihenfolge der Vorgänge im Vergleich zu ETL um. Bei diesem Ansatz werden die Daten aus den Quellsystemen extrahiert und direkt in das Zielsystem (in der Regel ein Data Lake oder eine cloudbasierte Plattform)geladen . Sobald die Daten im Zielspeichersystem sind, werden sie nach Bedarf umgewandelt , oft innerhalb der Zielumgebung .

Der ELT-Ansatz ist besonders effektiv, wenn es um große Mengen unstrukturierter oder halbstrukturierter Daten geht, bei denen die Transformation aufgeschoben werden kann, bis die Analyse erforderlich ist.

Wann du ELT einsetzen solltest:

- Bei der Arbeit mit Data Lakes oder Cloud-Speichern, die Rohdaten in großem Umfang verarbeiten können.

- Beim Umgang mit vielfältigen, unstrukturierten oder halbstrukturierten Daten, die nicht sofort umgewandelt werden müssen.

- Wenn Flexibilität gefragt ist, denn mit ELT können Datenumwandlungen bei Bedarf in der Speicherumgebung durchgeführt werden.

ELT-Pipeline-Architektur.

Datenerfassung ändern (CDC)

CDC ist eine Technik zur Identifizierung und Erfassung von Änderungen (z. B. Einfügungen, Aktualisierungen, Löschungen) an Daten in den Quellsystemen und zur anschließenden Replikation dieser Änderungen in Echtzeit in die Zielsysteme.

Diese Technik sorgt dafür, dass die Zielsysteme immer auf dem neuesten Stand sind, ohne dass der gesamte Datensatz neu geladen werden muss. CDC ist sehr effektiv, um die Echtzeitsynchronisation zwischen Datenbanken aufrechtzuerhalten und die Konsistenz zwischen Systemen zu gewährleisten.

Wann du die CDC verwenden solltest:

- Wenn die Synchronisierung von Daten in Echtzeit entscheidend ist, wie z.B. beim Hochfrequenzhandel, bei E-Commerce-Transaktionen oder bei der betrieblichen Berichterstattung.

- Wenn du deine Zielsysteme mit minimalen Verzögerungen oder Datenaktualisierungszeiten auf dem neuesten Stand halten musst.

- Wenn es notwendig ist, den Aufwand zu vermeiden, der durch das erneute Einlesen ganzer Datensätze entsteht.

Datenquellen für die Ingestion

Wir haben festgestellt, dass die Datenerfassung das Abrufen von Informationen aus verschiedenen Quellen beinhaltet. Aber wir haben noch nicht darüber gesprochen, was diese Strukturen sind - und das werden wir in diesem Abschnitt tun.

Die Datenquellen für die Ingestion lassen sich im Allgemeinen in 3 Haupttypen einteilen:

- Strukturiert

- Halbstrukturiert

- Unstrukturierte Daten

Wie du bei der Betrachtung der verschiedenen Quellen erfahren wirst, erfordert jede von ihnen unterschiedliche Handhabungs- und Verarbeitungstechniken, um effektiv genutzt werden zu können.

Strukturierte Datenquellen

Strukturierte Daten sind hochgradig organisiert und folgen einem vordefinierten Schema, wodurch sie leichter zu verarbeiten und zu analysieren sind. Sie werden in der Regel in relationalen Datenbanken gespeichert, die zusammenhängende Datenpunkte speichern und den Zugriff darauf ermöglichen. Die Daten werden in Tabellen mit klar definierten Zeilen und Spalten angeordnet.

Aufgrund dieser organisierten Natur sind strukturierte Daten am einfachsten zu erfassen.

Herkömmliche Tools wie MySQL und PostgreSQL werden in der Regel für die Verarbeitung strukturierter Daten verwendet. Diese SQL-basierten Tools vereinfachen den Validierungsprozess während der Ingestion, indem sie strenge Schemaregeln durchsetzen. Wenn die Daten in diese Systeme eingespeist werden,stellen sieautomatisch sicher, dass sie der in den Tabellen der Datenbank festgelegten Struktur entsprechen.

Wenn eine Spalte zum Beispiel so eingestellt ist, dass sie nur Integer-Werte akzeptiert, lehnt MySQL oder PostgreSQL alle Daten ab, die diese Anforderung nicht erfüllen.

Andere Dinge, die du über strukturierte Daten wissen solltest, sind:

- Sie werden normalerweise in großen Mengen (und in einem vorhersehbaren Format) gesammelt.

- Sie werden oft durch Batch-Prozesse eingelesen, die regelmäßige Aktualisierungen ermöglichen, um die Daten bei Bedarf aufzufrischen.

Semi-strukturierte Datenquellen

Halbstrukturierte Daten sind zwar bis zu einem gewissen Grad organisiert, entsprechen aber nicht einem starren, vordefinierten Schema wie strukturierte Daten. Stattdessen werden Tags oder Markierungen verwendet, um eine gewisse Ordnung zu schaffen, aber die Struktur bleibt flexibel.

Dieser Datentyp ist typischerweisein Formaten wie JSON-Dateien, CSV-Dateien und NoSQL-Datenbanken zu finden und wird häufig in Webanwendungen, APIs und Protokollsystemen verwendet.

Da die Struktur variieren kann,bieten halbstrukturierteDaten Flexibilität bei der Speicherung und Verarbeitung und eignen sich daher für Systeme, die mit sich verändernden oder inkonsistenten Datenformaten arbeiten.

Der Umgang mit halbstrukturierten Daten erfordert Werkzeuge, um die eingebetteten Tags oder Markierungen zu analysieren und sinnvolle Informationen daraus zu extrahieren. Eine JSON-Datei kann z. B. eine Sammlung von Schlüssel-Wert-Paaren enthalten, die beim Ingestion-Prozess geparst und in ein geeignetes Format umgewandelt werden müssen.

Halbstrukturierte Daten werden oft in flexible Umgebungen wie Data Lakes oder Cloud-Plattformen eingespeist, wo sie in ihrer Rohform gespeichert und später nach Bedarf verarbeitet werden können.

Andere Dinge, die du bei halbstrukturierten Daten beachten solltest, sind:

- Je nach Anwendungsfall können die Daten in Echtzeit oder über geplante Batches eingespeist werden.

- Sie müssen während der Aufnahme umgewandelt werden, damit sie effektiv verarbeitet oder analysiert werden können.

Unstrukturierte Datenquellen

Unstrukturierte Daten sind am kompliziertesten zu verwalten, weil sie kein bestimmtes Format und keine Organisationsstruktur haben. Zu dieser Kategorie gehören Daten wie:

- Bilder

- Videos

- Audio

- Dokumente

Im Gegensatz zu strukturierten oder halbstrukturierten Daten haben unstrukturierte Daten keine klaren Zeilen, Spalten oder Tags, um ihren Inhalt zu definieren, was ihre Verarbeitung und Analyse erschwert.

Trotz ihrer Komplexität können unstrukturierte Daten wertvolle Erkenntnisse liefern, insbesondere wenn sie mit fortschrittlichen Technologien wie maschinellem Lernen oder natürlicher Sprachverarbeitung analysiert werden.

Da unstrukturierte Daten nicht in einer vordefinierten Weise organisiert sind, werden spezielle Tools benötigt, um den Ingestionsprozess zu bewältigen. Diese Tools können relevante Informationen aus rohen, unstrukturierten Quellen extrahieren und in Formate umwandeln, die analysiert werden können.

Schließlich werden unstrukturierte Daten in der Regel in Data Lakes gespeichert, wo sie nach Bedarf verarbeitet werden können.

Vergleichstabelle: Strukturiert vs. Semi-Structured vs. Unstrukturierte Daten

|

Feature |

Strukturierte Daten |

Semi-strukturierte Daten |

Unstrukturierte Daten |

|

Definition |

Gut organisierte Daten mit einem vordefinierten Schema (z. B. Zeilen und Spalten). |

Teilweise organisierte Daten mit Tags oder Markierungen für Flexibilität (z. B. JSON, CSV). |

Daten ohne vordefinierte Struktur oder Organisation (z. B. Bilder, Videos). |

|

Beispiele |

Relationale Datenbanken wie MySQL, PostgreSQL. |

JSON-Dateien, NoSQL-Datenbanken, CSV-Protokolle. |

Bilder, Videos, Audiodateien, Textdokumente. |

|

Leichte Verarbeitung |

Am einfachsten zu verarbeiten aufgrund des strengen Schemas. |

Mittlerer Schwierigkeitsgrad; erfordert Parsing und Transformation. |

Die größte Herausforderung aufgrund der fehlenden Struktur. |

|

Lagerung |

Relationale Datenbanken oder Data Warehouses. |

Data Lakes, NoSQL-Datenbanken, Cloud-Speicher. |

Data Lakes oder spezielle Speicher für Rohdaten. |

|

Ansatz der Einnahme |

Wird in der Regel in Schüben eingenommen. |

Flexibel; kann in Echtzeit oder in Stapeln aufgenommen werden. |

In erster Linie im Rohformat für die spätere Verarbeitung aufgenommen. |

|

Verwendete Werkzeuge |

SQL-basierte Tools wie MySQL, PostgreSQL. |

Tools, die flexible Schemata verarbeiten, wie MongoDB, Google BigQuery. |

Fortgeschrittene Tools wie Hadoop, Apache Spark oder KI/ML-basierte Verarbeitungstools. |

|

Beispiele für Anwendungsfälle |

Erstellen von Berichten, Transaktionssysteme. |

API-Antworten, Webanwendungsprotokolle. |

Bilderkennung, Sprachanalyse, Stimmungsanalyse. |

Herausforderungen bei der Dateneingabe

Die Datenerfassung bringt einige Herausforderungen mit sich, die du bewältigen musst, um ein effizientes und effektives Datenmanagement zu gewährleisten. In diesem Abschnitt werden wir erörtern, was diese Herausforderungen sind und welche Lösungen es gibt, um sie zu überwinden.

Umgang mit großen Datenmengen

Eine der größten Herausforderungen bei der Datenerfassung ist die schiere Menge an Daten, die verarbeitet werden muss. Wenn Unternehmen wachsen, kann die Menge der von ihnen erzeugten und gesammelten Daten exponentiell ansteigen, insbesondere mit dem Anstieg von Echtzeit-Datenströmen aus Quellen wie IoT-Geräten und Social-Media-Plattformen.

Die Skalierung von Datenerfassungsprozessen zur Bewältigung dieser wachsenden Mengen kann schwierig sein, insbesondere bei Streaming-Daten, die eine kontinuierliche Erfassung erfordern.

Die Teams müssen sicherstellen, dass ihre Infrastruktur die Aufnahme von Batch- und Echtzeitdaten in großem Umfangohne Beeinträchtigung unterstützt. Der Kurs "Streaming Concepts " ist ein toller Einstieg für dich.

Datenqualität und -konsistenz

Datenqualität und -konsistenz sind eine weitere große Herausforderung, vor allem, wenn die Daten aus mehreren unterschiedlichen Quellen stammen. Jede Quelle kann unterschiedliche Formate, Vollständigkeitsgrade oder sogar widersprüchliche Informationen enthalten.

Das Einlesen von Daten, ohne diese Unstimmigkeiten zu beseitigen, kann zu ungenauen oder unvollständigen Datensätzen führen, die sich schließlich auf nachgelagerte Analysen auswirken.

Während der Dateneingabe müssen Datenvalidierungsprüfungen durchgeführt werden, um sicherzustellen, dass nur qualitativ hochwertige Daten in das System gelangen. Außerdem müssen die Teams die Konsistenz zwischen den verschiedenen Quellen wahren, um Datendiskrepanzen zu vermeiden.

Ich empfehle, mit dem ausgezeichneten Kurs Einführung in die Datenqualität in dieses Thema einzutauchen .

Sicherheit und Compliance

Wenn sensible Daten erfasst werden, haben Sicherheit und Compliance höchste Priorität. Teams, die personenbezogene Daten verarbeiten (z. B. Kundennamen, Adressen, Zahlungsdaten usw.), müssen diese Daten während des gesamten Erfassungsprozesses schützen.

Ein Finanzdienstleistungsunternehmen muss zum Beispiel strenge Vorschriften wie GDPR oder HIPAA einhalten, wenn es Kundendaten erfasst, um rechtliche Konsequenzen zu vermeiden. Werden die Daten während der Erfassung nicht gesichert, kann es zu Datenschutzverletzungen kommen, die das Vertrauen der Kunden gefährden und zu erheblichen finanziellen Strafen führen.

Um dies zu verhindern, sollten die Teams Verschlüsselung und sichere Zugangskontrollen während des Ingestionsprozesses einführen. So wird sichergestellt, dass sensible Daten vor unbefugtem Zugriff geschützt sind. Darüber hinaus müssen die Daten in einer Art und Weise erfasst werden, die denll relevanten gesetzlichen Standards entspricht, und es müssen regelmäßige Audits durchgeführt werden, um die Einhaltung dieser Standards zu überprüfen.

Entdecke mit dem interaktiven Kurs "Datensicherheit ", wie du deine Daten schützen kannst.

Anforderungen an die Latenzzeit

In Szenarien, in denen sofortige Erkenntnisse benötigt werden, können Verzögerungen bei der Datenaufnahme zu veralteten oder irrelevanten Informationen führen. Die Datenaufnahme mit niedriger Latenzzeit erfordert die Fähigkeit, Daten fast sofort zu verarbeiten und für die Analyse bereitzustellen, was bei großen Datenmengen eine Herausforderung sein kann.

Die Teams müssen ihre Systeme sorgfältig optimieren, um die Latenzzeit zu verringern und sicherzustellen, dass die Daten verfügbar sind, wenn sie gebraucht werden.

Best Practices für die Dateneingabe

Es gibt ein paar Best Practices, um eine effiziente und effektive Dateneingabe zu gewährleisten.

Datenqualität priorisieren

Die erfassten Daten werden für Analysen, Berichte und Entscheidungsfindungen verwendet und müssen daher vordefinierte Standards für Genauigkeit und Vollständigkeit erfüllen.

Durch die Implementierung von Datenvalidierungsprüfungen während der Dateneingabe kann sichergestellt werden, dass die Daten den erwarteten Formaten und Qualitätsstandards entsprechen. Ich habee schon einmal darüber geschrieben, in einem Tutorial über Große Erwartungen.

Wenn zum Beispiel erwartet wird, dass die Daten in einem bestimmten Bereich liegen oder bestimmte Kriterien erfüllen, verwende Validierungsregeln, um alle Daten, die diesen Standards nicht entsprechen, automatisch abzulehnen oder zu kennzeichnen. So werden Fehler minimiert und sichergestellt, dass nur zuverlässige Daten weiterverarbeitet werden.

Wähle den richtigen Ansatz für die Einnahme

Eine weitere Best Practice ist die Auswahl des richtigen Ingestion-Ansatzes für die Bedürfnisse deines Unternehmens.

Die Batch-Ingestion wird in der Regel für weniger zeitkritische Daten verwendet, z. B. für historische oder periodische Berichte. Im Gegensatz dazu wird Echtzeit-Ingestion für Anwendungen verwendet, die sofortigen Zugriff auf die neuesten Daten benötigen, wie z. B. Betrugserkennung oder IoT-Überwachung.

Beurteile deinen Bedarf anhand der Häufigkeit und Dringlichkeit von Datenaktualisierungen.

Skalierbarkeit sicherstellen

Dein Datenvolumen wird mit der Zeit wachsen. Daher ist es wichtig, skalierbare Tools und Infrastrukturen zu wählen, um wachsende Datenmengen ohne Leistungseinbußen zu bewältigen. So kannst du deine Datenpipelines und Verarbeitungskapazitäten erweitern, um zukünftiges Wachstum zu ermöglichen.

Datenkompression verwenden

Weniger benötigter Speicherplatz bedeutet geringere Infrastrukturkosten. Die Komprimierung beschleunigt auch die Datenübertragung, was bedeutet, dass der Ingest schneller geht - vor allem bei großen Datensätzen oder großen Datenströmen. Diese Praxis ist vor allem bei halbstrukturierten oder unstrukturierten Daten von Vorteil, da diese oft sehr groß sind.

Tools zur Datenerfassung

Wie du siehst, ist die Datenübernahme ein einfaches Konzept, aber es kann ziemlich schwierig sein, es selbst umzusetzen. Welches sind die besten Tools, die dir bei der Datenerfassung helfen? Ich habe eine Liste der am häufigsten genutzten Methoden zusammengestellt.

Apache Kafka

Apache Kafka ist eine verteilte Streaming-Plattform, die sich hervorragend für die Aufnahme von Daten in Echtzeit eignet. Sie ist für die Verarbeitung von Datenströmen mit hohem Durchsatz und niedriger Latenz konzipiert und eignet sich daher ideal für Anwendungsfälle, die einen sofortigen Zugriff auf große Mengen kontinuierlich generierter Daten erfordern.

Ein großer Vorteil von Kafka ist, dass es Unternehmen ermöglicht, Streaming-Daten in Echtzeit zu verarbeiten, zu speichern und an verschiedene Systeme weiterzuleiten. Sie wird häufig in Szenarien wie Betrugserkennung, IoT-Datenverarbeitung und Echtzeitanalysen eingesetzt.

Im Kurs "Einführung in Kafka " lernst du,wie du Kafka erstellst, verwaltest und für reale Herausforderungen des Datenstroms einsetzt.

Apache Nifi

Apache Nifi ist ein Tool zur Dateneingabe, das für seine benutzerfreundliche visuelle Oberfläche bekannt ist. Die leicht zugängliche Oberfläche ermöglicht es Unternehmen, Datenflüsse per Drag-and-Drop zu entwerfen, zu überwachen und zu verwalten.

Nifi unterstützt viele Datenquellen - einschließlich Batch- und Echtzeitdaten - und kann mit Systemen wie Hadoop, relationalen Datenbanken und NoSQL-Speichern integriert werden. Seine Fähigkeit, Arbeitsabläufe zur Dateneingabe zu automatisieren und komplexe Datenweiterleitungs- und -umwandlungsaufgaben zu bewältigen, macht es zu einem flexiblen und leistungsstarken Tool für die Dateneingabe in kleinem Umfang und auf Unternehmensebene.

Amazon Kinesis

Amazon Kinesis ist ein Cloud-nativer Service von AWS, der sich auf das Aufnehmen, Verarbeiten und Analysieren von Streaming-Daten spezialisiert hat. Sie wurde für Anwendungen entwickelt, die die Verarbeitung von Datenströmen mit hohem Durchsatz in nahezu Echtzeit erfordern, wie z. B:

- Video-Feeds

- Clickstream-Daten

- IoT-Sensordaten

Einer der Vorteile von Kinesis ist die Möglichkeit, es mit anderen AWS-Diensten für Speicherung, Analyse und maschinelles Lernen zu integrieren.

Dieses Tool eignet sich besonders gut für Unternehmen, die eine Cloud-Infrastruktur nutzen und eine vollständig verwaltete Lösung für ihre Datenerfassungsanforderungen suchen, ohne sich um Hardware- oder Skalierbarkeitsprobleme kümmern zu müssen.

Google Cloud Dataflow

Google Cloud Dataflow ist ein vollständig verwalteter Dienst von Google Cloud, der sowohl Batch- als auch Echtzeit-Datenverarbeitung unterstützt. Es basiert auf Apache Beam, einem einheitlichen Open-Source-Programmiermodell, und ermöglicht es den Nutzern, komplexe Datenpipelines zu entwerfen, die sowohl große Stapelverarbeitungen als auch Echtzeit-Datenströme verarbeiten können.

Dataflow automatisiert das Ressourcenmanagement und die Skalierung und ist damit ideal für Unternehmen, die Daten ohne manuelles Infrastrukturmanagement verarbeiten und analysieren wollen.

Airbyte

Airbyte ist eine Open-Source-Plattform zur Datenaufnahme, die die Integration von Daten aus verschiedenen Quellen in Speicherlösungen vereinfacht. Es bietet vorgefertigte Konnektoren für Hunderte von Datenquellen und -zielen und unterstützt Batch- und Echtzeit-Ingestion.

Das Tolle an Airbyte ist, dass es sehr anpassungsfähig ist - so können die Nutzer die Anschlüsse nach ihren Bedürfnissen erweitern. Airbyte ist eine flexible Lösung für Unternehmen, die ihre Dateneingabe-Workflows verwalten und rationalisieren wollen. Außerdem bietet das Unternehmen einen Managed Cloud Service für diejenigen, die eine "hands-off"-Lösung suchen.

Fazit

In diesem Artikel haben wir die Grundlagen der Datenerfassung, ihre Arten und die Techniken, die sie ermöglichen, untersucht. Du hast etwas über Batch- und Echtzeit-Ingestion und beliebte Ansätze wie ETL, ELT und Change Data Capture (CDC) gelernt. Wir haben uns auch mit den besten Praktiken, den verschiedenen Datenquellen und den Herausforderungen beschäftigt, mit denen Unternehmen bei der Durchführung konfrontiert sind.

Wenn du mehr über Datenmanagement und Ingestion-Tools erfahren möchtest, empfehle ich dir die folgenden Ressourcen:

Werde Dateningenieur

FAQs

Wie unterscheidet sich die Datenübernahme von der Datenintegration?

Die Datenaufnahme konzentriert sich auf das Sammeln und Importieren von Daten aus verschiedenen Quellen in ein zentrales System, während die Datenintegration Daten aus verschiedenen Quellen kombiniert und harmonisiert, um eine einheitliche Sicht zu ermöglichen. Bei der Integration müssen die Daten oft umgewandelt werden, um die Kompatibilität zwischen den Systemen zu gewährleisten, was über den Umfang der Aufnahme hinausgeht.

Was ist der Unterschied zwischen einer Datenpipeline und einem Dateningestion?

Die Datenaufnahme ist eine Komponente einer Datenpipeline. Während es beim Ingestion um das Sammeln und Übertragen von Daten in ein Zielsystem geht, umfasst eine Datenpipeline den gesamten Prozess, einschließlich Ingestion, Transformation, Validierung und Laden von Daten zur weiteren Verwendung oder Analyse.

Welche Rolle spielt Data Governance bei der Datenübernahme?

Data Governance stellt sicher, dass die eingegebenen Daten mit den Unternehmensrichtlinien, Qualitätsstandards und gesetzlichen Vorschriften übereinstimmen. Sie definiert Regeln für die Datenvalidierung, die Zugriffskontrolle und die Dokumentation und trägt so dazu bei, das Vertrauen und die Sicherheit im Ingestion-Prozess zu erhalten.