Curso

A criação de uma arquitetura sólida de data warehouse é crucial para que você possa lidar com conjuntos de dados grandes e complexos. Como os dados continuam a crescer, as empresas precisam de uma abordagem estruturada para armazenar, gerenciar e analisar as informações com eficiência.

Sem a arquitetura correta, você pode se deparar com consultas lentas, dados inconsistentes e desafios que tornam a tomada de decisões mais complicada do que deveria.

Neste post, apresentarei os principais componentes de um data warehouse, os diferentes tipos de arquitetura e as práticas recomendadas para ajudar você a projetar um sistema que seja escalável e eficiente. Se você estiver configurando um novo data warehouse ou otimizando um já existente, a compreensão desses princípios o preparará para o sucesso.

Componentes de uma arquitetura de data warehouse

Um data warehouse bem projetado é construído com base em uma série de componentes interconectados. Esses componentes trabalham juntos para processar dados de várias fontes, transformá-los para análise e disponibilizá-los aos usuários em um formato estruturado. Abaixo, exploramos os blocos de construção essenciais de uma arquitetura de data warehouse.

Fontes de dados

Um data warehouse coleta informações de várias fontes, incluindo dados estruturados de bancos de dados relacionais e dados não estruturados, como logs ou arquivos de texto. As fontes de dados comuns incluem:

- Bancos de dados transacionais (por exemplo, MySQL, PostgreSQL)

- Armazenamento em nuvem (por exemplo, Amazon S3,Google Cloud Storage)

- APIs externas (por exemplo, serviços de terceiros, aplicativos da Web)

Ao integrar essas diversas fontes em um único sistema, as empresas obtêm uma visão completa e unificada de suas operações.

Camada ETL

O processo de ETL (ou ELT) é um componente-chave da arquitetura do warehouse de dados. Isso envolve:

- Extração de dados brutos de várias fontes

- Transformando por meio de limpeza, formatação e estruturação

- Carregamento no data warehouse para análise

No ETL, os dados são transformados antes do carregamento, enquanto no ELT, os dados brutos são carregados primeiro e depois transformados dentro do warehouse. O ELT costuma ser preferido para os modernos warehouses baseados em nuvem devido às suas vantagens de escalabilidade e desempenho.

Área de preparação

A área de preparação é um espaço de armazenamento opcional e temporário onde os dados brutos são mantidos antes de serem processados e carregados no data warehouse. Essa camada atua como um buffer para permitir que as transformações de dados ocorram sem afetar diretamente o armazenamento principal de dados.

Camada de armazenamento de dados

No centro do data warehouse está a camada de armazenamento, onde os dados são organizados em tabelas de fatos e dimensões:

- Tabelas de fatos armazenam dados quantitativos (por exemplo, números de vendas)

- Tabelas de dimensão armazenam informações descritivas (por exemplo, detalhes de clientes ou produtos).

Normalmente, os dados são organizados em um esquema em estrela ou Snowflake para otimizá-los para o desempenho e a análise de consultas.

Camada de metadados

A camada de metadados gerenciae mantém a estrutura e os relacionamentos dentro do warehouse de dados. Em sua essência, os metadados fornecem informações sobre fontes de dados, esquemas e transformações. Isso permite que os usuários e os sistemas entendam o contexto,a linhagem e o uso dos dadosno warehouse.

Acesso aos dados e camada de análise

Essa camada permite que os usuários recuperem e analisem os dados do warehouse. Em geral, inclui:

- Ferramentas de business intelligence (BI) - Painéis, relatórios e visualizações (por exemplo, Tableau, Power BI)

- Acesso direto - Consultas SQL ou APIs para recuperação de dados

- Análise avançada - modelos de machine learning, análise preditiva e relatórios detalhados

Embora os relatórios e painéis básicos se enquadrem no acesso tradicional aos dados, os fluxos de trabalho mais complexos de machine learning e análise preditiva às vezes são categorizados separadamente como uma camada de análise devido às suas necessidades computacionais avançadas.

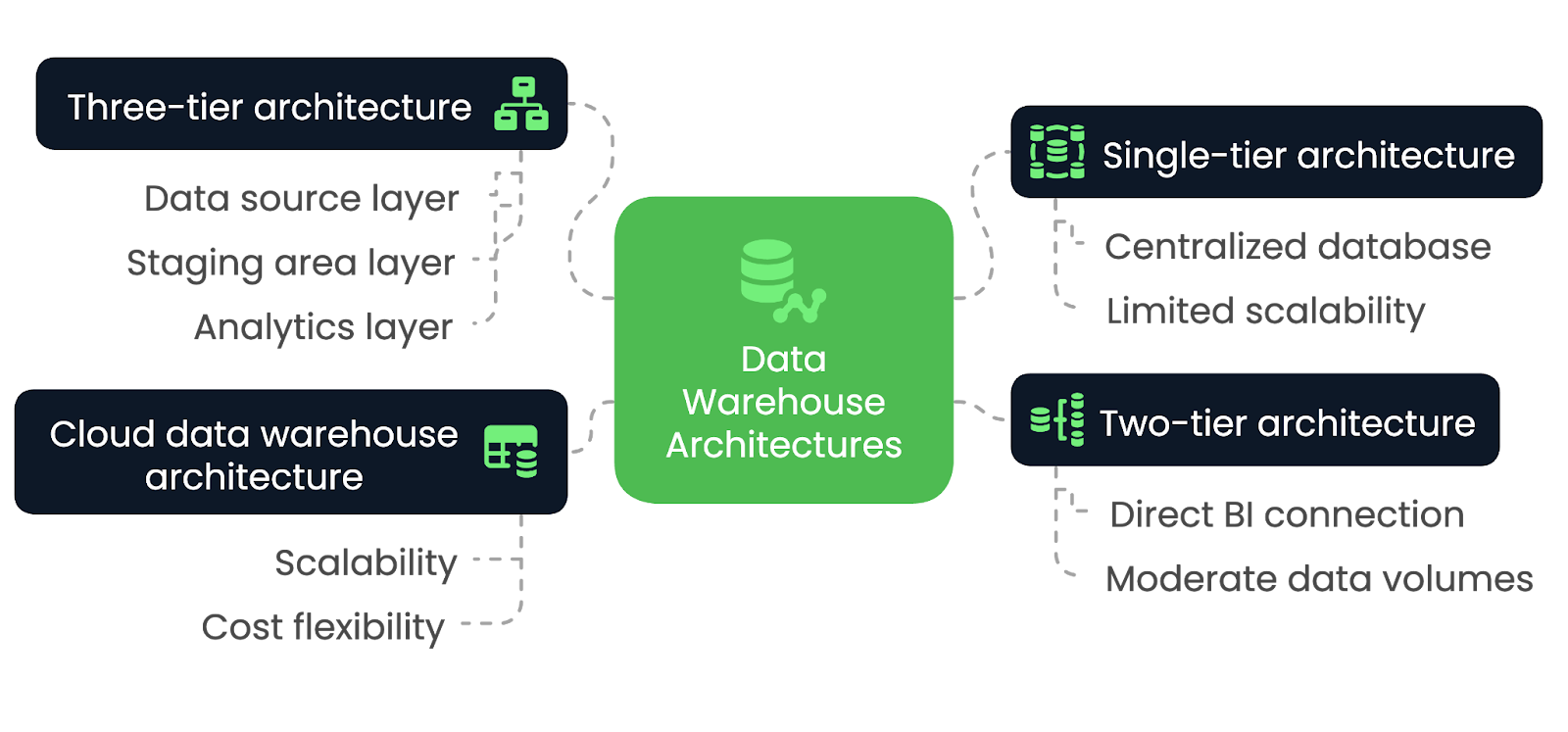

Tipos de arquitetura de data warehouse

A escolha da arquitetura correta de data warehouse é essencial para que você atenda às necessidades de desempenho, escalabilidade e integração da sua organização. No entanto, diferentes arquiteturas oferecem vantagens e compensações exclusivas, dependendo de vários fatores. Vamos explorá-las nesta seção.

Arquitetura de camada única

Em uma arquitetura de camada única, o data warehouse é construído em um banco de dados único e centralizado que consolida todos os dados de várias fontes em um único sistema. Essa arquitetura minimiza o número de camadas e simplifica o design geral, levando a um processamento e acesso mais rápidos aos dados. No entanto, ela não tem a flexibilidade e a modularidade encontradas em arquiteturas mais complexas.

A arquitetura de camada única é mais adequada para aplicativos de pequena escala e organizações com necessidades limitadas de processamento de dados. É ideal para empresas que priorizam a simplicidade e a implementação rápida em detrimento da escalabilidade. No entanto, à medida que o volume de dados aumenta ou que são necessárias análises mais avançadas, essa arquitetura pode ter dificuldades para atender a essas demandas de forma eficaz.

Arquitetura de duas camadas

Em uma arquitetura de duas camadas, o warehouse de dados se conecta diretamente às ferramentas de BI, geralmente por meio deum sistema OLAP. Embora essa abordagem forneça acesso mais rápido aos dados para análise, ela pode enfrentar desafios ao lidar com volumes de dados maiores, pois o dimensionamento se torna difícil devido à conexão direta entre o warehouse e as ferramentas de BI.

A arquitetura de duas camadas é mais adequada para organizações de pequeno e médio porte que precisam de acesso mais rápido aos dados para análise, mas não precisam da escalabilidade de arquiteturas maiores e mais complexas. É ideal para empresas com volumes de dados moderados e necessidades relativamente simples de relatórios ou análises, pois permite a integração direta entre o data warehouse e as ferramentas de business intelligence.

No entanto, à medida que os dados crescem ou os requisitos analíticos se tornam mais sofisticados, essa arquitetura pode ter dificuldades para dimensionar e lidar com o aumento das cargas de trabalho de forma eficiente.

Arquitetura de três camadas

A arquitetura de três camadas é o modelo mais comum e amplamente usado para data warehouses. Ele separa o sistema em camadas distintas: a camada de fonte de dados, a camada de área de preparação e a camada de análise. Essa separação permite processos eficientes de ETL, seguidos de análises e relatórios.

A arquitetura de três camadas é ideal para ambientes corporativos de grande escala que exigem escalabilidade, flexibilidade e capacidade de lidar com grandes volumes de dados. Ele permite que as empresas gerenciem os dados com mais eficiência e oferece suporte a análises avançadas, machine learning e relatórios em tempo real. A separação de camadas melhora o desempenho, tornando-o adequado para ambientes de dados complexos.

Arquitetura de data warehouse em nuvem

Na arquitetura de data warehouse em nuvem, toda a infraestrutura é hospedada em plataformas como Amazon Redshift, Google BigQuery ou Snowflake. As arquiteturas baseadas em nuvem oferecem escalabilidade praticamente ilimitada, com a capacidade de lidar com grandes conjuntos de dados sem a necessidade de hardware no local. Eles também oferecem flexibilidade de custo por meio de modelos de pagamento conforme o uso, o que os torna acessíveis a uma gama mais ampla de empresas.

A arquitetura de data warehouse em nuvem é ideal para organizações de todos os tamanhos. É ideal para empresas que buscam uma solução flexível e dimensionável, pois essa abordagem permite que as empresas dimensionem dinamicamente os recursos de armazenamento e computação.

Arquiteturas de data warehouse comparadas - imagem por autor.

Padrões de projeto de arquitetura de data warehouse

Existem vários padrões de design de data warehouse, mas cada um atende a diferentes necessidades, dependendo da complexidade dos dados e dos tipos de consultas que estão sendo executadas. Vamos explorar alguns dos mais comuns e decifrar os cenários mais apropriados para usá-los com o máximo de eficiência.

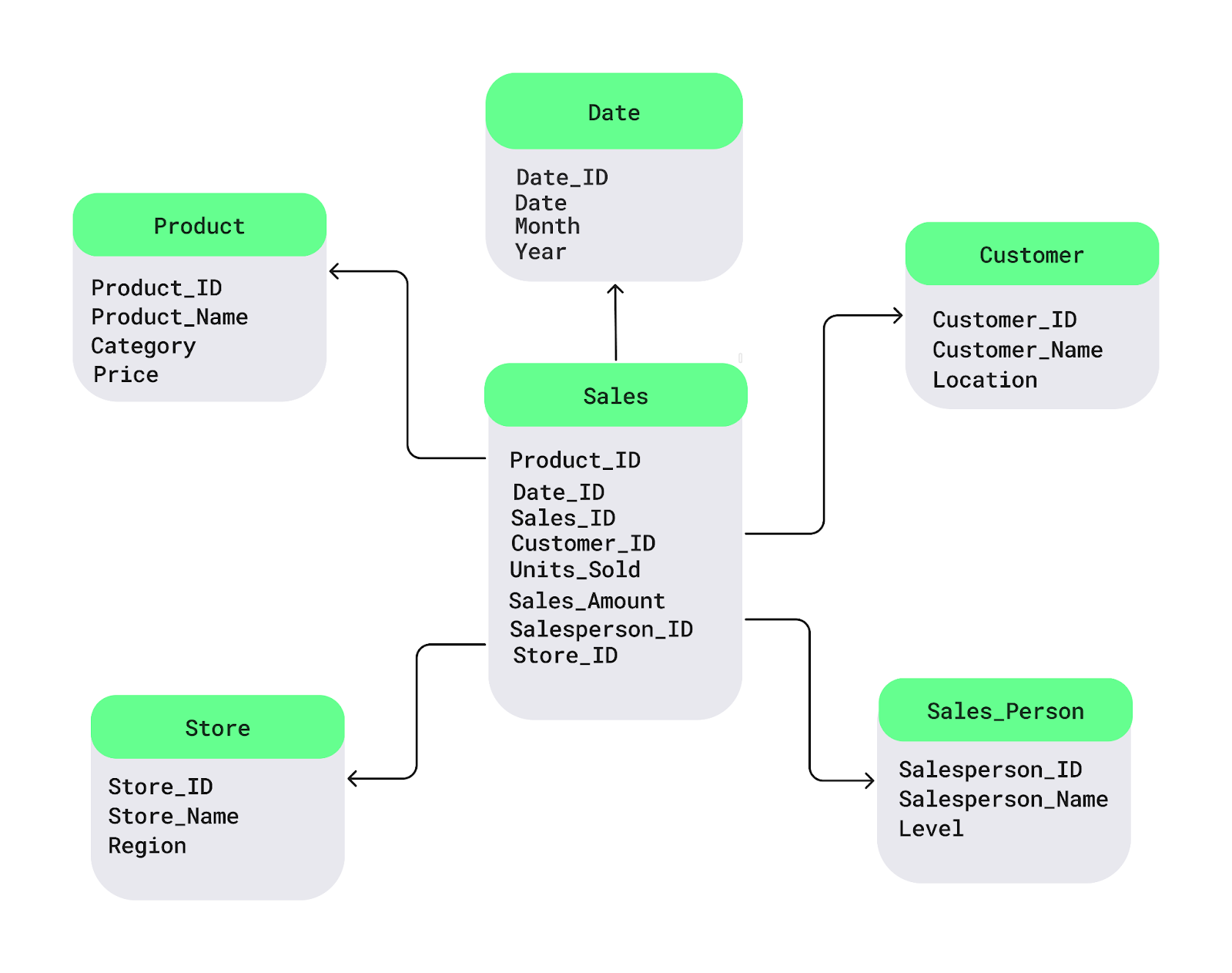

Esquema de estrela

O esquema em estrela é um dos padrões de design de data warehouse mais usados. Ele estrutura os dados em:

- Uma tabela de fatos central - Armazena dados quantitativos, como:

- Receita de vendas

- Unidades vendidas

- Tabelas de dimensão circundantes - Contêm atributos descritivos, incluindo:

- Detalhes do produto (por exemplo, nome do produto, categoria)

- Informações do cliente (por exemplo, ID do cliente, dados demográficos)

- Localização das lojas

- Períodos de tempo

Em um cenário de varejo, a tabela de fatos contém dados de vendas transacionais, enquanto as tabelas de dimensões fornecem contexto sobre produtos, clientes, lojas e tempo. Esse esquema melhora o desempenho da consulta, tornando-o ideal para ambientes com necessidades de relatórios frequentes e diretos.

Exemplo de esquema de estrela. Imagem source: DataCamp.

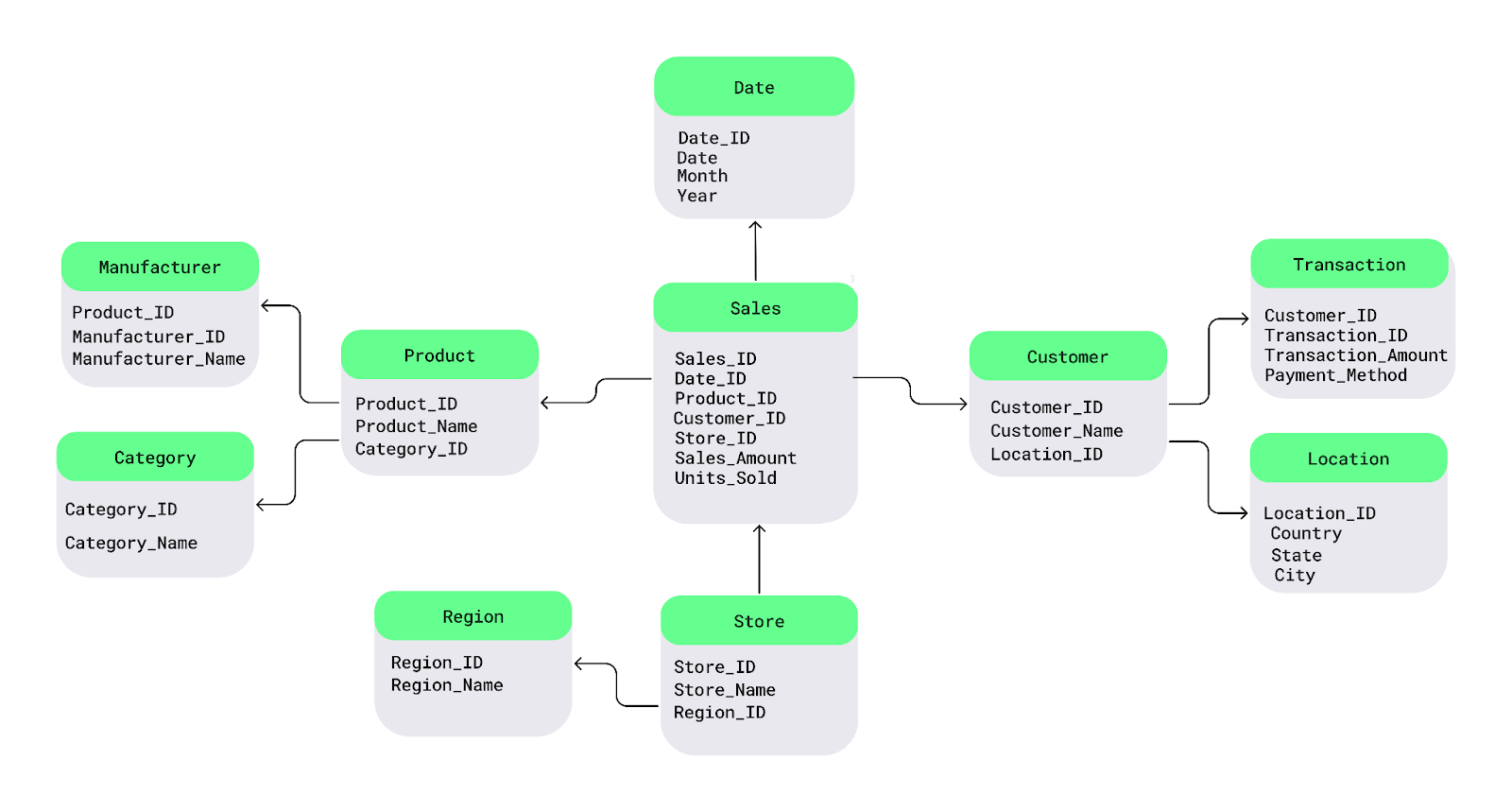

Esquema de Snowflake

O esquema Snowflake é uma extensão do esquema estrela, introduzindo normalização adicional nas tabelas de dimensão. As principais características incluem:

- Tabelas de dimensão normalizadas - As tabelas de dimensões são divididas em subdimensões para reduzir a redundância.

- Maior eficiência de armazenamento - Menos dados duplicados em comparação com o esquema em estrela.

- Consultas mais complexas - As uniões entre várias tabelas podem reduzir o desempenho da consulta.

Esse esquema é ideal para você:

- Otimização do armazenamento - Útil quando a redução da redundância é uma prioridade.

- Conjuntos de dados complexos - É benéfico para dados com muitos atributos que exigem normalização.

- Ambientes preocupados com os custos - Preferido quando os custos de armazenamento são altos.

- Consultas analíticas detalhadas - Oferece suporte a análises detalhadas em detrimento da velocidade de consulta.

Embora o esquema Snowflake conserve o armazenamento, ele pode levar a consultas mais complexas devido à sua natureza altamente estruturada.

Exemplo de esquema Snowflake. Imagem fonte: DataCamp.

Modelagem de cofre de dados

A modelagem de cofre de dados é um padrão de design mais recente que se concentra em flexibilidade, escalabilidade e rastreamento de dados históricos. Ele divide o data warehouse em três componentes principais:

- Hubs (que armazenam entidades comerciais importantes)

- Links (que representam relacionamentos entre entidades)

- Satélites (que contêm atributos descritivos)

Essa abordagem é altamente adaptável às mudanças nos processos de negócios, o que a torna adequada para ambientes de desenvolvimento ágeis.

O padrão de design de modelagem de cofre de dados tem crescido em popularidade devido à sua capacidade de lidar com ambientes de dados em evolução, acomodar mudanças nas fontes de dados e oferecer suporte à escalabilidade de longo prazo. Ele se tornou a solução ideal para organizações que exigem rastreamento histórico detalhado, alterações frequentes de esquema ou uma arquitetura altamente escalonável.

Práticas recomendadas para criar uma arquitetura de data warehouse

A implementação de práticas recomendadas desde o início é essencial para a criação de uma arquitetura robusta. Portanto, esta seção abordará algumas das práticas recomendadas a serem seguidas na construção de um data warehouse de alto desempenho.

Planeje a escalabilidade

Os volumes de dados e os requisitos comerciais inevitavelmente crescerão com o tempo, portanto, é essencial garantir que a arquitetura que você selecionar possa lidar com o aumento das cargas de trabalho. Você pode fazer isso simplesmente usando soluções de armazenamento escalonáveis, como plataformas baseadas em nuvem, e particionando tabelas grandes para obter melhor desempenho.

Otimizar os processos de ETL

Simplifique o pipeline de ETL minimizando as transformações de dados desnecessárias, aproveitando as estratégias de carregamento incremental e paralelizando as tarefas de ETL quando possível. Isso garante que os dados sejam ingeridos, transformados e carregados rapidamente, sem gargalos.

Garantir a qualidade e a consistência dos dados

Manter a alta qualidade dos dados é fundamental para o valor de um data warehouse.mental. Implemente procedimentos sólidos de validação e deduplicação de dados para garantir que os dados que entram no warehouse sejam precisos e consistentes. Auditorias regulares e verificações de qualidade devem fazer parte do pipeline de ETL para evitar problemas que possam levar a análises incorretas.

Foco na segurança e conformidade dos dados

A segurança dos dados deve ser uma prioridade, especialmente ao lidar com informações confidenciais ou regulamentadas. Há três medidas essenciais que você deve tomar:

- Aplique criptografia aos dados em repouso e em trânsito.

- Implemente controles de acesso baseados em funções para limitar o acesso aos dados a usuários autorizados.

- Garanta que a arquitetura atenda aos padrões regulatórios(por exemplo, GDPR, HIPAA,requisitos específicos do setor).

Monitorar o desempenho e o uso

Para manter o data warehouse operando de forma eficiente, monitore regularmente o seguinte:

- Desempenho da consulta

- Padrões de acesso do usuário

- Utilização do armazenamento

Os programas para monitorar o desempenho podem ajudar a identificar gargalos, o que pode ajudar você a fazer ajustes proativos quando necessário.

Nuvem vs. nuvem. Arquitetura de data warehouse no local

Você deve optar por um data warehouse baseado em nuvem ou manter tudo no local? Quais são os principais benefícios e desvantagens de cada abordagem? E uma solução híbrida é o melhor dos dois mundos?

Nesta seção, exploraremos essas questões e ajudaremos você a determinar a arquitetura certa para suas necessidades.

Arquitetura baseada em nuvem

Os data warehouses baseados em nuvem oferecem escalabilidade e flexibilidade inigualáveis. Essas plataformas permitem que as empresas dimensionem os recursos de armazenamento e computação sob demanda, o que as torna ideais para lidar com grandes volumes de dados dinâmicos sem custos iniciais de infraestrutura.

O modelo de preço de pagamento conforme o uso também torna as soluções em nuvem econômicas, especialmente para empresas com cargas de trabalho flutuantes. No entanto, os ambientes em nuvem podem levantar preocupações sobre a governança e a conformidade dos dados, especialmente para setores altamente regulamentados.

Os fornecedores populares de nuvem incluem:

- Amazon Web Services (Redshift)

- Google Cloud (BigQuery)

- Microsoft Azure (Azure Synapse Analytics)

Arquitetura no local

Os data warehouses no local são mais adequados para organizações que exigem controle rigoroso dos dados. Com a arquitetura no local, as empresas mantêm controle total sobre o hardware e os dados, o que é essencial para setores como finanças, saúde e governo, onde as informações confidenciais devem ser protegidas.

Mas aqui está o problema. Embora os sistemas locais possam oferecer um desempenho robusto, eles geralmente têm altos custos iniciais de hardware e manutenção contínua. O dimensionamento também pode ser desafiador, pois requer atualizações manuais e aquisição de hardware, o que é menos flexível do que as soluções em nuvem.

Arquitetura híbrida

As arquiteturas híbridas de data warehouse combinam componentes na nuvem e no local, oferecendo maior flexibilidade para as organizações que precisam equilibrar segurança, conformidade e escalabilidade. Por exemplo, os dados confidenciais podem ser armazenados no local, enquanto os dados menos críticos ou as cargas de trabalho de análise podem ser processados na nuvem.

As arquiteturas híbridas são particularmente úteis para empresas que precisam fazer a transição para a nuvem gradualmente ou que têm requisitos específicos de privacidade de dados. Esse modelo oferece o melhor dos dois mundos, mas requer uma orquestração cuidadosa para garantir a integração perfeita dos dados entre os ambientes.

Tabela de resumo: Arquitetura de data warehouse na nuvem, no local ou híbrida

|

Recurso |

Arquitetura baseada em nuvem |

Arquitetura no local |

Arquitetura híbrida |

|

Escalabilidade |

Alocação de recursos altamente dimensionável e sob demanda |

Limitado pelo hardware no local, requer atualizações manuais |

Combina recursos de nuvem escaláveis com controle no local |

|

Custo |

Preços de pagamento conforme o uso, custos iniciais mais baixos |

Alto investimento inicial em hardware e manutenção contínua |

Custos híbridos, equilibrando a economia na nuvem e as despesas no local |

|

Flexibilidade |

Extremamente flexível, ideal para cargas de trabalho dinâmicas |

Menos flexível, limitado pela infraestrutura física |

Flexível, combinando agilidade na nuvem com controle no local |

|

Segurança e conformidade |

Pode gerar preocupações para setores altamente regulamentados |

Controle total sobre a segurança dos dados e a conformidade normativa |

Garante a conformidade de dados confidenciais enquanto você aproveita a nuvem |

|

Desempenho |

Você pode variar de acordo com o provedor de nuvem e a configuração |

Alto desempenho, mas dependente de investimentos em hardware |

Desempenho equilibrado com base na distribuição da carga de trabalho |

|

Manutenção |

Manutenção mínima, gerenciada pelo provedor de nuvem |

Requer manutenção interna contínua de TI |

Abordagem híbrida com serviços em nuvem que lidam com alguma manutenção |

|

Casos de uso |

Ideal para empresas com volumes de dados grandes e flutuantes |

Ideal para organizações com necessidades rigorosas de segurança e conformidade |

Ideal para organizações que estão fazendo a transição para a nuvem ou com necessidades mistas |

Plataformas populares de data warehouse em nuvem

Aqui está uma visão geral de algumas das plataformas de data warehouse mais populares usadas na nuvem.

Amazon Redshift

O Amazon Redshift é uma solução de data warehouse em nuvem totalmenteenvelhecida para análise de dados em grande escala. Sua arquitetura é baseada em um sistema de processamento massivamente paralelo, que permite aos usuários consultar rapidamente vastos conjuntos de dados. Com sua capacidade de aumentar e diminuir com base nos requisitos de carga de trabalho, o Redshift é adequado para organizações que precisam de escalabilidade econômica e integração com outros serviços da AWS.

Google BigQuery

O Google BigQuery é uma plataforma de warehouse de dados altamente escalonável, sem serviços, criada para análises rápidas e em tempo real. Sua arquitetura exclusiva desacopla o armazenamento e a computação, o que permite que os usuários consultem petabytes de dados sem gerenciar a infraestrutura. A capacidade do BigQuery de processar análises em grande escala com o mínimo de sobrecarga o torna ideal para organizações com cargas de trabalho de dados pesadas que exigem consultas rápidas e complexas.

Snowflake

O Snowflake oferece uma arquitetura de dados compartilhados com vários lustres que separa a computação e o armazenamento, proporcionando flexibilidade em recursos de dimensionamento independente. A abordagem nativa da nuvem da Snowflake permite que as empresas dimensionem dinamicamente as cargas de trabalho, tornando-a uma opção atraente para as organizações que precisam de alta flexibilidade e gerenciamento de cargas de trabalho em várias plataformas de nuvem.

Microsoft Azure Synapse

O Microsoft Azure Synapse Analytics é uma plataforma híbrida de gerenciamento de dados que combina data warehouse e análise de big data. Sua arquitetura se integra a estruturas de big data, como o Apache Spark, para fornecer um ambiente unificado para o gerenciamento de data lakes e data warehouses. O Azure Synapse oferece integração perfeita com outros serviços da Microsoft e é ideal para empresas com diversas necessidades de análise de dados.

Tabela de resumo: Plataformas de data warehouse

|

Plataforma |

Arquitetura |

Principais recursos |

Casos de uso |

|

Amazon Redshift |

Arquitetura MPP, ecossistema AWS |

Consultas rápidas e dimensionáveis, integração com o AWS |

Análise em grande escala, aplicativos nativos da nuvem |

|

Google BigQuery |

Armazenamento e computação desacoplados e sem servidor |

Análise em tempo real, baixa infraestrutura |

Análise rápida, processamento de dados em tempo real |

|

Snowflake |

Arquitetura de dados compartilhados em vários clusters, entre nuvens (AWS, Azure, GCP) |

Separação entre computação e armazenamento, dimensionamento dinâmico |

Dimensionamento flexível, cargas de trabalho de plataforma entre nuvens |

|

Azure Synapse |

Integração híbrida e de big data |

Análise unificada, integração com o Spark |

Gerenciamento de dados híbridos, integração com ferramentas da Microsoft |

Desafios na arquitetura de data warehouse

Embora os data warehouses ofereçam recursos poderosos para as organizações analisarem e gerenciarem grandes quantidades de dados, eles também apresentam desafios inerentes.

Aqui estão alguns dos desafios e soluções mais significativos que você deve considerar ao projetar e manter uma arquitetura de data warehouse.

Integração de dados de diversas fontes

As organizações coletam dados de várias fontes, cada uma com diferentes formatos, esquemas e estruturas, o que torna a integração um desafio complexo. As principais considerações incluem:

- Combinação de dados estruturados e não estruturados - A combinação de registros de bancos de dados relacionais com logs, fluxos de mídia social ou dados de sensores exige uma transformação cuidadosa.

- Transformação e limpeza extensiva de dados - Os dados brutos geralmente precisam ser limpos, formatados e padronizados antes de serem usados com eficiência.

- Ambientes híbridos - A sincronização de dados entre sistemas locais e plataformas em nuvem adiciona outra camada de complexidade.

Para enfrentar esses desafios, as empresas precisam de processos flexíveis de ETL e ferramentas de gerenciamento de dados que suportem diversos formatos de dados e integração perfeita entre plataformas.

Desempenho em escala

À medida que os data warehouses crescem, manter um alto desempenho de consulta se torna um desafio. As operações em grande escala precisam processar com eficiência milhões - ou até bilhões - de linhas, evitando consultas lentas, altos custos e uso ineficiente de recursos.

As principais estratégias de otimização incluem:

- Indexação de dados - Acelera a recuperação de dados criando caminhos de pesquisa estruturados.

- Particionamento - Organiza os dados em segmentos menores e gerenciáveis para que você possa fazer consultas mais rápidas.

- Visualizações materializadas - Armazena resultados de consulta pré-computados para reduzir o tempo de processamento.

- Formatos de armazenamento colunar (por exemplo, Parquet, ORC) - Melhora o desempenho de leitura para consultas analíticas.

- Mecanismos de otimização de consultas - Melhore os planos de execução para obter um desempenho mais rápido.

Gerenciamento da carga de trabalho

À medida que mais usuários acessam o data warehouse, a alocação eficiente de recursos torna-se crítica. As principais considerações incluem:

- Gerenciamento de simultaneidade - Evita gargalos de desempenho quando várias consultas são executadas simultaneamente.

- Dimensionamento dinâmico - Os warehouses baseados em nuvem ajustam automaticamente os recursos para atender à demanda.

- Gerenciamento de contenção de recursos - Os sistemas locais ou híbridos devem gerenciar cuidadosamente os recursos de CPU, memória e disco para evitar lentidão.

Ao implementar essas estratégias, as organizações podem garantir que seu warehouse de dados seja dimensionado de forma eficaz e mantenha o alto desempenho à medida que o volume de dados e a atividade do usuário aumentam.

Governança e segurança de dados

Como os data warehouses armazenam quantidades cada vez maiores de informações confidenciais, medidas sólidas de governança e segurança são essenciais para evitar violações, garantir a conformidade e manter a integridade dos dados.

- Aplicação de políticas de governança consistentes

- Implemente controles de acesso baseados em funções (RBAC) para restringir o acesso aos dados.

- Mantenha catálogos de dados para rastrear a linhagem, a propriedade e o uso dos dados.

- Conformidade regulatória (GDPR, CCPA, HIPAA, etc.)

- Proteja os dados pessoais com técnicas de anonimização e mascaramento.

- Implemente políticas de retenção de dados para atender aos requisitos legais.

- Práticas recomendadas de criptografia e segurança

- Criptografe os dados em repouso e em trânsito para impedir o acesso não autorizado.

- Mantenha registros de auditoria detalhados para rastrear o acesso a dados confidenciais.

- Segurança em ambientes híbridos e de nuvem

- Gerencie chaves de criptografia de forma eficaz em sistemas locais e na nuvem.

- Proteja o tráfego de rede entre os sistemas na nuvem e no local.

- Garantir a conformidade com as políticas de segurança de provedores terceirizados.

Conclusão

Neste artigo, exploramos os principais componentes da arquitetura de data warehouse, os desafios comuns e as estratégias para superá-los. Em última análise, um data warehouse bem projetado faz mais do que armazenar dados - ele capacita as organizações a tomar decisões informadas e orientadas por dados que impulsionam o crescimento e a inovação.

Você quer se aprofundar na arquitetura de dados e nas práticas recomendadas? Dê uma olhada nestes recursos:

- Entendendo a engenharia de dados - Aprenda os fundamentos da engenharia de dados e sua função nos ecossistemas de dados modernos.

- Conceitos de Data Warehousing - Obtenha insights sobre os princípios e o design do Data Warehousing.

- Entendendo a arquitetura de dados moderna - Explore como as arquiteturas de dados evoluíram na era da nuvem.

- Projeto de banco de dados - Domine os fundamentos do projeto de bancos de dados eficientes e dimensionáveis.

- ETL e ELT em Python - Aprenda a criar pipelines ETL/ELT eficazes usando Python.

Torne-se um engenheiro de dados

Perguntas frequentes

Como um data warehouse difere de um banco de dados?

Um banco de dados é projetado para processamento transacional (OLTP), lidando com operações em tempo real, como inserção e atualização de registros. Um data warehouse, por outro lado, é otimizado para processamento analítico (OLAP), permitindo consultas complexas e análise de dados históricos.

Como um data warehouse oferece suporte à análise em tempo real?

Os data warehouses tradicionais processam atualizações em lote, mas as arquiteturas modernas baseadas em nuvem (por exemplo, Snowflake, BigQuery) permitem a análise em tempo real integrando dados de streaming por meio de ferramentas como Apache Kafka, AWS Kinesis ou Google Pub/Sub.

Que função os metadados desempenham em um data warehouse?

Os metadados fornecem informações essenciais sobre a estrutura, a linhagem e as definições dos dados armazenados no warehouse. Ele garante a consistência, melhora a governança dos dados e ajuda os usuários a localizar os conjuntos de dados certos com eficiência.

Um data warehouse pode lidar com dados não estruturados?

Os data warehouses armazenam principalmente dados estruturados, mas podem integrar formatos semiestruturados (por exemplo, JSON, XML, Parquet). No entanto, para dados puramente não estruturados (por exemplo, imagens, vídeos, texto bruto), as organizações geralmente usam lagos de dados em combinação com um data warehouse.

O que são chaves substitutas e por que elas são usadas no design do data warehouse?

As chaves substitutas são identificadores exclusivos gerados pelo sistema e usados em tabelas de fatos e dimensões em vez de chaves naturais (como ID do cliente ou código do produto). Eles melhoram o desempenho, a consistência e a flexibilidade no design do esquema.

Como as visualizações materializadas melhoram o desempenho do data warehouse?

As visualizações materializadas armazenam resultados de consulta pré-computados, reduzindo o tempo de processamento de consultas repetitivas. Isso melhora significativamente o desempenho, especialmente em consultas analíticas agregadas ou complexas.

Como um data warehouse se integra à IA e ao machine learning?

Muitos warehouses modernos oferecem suporte a cargas de trabalho de ML e IA:

- Funções de ML incorporadas (por exemplo, ML do BigQuery, ML do Redshift)

- Integração com estruturas de ML (por exemplo, TensorFlow, PyTorch, Scikit-learn)

- Armazenamento de recursos que permite que os analistas forneçam dados estruturados aos modelos de ML de forma eficiente

O que são dimensões de mudança lenta (SCD) em um data warehouse?

Os SCDs rastreiam as alterações históricas nas tabelas de dimensão. Os tipos mais comuns incluem:

- SCD Tipo 1 - Substitui dados antigos por novos dados.

- SCD Tipo 2 - Mantém dados históricos ao adicionar novos registros.

- SCD Tipo 3 - Mantém um histórico limitado usando colunas adicionais.