Curso

Construir una sólida arquitectura de almacén de datos es crucial para manejar conjuntos de datos grandes y complejos. A medida que los datos siguen creciendo, las empresas necesitan un enfoque estructurado para almacenar, gestionar y analizar la información de forma eficaz.

Sin la arquitectura adecuada, puedes encontrarte con consultas lentas, datos incoherentes y retos que hagan que la toma de decisiones sea más complicada de lo que debería.

En este post, te guiaré a través de los componentes clave de un almacén de datos, los distintos tipos de arquitectura y las mejores prácticas para ayudarte a diseñar un sistema que sea escalable y eficiente. Tanto si estás creando un nuevo almacén de datos como optimizando uno ya existente, comprender estos principios te preparará para el éxito.

Componentes de la arquitectura de un almacén de datos

Un almacén de datos bien diseñado se construye sobre una serie de componentes interconectados. Estos componentes trabajan juntos para procesar datos de diversas fuentes, transformarlos para su análisis y ponerlos a disposición de los usuarios en un formato estructurado. A continuación, exploramos los componentes esenciales de la arquitectura de un almacén de datos.

Fuentes de datos

Un almacén de datos recopila información de varias fuentes, incluidos datos estructurados de bases de datos relacionales y datos no estructurados como registros o archivos de texto. Las fuentes de datos más habituales son:

- Bases de datos transaccionales (por ejemplo, MySQL, PostgreSQL)

- Almacenamiento en la nube (por ejemplo, Amazon S3,Google Cloud Storage)

- API externas (por ejemplo, servicios de terceros, aplicaciones web)

Al integrar estas diversas fuentes en un único sistema, las empresas obtienen una visión completa y unificada de sus operaciones.

Capa ETL

El proceso ETL (o ELT) es un componente clave de la arquitectura del almacén de datos. Implica:

- Extrayendo datos brutos de varias fuentes

- Transformar mediante la limpieza, el formateo y la estructuración

- Carga de en el almacén de datos para su análisis

En el ETL, los datos se transforman antes de cargarse, mientras que en el ELT, primero se cargan los datos brutos y luego se transforman dentro del almacén. A menudo se prefiere el ELT para los almacenes modernos basados en la nube, debido a sus ventajas de escalabilidad y rendimiento.

Área de preparación

El área de preparación es un espacio de almacenamiento opcional y temporal donde se guardan los datos brutos antes de procesarlos y cargarlos en el almacén de datos. Esta capa actúa como un búfer para permitir que se produzcan transformaciones de datos sin afectar directamente al almacenamiento de datos principal.

Capa de almacenamiento de datos

En el núcleo del almacén de datos se encuentra la capa de almacenamiento, donde los datos se organizan en tablas de hechos y dimensiones:

- Tablas de hechos almacenan datos cuantitativos (por ejemplo, cifras de ventas)

- Tablas de dimensiones almacenan información descriptiva (por ejemplo, detalles de clientes o productos).

Los datos suelen organizarse en un esquema de estrella o copo de nieve para optimizar su rendimiento de consulta y análisis.

Capa de metadatos

La capa de metadatos gestionaes y mantiene la estructura y las relaciones dentro del almacén de datos. En esencia, los metadatos proporcionan información sobre fuentes de datos, esquemas y transformaciones. Esto permite a los usuarios y sistemas comprender el contexto, ellinaje y el uso de los datosdentro del almacén.

Capa de acceso y análisis de datos

Esta capa permite a los usuarios recuperar y analizar datos del almacén. Suele incluir:

- Herramientas de inteligencia empresarial (BI) - Cuadros de mando, informes y visualizaciones (por ejemplo, Tableau, Power BI)

- Acceso directo - Consultas SQL o API para la recuperación de datos

- Análisis avanzados: modelos de aprendizaje automático, análisis predictivos e informes detallados

Mientras que los informes básicos y los cuadros de mando entran dentro del acceso tradicional a los datos, los flujos de trabajo más complejos de aprendizaje automático y análisis predictivo a veces se clasifican por separado como capa analítica, debido a sus necesidades computacionales avanzadas.

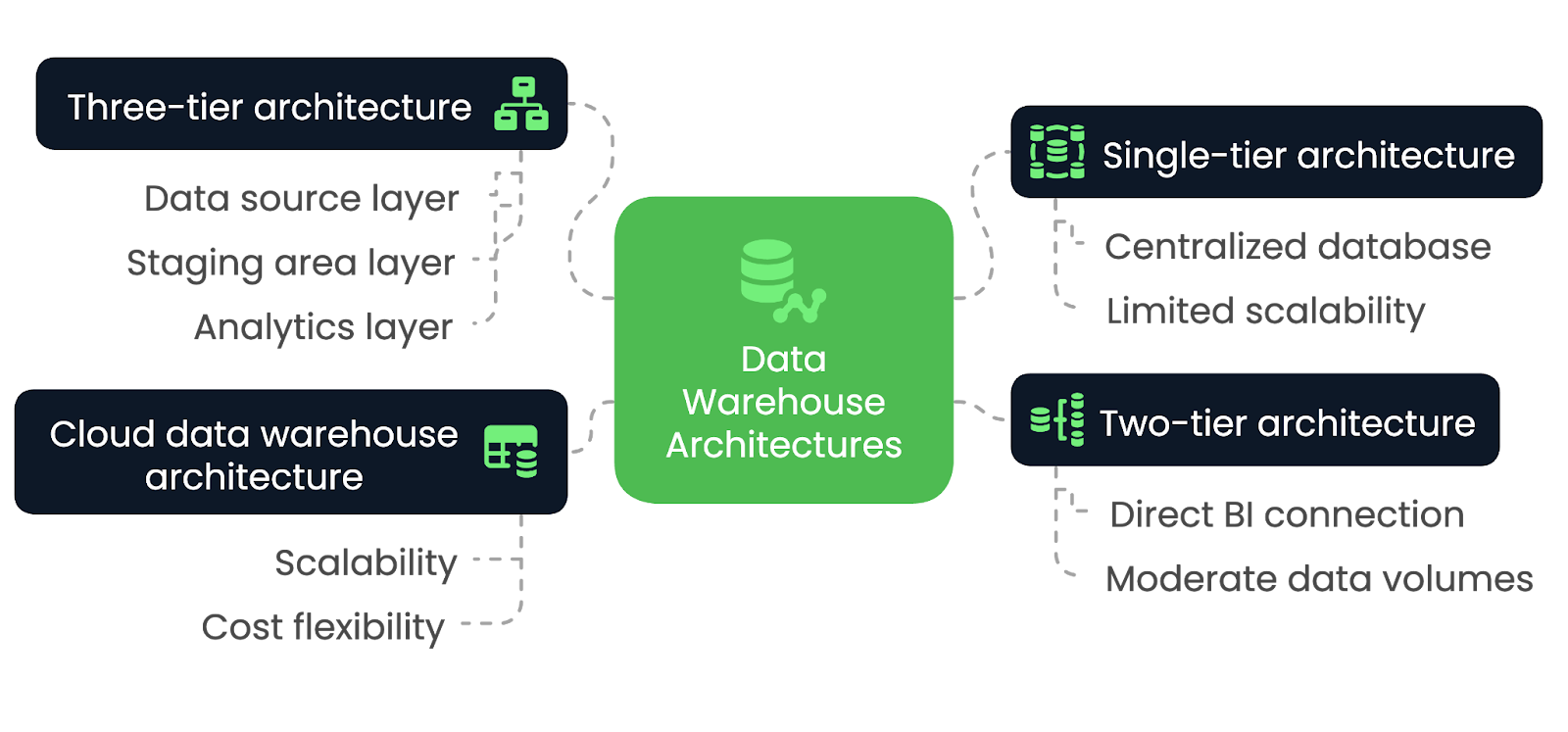

Tipos de arquitectura de almacén de datos

Elegir la arquitectura de almacén de datos adecuada es esencial para satisfacer las necesidades de rendimiento, escalabilidad e integración de tu organización. Sin embargo, las distintas arquitecturas ofrecen ventajas y desventajas únicas, dependiendo de varios factores. Explorémoslos en esta sección.

Arquitectura de un solo nivel

En una arquitectura de un solo nivel, el almacén de datos se construye sobre una única base de datos centralizada que consolida todos los datos de varias fuentes en un solo sistema. Esta arquitectura minimiza el número de capas y simplifica el diseño general, lo que permite un procesamiento y un acceso más rápidos a los datos. Sin embargo, carece de la flexibilidad y modularidad de las arquitecturas más complejas.

La arquitectura de un solo nivel se adapta mejor a las aplicaciones a pequeña escala y a las organizaciones con necesidades limitadas de procesamiento de datos. Es ideal para las empresas que dan prioridad a la sencillez y a la implantación rápida frente a la escalabilidad. Sin embargo, a medida que aumenta el volumen de datos o se requieren análisis más avanzados, esta arquitectura puede tener dificultades para satisfacer eficazmente esas demandas.

Arquitectura de dos niveles

En una arquitectura de dos niveles, el almacén de datos se conecta directamente a las herramientas de BI, a menudo a través deun sistema OLAP. Aunque este enfoque proporciona un acceso más rápido a los datos para su análisis, puede plantear problemas a la hora de manejar grandes volúmenes de datos, ya que el escalado se hace difícil debido a la conexión directa entre el almacén y las herramientas de BI.

La arquitectura de dos niveles es la más adecuada para organizaciones pequeñas y medianas que necesitan un acceso más rápido a los datos para su análisis, pero no requieren la escalabilidad de arquitecturas más grandes y complejas. Es ideal para empresas con volúmenes de datos moderados y necesidades de elaboración de informes o análisis relativamente sencillas, ya que permite la integración directa entre el almacén de datos y las herramientas de inteligencia empresarial.

Sin embargo, a medida que los datos crecen o los requisitos analíticos se hacen más sofisticados, esta arquitectura puede tener dificultades para escalar y manejar eficientemente cargas de trabajo cada vez mayores.

Arquitectura de tres niveles

La arquitectura de tres niveles es el modelo más común y utilizado para los almacenes de datos. Separa el sistema en capas distintas: la capa de la fuente de datos, la capa del área de preparación y la capa de análisis. Esta separación permite procesos ETL eficientes, seguidos de análisis e informes.

La arquitectura de tres niveles es ideal para entornos empresariales a gran escala que requieren escalabilidad, flexibilidad y capacidad para manejar volúmenes masivos de datos. Permite a las empresas gestionar los datos de forma más eficiente y admite análisis avanzados, aprendizaje automático e informes en tiempo real. La separación de capas mejora el rendimiento, por lo que es adecuada para entornos de datos complejos.

Arquitectura de almacén de datos en la nube

En la arquitectura de almacén de datos en la nube, toda la infraestructura se aloja en plataformas como Amazon Redshift, Google BigQuery o Snowflake. Las arquitecturas basadas en la nube ofrecen una escalabilidad prácticamente ilimitada, con capacidad para manejar grandes conjuntos de datos sin necesidad de hardware local. También ofrecen flexibilidad de costes mediante modelos de pago por uso, lo que las hace accesibles a un abanico más amplio de empresas.

La arquitectura de almacén de datos en la nube es ideal para organizaciones de todos los tamaños. Es ideal para las empresas que buscan una solución flexible y escalable, ya que este enfoque permite a las empresas escalar los recursos de almacenamiento y cálculo de forma dinámica.

Arquitecturas de almacenes de datos comparadas-imagen por Autor.

Patrones de Diseño de Arquitectura de Almacén de Datos

Hay bastantes patrones de diseño de almacenes de datos, pero cada uno atiende a necesidades distintas según la complejidad de los datos y los tipos de consultas que se ejecuten. Exploremos algunos de los más comunes y descifremos los escenarios más apropiados para utilizarlos con la máxima eficacia.

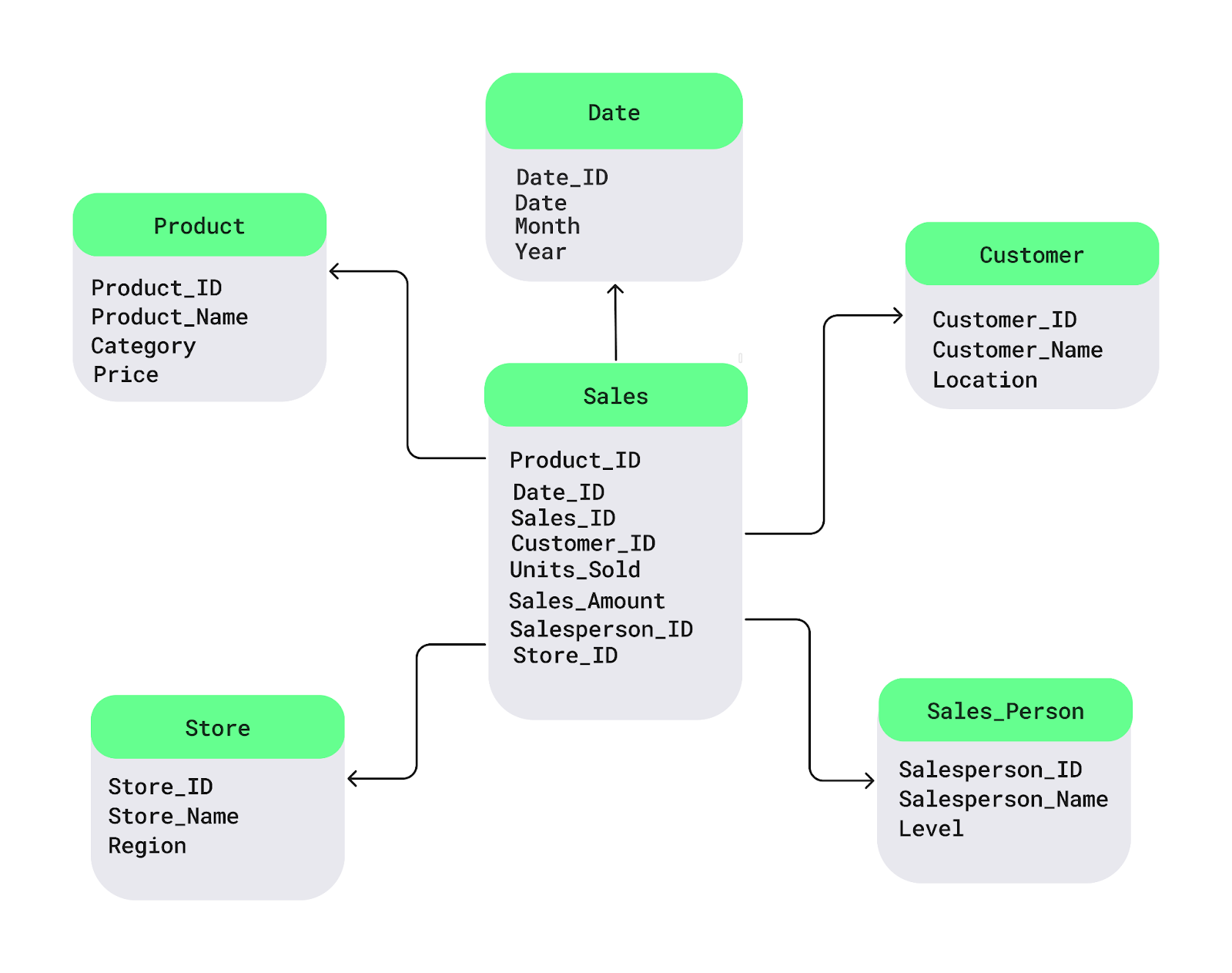

Esquema estrella

El esquema en estrella es uno de los patrones de diseño de almacenes de datos más utilizados. Estructura los datos en:

- Una tabla de hechos central - Almacena datos cuantitativos, como

- Ingresos por ventas

- Unidades vendidas

- Tablas de dimensiones circundantes - Contienen atributos descriptivos, como

- Detalles del producto (por ejemplo, nombre del producto, categoría)

- Información del cliente (por ejemplo, identificación del cliente, datos demográficos)

- Tiendas

- Periodos de tiempo

En un escenario minorista, la tabla de hechos contiene datos de ventas transaccionales, mientras que las tablas de dimensiones proporcionan contexto sobre productos, clientes, tiendas y tiempo. Este esquema mejora el rendimiento de las consultas, por lo que es ideal para entornos con necesidades de elaboración de informes frecuentes y sencillos.

Ejemplo de esquema estrella. Imagen source: Campamento de datos.

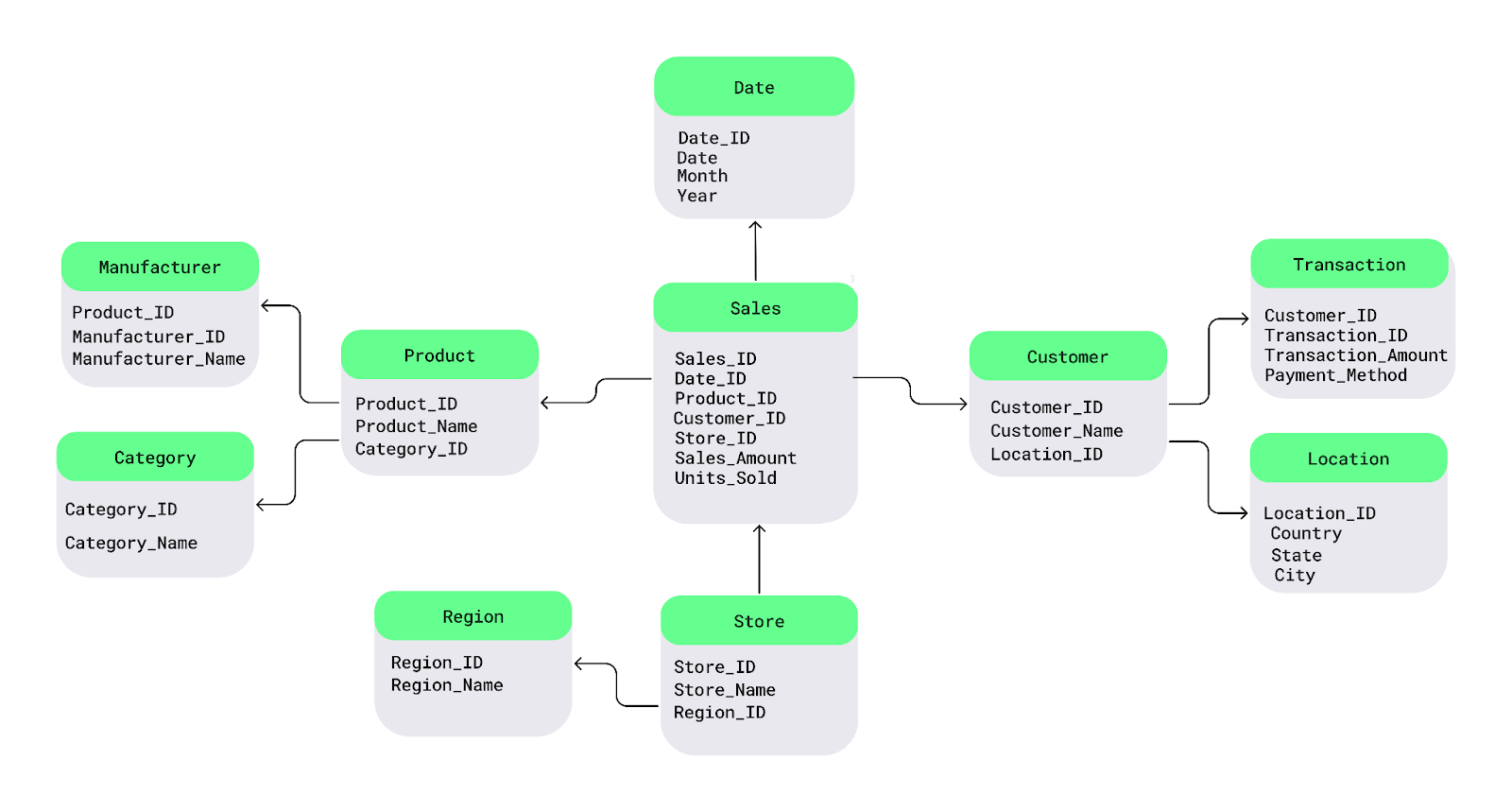

Esquema de copo de nieve

El esquema copo de nieve es una ampliación del esquema estrella, que introduce una normalización adicional a las tablas de dimensiones. Las características clave son:

- Tablas de dimensiones normalizadas - Las tablas de dimensiones se dividen en subdimensiones para reducir la redundancia.

- Mayor eficacia de almacenamiento - Menos datos duplicados en comparación con el esquema estrella.

- Consultas más complejas - Las uniones entre varias tablas pueden ralentizar el rendimiento de las consultas.

Este esquema es ideal para:

- Optimización del almacenamiento - Útil cuando reducir la redundancia es una prioridad.

- Conjuntos de datos complejos - Beneficioso para datos con muchos atributos que requieren normalización.

- Entornos conscientes de los costes - Preferible cuando los costes de almacenamiento son elevados.

- Consultas analíticas detalladas - Admite análisis en profundidad a expensas de la velocidad de consulta.

Aunque el esquema copo de nieve conserva el almacenamiento, puede dar lugar a consultas más intrincadas debido a su naturaleza altamente estructurada.

Ejemplo de esquema copo de nieve. Fuente de la imagen: Campamento de datos.

Modelado de bóvedas de datos

El modelado de bóvedas de datos es un patrón de diseño más reciente que se centra en la flexibilidad, la escalabilidad y el seguimiento histórico de los datos. Divide el almacén de datos en tres componentes básicos:

- Hubs (que almacenan entidades empresariales clave)

- Enlaces (que representan relaciones entre entidades)

- Satélites (que contienen atributos descriptivos)

Este enfoque es muy adaptable a los cambios en los procesos empresariales, lo que lo hace idóneo para entornos de desarrollo ágiles.

El patrón de diseño de modelado de bóvedas de datos ha ido ganando popularidad debido a su capacidad para manejar entornos de datos en evolución, adaptarse a los cambios en las fuentes de datos y soportar la escalabilidad a largo plazo. Se ha convertido en una solución ideal para las organizaciones que requieren un seguimiento histórico detallado, cambios frecuentes de esquema o una arquitectura altamente escalable.

Buenas prácticas para construir una arquitectura de almacén de datos

Aplicar las mejores prácticas desde el principio es esencial para construir una arquitectura sólida. Por ello, esta sección tratará algunas de las mejores prácticas a seguir al construir un almacén de datos de alto rendimiento.

Planificar la escalabilidad

Los volúmenes de datos y los requisitos empresariales crecerán inevitablemente con el tiempo, por lo que es esencial asegurarse de que la arquitectura que elijas pueda soportar cargas de trabajo cada vez mayores. Esto puede hacerse simplemente utilizando soluciones de almacenamiento escalables, como las plataformas basadas en la nube, y particionando las tablas grandes para mejorar el rendimiento.

Optimizar los procesos ETL

Agiliza la canalización ETL minimizando las transformaciones de datos innecesarias, aprovechando las estrategias de carga incremental y paralelizando las tareas ETL cuando sea posible. Esto garantiza que los datos se ingieran, transformen y carguen rápidamente, sin cuellos de botella.

Garantizar la calidad y coherencia de los datos

Mantener una alta calidad de los datos es fundamental para el valor de un almacén de datos. Pon en marcha sólidos procedimientos de validación y deduplicación de datos para garantizar que los datos que entran en el almacén son precisos y coherentes. Las auditorías periódicas y las comprobaciones de calidad deben formar parte del proceso ETL para evitar problemas que puedan dar lugar a análisis incorrectos.

Centrarse en la seguridad de los datos y el cumplimiento

La seguridad de los datos debe ser una prioridad máximaoridad, especialmente cuando se trata de información sensible o regulada. Hay tres medidas esenciales que debes tomar:

- Aplica la encriptación a los datos en reposo y en tránsito.

- Implanta controles de acceso basados en roles para limitar el acceso a los datos a los usuarios autorizados.

- Garantizar que la arquitectura cumple las normas reglamentarias(por ejemplo, GDPR, HIPAA,requisitos específicos del sector).

Controla el rendimiento y el uso

Para que el almacén de datos funcione con eficacia, controla regularmente lo siguiente:

- Rendimiento de la consulta

- Patrones de acceso de los usuarios

- Utilización del almacenamiento

Las herramientas de seguimiento del rendimiento pueden ayudar a identificar los cuellos de botella, lo que puede ayudarte a realizar ajustes proactivos cuando sea necesario.

Nube vs. Arquitectura de almacén de datos local

¿Deberías optar por un almacén de datos basado en la nube o mantenerlo todo in situ? ¿Cuáles son las principales ventajas y desventajas de cada enfoque? ¿Y una solución híbrida es lo mejor de ambos mundos?

En esta sección, exploraremos estas cuestiones y te ayudaremos a determinar la arquitectura adecuada a tus necesidades.

Arquitectura basada en la nube

Los almacenes de datos basados en la nube proporcionan una escalabilidad y flexibilidad sin precedentes. Estas plataformas permiten a las empresas escalar el almacenamiento y los recursos informáticos bajo demanda, lo que las hace ideales para manejar grandes volúmenes de datos dinámicos sin costes iniciales de infraestructura.

El modelo de precios de pago por uso también hace que las soluciones en la nube sean rentables, sobre todo para las empresas con cargas de trabajo fluctuantes. Sin embargo, los entornos en la nube pueden suscitar preocupaciones sobre la gobernanza y el cumplimiento de los datos, especialmente en sectores muy regulados.

Entre los proveedores de nube más populares están:

- Servicios web de Amazon (Redshift)

- Nube de Google (BigQuery)

- Microsoft Azure (Azure Synapse Analytics)

Arquitectura local

Los almacenes de datos locales son los más adecuados para las organizaciones que requieren un control estricto de los datos. Con la arquitectura local, las empresas mantienen un control total sobre su hardware y sus datos, algo esencial para sectores como el financiero, el sanitario y el gubernamental, donde debe protegerse la información sensible.

Pero aquí está el truco. Aunque los sistemas locales pueden ofrecer un rendimiento sólido, a menudo conllevan elevados costes iniciales de hardware y mantenimiento continuo. La ampliación también puede ser un reto, ya que requiere actualizaciones manuales y la adquisición de hardware, que es menos flexible que las soluciones en la nube.

Arquitectura híbrida

Las arquitecturas híbridas de almacén de datos combinan componentes en la nube y locales, ofreciendo mayor flexibilidad a las organizaciones que necesitan equilibrar la seguridad, el cumplimiento y la escalabilidad. Por ejemplo, los datos sensibles pueden almacenarse in situ, mientras que los datos menos críticos o las cargas de trabajo analíticas pueden procesarse en la nube.

Las arquitecturas híbridas son especialmente útiles para las empresas que necesitan una transición gradual a la nube o tienen requisitos específicos de privacidad de datos. Este modelo ofrece lo mejor de ambos mundos, pero requiere una orquestación cuidadosa para garantizar una integración de datos sin fisuras entre entornos.

Tabla resumen: Arquitectura de almacén de datos en la nube vs. local vs. híbrida

|

Función |

Arquitectura basada en la nube |

Arquitectura local |

Arquitectura híbrida |

|

Escalabilidad |

Asignación de recursos altamente escalable y bajo demanda |

Limitado por el hardware in situ, requiere actualizaciones manuales |

Combina recursos escalables en la nube con control local |

|

Coste |

Precios de pago por uso, menores costes iniciales |

Elevada inversión inicial en hardware y mantenimiento continuo |

Costes híbridos, equilibrando el ahorro en la nube y los gastos locales |

|

Flexibilidad |

Extremadamente flexible, ideal para cargas de trabajo dinámicas |

Menos flexible, limitado por la infraestructura física |

Flexible, combina la agilidad de la nube con el control local |

|

Seguridad y Cumplimiento |

Puede plantear problemas para las industrias muy reguladas |

Control total sobre la seguridad de los datos y el cumplimiento de la normativa |

Garantiza la conformidad de los datos sensibles al tiempo que aprovecha la nube |

|

Rendimiento |

Puede variar según el proveedor de la nube y la configuración |

Alto rendimiento, pero depende de las inversiones en hardware |

Rendimiento equilibrado basado en la distribución de la carga de trabajo |

|

Mantenimiento |

Mantenimiento mínimo, gestionado por el proveedor de la nube |

Requiere un mantenimiento informático interno continuo |

Enfoque híbrido con servicios en la nube que se encargan de parte del mantenimiento |

|

Casos prácticos |

Lo mejor para empresas con grandes volúmenes de datos fluctuantes |

Lo mejor para organizaciones con necesidades estrictas de seguridad y cumplimiento |

Ideal para organizaciones en transición a la nube o con necesidades mixtas |

Plataformas populares de almacén de datos en la nube

He aquí un resumen de algunas de las plataformas de almacén de datos más populares utilizadas en la nube.

Amazon Redshift

Amazon Redshift es una solución de almacén de datos en la nube totalmente manda para el análisis de datos a gran escala. Su arquitectura se basa en un sistema de procesamiento paralelo masivo, que permite a los usuarios consultar grandes conjuntos de datos con rapidez. Con su capacidad para escalar hacia arriba y hacia abajo en función de los requisitos de la carga de trabajo, Redshift es muy adecuado para las organizaciones que necesitan una escalabilidad rentable e integración con otros servicios de AWS.

Google BigQuery

Google BigQuery es una plataforma de almacén de datos sin servicioy altamente escalable, creada para realizar análisis rápidos y en tiempo real. Su arquitectura única desacopla el almacenamiento y el cálculo, lo que permite a los usuarios consultar petabytes de datos sin gestionar la infraestructura. La capacidad de BigQuery para procesar análisis a gran escala con una sobrecarga mínima lo hace ideal para organizaciones con grandes cargas de trabajo de datos que exigen consultas rápidas y complejas.

Copo de nieve

Snowflake ofrece una arquitectura multi-cluster de datos compartidos que separa la informática del almacenamiento, proporcionando flexibilidad para escalar los recursos de forma independiente. El enfoque nativo en la nube de Snowflake permite a las empresas escalar dinámicamente las cargas de trabajo, lo que lo convierte en una opción atractiva para las organizaciones que necesitan una gran flexibilidad y gestión de las cargas de trabajo en varias plataformas en la nube.

Sinapsis Microsoft Azure

Microsoft Azure Synapse Analytics es una plataforma híbrida de gestión de datos que combina el almacenamiento de datos y la analítica de big data. Su arquitectura se integra con marcos de big data como Apache Spark para proporcionar un entorno unificado de gestión de lagos de datos y almacenes de datos. Azure Synapse ofrece una integración perfecta con otros servicios de Microsoft y es ideal para empresas con diversas necesidades de análisis de datos.

Tabla resumen: Plataformas de almacén de datos

|

Plataforma |

Arquitectura |

Características principales |

Casos prácticos |

|

Amazon Redshift |

Arquitectura MPP, ecosistema AWS |

Consultas escalables y rápidas, integración con AWS |

Análisis a gran escala, aplicaciones nativas en la nube |

|

Google BigQuery |

Almacenamiento y computación desacoplados y sin servidor |

Análisis en tiempo real, baja infraestructura |

Análisis rápidos, procesamiento de datos en tiempo real |

|

Copo de nieve |

Arquitectura multi-clúster, de datos compartidos, cross-cloud (AWS, Azure, GCP) |

Separación ordenador-almacenamiento, escalado dinámico |

Escalado flexible, cargas de trabajo de plataformas multi-nube |

|

Sinapsis Azure |

Integración híbrida de big data |

Analítica unificada, integración con Spark |

Gestión híbrida de datos, integración con herramientas Microsoft |

Desafíos en la arquitectura de almacenes de datos

Aunque los almacenes de datos proporcionan potentes capacidades para que las organizaciones analicen y gestionen grandes cantidades de datos, también conllevan retos inherentes.

He aquí algunos de los retos y soluciones más importantes que hay que tener en cuenta al diseñar y mantener una arquitectura de almacén de datos.

Integración de datos de diversas fuentes

Las organizaciones recopilan datos de múltiples fuentes, cada una con formatos, esquemas y estructuras diferentes, lo que convierte la integración en un reto complejo. Las consideraciones clave incluyen:

- Mezclar datos estructurados y no estructurados - Combinar registros de bases de datos relacionales con registros, flujos de redes sociales o datos de sensores requiere una transformación cuidadosa.

- Amplia transformación y limpieza de datos - Los datos en bruto a menudo necesitan limpieza, formateo y normalización antes de que puedan utilizarse con eficacia.

- Entornos híbridos - Sincronizar datos entre sistemas locales y plataformas en la nube añade otra capa de complejidad.

Para afrontar estos retos, las empresas necesitan procesos ETL flexibles y herramientas de gestión de datos que admitan diversos formatos de datos y una integración perfecta entre plataformas.

Rendimiento a escala

A medida que crecen los almacenes de datos, mantener un alto rendimiento en las consultas se convierte en un reto. Las operaciones a gran escala deben procesar eficientemente millones -o incluso miles de millones- de filas, evitando al mismo tiempo consultas lentas, costes elevados y un uso ineficiente de los recursos.

Las estrategias clave de optimización incluyen:

- Indexación de datos - Acelera la recuperación de datos creando rutas de búsqueda estructuradas.

- Partición - Organiza los datos en segmentos más pequeños y manejables para una consulta más rápida.

- Vistas materializadas - Almacena resultados de consulta precalculados para reducir el tiempo de procesamiento.

- Formatos de almacenamiento en columnas (por ejemplo, Parquet, ORC) - Mejora el rendimiento de lectura para consultas analíticas.

- Motores de optimización de consultas - Mejora los planes de ejecución para obtener un rendimiento más rápido.

Gestión de la carga de trabajo

A medida que más usuarios acceden al almacén de datos, la asignación eficiente de recursos se vuelve crítica. Las consideraciones clave incluyen:

- Gestión de la concurrencia - Evita los cuellos de botella en el rendimiento cuando se ejecutan varias consultas simultáneamente.

- Escalado dinámico - Los almacenes basados en la nube ajustan automáticamente los recursos para satisfacer la demanda.

- Gestión de la contención de recursos - Los sistemas locales o híbridos deben gestionar cuidadosamente los recursos de CPU, memoria y disco para evitar ralentizaciones.

Aplicando estas estrategias, las organizaciones pueden asegurarse de que su almacén de datos se escala eficazmente y mantiene un alto rendimiento a medida que crecen el volumen de datos y la actividad de los usuarios.

Gobernanza y seguridad de los datos

A medida que los almacenes de datos almacenan cantidades cada vez mayores de información sensible, es esencial contar con una gobernanza y unas medidas de seguridad sólidas para evitar infracciones, garantizar el cumplimiento y mantener la integridad de los datos.

- Aplicar políticas de gobernanza coherentes

- Implanta controles de acceso basados en roles (RBAC) para restringir el acceso a los datos.

- Mantén catálogos de datos para rastrear el linaje, la propiedad y el uso de los datos.

- Cumplimiento normativo (GDPR, CCPA, HIPAA, etc.)

- Protege los datos personales con técnicas de anonimización y enmascaramiento.

- Aplica políticas de conservación de datos para cumplir los requisitos legales.

- Cifrado y buenas prácticas de seguridad

- Cifra los datos en reposo y en tránsito para evitar accesos no autorizados.

- Mantén registros de auditoría detallados para rastrear el acceso a datos sensibles.

- Seguridad en entornos híbridos y en la nube

- Gestiona eficazmente las claves de encriptación en los sistemas locales y en la nube.

- Protege el tráfico de red entre la nube y los sistemas locales.

- Garantizar el cumplimiento de las políticas de seguridad de terceros proveedores.

Conclusión

En este artículo, exploramos los componentes clave de la arquitectura de un almacén de datos, los retos habituales y las estrategias para superarlos. En última instancia, un almacén de datos bien diseñado hace algo más que almacenar datos: permite a las organizaciones tomar decisiones informadas y basadas en datos que impulsan el crecimiento y la innovación.

¿Quieres profundizar en la arquitectura de datos y las mejores prácticas? Consulta estos recursos:

- Comprender la ingeniería de datos - Aprende los fundamentos de la ingeniería de datos y su papel en los ecosistemas de datos modernos.

- Conceptos de almacenamiento de datos - Adquiere conocimientos sobre los principios y el diseño básicos del almacenamiento de datos.

- Comprender la arquitectura moderna de datos - Explora cómo han evolucionado las arquitecturas de datos en la era de la nube.

- Diseño de bases de datos - Domina los fundamentos del diseño de bases de datos eficientes y escalables.

- ETL y ELT en Python - Aprende a construir pipelines ETL/ELT eficaces utilizando Python.

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿En qué se diferencia un almacén de datos de una base de datos?

Una base de datos está diseñada para el procesamiento transaccional (OLTP), manejando operaciones en tiempo real como insertar y actualizar registros. Un almacén de datos, en cambio, está optimizado para el procesamiento analítico (OLAP), lo que permite realizar consultas complejas y análisis de datos históricos.

¿Cómo soporta un almacén de datos el análisis en tiempo real?

Los almacenes de datos tradicionales procesan actualizaciones por lotes, pero las arquitecturas modernas basadas en la nube (por ejemplo, Snowflake, BigQuery) permiten el análisis en tiempo real integrando datos en streaming mediante herramientas como Apache Kafka, AWS Kinesis o Google Pub/Sub.

¿Qué papel desempeñan los metadatos en un almacén de datos?

Los metadatos proporcionan información esencial sobre la estructura, el linaje y las definiciones de los datos almacenados en el almacén. Garantiza la coherencia, mejora la gobernanza de los datos y ayuda a los usuarios a localizar eficazmente los conjuntos de datos adecuados.

¿Puede un almacén de datos manejar datos no estructurados?

Los almacenes de datos almacenan principalmente datos estructurados, pero pueden integrar formatos semiestructurados (por ejemplo, JSON, XML, Parquet). Sin embargo, para los datos puramente no estructurados (por ejemplo, imágenes, vídeos, texto sin formato), las organizaciones suelen utilizar lagos de datos en combinación con un almacén de datos.

¿Qué son las claves sustitutivas y por qué se utilizan en el diseño de almacenes de datos?

Las claves sustitutas son identificadores únicos generados por el sistema que se utilizan en las tablas de hechos y dimensiones en lugar de claves naturales (como el ID de cliente o el código de producto). Mejoran el rendimiento, la coherencia y la flexibilidad en el diseño de esquemas.

¿Cómo mejoran las vistas materializadas el rendimiento del almacén de datos?

Las vistas materializadas almacenan los resultados precalculados de las consultas, reduciendo el tiempo de procesamiento de las consultas repetitivas. Esto mejora significativamente el rendimiento, especialmente en consultas analíticas agregadas o complejas.

¿Cómo se integra un almacén de datos con la IA y el aprendizaje automático?

Muchos almacenes modernos soportan cargas de trabajo de ML e IA ofreciendo:

- Funciones ML integradas (por ejemplo, BigQuery ML, Redshift ML)

- Integración con marcos ML (por ejemplo, TensorFlow, PyTorch, Scikit-learn)

- Almacenes de características que permiten a los analistas servir datos estructurados a modelos ML de forma eficiente

¿Qué son las Dimensiones de Cambio Lento (DCL) en un almacén de datos?

Los SCD hacen un seguimiento de los cambios históricos en las tablas de dimensiones. Los tipos más comunes son:

- SCD Tipo 1 - Sobrescribe los datos antiguos con datos nuevos.

- SCD Tipo 2 - Mantiene los datos históricos añadiendo nuevos registros.

- SCD Tipo 3 - Mantiene un historial limitado utilizando columnas adicionales.