Kurs

Die Qualität deiner Daten wirkt sich direkt auf die Genauigkeit deiner Analyse und die Leistung deines Modells aus. Und warum? Denn Rohdaten enthalten oft Ungereimtheiten, Fehler und irrelevante Informationen, die die Ergebnisse verzerren und zu fehlerhaften Erkenntnissen führen können. Die Vorverarbeitung der Daten ist eine Möglichkeit, dieses Problem zu entschärfen. Es ist der Prozess der Umwandlung von Rohdaten in ein sauberes, strukturiertes Format.

In diesem Blogbeitrag werde ich darüber berichten:

- Welche Datenvorverarbeitung?

- Schritte der Datenvorverarbeitung

- Techniken zur Vorverarbeitung von Daten mit Beispielen

- Tools für die Datenvorverarbeitung

- Best Practices für die Datenvorverarbeitung

Lass uns loslegen!

Was ist Datenvorverarbeitung?

Die Datenvorverarbeitung ist ein wichtiger Aspekt der Datenaufbereitung. Sie bezieht sich auf jede Verarbeitung von Rohdaten, um sie für weitere Analysen oder Verarbeitungsaufgaben vorzubereiten.

Traditionell ist die Datenvorverarbeitung ein wichtiger Schritt bei der Datenanalyse. In jüngerer Zeit wurden diese Techniken jedoch angepasst, um maschinelles Lernen und KI-Modelle zu trainieren und daraus Schlüsse zu ziehen.

Die Datenvorverarbeitung kann als Prozess definiert werden, bei dem Rohdaten in ein Format umgewandelt werden, das effizienter und genauer verarbeitet werden kann, z. B. bei Aufgaben wie:

- Datenanalyse

- Maschinelles Lernen

- Datenwissenschaft

- AI

Werde Dateningenieur

Schritte der Datenvorverarbeitung

Die Datenvorverarbeitung umfasst mehrere Schritte, die jeweils spezifische Herausforderungen in Bezug auf Datenqualität, -struktur und -relevanz angehen.

Werfen wir einen Blick auf diese wichtigen Schritte, die in der Regel in der folgenden Reihenfolge ablaufen:

Schritt 1: Datenbereinigung

Bei der Datenbereinigung geht es darum, Fehler oder Unstimmigkeiten in den Daten zu identifizieren und zu korrigieren, um sicherzustellen, dass sie korrekt und vollständig sind. Das Ziel ist es, Probleme zu lösen, die die Analyse oder die Modellleistung verzerren können.

Zum Beispiel:

- Umgang mit fehlenden Werten: Strategien wie Mittelwert-/Modus-Imputation, Löschung oder prädiktive Modelle verwenden, um fehlende Daten zu ergänzen oder zu entfernen.

- Entfernen von Duplikaten: Eliminierung von doppelten Einträgen, um sicherzustellen, dass jeder Eintrag einzigartig und relevant ist.

- Korrektur von inkonsistenten Formaten: Standardisierung von Formaten (z. B. Datumsformate, Groß- und Kleinschreibung), um Konsistenz zu gewährleisten.

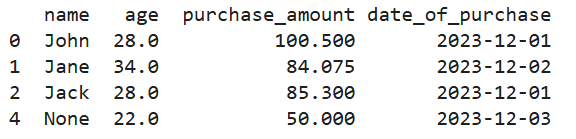

So sieht es in Python aus:

# Creating a manual dataset

data = pd.DataFrame({

'name': ['John', 'Jane', 'Jack', 'John', None],

'age': [28, 34, None, 28, 22],

'purchase_amount': [100.5, None, 85.3, 100.5, 50.0],

'date_of_purchase': ['2023/12/01', '2023/12/02', '2023/12/01', '2023/12/01', '2023/12/03']

})

# Handling missing values using mean imputation for 'age' and 'purchase_amount'

imputer = SimpleImputer(strategy='mean')

data[['age', 'purchase_amount']] = imputer.fit_transform(data[['age', 'purchase_amount']])

# Removing duplicate rows

data = data.drop_duplicates()

# Correcting inconsistent date formats

data['date_of_purchase'] = pd.to_datetime(data['date_of_purchase'], errors='coerce')

print(data)

Ausgabe des obigen Codes

Schritt 2: Datenintegration

Bei der Datenintegration werden Daten aus verschiedenen Quellen kombiniert, um einen einheitlichen Datensatz zu erstellen. Das ist oft notwendig, wenn Daten aus verschiedenen Quellsystemen gesammelt werden.

Einige Techniken, die bei der Datenintegration eingesetzt werden, sind:

- Schemaabgleich: Abgleich von Feldern und Datenstrukturen aus verschiedenen Quellen, um Konsistenz zu gewährleisten.

- Datendeduplizierung: Identifizieren und Entfernen von doppelten Einträgen in mehreren Datensätzen.

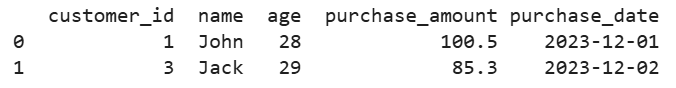

Nehmen wir zum Beispiel an, wir haben Kundendaten aus mehreren Datenbanken. So würden wir sie in einer einzigen Ansicht zusammenführen:

# Creating two manual datasets

data1 = pd.DataFrame({

'customer_id': [1, 2, 3],

'name': ['John', 'Jane', 'Jack'],

'age': [28, 34, 29]

})

data2 = pd.DataFrame({

'customer_id': [1, 3, 4],

'purchase_amount': [100.5, 85.3, 45.0],

'purchase_date': ['2023-12-01', '2023-12-02', '2023-12-03']

})

# Merging datasets on a common key 'customer_id'

merged_data = pd.merge(data1, data2, on='customer_id', how='inner')

print(merged_data)

Ausgabe des obigen Codes

Schritt 3: Datenumwandlung

Bei der Datenumwandlung werden Daten in Formate umgewandelt, die für Analysen, maschinelles Lernen oder Mining geeignet sind.

Zum Beispiel:

- Skalierung und Normalisierung: Die Anpassung numerischer Werte an eine gemeinsame Skala ist oft für Algorithmen notwendig, die auf Distanzmetriken beruhen.

- Kodierung kategorischer Variablen: Umwandlung von kategorischen Daten in numerische Werte mithilfe von One-Hot- oder Label-Codierungstechniken.

- Feature Engineering und Extraktion: Erstelle neue Merkmale oder wähle wichtige Merkmale aus, um die Leistung des Modells zu verbessern.

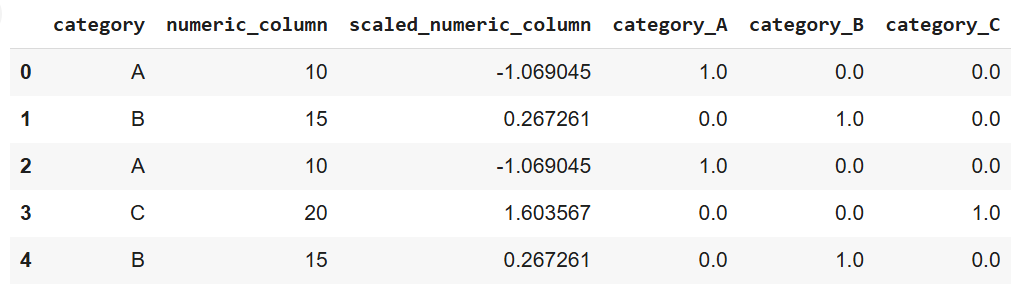

So sieht es in Python aus, wenn du Scikit-Learn verwendest:

from sklearn.preprocessing import StandardScaler, OneHotEncoder

# Creating a manual dataset

data = pd.DataFrame({

'category': ['A', 'B', 'A', 'C', 'B'],

'numeric_column': [10, 15, 10, 20, 15]

})

# Scaling numeric data

scaler = StandardScaler()

data['scaled_numeric_column'] = scaler.fit_transform(data[['numeric_column']])

# Encoding categorical variables using one-hot encoding

encoder = OneHotEncoder(sparse_output=False)

encoded_data = pd.DataFrame(encoder.fit_transform(data[['category']]),

columns=encoder.get_feature_names_out(['category']))

# Concatenating the encoded data with the original dataset

data = pd.concat([data, encoded_data], axis=1)

print(data)

Ausgabe des obigen Codes

Schritt 4: Datenreduktion

Bei der Datenreduzierung wird der Datensatz vereinfacht, indem die Anzahl der Merkmale oder Datensätze reduziert wird, während die wesentlichen Informationen erhalten bleiben. Das hilft, die Analyse und das Modelltraining zu beschleunigen, ohne die Genauigkeit zu beeinträchtigen.

Zu den Techniken zur Datenreduzierung gehören:

- Auswahl der Merkmale: Auswahl der wichtigsten Merkmale, die zur Leistung der Analyse oder des Modells beitragen.

- Hauptkomponentenanalyse (PCA): Eine Technik zur Dimensionalitätsreduzierung, die Daten in einen niedrigdimensionalen Raum transformiert.

- Stichprobenmethoden: Die Verkleinerung des Datensatzes durch die Auswahl repräsentativer Stichproben ist nützlich für die Bearbeitung großer Datensätze.

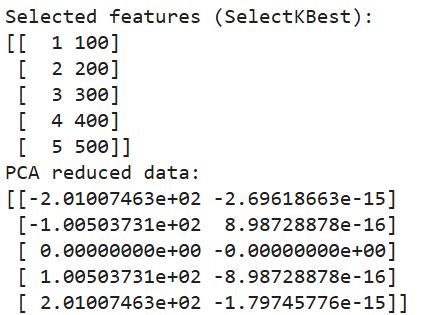

Und hier ist, wie wir die Dimensionalitätsreduktion in Python umsetzen:

from sklearn.decomposition import PCA

from sklearn.feature_selection import SelectKBest, chi2

# Creating a manual dataset

data = pd.DataFrame({

'feature1': [10, 20, 30, 40, 50],

'feature2': [1, 2, 3, 4, 5],

'feature3': [100, 200, 300, 400, 500],

'target': [0, 1, 0, 1, 0]

})

# Feature selection using SelectKBest

selector = SelectKBest(chi2, k=2)

selected_features = selector.fit_transform(data[['feature1', 'feature2', 'feature3']], data['target'])

# Printing selected features

print("Selected features (SelectKBest):")

print(selected_features)

# Dimensionality reduction using PCA

pca = PCA(n_components=2)

pca_data = pca.fit_transform(data[['feature1', 'feature2', 'feature3']])

# Printing PCA results

print("PCA reduced data:")

print(pca_data)

Ausgabe des obigen Codes

Allgemeine Techniken zur Datenvorverarbeitung mit Beispielen

Wir haben festgestellt, dass die Vorverarbeitung von Rohdaten wichtig ist, um sicherzustellen, dass sie für die Analyse oder für maschinelle Lernmodelle gut geeignet sind. Wir haben auch die einzelnen Schritte des Prozesses beschrieben.

In diesem Abschnitt werden wir uns mit verschiedenen Techniken befassen, um häufige Probleme in der Vorverarbeitungsphase zu lösen. Außerdem werden wir uns mit der Datenerweiterung befassen, einer nützlichen Technik zur Erstellung synthetischer Daten in bestimmten Kontexten wie Bild- oder Textdatensätzen.

Umgang mit fehlenden Daten

Fehlende Daten können sich negativ auf die Leistung eines maschinellen Lernmodells oder einer Analyse auswirken. Es gibt verschiedene Strategien, um fehlende Werte effektiv zu behandeln:

- Anrechnung: Bei dieser Technik werden fehlende Werte mit einem berechneten Schätzwert aufgefüllt, z. B. mit dem Mittelwert, dem Median oder dem Modus der verfügbaren Daten. Zu den fortgeschrittenen Methoden gehört die prädiktive Modellierung, bei der fehlende Werte anhand von Beziehungen innerhalb der Daten vorhergesagt werden.

# Note: This is dummy code and not expected to run on its own

from sklearn.impute import SimpleImputer

imputer = SimpleImputer(strategy='mean') # Replace 'mean' with 'median' or 'most_frequent' if needed

data['column_with_missing'] = imputer.fit_transform(data[['column_with_missing']])- Löschung: Das Entfernen von Zeilen oder Spalten mit fehlenden Werten ist eine unkomplizierte Lösung. Sie sollte jedoch mit Bedacht eingesetzt werden, da sie zum Verlust wertvoller Daten führen kann, vor allem wenn viele Einträge fehlen.

data.dropna(inplace=True) # Removes rows with any missing values- Modellierung fehlender Werte: In Fällen, in denen das Muster der fehlenden Daten komplexer ist, können maschinelle Lernmodelle die fehlenden Werte auf der Grundlage des restlichen Datensatzes vorhersagen. Dies kann die Genauigkeit verbessern, indem Beziehungen zwischen verschiedenen Variablen berücksichtigt werden.

Erkennung und Entfernung von Ausreißern

Ausreißer sind Extremwerte, die erheblich vom Rest der Daten abweichen und die, ebenso wie fehlende Werte, die Analyse und die Modellleistung verzerren können. Um Ausreißer zu erkennen und zu behandeln, können verschiedene Techniken eingesetzt werden:

- Z-Score-Methode: Dieser Ansatz misst, wie viele Standardabweichungen ein Datenpunkt vom Mittelwert abweicht. Datenpunkte, die einen bestimmten Schwellenwert überschreiten (z. B. ±3 Standardabweichungen), können als Ausreißer betrachtet werden.

# Note: this is dummy code.

# It won’t work unless a data with a column named “column” is imported

from scipy import stats

z_scores = stats.zscore(data['column']) outliers = abs(z_scores) > 3 # Identifying outliers- Interquartilsbereich (IQR): IQR ist der Bereich zwischen dem ersten Quartil (Q1) und dem dritten Quartil (Q3). Werte, die mehr als das 1,5-fache des IQR über Q3 oder unter Q1 liegen, gelten als Ausreißer.

Q1 = data['column'].quantile(0.25)

Q3 = data['column'].quantile(0.75)

IQR = Q3 - Q1

outliers = (data['column'] < (Q1 - 1.5 * IQR)) | (data['column'] > (Q3 + 1.5 * IQR))- Visuelle Techniken: Visualisierungsmethoden wie Boxplots, Streudiagramme oder Histogramme können helfen, Ausreißer in einem Datensatz zu erkennen. Sobald Ausreißer identifiziert sind, können sie entweder entfernt oder umgewandelt werden, je nachdem, welchen Einfluss sie auf die Analyse haben.

Datenkodierung

Bei der Arbeit mit kategorialen Daten ist eine Kodierung notwendig, um die Kategorien in numerische Darstellungen umzuwandeln, die maschinelle Lernalgorithmen verarbeiten können. Zu den gängigen Kodierungstechniken gehören:

- One-Hot-Codierung: Wie bereits erwähnt, erstelltdiese Methode binäre Spalten für jede Kategorie.

from sklearn.preprocessing import OneHotEncoder

encoder = OneHotEncoder(sparse_output=False)

encoded_data = encoder.fit_transform(data[['categorical_column']])- Kodierung des Labels: Bei der Label-Codierung wird jeder Kategorie ein eindeutiger numerischer Wert zugewiesen. Diese Methode kann jedoch zu einer unbeabsichtigten ordinalen Beziehung zwischen den Kategorien führen, wenn sie keine natürliche Reihenfolge haben.

from sklearn.preprocessing import LabelEncoder

le = LabelEncoder()

data['encoded_column'] = le.fit_transform(data['categorical_column'])- Ordinale Kodierung: Ordinale Kodierung wird verwendet, wenn kategoriale Variablen eine inhärente Reihenfolge haben, wie niedrig, mittel und hoch. Jeder Kategorie wird ein entsprechender ganzzahliger Wert zugeordnet, der ihre Rangfolge widerspiegelt.

from sklearn.preprocessing import OrdinalEncoder

oe = OrdinalEncoder(categories=[['low', 'medium', 'high']])

data['ordinal_column'] = oe.fit_transform(data[['ordinal_column']])Skalierung und Normalisierung von Daten

Skalierung und Normalisierung stellen sicher, dass die numerischen Merkmale auf einer ähnlichen Skala liegen. Das ist besonders wichtig für Algorithmen, die auf Abstandsmetriken beruhen (z. B. k-nearest neighbors, SVMs).

- Min-Max-Skalierung: Diese Technik skaliert Daten auf einen bestimmten Bereich, in der Regel 0 bis 1. Sie ist nützlich, wenn alle Merkmale den gleichen Maßstab haben müssen.

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

data[['scaled_column']] = scaler.fit_transform(data[['numeric_column']])- Standardisierung (Z-Score-Normalisierung): Bei dieser Methode werden die Daten so skaliert, dass der Mittelwert 0 und die Standardabweichung 1 wird, damit die Modelle bei normalverteilten Merkmalen besser funktionieren.

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

data[['standardized_column']] = scaler.fit_transform(data[['numeric_column']])Datenerweiterung

Die Datenerweiterung ist eine Technik zur künstlichen Vergrößerung eines Datensatzes durch die Erstellung neuer, synthetischer Beispiele. Dies ist besonders nützlich für Bild- oder Textdatensätze in Deep Learning-Modellen, wo große Datenmengen für eine robuste Modellleistung erforderlich sind.

- Bildvergrößerung: Techniken wie Drehen, Spiegeln, Skalieren oder das Hinzufügen von Rauschen zu Bildern helfen, Variationen zu erzeugen, die die Modellgeneralisierung verbessern.

from tensorflow.keras.preprocessing.image import ImageDataGenerator

datagen = ImageDataGenerator(

rotation_range=40,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest')

augmented_images = datagen.flow_from_directory('image_directory', target_size=(150, 150))- Textergänzung: Bei Textdaten gehören zu den Augmentierungsmethoden das Ersetzen von Synonymen, das zufällige Einfügen von Wörtern und die Rückübersetzung, bei der ein Satz in eine andere Sprache und dann zurück in die ursprüngliche Sprache übersetzt wird, wobei Variationen eingeführt werden.

import nlpaug.augmenter.word as naw

# install nlpaug here: https://github.com/makcedward/nlpaug

aug = naw.SynonymAug(aug_src='wordnet')

augmented_text = aug.augment("This is a sample text for augmentation.")Tools für die Datenvorverarbeitung

Du kannst die Datenverarbeitung zwar mit reinem Python-Code implementieren, aber es wurden auch leistungsstarke Tools entwickelt, um verschiedene Aufgaben zu erledigen und den gesamten Prozess effizienter zu gestalten. Hier sind ein paar Beispiele:

Python-Bibliotheken

Es gibt eine ganze Reihe spezialisierter Bibliotheken für die Datenvorverarbeitung in Python. Hier sind 3 der beliebtesten:

- Pandas: Die meistgenutzte Bibliothek in Python für die Datenbearbeitung und -bereinigung. Es bietet flexible Datenstrukturen, vor allem DataFrame und Series, mit denen du strukturierte Daten effizient verarbeiten und manipulieren kannst. Pandas unterstützt Operationen wie den Umgang mit fehlenden Daten, das Zusammenführen von Datensätzen, das Filtern von Daten und die Umformung.

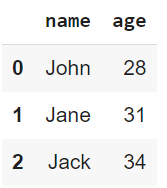

import pandas as pd

# Load a sample dataset

data = pd.DataFrame({

'name': ['John', 'Jane', 'Jack'],

'age': [28, 31, 34]

})

print(data)

Ausgabe des obigen Codes

- NumPy: Eine grundlegende Bibliothek für numerische Berechnungen. Es unterstütztgroße, mehrdimensionale Arrays und Matrizen sowie mathematische Funktionen, die mit diesen Arrays arbeiten. NumPy ist oft die Grundlage für viele höherstufige Datenverarbeitungsbibliotheken, wie z.B. Pandas.

import numpy as np

# Create an array and perform element-wise operations

array = np.array([1, 2, 3, 4])

squared_array = np.square(array)

print(squared_array)![]()

Ausgabe des obigen Codes

- Scikit-learn: Sie wird häufig für maschinelle Lernaufgaben verwendet, bietet aber auch zahlreiche Vorverarbeitungsfunktionen wie Skalierung, Kodierung und Datentransformation. Das Vorverarbeitungsmodul enthält Werkzeuge zur Verarbeitung kategorischer Daten, zur Skalierung numerischer Daten, zur Merkmalsextraktion und mehr.

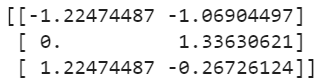

from sklearn.preprocessing import StandardScaler

# Standardize data

data = [[10, 2], [15, 5], [20, 3]]

scaler = StandardScaler()

scaled_data = scaler.fit_transform(data)

print(scaled_data)

Ausgabe des obigen Codes

Cloud-Plattformen

Vor Ort installierte Systeme können große Datenmengen möglicherweise nicht effektiv verarbeiten. In solchen Situationen bieten Cloud-Plattformen skalierbare, effiziente Lösungen, mit denen du große Datenmengen über verteilte Systeme hinweg verarbeiten kannst.

Einige Cloud-Plattform-Tools, die du in Betracht ziehen solltest, sind:

- AWS-Kleber: Ein vollständig verwalteter ETL-Service von AmazonWeb Services. Es entdeckt und organisiert Daten automatisch und bereitet sie für Analysen vor. Glue unterstützt die Katalogisierung von Daten und kann sich mit AWS-Diensten wie S3 und Redshift verbinden.

- Azure Data Factory: Ein Cloud-basierter Datenintegrationsdienst von Microsoft. Es unterstützt den Aufbau von ETL und ELT-Pipelines für große Datenmengen. Azure Data Factory ermöglicht es, Daten zwischen verschiedenen Diensten zu verschieben, sie mithilfe von Transformationen vorzuverarbeiten und Workflows über eine visuelle Schnittstelle zu orchestrieren.

Automatisierungstools

Die Automatisierung der sich wiederholenden Schritte der Datenvorverarbeitung kann Zeit sparen und Fehler reduzieren - vor allem, wenn du mit Machine-Learning-Modellen und großen Datensätzen arbeitest. Hier sind einige Tools, die integrierte Preprocessing-Pipelines anbieten:

- AutoML-Plattformen: AutoML ist die Abkürzung für Automated Machine Learning (und es bedeutet, was auf der Verpackung steht). Mit anderen Worten: Diese Plattformen automatisieren mehrere Phasen des maschinellen Lernprozesses. Die Plattformen like Google's AutoML, Microsoft's Azure AutoML und H2O.ai's AutoML bieten automatisierte Pipelines, die Aufgaben wie die Auswahl von Merkmalen, die Datenumwandlung und die Modellauswahl mit minimalen Benutzereingriffen erledigen.

- Preprocessing-Pipelines in Scikit-Learn: Scikit-learn stelltdie Klasse Pipeline zur Verfügung, mit der dieeamline und die Vorverarbeitungsschritte automatisiert werden können. Damit kannst du mehrere Vorverarbeitungsvorgänge in einem einzigen, ausführbaren Arbeitsablauf zusammenfassen und sicherstellen, dass die Vorverarbeitungsaufgaben einheitlich durchgeführt werden:

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.impute import SimpleImputer

from sklearn.compose import ColumnTransformer

# Example Pipeline combining different preprocessing tasks

numeric_transformer = Pipeline(steps=[

('imputer', SimpleImputer(strategy='mean')),

('scaler', StandardScaler())

])

categorical_transformer = Pipeline(steps=[

('imputer', SimpleImputer(strategy='most_frequent')),

('encoder', OneHotEncoder())

])

preprocessor = ColumnTransformer(transformers=[

('num', numeric_transformer, ['age']),

('cat', categorical_transformer, ['category'])

])

preprocessed_data = preprocessor.fit_transform(data)Best Practices für die Datenvorverarbeitung

Es ist wichtig, dass du die besten Praktiken befolgst, um die Effektivität deiner Vorverarbeitung zu maximieren. Im Folgenden findest du einige Praktiken, die ich dir ans Herz legen möchte:

Verstehe die Daten

Bevor du mit der Vorverarbeitung beginnst, ist es wichtig, dass du den Datensatz genau verstehst. Führe eine explorative Datenanalyse durch, um die Struktur der vorliegenden Daten zu ermitteln. Was du genau verstehen willst, sind:

- Wesentliche Merkmale

- Mögliche Anomalien

- Beziehungen

Wenn du die Eigenschaften des Datensatzes nicht kennst, ist es sehr wahrscheinlich, dass du falsche Vorverarbeitungsmethoden anwendest und die Daten dadurch verzerrt werden.

Sich wiederholende Schritte automatisieren

Die Vorverarbeitung umfasst oft sich wiederholende Aufgaben. Die Automatisierung dieser Aufgaben durch den Aufbau von Pipelines sorgt für Konsistenz und Effizienz und verringert die Wahrscheinlichkeit von manuellen Fehlern. Um Arbeitsabläufe zu rationalisieren, kannst du Pipelines in Tools wie Scikit-Learn oder cloudbasierte Plattformen nutzen.

Schritte zur Vorverarbeitung von Dokumenten

Eine klare Dokumentation hilft, zwei Ziele zu erreichen:

- Reproduzierbarkeit

- Verstehen (für dich selbst zu einem späteren Zeitpunkt oder für andere in deinem Team).

Jede Entscheidung, Umwandlung oder Filterung sollte aufgezeichnet werden, einschließlich der Gründe dafür. Dadurch wird die Zusammenarbeit zwischen den Teammitgliedern deutlich verbessert und du kannst Projekte dort fortsetzen, wo du aufgehört hast.

Iterative Verbesserungen

Die Datenvorverarbeitung ist keine einmalige Aufgabe - sie sollte ein iterativer Prozess sein. Wenn sich die Modelle weiterentwickeln und Rückmeldungen zu ihrer Leistung liefern, kannst du diese Informationen nutzen, um die Vorverarbeitungsschritte zu überarbeiten und zu verfeinern, da dies zu besseren Ergebnissen führen kann. So kann zum Beispiel das Feature-Engineering neue nützliche Merkmale zutage fördern oder die Behandlung von Ausreißern die Modellgenauigkeit verbessern - nutze dieses Feedback, um deine Vorverarbeitungsschritte zu aktualisieren.

Fazit

Die Datenvorverarbeitung spielt eine entscheidende Rolle für den Erfolg eines jeden Datenprojekts. Die richtige Vorverarbeitung sorgt dafür, dass die Rohdaten in ein sauberes, strukturiertes Format umgewandelt werden, damit die Modelle und Analysen genauere und aussagekräftigere Erkenntnisse liefern.

In diesem Artikel habe ich verschiedene Techniken vorgestellt, die bei der Datenvorverarbeitung helfen. Das Wichtigste ist jedoch, dass dieser Prozess keine einmalige Anstrengung ist, sondern ein iterativer Prozess! Die kontinuierliche Verfeinerung führt zu einer verbesserten Modellleistung und einer besseren Entscheidungsfindung. Ein gut aufbereiteter Datensatz ist die Grundlage für jede erfolgreiche Daten-KI-Initiative.

Um dich weiterzubilden, empfehle ich dir, die folgenden ausgezeichneten Ressourcen zu lesen:

Werde ein ML-Wissenschaftler