programa

Técnicas avanzadas para sistemas de generación mejorada por recuperación (RAG)

La generación aumentada de recuperación (RAG) combina la recuperación de documentos con la generación de lenguaje natural, creando respuestas más precisas y conscientes del contexto.

Aunque el GAR básico es eficaz, tiene dificultades con las consultas complejas, las alucinaciones y el mantenimiento del contexto en conversaciones de varios turnos.

En este blog, exploraré técnicas avanzadas que abordan estos retos mejorando la precisión de la recuperación, la calidad de la generación y el rendimiento general del sistema.

Si estás leyendo esto como preparación para una entrevista, asegúrate de consultar las Las 30 mejores preguntas y respuestas para una entrevista RAG artículo.

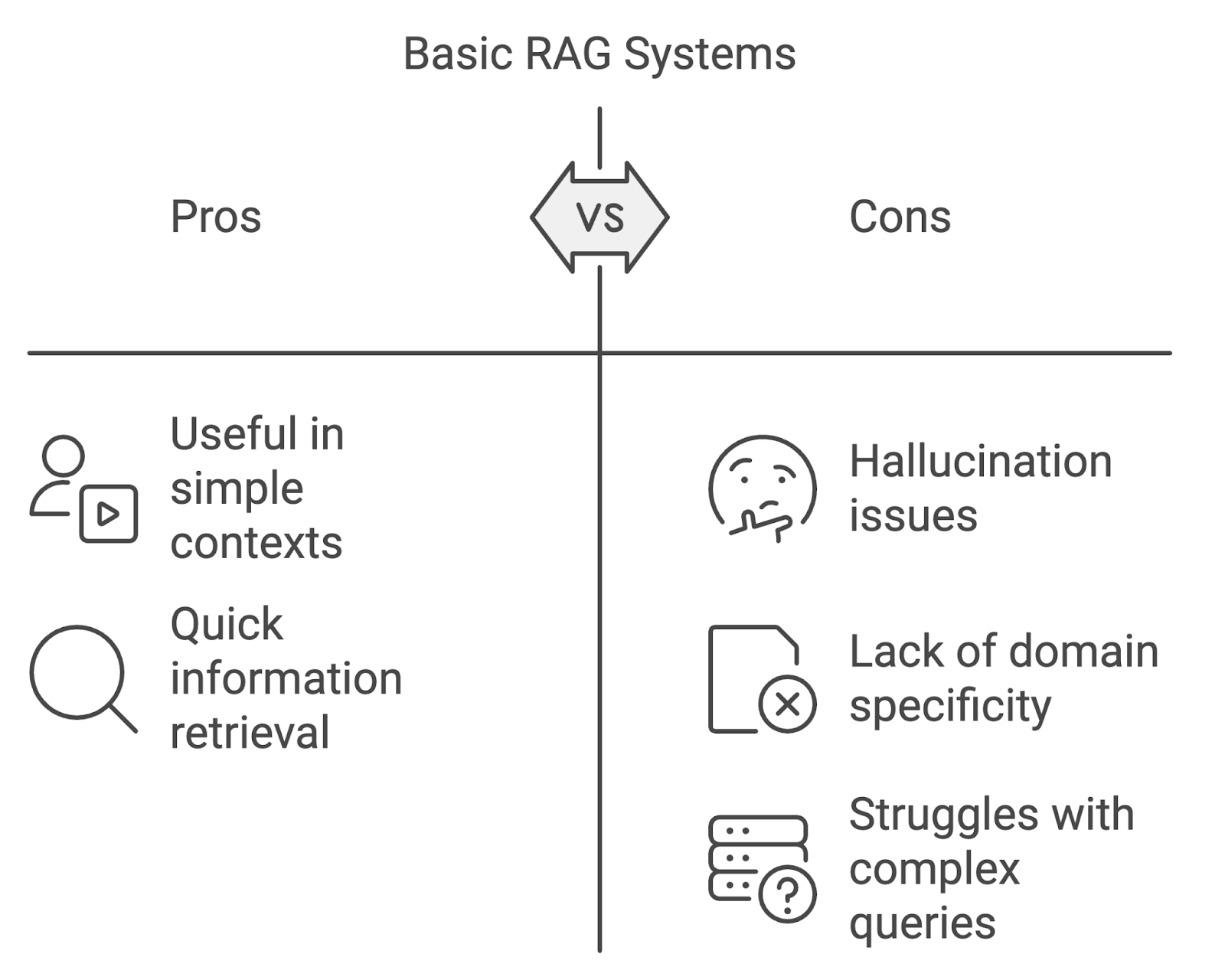

Limitaciones de los sistemas básicos de GAR

Aunque las implementaciones básicas de la GAR pueden ser útiles, tienen sus limitaciones, sobre todo cuando se aplican en contextos más exigentes.

Alucinación

Uno de los problemas más destacados es la alucinación, en la que el modelo genera contenidos que son objetivamente incorrectos o que no están respaldados por los documentos recuperados. Esto puede socavar la fiabilidad del sistema, especialmente en campos que requieren una gran precisión, como la medicina o la abogacía.

Falta de especificidad de dominio

Los modelos GAR estándar pueden tener dificultades cuando se trata de consultas específicas de un dominio. Sin adaptar los procesos de recuperación y generación a los matices de los dominios especializados, el sistema corre el riesgo de recuperar información irrelevante o inexacta.

Manejar conversaciones complejas o de varios turnos

Otro reto es gestionar consultas complejas de varios pasos o conversaciones de varios turnos. Los sistemas básicos de GAR a menudo tienen dificultades para mantener el contexto a lo largo de las interacciones, lo que da lugar a respuestas inconexas o incompletas. A medida que las consultas de los usuarios se hacen más complejas, los sistemas GAR tienen que evolucionar para gestionar esta creciente complejidad.

Diagrama generado con napkin.ai

Técnicas avanzadas de recuperación

Las técnicas avanzadas de recuperación se centran en mejorar tanto la relevancia como el alcance de los documentos recuperados. Estas técnicas, que incluyen la recuperación densa, la búsqueda híbrida, el reranking y la expansión de consultas, abordan las limitaciones de la recuperación basada en palabras clave.

Recuperación densa y búsqueda híbrida

La recuperación densa y la búsqueda híbrida son técnicas clave para mejorar la precisión y la relevancia de la recuperación. Métodos como el TF-IDF o el BM25 suelen tener problemas de comprensión semántica cuando las consultas están redactadas de forma diferente a los documentos.

La recuperación densa, como DPR (Dense Passage Retrieval), utiliza aprendizaje profundo para mapear consultas y documentos en representaciones vectorialescapturando el significado del texto más allá de las palabras clave exactas.

La búsqueda híbrida combina la recuperación dispersa y la densa, equilibrando la precisión y la recuperación al combinar la coincidencia basada en palabras clave con la similitud semántica, lo que la hace eficaz para consultas más complejas.

Nueva clasificación

El reordenamiento es otra técnica avanzada que se utiliza para refinar la lista de documentos recuperados antes de pasarlos al componente de generación. En un sistema GAR típico, la fase inicial de recuperación puede producir un gran conjunto de documentos que varían en relevancia.

La función del reordenamiento es reordenar estos documentos para que el modelo lingüístico dé prioridad a los más relevantes. La reordenación puede realizarse desde una simple puntuación basada en la similitud consulta-documento hasta modelos más complejos de aprendizaje automático entrenados para predecir la relevancia de cada documento.

Puedes aprender a implementar el reranking en este tutorial sobre reranking con RankGPT.

Ampliación de la consulta

La expansión de la consulta consiste en enriquecer la consulta del usuario con términos adicionales que aumenten las posibilidades de recuperar documentos relevantes. Se puede conseguir mediante:

- Expansión de sinónimos: Añadir sinónimos o términos estrechamente relacionados a la consulta original para capturar documentos que pueden utilizar una redacción diferente pero transmitir significados similares.

- Ampliación conceptual: Ampliar la consulta para incluir conceptos más amplios o relacionados que podrían ayudar a hacer aflorar documentos más diversos pero relevantes.

Por ejemplo, si la consulta original es "inteligencia artificial en sanidad", la ampliación de la consulta podría incluir términos relacionados como "IA", "aprendizaje automático" o "tecnología sanitaria", garantizando una red de recuperación más amplia.

Optimizar la pertinencia y la calidad en los sistemas GAR

En los sistemas RAG, no basta con recuperar documentos, sino que es fundamental garantizar la pertinencia y la calidad de esos documentos para mejorar el resultado final. Para ello, son vitales las técnicas avanzadas que refinan y filtran el contenido recuperado.

Estos métodos funcionan para reducir el ruido, potenciar la relevancia y centrar el modelo lingüístico en la información más importante durante el proceso de generación.

Técnicas avanzadas de filtrado

Las técnicas avanzadas de filtrado utilizan metadatos o reglas basadas en el contenido para excluir los documentos irrelevantes o de baja calidad, garantizando que sólo se transmitan los resultados más relevantes.

- Filtrado basado en metadatos: Los documentos pueden filtrarse en función de metadatos como la fecha, el autor, el dominio o el tipo de documento. En aplicaciones jurídicas o médicas, esto puede garantizar que sólo se utilicen las fuentes más recientes o autorizadas.

- Filtrado basado en el contenido: Evalúa el contenido de los propios documentos, aplicando reglas para excluir los que no cumplan determinados umbrales de relevancia. También podría implicar el filtrado de documentos con baja similitud semántica con la consulta o de documentos que no incluyan frases o términos clave relacionados con la consulta.

Destilación del contexto

La destilación del contexto es el proceso de resumir o condensar los documentos recuperados para centrar el modelo lingüístico en las piezas de información más importantes. Esto es útil cuando los documentos recuperados contienen demasiado contenido irrelevante o cuando la consulta implica un razonamiento complejo de varios pasos.

Al destilar el contexto, el sistema extrae las ideas clave y los pasajes más relevantes de los documentos recuperados, garantizando que el modelo lingüístico tenga la información más clara y pertinente con la que trabajar.

Optimización del Proceso de Generación

Una vez recuperados y depurados los documentos relevantes, el siguiente paso en un sistema GAR es el proceso de generación. Optimizar la forma en que el modelo lingüístico genera las respuestas es esencial para establecer la precisión, la coherencia y la relevancia.

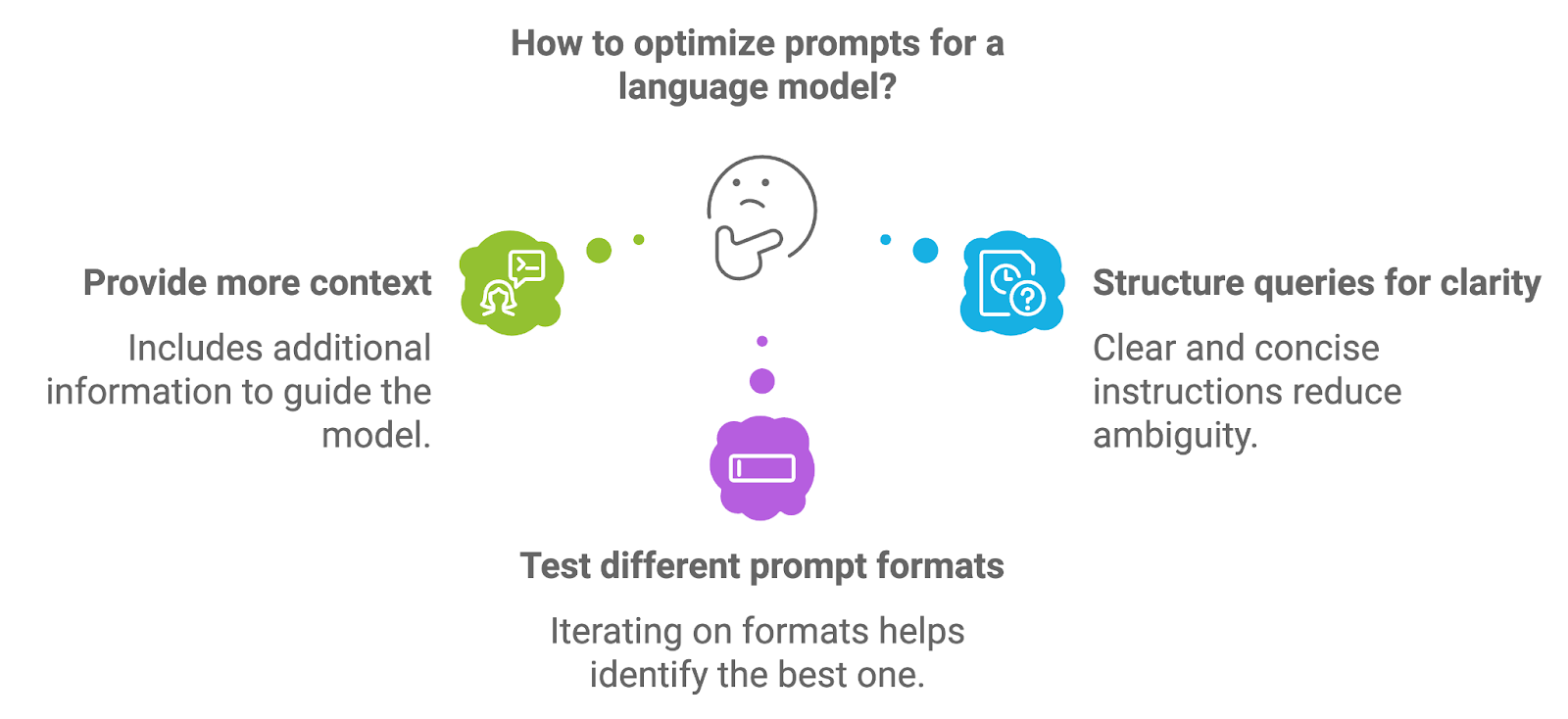

Ingeniería rápida

Ingeniería de instrucciones se refiere al proceso de diseño y estructuración de las instrucciones que se introducen en el modelo lingüístico. La calidad de la indicación influye directamente en la calidad del resultado generado por el modelo, ya que la indicación proporciona las instrucciones iniciales o el contexto para la tarea de generación.

Diagrama generado con napkin.ai

Para optimizar los avisos, los desarrolladores pueden experimentar con algunos enfoques diferentes.

Proporcionar más contexto

Incluir información adicional, como instrucciones explícitas o términos clave, puede guiar al modelo hacia respuestas más precisas y contextualmente relevantes. Por ejemplo, en un sistema RAG médico, una solicitud puede pedir explícitamente que el modelo proporcione un resumen del diagnóstico basado en los documentos recuperados.

Estructurar las consultas para mayor claridad

Las indicaciones bien estructuradas, con instrucciones claras y concisas, ayudan a reducir la ambigüedad y conducen a resultados de generación más centrados. Plantear la cuestión como una pregunta o petición directa suele dar mejores resultados.

Probar diferentes formatos de aviso

Iterar los formatos de los avisos, como reformular las preguntas, ajustar el nivel de especificidad o proporcionar ejemplos, puede ayudar a identificar el formato que ofrece los mejores resultados para un caso de uso específico.

Más información en este blog: Técnicas de Optimización Prompt.

Razonamiento en varios pasos

Muchas consultas, sobre todo en ámbitos como la investigación, el derecho o la asistencia técnica, implican múltiples pasos o requieren razonamientos complejos. El razonamiento en varios pasos es el proceso mediante el cual un sistema descompone una consulta compleja en subtareas manejables y las procesa secuencialmente para llegar a una respuesta completa.

Podemos implementar el razonamiento multipaso dentro de un sistema GAR de numerosas formas:

- Encadenamiento de recuperación y generación: En algunos casos, se puede conseguir un razonamiento de varios pasos encadenando los pasos de recuperación y generación. Tras procesar una consulta inicial, el sistema podría generar una consulta de seguimiento o solicitar información adicional antes de generar la respuesta final.

- Incorporación de pasos intermedios: Para consultas que requieran razonar sobre múltiples documentos o temas, el sistema podría recuperar diferentes conjuntos de documentos para cada paso, construyendo gradualmente una respuesta más matizada y completa.

- Respuesta a preguntas multisalto: Este enfoque permite al sistema establecer conexiones lógicas entre las distintas piezas de información recuperada, lo que le permite gestionar consultas más sofisticadas que implican relaciones entre varios hechos o puntos de datos.

Abordar la alucinación

Como se ha mencionado brevemente, uno de los principales retos de los modelos de generación, incluidos los utilizados en los sistemas GAR, es la alucinación. Varias técnicas pueden ayudar a mitigar las alucinaciones en los sistemas GAR:

- Fundamentación en documentos recuperados: Una de las formas más eficaces de reducir las alucinaciones es asegurarse de que el modelo de generación esté bien fundamentado en el contenido recuperado. Esto significa condicionar el modelo para que sólo genere respuestas basadas en el contenido real de los documentos, en lugar de basarse en conocimientos externos preentrenados.

- Condicionamiento del contexto: Afinando cómo se proporciona el contexto al modelo, los desarrolladores pueden controlar mejor el proceso de generación. Esto podría implicar filtrar las partes irrelevantes de los documentos recuperados antes de pasarlos al modelo o proporcionar instrucciones específicas que guíen al modelo para que se centre en la información clave.

- Circuitos de retroalimentación: Implementar un mecanismo de retroalimentación en el que el sistema compruebe la exactitud de los resultados generados comparándolos con los documentos recuperados puede ayudar a detectar las alucinaciones antes de que lleguen al usuario. Este paso de verificación adicional puede mejorar significativamente la fiabilidad del sistema.

Manejar consultas y conversaciones complejas

A medida que los sistemas GAR se aplican cada vez más a tareas del mundo real, deben ser capaces de manejar interacciones complejas de varios giros y consultas ambiguas.

Gestionar conversaciones multiturno

Uno de los principales retos de los sistemas RAG conversacionales es gestionar el flujo de información a través de múltiples interacciones. En muchos escenarios cotidianos, como la atención al cliente o las discusiones técnicas en curso, los usuarios suelen participar en conversaciones de varios turnos en las que el contexto debe mantenerse a lo largo de varios intercambios.

Hacer que el sistema rastree y recuerde las partes relevantes de la conversación es clave para dar respuestas coherentes y consistentes. Para gestionar eficazmente las conversaciones multiturno, los sistemas GAR pueden utilizar las siguientes técnicas:

- Seguimiento del historial de conversaciones: Mantener una representación estructurada de la historia de la conversación desempeña un papel importante. Esto puede implicar guardar interacciones clave, como consultas anteriores y respuestas generadas, para utilizarlas como contexto en turnos posteriores.

- Ventana contextual: Utilizar una ventana contextual que se actualiza dinámicamente a medida que avanza la conversación permite al sistema centrarse en las partes más relevantes de la interacción. Al limitar el alcance del historial de conversaciones a los intercambios más recientes o críticos, el sistema puede permanecer centrado sin abrumar al modelo de generación con información excesiva.

- Memoria basada en la recuperación: Para conversaciones especialmente complejas o largas, los sistemas GAR pueden aplicar un mecanismo de memoria basado en la recuperación. Este enfoque permite que el sistema recupere selectivamente partes relevantes del historial de la conversación cuando sea necesario, garantizando que sólo se pase al modelo lingüístico el contexto más pertinente.

Tratamiento de consultas ambiguas o complejas

Las consultas de los usuarios no siempre son sencillas, muchas veces pueden ser vagas, ambiguas o implicar razonamientos complejos que desafían las capacidades de un sistema GAR.

Desambiguación mediante la clarificación

Una forma de abordar la ambigüedad es pedir al sistema que pida aclaraciones al usuario. Por ejemplo, si la consulta es demasiado vaga, el sistema puede generar una pregunta de seguimiento pidiendo más detalles. Este proceso interactivo ayuda a delimitar la intención del usuario antes de proceder a las fases de recuperación y generación.

Procesamiento versátil de consultas

Para consultas complejas que implican múltiples aspectos o subtemas, el sistema puede descomponer la consulta en partes más pequeñas y manejables. Se trata de recuperar la información por etapas, en las que cada etapa aborda un aspecto concreto de la consulta. El resultado final se sintetiza a partir de múltiples pasos de recuperación y generación, garantizando que se abordan todos los componentes de la consulta.

Utilizar pistas contextuales

Para manejar la ambigüedad, el sistema puede utilizar pistas contextuales de la consulta o del historial de la conversación. Analizando interacciones anteriores o temas relacionados, el sistema GAR puede inferir la intención del usuario con mayor precisión, reduciendo la probabilidad de generar respuestas irrelevantes o incorrectas.

Técnicas avanzadas de recuperación para consultas complejas

Para consultas especialmente difíciles, los sistemas RAG pueden aplicar métodos avanzados de recuperación, como la respuesta a preguntas de varios saltos, en la que el sistema recupera información de varios documentos y establece conexiones lógicas entre ellos para responder a consultas complejas.

Afrontar los retos comunes de los GAR

Aunque los sistemas GAR ofrecen soluciones potentes para la recuperación de información y la generación de textos, también introducen retos específicos que hay que abordar.

Afrontar los prejuicios en la generación

Sesgo en los modelos lingüísticos, incluidos los utilizados en los sistemas GAR, es un problema bien conocido que puede afectar negativamente a la imparcialidad y precisión de los resultados generados. El sesgo puede entrar en el sistema tanto en la fase de recuperación como en la de generación, dando lugar a resultados sesgados o discriminatorios que reflejen los sesgos sociales, culturales o específicos del ámbito presentes en los conjuntos de datos subyacentes.

Para mitigar el sesgo en los sistemas GAR, podemos aplicar varias estrategias:

- Bias-aware retrieval: Los sesgos en la fase de recuperación pueden surgir cuando los documentos recuperados representan de forma desproporcionada determinados puntos de vista, demografía o perspectivas. Aplicando técnicas de filtrado para garantizar la diversidad en los documentos recuperados, como equilibrar las fuentes en función de la autoría, el intervalo de fechas o la geografía, los sistemas GAR pueden reducir la probabilidad de una recuperación sesgada.

- Equidad en la generación: El sesgo en la fase de generación puede producirse si el modelo lingüístico se entrena con datos que contienen contenido sesgado o si el modelo amplifica ciertas perspectivas sobre otras. Una forma de mitigarlo es afinar el modelo en conjuntos de datos curados diseñados para minimizar el sesgo, garantizando que las respuestas generadas sean lo más neutrales y justas posible.

- Filtrado posterior a la generación: Implementar pasos de post-procesamiento en los que se analice el resultado generado en busca de contenido sesgado o perjudicial puede reducir aún más el sesgo. Estos filtros pueden marcar o modificar las salidas problemáticas antes de que se presenten al usuario, garantizando que la salida final cumpla los criterios de imparcialidad.

Gastos generales de cálculo

A medida que los sistemas GAR se hacen más complejos con la integración de técnicas avanzadas de recuperación y generación, las exigencias informáticas también aumentan. Este reto se manifiesta en aspectos como el tamaño del modelo, la velocidad de procesamiento y la latencia, que pueden afectar a la eficacia y escalabilidad del sistema.

Para gestionar los gastos generales de cálculo, los desarrolladores pueden emplear las siguientes optimizaciones:

- Técnicas de recuperación eficaces: Optimizar la fase de recuperación utilizando algoritmos de indexación y búsqueda más eficientes (como los vecinos más próximos aproximados) puede reducir enormemente el tiempo y los recursos necesarios para localizar los documentos relevantes.

- Compresión y optimización de modelos: Los modelos lingüísticos utilizados en los sistemas GAR pueden ser intensivos desde el punto de vista computacional, sobre todo cuando se trata de consultas a gran escala o específicas de un dominio. Se pueden utilizar técnicas como la destilación de modelos, la cuantización y la poda para reducir el tamaño y el coste computacional de estos modelos sin sacrificar demasiado el rendimiento.

Limitaciones de los datos

Los sistemas GAR dependen en gran medida de la calidad y el alcance de los datos que recuperan y generan. En las aplicaciones de dominios específicos, las limitaciones de los datos pueden ser un reto importante, sobre todo cuando los datos de entrenamiento disponibles son insuficientes, obsoletos o de baja calidad.

Podemos abordar las limitaciones de datos en los sistemas GAR con algunos enfoques.

Aumento de datos

Cuando los datos de entrenamiento específicos del dominio son limitados, las técnicas de aumento de datos pueden ayudar a ampliar artificialmente el conjunto de datos. Esto puede incluir generar datos sintéticos, parafrasear documentos existentes o utilizar fuentes externas para complementar el conjunto de datos original. El aumento de datos garantiza que el modelo tenga acceso a una gama más amplia de ejemplos, mejorando su capacidad para manejar consultas diversas.

Adaptación del dominio

El ajuste fino de los modelos lingüísticos preentrenados en conjuntos de datos pequeños y específicos del dominio puede ayudar a los sistemas GAR a adaptarse a casos de uso especializados, incluso con datos limitados. La adaptación al dominio permite que el modelo comprenda mejor la terminología y los matices específicos del sector, mejorando la calidad de las respuestas generadas.

Aprendizaje activo

En los casos en que los datos de entrenamiento de alta calidad son escasos, se puede emplear el aprendizaje activo para mejorar el conjunto de datos de forma iterativa. Al identificar los puntos de datos más informativos y centrar los esfuerzos de anotación en ellos, los desarrolladores pueden mejorar gradualmente el conjunto de datos sin requerir cantidades masivas de datos etiquetados desde el principio.

Aplicación de técnicas avanzadas en RAG

La aplicación de técnicas avanzadas en los sistemas GAR requiere una sólida comprensión de las herramientas, marcos y estrategias disponibles. A medida que estas técnicas se hacen más complejas, el aprovechamiento de bibliotecas y marcos especializados simplifica la integración de sofisticados flujos de trabajo de recuperación y generación.

Herramientas y bibliotecas

Han surgido muchos marcos y bibliotecas para apoyar la aplicación de técnicas avanzadas de GAR, que ofrecen soluciones modulares y escalables para desarrolladores e investigadores. Estas herramientas mejoran el proceso de construcción de sistemas RAG proporcionando componentes de recuperación, clasificación, filtrado y generación.

LangChain

LangChain es un popular marco diseñado específicamente para trabajar con modelos lingüísticos e integrarlos con fuentes de datos externas. Admite técnicas avanzadas de recuperación aumentada, como la indexación de documentos, la consulta y el encadenamiento de distintos pasos de procesamiento (recuperación, generación y razonamiento).

LangChain también ofrece integraciones listas para usar con bases de datos vectoriales y varios recuperadores, lo que la convierte en una opción versátil para construir sistemas RAG personalizados.

Aprende más sobre LangChain y RAG en este curso: Construye sistemas RAG con LangChain

Pajar

Haystack es un framework de código abierto especializado en construir sistemas RAG para uso en producción. Proporciona herramientas para la recuperación densa, la clasificación y el filtrado de documentos, así como la generación de lenguaje natural.

Haystack es especialmente potente en aplicaciones que requieren búsqueda específica de dominio, respuesta a preguntas o resumen de documentos. Gracias a la compatibilidad con diversos backends y a la integración con los modelos lingüísticos más populares, Haystack simplifica la implantación de sistemas RAG en escenarios reales.

OpenAI API

El sitio API OpenAI permite a los desarrolladores integrar potentes modelos lingüísticos, como el GPT-4, en los flujos de trabajo RAG. Aunque no son específicos de las tareas de recuperación aumentada, los modelos de OpenAI pueden utilizarse junto con los marcos de recuperación para generar respuestas basadas en la información recuperada, lo que permite capacidades de generación avanzadas.

Estrategias de aplicación

Para integrar técnicas avanzadas en un sistema GAR existente, es esencial seguir un enfoque estructurado.

Elige el marco adecuado

Empieza por seleccionar un marco o biblioteca que se ajuste a tu caso de uso. Por ejemplo, si necesitas un sistema altamente escalable con capacidad de recuperación densa, marcos como LangChain o Haystack son ideales.

Configurar la recuperación de documentos

El primer paso es configurar el componente de recuperación, lo que implica indexar tu fuente de datos y configurar el método de recuperación. Según tu caso de uso, puedes elegir la recuperación densa (utilizando incrustaciones vectoriales) o la búsqueda híbrida (combinando métodos dispersos y densos). Por ejemplo, se puede utilizar LangChain o Haystack para crear el conducto de recuperación.

Aplicar reordenación y filtrado

Una vez que el sistema de recuperación está operativo, el siguiente paso es mejorar la relevancia mediante técnicas de reordenación y filtrado. Esto puede hacerse utilizando los módulos de reordenación incorporados en Haystack o personalizando tus modelos de reordenación en función de tus tipos de consulta específicos.

Incorporar técnicas avanzadas de generación

Tras la recuperación, optimiza el proceso de generación aprovechando la ingeniería de instrucciones, la destilación del contexto y el razonamiento en varios pasos. Con LangChain, puedes encadenar los pasos de recuperación y generación para gestionar consultas de varios pasos o utilizar plantillas de consulta que condicionen el modelo para una generación más precisa.

Si la alucinación es un problema, céntrate en fundamentar la generación en los documentos recuperados, asegurándote de que el modelo genera resultados basados en el contenido de esos documentos.

Probar y evaluar

Las pruebas periódicas son cruciales para perfeccionar el rendimiento del sistema GAR. Utiliza métricas de evaluación como la precisión, la relevancia y la satisfacción del usuario para valorar la eficacia de técnicas avanzadas como el reranking y la destilación del contexto. Realiza pruebas A/B para comparar distintos enfoques y afinar el sistema basándote en las reacciones.

Optimiza la escalabilidad

A medida que el sistema crece, los gastos generales de cálculo pueden convertirse en un problema. Para gestionarlo, emplea técnicas de optimización como la destilación de modelos o la cuantización, y asegúrate de que los procesos de recuperación sean eficientes. Utilizar la aceleración o paralelización de la GPU también puede ayudar a mantener el rendimiento a escala.

Supervisar y actualizar

Los sistemas GAR tienen que evolucionar para adaptarse a las nuevas consultas y datos. Establece herramientas de supervisión para seguir el rendimiento del sistema en tiempo real, y actualiza continuamente el modelo y el índice de recuperación para hacer frente a las nuevas tendencias y necesidades.

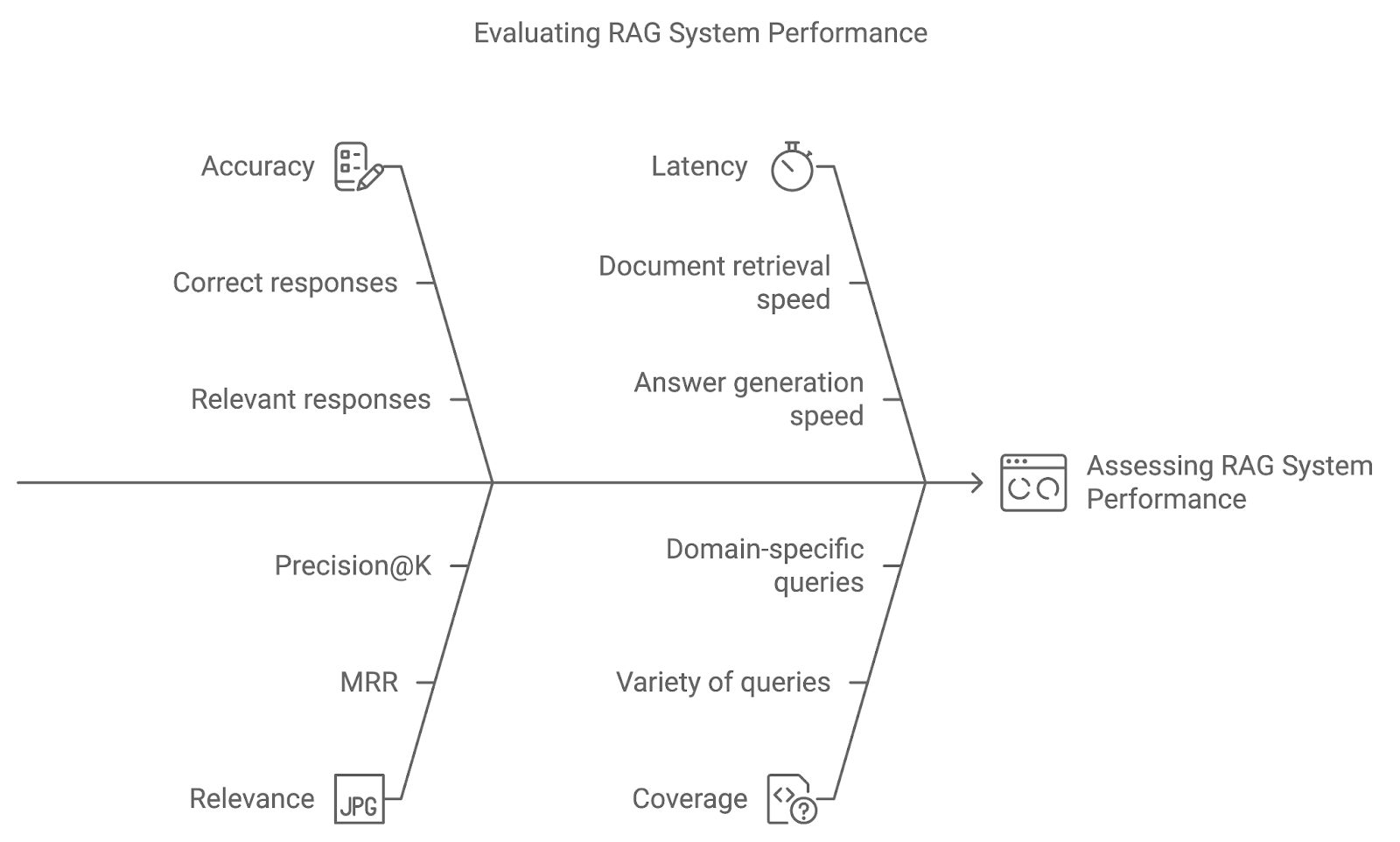

Evaluación de técnicas avanzadas de GAR

Implantar técnicas avanzadas en un sistema GAR es sólo el principio. Mediante el uso de métricas de evaluación y métodos de prueba como las pruebas A/B, podemos evaluar lo bien que responde el sistema a las consultas de los usuarios y perfeccionarlo con el tiempo.

Precisión

La precisión mide la frecuencia con la que el sistema recupera y genera la respuesta correcta o pertinente. Para los sistemas de respuesta a preguntas, esto podría implicar una comparación directa de las respuestas generadas con datos reales. Una mayor precisión indica que el sistema está interpretando con exactitud las consultas y ofreciendo resultados precisos.

Relevancia

Esta métrica evalúa la relevancia de los documentos recuperados y la calidad de la respuesta generada en función de lo bien que responden a la consulta del usuario. Para cuantificar la relevancia se suelen utilizar métricas como el Rango Recíproco Medio (MRR) o la Precisión@K, que evalúan lo alto que aparece en la clasificación el documento más relevante.

Latencia

Aunque la precisión y la relevancia son fundamentales, el rendimiento en tiempo real también importa. La latencia se refiere al tiempo de respuesta del sistema: la velocidad a la que el sistema recupera documentos y genera respuestas. La baja latencia es especialmente importante en aplicaciones en las que la rapidez de respuesta es vital, como la atención al cliente o los sistemas de preguntas y respuestas en directo.

Cobertura

La cobertura mide lo bien que el sistema GAR gestiona una amplia variedad de consultas. En las aplicaciones de dominio específico, garantizar que el sistema pueda gestionar todo el abanico de posibles consultas de los usuarios es clave para proporcionar una asistencia completa.

Diagrama generado con napkin.ai

Casos prácticos de las técnicas avanzadas de GAR

Las técnicas avanzadas de GAR abren un amplio abanico de posibilidades en diferentes industrias y aplicaciones.

Sistemas complejos de respuesta a preguntas

Uno de los casos de uso más impactantes de las técnicas RAG avanzadas es el de los sistemas complejos de respuesta a preguntas (QA). Estos sistemas requieren algo más que una simple recuperación de documentos: deben comprender el contexto, desglosar las consultas de varios pasos y proporcionar respuestas completas basadas en los documentos recuperados.

Recuperación de conocimientos específicos de un dominio

En los sectores en los que es importante el conocimiento específico del dominio, se pueden construir sistemas RAG avanzados para recuperar y generar contenidos altamente especializados. Algunas aplicaciones destacables son:

- Sanidad: Los profesionales médicos se basan en investigaciones actualizadas, directrices clínicas e historiales de los pacientes a la hora de tomar decisiones. Los sistemas RAG avanzados pueden recuperar documentos médicos, resumir historiales de pacientes y generar opciones de tratamiento. El filtrado y la reordenación son especialmente importantes para garantizar que el contenido recuperado es reciente, preciso y muy relevante para el estado del paciente.

- Servicios financieros: En el sector financiero, los sistemas RAG pueden recuperar informes de mercado, archivos normativos y previsiones económicas, ayudando a los analistas a generar perspectivas precisas basadas en datos. La ampliación de consultas y la recuperación densa pueden garantizar que los analistas reciban los datos más relevantes y completos disponibles.

Recomendaciones personalizadas

Los sistemas de recomendación personalizados son otro caso de uso clave para las técnicas avanzadas de GAR. Combinando las preferencias del usuario, su comportamiento y fuentes de datos externas, los sistemas GAR pueden generar recomendaciones personalizadas de productos, servicios o contenidos, entre otros:

- E-commerce: Los sistemas RAG pueden recomendar productos recuperando descripciones de productos, opiniones de clientes y perfiles de usuarios para generar sugerencias personalizadas. La búsqueda híbrida (que combina la recuperación basada en palabras clave y la basada en vectores) y el reranking son esenciales para mejorar la relevancia de estas recomendaciones.

- Plataformas de contenidos: En las plataformas de streaming o de noticias, los sistemas RAG pueden recomendar contenidos basándose en las preferencias de los usuarios y en las tendencias recientes. La ampliación de las consultas y la destilación del contexto pueden ayudar a estos sistemas a proporcionar recomendaciones más matizadas, adaptando las sugerencias en función del comportamiento anterior y los intereses actuales.

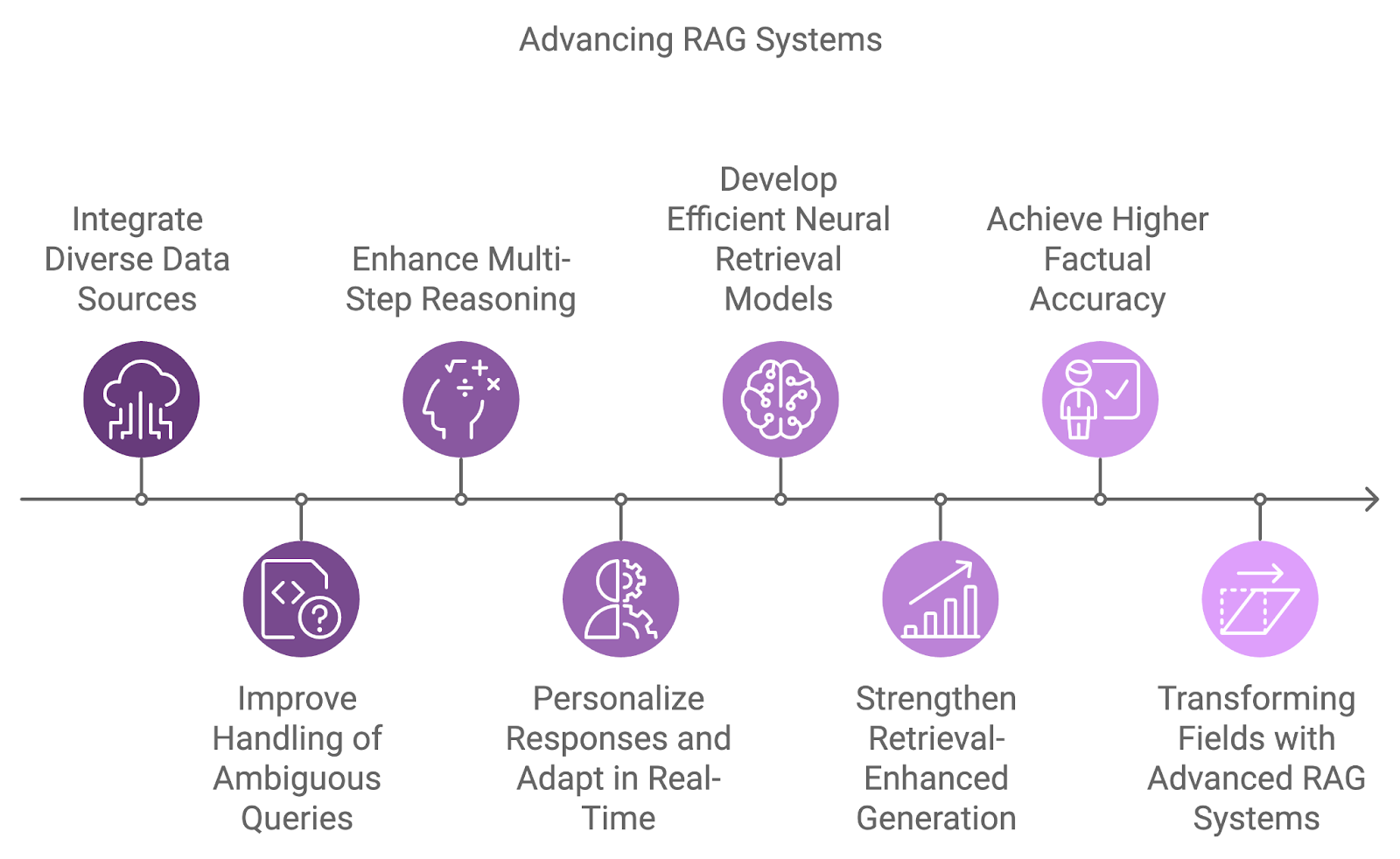

El futuro de los sistemas RAG

La próxima generación de sistemas GAR integrará fuentes de datos más diversas, mejorando la capacidad de razonamiento y abordando las limitaciones actuales, como la ambigüedad y el manejo de consultas complejas.

Un área de desarrollo clave es la integración de diversas fuentes de datos, superando la dependencia de conjuntos de datos únicos. Los sistemas futuros combinarán información de diversas fuentes, como bases de datos, API y fuentes en tiempo real, permitiendo respuestas más completas y multidimensionales a consultas complejas.

Manejar las consultas ambiguas o incompletas es otro reto que abordarán los futuros sistemas GAR. Combinando el razonamiento probabilístico con una mejor comprensión contextual, estos sistemas gestionarán la incertidumbre con mayor eficacia.

Además, el razonamiento en varios pasos será cada vez más integral en la forma en que los sistemas GAR procesan las consultas complejas, descomponiéndolas en componentes más pequeños y sintetizando los resultados en varios documentos o pasos. Esto será especialmente beneficioso en campos como la investigación jurídica, los descubrimientos científicos y la atención al cliente, donde las consultas a menudo requieren conectar diversas piezas de información.

A medida que la personalización y el conocimiento del contexto sigan mejorando, los futuros sistemas de GAR adaptarán sus respuestas basándose en el historial, las preferencias y las interacciones anteriores del usuario. La adaptación en tiempo real a la nueva información permitirá conversaciones más dinámicas y productivas.

Diagrama generado con napkin.ai

Los modelos actuales de recuperación densa son muy eficaces, pero se está investigando para desarrollar modelos neuronales de recuperación aún más eficaces y precisos. Estos modelos pretenden captar mejor las similitudes semánticas en una gama más amplia de pares consulta-documento, mejorando al mismo tiempo la eficacia en tareas de recuperación a gran escala.

Papers like Karpukhin et al. (2020) introdujeron la Recuperación de Pasajes Densos (DPR) como método básico para la respuesta a preguntas de dominio abierto, mientras que estudios más recientes como Izacard et al. (2022) se centran en el aprendizaje de pocos disparos para adaptar los sistemas GAR a tareas específicas del dominio.

Otra área de investigación emergente se centra en mejorar la conexión entre la recuperación y la generación mediante modelos de generación mejorados por la recuperación. Estos modelos pretenden integrar perfectamente los documentos recuperados en el proceso de generación, permitiendo que el modelo lingüístico condicione su salida más directamente al contenido recuperado.

Esto puede reducir las alucinaciones y mejorar la precisión factual de las respuestas generadas, haciendo que el sistema sea más fiable. Entre los trabajos más destacados se encuentran Huang et al. (2023) con el modelo RAVEN, que mejora el aprendizaje en contexto utilizando modelos codificador-decodificador aumentados por recuperación.

Conclusión

La integración de técnicas avanzadas de RAG, como la recuperación densa, el reranking y el razonamiento en varios pasos, garantiza que los sistemas RAG puedan satisfacer las demandas de las aplicaciones del mundo real, desde la asistencia sanitaria hasta las recomendaciones personalizadas.

De cara al futuro, la evolución de los sistemas GAR se verá impulsada por innovaciones como la capacidad multilingüe, la generación personalizada y el manejo de fuentes de datos más diversas.

Si quieres seguir aprendiendo y ponerte más manos a la obra con los sistemas RAG, te recomiendo estos tutoriales: