Cursus

Qwen3 est l'une des suites de modèles ouverts les plus complètes publiées à ce jour.

Elle provient de l'équipe Qwen d'Alibaba et comprend des modèles qui atteignent des performances de niveau recherche ainsi que des versions plus petites qui peuvent être exécutées localement sur du matériel plus modeste.

Dans ce blog, je vous donnerai un aperçu rapide de la suite Qwen3 complète, j'expliquerai comment les modèles ont été développés, je vous présenterai les résultats de l'analyse comparative et je vous montrerai comment vous pouvez accéder à ces modèles et commencer à les utiliser.

Notre équipe travaille également sur des tutoriels qui montrent comment exécuter Qwen3 localement et comment affiner les modèles Qwen3. Je veillerai à mettre à jour cet article dès qu'elles seront prêtes. Si vous revenez ici au cours des deux ou trois prochains jours, vous trouverez des liens vers ces ressources ajoutées à cette introduction.

Nous tenons nos lecteurs informés des dernières nouveautés en matière d'IA en leur envoyant The Median, notre lettre d'information gratuite du vendredi qui analyse les principaux sujets de la semaine. Abonnez-vous et restez à la pointe de la technologie en quelques minutes par semaine :

Qu'est-ce que Qwen 3 ?

Qwen3 est la dernière famille de grands modèles linguistiques de l'équipe Qwen d'Alibaba. Tous les modèles de la gamme sont à pondération libre sous la licence Apache 2.0.

Ce qui a tout de suite attiré mon attention, c'est l'introduction d'un budget de réflexion que les utilisateurs peuvent contrôler directement dans l'application Qwen. Cela permet aux utilisateurs réguliers d'exercer un contrôle granulaire sur le processus de raisonnement, ce qui, auparavant, ne pouvait se faire que par programmation.

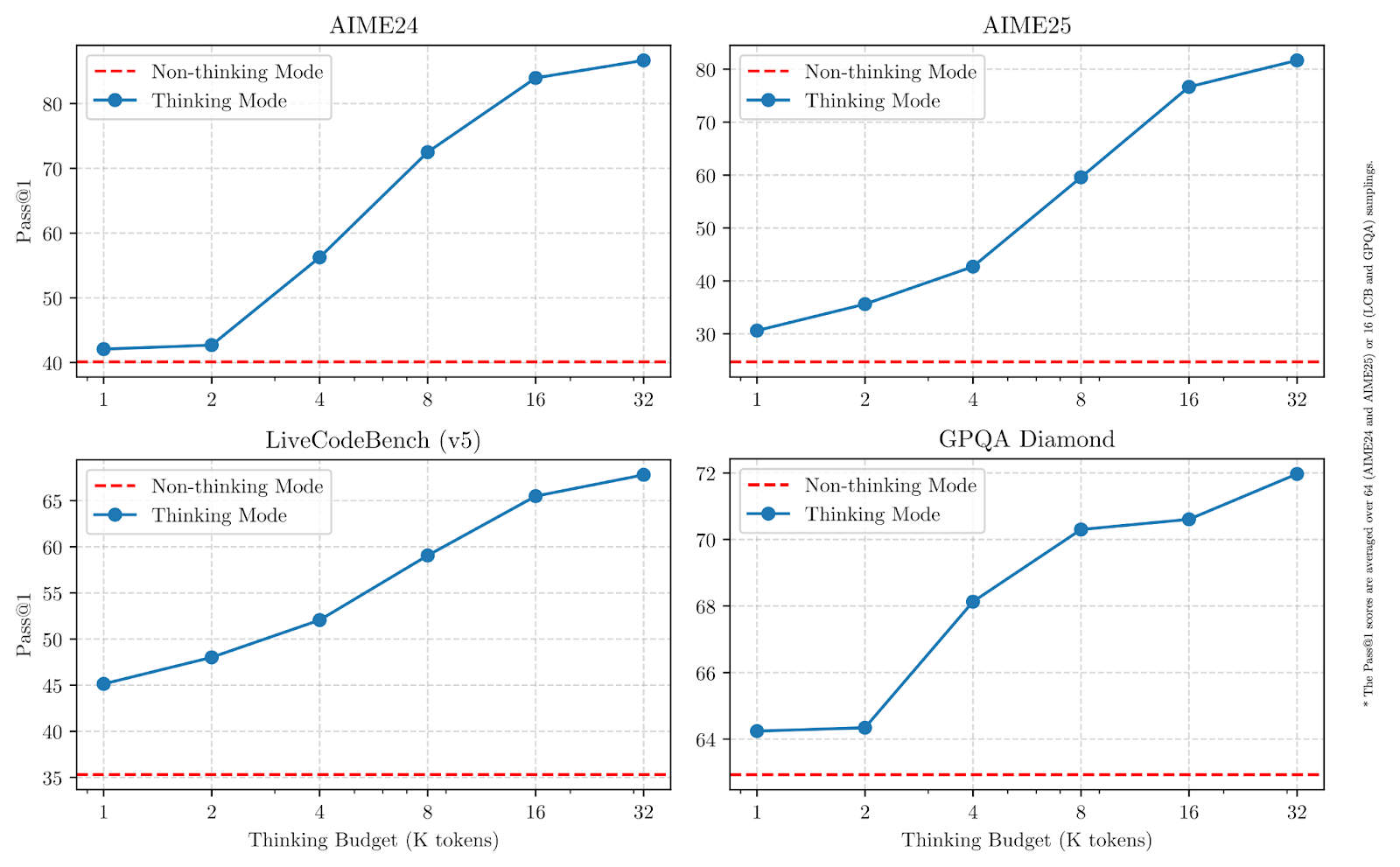

Comme le montrent les graphiques ci-dessous, l'augmentation des budgets de réflexion améliore considérablement les performances, en particulier pour les mathématiques, le codage et les sciences.

Source : Qwen

Dans les tests de référence, le modèle phare Qwen3-235B-A22B est compétitif par rapport à d'autres modèles de haut niveau et affiche des résultats supérieurs à ceux du modèle DeepSeek-R1 dans les domaines du codage, des mathématiques et du raisonnement général. Examinons rapidement chaque modèle et comprenons à quoi il est destiné.

Qwen3-235B-A22B

Il s'agit du plus grand modèle de la gamme Qwen3. Il utilise un mélange d'experts (MoE) avec 235 milliards de paramètres totaux et 22 milliards de paramètres actifs par étape de génération.

Dans un modèle MoE, seul un petit sous-ensemble de paramètres est activé à chaque étape, ce qui le rend plus rapide et moins coûteux à exécuter que les modèles denses (comme le GPT-4o), où tous les paramètres sont toujours utilisés.

Le modèle obtient de bons résultats en mathématiques, en raisonnement et en codage, et dans les comparaisons de référence, il surpasse des modèles tels que DeepSeek-R1.

Qwen3-30B-A3B

Qwen3-30B-A3B est un modèle MoE plus petit avec 30 milliards de paramètres totaux et seulement 3 milliards actifs à chaque étape. Malgré le faible nombre d'actifs, ses performances sont comparables à celles de modèles beaucoup plus denses tels que le QwQ-32B. C'est un choix pratique pour les utilisateurs qui recherchent à la fois des capacités de raisonnement et des coûts d'inférence réduits. Comme le modèle 235B, il supporte une fenêtre contextuelle de 128K et est disponible sous Apache 2.0.

Modèles denses : 32B, 14B, 8B, 4B, 1.7B, 0.6B

Les six modèles denses de la version Qwen3 suivent une architecture plus traditionnelle où tous les paramètres sont actifs à chaque étape. Ils couvrent un large éventail de cas d'utilisation :

Qwen3-32B, 14B, 8B prennent en charge 128K fenêtres contextuelles, tandis que Qwen3-4B, 1.7B, 0.6B prennent en charge 32K. Tous sont à pondération libre et sous licence Apache 2.0. Les petits modèles de ce groupe sont bien adaptés aux déploiements légers, tandis que les plus grands sont plus proches des LLM à usage général.

Quel modèle choisir ?

Qwen3 propose différents modèles en fonction de la profondeur de raisonnement, de la vitesse et du coût de calcul dont vous avez besoin. Voici un aperçu rapide du site :

|

Modèle |

Type |

Contexte Longueur |

Meilleur pour |

|

Qwen3-235B-A22B |

MdE |

128K |

Tâches de recherche, flux de travail des agents, longues chaînes de raisonnement |

|

Qwen3-30B-A3B |

MdE |

128K |

Un raisonnement équilibré pour un coût d'inférence moindre |

|

Qwen3-32B |

Dense |

128K |

Déploiements polyvalents haut de gamme |

|

Qwen3-14B |

Dense |

128K |

Applications de milieu de gamme nécessitant un raisonnement solide |

|

Qwen3-8B |

Dense |

128K |

Tâches de raisonnement légères |

|

Qwen3-4B |

Dense |

32K |

Des applications plus petites, une inférence plus rapide |

|

Qwen3-1.7B |

Dense |

32K |

Cas d'utilisation mobile et embarquée |

|

Qwen3-0.6B |

Dense |

32K |

Paramètres très légers ou limités |

Si vous travaillezsur des tâches nécessitant un raisonnement plus approfondi, l'utilisation d'outils d'agent ou la gestion de contextes longs, Qwen3-235B-A22B vous offrira la plus grande flexibilité.

Pour les cas où vous souhaitez que l'inférence soit plus rapide et moins coûteuse tout en gérant des tâches modérément complexes, Qwen3-30B-A3B est une option solide.

Les modèles denses offrent des déploiements plus simples et une latence prévisible, ce qui les rend plus adaptés aux applications à petite échelle.

Comment Qwen3 a été développé

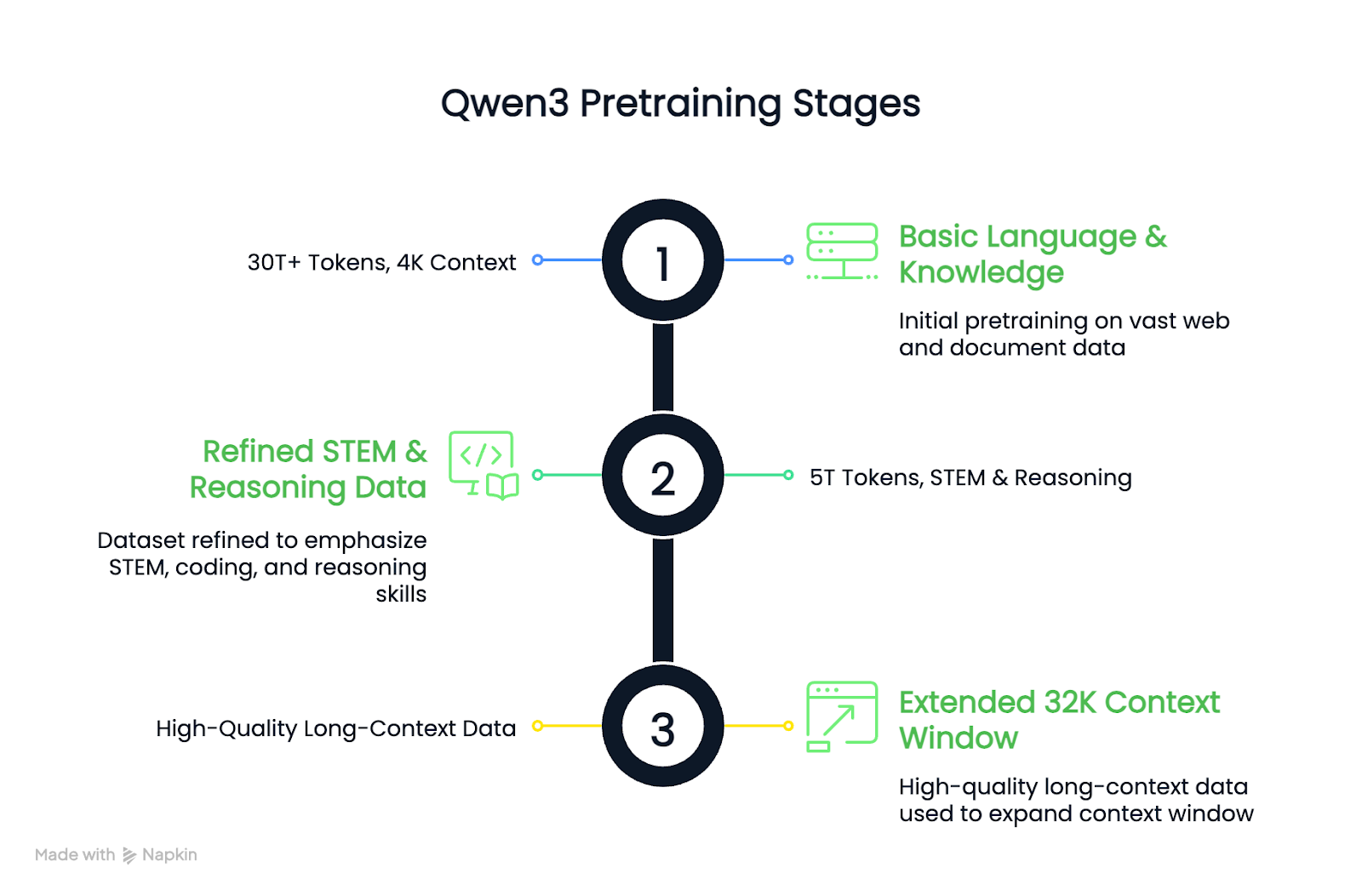

Les modèles Qwen3 ont été construits grâce à une phase de pré-entraînement en trois étapes, suivie d'un pipeline de post-entraînement en quatre étapes.

Le préapprentissage est l'étape au cours de laquelle le modèle apprend des modèles généraux à partir de quantités massives de données (langage, logique, mathématiques, code) sans qu'on lui dise exactement ce qu'il doit faire. Le post-entraînement consiste à affiner le modèle pour qu'il se comporte de manière spécifique, par exemple en raisonnant avec prudence ou en suivant des instructions.

Je vais vous présenter les deux parties en termes simples, sans entrer dans les détails techniques.

Préformation

Par rapport à Qwen2.5, l'ensemble de données de préformation pour Qwen3 a été considérablement élargi. Environ 36 000 milliards de jetons ont été utilisés, soit le double de la génération précédente. Les données comprenaient du contenu web, du texte extrait de documents, des mathématiques synthétiques et des exemples de code générés par les modèles Qwen2.5.

Le processus de formation préalable s'est déroulé en trois étapes :

- Étape 1: Les compétences linguistiques et les connaissances de base ont été acquises à l'aide de plus de 30 billions de jetons, avec une longueur de contexte de 4K.

- Étape 2: L'ensemble de données a été affiné pour augmenter la part des données relatives aux STIM, au codage et au raisonnement, puis 5 billions de jetons supplémentaires ont été ajoutés.

- Étape 3: Des données de haute qualité sur les contextes longs ont été utilisées pour étendre les modèles à des fenêtres contextuelles de 32K.

Il en résulte que les modèles de base denses de Qwen3 égalent ou dépassent les modèles de base plus grands de Qwen2.5 tout en utilisant moins de paramètres, en particulier dans les tâches de STIM et de raisonnement.

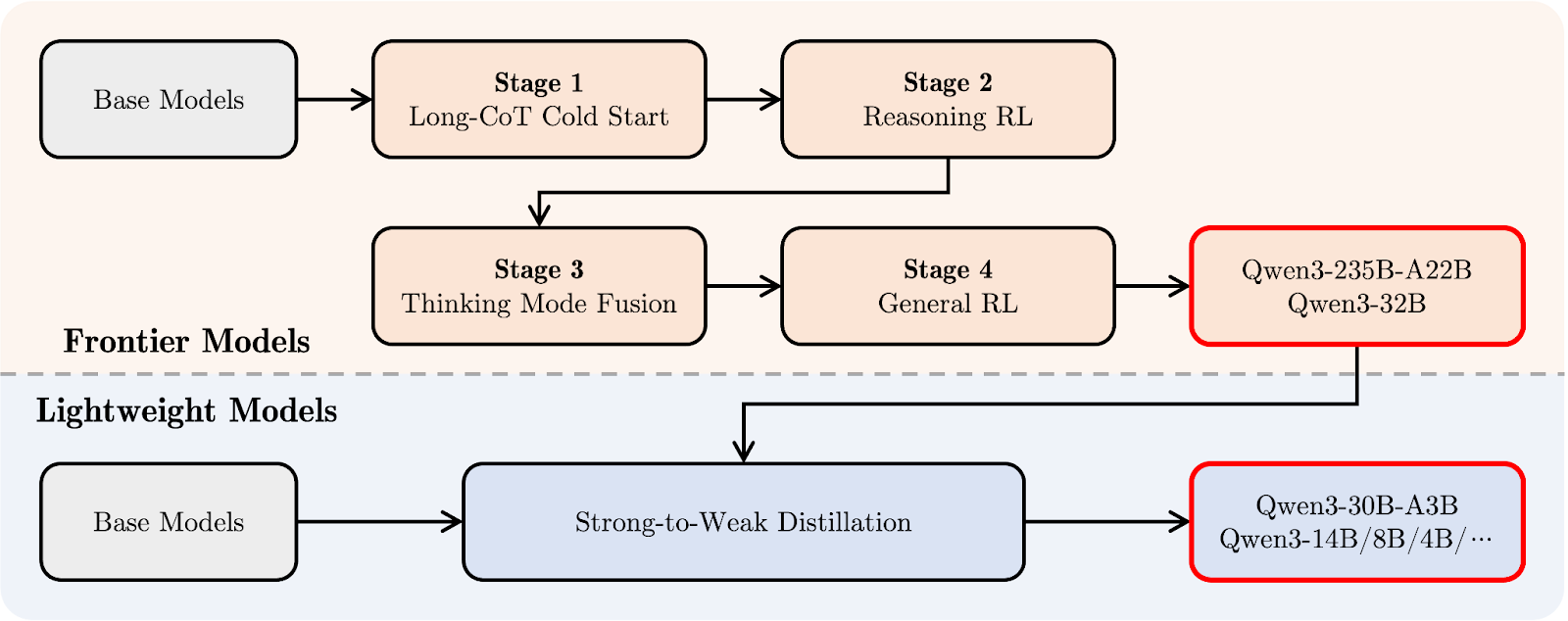

Après la formation

Le pipeline de post-formation de Qwen3 s'est concentré sur l'intégration de capacités de raisonnement approfondi et de réponse rapide dans un modèle unique. Voyons d'abord le schéma ci-dessous, puis je vous expliquerai pas à pas :

Pipeline post-formation Qwen 3. Source : Qwen

En haut (en orange), vous pouvez voir le chemin de développement des plus grands "modèles frontières", comme Qwen3-235B-A22B et Qwen3-32B. Tout commence par une Longue chaîne de pensée Démarrage à froid (étape 1), où le modèle apprend à raisonner étape par étape sur des tâches plus difficiles.

Vient ensuite le raisonnement Apprentissage par renforcement (RL) (étape 2) pour encourager de meilleures stratégies de résolution de problèmes. Au stade 3, appelé Thinking Mode Fusion, Qwen3 apprend à équilibrer un raisonnement lent et prudent avec des réponses plus rapides. Enfin, une étapeRL générale améliore son comportement dans un large éventail de tâches, comme le suivi d'instructions et les cas d'utilisation agentique.

En dessous (en bleu clair), vous verrez le chemin pour les "modèles légers", comme Qwen3-30B-A3B et les modèles denses plus petits. Ces modèles sont formés à l'aide d'une distillationun processus au cours duquel les connaissances des grands modèles sont comprimées dans des modèles plus petits et plus rapides, sans perdre trop de capacité de raisonnement.

En termes simples, les grands modèles ont été formés en premier, puis les modèles légers ont été distillés à partir de ces modèles. Ainsi, toute la famille Qwen3 partage un style de pensée similaire, même pour des modèles de tailles très différentes.

Qwen 3 Benchmarks

Les modèles Qwen3 ont été évalués sur une série de critères de raisonnement, de codage et de connaissances générales. Les résultats montrent que le modèle Qwen3-235B-A22B est le plus performant dans la plupart des tâches, mais les modèles plus petits Qwen3-30B-A3B et Qwen3-4B offrent également de bonnes performances.

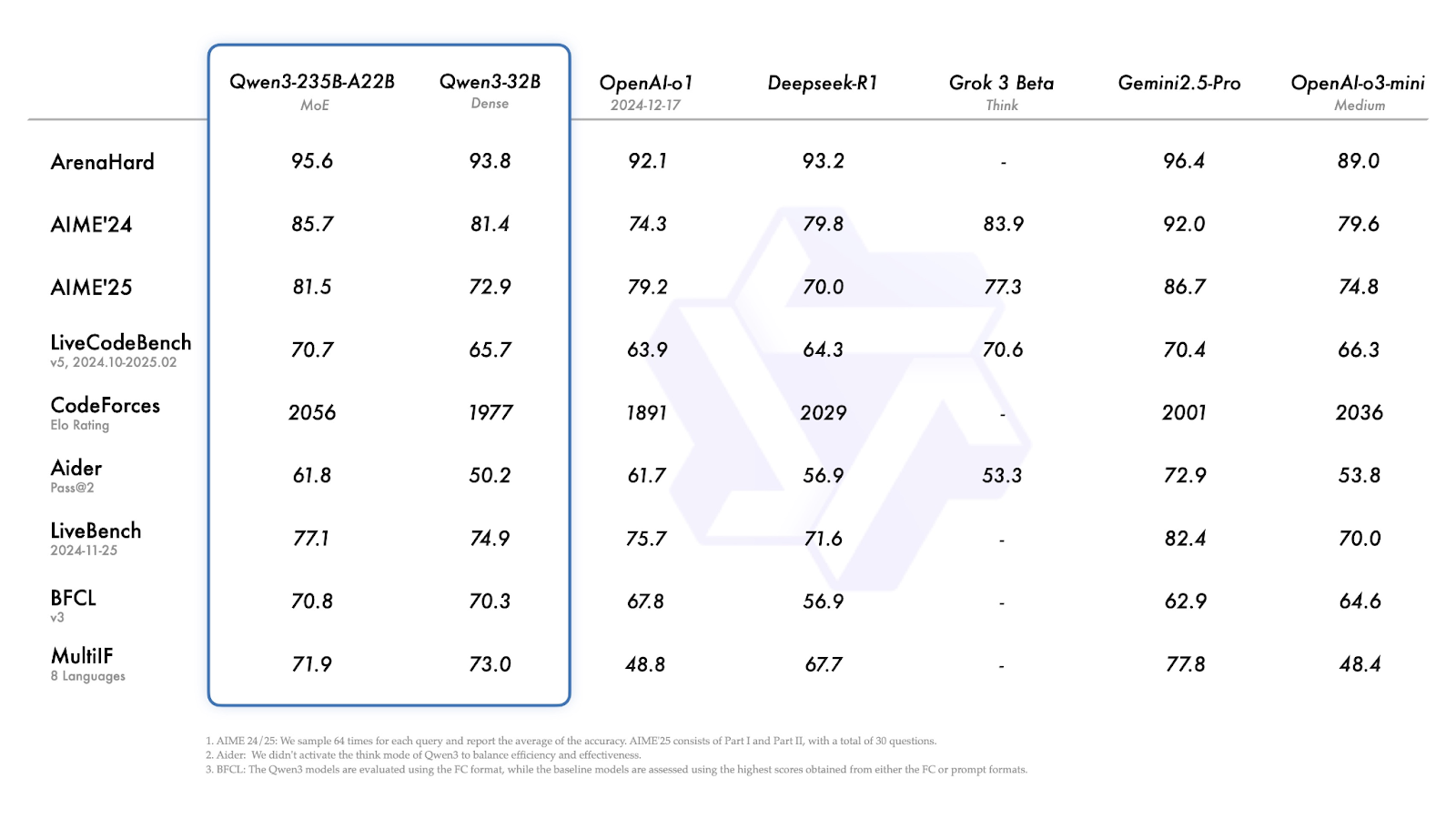

Qwen3-235B-A22B et Qwen3-32B

Dans la plupart des tests de référence, le Qwen3-235B-A22B figure parmi les modèles les plus performants, mais il n'est pas toujours en tête.

Source : Qwen

Examinons rapidement les résultats ci-dessus :

- ArenaHard (raisonnement global) : Gemini 2.5 Pro est en tête avec 96,4. Qwen3-235B est juste derrière avec 95,6, devant o1 et DeepSeek-R1.

- AIME'24 / AIME'25 (maths) : Les notes sont de 85,7 et 81,4. Gemini 2.5 Pro se classe à nouveau en tête, mais Qwen3-235B reste plus performant que DeepSeek-R1, Grok 3 et o3-mini.

- LiveCodeBench (génération de code) : 70,7 pour le modèle 235B - meilleur que la plupart des modèles sauf Gemini.

- CodeForces Elo (programmation compétitive) : 2056, soit plus que tous les autres modèles répertoriés, y compris DeepSeek-R1 et Gemini 2.5 Pro.

- LiveBench (tâches générales réelles) : 77.1, ce qui le place en deuxième position derrière Gemini 2.5 Pro.

- MultiIF (raisonnement multilingue) : Le Qwen3-32B, plus petit, obtient de meilleurs résultats (73,0), mais il reste derrière le Gemini (77,8).

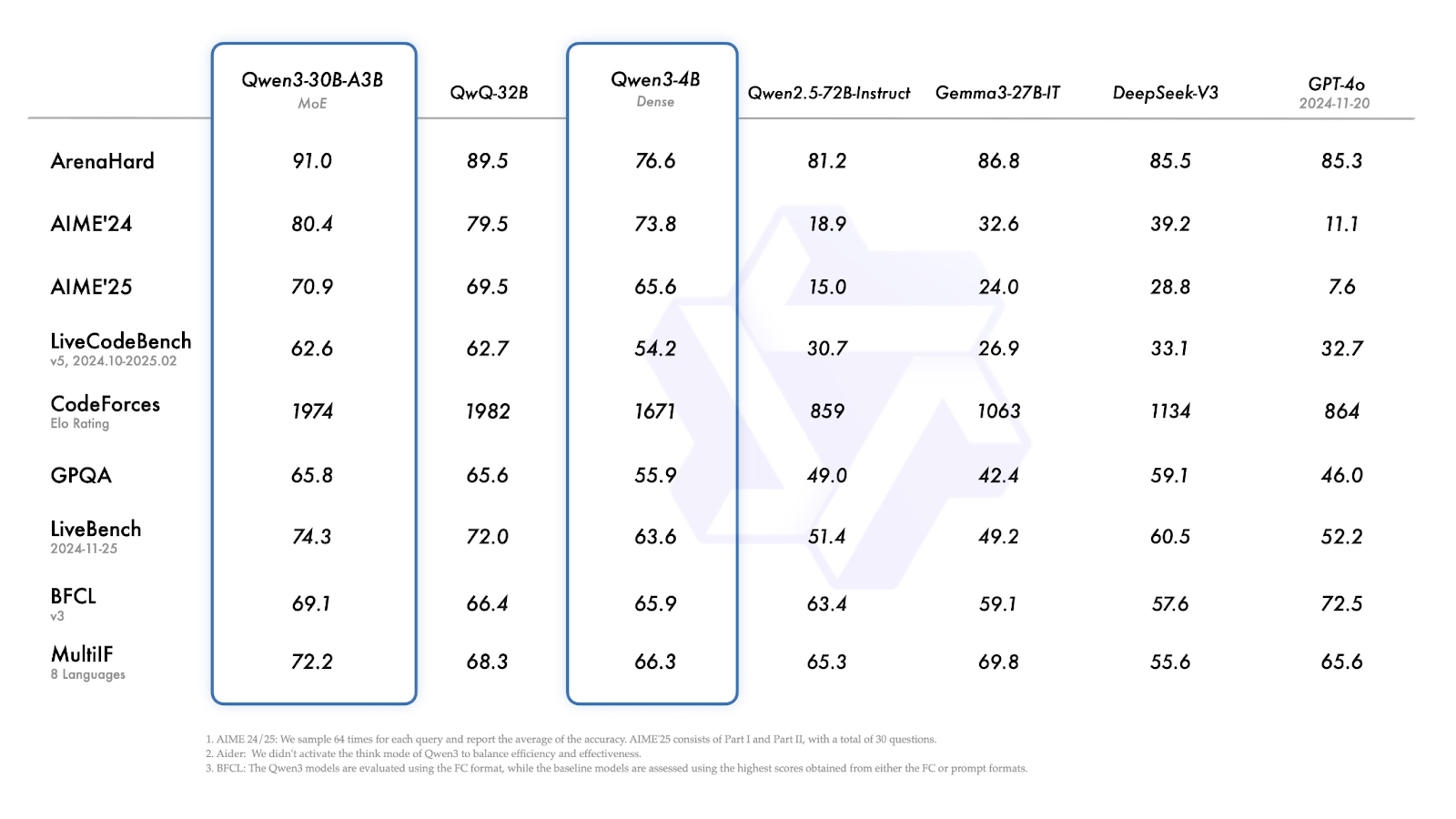

Qwen3-30B-A3B et Qwen3-4B

Qwen3-30B-A3B (le plus petit modèle MoE) obtient de bons résultats dans presque tous les points de référence, égalant ou surpassant systématiquement les modèles denses de taille similaire.

- ArenaHard: 91,0 au-dessus de QwQ-32B (89,5), DeepSeek-V3 (85,5) et GPT-4o (85,3).

- AIME'24 / AIME'25: 80,4 - légèrement en avance sur QwQ-32B, mais à des kilomètres des autres modèles.

- CodeForces Elo: 1974 - juste en dessous de QwQ-32B (1982).

- GPQA (assurance qualité de niveau supérieur) : 65,8 - à peu près à égalité avec QwQ-32B.

- MultiIF: 72,2 - plus élevé que QwQ-32B (68,3).

Source : Qwen

Qwen3-4B affiche des performances solides pour sa taille :

- ArenaHard: 76.6

- AIME'24 / AIME'25: 73,8 et 65,6 - nettement plus résistants que les anciens modèles Qwen2.5, beaucoup plus grands, et que des modèles comme le Gemma-27B-IT.

- CodeForces Elo: 1671 - il n'est pas compétitif par rapport aux modèles plus grands, mais il est à la hauteur de sa catégorie de poids.

- MultiIF: 66,3 - respectable pour un modèle 4B dense, et nettement supérieur à de nombreuses lignes de base de taille similaire.

Comment accéder à Qwen3

Les modèles Qwen3 sont accessibles au public et peuvent être utilisés sur l'application de chat, via l'API, téléchargés pour un déploiement local ou intégrés dans des configurations personnalisées.

Interface de chat

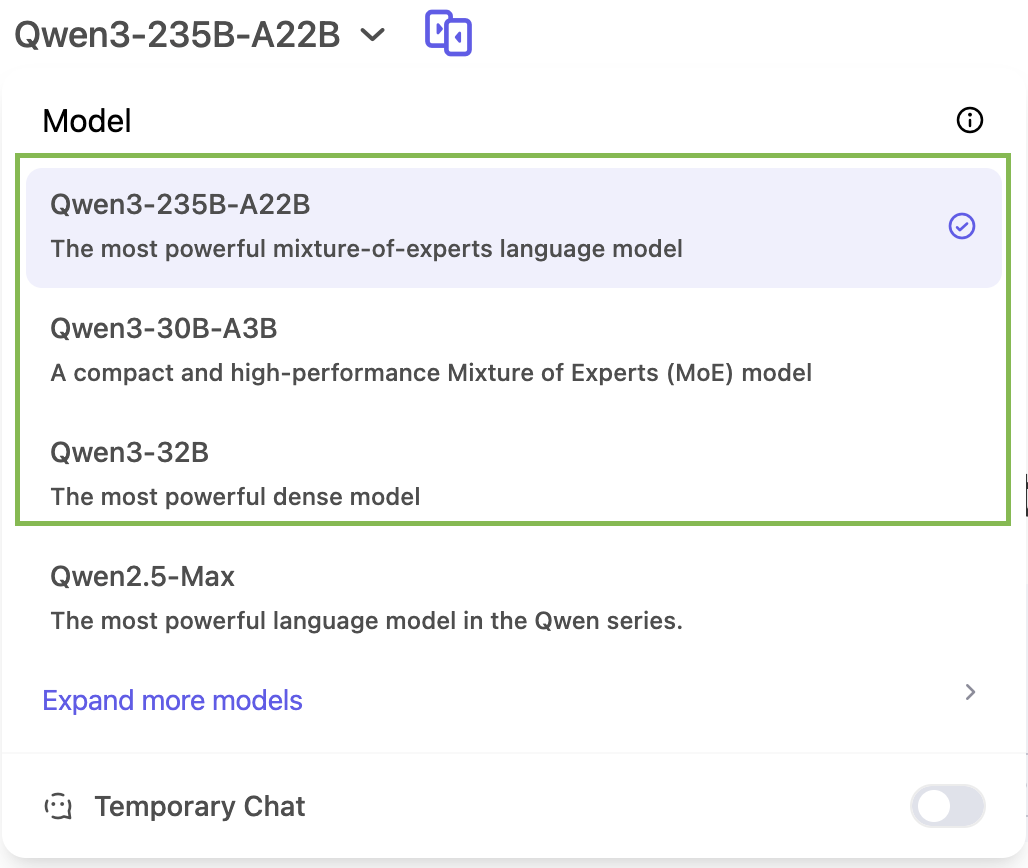

Vous pouvez essayer Qwen3 directement à l'adresse suivante chat.qwen.ai.

Vous n'aurez accès qu'à trois modèles de la famille Qwen 3 dans l'application de chat : Qwen3-235B, Qwen3-30B et Qwen3-32B :

Accès à l'API Qwen 3

Qwen3 fonctionne avec des formats d'API compatibles avec OpenAI par le biais de fournisseurs tels que ModelScope ou DashScope. Des outils comme vLLM et SGLang offrent un service efficace pour un déploiement local ou autonome. Le blog officiel de Qwen 3 contient plus de détails à ce sujet.

Poids ouverts

Tous les modèles Qwen3, qu'ils soient MoE ou denses, sont publiés sous la licence Apache 2.0. Ils sont disponibles sur :

Déploiement local

Vous pouvez également exécuter Qwen3 localement en utilisant :

- Ollama

- LM Studio

- llama.cpp

- KTransformateurs

Conclusion

Qwen3 est l'une des suites de modèles ouverts les plus complètes publiées à ce jour.

Le modèle phare 235B MoE est performant dans les tâches de raisonnement, de mathématiques et de codage, tandis que les versions 30B et 4B offrent des alternatives pratiques pour les déploiements à plus petite échelle ou à budget limité. La possibilité d'ajuster le budget de réflexion du modèle ajoute une couche supplémentaire de flexibilité pour les utilisateurs réguliers.

En l'état, Qwen3 est une version bien équilibrée qui couvre un large éventail de cas d'utilisation et qui est prête à être utilisée dans des contextes de recherche et de production.

FAQ

Puis-je utiliser Qwen3 dans des produits commerciaux ?

Oui. La licence Apache 2.0 autorise l'utilisation commerciale, la modification et la distribution avec attribution.

Puis-je affiner les modèles Qwen3 ?

Oui, les modèles Qwen3 sont à poids ouvert et vous pouvez les régler avec précision.

Qwen3 prend-il en charge l'appel de fonctions ou l'utilisation d'outils ?

Oui. Qwen3 peut effectuer des appels de fonction lorsqu'il est intégré à un cadre de raisonnement tel que Qwen-Agent. Il prend en charge les analyseurs d'outils personnalisés, la configuration de l'utilisation des outils via MCP et les interfaces compatibles avec l'OpenAI.

Qwen3 offre-t-il une prise en charge multilingue dès sa sortie de l'emballage ?

Oui. Qwen3 a été formé sur des données provenant de 119 langues et dialectes, ce qui le rend adapté à des tâches telles que la traduction, l'assurance qualité multilingue et les déploiements LLM à l'échelle mondiale.

Je suis rédacteur et écrivain et je couvre les blogs, les tutoriels et les actualités sur l'IA, en m'assurant que tout est conforme à une stratégie de contenu solide et aux meilleures pratiques en matière de référencement. J'ai rédigé des cours de science des données sur Python, les statistiques, les probabilités et la visualisation des données. J'ai également publié un roman primé et je consacre mon temps libre à l'écriture de scénarios et à la réalisation de films.