Curso

Como alguien que ha apoyado a equipos de datos conplataformas MLOpsy ha ayudado a diseñar infraestructuras escalables, he visto de primera mano lo cruciales que son los lagos de datos en la pila de datos actual.

A diferencia de los almacenes de datos tradicionales, que exigen que los datos estén limpios y estructurados antes de almacenarlos, los lagos de datos te permiten almacenarlo todo en formatos brutos, desordenados y sin estructurar. Esta flexibilidad abre un mundo de posibilidades para aplicaciones y casos de uso basados en datos. Un lago de datos te permite reunir y almacenar datos de diversas fuentes en un solo lugar, donde pueden analizarse y utilizarse para la IA.

En este artículo, te explicaré qué es un lago de datos, cómo funciona, cuándo utilizarlo y cómo se compara con las soluciones más tradicionales.

Comprender el concepto de lago de datos

Antes de hablar de la arquitectura técnica o los casos de uso, es esencial entender qué es un lago de datos y qué lo distingue de los sistemas de almacenamiento más tradicionales.

Esta sección define el concepto, desglosa sus características clave y lo compara con el mundo más estructurado de los almacenes de datos.

Te recomiendo el curso Estrategia de Datos si quieres saber más sobre cómo puede ayudar a las empresas una estrategia de datos bien diseñada.

Definición de un lago de datos

Un lago de datos es un repositorio centralizado que almacena todos tus datos estructurados, semiestructurados y no estructurados a cualquier escala.

Puedes ingerir datos brutos de diversas fuentes y conservarlos en su formato original hasta que necesites procesarlos o analizarlos.

A diferencia de las bases de datos o los almacenes de datos, que suelen requerir un esquema predefinido (esquema en escritura), los lagos de datos utilizan un enfoque de esquema en lectura. Esto significa que la estructura se aplica sólo cuando se accede a los datos para su análisis, dando a los equipos flexibilidad para interpretar y transformar los datos posteriormente.

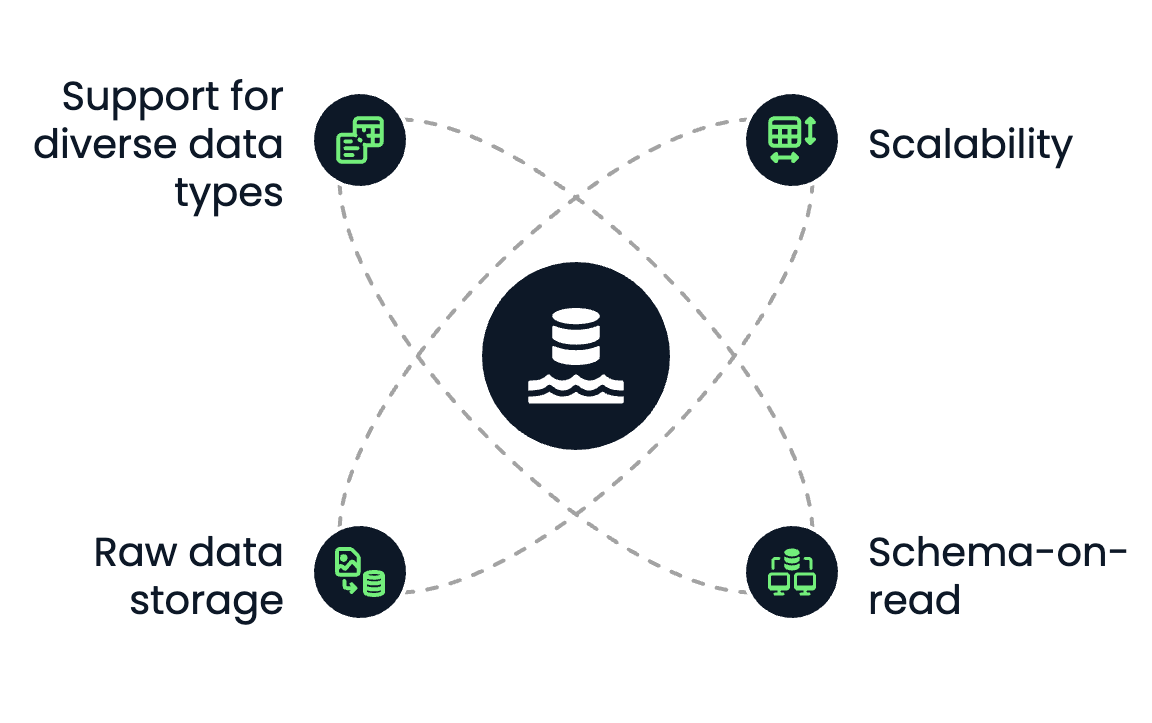

Características principales

Un lago de datos tiene las siguientes características básicas:

- Escalabilidad: Los lagos de datos se construyen para escalar horizontalmente. Tanto si almacenas terabytes como petabytes de datos, las soluciones de almacenamiento de objetos basadas en la nube, como Amazon S3 o Azure Data Lake Storage, facilitan el crecimiento sin preocuparse por la capacidad.

- Esquema en lectura: No necesitas definir el esquema al almacenar los datos. En su lugar, los científicos de datos, los analistas o los ingenieros pueden aplicar diferentes esquemas en función del caso de uso durante la recuperación o la transformación.

- Almacenamiento de datos en bruto: Los lagos de datos conservan todos los tipos de datos en su formato nativo, ya sean archivos CSV, registros JSON, archivos de audio, vídeos o datos de sensores.

- Admite diversos tipos de datos: Puedes almacenar datos estructurados (por ejemplo, tablas SQL), semiestructurados (por ejemplo, XML, JSON) y no estructurados (por ejemplo, imágenes, PDF, texto) en un solo lugar.

Características fundamentales de los lagos de datos. Imagen del autor.

Comparación con los almacenes de datos

Los lagos de datos y los almacenes de datos se utilizan para almacenar y analizar datos. Sin embargo, difieren significativamente en estructura, rendimiento y casos de uso.

Si eres nuevo en los almacenes de datos y quieres aprender más, te recomiendo el curso Conceptos de Almacén de Datos y los artículos Qué es un almacén de datos y Arquitectura de almacenes de datos: Tendencias, herramientas y técnicas.

Veamos en quése diferencian:

|

Función |

Lago de datos |

Almacén de datos |

|

Tipo de datos |

Estructurado, semiestructurado, no estructurado |

Sólo estructurado |

|

Formato de almacenamiento |

En bruto (objetos de archivo) |

Procesado (tablas, filas, columnas) |

|

Esquema |

Esquema en lectura |

Esquema en escritura |

|

Coste |

Almacenamiento de bajo coste |

Más caro por GB |

|

Caso práctico |

Aprendizaje automático, big data y almacenamiento de datos en bruto |

Inteligencia empresarial, análisis estructurado |

|

Rendimiento |

Flexible, depende del motor de cálculo |

Optimizado para consultas SQL rápidas |

En la práctica, muchas estrategias de datos modernas combinan ambas cosas: utilizan lagos de datos como base para el almacenamiento de datos brutos y almacenes de datos para la elaboración de informes estructurados y la inteligencia empresarial.

También existe una solución híbrida llamada "casa lago de datos". El artículo ¿Qué es un Data Lakehouse? Arquitectura, Tecnología y Casos de Uso lo explica con más detalle.

Componentes de una arquitectura de lago de datos

Una arquitectura de lago de datos bien diseñada es esencial para que los datos brutos sean utilizables y accesibles para el análisis posterior, el aprendizaje automático y la elaboración de informes.

Esta sección desglosa las cinco capas clave de un lago de datos moderno, desde la ingestión hasta la gobernanza.

Capa de ingestión de datos

La capa de ingestión introduce datos de diversas fuentes en el lago de datos. Estas fuentes incluyen sistemas internos (como bases de datos o CRM), API externas o dispositivos y registros IoT.

Hay tres modos principales de ingestión:

- Ingesta por lotes: Cargar datos periódicamente (como cada noche) en lotes.

- Ingestión de flujos: Flujos de datos en tiempo real, como el flujo de clics o los datos de los sensores.

- Ingestión híbrida: Una combinación de batch y stream, habitual en entornos empresariales.

Las herramientas de ingesta estándar incluyen:

- Apache Kafka y AWS Kinesis para streaming

- Apache NiFi, Flume y AWS Glue para ETL por lotes

Una capa de ingesta flexible garantiza que los datos lleguen rápidamente y que puedan manejar diversos formatos y velocidades.

Capa de almacenamiento

Cuando se ingieren los datos, se almacenan en la zona bruta del lago de datos. La capa de almacenamiento suele basarse en el almacenamiento de objetos en la nube, que ofrece escalado elástico, redundancia y rentabilidad.

Las opciones más populares son:

- Amazon S3

- Azure Data Lake Storage

- Google Cloud Storage

Sin embargo, también hay opciones para las empresas que quieren almacenar sus datos en sus nubes locales alojadas en sus centros de datos.

Uno podría, por ejemplo, instalar MinIO en su infraestructura. El propio MinIO es de código abierto y ofrece una API compatible con Amazon S3.

Las características clave de una capa de almacenamiento incluyen:

- Durabilidad y disponibilidad: Los datos se replican automáticamente entre regiones.

- Separación de almacenamiento y cálculo: Puedes escalar el cálculo de forma independiente en función de la demanda.

- Nivelación de datos: Permite el almacenamiento en frío para archivar y el almacenamiento en caliente para los datos a los que se accede con frecuencia.

Almacenar los datos en su formato original te permite conservar todo su potencial para procesarlos y analizarlos en el futuro.

Gestión de catálogos y metadatos

Sin metadatos, un lago de datos se convierte en un pantano de datos, ya que es imposible volver a encontrar tus datos y trabajar con ellos de forma eficiente.

El catálogo y la capa demetadatos aportan estructura al caos llevando un registro:

- Esquema de datos

- Localización y partición de datos

- Linaje y versionado

Esta capa garantiza la descubribilidad y usabilidad indexando todos los conjuntos de datos disponibles y permitiendo la búsqueda y el control de acceso. Las herramientas estándar para esta capa son

- Catálogo de datos de AWS Glue

- Apache Hive Metastore

- Apache Atlas

- DataHub

Un sistema de metadatos sólido es esencial para la colaboración, la gobernanza y la eficacia operativa.

Capa de procesamiento y análisis

Esta es la capa en la que se procesan los datos brutos y se convierten en información. La capa de procesamiento admite diversas operaciones, desde transformaciones fundamentales hasta análisis avanzados y aprendizaje automático.

Los flujos de trabajo típicosincluyen:

- ETL/ELT pipelines para la limpieza y normalización de datos

- Consulta SQL

- Canalizaciones de aprendizaje automático

Esta capa suele incluir computación por lotes y en tiempo real, permitiendo el análisis exploratorio de datos y las cargas de trabajo de producción.

Seguridad y gobernanza

Una arquitectura robusta de lago de datos debe tener mecanismos incorporados para proteger los datos sensibles y garantizar el cumplimiento. Esta parte es crucial, ya que los lagos de datos contienen en su mayoría muchos datos sensibles que, si se ponen en peligro, podrían perjudicar a la empresa a la que pertenecen.

Las características esenciales de esa capa incluyen

- Gestión de identidades y accesos (IAM): Restringe quién puede ver o modificar los datos.

- Cifrado: Cifrado en tránsito (TLS) y en reposo.

- Enmascaramiento y anonimización de datos: Para tratar información personal identificable.

- Auditoría y seguimiento: Para la trazabilidad y el cumplimiento.

Herramientas y servicios populares:

- Formación Lago AWS

- Guardabosques Apache

- Visión Azul

La seguridad determina a menudo si un lago de datos puede utilizarse en sectores regulados como el financiero, el sanitario o el militar.

Casos de uso habituales de los lagos de datos

Los lagos de datos son adecuados para casos de uso en los que la escala, la flexibilidad y la diversidad de tipos de datos son esenciales. Sirven de base para las operaciones y aplicaciones modernas basadas en datos en todos los sectores.

En esta sección, exploraremos algunos de los casos de uso más comunes e impactantes en los que los lagos de datos desempeñan un papel central.

Análisis de grandes datos

Uno de los usos más conocidos de los lagos de datos es permitir el análisis de datos a gran escala.

Como los lagos de datos pueden almacenar datos en su forma bruta, las organizaciones ya no tienen que preocuparse de limpiar o estructurar cada conjunto de datos antes de analizarlos. Es ideal para recopilar registros, datos de sensores o secuencias de clics, que son demasiado grandes o cambian demasiado rápido para los sistemas tradicionales.

Los lagos de datos permiten

- Analiza los datos históricos junto con los datos en tiempo real

- Ejecuta consultas personalizadas en conjuntos de datos a escala de petabytes

- Permite el análisis interdepartamental con una única fuente de verdad

Herramientascomo Amazon Athena o Google BigQuery pueden consultar los datos directamente en el lago, sin necesidad de transformaciones complejas ni de trasladar los datos a otro lugar.

Aprendizaje automático e IA

Los lagos de datos se adaptan perfectamente a los flujos de trabajo del aprendizaje automático y la IA.

Proporcionan el entorno ideal para:

- Almacenamiento de conjuntos de datos de entrenamiento en múltiples formatos (por ejemplo, CSV, Parquet, imágenes, etc.)

- Conservar datos sin procesar y, por tanto, más completos, lo que permite una mayor flexibilidad a la hora de explorar, experimentar e iterar sobre modelos ML

- Impulsar canalizaciones automatizadas de ML que iteren sobre volúmenes masivos de datos

En lugar de limitar los modelos a los datos prelimpiados de un almacén, los científicos de datos pueden acceder a datos ricos y sin procesar para experimentar con mayor libertad e iterar más rápidamente. Esto es especialmente útil en ámbitos como el procesamiento del lenguaje natural (PLN), la visión por ordenador y la previsión de series temporales.

Si quieres un ejemplo de cómo puede utilizarse la solución DatabricksLakehouse para la IA, te recomiendo queleas Una guía completa de la IA de Databricks Lakehouse para científicos de datos.

Archivo de datos centralizado

Muchas organizaciones utilizan los lagos de datos para el almacenamiento y archivo a largo plazo.

Gracias al bajo coste del almacenamiento de objetos en la nube, es económicamente factible almacenar años de datos operativos que quizá no se utilicen a diario, pero a los que aún es necesario acceder con fines de cumplimiento y auditoría, análisis de tendencias, previsiones o entrenamiento de futuros modelos de ML.

La mayoría de las soluciones de almacenamiento de objetos en la nube te permiten escalonar el almacenamiento para archivar los datos a los que se accede raramente, manteniendo el lago reducido y eficiente.

Experimentación en ciencia de datos

Los lagos de datos permiten a los científicos de datos explorar datos brutos sin restricciones.

Tanto si estás construyendo un prototipo rápido, probando una nueva hipótesis o ejecutando un análisis exploratorio de datos (AED), el lago te ofrece un acceso flexible a:

- Datos en bruto no estructurados (como PDF, correos electrónicos, archivos de texto)

- Formatos semiestructurados (como JSON, XML o logs)

- Conjuntos de datos masivos que no cabrían en una BD tradicional

Esta capa de experimentación es esencial para la innovación. Los lagos de datos te permiten explorar conjuntos de datos de nuevas formas sin tener que enviar tickets al equipo de ingeniería de datos ni esperar a tener una versión depurada en el almacén.

Ventajas y retos de los lagos de datos

Aunque los lagos de datos proporcionan potentes capacidades para los flujos de trabajo de datos modernos, también presentan retos únicos. Comprender ambas partes es esencial antes de adoptar una arquitectura de lago de datos. En esta sección, hablaré de las principales ventajas, los escollos más comunes y cómo superarlos.

Ventajas de los lagos de datos

La ventaja más significativa de un lago de datos es su flexibilidad. No estás atado a un esquema o modelo de datos específico desde el principio, lo que es excelente cuando trabajas con conjuntos de datos que cambian o evolucionan rápidamente.

He aquí algunas ventajas clave:

- Escalabilidad: Los lagos de datos se construyen sobre un almacenamiento nativo en la nube que se escala sin esfuerzo, tanto si almacenas gigabytes como petabytes.

- Compatible con todos los tipos de datos: En la misma plataforma se pueden almacenar datos estructurados (tablas SQL), semiestructurados (JSON, XML) y no estructurados (texto, imágenes, vídeo).

- Rentabilidad: El almacenamiento de objetos en la nube (por ejemplo, Amazon S3) es significativamente más barato que el almacenamiento utilizado por las bases de datos o almacenes tradicionales.

- Arquitectura desacoplada: El cálculo y el almacenamiento están separados para escalar las cargas de trabajo analíticas independientemente del almacenamiento de datos.

- Análisis mejorados: Los lagos de datos almacenan datos brutos sin procesar y permiten un análisis de datos más completo y flexible, incluido el aprendizaje automático y el análisis predictivo.

- Mejora de la toma de decisiones: Los lagos de datos pueden permitir un análisis más profundo y exhaustivo de los datos, lo que conduce a decisiones mejor informadas en toda la organización.

- Eliminación de silos de datos: Los lagos de datos ayudan a romper los silos de datos consolidando los datos de varias fuentes en un único repositorio centralizado.

En los proyectos en los que he trabajado, esta centralización ha reducido los silos de datos y ha mejorado significativamente la colaboración entre equipos.

Principales retos

Los lagos de datos son potentes, pero hay que gestionar algunos retos clave. Si no se gestionan, pueden quedar rápidamente desorganizados e inutilizables, un estado que suele denominarse "pantano de datos".

Algunos retos comunes son:

- Falta de estructura: Sin esquemas predefinidos, los datos pueden ser difíciles de consultar, documentar o gobernar.

- Problemas de calidad de los datos: Dado que los datos se ingieren en bruto, los datos de mala calidad o incompletos pueden pasar desapercibidos hasta el final.

- Lagunas en los metadatos y la descubribilidad: Sin un sistema de catalogación sólido, los usuarios pueden no saber qué datos existen o cómo utilizarlos.

- Gobernanza compleja: Garantizar el control de acceso, la auditabilidad y el cumplimiento es más difícil en un entorno flexible.

Estos problemas pueden reducir la confianza en el lago de datos y la adopción en toda la empresa.

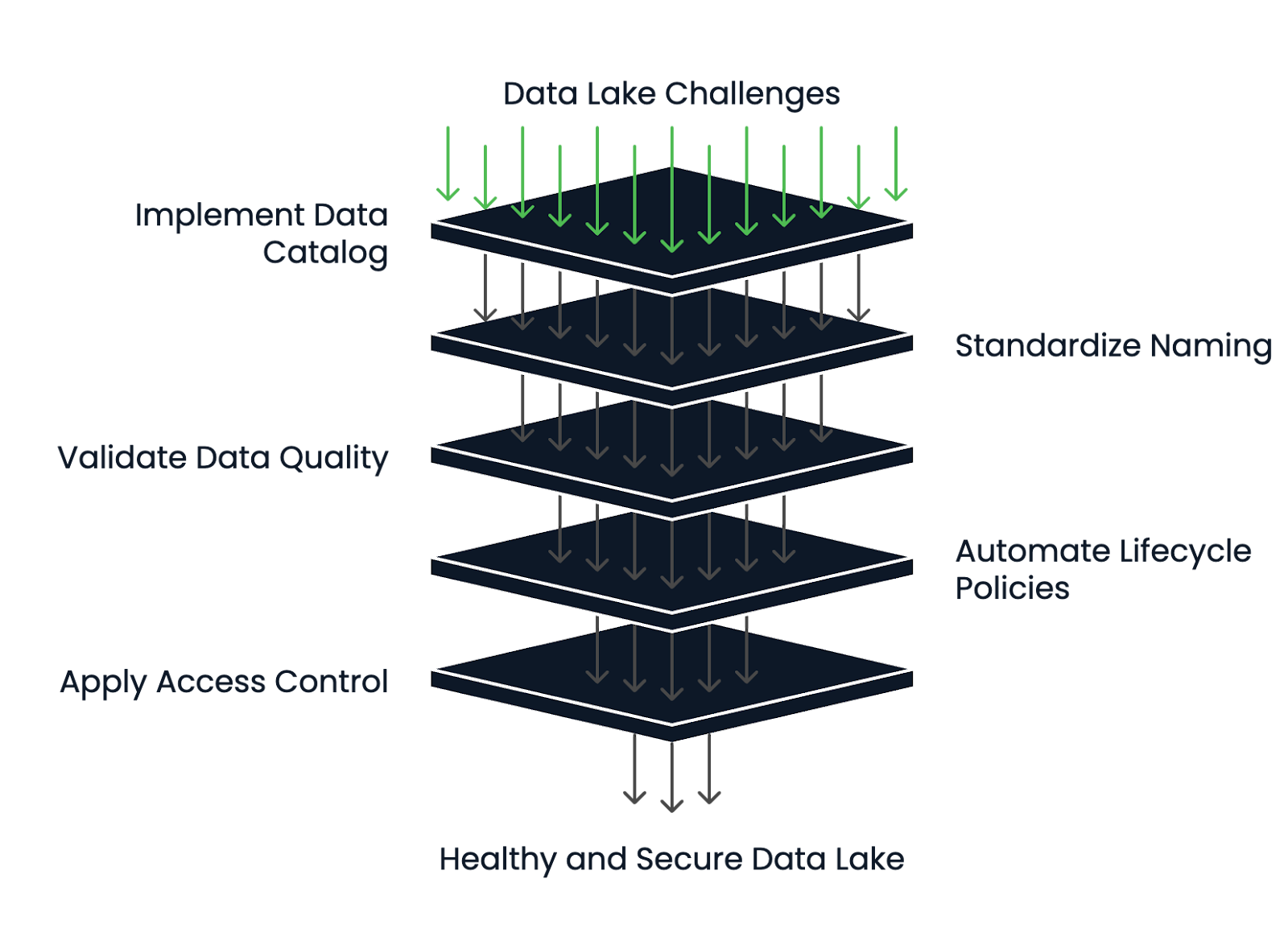

Cómo mitigar los retos

Los lagos de datos de más éxito tienen sólidas prácticas de gestión de metadatos y del ciclo de vida.

He aquí cómo reducir el riesgo y mantener sano tu lago de datos:

- Implementa un catálogo de datos: Herramientas como AWS Glue o DataHub ayudan a mantener la descubribilidad, las definiciones de esquemas y el seguimiento del linaje.

- Utiliza estructuras estandarizadas de nombres y carpetas: Esto crea coherencia y reduce la confusión del equipo.

- Adapta las herramientas de validación y perfilado de datos: Garantiza la calidad durante la ingestión y revalida periódicamente los datos.

- Automatizar las políticas del ciclo de vida: Mueve automáticamente los datos obsoletos al almacenamiento en frío o elimínalos tras un periodo de retención definido.

- Aplica un sólido control de acceso y encriptación: Para proteger los datos sensibles, utiliza políticas IAM, acceso basado en roles y encriptación en reposo y en tránsito.

Un lago de datos puede seguir siendo un activo y no un pasivo si se diseña una arquitectura limpia desde el principio y se establecen estructuras de gobierno sólidas.

Marco de gestión de la salud del lago de datos. Imagen del autor.

Tecnologías populares de lagos de datos

Con la creciente importancia de los lagos de datos en la arquitectura de datos moderna, ha surgido una amplia gama de tecnologías para darles soporte. Estas herramientas abarcan plataformas nativas en la nube, ecosistemas de código abierto e integraciones con soluciones analíticas. En esta sección, te guiaré a través de las herramientas más populares.

Soluciones nativas en la nube

Los proveedores de la nube ofrecen servicios totalmente gestionados para crear y mantener lagos de datos. Estas plataformas suelen ser el punto de partida para los equipos que buscan escala, durabilidad y una estrecha integración con otros servicios en la nube.

Las soluciones nativas en la nube más populares son:

- Amazon S3 + AWS Formación de lagos: S3 proporciona almacenamiento de objetos, mientras que Lake Formation gestiona los permisos, la catalogación y la gobernanza.

- Almacenamiento Azure Data Lake: Combina el almacenamiento blob con capacidades similares a HDFS.

- Almacenamiento en la nube de Google (GCS): GCS es muy duradero y se integra bien con BigQuery y Vertex AI para cargas de trabajo analíticas y de ML.

Estos servicios están optimizados para ofrecer elasticidad, rentabilidad y seguridad, lo que los hace ideales para los lagos de datos a escala empresarial.

Herramientas de código abierto

Las tecnologías de código abierto añaden flexibilidad y extensibilidad, especialmente para los equipos que quieren evitar la dependencia de un proveedor u operar en entornos híbridos/multi-nube.

Las soluciones más populares son:

- Apache Hadoop: Uno de los marcos originales de los lagos de datos. Aunque hoy es menos habitual en los nuevos proyectos, sentó las bases del almacenamiento y procesamiento de datos distribuidos.

- Delta Lake: Desarrollado por Databricks, Delta Lake añade transacciones ACID, versionado y aplicación de esquemas al almacenamiento de objetos en la nube.

- Apache Iceberg: Iceberg ofrece operaciones atómicas, partición oculta y viaje en el tiempo para consultar datos históricos.

- Presto: Un motor de consultas SQL distribuido que te permite ejecutar consultas rápidas e interactivas sobre datos almacenados en S3, HDFS u otras fuentes sin mover los datos.

Estas herramientas suelen integrarse en plataformas de datos más amplias y son las preferidas por los equipos de ingeniería que construyen soluciones personalizadas o modulares.

Si quieres explorar las diferencias entreApache Iceberg y Delta Lake con más detalle, te recomiendo queleas Apache Iceberg vs. Delta Lake. Delta Lake: Características, diferencias y casos de uso.

Integración con plataformas analíticas

Un lago de datos adquiere valor cuando se integra con herramientas de análisis y visualización que ayudan a extraer ideas e impulsar las decisiones empresariales. Por tanto, antes de seleccionar la solución definitiva, siempre hay que comprobar por adelantado con qué plataformas analíticas debe integrarse la solución de lago de datos.

Las plataformas analíticas más populares son:

- Databricks: Combina el almacenamiento del lago de datos con un espacio de trabajo colaborativo para la ingeniería de datos, el aprendizaje automático y la analítica. es compatible con Delta Lake desde el primer momento.

- Copo de nieve: Aunque tradicionalmente es un almacén de datos, Snowflake puede consultar datos externos en el almacenamiento en la nube (a través de Snowpipe o tablas externas), lo que lo convierte en una solución híbrida de almacén de datos.

- Power BI, Tableau: Estas herramientas de BI pueden conectarse a los lagos de datos directamente o a través de motores de consulta como Athena o BigQuery, lo que permite crear cuadros de mando e informes sobre datos brutos o semiestructurados.

Si quieres saber más sobre Databricks , te recomiendoel curso Introducción a Databricks.

Al elegir las tecnologías, es esencial alinearlas con la experiencia de tu equipo, tu estrategia de datos y el nivel de flexibilidad o abstracción que necesitas.

Conclusión

Los lagos de datos permiten a las organizaciones crear sólidas aplicaciones de aprendizaje automático y cuadros de mando en tiempo real, al ofrecer una base de datos flexible, escalable, sin procesar y semiestructurada.

En este artículo, exploramos qué es un lago de datos, sus componentes clave y cuándo utilizarlo. Discutimos las ventajas, como la flexibilidad y la escalabilidad, los retos, como la gobernanza de los datos y el riesgo de un "pantano de datos", y cómo evitarlos. Por último, cubrimos las tecnologías más populares para construir lagos de datos, incluidas las plataformas en la nube y las herramientas de código abierto.

Desde mi experiencia trabajando en MLOps, infraestructuras de IA y sistemas de datos nativos en la nube, he visto cómo un lago de datos bien diseñado puede transformar la forma en que los equipos colaboran e innovan. Pero también he visto lo rápido que un lago de datos mal gobernado puede convertirse en un lastre, y navegar por él puede resultar difícil.

Si tu organización maneja datos complejos, diversos o a gran escala y quiere permitiruna experimentación más rápida, análisis más ricos o desarrollo de IA, un lago de datos puede ser precisamente lo que necesitas.

El curso Comprender la Arquitectura Moderna de Datos es una gran primera parada si quieres saber más.

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Qué tipo de organizaciones se benefician más del uso de un lago de datos?

Las organizaciones que trabajan con conjuntos de datos a gran escala, diversos o en rápida evolución, como las empresas tecnológicas, las instituciones financieras y los proveedores de atención sanitaria, son las que más se benefician de los lagos de datos.

¿Cómo soporta un lago de datos los análisis en tiempo real?

Un lago de datos puede ingerir datos en flujo desde dispositivos o aplicaciones IoT en tiempo real, permitiendo un análisis inmediato y una toma de decisiones más rápida mediante herramientas como Apache Kafka y Amazon Kinesis.

¿Los lagos de datos pueden desplegarse in situ, o son sólo en la nube?

Aunque los lagos de datos basados en la nube son habituales, es posible desplegar lagos de datos locales utilizando soluciones como Hadoop Distributed File System (HDFS) o MinIO para el almacenamiento de objetos compatible con S3.

¿Qué es un pantano de datos y cómo puede evitarse?

Un pantano de datos se produce cuando un lago de datos se vuelve desorganizado e inutilizable debido a una mala gestión y gobernanza de los metadatos. Unas políticas sólidas de catalogación, documentación y gobernanza ayudan a evitarlo.

¿Cómo permiten los lagos de datos el desarrollo del aprendizaje automático?

Al almacenar datos en bruto y de diversos tipos, los lagos de datos permiten a los científicos de datos experimentar con mayor libertad, crear conjuntos de datos de entrenamiento más ricos e iterar más rápidamente en modelos de aprendizaje automático.

¿Existen problemas específicos de cumplimiento con los lagos de datos?

Sí, el almacenamiento de datos no estructurados y sensibles en formatos sin procesar requiere un cifrado estricto, control de acceso, auditoría y marcos de cumplimiento para cumplir normativas como GDPR e HIPAA.

¿Cómo afecta el esquema en lectura al análisis de datos en un lago de datos?

El esquema en lectura permite a los usuarios aplicar diferentes esquemas en el momento de la consulta, lo que ofrece flexibilidad, pero también requiere un descubrimiento y una interpretación cuidadosos de los datos para un análisis preciso.

¿Cuál es la diferencia entre un lago de datos y una casa lago de datos?

Un data lakehouse combina la flexibilidad de un lago de datos con las capacidades de gestión y transaccionales de un almacén de datos, ofreciendo lo mejor de ambos mundos para la analítica y la IA.

¿Cuánto suele costar mantener un lago de datos basado en la nube?

Los costes varían en función del volumen de almacenamiento, la transferencia de datos y la frecuencia de acceso, pero los servicios de almacenamiento de objetos en la nube (como Amazon S3) suelen ser más baratos por GB que las bases de datos tradicionales.

¿Qué habilidades se necesitan para construir y gestionar con éxito un lago de datos?

Entre las habilidades clave se incluyen la gestión de infraestructuras en la nube, ingeniería de datos, experiencia en seguridad y cumplimiento, gestión de metadatos y experiencia con herramientas de big data como Spark o Presto.

Soy un Ingeniero de la Nube con una sólida base de Ingeniería Eléctrica, aprendizaje automático y programación. Mi carrera comenzó en visión por ordenador, centrándome en la clasificación de imágenes, antes de pasar a MLOps y DataOps. Me especializo en la creación de plataformas MLOps, el apoyo a los científicos de datos y la entrega de soluciones basadas en Kubernetes para agilizar los flujos de trabajo de aprendizaje automático.