Kurs

Als jemand, der Datenteams mitMLOps-Plattformenunterstütztund an der Entwicklung skalierbarer Infrastrukturen mitgewirkt hat, weiß ich aus erster Hand, wie wichtig Data Lakes in der heutigen Datenlandschaft sind.

Im Gegensatz zu traditionellen Data Warehouses, bei denen die Daten vor der Speicherung sauber und strukturiert sein müssen, kannst du in Data Lakes alles in roher, ungeordneter und unstrukturierter Form speichern. Diese Flexibilität eröffnet dir eine Welt voller Möglichkeiten für datengesteuerte Anwendungen und Anwendungsfälle. Ein Data Lake ermöglicht es dir, Daten aus verschiedenen Quellen an einem Ort zu sammeln und zu speichern, wo sie weiter analysiert und für KI genutzt werden können.

In diesem Artikel erkläre ich, was ein Data Lake ist, wie er funktioniert, wann er eingesetzt werden sollte und wie er sich von herkömmlichen Lösungen unterscheidet.

Das Konzept eines Data Lake verstehen

Bevor wir über die technische Architektur oder Anwendungsfälle sprechen, ist es wichtig zu verstehen, was ein Data Lake ist und was ihn von herkömmlichen Speichersystemen unterscheidet.

In diesem Abschnitt wird das Konzept definiert, seine wichtigsten Merkmale aufgeschlüsselt und mit der stärker strukturierten Welt der Data Warehouses verglichen.

Ich empfehle den Kurs Datenstrategie, wenn du mehr darüber erfahren möchtest, wie eine gut durchdachte Datenstrategie Unternehmen helfen kann.

Definition eines Datensees

Ein Data Lake ist ein zentraler Speicher, der alle strukturierten, halbstrukturierten und unstrukturierten Daten in beliebigem Umfang speichert.

Du kannst Rohdaten aus verschiedenen Quellen einlesen und sie in ihrem ursprünglichen Format aufbewahren, bis du sie verarbeiten oder analysieren musst.

Im Gegensatz zu Datenbanken oder Data Warehouses, die in der Regel ein vordefiniertes Schema benötigen (Schema-on-write), verwenden Data Lakes einen Schema-on-read-Ansatz. Das bedeutet, dass die Struktur nur dann angewendet wird, wenn auf die Daten für die Analyse zugegriffen wird, sodass die Teams die Daten später flexibel interpretieren und umwandeln können.

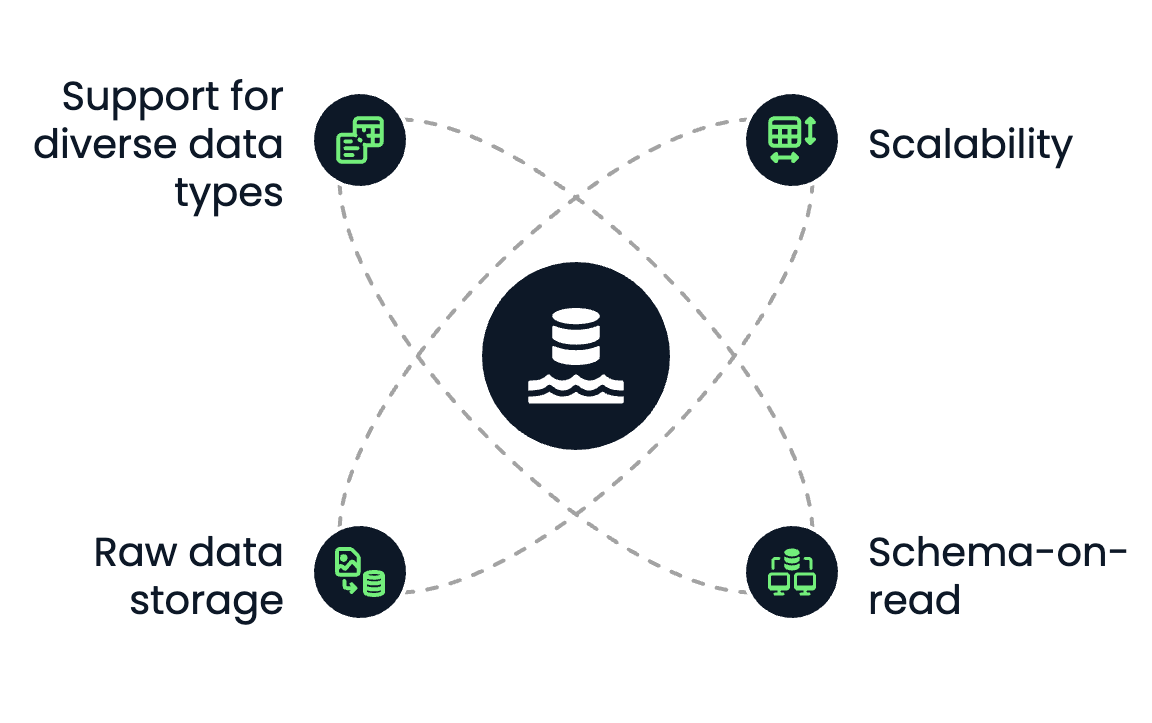

Kernmerkmale

Ein Data Lake weist die folgenden Hauptmerkmale auf:

- Skalierbarkeit: Data Lakes sind für eine horizontale Skalierung ausgelegt. Egal, ob du Terabytes oder Petabytes an Daten speicherst, mit Cloud-basierten Objektspeicherlösungen wie Amazon S3 oder Azure Data Lake Storage kannst du ganz einfach wachsen, ohne dir Gedanken über die Kapazität zu machen.

- Schema-auf-Lese: Du musst das Schema beim Speichern der Daten nicht definieren. Stattdessen können Datenwissenschaftler, Analysten oder Ingenieure bei der Abfrage oder Umwandlung je nach Anwendungsfall unterschiedliche Schemata anwenden.

- Speicherung von Rohdaten: Data Lakes bewahren alle Datentypen in ihrem nativen Format auf, egal ob CSV-Dateien, JSON-Logs, Audiodateien, Videos oder Sensordaten.

- Unterstützung für verschiedene Datentypen: Du kannst strukturierte (z. B. SQL-Tabellen), halbstrukturierte (z. B. XML, JSON) und unstrukturierte Daten (z. B. Bilder, PDFs, Text) an einem Ort speichern.

Kernmerkmale von Data Lakes. Bild vom Autor.

Vergleich mit Data Warehouses

Data Lakes und Data Warehouses werden zum Speichern und Analysieren von Daten verwendet. Sie unterscheiden sich jedoch erheblich in Struktur, Leistung und Anwendungsfällen.

Wenn du neu im Bereich Data Warehouse bist und mehr darüber erfahren möchtest, empfehle ich dir den Kurs Data Warehousing Concepts und die Artikel What Is a Data Warehouse und Data Warehouse Architecture: Trends, Tools und Techniken.

Schauen wiruns an, wie siesich unterscheiden:

|

Feature |

Datensee |

Data Warehouse |

|

Datentyp |

Strukturiert, halbstrukturiert, unstrukturiert |

Nur strukturiert |

|

Speicherformat |

Raw (Dateiobjekte) |

Verarbeitet (Tabellen, Zeilen, Spalten) |

|

Schema |

Schema-on-read |

Schema-on-write |

|

Kosten |

Kostengünstige Lagerung |

Teurer pro GB |

|

Anwendungsfall |

Maschinelles Lernen, Big Data und Speicherung von Rohdaten |

Business Intelligence, strukturierte Analytik |

|

Leistung |

Flexibel, abhängig von der Compute Engine |

Optimiert für schnelle SQL-Abfragen |

In der Praxis kombinieren viele moderne Datenstrategien beides: Sie nutzen Data Lakes als Grundlage für die Speicherung von Rohdaten und Data Warehouses für strukturierte Berichte und Business Intelligence.

Es gibt auch eine hybride Lösung, das sogenannte Data Lakehouse. Der Artikel Was ist ein Data Lakehouse? Architektur, Technologie und Anwendungsfälle erklärt es genauer.

Komponenten einer Data Lake Architektur

Eine gut durchdachte Data-Lake-Architektur ist wichtig, um Rohdaten für nachgelagerte Analysen, maschinelles Lernen und Berichte nutzbar und zugänglich zu machen.

In diesem Abschnitt werden die fünf Schlüsselebenen eines modernen Data Lakes beschrieben, von der Datenaufnahme bis zur Governance.

Dateneingabeschicht

Der Ingestion Layer bringt Daten aus verschiedenen Quellen in den Data Lake. Zu diesen Quellen gehören interne Systeme (wie Datenbanken oder CRMs), externe APIs oder IoT-Geräte und Logs.

Es gibt drei Hauptarten der Einnahme:

- Batch-Ingestion: Regelmäßiges (z. B. nächtliches) Laden von Daten in Stapeln.

- Stream-Ingestion: Echtzeit-Datenströme, wie z. B. Clickstream- oder Sensordaten.

- Hybride Einnahme: Eine Kombination aus Batch und Stream, wie sie in Unternehmensumgebungen üblich ist.

Zu den Standard-Ingestion-Tools gehören:

- Apache Kafka und AWS Kinesis für Streaming

- Apache NiFi, Flume und AWS Glue für Batch-ETL

Ein flexibler Ingestion Layer sorgt dafür, dass die Daten schnell ankommen und eine Vielzahl von Formaten und Geschwindigkeiten verarbeiten können.

Speicherschicht

Wenn die Daten aufgenommen werden, werden sie in der Rohzone des Data Lake gespeichert. Die Speicherebene basiert in der Regel auf Cloud Object Storage, der elastische Skalierung, Redundanz und Kosteneffizienz bietet.

Beliebte Optionen sind:

- Amazon S3

- Azure Data Lake Storage

- Google Cloud Storage

Es gibt aber auch Optionen für Unternehmen, die ihre Daten in ihren eigenen Clouds speichern wollen, die in ihren Rechenzentren gehostet werden.

Man könnte z.B. MinIO in seiner Infrastruktur installieren. MinIO selbst ist Open-Source und bietet eine Amazon S3-kompatible API.

Zu den wichtigsten Merkmalen einer Speicherschicht gehören:

- Langlebigkeit und Verfügbarkeit: Die Daten werden automatisch zwischen den Regionen repliziert.

- Trennung von Speicher und Rechenleistung: Du kannst die Rechenleistung je nach Bedarf unabhängig skalieren.

- Data Tiering: Ermöglicht kalten Speicher für die Archivierung und heißen Speicher für Daten, auf die häufig zugegriffen wird.

Wenn du die Daten in ihrem ursprünglichen Format speicherst, behältst du ihr gesamtes Potenzial für die spätere Verarbeitung und Analyse.

Katalog- und Metadatenverwaltung

Ohne Metadaten wird ein Data Lake zu einem Datensumpf, denn es ist unmöglich, deine Daten wiederzufinden und effizient mit ihnen zu arbeiten.

Der Katalog und die Metadatenebene bringen Struktur in das Chaos, indem sie den Überblick behalten:

- Datenschema

- Speicherort und Aufteilung der Daten

- Abstammung und Versionierung

Diese Ebene stellt die Auffindbarkeit und Nutzbarkeit sicher, indem sie alle verfügbaren Datensätze indexiert und die Suche und Zugriffskontrolle ermöglicht. Zu den Standardwerkzeugen für diese Ebene gehören:

- AWS Glue Datenkatalog

- Apache Hive Metastore

- Apache Atlas

- DataHub

Ein solides Metadatensystem ist für die Zusammenarbeit, die Verwaltung und die betriebliche Effizienz unerlässlich.

Verarbeitungs- und Analyseschicht

Dies ist die Ebene, auf der Rohdaten verarbeitet und in Erkenntnisse umgewandelt werden. Die Verarbeitungsebene unterstützt verschiedene Operationen, von grundlegenden Transformationen bis hin zu fortgeschrittenen Analysen und maschinellem Lernen.

TypischeArbeitsabläufe sind:

- ETL/ELT-Pipelines für die Datenbereinigung und -normalisierung

- SQL-Abfragen

- Pipelines für maschinelles Lernen

Diese Schicht umfasst oft Batch- und Echtzeitberechnungen, die explorative Datenanalysen und Produktionsworkloads ermöglichen.

Sicherheit und Governance

Eine robuste Data-Lake-Architektur muss über integrierte Mechanismen verfügen, um sensible Daten zu schützen und die Einhaltung von Vorschriften zu gewährleisten. Dieser Teil ist entscheidend, da Data Lakes meist viele sensible Daten enthalten, die, wenn sie kompromittiert werden, dem Unternehmen, zu dem sie gehören, schaden könnten.

Zu den wesentlichen Merkmalen dieser Ebene gehören:

- Identitäts- und Zugriffsmanagement (IAM): Schränke ein, wer Daten sehen oder ändern kann.

- Verschlüsselung: Verschlüsselung während des Transports (TLS) und im Ruhezustand.

- Datenmaskierung und Anonymisierung: Für den Umgang mit personenbezogenen Daten.

- Auditing und Überwachung: Für Rückverfolgbarkeit und Konformität.

Beliebte Tools und Dienste:

- AWS Lake Formation

- Apache Ranger

- Azure Purview

Die Sicherheit entscheidet oft darüber, ob ein Data Lake in regulierten Branchen wie dem Finanzwesen, dem Gesundheitswesen oder dem Militär eingesetzt werden kann.

Häufige Anwendungsfälle für Data Lakes

Data Lakes eignen sich gut für Anwendungsfälle, bei denen Skalierbarkeit, Flexibilität und unterschiedliche Datentypen wichtig sind. Sie dienen als Grundlage für moderne datengesteuerte Abläufe und Anwendungen in allen Branchen.

In diesem Abschnitt werden wir einige der häufigsten und wirkungsvollsten Anwendungsfälle untersuchen, in denen Data Lakes eine zentrale Rolle spielen.

Big Data-Analytik

Eine der bekanntesten Anwendungen von Data Lakes ist die Ermöglichung groß angelegter Datenanalysen.

Da Data Lakes Daten in ihrer Rohform speichern können, müssen sich Unternehmen nicht mehr darum kümmern, jeden Datensatz vor der Analyse zu bereinigen oder zu strukturieren. Dies ist ideal für die Erfassung von Logs, Sensordaten oder Clickstreams, die für herkömmliche Systeme zu groß sind oder sich schnell ändern.

Data Lakes machen es möglich,:

- Analysiere historische Daten neben Echtzeitdaten

- Führen Sie benutzerdefinierte Abfragen auf Petabyte-Datensätzen aus

- Abteilungsübergreifende Analysen mit einer einzigen Quelle der Wahrheit ermöglichen

Toolswie Amazon Athena oder Google BigQuery können Daten direkt im Lake abfragen, ohne dass komplexe Transformationen oder das Verschieben der Daten an einen anderen Ort erforderlich sind.

Maschinelles Lernen und KI

Data Lakes sind perfekt für maschinelles Lernen und KI-Workflows geeignet.

Sie bieten die ideale Umgebung für:

- Speichern von Trainingsdatensätzen in verschiedenen Formaten (z. B. CSV, Parquet, Bilder, etc.)

- Rohdaten und damit umfassendere Daten, die mehr Flexibilität beim Erforschen, Experimentieren und Iterieren von ML-Modellen ermöglichen

- Automatisierte ML-Pipelines, die über riesige Datenmengen iterieren

Anstatt Modelle auf vorbereinigte Daten aus einem Lagerhaus zu beschränken, können Datenwissenschaftler/innen auf umfangreiche Rohdaten zugreifen, um freier zu experimentieren und schneller zu iterieren. Dies ist vor allem in Bereichen wie der Verarbeitung natürlicher Sprache (NLP), dem Computersehen und der Zeitreihenprognose nützlich.

Wenn du ein Beispiel dafür suchst, wie die Databricks Lakehouse-Lösung für KI genutzt werden kann, empfehle ich dirdie Lektüre von A Comprehensive Guide to Databricks Lakehouse AI For Data Scientists.

Zentralisierte Datenarchivierung

Viele Unternehmen nutzen Data Lakes für die langfristige Speicherung und Archivierung.

Dank der niedrigen Kosten der Cloud-Objektspeicherung ist es wirtschaftlich machbar, jahrelange Betriebsdaten zu speichern, die zwar nicht täglich genutzt werden, aber dennoch für Compliance- und Audit-Zwecke, Trendanalysen, Prognosen oder das Training zukünftiger ML-Modelle zugänglich sein müssen.

Die meisten Cloud-Objektspeicherlösungen ermöglichen es dir, deinen Speicher zu staffeln, um selten genutzte Daten zu archivieren und gleichzeitig den See schlank und effizient zu halten.

Datenwissenschaftliches Experimentieren

Data Lakes ermöglichen es Datenwissenschaftlern, Rohdaten ohne Einschränkungen zu untersuchen.

Ganz gleich, ob du einen schnellen Prototyp baust, eine neue Hypothese testest oder eine explorative Datenanalyse (EDA) durchführst, der Lake bietet dir flexiblen Zugriff darauf:

- Unstrukturierte Rohdaten (wie PDFs, E-Mails, Textdateien)

- Semi-strukturierte Formate (wie JSON, XML oder Logs)

- Riesige Datensätze, die nicht in eine herkömmliche DB passen würden

Diese Experimentierebene ist für die Innovation unerlässlich. Mit Data Lakes kannst du Datensätze auf neue Art und Weise erforschen, ohne Tickets an das Data Engineering Team zu schicken oder auf eine bereinigte Version im Warehouse zu warten.

Vorteile und Herausforderungen von Data Lakes

Data Lakes bieten zwar leistungsstarke Funktionen für moderne Daten-Workflows, haben aber auch einzigartige Herausforderungen. Es ist wichtig, beide Seiten zu verstehen, bevor du eine Data-Lake-Architektur einführst. In diesem Abschnitt erläutere ich die wichtigsten Vorteile, die häufigsten Fallstricke und wie du sie umgehen kannst.

Vorteile von Data Lakes

Der größte Vorteil eines Data Lake ist seine Flexibilität. Du bist nicht von Anfang an an ein bestimmtes Schema oder Datenmodell gebunden, was bei der Arbeit mit sich schnell ändernden oder sich weiterentwickelnden Datensätzen hervorragend ist.

Hier sind einige wichtige Vorteile:

- Skalierbarkeit: Data Lakes basieren auf Cloud-nativem Speicher, der sich mühelos skalieren lässt, egal ob du Gigabytes oder Petabytes speicherst.

- Unterstützung für alle Datentypen: Strukturierte (SQL-Tabellen), halb-strukturierte (JSON, XML) und unstrukturierte (Text, Bilder, Video) Daten können auf derselben Plattform gespeichert werden.

- Kosteneffizienz: Der Cloud-Objektspeicher (z. B. Amazon S3) ist deutlich günstiger als der Speicher herkömmlicher Datenbanken oder Lagerhäuser.

- Entkoppelte Architektur: Compute und Storage sind getrennt, um Analyse-Workloads unabhängig vom Datenspeicher zu skalieren.

- Erweiterte Analytik: Data Lakes speichern rohe, unverarbeitete Daten und ermöglichen eine umfassendere und flexiblere Datenanalyse, einschließlich maschinellem Lernen und prädiktiven Analysen.

- Verbesserte Entscheidungsfindung: Data Lakes können eine tiefgreifendere und umfassendere Datenanalyse ermöglichen, die zu besser informierten Entscheidungen im gesamten Unternehmen führt.

- Beseitigung von Datensilos: Data Lakes helfen dabei, Datensilos aufzubrechen, indem sie Daten aus verschiedenen Quellen in einem einzigen, zentralisierten Speicher zusammenführen.

In Projekten, an denen ich gearbeitet habe, hat diese Zentralisierung Datensilos reduziert und die teamübergreifende Zusammenarbeit deutlich verbessert.

Zentrale Herausforderungen

Data Lakes sind leistungsfähig, aber es gibt einige wichtige Herausforderungen, die es zu bewältigen gilt. Wenn sie nicht verwaltet werden, können sie schnell unübersichtlich und unbrauchbar werden - ein Zustand, der oft als Datensumpf bezeichnet wird.

Zu den häufigsten Herausforderungen gehören:

- Fehlende Struktur: Ohne vordefinierte Schemata kann es schwierig sein, Daten abzufragen, zu dokumentieren oder zu verwalten.

- Probleme mit der Datenqualität: Da die Daten in Rohform eingelesen werden, können minderwertige oder unvollständige Daten bis zur Weiterverarbeitung unentdeckt bleiben.

- Lücken bei Metadaten und Auffindbarkeit: Ohne ein solides Katalogisierungssystem wissen die Nutzer/innen möglicherweise nicht, welche Daten vorhanden sind und wie sie sie nutzen können.

- Komplexe Steuerung: In einer flexiblen Umgebung ist es schwieriger, Zugangskontrolle, Überprüfbarkeit und Compliance zu gewährleisten.

Diese Probleme können das Vertrauen in den Data Lake mindern und die Akzeptanz im Unternehmen verringern.

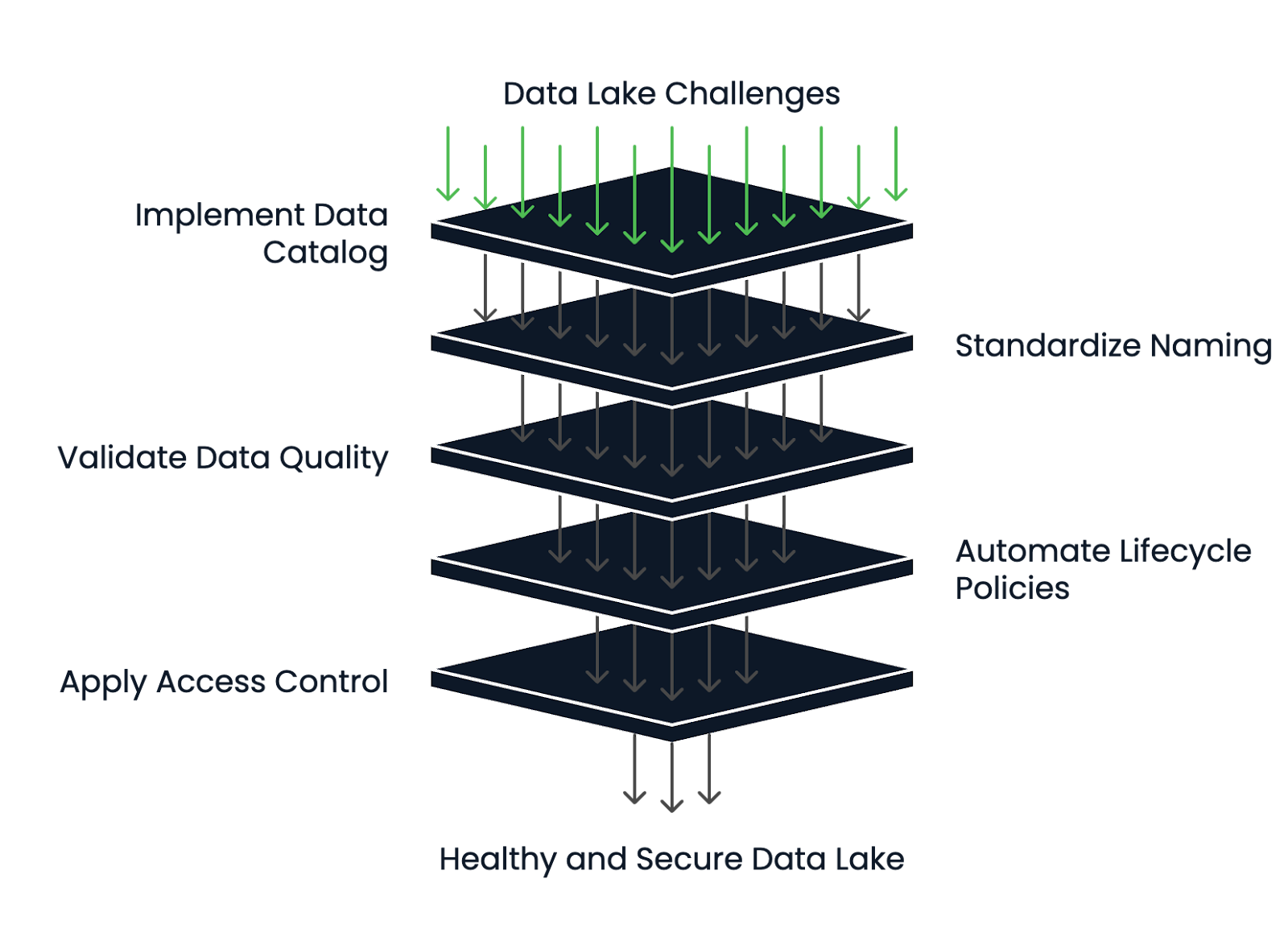

Wie man die Herausforderungen entschärft

Die erfolgreichsten Data Lakes verfügen über ein solides Metadaten- und Lebenszyklusmanagement.

Hier erfährst du, wie du das Risiko reduzierst und deinen Data Lake gesund hältst:

- Implementiere einen Datenkatalog: Tools wie AWS Glue oder DataHub helfen dabei, die Auffindbarkeit, die Schemadefinitionen und die Nachverfolgung der Herkunft zu gewährleisten.

- Verwende standardisierte Benennungen und Ordnerstrukturen: Das schafft Konsistenz und verringert die Verwirrung im Team.

- Datenvalidierung und Profiling-Tools anpassen: Stelle die Qualität bei der Erfassung sicher und überprüfe die Daten regelmäßig.

- Automatisiere Lebenszyklusrichtlinien: Verschiebe veraltete Daten automatisch in den Cold Storage oder lösche sie nach einer bestimmten Aufbewahrungsfrist.

- Wende eine robuste Zugangskontrolle und Verschlüsselung an: Um sensible Daten zu schützen, verwende IAM-Richtlinien, rollenbasierten Zugriff und Verschlüsselung im Ruhezustand und bei der Übertragung.

Ein Data Lake kann ein Aktivposten und keine Belastung sein, wenn von Anfang an eine saubere Architektur entworfen undsolide Governance-Struktureneingerichtet werden.

Data Lake Health Management Framework. Bild vom Autor.

Beliebte Data Lake Technologien

Mit der wachsenden Bedeutung von Data Lakes in der modernen Datenarchitektur ist eine breite Palette von Technologien entstanden, die sie unterstützen. Diese Tools umfassen Cloud-native Plattformen, Open-Source-Ökosysteme und Integrationen mit Analyselösungen. In diesem Abschnitt stelle ich dir die beliebtesten Tools vor.

Cloud-native Lösungen

Cloud-Anbieter bieten vollständig verwaltete Dienste für den Aufbau und die Pflege von Data Lakes an. Diese Plattformen sind oft der Ausgangspunkt für Teams, die nach Skalierbarkeit, Langlebigkeit und enger Integration mit anderen Cloud-Diensten suchen.

Zu den beliebten Cloud-nativen Lösungen gehören:

- Amazon S3 + AWS Lake Formation: S3 stellt den Objektspeicher zur Verfügung, während Lake Formation sich um Berechtigungen, Katalogisierung und Governance kümmert.

- Azure Data Lake Storage: Kombiniert Blob-Speicher mit HDFS-ähnlichen Funktionen.

- Google Cloud Storage (GCS): GCS ist sehr langlebig und lässt sich gut mit BigQuery und Vertex AI für Analysen und ML-Workloads integrieren.

Diese Dienste sind für Elastizität, Kosteneffizienz und Sicherheit optimiert und damit ideal für Data Lakes im Unternehmensmaßstab.

Open-Source-Tools

Open-Source-Technologien sorgen für mehr Flexibilität und Erweiterbarkeit, vor allem für Teams, die eine Herstellerbindung vermeiden oder in hybriden bzw. Multi-Cloud-Umgebungen arbeiten wollen.

Beliebte Lösungen sind:

- Apache Hadoop: Eines der ursprünglichen Data-Lake-Frameworks. Auch wenn dies heute bei neuen Projekten weniger üblich ist, wurde damit der Grundstein für die verteilte Datenspeicherung und -verarbeitung gelegt.

- Delta Lake: Delta Lake wurde von Databricks entwickelt und erweitert den Cloud-Objektspeicher um ACID-Transaktionen, Versionierung und Schemadurchsetzung.

- Apache Iceberg: Iceberg bietet atomare Operationen, versteckte Partitionierung und Zeitreisen für die Abfrage von historischen Daten.

- Presto: Eine verteilte SQL-Abfrage-Engine, mit der du schnelle, interaktive Abfragen auf Daten ausführen kannst, die in S3, HDFS oder anderen Quellen gespeichert sind, ohne die Daten zu verschieben.

Diese Tools lassen sich oft in breitere Datenplattformen integrieren und werden von Entwicklungsteams bevorzugt, die maßgeschneiderte oder modulare Lösungen entwickeln.

Wenn du die Unterschiede zwischen Apache Iceberg und Delta Lake genauer kennenlernen möchtest, empfehle ich dir, Apache Iceberg vs. Delta Lakezu lesen. Delta Lake: Merkmale, Unterschiede und Anwendungsfälle.

Integration mit Analyseplattformen

Ein Data Lake wird wertvoll, wenn er mit Analyse- und Visualisierungstools integriert wird, die helfen, Erkenntnisse zu gewinnen und Geschäftsentscheidungen zu treffen. Deshalb sollte man vor der Auswahl der endgültigen Lösung immer im Voraus prüfen, mit welchen Analyseplattformen die Data-Lake-Lösung integriert werden soll.

Beliebte Analyseplattformen sind u. a:

- Databricks: Kombiniert Data Lake Storage mit einem kollaborativen Arbeitsbereich für Data Engineering, maschinelles Lernen und Analytik. Es unterstützt Delta Lake sofort.

- Snowflake: Snowflake ist zwar traditionell ein Data Warehouse, kann aber auch externe Daten in der Cloud abfragen (über Snowpipe oder externe Tabellen), was es zu einer hybriden Lakehouse-Lösung macht.

- Power BI, Tableau: Diese BI-Tools können entweder direkt oder über Abfrage-Engines wie Athena oder BigQuery mit Data Lakes verbunden werden und ermöglichen Dashboarding und Reporting auf Basis von rohen oder halbstrukturierten Daten.

Wenn du mehr über Databricks erfahren möchtest, empfehle ich dirden Kurs Einführung in Databricks.

Bei der Auswahl von Technologien ist es wichtig, dass du sie mit dem Fachwissen deines Teams, deiner Datenstrategie und dem Grad an Flexibilität oder Abstraktion, den du brauchst, in Einklang bringst.

Fazit

Data Lakes ermöglichen es Unternehmen, robuste Machine-Learning-Anwendungen und Echtzeit-Dashboards zu entwickeln, indem sie eine flexible, skalierbare, rohe und halbstrukturierte Datengrundlage bieten.

In diesem Artikel haben wir uns angesehen, was ein Data Lake ist, welche Komponenten er hat und wann man ihn einsetzen sollte. Wir erörterten die Vorteile wie Flexibilität und Skalierbarkeit, Herausforderungen wie Data Governance und das Risiko eines "Datensumpfes" und wie man sie vermeiden kann. Schließlich haben wir beliebte Technologien für den Aufbau von Data Lakes behandelt, darunter Cloud-Plattformen und Open-Source-Tools.

Durch meine Erfahrung in den Bereichen MLOps, KI-Infrastruktur und Cloud-native Datensysteme habe ich gesehen, wie ein gut strukturierter Data Lake die Zusammenarbeit und Innovation von Teams verändern kann. Aber ich habe auch gesehen, wie schnell ein schlecht verwalteter Datensee zu einer Belastung werden kann und wie schwierig es sein kann, sich darin zurechtzufinden.

Wenn dein Unternehmen komplexe, vielfältige oder umfangreiche Daten verarbeitet undschnellere Experimente, umfassendere Analysen oder KI-Entwicklung ermöglichen möchte, könnte ein Data Lake genau das Richtige für dich sein.

Der Kurs Understanding Modern Data Architecture ist eine gute erste Anlaufstelle, wenn du mehr erfahren möchtest.

Werde Dateningenieur

FAQs

Welche Arten von Organisationen profitieren am meisten vom Einsatz eines Data Lake?

Organisationen, die mit großen, vielfältigen oder sich schnell entwickelnden Datensätzen arbeiten, wie z. B. Technologieunternehmen, Finanzinstitute und Gesundheitsdienstleister, profitieren am meisten von Data Lakes.

Wie unterstützt ein Data Lake Echtzeit-Analysen?

Ein Data Lake kann Streaming-Daten von IoT-Geräten oder -Anwendungen in Echtzeit aufnehmen und mit Tools wie Apache Kafka und Amazon Kinesis sofortige Analysen und schnellere Entscheidungen ermöglichen.

Können Data Lakes vor Ort eingesetzt werden, oder sind sie nur in der Cloud verfügbar?

Obwohl Cloud-basierte Data Lakes weit verbreitet sind, ist es auch möglich, Data Lakes vor Ort mit Lösungen wie Hadoop Distributed File System (HDFS) oder MinIO für S3-kompatible Objektspeicher einzurichten.

Was ist ein Datensumpf und wie kann er vermieden werden?

Ein Datensumpf entsteht, wenn ein Data Lake aufgrund von schlechtem Metadatenmanagement und schlechter Governance unübersichtlich und unbrauchbar wird. Eine strenge Katalogisierungs-, Dokumentations- und Verwaltungspolitik hilft, dies zu verhindern.

Wie ermöglichen Data Lakes die Entwicklung von maschinellem Lernen?

Durch die Speicherung von Rohdaten und verschiedenen Datentypen ermöglichen Data Lakes Datenwissenschaftlern, freier zu experimentieren, umfangreichere Trainingsdatensätze zu erstellen und Modelle für maschinelles Lernen schneller zu iterieren.

Gibt es bei Data Lakes besondere Probleme mit der Einhaltung von Vorschriften?

Ja, die Speicherung unstrukturierter und sensibler Daten in Rohformaten erfordert eine strenge Verschlüsselung, Zugriffskontrolle, Prüfung und Einhaltung von Vorschriften, um Bestimmungen wie GDPR und HIPAA zu erfüllen.

Wie wirkt sich das Schema-on-read auf die Datenanalyse in einem Data Lake aus?

Schema-on-Read ermöglicht es den Nutzern, verschiedene Schemata zur Abfragezeit anzuwenden. Das bietet Flexibilität, erfordert aber auch eine sorgfältige Datenerfassung und -interpretation für eine genaue Analyse.

Was ist der Unterschied zwischen einem Data Lake und einem Data Lakehouse?

Ein Data Lakehouse kombiniert die Flexibilität eines Data Lakes mit den Verwaltungs- und Transaktionsfunktionen eines Data Warehouses und bietet das Beste aus beiden Welten für Analysen und KI.

Wie hoch sind die Kosten für die Wartung eines Cloud-basierten Data Lake?

Die Kosten variieren je nach Speichervolumen, Datentransfer und Zugriffshäufigkeit, aber Cloud-Objektspeicherdienste (wie Amazon S3) sind in der Regel pro GB günstiger als herkömmliche Datenbanken.

Welche Fähigkeiten sind erforderlich, um einen Data Lake erfolgreich aufzubauen und zu verwalten?

Zu den Schlüsselqualifikationen gehören das Management der Cloud-Infrastruktur, Daten-Engineering, Sicherheits- und Compliance-Kenntnisse, Metadatenmanagement und Erfahrung mit Big-Data-Tools wie Spark oder Presto.

Ich bin ein Cloud-Ingenieur mit fundierten Kenntnissen in den Bereichen Elektrotechnik, maschinelles Lernen und Programmierung. Meine Karriere begann im Bereich Computer Vision mit dem Schwerpunkt Bildklassifizierung, bevor ich zu MLOps und DataOps wechselte. Ich bin spezialisiert auf den Aufbau von MLOps-Plattformen, die Unterstützung von Data Scientists und die Bereitstellung von Kubernetes-basierten Lösungen zur Optimierung von Machine Learning-Workflows.