Cours

En tant que personne ayant soutenu des équipes de données avec desplateformes MLOpset aidé à concevoir des infrastructures évolutives, j'ai vu de mes propres yeux à quel point les lacs de données sont cruciaux dans la pile de données d'aujourd'hui.

Contrairement aux entrepôts de données traditionnels, qui exigent que les données soient propres et structurées avant d'être stockées, les lacs de données vous permettent de tout stocker dans des formats bruts, désordonnés et non structurés. Cette flexibilité ouvre un monde de possibilités pour les applications et les cas d'utilisation axés sur les données. Un lac de données vous permet de rassembler et de stocker des données provenant de diverses sources en un seul endroit, où elles peuvent être analysées et utilisées pour l'IA.

Dans cet article, je vais vous expliquer ce qu'est un lac de données, comment il fonctionne, quand l'utiliser et comment il se compare aux solutions plus traditionnelles.

Comprendre le concept de lac de données

Avant d'aborder l'architecture technique ou les cas d'utilisation, il est essentiel de comprendre ce qu'est un lac de données et ce qui le distingue des systèmes de stockage plus traditionnels.

Cette section définit le concept, décompose ses principales caractéristiques et le compare au monde plus structuré des entrepôts de données.

Je vous recommande le cours sur la stratégie des données si vous souhaitez en savoir plus sur la manière dont une stratégie des données bien conçue peut aider les entreprises.

Définition d'un lac de données

Un lac de données est un référentiel centralisé qui stocke toutes vos données structurées, semi-structurées et non structurées à n'importe quelle échelle.

Vous pouvez ingérer des données brutes provenant de diverses sources et les conserver dans leur format d'origine jusqu'à ce que vous ayez besoin de les traiter ou de les analyser.

Contrairement aux bases de données ou aux entrepôts de données, qui nécessitent généralement un schéma prédéfini (schéma à l'écriture), les lacs de données utilisent une approche de schéma à la lecture. Cela signifie que la structuren'est appliquée que lorsque l'on accède aux données pour les analyser, ce qui donne aux équipes une certaine souplesse pour interpréter et transformer les données par la suite.

Caractéristiques principales

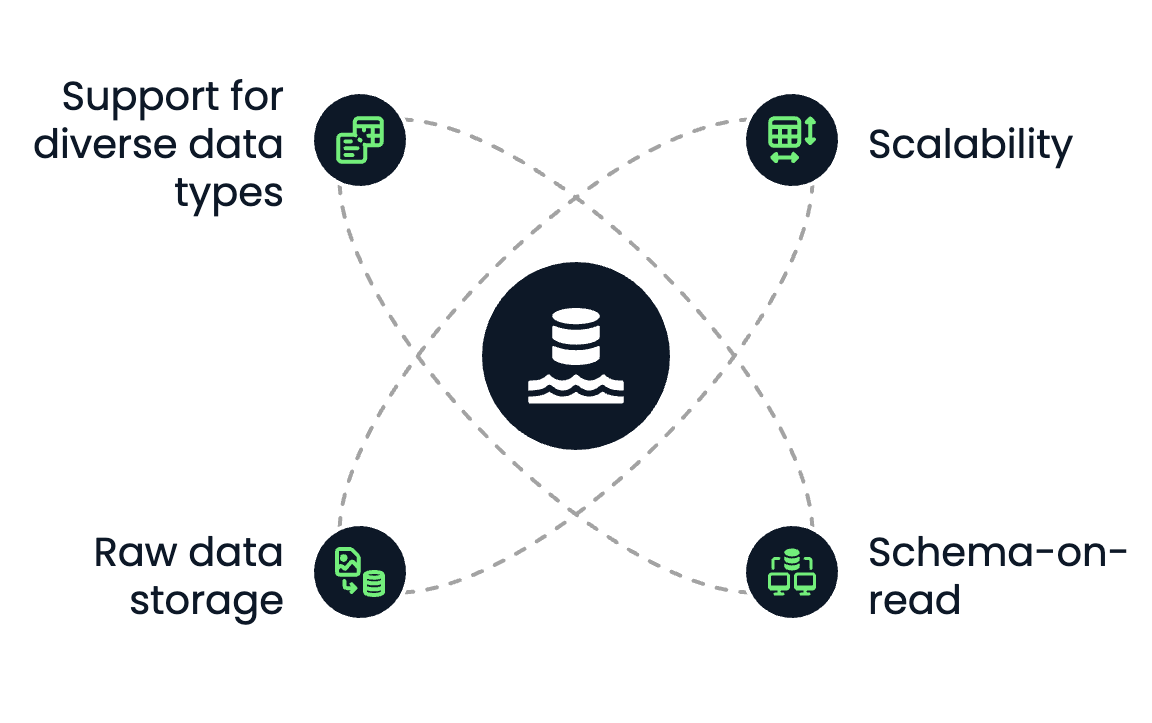

Un lac de données présente les caractéristiques essentielles suivantes :

- Évolutivité : Les lacs de données sont conçus pour évoluer horizontalement. Que vous stockiez des téraoctets ou des pétaoctets de données, les solutions de stockage d'objets dans le cloud, comme Amazon S3 ou Azure Data Lake Storage, facilitent la croissance sans se soucier de la capacité.

- Schema-on-read : Il n'est pas nécessaire de définir le schéma lors du stockage des données. Au lieu de cela, les data scientists, les analystes ou les ingénieurs peuvent appliquer différents schémas en fonction du cas d'utilisation lors de l'extraction ou de la transformation.

- Stockage de données brutes : Les lacs de données conservent tous les types de données dans leur format d'origine, qu'il s'agisse de fichiers CSV, de journaux JSON, de fichiers audio, de vidéos ou de données de capteurs.

- Prise en charge de divers types de données : Vous pouvez stocker des données structurées (par exemple, des tableaux SQL), semi-structurées (par exemple, XML, JSON) et non structurées (par exemple, des images, des PDF, du texte) en un seul endroit.

Caractéristiques principales des lacs de données. Image par l'auteur.

Comparaison avec les entrepôts de données

Les lacs de données et les entrepôts de données sont utilisés pour stocker et analyser les données. Cependant, ils diffèrent considérablement en termes de structure, de performances et de cas d'utilisation.

Si vous êtes novice en matière d'entrepôts de données et que vous souhaitez en savoir plus, je vous recommande le cours Concepts d'entreposage de données et les articles Qu'est-ce qu'un entrepôt de données et Architecture d'entrepôt de données : Tendances, outils et techniques.

Voyons ce quiles différencie :

|

Fonctionnalité |

Lac de données |

Entrepôt de données |

|

Type de données |

Structuré, semi-structuré, non structuré |

Structuré uniquement |

|

Format de stockage |

Brut (objets de fichiers) |

Traitée (tableaux, lignes, colonnes) |

|

Schéma |

Schéma en lecture |

Schéma en écriture |

|

Coût |

Stockage à faible coût |

Plus cher par Go |

|

Cas d'utilisation |

Apprentissage automatique, big data et stockage de données brutes |

Intelligence économique, analyse structurée |

|

Performance |

Flexible, dépend du moteur de calcul |

Optimisé pour des requêtes SQL rapides |

Dans la pratique, de nombreuses stratégies de données modernes combinent les deux : les lacs de données servent de base au stockage des données brutes et les entrepôts de données au reporting structuré et à la veille stratégique.

Il existe également une solution hybride appelée "data lakehouse". L'article Qu'est-ce qu'un Data Lakehouse ? Architecture, technologie et cas d'utilisation l'explique plus en détail.

Composants d'une architecture de lac de données

Une architecture de lac de données bien conçue est essentielle pour rendre les données brutes utilisables et accessibles à l'analyse en aval, à l'apprentissage automatique et au reporting.

Cette section présente les cinq couches clés d'un lac de données moderne, de l'ingestion à la gouvernance.

Couche d'ingestion des données

La couche d'ingestion permet d'introduire dans le lac de données des données provenant de diverses sources. Ces sources comprennent les systèmes internes (comme les bases de données ou les CRM), les API externes, ou les appareils IoT et les journaux.

Il existe trois modes d'ingestion principaux :

- L'ingestion par lots : Chargement des données périodiquement (par exemple chaque nuit) par lots.

- Ingestion de cours d'eau : Flux de données en temps réel, tels que les flux de clics ou les données de capteurs.

- L'ingestion hybride : Une combinaison de batch et de stream, ce qui est courant dans les environnements d'entreprise.

Les outils d'ingestion standard sont les suivants

- Apache Kafka et AWS Kinesis pour le streaming

- Apache NiFi, Flume et AWS Glue pour l'ETL par lots

Une couche d'ingestion flexible garantit que les données arrivent rapidement et peut gérer une variété de formats et de vitesses.

Couche de stockage

Lorsque les données sont ingérées, elles sont stockées dans la zone brute du lac de données. La couche de stockage est généralement construite sur le stockage d'objets dans le cloud, qui offre une mise à l'échelle élastique, une redondance et un bon rapport coût-efficacité.

Les options les plus courantes sont les suivantes :

- Amazon S3

- Stockage de lac de données Azure

- Stockage dans le nuage de Google

Toutefois, il existe également des options pour les entreprises qui souhaitent stocker leurs données dans leurs clouds sur site hébergés dans leurs centres de données.

On peut, par exemple, installer MinIO dans son infrastructure. MinIO est un logiciel libre qui propose une API compatible avec Amazon S3.

Les principales caractéristiques d'une couche de stockage sont les suivantes

- Durabilité et disponibilité: Les données sont automatiquement répliquées entre les régions.

- Séparation du stockage et du calcul: Vous pouvez faire évoluer le calcul de manière indépendante en fonction de la demande.

- Étagement des données: Permet le stockage à froid pour l'archivage et le stockage à chaud pour les données fréquemment consultées.

Le stockage des données dans leur format d'origine vous permet de conserver tout leur potentiel en vue d'un traitement et d'une analyse ultérieurs.

Catalogue et gestion des métadonnées

Sans métadonnées, un lac de données devient un marécage de données, car il est impossible de retrouver vos données et de les utiliser efficacement.

Le catalogue et la couche demétadonnées apportent une structure au chaos en gardant une trace :

- Schéma de données

- Localisation et partitionnement des données

- Lignage et versionnement

Cette couche garantit la facilité de découverte et d'utilisation en indexant tous les ensembles de données disponibles et en permettant la recherche et le contrôle d'accès. Les outils standard pour cette couche sont les suivants :

- Catalogue de données AWS Glue

- Métastore Apache Hive

- Atlas Apache

- DataHub

Un système de métadonnées solide est essentiel pour la collaboration, la gouvernance et l'efficacité opérationnelle.

Couche de traitement et d'analyse

C'est à ce niveau que les données brutes sont traitées et transformées en informations. La couche de traitement prend en charge diverses opérations, des transformations fondamentales aux analyses avancées et à l'apprentissage automatique.

Les flux de travail typiquessont les suivants :

- Pipelines ETL/ELT pour le nettoyage et la normalisation des données

- Requête SQL

- Pipelines d'apprentissage automatique

Cette couche comprend souvent des calculs en lots et en temps réel, permettant l'analyse exploratoire des données et les charges de travail de production.

Sécurité et gouvernance

Une architecture robuste de lac de données doit comporter des mécanismes intégrés pour protéger les données sensibles et garantir la conformité. Cette partie est cruciale, car les lacs de données contiennent généralement de nombreuses données sensibles qui, si elles sont compromises, peuvent nuire à l'entreprise à laquelle elles appartiennent.

Les caractéristiques essentielles de cette couche sont les suivantes

- Gestion des identités et des accès (IAM): Limitez les personnes qui peuvent voir ou modifier les données.

- Chiffrement: Cryptage en transit (TLS) et au repos.

- Masquage et anonymisation des données: Pour le traitement d'informations personnellement identifiables.

- Audit et suivi: Pour la traçabilité et la conformité.

Outils et services populaires :

- Formation d'AWS Lake

- Ranger Apache

- Vue d'azur

La sécurité détermine souvent si un lac de données peut être utilisé dans des secteurs réglementés comme la finance, les soins de santé ou l'armée.

Cas d'utilisation courants pour les lacs de données

Les lacs de données sont bien adaptés aux cas d'utilisation où l'échelle, la flexibilité et la diversité des types de données sont essentielles. Ils servent de base aux opérations et applications modernes basées sur les données dans tous les secteurs d'activité.

Dans cette section, nous allons explorer quelques-uns des cas d'utilisation les plus courants et les plus importants dans lesquels les lacs de données jouent un rôle central.

Analyse des données (big data)

L'une des utilisations les plus connues des lacs de données est l'analyse de données à grande échelle.

Les lacs de données pouvant stocker des données brutes, les entreprises n'ont plus à se préoccuper du nettoyage ou de la structuration de chaque ensemble de données avant de les analyser. Cette solution est idéale pour la collecte de journaux, de données de capteurs ou de flux de clics, qui sont trop volumineux ou évoluent trop rapidement pour les systèmes traditionnels.

Les lacs de données permettent de :

- Analyser les données historiques en même temps que les données en temps réel

- Exécutez des requêtes personnalisées sur des ensembles de données à l'échelle du pétaoctet.

- Permettre des analyses interdépartementales à partir d'une source unique de vérité

Des outilscomme Amazon Athena ou Google BigQuery permettent d'interroger les données directement dans le lac, sans nécessiter de transformations complexes ou de déplacement des données.

Apprentissage automatique et IA

Les lacs de données sont parfaitement adaptés à l'apprentissage automatique et aux flux de travail de l'IA.

Ils constituent l'environnement idéal pour :

- Stockage des ensembles de données d'entraînement dans plusieurs formats (par exemple, CSV, Parquet, images, etc.)

- Conserver des données brutes et donc plus complètes, ce qui permet une plus grande flexibilité dans l'exploration, l'expérimentation et l'itération des modèles ML.

- Alimenter des pipelines ML automatisés qui itèrent sur des volumes massifs de données.

Au lieu de limiter les modèles à des données pré-nettoyées provenant d'un entrepôt, les scientifiques des données peuvent accéder à des données riches et brutes afin d'expérimenter plus librement et de procéder à des itérations plus rapides. Ceci est particulièrement utile dans des domaines tels que le traitement du langage naturel (NLP), la vision par ordinateur et les prévisions de séries temporelles.

Si vous voulez un exemple de la façon dont la solution Databricks Lakehouse peut être utilisée pour l'IA, je vous recommande delire A Comprehensive Guide to Databricks Lakehouse AI For Data Scientists (Guide complet de l'IA Databricks Lakehouse pour les scientifiques des données).

Archivage centralisé des données

De nombreuses organisations utilisent des lacs de données pour le stockage et l'archivage à long terme.

Grâce au faible coût du stockage d'objets dans le cloud, il est économiquement possible de stocker des années de données opérationnelles qui ne sont peut-être pas utilisées quotidiennement, mais qui doivent tout de même être accessibles à des fins de conformité et d'audit, d'analyse des tendances, de prévision ou d'entraînement de futurs modèles ML.

La plupart des solutions de stockage objet dans le cloud vous permettent de hiérarchiser votre stockage afin d'archiver les données rarement consultées tout en conservant un lac léger et efficace.

Expérimentation en science des données

Les lacs de données permettent aux data scientists d'explorer les données brutes sans contraintes.

Que vous construisiez un prototype rapide, que vous testiez une nouvelle hypothèse ou que vous réalisiez une analyse exploratoire des données (EDA), le lac vous offre un accès flexible :

- Données brutes non structurées (comme les PDF, les courriels, les fichiers texte)

- Formats semi-structurés (tels que JSON, XML ou logs)

- Ensembles massifs de données qui n'auraient pas leur place dans une base de données traditionnelle

Cette couche d'expérimentation est essentielle pour l'innovation. Les lacs de données vous permettent d'explorer des ensembles de données d'une nouvelle manière sans avoir à soumettre des tickets à l'équipe d'ingénierie des données ou à attendre une version nettoyée dans l'entrepôt.

Avantages et défis des lacs de données

Si les lacs de données offrent de puissantes capacités pour les flux de données modernes, ils présentent également des défis uniques. Il est essentiel de comprendre les deux aspects avant d'adopter une architecture de lac de données. Dans cette section, je discuterai des principaux avantages, des pièges les plus courants et de la manière de les surmonter.

Avantages des lacs de données

L'avantage le plus important d'un lac de données est sa flexibilité. Vous n'êtes pas lié à un schéma ou à un modèle de données spécifique dès le départ, ce qui est excellent lorsque vous travaillez avec des ensembles de données qui changent ou évoluent rapidement.

En voici les principaux avantages :

- Évolutivité: Les lacs de données reposent sur un stockage cloud-natif qui évolue sans effort, que vous stockiez des gigaoctets ou des pétaoctets.

- Prise en charge de tous les types de données: Les données structurées (tableaux SQL), semi-structurées (JSON, XML) et non structurées (texte, images, vidéo) peuvent être stockées dans la même plateforme.

- Rapport coût-efficacité: Le stockage d'objets dans le cloud (par exemple, Amazon S3) est nettement moins cher que le stockage utilisé par les bases de données ou les entrepôts traditionnels.

- Architecture découplée: Le calcul et le stockage sont séparés pour faire évoluer les charges de travail analytiques indépendamment du stockage des données.

- Analyse améliorée: Les lacs de données stockent des données brutes, non traitées, et permettent une analyse plus complète et plus souple des données, y compris l'apprentissage automatique et l'analyse prédictive.

- Amélioration de la prise de décision: Les lacs de données peuvent permettre une analyse plus approfondie et plus complète des données, conduisant à des décisions mieux informées dans l'ensemble de l'organisation.

- Élimination des silos de données: Les lacs de données permettent d'éliminer les silos de données en consolidant les données provenant de diverses sources dans un référentiel unique et centralisé.

Dans les projets sur lesquels j'ai travaillé, cette centralisation a permis de réduire les silos de données et d'améliorer considérablement la collaboration entre les équipes.

Principaux défis

Les lacs de données sont puissants, mais certains défis majeurs doivent être relevés. Si elles ne sont pas gérées, elles peuvent rapidement devenir désorganisées et inutilisables, un état souvent appelé "marécage de données".

Les défis les plus courants sont les suivants :

- Manque de structure: Sans schémas prédéfinis, les données peuvent être difficiles à interroger, à documenter ou à gérer.

- Questions relatives à la qualité des données: Étant donné que les données sont ingérées sous forme brute, des données de mauvaise qualité ou incomplètes peuvent passer inaperçues jusqu'à ce qu'elles arrivent en aval.

- Lacunes en matière de métadonnées et d'accessibilité: Sans un système de catalogage solide, les utilisateurs risquent de ne pas savoir quelles données existent ni comment les utiliser.

- Gouvernance complexe: Dans un environnement flexible, il est plus difficile de garantir le contrôle d'accès, l'auditabilité et la conformité.

Ces problèmes peuvent réduire la confiance dans le lac de données et son adoption par l'ensemble de l'entreprise.

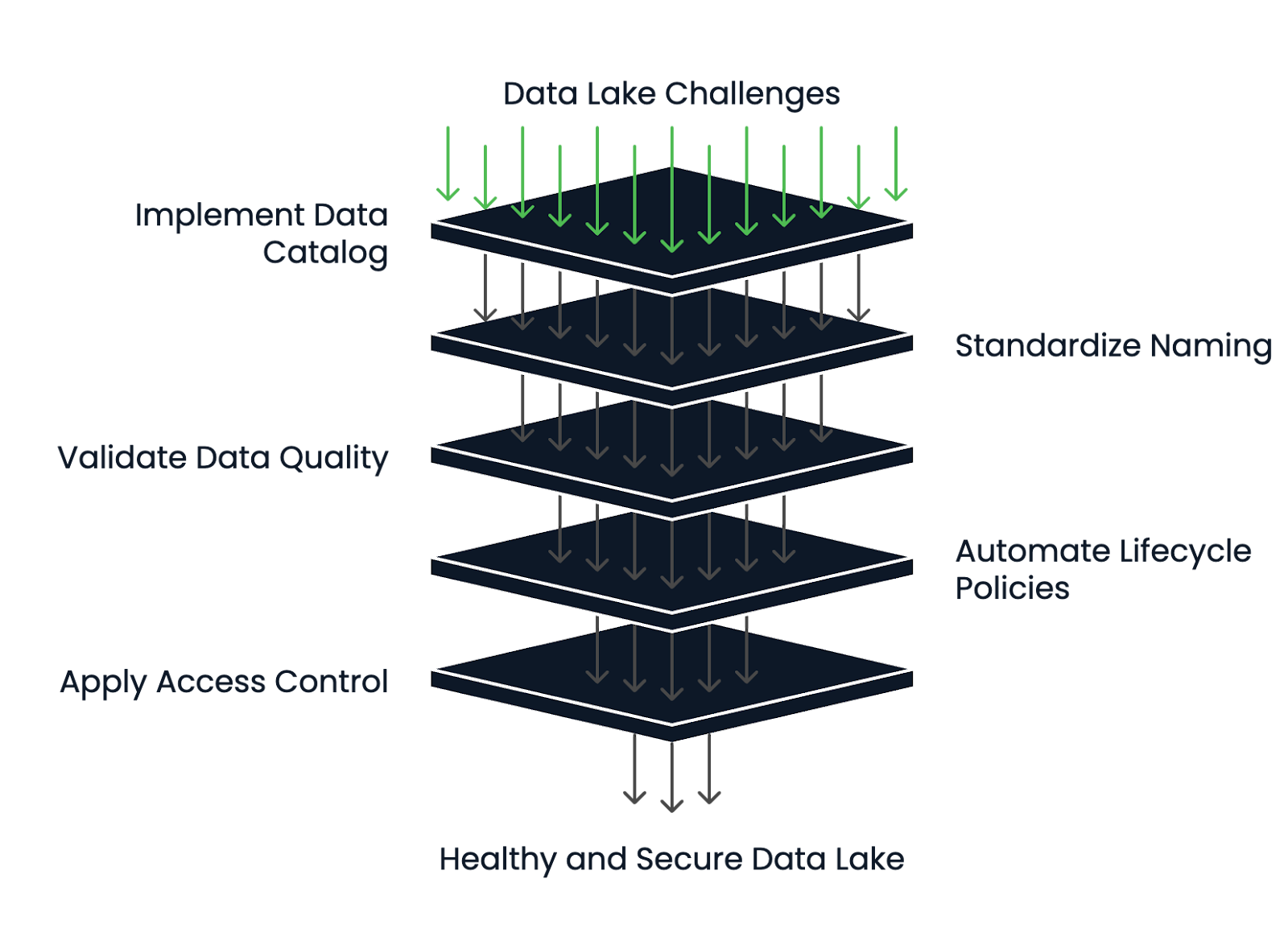

Comment atténuer les difficultés

Les lacs de données les plus performants ont de solides pratiques de gestion des métadonnées et du cycle de vie.

Voici comment réduire les risques et maintenir votre lac de données en bonne santé :

- Mettre en œuvre un catalogue de données: Des cursus comme AWS Glue ou DataHub aident à maintenir la découvrabilité, les définitions de schémas et le suivi du lignage.

- Utilisez des structures de noms et de dossiers normalisées: Cela crée de la cohérence et réduit la confusion au sein de l'équipe.

- Adapter les outils de validation et de profilage des données: Assurez la qualité lors de l'ingestion et revalidez périodiquement les données.

- Automatiser les politiques de cycle de vie: Déplacez automatiquement les données périmées vers le stockage à froid ou supprimez-les après une période de conservation définie.

- Appliquer un contrôle d'accès et un cryptage robustes: Pour protéger les données sensibles, utilisez des politiques IAM, un accès basé sur les rôles et le cryptage au repos et en transit.

Un lac de données peut rester un actif et non un passif en concevant une architecture propre dès le départ et en établissant des structures de gouvernance solides.

Cadre de gestion de la santé du lac de données. Image par l'auteur.

Technologies de lac de données populaires

L'importance croissante des lacs de données dans l'architecture moderne des données a donné lieu à l'émergence d'un large éventail de technologies pour les prendre en charge. Ces outils couvrent les plateformes cloud-natives, les écosystèmes open-source et les intégrations avec des solutions d'analyse. Dans cette section, je vous présenterai les outils les plus populaires.

Solutions basées sur le cloud

Les fournisseurs de cloud proposent des services entièrement gérés pour la construction et la maintenance des lacs de données. Ces plateformes sont souvent le point de départ pour les équipes qui recherchent l'évolutivité, la durabilité et une intégration étroite avec d'autres services cloud.

Parmi les solutions cloud-natives les plus populaires, citons :

- Amazon S3 + AWS Lake Formation: S3 assure le stockage des objets, tandis que Lake Formation gère les autorisations, le catalogage et la gouvernance.

- Azure Data Lake Storage: Combine le stockage en mode blob avec des capacités similaires à celles de HDFS.

- Google Cloud Storage (GCS): GCS est très durable et s'intègre bien avec BigQuery et Vertex AI pour les charges de travail analytiques et de ML.

Ces services sont optimisés pour l'élasticité, la rentabilité et la sécurité, ce qui les rend idéaux pour les lacs de données à l'échelle de l'entreprise.

Outils libres

Les technologies open-source ajoutent de la flexibilité et de l'extensibilité, en particulier pour les équipes qui veulent éviter le verrouillage des fournisseurs ou fonctionner dans des environnements hybrides/multi-cloud.

Les solutions les plus courantes sont les suivantes :

- Apache Hadoop: L'une des premières structures de lac de données. Bien qu'il soit moins courant aujourd'hui pour les nouveaux projets, il a jeté les bases du stockage et du traitement des données distribuées.

- Lac Delta: Développé par Databricks, Delta Lake ajoute les transactions ACID, le versionnage et l'application des schémas au stockage d'objets dans le cloud.

- Apache Iceberg: Iceberg propose des opérations atomiques, un partitionnement caché et un voyage dans le temps pour l'interrogation de données historiques.

- Presto: Un moteur de requête SQL distribué qui vous permet d'exécuter des requêtes rapides et interactives sur des données stockées dans S3, HDFS ou d'autres sources sans déplacer les données.

Ces outils s'intègrent souvent dans des plateformes de données plus larges et sont privilégiés par les équipes d'ingénieurs qui construisent des solutions personnalisées ou modulaires.

Si vous souhaitez étudier plus en détail les différences entre Apache Iceberg et Delta Lake, je vous recommande delire Apache Iceberg vs. Lac Delta : Caractéristiques, différences et cas d'utilisation.

Intégration avec les plateformes d'analyse

Un lac de données devient précieux lorsqu'il est intégré à des outils d'analyse et de visualisation qui permettent d'extraire des informations et de prendre des décisions commerciales. Par conséquent, avant de choisir la solution finale, il faut toujours vérifier au préalable avec quelles plateformes analytiques la solution de lac de données doit être intégrée.

Les plates-formes d'analyse les plus répandues sont les suivantes :

- Databricks: Combine le stockage du lac de données avec un espace de travail collaboratif pour l'ingénierie des données, l'apprentissage automatique et l'analyse. Le site prend en charge le lac Delta dès sa sortie de l 'emballage.

- Snowflake: Bien qu'il s'agisse traditionnellement d'un entrepôt de données, Snowflake peut interroger des données externes stockées dans le cloud (via Snowpipe ou des tableaux externes), ce qui en fait une solution hybride de type "lakehouse".

- Power BI, Tableau: Ces outils de BI peuvent se connecter aux lacs de données soit directement, soit par l'intermédiaire de moteurs de requête comme Athena ou BigQuery, ce qui permet d'établir des tableaux de bord et des rapports à partir de données brutes ou semi-structurées.

Si vous souhaitez en savoir plus sur Databricks, je vous recommandele cours Introduction à Databricks.

Lors du choix des technologies, il est essentiel de les adapter à l'expertise de votre équipe, à votre stratégie en matière de données et au niveau de flexibilité ou d'abstraction dont vous avez besoin.

Conclusion

Les lacs de données permettent aux organisations de créer des applications d'apprentissage automatique robustes et des tableaux de bord en temps réel en offrant une base de données flexibles, évolutives, brutes et semi-structurées.

Dans cet article, nous avons exploré ce qu'est un lac de données, ses composants clés et quand l'utiliser. Nous avons discuté des avantages tels que la flexibilité et l'évolutivité, des défis tels que la gouvernance des données et le risque d'un "marécage de données", et de la manière de les éviter. Enfin, nous avons abordé les technologies populaires pour la construction de lacs de données, notamment les plateformes cloud et les outils open-source.

De par mon expérience au sein des MLOps, de l'infrastructure d'IA et des systèmes de données cloud-natives, j'ai pu constater qu'un lac de données bien architecturé peut transformer la façon dont les équipes collaborent et innovent. Mais j'ai également constaté qu'un lac de données mal géré peut rapidement devenir un handicap et qu'il peut être difficile de s'y retrouver.

Si votre organisation traite des données complexes, diverses ou à grande échelle et souhaiteaccélérer l'expérimentation, enrichir l'analyse ou développer l'IA, un lac de données pourrait être précisément ce dont vous avez besoin.

Le cours " Comprendre l'architecture moderne des données" est une excellente première étape si vous souhaitez en savoir plus.

Devenez ingénieur en données

FAQ

Quels sont les types d'organisations qui bénéficient le plus de l'utilisation d'un lac de données ?

Les organisations qui traitent des ensembles de données à grande échelle, diversifiés ou en évolution rapide, telles que les entreprises technologiques, les institutions financières et les prestataires de soins de santé, sont celles qui bénéficient le plus des lacs de données.

Comment un lac de données soutient-il l'analyse en temps réel ?

Un lac de données peut ingérer des données en continu provenant d'appareils ou d'applications IoT en temps réel, ce qui permet une analyse immédiate et une prise de décision plus rapide grâce à des outils tels qu'Apache Kafka et Amazon Kinesis.

Les lacs de données peuvent-ils être déployés sur site, ou sont-ils réservés au cloud ?

Si les lacs de données basés sur le cloud sont courants, il est possible de déployer des lacs de données sur site en utilisant des solutions telles que Hadoop Distributed File System (HDFS) ou MinIO pour le stockage d'objets compatibles avec S3.

Qu'est-ce qu'un marécage de données et comment l'éviter ?

Un marécage de données se produit lorsqu'un lac de données devient désorganisé et inutilisable en raison d'une mauvaise gestion des métadonnées et d'une mauvaise gouvernance. De solides politiques de catalogage, de documentation et de gouvernance permettent d'éviter cela.

Comment les lacs de données permettent-ils le développement de l'apprentissage automatique ?

En stockant des types de données brutes et diverses, les lacs de données permettent aux scientifiques d'expérimenter plus librement, de créer des ensembles de données d'entraînement plus riches et d'élaborer plus rapidement des modèles d'apprentissage automatique.

Les lacs de données posent-ils des problèmes de conformité spécifiques ?

Oui, le stockage de données non structurées et sensibles dans des formats bruts nécessite un cryptage strict, un contrôle d'accès, un audit et des cadres de conformité pour répondre à des réglementations telles que le GDPR et l'HIPAA.

Quel est l'impact du schema-on-read sur l'analyse des données dans un lac de données ?

Schema-on-read permet aux utilisateurs d'appliquer différents schémas au moment de l'interrogation, ce qui offre une certaine flexibilité mais nécessite également une découverte et une interprétation minutieuses des données pour une analyse précise.

Quelle est la différence entre un lac de données (data lake) et un centre de données (data lakehouse) ?

Un data lakehouse combine la flexibilité d'un lac de données avec les capacités de gestion et de transaction d'un entrepôt de données, offrant le meilleur des deux mondes pour l'analyse et l'IA.

Combien coûte généralement la maintenance d'un lac de données basé sur le cloud ?

Les coûts varient en fonction du volume de stockage, du transfert de données et de la fréquence d'accès, mais les services de stockage d'objets dans le cloud (comme Amazon S3) sont généralement moins chers par Go que les bases de données traditionnelles.

Quelles sont les compétences nécessaires pour construire et gérer avec succès un lac de données ?

Les compétences clés comprennent la gestion de l'infrastructure cloud, l'ingénierie des données, l'expertise en matière de sécurité et de conformité, la gestion des métadonnées et l'expérience avec des outils big data tels que Spark ou Presto.

Je suis un ingénieur cloud avec de solides bases en génie électrique, en apprentissage automatique et en programmation. J'ai commencé ma carrière dans le domaine de la vision par ordinateur, en me concentrant sur la classification des images, avant de passer aux MLOps et aux DataOps. Je suis spécialisé dans la construction de plateformes MLOps, le soutien aux data scientists et la fourniture de solutions basées sur Kubernetes pour rationaliser les flux de travail d'apprentissage automatique.