Curso

Como alguém que já deu suporte a equipes de dados complataformas MLOpse ajudou a projetar infraestruturas dimensionáveis, vi em primeira mão como os data lakes são cruciais na pilha de dados atual.

Diferentemente dos data warehouses tradicionais, que exigem que os dados sejam limpos e estruturados antes do armazenamento, os data lakes permitem que você armazene tudo em formatos brutos, bagunçados e não estruturados. Essa flexibilidade abre um mundo de possibilidades para aplicativos orientados por dados e casos de uso. Um data lake permite que você reúna e armazene dados de várias fontes em um único local, onde eles podem ser analisados e usados para IA.

Neste artigo, explicarei o que é um data lake, como ele funciona, quando usá-lo e como ele se compara às soluções mais tradicionais.

Entendendo o conceito de um lago de dados

Antes de discutir a arquitetura técnica ou os casos de uso, é essencial que você entenda o que é um data lake e o que o distingue dos sistemas de armazenamento mais tradicionais.

Esta seção define o conceito, detalha suas principais características e o compara com o mundo mais estruturado dos data warehouses.

Recomendo o curso Estratégia de dados se você quiser saber mais sobre como uma estratégia de dados bem elaborada pode ajudar as empresas.

Definição de um lago de dados

Um data lake é um repositório centralizado que armazena todos os seus dados estruturados, semiestruturados e não estruturados em qualquer escala.

Você pode ingerir dados brutos de várias fontes e mantê-los em seu formato original até precisar processá-los ou analisá-los.

Diferentemente dos bancos de dados ou dos data warehouses, que normalmente exigem um esquema predefinido (schema-on-write), os data lakes usam uma abordagem de schema-on-read. Isso significa que a estrutura é aplicada somente quando os dados são acessados para análise, dando às equipes flexibilidade para interpretar e transformar os dados posteriormente.

Características principais

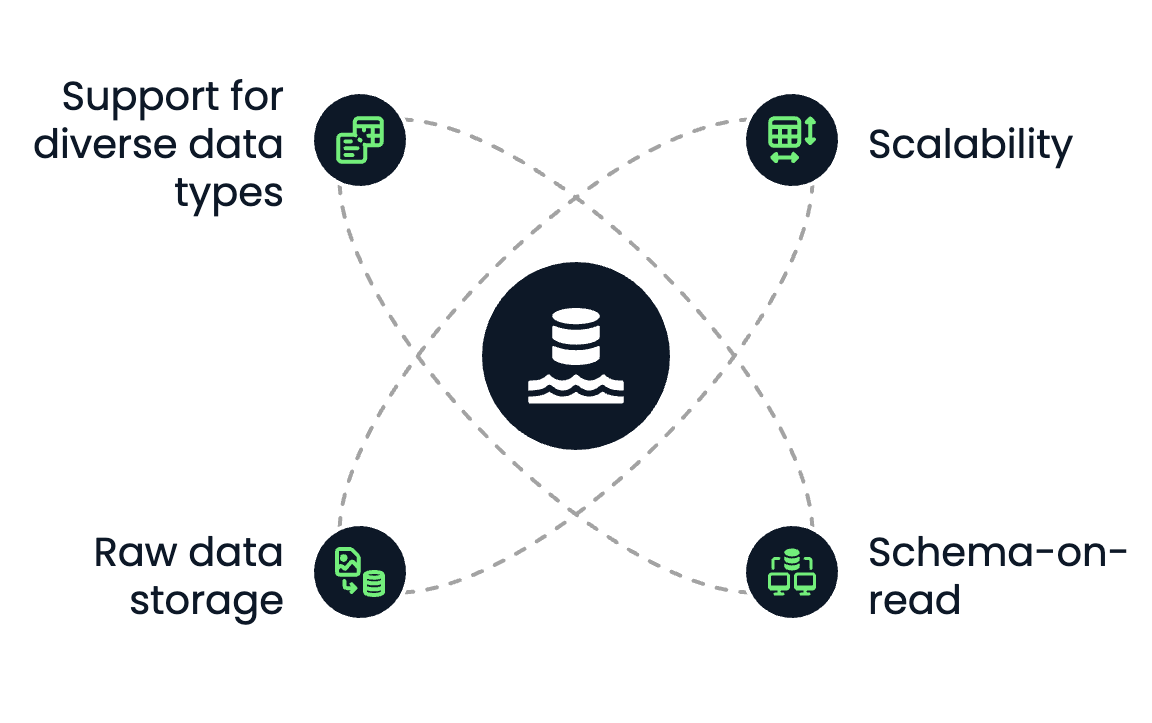

Um data lake tem as seguintes características principais:

- Escalabilidade: Os data lakes são criados para serem dimensionados horizontalmente. Não importa se você está armazenando terabytes ou petabytes de dados, as soluções de armazenamento de objetos em nuvem, como o Amazon S3 ou o Azure Data Lake Storage, facilitam o crescimento sem se preocupar com a capacidade.

- Esquema em leitura: Você não precisa definir o esquema ao armazenar os dados. Em vez disso, cientistas de dados, analistas ou engenheiros podem aplicar esquemas diferentes, dependendo do caso de uso durante a recuperação ou transformação.

- Armazenamento de dados brutos: Os data lakes retêm todos os tipos de dados em seu formato nativo, sejam eles arquivos CSV, logs JSON, arquivos de áudio, vídeos ou dados de sensores.

- Suporte a diversos tipos de dados: Você pode armazenar dados estruturados (por exemplo, tabelas SQL), semiestruturados (por exemplo, XML, JSON) e não estruturados (por exemplo, imagens, PDFs, texto) em um só lugar.

Principais características dos data lakes. Imagem do autor.

Comparação com data warehouses

Os data lakes e data warehouses são usados para armazenar e analisar dados. No entanto, eles diferem significativamente em termos de estrutura, desempenho e casos de uso.

Se você não tem experiência com data warehouses e deseja saber mais, recomendo o curso Conceitos de data warehouse e os artigos O que é um data warehouse e Arquitetura de data warehouse: Tendências, ferramentas e técnicas.

Vamos ver como elesdiferem:

|

Recurso |

Lago de dados |

Data Warehouse |

|

Tipo de dados |

Estruturado, semiestruturado, não estruturado |

Somente estruturado |

|

Formato de armazenamento |

Raw (objetos de arquivo) |

Processado (tabelas, linhas, colunas) |

|

Esquema |

Esquema em leitura |

Esquema na gravação |

|

Custo |

Armazenamento de baixo custo |

Mais caro por GB |

|

Caso de uso |

Machine learning, big data e armazenamento de dados brutos |

Inteligência de negócios, análise estruturada |

|

Desempenho |

Flexível, depende do mecanismo de computação |

Otimizado para consultas SQL rápidas |

Na prática, muitas estratégias modernas de dados combinam ambos: usando data lakes como base para o armazenamento de dados brutos e data warehouses para relatórios estruturados e business intelligence.

Há também uma solução híbrida chamada de data lakehouse. O artigo O que é um Data Lakehouse? Architecture, Technology & Use Cases explica isso de forma mais completa.

Componentes de uma arquitetura de data lake

Uma arquitetura de data lake bem projetada é essencial para tornar os dados brutos utilizáveis e acessíveis para análises downstream, machine learning e relatórios.

Esta seção detalha as cinco camadas principais de um data lake moderno, desde a ingestão até a governança.

Camada de ingestão de dados

A camada de ingestão traz dados de várias fontes para o lago de dados. Essas fontes incluem sistemas internos (como bancos de dados ou CRMs), APIs externas ou dispositivos e registros de IoT.

Há três modos principais de ingestão:

- Ingestão de lotes: Carregar dados periodicamente (como à noite) em lotes.

- Ingestão de fluxo: Fluxos de dados em tempo real, como fluxo de cliques ou dados de sensores.

- Ingestão híbrida: Uma combinação de lote e fluxo, que é comum em ambientes corporativos.

As ferramentas de ingestão padrão incluem:

- Apache Kafka e AWS Kinesis para streaming

- Apache NiFi, Flume e AWS Glue para ETL em lote

Uma camada de ingestão flexível garante que os dados cheguem rapidamente e possa lidar com uma variedade de formatos e velocidades.

Camada de armazenamento

Quando os dados são ingeridos, eles são armazenados na zona bruta do lago de dados. A camada de armazenamento geralmente é criada com base no armazenamento de objetos em nuvem, que oferece dimensionamento elástico, redundância e eficiência de custo.

As opções mais populares incluem:

- Amazon S3

- Azure Data Lake Storage

- Google Cloud Storage

No entanto, também há opções para empresas que desejam armazenar seus dados em suas nuvens locais hospedadas em seus data centers.

Você pode, por exemplo, instalar o MinIO em sua infraestrutura. O próprio MinIO é de código aberto e oferece uma API compatível com o Amazon S3.

Os principais recursos de uma camada de armazenamento incluem:

- Durabilidade e disponibilidade: Os dados são replicados automaticamente entre as regiões.

- Separação de armazenamento e computação: Você pode dimensionar a computação de forma independente com base na demanda.

- Classificação de dados em camadas: Permite o armazenamento a frio para arquivamento e o armazenamento a quente para dados acessados com frequência.

O armazenamento de dados em seu formato original permite que você mantenha todo o seu potencial para processamento e análise futuros.

Gerenciamento de catálogos e metadados

Sem metadados, um lago de dados se torna um pântano de dados, pois é impossível encontrar seus dados novamente e trabalhar com eles de forma eficiente.

O catálogo e a camada demetadados trazem estrutura ao caos, mantendo o controle:

- Esquema de dados

- Localização e particionamento de dados

- Linhagem e controle de versão

Essa camada garante a capacidade de descoberta e de uso, indexando todos os conjuntos de dados disponíveis e permitindo a pesquisa e o controle de acesso. As ferramentas padrão para essa camada incluem:

- Catálogo de dados do AWS Glue

- Metastore do Apache Hive

- Atlas do Apache

- DataHub

Um sistema de metadados sólido é essencial para a colaboração, a governança e a eficiência operacional.

Camada de processamento e análise

Essa é a camada em que os dados brutos são processados e transformados em insights. A camada de processamento oferece suporte a várias operações, desde transformações fundamentais até análises avançadas e machine learning.

Os fluxos de trabalho típicosincluem:

- Pipelines ETL/ELT para limpeza e normalização de dados

- Consulta SQL

- Pipelines de machine learning

Essa camada geralmente inclui computação em lote e em tempo real, permitindo a análise exploratória de dados e cargas de trabalho de produção.

Segurança e governança

Uma arquitetura robusta de data lake deve ter mecanismos integrados para proteger dados confidenciais e garantir a conformidade. Essa parte é crucial, pois os data lakes contêm, em sua maioria, muitos dados confidenciais que, quando comprometidos, podem prejudicar a empresa à qual pertencem.

Os recursos essenciais dessa camada incluem:

- Gerenciamento de identidade e acesso (IAM): Restringir quem pode ver ou modificar os dados.

- Criptografia: Criptografia em trânsito (TLS) e em repouso.

- Mascaramento e anonimização de dados: Para lidar com informações de identificação pessoal.

- Auditoria e monitoramento: Para rastreabilidade e conformidade.

Ferramentas e serviços populares:

- Formação do Lago AWS

- Apache Ranger

- Visão do Azure

A segurança geralmente determina se um data lake pode ser usado em setores regulamentados, como o financeiro, o de saúde ou o militar.

Casos de uso comuns para data lakes

Os data lakes são adequados para casos de uso em que escala, flexibilidade e diversos tipos de dados são essenciais. Eles servem como base para operações e aplicativos modernos orientados por dados em todos os setores.

Nesta seção, exploraremos alguns dos casos de uso mais comuns e impactantes em que os lagos de dados desempenham um papel central.

Análise de Big Data

Um dos usos mais conhecidos dos data lakes é permitir a análise de dados em grande escala.

Como os data lakes podem armazenar dados em sua forma bruta, as organizações não precisam mais se preocupar com a limpeza ou a estruturação de cada conjunto de dados antes da análise. Isso é ideal para a coleta de logs, dados de sensores ou fluxos de cliques, que são muito grandes ou mudam rapidamente para os sistemas tradicionais.

Os data lakes possibilitam que você:

- Analisar dados históricos juntamente com dados em tempo real

- Execute consultas personalizadas em conjuntos de dados em escala de petabytes

- Permitir análises entre departamentos com uma única fonte de verdade

Ferramentascomo o Amazon Athena ou o Google BigQuery podem consultar dados diretamente no lago sem exigir transformações complexas ou mover os dados para outro lugar.

Machine learning e IA

Os data lakes são perfeitos para os fluxos de trabalho de machine learning e IA.

Eles proporcionam o ambiente ideal para você:

- Armazenamento de conjuntos de dados de treinamento em vários formatos (por exemplo, CSV, Parquet, imagens, etc.)

- Manter dados brutos e, portanto, mais abrangentes, permitindo maior flexibilidade na exploração, experimentação e iteração de modelos de ML

- Potencializar pipelines de ML automatizados que iteram sobre grandes volumes de dados

Em vez de limitar os modelos a dados pré-limpos de um warehouse, os cientistas de dados podem acessar dados ricos e brutos para fazer experiências com mais liberdade e iterar mais rapidamente. Isso é especialmente útil em domínios como processamento de linguagem natural (NLP), visão computacional e previsão de séries temporais.

Se você quiser um exemplo de como a solução Databricks Lakehouse pode ser usada para IA, recomendoa leitura de A Comprehensive Guide to Databricks Lakehouse AI For Data Scientists.

Arquivamento centralizado de dados

Muitas organizações usam data lakes para armazenamento e arquivamento de longo prazo.

Graças ao baixo custo do armazenamento de objetos em nuvem, é economicamente viável armazenar anos de dados operacionais que podem não ser usados diariamente, mas que ainda precisam estar acessíveis para fins de conformidade e auditoria, análise de tendências, previsão ou treinamento de futuros modelos de ML.

A maioria das soluções de armazenamento de objetos em nuvem permite que você classifique seu armazenamento em níveis para arquivar dados raramente acessados e, ao mesmo tempo, manter o lago enxuto e eficiente.

Experimentação de ciência de dados

Os data lakes permitem que os cientistas de dados explorem dados brutos sem restrições.

Quer você esteja criando um protótipo rápido, testando uma nova hipótese ou executando uma análise exploratória de dados (EDA), o lago oferece acesso flexível a:

- Dados brutos não estruturados (como PDFs, e-mails, arquivos de texto)

- Formatos semiestruturados (como JSON, XML ou registros)

- Grandes conjuntos de dados que não caberiam em um banco de dados tradicional

Essa camada de experimentação é essencial para a inovação. Os data lakes permitem que você explore conjuntos de dados de novas maneiras sem enviar tíquetes para a equipe de engenharia de dados ou esperar por uma versão limpa no warehouse.

Benefícios e desafios dos data lakes

Embora os data lakes ofereçam recursos potentes para fluxos de trabalho de dados modernos, eles também apresentam desafios exclusivos. Compreender os dois lados é essencial antes de adotar uma arquitetura de data lake. Nesta seção, discutirei os principais benefícios, as armadilhas comuns e como superá-las.

Benefícios dos data lakes

A vantagem mais significativa de um data lake é sua flexibilidade. Você não está vinculado a um esquema ou modelo de dados específico desde o início, o que é excelente quando se trabalha com conjuntos de dados que mudam ou evoluem rapidamente.

Aqui estão alguns dos principais benefícios:

- Escalabilidade: Os data lakes são criados com base no armazenamento nativo da nuvem que é dimensionado sem esforço, quer você esteja armazenando gigabytes ou petabytes.

- Suporte para todos os tipos de dados: Você pode armazenar dados estruturados (tabelas SQL), semiestruturados (JSON, XML) e não estruturados (texto, imagens, vídeo) na mesma plataforma.

- Eficiência de custo: O armazenamento de objetos em nuvem (por exemplo, Amazon S3) é significativamente mais barato do que o armazenamento usado por bancos de dados ou warehouses tradicionais.

- Arquitetura desacoplada: A computação e o armazenamento são separados para dimensionar as cargas de trabalho de análise independentemente do armazenamento de dados.

- Análises aprimoradas: Os data lakes armazenam dados brutos e não processados e permitem uma análise de dados mais abrangente e flexível, incluindo machine learning e análise preditiva.

- Melhoria na tomada de decisões: Os data lakes podem permitir uma análise de dados mais profunda e abrangente, levando a decisões mais bem informadas em toda a organização.

- Eliminação de silos de dados: Os data lakes ajudam a eliminar os silos de dados, consolidando dados de várias fontes em um único repositório centralizado.

Nos projetos em que trabalhei, essa centralização reduziu os silos de dados e melhorou significativamente a colaboração entre as equipes.

Principais desafios

Os lagos de dados são poderosos, mas alguns desafios importantes devem ser gerenciados. Se não forem gerenciados, eles podem rapidamente se tornar desorganizados e inutilizáveis, um estado geralmente chamado de pântano de dados.

Alguns desafios comuns incluem:

- Falta de estrutura: Sem esquemas predefinidos, pode ser difícil consultar, documentar ou controlar os dados.

- Problemas de qualidade de dados: Como os dados são ingeridos na forma bruta, os dados de baixa qualidade ou incompletos podem não ser detectados até o final do processo.

- Lacunas nos metadados e na capacidade de descoberta: Sem um sistema de catalogação sólido, os usuários podem não saber quais dados existem ou como usá-los.

- Governança complexa: Garantir o controle de acesso, a auditabilidade e a conformidade é mais difícil em um ambiente flexível.

Esses problemas podem diminuir a confiança no data lake e reduzir a adoção em toda a empresa.

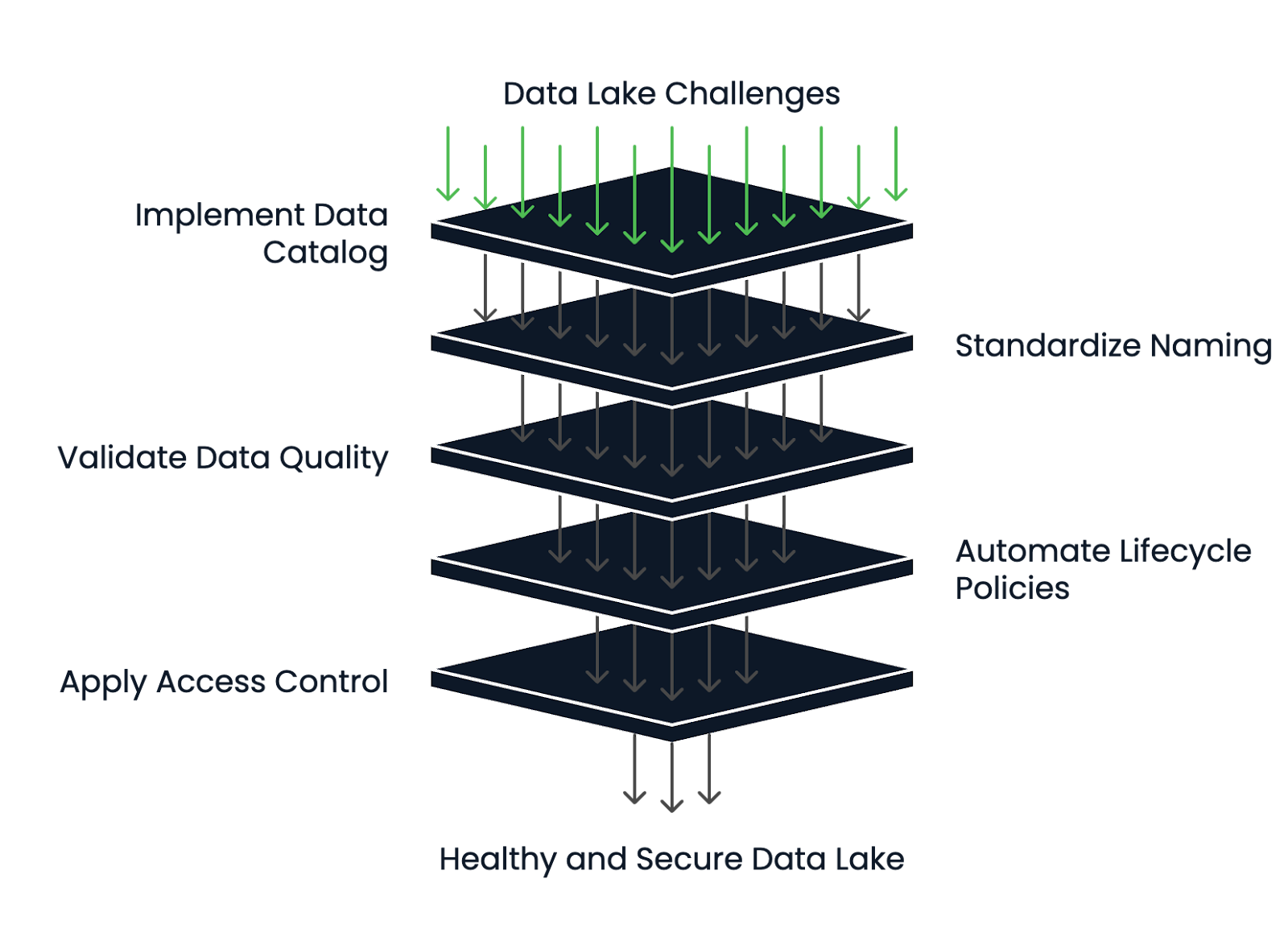

Como mitigar os desafios

Os data lakes mais bem-sucedidos têm práticas sólidas de gerenciamento de metadados e de ciclo de vida.

Veja como você pode reduzir os riscos e manter seu lago de dados saudável:

- Implementar um catálogo de dados: Ferramentas como o AWS Glue ou o DataHub ajudam a manter a capacidade de descoberta, as definições de esquema e o rastreamento de linhagem.

- Use estruturas padronizadas de nomes e pastas: Isso cria consistência e reduz a confusão na equipe.

- Adapte as ferramentas de validação de dados e criação de perfis: Garanta a qualidade durante a ingestão e revalide periodicamente os dados.

- Automatize as políticas de ciclo de vida: Mova automaticamente dados obsoletos para o armazenamento a frio ou exclua-os após um período de retenção definido.

- Aplique controle de acesso e criptografia robustos: Para proteger dados confidenciais, use políticas de IAM, acesso baseado em funções e criptografia em repouso e em trânsito.

Um data lake pode continuar sendo um ativo, e não um passivo, se você projetar uma arquitetura limpa desde o início e estabelecer estruturas de governança sólidas.

Estrutura de gerenciamento da integridade do lago de dados. Imagem do autor.

Popular Data Lake Technologies

Com a crescente importância dos data lakes na arquitetura de dados moderna, surgiu uma ampla gama de tecnologias para dar suporte a eles. Essas ferramentas abrangem plataformas nativas de nuvem, ecossistemas de código aberto e integrações com soluções de análise. Nesta seção, mostrarei a você as ferramentas mais populares.

Soluções nativas da nuvem

Os provedores de nuvem oferecem serviços totalmente gerenciados para a criação e manutenção de data lakes. Essas plataformas costumam ser o ponto de partida para equipes que buscam escala, durabilidade e forte integração com outros serviços em nuvem.

As soluções populares nativas da nuvem incluem:

- Amazon S3 + AWS Lake Formation: O S3 fornece armazenamento de objetos, enquanto o Lake Formation lida com permissões, catalogação e governança.

- Azure Data Lake Storage: Combina o armazenamento de blob com recursos semelhantes aos do HDFS.

- Google Cloud Storage (GCS): O GCS é altamente durável e se integra bem ao BigQuery e ao Vertex AI para cargas de trabalho de análise e ML.

Esses serviços são otimizados para elasticidade, economia e segurança, o que os torna ideais para lagos de dados em escala empresarial.

Ferramentas de código aberto

As tecnologias de código aberto adicionam flexibilidade e extensibilidade, especialmente para equipes que desejam evitar a dependência de fornecedores ou operar em ambientes híbridos/multi-nuvem.

As soluções mais populares incluem:

- Apache Hadoop: Uma das estruturas originais de data lake. Embora menos comum hoje em dia para novos projetos, ele estabeleceu a base para o armazenamento e o processamento de dados distribuídos.

- Delta Lake: Desenvolvido pela Databricks, o Delta Lake adiciona transações ACID, controle de versão e aplicação de esquema ao armazenamento de objetos em nuvem.

- Apache Iceberg: O Iceberg oferece operações atômicas, particionamento oculto e viagem no tempo para consulta de dados históricos.

- Presto: Um mecanismo de consulta SQL distribuído que permite que você execute consultas rápidas e interativas em dados armazenados no S3, no HDFS ou em outras fontes sem mover os dados.

Essas ferramentas geralmente se integram a plataformas de dados mais amplas e são preferidas pelas equipes de engenharia que criam soluções personalizadas ou modulares.

Se você quiser explorar as diferenças entre o Apache Iceberg e o Delta Lake com mais detalhes, recomendoa leitura de Apache Iceberg vs. Delta Lake. Delta Lake: Recursos, diferenças e casos de uso.

Integração com plataformas de análise

Um lago de dados se torna valioso quando integrado a ferramentas de análise e visualização que ajudam a extrair insights e a orientar as decisões de negócios. Portanto, antes de selecionar a solução final, você deve sempre verificar antecipadamente com quais plataformas de análise a solução de data lake deve ser integrada.

As plataformas de análise mais populares incluem:

- Databricks: Combina o armazenamento do data lake com um espaço de trabalho colaborativo para engenharia de dados, machine learning e análise. Ele suporta o Delta Lake imediatamente.

- Snowflake: Embora seja tradicionalmente um data warehouse, o Snowflake pode consultar dados externos no armazenamento em nuvem (via Snowpipe ou tabelas externas), o que o torna uma solução híbrida de lakehouse.

- Power BI, Tableau: Essas ferramentas de BI podem se conectar aos data lakes diretamente ou por meio de mecanismos de consulta como o Athena ou o BigQuery, permitindo a criação de painéis e relatórios sobre dados brutos ou semiestruturados.

Se você quiser saber mais sobre o Databricks, recomendoo curso Introduction to Databricks.

Ao escolher as tecnologias, é essencial alinhá-las à experiência da sua equipe, à sua estratégia de dados e ao nível de flexibilidade ou abstração de que você precisa.

Conclusão

Os data lakes capacitam as organizações a criar aplicativos robustos de machine learning e painéis em tempo real, oferecendo uma base de dados flexível, escalável, bruta e semiestruturada.

Neste artigo, exploramos o que é um data lake, seus principais componentes e quando você deve usá-lo. Discutimos os benefícios, como flexibilidade e escalabilidade, os desafios, como a governança de dados e o risco de um "pântano de dados", e como evitá-los. Por fim, abordamos tecnologias populares para a criação de data lakes, incluindo plataformas de nuvem e ferramentas de código aberto.

Com base na minha experiência de trabalho em MLOps, infraestrutura de IA e sistemas de dados nativos da nuvem, vi como um data lake bem arquitetado pode transformar a forma como as equipes colaboram e inovam. Mas também vi como um lago de dados mal governado pode se tornar um problema rapidamente, e navegar por ele pode se tornar difícil.

Se a sua organização lida com dados complexos, diversificados ou em grande escala e deseja permitirexperimentação mais rápida, análises mais ricas ou desenvolvimento de IA, um data lake pode ser exatamente o que você precisa.

O curso Understanding Modern Data Architecture é uma ótima primeira parada se você quiser saber mais.

Torne-se um engenheiro de dados

Perguntas frequentes

Que tipos de organizações se beneficiam mais com o uso de um data lake?

As organizações que lidam com conjuntos de dados em grande escala, diversificados ou em rápida evolução, como empresas de tecnologia, instituições financeiras e prestadores de serviços de saúde, são as que mais se beneficiam dos data lakes.

Como um data lake oferece suporte à análise em tempo real?

Um data lake pode ingerir dados de streaming de dispositivos ou aplicativos de IoT em tempo real, permitindo análises imediatas e tomadas de decisão mais rápidas por meio de ferramentas como Apache Kafka e Amazon Kinesis.

Você pode implantar os data lakes no local ou eles são apenas para a nuvem?

Embora os data lakes baseados em nuvem sejam comuns, é possível implantar data lakes no local usando soluções como o HDFS (Hadoop Distributed File System) ou MinIO para armazenamento de objetos compatível com S3.

O que é um pântano de dados e como você pode evitá-lo?

Um pântano de dados ocorre quando um lago de dados se torna desorganizado e inutilizável devido ao gerenciamento e à governança de metadados deficientes. Políticas sólidas de catalogação, documentação e governança ajudam a evitar isso.

Como os data lakes permitem o desenvolvimento do machine learning?

Ao armazenar tipos de dados brutos e diversos, os data lakes permitem que os cientistas de dados façam experiências com mais liberdade, criem conjuntos de dados de treinamento mais ricos e iterem mais rapidamente nos modelos de machine learning.

Há preocupações específicas de conformidade com os data lakes?

Sim, o armazenamento de dados não estruturados e confidenciais em formatos brutos exige criptografia rigorosa, controle de acesso, auditoria e estruturas de conformidade para atender a normas como GDPR e HIPAA.

Como o schema-on-read afeta a análise de dados em um data lake?

O schema-on-read permite que os usuários apliquem diferentes esquemas no momento da consulta, oferecendo flexibilidade, mas também exigindo descoberta e interpretação cuidadosa dos dados para uma análise precisa.

Qual é a diferença entre um data lake e um data lakehouse?

Um data lakehouse combina a flexibilidade de um data lake com os recursos de gerenciamento e transacionais de um data warehouse, oferecendo o melhor dos dois mundos para análise e IA.

Quanto custa para você manter um data lake baseado em nuvem?

Os custos variam de acordo com o volume de armazenamento, a transferência de dados e a frequência de acesso, mas os serviços de armazenamento de objetos em nuvem (como o Amazon S3) são normalmente mais baratos por GB do que os bancos de dados tradicionais.

Quais são as habilidades necessárias para criar e gerenciar um data lake com sucesso?

As principais habilidades incluem gerenciamento de infraestrutura em nuvem, engenharia de dados, experiência em segurança e conformidade, gerenciamento de metadados e experiência com ferramentas de big data como Spark ou Presto.

Sou um engenheiro de nuvem com sólida base em engenharia elétrica, aprendizado de máquina e programação. Minha carreira começou na área de visão computacional, com foco na classificação de imagens, antes de fazer a transição para MLOps e DataOps. Sou especialista em criar plataformas MLOps, dar suporte a cientistas de dados e fornecer soluções baseadas em Kubernetes para otimizar os fluxos de trabalho de aprendizado de máquina.