Kurs

Python ist eine der beliebtesten Programmiersprachen, die in vielen technischen Bereichen genutzt wird, vor allem in der Datenwissenschaft und im maschinellen Lernen. Python ist eine einfach zu programmierende, objektorientierte Hochsprache mit einer großen Auswahl an Bibliotheken für viele verschiedene Anwendungsfälle. Es hat über 200.000 Bibliotheken.

Einer der Gründe, warum Python für die Datenwissenschaft so wichtig ist, ist die riesige Auswahl an Bibliotheken für Datenbearbeitung, Datenvisualisierung, maschinelles Lernen und Deep Learning. Da Python so viele tolle Bibliotheken für Datenwissenschaft hat, ist es echt unmöglich, alles in einem Artikel zu erklären. Die Liste der besten Bibliotheken hier konzentriert sich nur auf fünf Hauptbereiche:

- Grundlagen der Datenwissenschaft

- Maschinelles Lernen

- AutoML

- Tiefes Lernen

- Natürliche Sprachverarbeitung

Es gibt noch viele andere Bereiche, die hier nicht aufgeführt sind, zum Beispiel MLOps, Big Data und Computer Vision. Die Liste in diesem Blog ist nicht in irgendeiner bestimmten Reihenfolge und soll auch nicht als eine Art Rangliste verstanden werden.

Wichtige Python-Bibliotheken für die Datenwissenschaft

1. NumPy

NumPy ist eine der am häufigsten genutzten Open-Source-Python-Bibliotheken und wird hauptsächlich für wissenschaftliche Berechnungen verwendet. Die eingebauten Mathefunktionen machen blitzschnelle Berechnungen möglich und können mit mehrdimensionalen Daten und großen Matrizen umgehen. Es wird auch in der linearen Algebra benutzt. NumPy-Arrays werden oft lieber als Listen benutzt, weil sie weniger Speicher brauchen und praktischer und effizienter sind.

Laut der Website von NumPy ist es ein Open-Source-Projekt, das numerische Berechnungen mit Python ermöglichen soll. Es wurde 2005 entwickelt und basiert auf den frühen Arbeiten der Bibliotheken Numeric und Numarray. Einer der großen Vorteile von NumPy ist, dass es unter der modifizierten BSD-Lizenz veröffentlicht wurde und somit für alle immer kostenlos nutzbar sein wird.

NumPy wird auf GitHub entwickelt, und zwar mit dem Einverständnis der NumPy-Community und der größeren wissenschaftlichen Python-Community. Mehr dazu erfährst du in unserem Einführungskurs zu Numpy.

⭐ GitHub-Sterne: 25K | Gesamtzahl der Downloads: 2,4 Milliarden

2. Pandas

Pandas ist eine Open-Source-Bibliothek, die man oft in der Datenwissenschaft benutzt. Es wird hauptsächlich für die Datenanalyse, Datenbearbeitung und Datenbereinigung genutzt. Pandas machen es einfach, Daten zu modellieren und zu analysieren, ohne dass man viel Code schreiben muss. Wie auf ihrer Website steht, ist pandas ein schnelles, leistungsstarkes, flexibles und einfach zu bedienendes Open-Source-Tool zur Datenanalyse und -bearbeitung. Ein paar wichtige Features dieser Bibliothek sind:

- DataFrame, die eine schnelle und effiziente Datenbearbeitung ermöglichen und eine integrierte Indizierung haben;

- Ein paar Tools, mit denen man Daten zwischen In-Memory-Datenstrukturen und verschiedenen Formaten schreiben und lesen kann, wie Excel-Dateien, Text- und CSV-Dateien, Microsoft-, HDF5-Formate und SQL-Datenbanken.

- Intelligentes, auf Labels basierendes Slicing, ausgefallene Indizierung und Teilmengebildung großer Datensätze;

- Schnelles Zusammenführen und Verbinden von Datensätzen;

- Eine leistungsstarke Gruppierungs-Engine, die Datenaggregation oder -transformation ermöglicht und es den Benutzern erlaubt, Split-Apply-Combine-Operationen an Datensätzen durchzuführen.

- Zeitreihen-Funktion, die die Erstellung von Datumsbereichen und die Umrechnung von Frequenzen, gleitende Fensterstatistiken, Datumsverschiebungen und Verzögerungen ermöglicht. Du kannst sogar Zeitreihen zusammenführen und domänenspezifische Zeitversätze erstellen, ohne dir Sorgen machen zu müssen, dass du Daten verlierst.

- Perfekt, wenn du mit kritischen Codepfaden arbeitest, die in C oder Cython geschrieben sind.

Der Einstieg in Pandas ist echt einfach und unkompliziert. Du kannst dir „Analyzing Police Activity with pandas” von DataCamp anschauen, um zu lernen, wie man pandas mit echten Datensätzen benutzt.

⭐ GitHub-Sterne: 41K | Gesamtzahl der Downloads: 1,6 Milliarden

3. Polare

Während Pandas immer noch der Standard für kleine Datenmengen ist, hat sich Polars zum Standard für die Hochleistungsdatenverarbeitung entwickelt. Es ist in Rust geschrieben und nutzt eine „Lazy Evaluation”-Engine, um Datensätze (10 GB–100 GB+) zu verarbeiten, die normalerweise Maschinen mit begrenztem RAM zum Absturz bringen würden. Anders als Pandas, das Operationen nacheinander macht, optimiert Polars Abfragen von Anfang bis Ende und führt sie parallel auf allen verfügbaren CPU-Kernen aus.

Es ist als Drop-in-Upgrade für schwere Workloads gedacht und bietet eine Syntax, die oft besser lesbar und 10- bis 50-mal schneller ist als herkömmliche DataFrame.

Hier ist ein Beispiel für einen Code, der eine gefilterte, gruppierte und zusammengefasste Auswahl aus einem riesigen CSV-Datensatz macht:

import polars as pl

# Lazy evaluation: Nothing runs until .collect() is called

# allowing Polars to optimize the query plan beforehand

q = (

pl.scan_csv("massive_dataset.csv")

.filter(pl.col("category") == "Technology")

.group_by("region")

.agg(pl.col("sales").sum())

)

df = q.collect() # Executes in parallel⭐ GitHub-Sterne: 40K+ | Status: Hochleistungsstandard

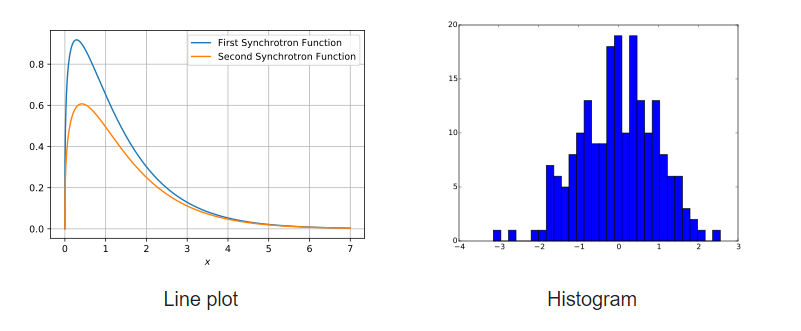

4. Matplotlib

Matplotlib ist eine umfangreiche Bibliothek zum Erstellen von festen, interaktiven und animierten Python-Visualisierungen. Viele Pakete von Drittanbietern erweitern und bauen auf den Funktionen von Matplotlib auf, darunter mehrere höherwertige Schnittstellen zum Zeichnen von Diagrammen (Seaborn, HoloViews, ggplot usw.).

Matplotlib ist so gemacht, dass es genauso gut funktioniert wie MATLAB, und man kann zusätzlich Python nutzen. Außerdem ist es kostenlos und Open Source. Damit kann man Daten mit verschiedenen Diagrammtypen anschauen, zum Beispiel Streudiagramme, Histogramme, Balkendiagramme, Fehlerdiagramme und Boxplots. Außerdem kannst du alle Visualisierungen mit nur ein paar Zeilen Code machen.

Beispielgrafiken, die mit Matplotlib erstellt wurden

Starte mit diesem Schritt-für-Schritt-Tutorial in Matplotlib.

⭐ GitHub-Sterne: 18,7K | Gesamtzahl der Downloads: 653 Millionen

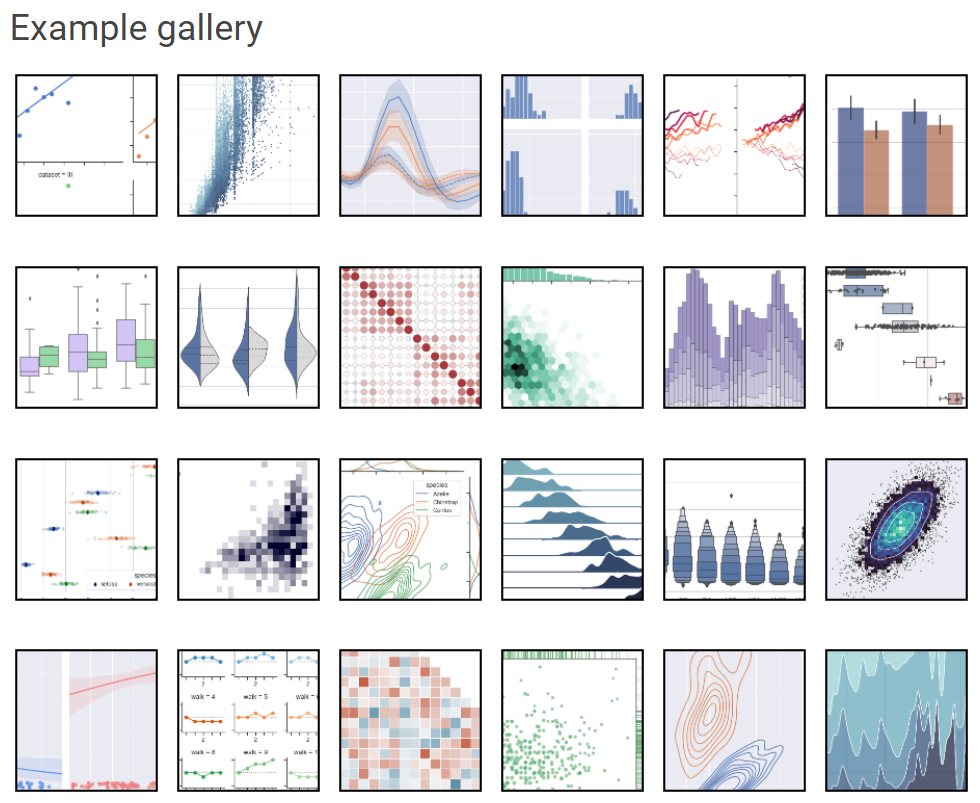

5. Seaborn

Seaborn ist ein weiteres beliebtes Python-Framework zur Datenvisualisierung, das auf Matplotlib basiert. Es ist eine hochentwickelte Schnittstelle zum Erstellen von ästhetisch ansprechenden und wertvollen statistischen Darstellungen, die für die Untersuchung und das Verständnis von Daten entscheidend sind. Diese Python-Bibliothek ist eng mit den Datenstrukturen von NumPy und pandas verbunden. Das Hauptziel von Seaborn ist es, die Visualisierung zu einem wichtigen Teil der Datenanalyse und -erkundung zu machen. Deshalb nutzen seine Plotting-Algorithmen Datenrahmen, die ganze Datensätze abdecken.

Seaborn-Beispielgalerie

Dieses Seaborn-Tutorial für Anfänger ist super, um dich mit dieser dynamischen Visualisierungsbibliothek vertraut zu machen.

⭐ GitHub-Sterne: 11,6K | Gesamtzahl der Downloads: 180 Millionen

6. Plotly

Die super beliebte Open-Source-Grafikbibliothek Plotly kann man nutzen, um interaktive Datenvisualisierungen zu erstellen. Plotly basiert auf der Plotly-JavaScript-Bibliothek (plotly.js) und kann verwendet werden, um webbasierte Datenvisualisierungen zu erstellen, die als HTML-Dateien gespeichert oder in Jupyter-Notebooks und Webanwendungen mit Dash angezeigt werden können.

Es bietet über 40 einzigartige Diagrammtypen, wie zum Beispiel Streudiagramme, Histogramme, Liniendiagramme, Balkendiagramme, Kreisdiagramme, Fehlerbalken, Boxplots, mehrere Achsen, Sparklines, Dendrogramme und 3D-Diagramme. Plotly hat auch Konturdiagramme, die in anderen Bibliotheken für Datenvisualisierung nicht so oft vorkommen.

Wenn du interaktive Visualisierungen oder Dashboard-ähnliche Grafiken willst, ist Plotly eine gute Alternative zu Matplotlib und Seaborn. Es steht derzeit unter der MIT-Lizenz zur Verfügung.

Mit diesem Plotly-Visualisierungskurs kannst du noch heute anfangen, Plotly zu meistern.

⭐ GitHub-Sterne: 14,7K | Gesamtzahl der Downloads: 190 Millionen

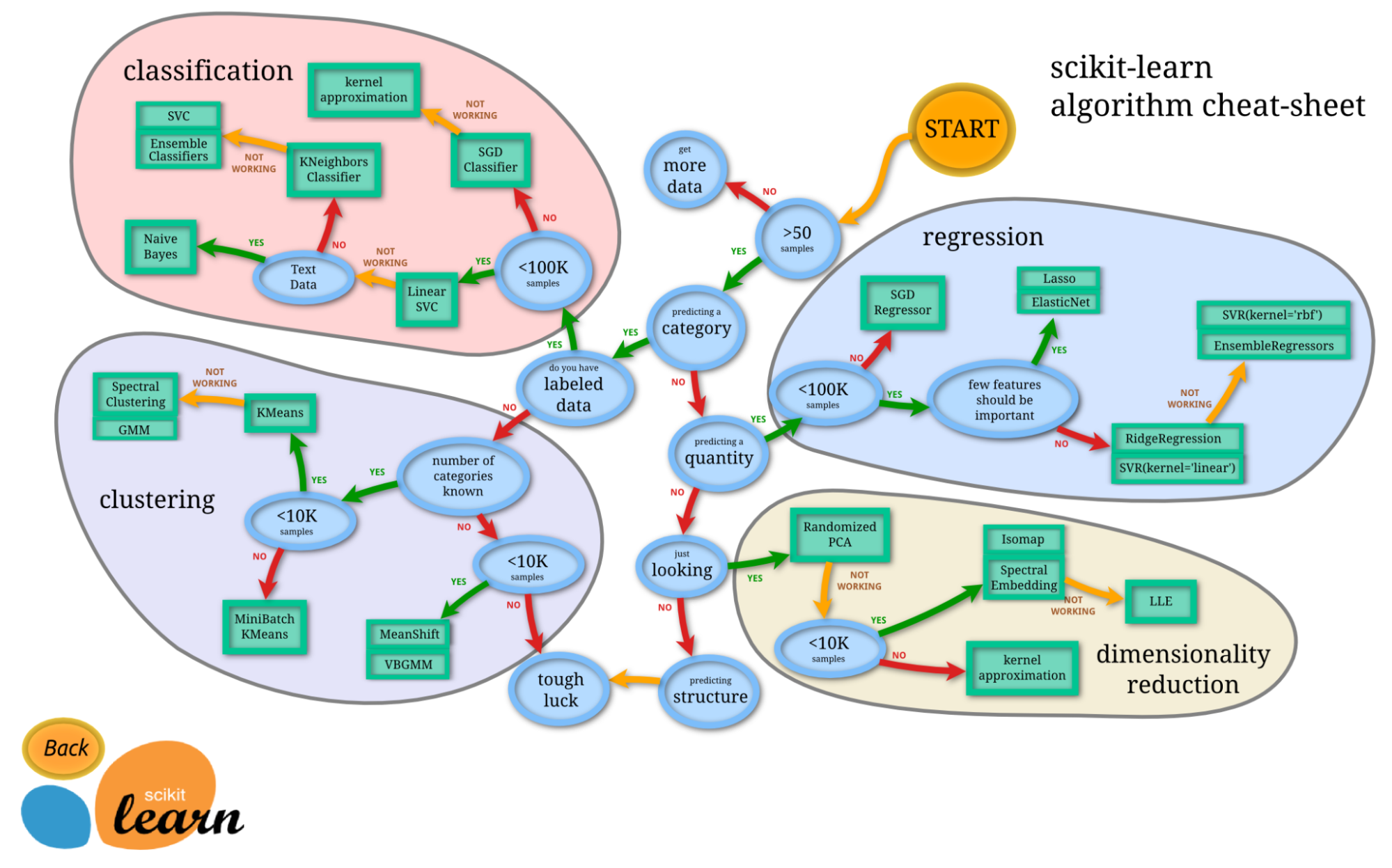

7. Scikit-Learn

Die Begriffe „maschinelles Lernen“ und „scikit-learn“ sind untrennbar miteinander verbunden. Scikit-learn ist eine der am häufigsten genutzten Bibliotheken für maschinelles Lernen in Python. Es basiert auf NumPy, SciPy und Matplotlib und ist eine Open-Source-Python-Bibliothek, die unter der BSD-Lizenz kommerziell genutzt werden kann. Es ist ein einfaches und effizientes Tool für Aufgaben der prädiktiven Datenanalyse.

Scikit-learn wurde 2007 als Google Summer of Code-Projekt gestartet und ist ein gemeinschaftliches Projekt. Aber institutionelle und private Fördermittel helfen dabei, dass es weiterläuft.

Das Beste an scikit-learn ist, dass es echt einfach zu benutzen ist.

import numpy as np

from sklearn import datasets, linear_model

from sklearn.metrics import mean_squared_error, r2_score

# Load the diabetes dataset

diabetes_X, diabetes_y = datasets.load_diabetes(return_X_y=True)

# Use only one feature

diabetes_X = diabetes_X[:, np.newaxis, 2]

# Split the data into training/testing sets

diabetes_X_train = diabetes_X[:-20]

diabetes_X_test = diabetes_X[-20:]

# Split the targets into training/testing sets

diabetes_y_train = diabetes_y[:-20]

diabetes_y_test = diabetes_y[-20:]

# Create linear regression object

regr = linear_model.LinearRegression()

# Train the model using the training sets

regr.fit(diabetes_X_train, diabetes_y_train)

# Make predictions using the testing set

diabetes_y_pred = regr.predict(diabetes_X_test)Quelle: Code aus der offiziellen Dokumentation von scikit-learn.

Du kannst scikit-learn mit diesem Tutorial für Anfänger selbst ausprobieren.

⭐ GitHub-Sterne: 57K | Gesamtzahl der Downloads: 703 Millionen

8. Streamlit

Die Zeiten, in denen Datenwissenschaftler nur statische PDF-Berichte geliefert haben, sind vorbei. Streamlit macht aus Python-Skripten in wenigen Minuten interaktive Web-Apps, die man teilen kann. Du brauchst keine Kenntnisse in HTML, CSS oder JavaScript. Im Jahr 2025 wird es oft benutzt, um interne Tools, Dashboard-Prototypen und interaktive Modelldemos für die Beteiligten zu erstellen.

Mit einfachen API-Aufrufen wie st.write() und st.slider() kannst du ein Frontend erstellen, das in Echtzeit auf Datenänderungen reagiert und so die Lücke zwischen Analyse und Technik schließt.

⭐ GitHub-Sterne: 42K+ | Status: Wichtig für die Lieferung

9. Pydantic

Pydantic war mal ein Tool für die Webentwicklung, ist jetzt aber ein wichtiger Teil des KI-Stacks. Es macht Datenvalidierung und verwaltet Einstellungen mit Python-Typ-Annotationen. Im Zeitalter der LLMs ist es echt wichtig, dass die Daten (und die Modellergebnisse) genau einem bestimmten Schema entsprechen.

Pydantic ist die Engine, die Bibliotheken wie LangChain und Hugging Face antreibt. Sie sorgt dafür, dass die chaotischen JSON-Ausgaben von KI-Modellen in strukturierte, gültige Python-Objekte umgewandelt werden, die deinen nachgelagerten Code nicht kaputt machen.

⭐ GitHub-Sterne: 26K+ | Status: Kritische Infrastruktur

Python-Bibliotheken für maschinelles Lernen

10. LightGBM

LightGBM ist eine super beliebte Open-Source-Bibliothek für Gradient Boosting, die Algorithmen auf Basis von Entscheidungsbäumen nutzt. Es hat folgende Vorteile:

- Schnellere Trainingsgeschwindigkeit und höhere Effizienz

- Weniger Speicher verbrauchen

- Bessere Genauigkeit

- Unterstützung von parallelem, verteiltem und GPU-Lernen

- Kann mit riesigen Datenmengen umgehen

Es kann sowohl für überwachte Klassifizierungs- als auch für Regressionsaufgaben verwendet werden. Du kannst dir die offizielle Dokumentation oder deren GitHub ansehen, um mehr über dieses tolle Framework zu erfahren.

⭐ GitHub-Sterne: 15,8K | Gesamtzahl der Downloads: 162 Millionen

11. XGBoost

XGBoost ist eine weitere weit verbreitete Bibliothek für verteiltes Gradientenboosting, die portabel, flexibel und effizient ist. Es ermöglicht die Implementierung von Algorithmen für maschinelles Lernen innerhalb des Gradient-Boosting-Frameworks. XGBoost bietet (GBDT) gradientenverstärkte Entscheidungsbäume, ein paralleles Baum-Boosting, das schnell und genau Lösungen für viele Probleme in der Datenwissenschaft liefert. Der gleiche Code läuft auf den wichtigsten verteilten Umgebungen (Hadoop, SGE, MPI) und kann unzählige Probleme lösen.

XGBoost ist in den letzten Jahren richtig beliebt geworden, weil es Leuten und Teams geholfen hat, fast jeden Kaggle-Wettbewerb mit strukturierten Daten zu gewinnen. Zu den Vorteilen von XGBoost gehören:

- Eine große und ständig wachsende Nutzerbasis

- Kann für viele Sachen verwendet werden, wie Regression, Klassifizierung und Rangfolge.

- Läuft auf allen OS X-, Windows- und Linux-Plattformen

- Cloud-Integration

- Wird von vielen Unternehmen in der Produktion genutzt

XGBoost wurde von aktiven Community-Mitgliedern entwickelt und wird von ihnen gepflegt. Es kann unter der Apache-Lizenz genutzt werden. Dieses XGBoost-Tutorial ist eine super Quelle, wenn du mehr darüber erfahren möchtest.

⭐ GitHub-Sterne: 25,2K | Gesamtzahl der Downloads: 179 Millionen

12. CatBoost

Catboost ist eine schnelle, skalierbare und leistungsstarke Gradientenverstärkungsbibliothek für Entscheidungsbäume, die für Ranking, Klassifizierung, Regression und andere Machine-Learning-Aufgaben für Python, R, Java und C++ verwendet wird. Es unterstützt Berechnungen auf CPU und GPU.

Als Nachfolger des MatrixNet-Algorithmus wird er oft für Ranking-Aufgaben, Prognosen und Empfehlungen genutzt. Weil es so vielseitig ist, kann man es in vielen Bereichen und für verschiedene Probleme nutzen.

Die Vorteile von CatBoost sind laut ihrem Repository:

- Bessere Leistung bei vielen Datensätzen im Vergleich zu anderen Bibliotheken für Entscheidungsbäume mit Gradientenverstärkung

- Die schnellste Vorhersagegeschwindigkeit in ihrer Klasse

- Unterstützung für numerische und kategoriale Merkmale

- Super GPU-Unterstützung

- Visualisierungstools inklusive

- Reproduzierbares, effizientes verteiltes Training mit Apache Spark und CLI

⭐ GitHub-Sterne: 7,5K | Gesamtzahl der Downloads: 53 Millionen

13. Statistikmodelle

Statsmodels hat Klassen und Funktionen, mit denen man verschiedene statistische Modelle schätzen, statistische Tests machen und statistische Daten untersuchen kann. Für jeden Schätzer gibt's dann eine umfassende Liste mit Ergebnisstatistiken. Die Genauigkeit der Ergebnisse kann dann mit vorhandenen Statistikpaketen überprüft werden.

Die meisten Testergebnisse in der Bibliothek wurden mit mindestens einem anderen Statistikpaket überprüft: R, Stata oder SAS. Einige Funktionen von statsmodels sind:

- Es hat coole Funktionen für statistische Tests und Modellierung, die man in Bibliotheken wie NumPy oder SciPy nicht findet.

- Lineare Regression.

- Logistische Regression.

- Zeitreihenanalyse.

- Funktioniert mit DataFrames.

- Die Methode zur statistischen Analyse passt besser zur Programmiersprache R. Deshalb ist diese Bibliothek super für Datenwissenschaftler, die schon mit R arbeiten und auf Python umsteigen wollen.

Dieser Einführungskurs zu statistischen Modellen ist super, wenn du mehr darüber lernen willst.

⭐ GitHub-Sterne: 9,2K | Gesamtzahl der Downloads: 161 Millionen

14. RAPIDS.AI cuDF und cuML

Die RAPIDS-Suite von Open-Source-Softwarebibliotheken macht die ganze Datenwissenschaft und Analyse-Pipelines komplett auf GPUs. Mit Dask lässt es sich nahtlos von GPU-Workstations auf Multi-GPU-Server und Multi-Node-Cluster skalieren. Das Projekt wird von NVIDIA unterstützt und nutzt auch Numba, Apache Arrow und viele andere Open-Source-Projekte.

cuDF ist eine GPU-DataFrame-Bibliothek, mit der man Daten laden, verbinden, zusammenfassen, filtern und auf andere Weise bearbeiten kann. Es wurde auf Basis des spaltenorientierten Speicherformats von Apache Arrow entwickelt. Es bietet eine pandas-ähnliche API, die Dateningenieuren und Datenwissenschaftlern vertraut sein wird und es ihnen ermöglicht, ihre Arbeitsabläufe einfach zu beschleunigen, ohne sich mit den Details der CUDA-Programmierung befassen zu müssen.

cuML ist eine Reihe von Bibliotheken, die Algorithmen für maschinelles Lernen und mathematische Grundfunktionen implementieren, die kompatible APIs mit anderen RAPIDS-Projekten teilen. Damit können Datenwissenschaftler, Forscher und Softwareentwickler klassische tabellarische ML-Aufgaben auf GPUs ausführen, ohne sich mit den Details der CUDA-Programmierung beschäftigen zu müssen. Die Python-API von cuML passt normalerweise zur scikit-learn-API.

15. Optuna

Dieses Open-Source-Framework zur Hyperparameter-Optimierung wird hauptsächlich benutzt, um die Suche nach Hyperparametern zu automatisieren. Es nutzt Python-Schleifen, Bedingungen und Syntax, um automatisch nach den besten Hyperparametern zu suchen. Außerdem kann es große Bereiche durchsuchen und aussichtslose Versuche aussortieren, um schneller Ergebnisse zu kriegen. Das Beste daran ist, dass es einfach parallelisiert und auf große Datensätze skaliert werden kann.

Wichtigste Features laut ihrem GitHub-Repository:

- Leichte, vielseitige und plattformunabhängige Architektur

- Pythoneske Suchräume

- Effiziente Optimierungsalgorithmen

- Einfache Parallelisierung

- Schnelle Visualisierung

⭐ GitHub-Sterne: 9,1K | Gesamtzahl der Downloads: 18 Millionen

Python-Bibliotheken für automatisiertes maschinelles Lernen (AutoML)

16. PyCaret

Diese mega beliebte Open-Source-Bibliothek für maschinelles Lernen macht Workflows für maschinelles Lernen in Python mit echt wenig Code automatisch. Es ist ein Tool für die Modellverwaltung und maschinelles Lernen, das den Versuchszyklus echt beschleunigen kann.

Im Vergleich zu anderen Open-Source-Bibliotheken für maschinelles Lernen bietet PyCaret eine Low-Code-Lösung, die Hunderte von Codezeilen durch nur wenige ersetzen kann. Das macht Experimente echt schnell und effizient.

PyCaret kann man im Moment unter der MIT-Lizenz nutzen. Wenn du mehr über PyCaret erfahren willst, kannst du dir die offizielle Doku oder das GitHub-Repository anschauen oder dieses Einführungs-Tutorial zu PyCaret durchgehen.

in PyCaret – Quelle

⭐ GitHub-Sterne: 8,1K | Gesamtzahl der Downloads: 3,9 Millionen

17. H2O

H2O ist eine Plattform für maschinelles Lernen und prädiktive Analysen, mit der man Modelle für maschinelles Lernen auf Big Data aufbauen kann. Außerdem macht es die einfache Produktion dieser Modelle in einer Unternehmensumgebung möglich.

Der Kerncode von H2O ist in Java geschrieben. Die Algorithmen nutzen das Java Fork/Join-Framework für Multithreading und laufen auf dem verteilten Map/Reduce-Framework von H2O.

H2O ist unter der Apache-Lizenz, Version 2.0, lizenziert und für die Sprachen Python, R und Java verfügbar. Mehr über H2O AutoML erfährst du in der offiziellen Dokumentation.

⭐ GitHub-Sterne: 10,6K | Gesamtzahl der Downloads: 15,1 Millionen

18. Auto-sklearn

Auto-sklearn ist ein Toolkit für automatisiertes maschinelles Lernen und ein guter Ersatz für ein scikit-learn-Modell. Es macht die Hyperparameter-Optimierung und Algorithmusauswahl automatisch, was den Leuten, die mit maschinellem Lernen arbeiten, echt viel Zeit spart. Das Design zeigt die neuesten Fortschritte beim Meta-Lernen, beim Aufbau von Ensembles und bei der Bayes'schen Optimierung.

Auto-sklearn ist als Add-on zu scikit-learn entwickelt worden und nutzt ein bayessches Optimierungsverfahren, um die leistungsstärkste Modellpipeline für einen bestimmten Datensatz zu finden.

Auto-sklearn ist echt einfach zu bedienen und kann sowohl für überwachte Klassifizierungs- als auch für Regressionsaufgaben genutzt werden.

import autosklearn.classification

cls = autosklearn.classification.AutoSklearnClassifier()

cls.fit(X_train, y_train)

predictions = cls.predict(X_test)Quelle: Beispiel aus der offiziellen Dokumentation von auto-sklearn.

Mehr über auto-sklearn erfährst du in ihrem GitHub-Repository.

⭐ GitHub-Sterne: 7,3K | Gesamtzahl der Downloads: 675K

19. FLAML

FLAML ist eine schlanke Python-Bibliothek, die automatisch genaue Modelle für maschinelles Lernen findet. Es sucht automatisch Lernende und Hyperparameter aus, was den Leuten, die sich mit maschinellem Lernen beschäftigen, viel Zeit und Mühe spart. Laut ihrem GitHub-Repository hat FLAML unter anderem diese Features:

- Bei Klassifizierungs- und Regressionsaufgaben kann FLAML schnell gute Modelle mit wenig Rechenaufwand finden.

- Es unterstützt sowohl tiefe neuronale Netze als auch klassische Modelle des maschinellen Lernens.

- Es ist einfach anzupassen oder zu erweitern.

- Es unterstützt schnelle automatische Abstimmung, kann mit komplizierten Einschränkungen umgehen und bietet die Möglichkeit des vorzeitigen Abbruchs.

Mit nur drei Zeilen Code kannst du mit dieser schnellen AutoML-Engine einen Schätzer im Stil von scikit-learn bekommen.

from flaml import AutoML

automl = AutoML()

automl.fit(X_train, y_train, task="classification")Quelle: Beispiel aus dem offiziellen GitHub-Repository

⭐ GitHub-Sterne: 3,5K | Gesamtzahl der Downloads: 456K

20. AutoGluon

Während andere AutoML-Bibliotheken auf Geschwindigkeit setzen, geht es bei AutoGluon (von Amazon entwickelt) um Robustheit und modernste Genauigkeit. Es ist bekannt für seine „Multi-Layer-Stack-Ensembling“-Strategie, mit der es oft besser abschneidet als von Menschen entwickelte Modelle bei tabellarischen Daten-Benchmarks.

Es unterstützt nicht nur tabellarische Daten, sondern auch multimodale Probleme. Das heißt, du kannst einen einzelnen Prädiktor auf einem Datensatz trainieren, der Spalten mit Text, Bildern und Zahlen gleichzeitig enthält, ohne dass du dich mit kompliziertem Feature Engineering beschäftigen musst.

Der folgende Codeausschnitt zeigt dir die AutoGluon-Syntax:

from autogluon.tabular import TabularPredictor

predictor = TabularPredictor(label='class').fit(train_data)

# AutoGluon automatically trains, tunes, and ensembles multiple models⭐ GitHub-Sterne: 10.000+ | Status: Top-Genauigkeit

Python-Bibliotheken für Deep Learning

21. TensorFlow

TensorFlow ist eine beliebte Open-Source-Bibliothek für leistungsstarke numerische Berechnungen, die vom Google Brain-Team bei Google entwickelt wurde und ein wichtiger Bestandteil im Bereich der Deep-Learning-Forschung ist.

Wie auf der offiziellen Website steht, ist TensorFlow eine durchgängige Open-Source-Plattform für maschinelles Lernen. Es bietet ein umfangreiches, vielseitiges Sortiment an Tools, Bibliotheken und Community-Ressourcen für Forscher und Entwickler im Bereich maschinelles Lernen.

Ein paar der Features von TensorFlow, die es zu einer beliebten und weit verbreiteten Deep-Learning-Bibliothek gemacht haben:

- Modelle lassen sich leicht entwickeln.

- Komplexe numerische Berechnungen sind auf skalierbare Weise möglich.

- TensorFlow hat viele APIs und bietet stabile Low-Level- und High-Level-APIs in Python und C.

- Einfache Bereitstellung und Berechnung mit CPU und GPU.

- Enthält vorab trainierte Modelle und Datensätze.

- Vortrainierte Modelle für Handys, eingebettete Geräte und die Produktion.

- Tensorboard, ein Tool, das das Visualisierungstoolkit von TensorFlow nutzt, um Experimente und Modelltrainings zu protokollieren und zu verfolgen.

- Kompatibel mit Keras – einer High-Level-API von TensorFlow.

Wenn du mehr über TensorFlow erfahren willst, schau dir den offiziellen Leitfaden oder das GitHub-Repository an oder probier es selbst aus, indem du diesem Schritt-für-Schritt -Tutorial zu TensorFlow folgst.

⭐ GitHub-Sterne: 180K | Gesamtzahl der Downloads: 384 Millionen

22. PyTorch

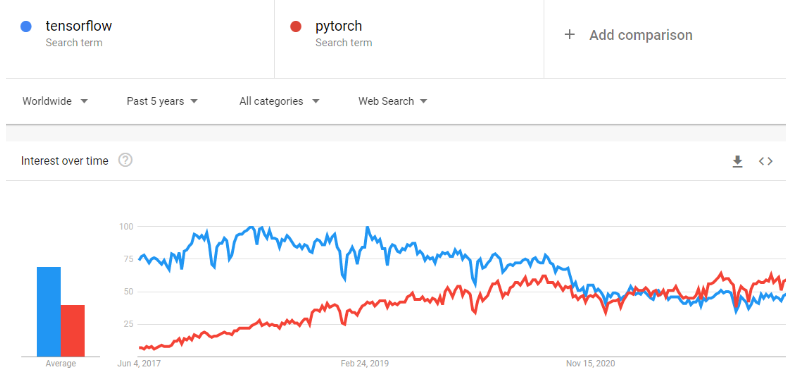

PyTorch ist ein Framework für maschinelles Lernen, das den Weg vom Forschungsprototyp bis zur Produktion echt beschleunigt. Es ist eine optimierte Tensor-Bibliothek für Deep Learning mit GPUs und CPUs und gilt als Alternative zu TensorFlow. Mit der Zeit ist PyTorch immer beliebter geworden und hat TensorFlow bei Google Trends überholt.

Es wurde von Facebook entwickelt und wird von Facebook gepflegt und ist im Moment unter BSD verfügbar.

Laut der offiziellen Website sind die wichtigsten Features von PyTorch:

- Es wechselt mit TorchScript nahtlos zwischen Eager- und Graph-Modus und beschleunigt mit TorchServe den Weg zur Produktion.

- Es bietet skalierbares verteiltes Training und Leistungsoptimierung in der Forschung, und die Produktion wird durch das Backend torch.distributed ermöglicht.

- Ein umfangreiches Ökosystem aus Tools und Bibliotheken erweitert PyTorch und hilft bei der Entwicklung in Bereichen wie Computer Vision, NLP und anderen.

- Umfassende Unterstützung auf den wichtigsten Cloud-Plattformen

⭐ GitHub-Sterne: 74K | Gesamtzahl der Downloads: 119 Millionen

23. FastAI

FastAI ist eine Deep-Learning-Bibliothek, die Leuten hochwertige Komponenten bietet, mit denen man ganz einfach top Ergebnisse erzielen kann. Es hat auch einfache Teile, die man austauschen kann, um neue Sachen zu entwickeln. Es soll beides schaffen, ohne dabei die Benutzerfreundlichkeit, Flexibilität oder Leistung großartig zu beeinträchtigen.

Eigenschaften:

- Ein Typdispatch-System für Python zusammen mit einer semantischen Typhierarchie für Tensoren.

- Eine GPU-optimierte Computer-Vision-Bibliothek, die mit reinem Python komplett erweiterbar ist.

- Ein Optimierer, der die gängigen Funktionen moderner Optimierer in zwei grundlegende Teile aufteilt, sodass Optimierungsalgorithmen in nur 4 bis 5 Zeilen Code umgesetzt werden können.

- Ein 2-Wege-Callback-System, das während des Trainings jederzeit auf alle Teile des Modells, der Daten oder des Optimierers zugreifen und diese ändern kann.

Mehr über das Projekt erfährst du in der offiziellen Dokumentation.

⭐ GitHub-Sterne: 25,1K | Gesamtzahl der Downloads: 6,1 Millionen

24. Keras

Keras ist eine Deep-Learning-API, die für Menschen und nicht für Maschinen entwickelt wurde. Keras hält sich an bewährte Methoden, um die kognitive Belastung zu reduzieren: Es bietet einheitliche und einfache APIs, minimiert die Anzahl der für gängige Anwendungsfälle erforderlichen Benutzeraktionen und liefert klare und umsetzbare Fehlermeldungen. Keras ist so einfach zu bedienen, dass TensorFlow es in der Version TF 2.0 als Standard-API übernommen hat.

Keras macht es einfacher, neuronale Netze zu beschreiben, und hat auch ein paar echt coole Tools für die Entwicklung von Modellen, die Verarbeitung von Datensätzen, die Visualisierung von Graphen und vieles mehr.

Eigenschaften:

- Es läuft sowohl auf der CPU als auch auf der GPU reibungslos.

- Es unterstützt fast alle Modelle neuronaler Netze, wie zum Beispiel Faltungs-, Einbettungs-, Pooling- und rekurrenten Netze usw. Diese Modelle kann man auch zusammenbauen, um komplexere Modelle zu machen.

- Keras ist modular aufgebaut und deshalb super ausdrucksstark, flexibel und perfekt für innovative Forschung.

- Es ist echt einfach zu debuggen und zu erkunden.

Wenn du mehr über Keras erfahren willst, schau dir die offizielle Dokumentation an oder mach diesen Einführungskurs: Deep Learning mit Keras.

⭐ GitHub-Sterne: 60,2K | Gesamtzahl der Downloads: 163 Millionen

25. PyTorch Lightning

PyTorch Lightning hat eine coole Schnittstelle für PyTorch. Sein leistungsstarkes und leichtes Framework kann PyTorch-Code so organisieren, dass die Forschung vom Engineering getrennt wird, wodurch Deep-Learning-Experimente einfacher zu verstehen und zu reproduzieren sind. Es wurde entwickelt, um skalierbare Deep-Learning-Modelle zu erstellen, die problemlos auf verteilter Hardware laufen.

Laut der offiziellen Website ist PyTorch Lightning so gemacht, dass du mehr Zeit mit Forschung und weniger mit Technik verbringen kannst. Mit einer schnellen Umgestaltung kannst du:

- Lass deinen Code auf jeder Hardware laufen.

- Leistung und Engpässe des Profils.

- Modell-Checkpointing.

- Hat eine Genauigkeit von 16 Bit.

- Mach ein verteiltes Training.

Mehr über diese Bibliothek erfährst du auf ihrer offiziellen Website.

⭐ GitHub-Sterne: 25,6K | Gesamtzahl der Downloads: 18,2 Millionen

26. JAX

JAX ist eine von Google entwickelte Hochleistungsbibliothek für numerische Berechnungen. Während PyTorch der benutzerfreundliche Standard ist, ist JAX das „Formel-1-Auto” für Forscher (einschließlich DeepMind), die extrem hohe Geschwindigkeit brauchen. Damit kann NumPy-Code automatisch kompiliert werden, um über XLA (Accelerated Linear Algebra) auf Beschleunigern (GPUs/TPUs) zu laufen.

Die Möglichkeit, native Python-Funktionen automatisch zu differenzieren, macht es super für die Entwicklung neuer Algorithmen von Grund auf, vor allem bei generativen Modellen und Physiksimulationen.

⭐ GitHub-Sterne: 35K+ | Status: Forschungsstandard

Python-Bibliotheken für die Verarbeitung natürlicher Sprache

27. spaCy

spaCy ist eine leistungsstarke Open-Source-Bibliothek für die Verarbeitung natürlicher Sprache in Python. spaCy ist super für große Aufgaben im Bereich der Informationsextraktion. Es wurde komplett in Cython geschrieben, das sorgfältig den Speicher verwaltet. spaCy ist die perfekte Bibliothek, wenn deine Anwendung riesige Web-Dumps verarbeiten muss.

Eigenschaften:

- spaCy kann sowohl CPU- als auch GPU-Verarbeitung.

- Unterstützt über 66 Sprachen

- Hat 73 trainierte Pipelines für 22 Sprachen

- Multitask-Lernen mit vortrainierten Transformatoren wie BERT

- Vortrainierte Wortvektoren

- Top-Geschwindigkeit

- Produktionsreifes Trainingssystem

- Komponenten für die Erkennung benannter Entitäten, Part-of-Speech-Tagging, Dependenzparsing, Satzsegmentierung, Textklassifizierung, Lemmatisierung, morphologische Analyse, Entitätsverknüpfung und mehr

- Unterstützung für benutzerdefinierte TensorFlow- und PyTorch-Modelle

- Integrierte Visualisierer für Syntax und NER

- Einfaches Modellieren, Bereitstellen und Verwalten von Workflows

Mehr über spaCy erfährst du auf der offiziellen Website oder im GitHub-Repository. Mit diesem praktischen spaCY-Spickzettel kannst du dich schnell mit den Funktionen vertraut machen.

⭐ GitHub-Sterne: 28K | Gesamtzahl der Downloads: 81 Millionen

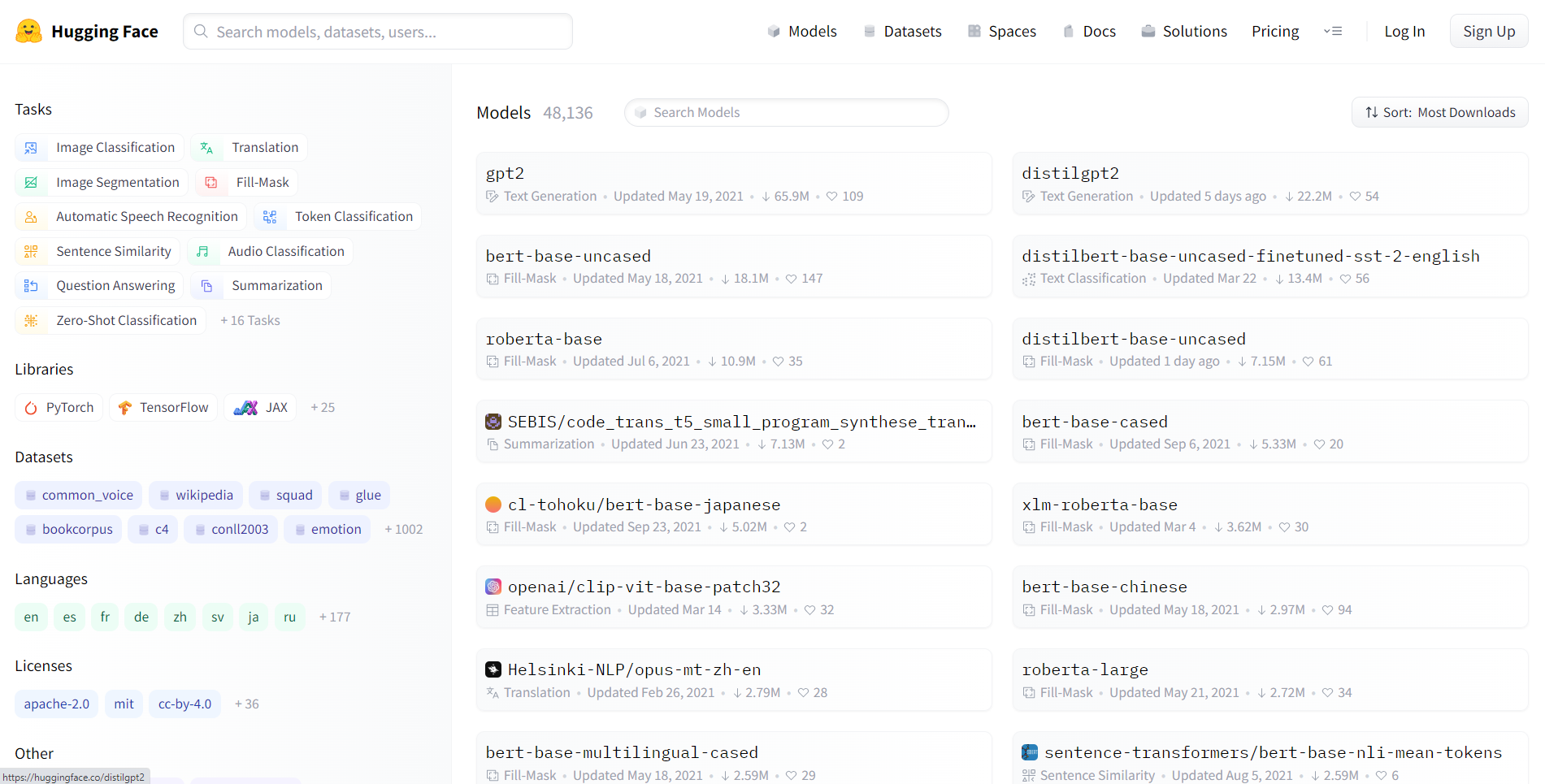

28. Hugging Face Transformatoren

Hugging Face Transformers ist eine Open-Source-Bibliothek von Hugging Face. Transformatoren machen es APIs einfach, moderne, vorab trainierte Modelle runterzuladen und zu trainieren. Mit vorab trainierten Modellen kannst du deine Rechenkosten und deinen CO2-Fußabdruck senken und sparst Zeit, weil du das Modell nicht von Grund auf neu trainieren musst. Die Modelle passen für viele verschiedene Sachen, zum Beispiel:

- Text: Texte sortieren, Infos raussuchen, Fragen beantworten, übersetzen, zusammenfassen und sogar Texte in über 100 Sprachen erstellen.

- Bilder: Bildklassifizierung, Objekterkennung und Segmentierung.

- Audio: Spracherkennung und Audioklassifizierung.

- Multimodal: Beantwortung von Fragen an Tabellen, optische Zeichenerkennung, Auslesen von Infos aus gescannten Dokumenten, Videoklassifizierung und visuelle Beantwortung von Fragen.

Die Transformers-Bibliothek macht die nahtlose Integration zwischen drei der beliebtesten Deep-Learning-Bibliotheken möglich: PyTorch, TensorFlow, and JAX. Du kannst dein Modell mit nur drei Zeilen Code in einem Framework trainieren und es dann in einem anderen Framework laden, um Schlussfolgerungen zu ziehen. Die Architektur jedes Transformators ist in einem eigenständigen Python-Modul definiert, sodass sie für Experimente und Forschungszwecke leicht anpassbar sind.

Die Bibliothek kann man jetzt unter der Apache-Lizenz 2.0 nutzen.

Wenn du mehr über Transformers erfahren willst, schau dir ihre offizielle Website oder das GitHub-Repository an und check unser Tutorial zur Verwendung von Transformers und Hugging Face aus.

⭐ GitHub-Sterne: 119K | Gesamtzahl der Downloads: 62 Millionen

29. LangChain

LangChain ist das Standard-Orchestrierungsframework für große Sprachmodelle (LLMs). Damit können Entwickler verschiedene Komponenten miteinander verbinden, zum Beispiel ein LLM (wie GPT 5.2) mit anderen Rechen- oder Wissensquellen.

Es macht die Arbeit mit Eingabeaufforderungen einfacher, sodass du ganz leicht „Agenten” erstellen kannst, die Tools (wie einen Taschenrechner, die Google-Suche oder eine Python-REPL) nutzen können, um Probleme mit mehreren Schritten zu lösen.

from langchain.chains import LLMChain

# Example: Creating a chain that takes user input and formats it

# before sending to an LLM

chain = prompt | llm | output_parser

result = chain.invoke({"topic": "Data Science"})⭐ GitHub-Sterne: 123K+ | Status: GenAI Essential

30. LlamaIndex

Während LangChain sich um das Schlussfolgern kümmert, macht sich LlamaIndex mit den Daten klar. Es ist das führende Framework für RAG (Retrieval-Augmented Generation). Es ist darauf spezialisiert, deine privaten Daten (PDFs, SQL-Datenbanken, Excel-Tabellen) zu erfassen, zu indexieren und abzurufen, damit LLMs Fragen dazu genau beantworten können.

Im Jahr 2025 ist „mit deinen Dokumenten chatten” ein ganz normaler Business-Anspruch, und LlamaIndex hat die Datenstrukturen drauf, die das effizient und ohne Probleme machen.

⭐ GitHub-Sterne: 35K+ | Status: RAG-Standard

31. ChromaDB

Damit LLMs sich Infos „merken“ können, brauchst du eine Vektordatenbank. ChromaDB ist die Open-Source-Vektordatenbank mit KI, die für Python-Entwickler zum Standard geworden ist. Es kümmert sich um die ganze Sache mit dem Einbetten von Text (also das Umwandeln von Wörtern in Zahlenlisten) und speichert sie für die semantische Suche.

Anders als bei herkömmlichen SQL-Datenbanken, die nach exakten Schlüsselwörtern suchen, kannst du mit ChromaDB nach Bedeutung suchen. Das macht es zum Langzeitgedächtnis-Backend für moderne KI-Anwendungen.

⭐ GitHub-Sterne: 25K+ | Status: Vektor-Speicher-Standard

Die beste Python-Bibliothek auswählen

Die richtige Python-Bibliothek für deine Aufgaben in den Bereichen Data Science, maschinelles Lernen oder natürliche Sprachverarbeitung auszuwählen, ist echt wichtig und kann den Erfolg deiner Projekte stark beeinflussen. Bei der großen Auswahl an Bibliotheken ist es wichtig, verschiedene Faktoren zu bedenken, um eine gute Entscheidung zu treffen. Hier sind ein paar wichtige Punkte, die dir helfen sollen:

1. Projektanforderungen

- Sag mir, was du erreichen willst: Mach dir klar, was du mit deinem Projekt erreichen willst. Finde raus, welche Aufgaben dein Projekt genau mit sich bringt, wie zum Beispiel Datenbearbeitung, Visualisierung, maschinelles Lernen oder Verarbeitung natürlicher Sprache.

- Verstehe den Umfang: Überleg dir, wie groß dein Projekt ist. Manche Bibliotheken sind in bestimmten Bereichen echt gut, deshalb ist es wichtig, dass du deine Bedürfnisse mit den Stärken einer Bibliothek abgleichst.

2. Einfach zu bedienen und leicht zu lernen

- Einfach zu bedienende Oberflächen: Schau dir mal an, wie einfach die einzelnen Bibliotheken zu benutzen sind. Bibliotheken mit einfachen APIs, einer umfangreichen Dokumentation und einer hilfsbereiten Community können den Entwicklungsprozess echt vereinfachen.

- Lernmaterialien: Schau mal, ob es für jede Bibliothek Tutorials, Kurse und Community-Foren gibt. Bibliotheken mit vielen Lernmaterialien können das Lernen echt beschleunigen.

3. Unterstützung durch die Gemeinschaft

- Aktive Community: Eine lebendige und aktive Gemeinschaft ist ein Zeichen für eine gesunde und gut gepflegte Bibliothek. Schau dir mal die Anzahl der Mitwirkenden, die Häufigkeit der Updates und wie schnell auf Fragen der Community reagiert wird an.

- GitHub-Aktivität: Schau mal in den GitHub-Repositorys nach den neuesten Commits, Problemen und Diskussionen. Ein aktives GitHub-Repository zeigt oft, dass die Entwicklung weitergeht und die Community aktiv dabei ist.

4. Leistung und Skalierbarkeit

- Skalierbarkeit: Denk mal über die Skalierbarkeit der Bibliothek nach, um große Datensätze oder komplizierte Berechnungen zu verarbeiten. Einige Bibliotheken sind auf Leistung optimiert und können mit wachsenden Datenmengen effizient skaliert werden.

5. Integration in das Ökosystem

- Kompatibilität: Stell sicher, dass die gewählte Bibliothek nahtlos in deine bestehende Technologieplattform integriert werden kann. Die Kompatibilität mit anderen Bibliotheken, Frameworks oder Tools, die du nutzen willst, ist super wichtig für einen reibungslosen Arbeitsablauf.

6. Lizenz und rechtliche Sachen

- Lizenzierung: Verstehe die Lizenzbedingungen jeder Bibliothek. Stell sicher, dass die Lizenz zu den Anforderungen deines Projekts und den rechtlichen Überlegungen deiner Organisation passt.

7. Feedback und Ruf der Community

- Bewertungen und Erfahrungsberichte: Such nach Bewertungen und Erfahrungsberichten von anderen Entwicklern und Datenwissenschaftlern, die die Bibliotheken schon benutzt haben. Dieses Feedback aus erster Hand kann Einblicke in die praktische Nutzung der Bibliotheken geben.

8. Laufende Wartung und Updates

- Letzte Aktualisierungen: Schau mal, wann die Bibliothek das letzte Mal aktualisiert wurde. Regelmäßige Updates zeigen, dass ständig gepflegt und verbessert wird. Vermeide Bibliotheken, die nicht mehr regelmäßig aktualisiert werden.

9. Leistungsbenchmarks

- Benchmarking: Schau dir die Leistungsbenchmarks für die Bibliotheken an, vor allem, wenn die Leistung für dein Projekt echt wichtig ist. Benchmarks können dir helfen, die Geschwindigkeit und Effizienz verschiedener Bibliotheken zu vergleichen.

10. Überlegungen zu zukünftigen Entwicklungen

- Roadmap: Schau dir mal die Roadmap oder die Pläne für die zukünftige Entwicklung jeder Bibliothek an. Wenn du eine Bibliothek mit einer klaren Vision für zukünftige Verbesserungen wählst, ist die langfristige Unterstützung deiner Projekte gesichert.

Wenn du diese Faktoren genau checkst, kannst du eine gute Entscheidung treffen, wenn du Python-Bibliotheken für deine Data-Science- oder Machine-Learning-Projekte suchst. Denk dran, dass die beste Bibliothek für dein Projekt von den spezifischen Anforderungen und Zielen abhängt, die du erreichen willst.

Um deine Karriere im Bereich Data Science zu starten, mach den Lernpfad „Data Scientist in Python “.