programa

Inteligencia artificial generativa (también conocida como IA generativa o GenAI) es una subcategoría de la IA que se centra en la creación de nuevos contenidos, como texto, imágenes o vídeos, utilizando diversas tecnologías de IA.

A medida que avanza la GenAI, se extiende a muchos otros campos tecnológicos, como el desarrollo de software. Un amplio conocimiento de sus fundamentos seguirá siendo cada vez más relevante en estos campos.

Para puestos como científicos de datoso profesionales del machine learninge ingenieros de IA, la IA generativa es un tema fundamental que hay que dominar.

Aquí tienes 30 preguntas sobre GenAI que te podrían hacer durante una entrevista.

Obtén una certificación superior en IA

Preguntas básicas para entrevistas sobre IA generativa

Comencemos con algunas preguntas básicas para entrevistas sobre IA generativa. Estas pruebas evaluarán tu comprensión de los conceptos y principios fundamentales.

¿Cuáles son las diferencias clave entre los modelos discriminativos y generativos?

Los modelos discriminativos aprenden la frontera de decisión entre clases y los patrones que las diferencian. Estiman la probabilidad P(y|x), que es la probabilidad de una etiqueta concreta y, dados los datos de entrada x. Estos modelos se centran en distinguir entre diferentes categorías (por ejemplo,«¿Es este correo electrónico spam?»).

Los modelos generativos aprenden la distribución de los datos mismos mediante el modelado de la probabilidad conjunta P(x,y), lo que implica el muestreo de puntos de datos de esta distribución. Tras ser entrenado con miles de imágenes de dígitos, este muestreo podría producir una nueva imagen de un dígito.

Más información en este blog sobre « » ( Modelos generativos frente a discriminativos): Diferencias y casos de uso.

¿Qué son los tokens y las incrustaciones en el contexto de los modelos de lenguaje grandes (LLM)?

Los tokens son las unidades fundamentales de texto que procesa un LLM; pueden ser palabras completas, sílabas o incluso letras individuales (por ejemplo, la palabra «generative» podría dividirse en «gener», «at» e «ive»).

Las incrustaciones son representaciones vectoriales numéricas de esos tokens que los sitúan en un espacio multidimensional basado en su significado. Esta conversión permite al modelo captar el significado semántico y comprender las relaciones entre las palabras, por ejemplo, reconociendo que «rey» está relacionado con «reina».

¿Podrías explicar los principios básicos que subyacen a las redes generativas adversarias (GAN)?

Las GAN están formadas por dos redes neuronales que compiten entre sí (de ahí el término «adversarial», que significa «adversario»): un generador y un discriminador.

El generador crea muestras de datos falsos, mientras que el discriminador los evalúa comparándolos con los datos de entrenamiento reales. Las dos redes se entrenan simultáneamente:

- El generador tiene como objetivo producir imágenes tan indistinguibles de los datos reales que el discriminador no pueda notar la diferencia.

- El discriminador tiene como objetivo identificar con precisión si una imagen determinada es real o generada.

A través de este aprendizaje competitivo, el generador adquiere destreza en la producción de datos muy realistas que son similares a los datos de entrenamiento.

¿Cuáles son algunas aplicaciones populares de la IA generativa en el mundo real?

- Generación de texto: Se utiliza en chatbots, creación de contenidos o traducción (chatGPT, Claude, Gemini).

- Generación de imágenes: Producción de imágenes realistas para arte o diseño (por ejemplo, chatGPT Images, Nano Banana Pro, Stable Diffusion).

- Agentes de codificación: Escribir módulos de código completos, utilizados en ingeniería de software.

- Generación aumentada por recuperación (RAG): Recuperación de conocimientos empresariales, utilizada en el servicio de atención al cliente o para wikis internos.

- Descubrimiento de fármacos: Diseño de nuevas estructuras moleculares para medicamentos.

- Aumento de datos: Ampliación de conjuntos de datos de bajo volumen para machine learning.

¿Cuáles son algunos de los retos asociados con el entrenamiento y la evaluación de modelos de IA generativa?

- Coste computacional: Alta potencia computacional y requisitos de hardware para entrenar modelos más complejos.

- Complejidad de la formación: El entrenamiento de modelos generativos puede ser complicado y estar lleno de matices.

- Métricas de evaluación: Es difícil evaluar cuantitativamente la calidad y la diversidad de los resultados del modelo.

- Requisitos de datos: Los modelos generativos suelen requerir grandes cantidades de datos de alta calidad y diversidad. La recopilación de esos datos podría llevar mucho tiempo y resultar costosa.

- Sesgo y equidad: Los modelos sin verificar pueden amplificar los sesgos presentes en los datos de entrenamiento, lo que da lugar a resultados injustos.

¿Cuáles son algunas consideraciones éticas relacionadas con el uso de la IA generativa?

El uso generalizado de la GenAI y sus casos de aplicación requieren una evaluación exhaustiva de su rendimiento en términos de ética. Algunos ejemplos son:

- Deepfakes: La creación de medios falsos pero hiperrealistas puede difundir información errónea o difamar a personas.

- Generación sesgada: Amplificación de los sesgos históricos y sociales en los datos de entrenamiento.

- Propiedad intelectual: Uso no autorizado de material protegido por derechos de autor en los datos.

¿Cómo se puede utilizar la IA generativa para aumentar o mejorar la creatividad humana?

Aunque las alucinaciones de los modelos de IA pueden producir resultados erróneos, estos modelos generativos son útiles en muchos aspectos y usos. Pueden servir de inspiración creativa a los expertos en diversos campos:

- Arte y diseño: Inspiración en arte y diseño.

- Asistencia en la redacción: Sugerir títulos e ideas para escribir o completar textos.

- Música: Componer ritmos y armonías.

- Programación: Optimizar el código existente u ofrecer formas de abordar un problema de implementación.

¿Cuál es la diferencia entre un modelo base y un modelo ajustado?

Un modelo base (como GPT-5.2) se entrena con grandes cantidades de datos generales de Internet para aprender patrones generales, razonamiento y estructura lingüística.

Un modelo ajustado toma esta base generalista y lo entrena aún más en un conjunto de datos más pequeño y seleccionado para dominar una tarea específica, como el diagnóstico médico o hablar en un lenguaje de programación específico. El perfeccionamiento cambia la versatilidad general por una mayor especialización en un campo específico.

Preguntas de entrevista sobre IA generativa de nivel intermedio

Ahora que ya hemos cubierto los conceptos básicos, exploremos algunas preguntas intermedias sobre IA generativa para entrevistas.

¿Qué es el «colapso modal» en las GAN y cómo se aborda?

Al igual que un creador de contenido que descubre que un determinado formato de vídeo genera más alcance e interacciones, el modelo generativo de una GAN podría fijarse en una diversidad limitada de resultados que engañan al modelo discriminador. Esto hace que el generador produzca un conjunto reducido de resultados, lo que merma la diversidad y la flexibilidad de los datos generados.

Las posibles soluciones a este problema podrían centrarse en técnicas de entrenamiento mediante el ajuste de los hiperparámetros y diversos algoritmos de optimización, la aplicación de regularizaciones que promuevan la diversidad o la combinación de múltiples generadores para cubrir diferentes modos de generación de datos.

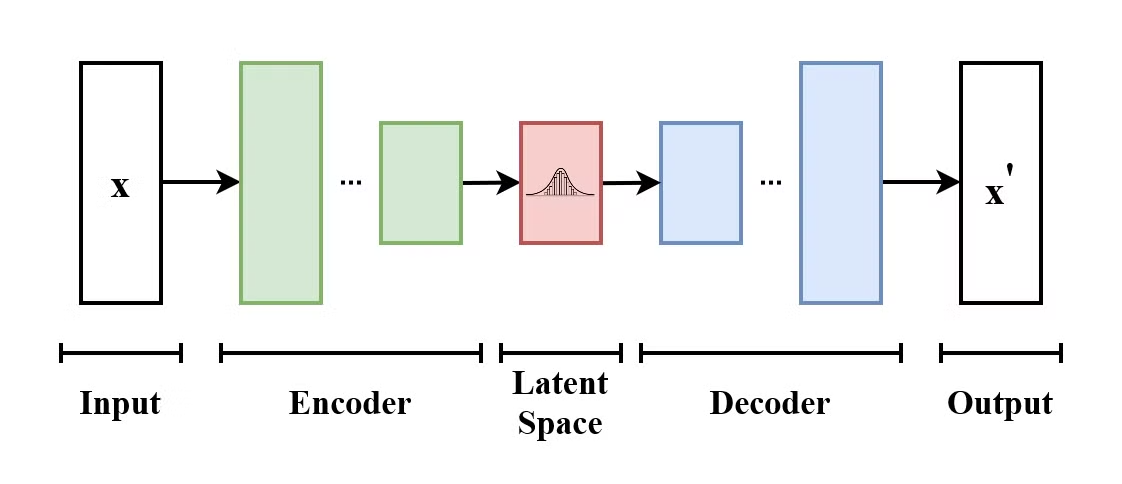

¿Cómo funciona un autoencoder variacional (VAE)?

Un autocodificador variacional (VAE) es un tipo de modelo generativo que aprende a codificar datos de entrada en un espacio latente y a descodificarlos para reconstruir los datos de entrada originales. Los VAE son modelos codificador-decodificador:

- El codificador mapea los datos de entrada a una distribución sobre el espacio latente.

- El decodificador muestras de esta distribución del espacio latente reconstruyen los datos de entrada.

La estructura de un autoencoder variacional. (Fuente: Wikimedia Commons)

Lo que diferencia a los VAE de los autoencoders tradicionales es que los VAE fomentan que el espacio latente siga una distribución conocida (como la gaussiana). Esto los hace más útiles para generar nuevos datos mediante el muestreo de este espacio latente.

Explica la diferencia entre la generación aumentada por recuperación (RAG) y el ajuste fino. ¿Cuándo usarías uno en lugar del otro?

RAG ( ) conecta un modelo con fuentes de datos externas (como la wiki de tu empresa) para obtener información actualizada sin necesidad de volver a entrenar el modelo. Los parámetros del modelo siguen siendo los mismos; solo que ahora tiene acceso a datos adicionales.

El ajuste fino modifica los pesos internos del modelo para cambiar la forma en que habla, se comporta o razona, pero no es adecuado para añadir nuevos conocimientos fácticos.

Utiliza RAG cuando necesites datos actualizados (noticias, datos de empresas privadas) o una cita específica. Utiliza el ajuste fino cuando necesites que el modelo aprenda un nuevo «comportamiento», idioma o formato de salida específico (por ejemplo, hablar en código SQL).

¿Cómo evaluarías una solicitud de máster en Derecho? Explica qué es «LLM como juez».

La evaluación de las muestras generadas es una tarea compleja que depende de la modalidad de los datos (imagen, texto, vídeo, etc.). TTexto tradicional métricas, como la precisión, son insuficientes para tareas creativas porque solo comprueban la superposición de palabras, no el significado.

Los puntos de referencia y las tablas de clasificación de LLM utilizan pruebas estandarizadas para medir la eficacia con la que un modelo realiza una tarea determinada. Son útiles para comparar modelos y realizar un programa del progreso dentro de una misma modalidad o entre diferentes modalidades.

LLM-as-a-Judge es un marco de evaluación moderno en el que un modelo «profesor» altamente capacitado (como Gemini 3) califica los resultados de un modelo más pequeño basándose en criterios específicos, como la fidelidad, la utilidad y el tono. Esto proporciona una forma escalable de aproximarse a las preferencias humanas sin la lentitud y el coste que supone la revisión manual por parte de personas.

¿Cuáles son algunas técnicas para mejorar la estabilidad y la convergencia del entrenamiento de GAN?

Mejorar la estabilidad y la convergencia del entrenamiento de las GAN es importante para evitar el colapso modal, garantizar un entrenamiento eficiente y obtener buenos resultados. A continuación, se describen algunas técnicas para mejorar la estabilidad y la convergencia del entrenamiento de GAN:

- Wasserstein GAN (WGAN): Utiliza la distancia de Wasserstein como función de pérdida, lo que mejora la estabilidad del entrenamiento y proporciona gradientes más suaves.

- Regla de actualización de doble escala temporal (TTUR): Usando tasas de aprendizaje separadas para el generador y el discriminador.

- Suavizado de etiquetas: Suaviza las etiquetas para evitar el exceso de confianza.

- Tasas de aprendizaje adaptativo: Uso de optimizadores como Adam para ayudar a gestionar la tasa de aprendizaje de forma dinámica.

- Penalización por gradiente: Penaliza los grandes gradientes en el discriminador para imponer una continuidadLipschitz e e y lograr un entrenamiento más estable.

¿Cómo puedes controlar el estilo o los atributos del contenido generado utilizando modelos de IA generativa?

Existen varias técnicas comunes para controlar el estilo de los resultados de GenAI:

- Ingeniería rápida: Especifica el estilo de salida deseado proporcionando indicaciones detalladas que destaquen el estilo o el tono de la generación de contenido. Este es un método eficaz y sencillo tanto en modelos de texto a texto como de texto a imagen. Es un método mucho más eficaz si se hace de acuerdo con los requisitos específicos o la documentación del modelo concreto en cuestión.

- Control de temperatura y muestreo: El parámetro«temperatura» ( ) de « » controla el grado de aleatoriedad de los resultados. Las temperaturas más bajas implican una selección de tokens más conservadora y predecible, mientras que las temperaturas más altas permiten una generación más creativa. Otros parámetros, como top-k y top-p, también pueden controlar la creatividad con la que el modelo selecciona los posibles tokens siguientes durante la generación.

- Resultados estructurados: En cuanto a la estructura, los modelos modernos utilizan el «modo JSON» o «salidas estructuradas», que limitan el modelo para que genere estrictamente esquemas JSON o XML válidos en lugar de texto libre.

- Mensajes del sistema: Las indicaciones del sistema se envían junto con cada nuevo mensaje al modelo. Se pueden utilizar para establecerinstrucciones de comportamiento persistentes que anulan las entradas del usuario para mantener personalidades o reglas específicas.

- Transferencia de estilo (imágenes): Otra técnica que se puede utilizar durante la inferencia para los modelos compatibles es aplicar el estilo de una imagen (imagen de referencia) a una imagen de entrada.

- Ajuste fino: Podemos utilizar un modelo preentrenado y ajustarlo a un conjunto de datos específico que contenga el estilo o tono deseado. Esto significa entrenar el modelo con datos adicionales para que aprenda estilos o atributos específicos adicionales.

- Aprendizaje por refuerzo: Podemos guiar al modelo para que prefiera determinados resultados y se aleje de otros proporcionándole información. Esta información se utilizará para modificar el modelo mediante el aprendizaje por refuerzo. Con el tiempo, el modelo se ajustará a las preferencias de los usuarios y/o a los conjuntos de datos de preferencias. Un ejemplo de esto, en el contexto de los LLM, es el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF).

¿De qué maneras se puede abordar el problema del sesgo en los modelos de IA generativa?

Para garantizar que el modelo sea imparcial y justo, es necesario realizar ajustes iterativos y supervisar cada fase.

En primer lugar, es necesario evitar la contaminación de los datos asegurándote de que ningún dato de prueba se filtre en los datos de entrenamiento. En ese caso, el modelo se entrenaría para memorizar los datos en lugar de generalizarlos.

Además, debemos asegurarnos de que los datos de entrenamiento sean lo más diversos e inclusivos posible. Durante el entrenamiento, podemos orientar el modelo hacia una generación más justa incorporando objetivos de equidad en la función de pérdida.

Los resultados del modelo deben supervisarse periódicamente para detectar posibles sesgos. Para generar confianza en el público, es útil que el proceso de toma de decisiones del modelo, los detalles del conjunto de datos y los pasos de preprocesamiento sean lo más transparentes posible.

¿Podrías explicar el concepto de «espacio latente» en los modelos generativos y su importancia?

En el contexto de los modelos generativos, el espacio latente es un espacio de menor dimensión que captura las características esenciales de los datos de tal manera que las entradas similares se mapean más cerca unas de otras. El muestreo de este espacio latente permite a los modelos generar nuevos datos y manipular atributos o características específicos (generando variaciones de imágenes).

Los espacios latentes son fundamentales para generar resultados controlables, fieles a los datos de entrenamiento y diversos.

¿Cuál es el papel del aprendizaje auto-supervisado en el desarrollo de modelos de IA generativa?

La idea clave detrás del aprendizaje auto-supervisado es aprovechar un vasto corpus de datos sin etiquetar para aprender representaciones útiles sin necesidad de etiquetado manual. Modelos como BERT y GPT se entrenan mediante métodos auto-supervisados, como la predicción del siguiente token y el aprendizaje de la estructura y la semántica de los idiomas. Esto reduce la dependencia de los datos etiquetados, cuya obtención resulta costosa y lleva mucho tiempo, lo que permite a los modelos aprovechar grandes conjuntos de datos sin etiquetar para el entrenamiento.

¿Qué es la adaptación de rango bajo (LoRA)?

Reentrenar un modelo masivo de 70 000 millones de parámetros resulta prohibitivamente caro y lento para la mayoría de las organizaciones. La adaptación de rango bajo (LoRA) resuelve este problema congelando los pesos del modelo principal y entrenando únicamente una pequeña capa «adaptadora» (a menudo menos del 1 % del total de parámetros) que se sitúa en la parte superior. Esto te permite ofrecer docenas de modelos «personalizados» diferentes a partir de un único modelo base, lo que reduce drásticamente el coste computacional y las necesidades de almacenamiento.

Preguntas avanzadas sobre IA generativa para entrevistas

Para aquellos que buscan puestos de mayor responsabilidad o que desean demostrar un profundo conocimiento de la IA generativa, veamos algunas preguntas avanzadas para entrevistas.

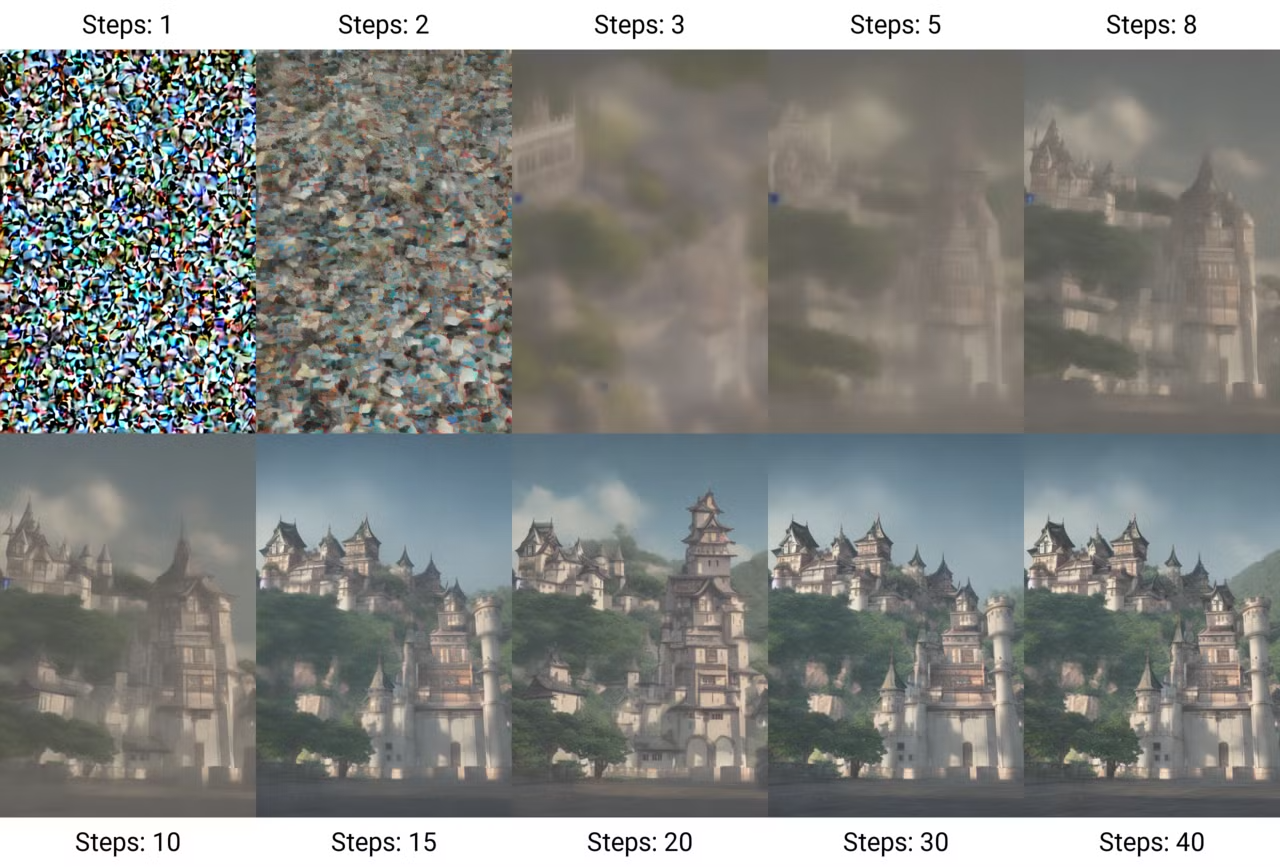

Explica el concepto de «modelos de difusión» y en qué se diferencian de las arquitecturas más antiguas.

Los modelos de difusión funcionan principalmente añadiendo ruido gradualmente a una imagen hasta que solo queda ruido, y luego aprendiendo a invertir este proceso para generar nuevas muestras a partir del ruido. Este proceso se denominadifusión e e. Estos modelos han ganado popularidad por su capacidad para generar imágenes de alta calidad y gran detalle.

Generación de una imagen mediante pasos de difusión. (Fuente: Wikimedia Commons)

El proceso de entrenamiento de estos modelos incluye dos pasos:

- El proceso de avance (difusión): Tomar una imagen de entrada y añadir ruido progresivamente en varios pasos, hasta que los datos se transformen en ruido puro.

- El proceso inverso (eliminación de ruido): Aprender a recuperar los datos originales a partir del ruido. Esto se consigue entrenando una red neuronal para que prediga cuál es el ruido y, a continuación, eliminando el ruido de la imagen paso a paso hasta recuperar los datos originales.

A diferencia de las GAN más antiguas, que a menudo adolecían de inestabilidad en el entrenamiento, los modelos de difusión son más estables y escalables, aunque pueden ser más lentos debido a su naturaleza iterativa.

Las variantes modernas, como la difusión latente, operan en un «espacio latente» comprimido para acelerar la generación, y las arquitecturas de coincidencia de flujos están sustituyendo ahora a la difusión estándar para obtener un rendimiento aún mejor.

¿Cómo funciona la arquitectura Transformer y cuál es su principal cuello de botella?

La arquitectura del transformador presentada en el artículo «Attention is All You Need», ha revolucionado el campo de la IA generativa, especialmente en el procesamiento del lenguaje natural (NLP).

A diferencia de las redes neuronales recurrentes (RNN) tradicionales, que procesan los datos de forma secuencial, los transformadores utilizan el mecanismo de autoatención para atribuir pesos a diferentes partes de los datos de entrada simultáneamente. Esto permite que el modelo capte eficazmente las relaciones contextuales y permite el procesamiento paralelo de secuencias, lo que acelera considerablemente el entrenamiento.

El principal obstáculo es que este mecanismo de atención se escala cuadráticamente con la longitud de la secuencia: duplicar la ventana de contexto requiere cuatro veces más capacidad de cálculo. Esto hace que el «contexto infinito» sea teóricamente posible, pero computacionalmente costoso, lo que impulsa la investigación hacia métodos de atención más eficientes.

¿Qué es un «modelo de razonamiento» (pensamiento del sistema 2) y en qué se diferencia de un LLM estándar?

Los LLM estándar actúan como pensadores del «Sistema 1», prediciendo la siguiente palabra inmediatamente basándose en patrones superficiales.

Los modelos de razonamiento (como Gemini 3 o DeepSeek-R1) están entrenados para generar una «cadena de pensamiento» oculta antes de dar una respuesta, lo que les permite «pensar», planificar y autocorregir errores. Esto los hace significativamente mejores en matemáticas complejas, codificación y rompecabezas lógicos, aunque son más lentos y más caros de ejecutar.

¿Podrías hablar sobre los retos que plantea la generación de contenido de alta resolución o de formato largo utilizando IA generativa?

A medida que aumentas la complejidad de la generación de IA, también debes abordar:

- Coste computacional: Las salidas de alta resolución requieren redes más grandes y mayor potencia computacional.

- Entrenamiento con múltiples GPU: Es posible que los modelos más grandes no quepan en una sola GPU, por lo que se requerirá un entrenamiento con múltiples GPU. Las plataformas en línea pueden mitigar la complejidad de implementar dichos sistemas.

- Estabilidad en el entrenamiento: Las redes más grandes y las arquitecturas más complejas hacen que sea más difícil mantener un procedimiento de entrenamiento estable.

- Calidad de los datos: Una mayor resolución y un contenido más extenso requieren datos de mayor calidad.

¿Cuáles son algunas de las tendencias emergentes y las líneas de investigación en el campo de la IA generativa?

El campo de la GenAI está evolucionando y transformándose a un ritmo vertiginoso. Esto incluye:

- Modelos multimodales: Integración de múltiples formatos de datos, como texto, audio e imágenes.

- Modelos lingüísticos pequeños (SLM): A diferencia de los grandes modelos lingüísticos, los SLM están ganando terreno gracias a su eficiencia y adaptabilidad. Estos modelos requieren menos recursos computacionales, lo que los hace adecuados para su implementación en entornos con capacidades limitadas. Para obtener más información, lee este blog sobre IA periférica.

- IA ética: Desarrollo de marcos para garantizar el rendimiento alineado de los modelos generativos.

- Modelos generativos para vídeo: Avances en la generación de vídeos ultrarrealistas y coherentes mediante GenAI. Los ejemplos más recientes incluyen Sora AI, Meta Movie Geny Runway Act-One.

¿Cómo diseñarías un sistema para utilizar la IA generativa con el fin de crear contenido personalizado en un sector específico, como el de la asistencia sanitaria?

Diseñar un sistema que utilice IA generativa para casos de uso específicos de la industria es un enfoque exhaustivo. Las directrices generales también pueden adaptarse y modificarse para otros sectores.

- Comprender las necesidades del sector: El conocimiento del dominio de una industria tiene un efecto importante en las decisiones que conducen al diseño de un sistema de este tipo. El primer paso es adquirir conocimientos generales y prácticos sobre el sector, los fundamentos, los conceptos, los objetivos y los requisitos.

- Recopilación y gestión de datos: Identifica posibles proveedores de datos. En el ámbito sanitario, esto implica recopilar datos de los proveedores de servicios sanitarios sobre los detalles del tratamiento, la información de los pacientes, las directrices médicas, etc. Deben identificarse y respetarse las barreras de protección específicas del sector de Data Privacy and Security. Asegúrate de que los datos sean de alta calidad, precisos, actualizados y representativos de los diversos grupos.

- Selección del modelo: Decide si quieres ajustar los modelos preentrenados o crear tus propias arquitecturas desde cero. Dependiendo del tipo de proyecto, los modelos óptimos de IA generativa pueden variar. Un modelo como GPT-4o podría ser una buena opción plug-and-play. Algunos dominios pueden requerir modelos alojados localmente por motivos de privacidad. En este caso, los modelos de código abierto son la mejor opción. Considera la posibilidad de ajustar estos modelos con los datos específicos del sector que hayas recopilado anteriormente.

- Validación de salida: Implementar un proceso de evaluación exhaustivo en el que los expertos y profesionales validen el contenido generado antes de ponerlo en práctica.

- Escalabilidad: Diseña una infraestructura escalable basada en la nube para gestionar las cargas necesarias sin afectar al rendimiento.

- Consideraciones legales y éticas: Establece directrices éticas claras para el uso de la IA y comunica de forma transparente las posibles limitaciones de tu modelo. Respetar los derechos de propiedad intelectual y abordar cualquier cuestión relacionada con ellos.

- Mejora continua: Revisa periódicamente el rendimiento del sistema y la evaluación de los expertos sobre el contenido generado. Recopila más información y datos para modificar el modelo y mejorarlo.

Explica el concepto de «aprendizaje en contexto» en el contexto de los LLM.

El aprendizaje en contexto se refiere a la capacidad de los LLM para modificar su estilo y resultados en función del contexto proporcionado sin necesidad de un ajuste adicional.

También se podría denominar aprendizaje con pocos ejemplos o ingeniería de prompts. Esto podría lograrse especificando uno o varios ejemplos de la respuesta deseada o describiendo claramente cómo debe comportarse el modelo.

El aprendizaje en contexto también tiene sus limitaciones. Es a corto plazo y específico para cada tarea, ya que el modelo no retiene realmente ningún conocimiento en otras sesiones en las que se utiliza esta técnica.

Además, si el resultado requerido es complejo, es posible que el modelo necesite un gran número de ejemplos. Si los ejemplos proporcionados no son lo suficientemente claros o la tarea es más difícil de lo que el modelo puede manejar, a veces puede generar resultados incorrectos o incoherentes.

¿Cómo se pueden diseñar estratégicamente las indicaciones para obtener los comportamientos o resultados deseados del modelo? ¿Cuáles son algunas de las mejores prácticas para una ingeniería eficaz?

Las indicaciones son importantes para dirigir a los LLM a responder a tareas específicas. Las indicaciones eficaces pueden incluso mitigar la necesidad de ajustar los modelos mediante el uso de técnicas como el aprendizaje con pocos ejemplos, la descomposición de tareas y las plantillas de indicaciones.

Algunas mejores prácticas para una ingeniería eficaz y rápida incluyen:

- Sé claro y conciso: Proporciona instrucciones específicas para que el modelo sepa exactamente qué tarea quieres que realice. Sé directo y ve al grano.

- Ejemplos de uso: Para el aprendizaje en contexto, mostrar algunos pares de entrada-salida ayuda al modelo a comprender la tarea tal y como tú deseas.

- Desglosa las tareas complejas: Si la tarea es complicada, dividirla en pasos más pequeños puede mejorar la calidad de la respuesta.

- Establece restricciones o formatos: Si necesitas un estilo, formato o longitud específicos para el resultado, indica claramente esos requisitos en la solicitud.

Lee más en este blog sobre Técnicas de optimización rápida.

¿Cuáles son algunas técnicas para optimizar la velocidad de inferencia de los modelos de IA generativa?

- Poda del modelo: Eliminación de pesos/capas innecesarios para reducir el tamaño del modelo.

- Cuantización: Reducción de la precisión de los pesos del modelo a fp16/int8.

- Destilación del conocimiento: Entrenar un modelo más pequeño para que imite a uno más grande.

- Aceleración por GPU: Uso de hardware especializado.

¿Podrías explicar el concepto de «generación condicional» y cómo se aplica en modelos como las GAN condicionales (cGAN)?

La generación condicional implica que el modelo genere resultados basados en determinadas condiciones o contextos. Esto permite un mayor control sobre el contenido generado. En las GAN condicionales (cGAN), tanto el generador como el discriminador están condicionados por información adicional, como las etiquetas de clase. Así es como funciona:

- Generator: Recibe tanto ruido como información condicional (por ejemplo, una etiqueta de clase) para producir datos que se ajusten a la condición.

- Discriminador: Evalúa la autenticidad de los datos generados, teniendo en cuenta también la información condicional.

¿Podrías explicar la arquitectura Mixture of Experts (MoE)? ¿Por qué se prefiere para modelos grandes?

La mezcla de expertos (MoE) sustituye una única red neuronal densa por muchas subredes «expertas» especializadas. Para cualquier token dado, un enrutador selecciona solo a los expertos más relevantes para procesar los datos, lo que significa que un modelo puede tener 100 000 millones de parámetros, pero solo utilizar 10 000 millones para la inferencia.

Esta arquitectura permite que los modelos sean increíblemente inteligentes (alto número total de parámetros) y, al mismo tiempo, rápidos y económicos de ejecutar (bajo número de parámetros activos).

Preguntas de entrevista sobre IA generativa para un ingeniero de IA

Si estás realizando una entrevista para un puesto de ingeniero de IA centrado en la IA generativa, prepárate para responder preguntas que evalúen tu capacidad para diseñar, implementar y desplegar modelos generativos.

¿En qué se diferencia un flujo de trabajo con agente de un chatbot estándar?

Un chatbot estándar es pasivo: recibe una consulta y genera una respuesta de texto basada en su entrenamiento.

Un flujo de trabajo agencial proporciona al LLM acceso a herramientas (como un navegador web, un intérprete de código o una API) y la autonomía necesaria para planificar un proceso de varios pasos con el fin de alcanzar un objetivo. El agente podría planear buscar en la web, analizar los datos con código Python y luego escribir un informe, repitiendo el proceso hasta completar la tarea.

¿Cómo garantizas la seguridad y la solidez en la implementación de LLM utilizando Guardrails?

Garantizar la seguridad y la solidez de los LLM plantea varios retos. Uno de los principales retos es la posibilidad de generar resultados perjudiciales o sesgados, ya que estos modelos se entrenan con fuentes de datos enormes o incluso sin filtrar y pueden producir contenidos tóxicos o engañosos.

Otro problema importante del contenido generado por LLM es el peligro de las alucinaciones, es decir, que el modelo genere contenido que suena convincente pero que, en realidad, es información incorrecta. Otro reto es la seguridad frente a indicaciones adversas que violan las medidas de seguridad del modelo y producen respuestas dañinas o poco éticas, como se ha demostrado en numerosas ocasiones en relación con diversos modelos.

La incorporación de filtros de seguridad y capas de moderación puede ayudar a identificar y eliminar el contenido perjudicial que se está generando. La supervisión continua por parte de personas mejora aún más la seguridad del modelo.

Además, los ingenieros deben implementar barreras de protección explícitas (como NeMo Guardrails o Llama Guard) que se interponen entre el usuario y el modelo. Estos sistemas analizan las entradas para bloquear los intentos de inyección de comandos o la filtración de información de identificación personal (PII) y analizan las salidas para detectar respuestas tóxicas o alucinatorias antes de que lleguen al usuario. Esto crea una capa de seguridad determinista que funciona independientemente de la naturaleza probabilística del modelo.

Describe un proyecto desafiante relacionado con la IA generativa que hayas abordado. ¿Cuáles fueron los principales retos y cómo los superaste?

Responder a esta pregunta depende en gran medida de tus proyectos y experiencias. Sin embargo, puedes tener en cuenta estos puntos al responder preguntas como esta:

- Selecciona un proyecto específico con retos claros en materia de IA, como el sesgo, la precisión de los modelos o las alucinaciones.

- Aclara el problema y explica la dificultad técnica u operativa.

- Muestra tu enfoque mencionando las estrategias clave que has utilizado, como el aumento de datos, el ajuste de modelos o la colaboración con expertos.

- Destaca los resultados y cuantificar el impacto: mayor precisión, mejor interacción de los usuarios o resolución de un problema empresarial.

¿Puedes hablar sobre tu experiencia en la implementación y el despliegue de modelos de IA generativa en entornos de producción?

Al igual que la pregunta anterior, esta pregunta puede responderse basándose en tu experiencia, pero también teniendo en cuenta lo siguiente:

- Céntrate en la implementación: Menciona la infraestructura (nube servicios, MLOps ) y tareas clave de implementación (escalado, optimización de baja latencia). No hay necesidad de entrar en detalles. Basta con demostrar que estás al tanto de todo.

- Menciona un reto: Vale la pena mencionar uno o dos retos comunes que hay que evitar, para demostrar tu experiencia.

- , después de la implementación: Incluye estrategias de supervisión y mantenimiento para garantizar un rendimiento constante.

- Dirección de seguridad: Menciona cualquier medida que se haya tomado para gestionar los sesgos o la seguridad durante la implementación.

¿Cómo manejas el fenómeno de «perderse en medio» en ventanas de texto largo?

Incluso con ventanas de contexto masivas (por ejemplo, 1 millón de tokens), los LLM a menudo tienen dificultades para recuperar información oculta en medio de la solicitud, dando prioridad al principio y al final.

Los ingenieros mitigan este problema utilizando algoritmos inteligentes de reclasificación que mueven los fragmentos recuperados más críticos al principio o al final de la ventana de contexto. Otra estrategia es el algoritmo «map-reduce», en el que el modelo resume secciones del documento largo de forma independiente antes de combinarlas para obtener una respuesta final.

¿Cómo abordarías la tarea de crear un sistema RAG integral?

La creación de un sistema RAG requiere un enfoque sistemático. Así es como podría ser el proceso:

- División eficaz en fragmentos: Utiliza estrategias semánticas o recursivas para dividir los documentos en segmentos significativos (en lugar de recuentos arbitrarios de caracteres) para garantizar que se conserve el contexto.

- Almacenamiento vectorial: Incrustar estos fragmentos utilizando un modelo de incrustación de alto rendimiento y almacenarlos en una base de datos vectorial, adjuntando metadatos enriquecidos (como fechas o autores) para el filtrado previo.

- Búsqueda híbrida: Implementa una capa de recuperación que combine la búsqueda por palabras clave (BM25) para coincidencias exactas con la búsqueda vectorial (similitud semántica) para capturar tanto términos específicos como conceptos más amplios.

- Reordenación: Aplica un modelo de codificador cruzado para volver a puntuar los resultados más relevantes recuperados, filtrando de forma agresiva los fragmentos irrelevantes antes de que lleguen al LLM.

- Cita y generación: Solicita al LLM que genere respuestas basadas estrictamente en el contexto proporcionado y exígele que cite documentos fuente específicos para evitar alucinaciones.

¿Cuáles son algunas de las cuestiones o áreas de investigación abiertas que te parecen más interesantes en el campo de la IA generativa?

La respuesta depende también de tus preferencias personales, pero aquí tienes algunos temas que puedes mencionar:

- Mejora de la interpretabilidad del modelo: Hacer que los modelos generativos sean más transparentes e interpretables.

- Marcos éticos: Desarrollo de directrices para una IA responsable.

- Generación intermodal: Generación de contenido a través de múltiples tipos de datos (imágenes, texto, etc.).

- Robustez ante adversidades: Creación de modelos resistentes a ataques adversarios.

- Capacidades de razonamiento: Aumentar la capacidad de razonamiento de los LLM.

Conclusión

A medida que la IA generativa encuentra formas de influir en diversos aspectos de nuestras vidas y carreras profesionales, es fundamental mantener una mirada curiosa sobre los temas esenciales. Aunque las posibles preguntas sobre GenAI que se pueden plantear durante una entrevista dependen del puesto y la empresa concretos, he intentado recopilar 30 preguntas y respuestas para ayudarte a empezar a preparar tu entrevista.

Para explorar más preguntas de entrevista, recomiendo estos blogs:

Estudiante de Máster en Inteligencia Artificial y redactor técnico de IA. Comparto ideas sobre la última tecnología de IA, haciendo accesible la investigación en ML y simplificando los complejos temas de IA necesarios para mantenerte a la vanguardia.