programa

Los modelos de lenguaje grandes (LLM) han cobrado cada vez más importancia en la inteligencia artificial, con aplicaciones en diversos sectores.

A medida que crece la demanda de profesionales con experiencia en LLM, este artículo ofrece un conjunto completo de preguntas y respuestas para entrevistas, que abarca conceptos fundamentales, técnicas avanzadas y aplicaciones prácticas.

Si te estás preparando para una entrevista de trabajo o simplemente deseas ampliar tus conocimientos, este artículo te resultará útil.

Preguntas básicas para la entrevista de LLM

Para comprender los LLM, es importante empezar por los conceptos fundamentales. Estas preguntas fundamentales abarcan aspectos esenciales como la arquitectura, los mecanismos clave y los retos típicos, lo que proporciona una base sólida para aprender temas más avanzados.

¿Qué es la arquitectura Transformer y cómo se utiliza en los LLM?

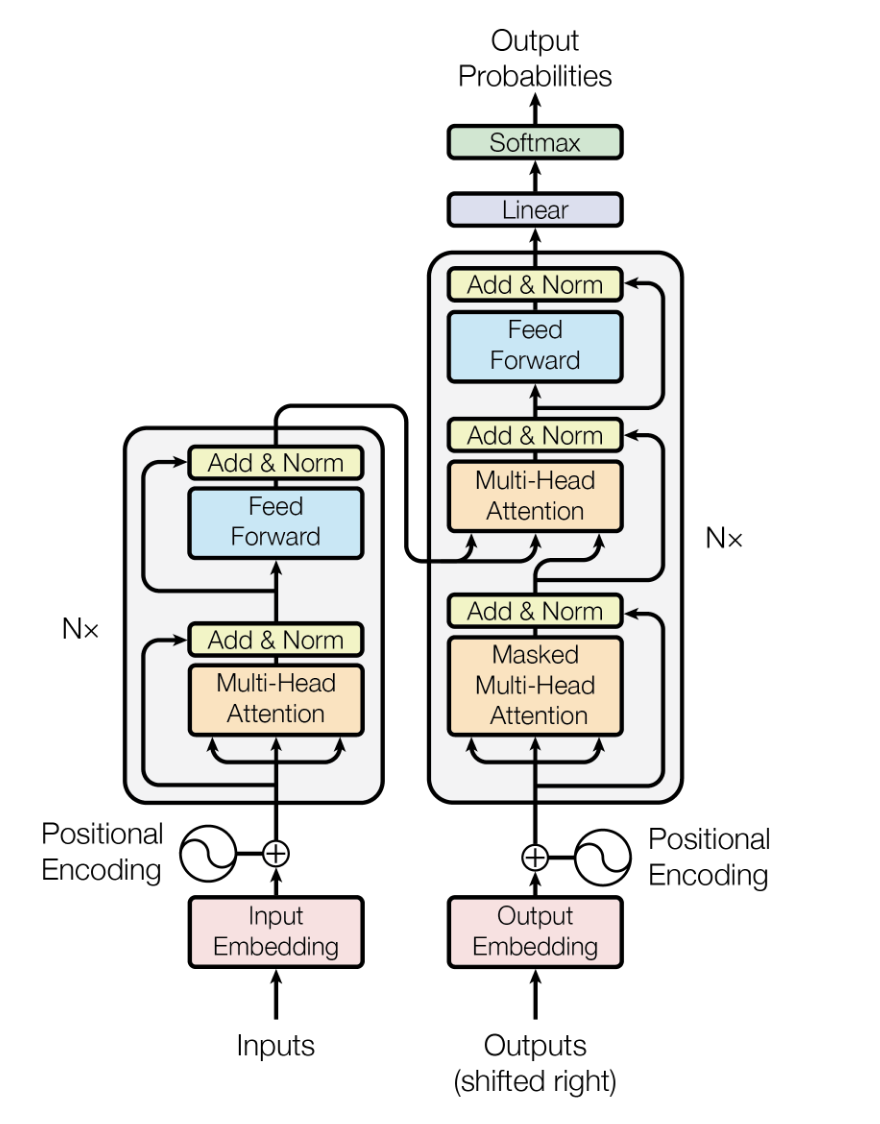

La arquitectura Transformer es un modelo de aprendizaje profundo introducido por Vaswani et alen 2017, diseñado para manejar datos secuenciales con mayor eficiencia y rendimiento que los modelos anteriores, como las redes neuronales recurrentes (RNN) y las redes neuronales con memoria a corto y largo plazo (LSTM).

Se basa en mecanismos de autoatención para procesar los datos de entrada en paralelo, lo que te hace altamente escalable y capaz de capturar dependencias de largo alcance.

En los LLM, la arquitectura Transformer constituye la columna vertebral, lo que permite a los modelos procesar grandes cantidades de datos de texto de manera eficiente y generar resultados de texto coherentes y relevantes desde el punto de vista contextual.

La arquitectura del modelo Transformer. Fuente

Explica el concepto de «ventana de contexto» en los modelos de lenguaje grande (LLM) y su importancia.

La ventana de contexto en los LLM se refiere al rango de texto (en términos de tokens o palabras) que el modelo puede considerar a la vez al generar o comprender el lenguaje. La importancia de la ventana de contexto radica en su impacto en la capacidad del modelo para generar respuestas lógicas y relevantes.

Por lo general, una ventana de contexto más amplia permite al modelo tener en cuenta más contexto, lo que se traduce en una mejor comprensión y generación de texto, especialmente en conversaciones complejas o largas. Sin embargo, también aumenta los requisitos computacionales, lo que lo convierte en un equilibrio entre rendimiento y eficiencia.

Además, investigaciones recientes revelan que los modelos de most muestran un rendimiento degradado mucho antes de alcanzar los límites anunciados. Los modelos pueden presentar un fenómeno de «pérdida en el medio», en el que la información del centro del contexto se ignora o se deja de priorizar. Por lo tanto,un contexto relevante y seleccionado en ventanas más pequeñas suele funcionar mejor que llenar ventanas más grandes con ruido.

¿Cuáles son algunos de los objetivos comunes previos al entrenamiento para los LLM y cómo funcionan?

Los objetivos comunes previos al entrenamiento para los LLM incluyen el modelado de lenguaje enmascarado (MLM) y el modelado de lenguaje autorregresivo. En MLM, se ocultan palabras aleatorias en una frase y se entrena al modelo para que prediga las palabras ocultas basándose en el contexto circundante. Esto ayuda al modelo a comprender el contexto bidireccional.

El modelado autorregresivo del lenguaje consiste en predecir la siguiente palabra de una secuencia y entrenar al modelo para que genere texto de un token en un momento dado. Ambos objetivos permiten al modelo aprender patrones lingüísticos y semánticos a partir de grandes corpus, lo que proporciona una base sólida para ajustar tareas específicas.

¿Quieres iniciarte en la IA Generativa?

Aprende a trabajar con LLMs en Python directamente en tu navegador

¿Qué es el ajuste fino en el contexto de los LLM y por qué es importante?

El ajuste fino en el contexto de los LLM implica tomar un modelo preentrenado y seguir entrenándolo con un conjunto de datos más pequeño y específico para la tarea. Este proceso ayuda al modelo a adaptar su comprensión general del lenguaje a los matices de la aplicación específica, mejorando así el rendimiento.

Esta es una técnica importante porque aprovecha los amplios conocimientos lingüísticos adquiridos durante el entrenamiento previo, al tiempo que modifica el modelo para que funcione bien en aplicaciones específicas, como el análisis de sentimientos, la síntesis de textos o la respuesta a preguntas.

¿Cuáles son algunos de los retos más comunes asociados al uso de los LLM?

El uso de los LLM plantea varios retos, entre ellos:

- Recursos computacionales: Los LLM requieren una gran potencia computacional y mucha memoria, lo que hace que su entrenamiento y despliegue consuman muchos recursos.

- Sesgo y equidad: Los LLM pueden aprender y propagar inadvertidamente los sesgos presentes en los datos de entrenamiento, lo que da lugar a resultados injustos o sesgados.

- Interpretabilidad: Comprender y explicar las decisiones tomadas por los LLM puede resultar difícil debido a su naturaleza compleja y opaca.

- Privacidad de los datos: El uso de grandes conjuntos de datos para el entrenamiento puede suscitar preocupaciones sobre la privacidad y la seguridad de los datos.

- Coste: El desarrollo, la formación y la implementación de los LLM pueden resultar costosos, lo que limita su accesibilidad para las organizaciones más pequeñas.

¿Cómo gestionan los LLM las palabras o tokens que no están en el vocabulario (OOV)?

Los LLM gestionan las palabras o tokens fuera del vocabulario (OOV) utilizando técnicas como la tokenización de subpalabras (por ejemplo, Byte Pair Encoding o BPE, y WordPiece). Estas técnicas descomponen las palabras desconocidas en unidades más pequeñas y conocidas que el modelo puede procesar.

Este enfoque garantiza que, aunque una palabra no aparezca durante el entrenamiento, el modelo pueda seguir comprendiendo y generando texto basándose en sus partes constitutivas, lo que mejora la flexibilidad y la solidez.

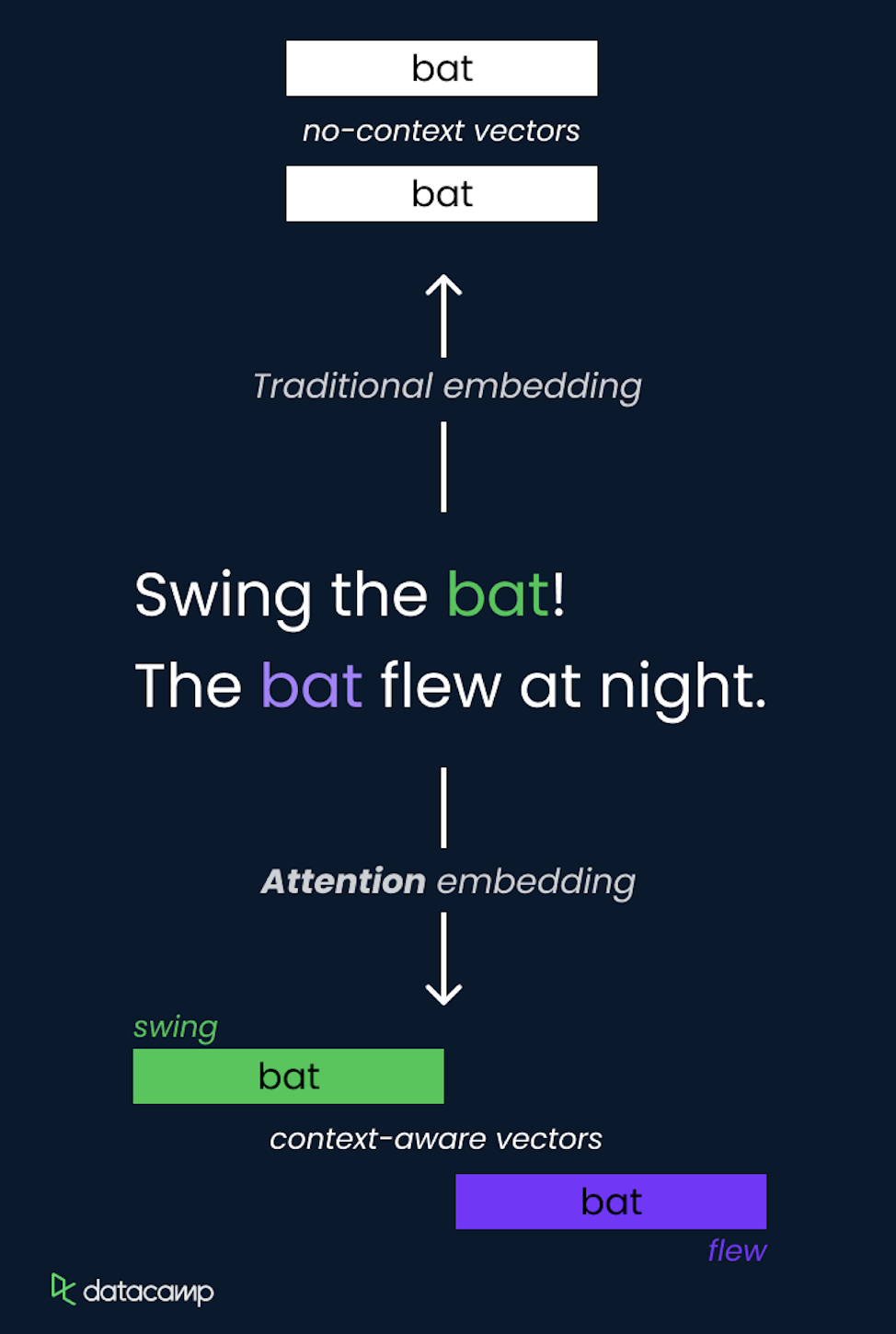

¿Qué son las capas de incrustación y por qué son importantes en los LLM?

Las capas de incrustación son un componente importante de los LLM que se utilizan para convertir datos categóricos, como las palabras, en representaciones vectoriales densas. Estas incrustaciones capturan las relaciones semánticas entre las palabras representándolas en un espacio vectorial continuo en el que las palabras similares muestran una mayor proximidad. La importancia de incorporar capas en los LLM incluye:

- Reducción de dimensionalidad: Reducen la dimensionalidad de los datos de entrada, lo que facilita su procesamiento por parte del modelo.

- Comprensión semántica: Las incrustaciones capturan matices semánticos y relaciones entre palabras, lo que mejora la capacidad del modelo para comprender y generar texto similar al humano.

- Aprendizaje por transferencia: Las incrustaciones preentrenadas pueden utilizarse en diferentes modelos y tareas, lo que proporciona una base sólida para la comprensión del lenguaje que puede ajustarse para aplicaciones específicas.

¿Cómo funcionan las codificaciones posicionales LLM modernas y por qué las incrustaciones de posición rotatoria (RoPE) se han convertido en el estándar?

Las codificaciones posicionales indican a los transformadores dónde se encuentra cada token en la secuencia.

Codificaciones posicionales sinusoidales tradicionales (de Vaswani et al. 2017) utilizaron funciones matemáticas fijas para codificar posiciones de forma estática. Las incrustaciones de posición rotatoria (RoPE), introducidas más recientemente, se han convertido en el estándar en los LLM modernos porque ofrecen propiedades fundamentalmente superiores.

RoPE funciona representando posiciones como ángulos de rotación en un espacio vectorial complejo, rotando las incrustaciones de tokens en un ángulo proporcional a su posición. Este enfoque geométrico es más eficiente y admite de forma natural la interpolación a secuencias más largas que las observadas durante el entrenamiento, lo cual es una capacidad fundamental para ampliar las ventanas de contexto. Modelos como GPT-5.2 y Gemini 3 utilizan RoPE como codificación posicional.

Preguntas de entrevista para el máster intermedio en Derecho

Partiendo de conceptos básicos, las preguntas de nivel intermedio profundizan en las técnicas prácticas utilizadas para optimizar el rendimiento de los modelos LLM y abordar los retos relacionados con la eficiencia computacional y la interpretabilidad de los modelos.

Explica el concepto de atención en los LLM y cómo se implementa.

El concepto de atención en los LLM es un método que permite al modelo centrarse en diferentes partes de la secuencia de entrada al realizar predicciones. Asigna dinámicamente pesos a otros tokens en la entrada, resaltando los más relevantes para la tarea actual.

Esto se implementa utilizando la autoatención, donde el modelo calcula las puntuaciones de atención para cada token en relación con todos los demás tokens de la secuencia, lo que te permite capturar las dependencias independientemente de su distancia.

El mecanismo de autoatención es un componente fundamental de la arquitectura Transformer, que te permite procesar información de manera eficiente y captar relaciones de largo alcance.

¿Cuál es el papel de la tokenización en el procesamiento de LLM?

La tokenización convierte el texto sin procesar en unidades más pequeñas llamadas tokens, que pueden ser palabras, subpalabras o caracteres.

El papel de la tokenización en el procesamiento de LLM es fundamental, ya que transforma el texto en un formato que el modelo puede comprender y procesar.

Una tokenización eficaz garantiza que el modelo pueda manejar una amplia gama de entradas, incluidas palabras poco frecuentes y diferentes idiomas, al dividirlas en partes manejables. Este paso es necesario para un entrenamiento y una inferencia óptimos, ya que estandariza la entrada y ayuda al modelo a aprender patrones significativos en los datos.

¿Cómo se mide el rendimiento de un LLM?

Los investigadores y profesionales han desarrollado numerosas métricas de evaluación para medir el rendimiento de un LLM. Las métricas clásicas incluyen:

- Perplejidad: Mide la capacidad del modelo para predecir una muestra, y se utiliza habitualmente en tareas de modelado del lenguaje.

- Precisión: Se utiliza para tareas como la clasificación de textos con el fin de medir la proporción de predicciones correctas.

- Puntuación F1: Media armónica de precisión y recuperación, utilizada para tareas como el reconocimiento de entidades nombradas.

- Puntuación BLEU (Bilingual Evaluation Understudy): Mide la calidad del texto generado por máquina en comparación con traducciones de referencia, lo cual se utiliza habitualmente en la traducción automática.

- ROUGE (Recall-Oriented Understudy for Gisting Evaluation): Conjunto de métricas que evalúan la coincidencia entre el texto generado y el texto de referencia, que se utiliza a menudo en tareas de resumen. Ayudan a cuantificar la eficacia del modelo y orientan las mejoras posteriores.

Más allá de las métricas tradicionales, los profesionales utilizan ahora puntos de referencia estandarizados para diferentes fines, como MMLU (prueba de conocimientos de 57 tareas), MMMU-Pro (razonamiento multimodal) y HumanEval (generación de código). Además, las tablas de clasificación como LMArena clasifican los LLM según las preferencias humanas. En los sistemas implementados, se ha vuelto esencial medir las tasas de alucinación en el mundo real, la latencia y la eficiencia de los tokens.

¿Cuáles son algunas técnicas para controlar la salida de un LLM?

Se pueden utilizar varias técnicas para controlar la salida de un LLM, entre ellas:

- Temperatura: El ajuste de este parámetro durante el muestreo controla la aleatoriedad de la salida. Las temperaturas más bajas producen resultados más deterministas, mientras que los valores más altos arrojan resultados más variados.

- Muestreo Top-K: Limita el conjunto de muestras a los K tokens más probables, lo que reduce la probabilidad de generar texto menos relevante o sin sentido.

- Muestreo Top-P (núcleo): Selecciona tokens del conjunto más pequeño cuya probabilidad acumulativa supere un umbral P, equilibrando diversidad y coherencia.

- Ingeniería rápida: Creación de indicaciones específicas para guiar al modelo hacia la generación de resultados deseados, proporcionando contexto o ejemplos.

- Fichas de control: Uso de tokens especiales para indicar al modelo que genere texto con un estilo, formato o tipo de contenido específicos.

¿Cuáles son algunos enfoques para reducir el costo computacional de los LLM?

Para reducir el coste computacional de los LLM, podemos emplear:

- Poda del modelo: Eliminar pesos o neuronas menos importantes del modelo para reducir su tamaño y los requisitos computacionales.

- Cuantización: La conversión de los pesos del modelo de una precisión mayor (por ejemplo, 32 bits en coma flotante) a una precisión menor (por ejemplo, 8 bits enteros) reduce el uso de memoria y acelera la inferencia.

- Destilación: Entrenar un modelo más pequeño (alumno) para que imite el comportamiento de un modelo más grande y preentrenado (profesor) con el fin de lograr un rendimiento similar con menos recursos.

- Atención escasa: El uso de técnicas como los transformadores dispersos para limitar el mecanismo de atención a un subconjunto de tokens reduce la carga computacional.

- Arquitecturas eficientes: Desarrollar y utilizar arquitecturas de modelos eficientes diseñadas específicamente para minimizar las exigencias computacionales sin perder rendimiento, como Reformer o Longformer.

¿Cuál es la importancia de la interpretabilidad de los modelos en los LLM y cómo se puede lograr?

La interpretabilidad del modelo es esencial para comprender cómo toma decisiones un LLM, lo cual es importante para generar confianza, garantizar la responsabilidad e identificar y mitigar los sesgos. Para lograr la interpretabilidad se pueden adoptar diferentes enfoques, tales como:

- Visualización de atención: Analizar las ponderaciones de atención para ver en qué partes de la entrada se centra el modelo.

- Mapas de saliencia: Destacar las características de entrada que tienen mayor influencia en el resultado del modelo.

- Métodos independientes del modelo: Uso de técnicas como LIME (Local Interpretable Model-agnostic Explanations) para explicar predicciones individuales.

- Propagación de relevancia por capas: Desglosar las predicciones del modelo en contribuciones de cada capa o neurona.

¿Cómo gestionan los LLM las dependencias a largo plazo en el texto?

Los LLM gestionan las dependencias a largo plazo en el texto a través de su arquitectura, en particular el mecanismo de autoatención, que les permite considerar todos los tokens de la secuencia de entrada simultáneamente. Esta capacidad para prestar atención a tokens distantes ayuda a los LLM a captar relaciones y dependencias en contextos largos.

Además, los modelos avanzados como Transformer-XL y Longformer están diseñados específicamente para ampliar la ventana de contexto y gestionar secuencias más largas de forma más eficaz, lo que garantiza un mejor manejo de las dependencias a largo plazo.

Los modelos de producción modernos utilizan estrategias más avanzadas para gestionar las dependencias a largo plazo y contrarrestar la degradación del rendimiento con ventanas de contexto ampliadas, tales como:

- Incrustaciones de posición rotatoria (RoPE) para una mejor extrapolación de la longitud y una codificación de posición superior.

- Patrones de atención optimizados para secuencias largas, incluyendo variantes de atención agrupada y atención múltiple.

- Integración cuidadosa del conocimiento mediante RAG, en lugar de depender únicamente de la capacidad de la ventana de contexto.

¿Qué es la generación aumentada por recuperación (RAG) y cómo ha evolucionado?

RAG combina mecanismos de recuperación con modelos generativos para obtener información relevante de fuentes externas durante la generación de texto. Este enfoque aborda directamente dos limitaciones críticas del LLM: las alucinaciones y la actualidad del conocimiento. El RAG tradicional utiliza procesos de recuperación y generación relativamente sencillos, pero en su evolución hacia el «RAG 2.0», se ha vuelto mucho más sofisticado.

Las características principales de RAG 2.0 incluyen:

- Recuperación recursiva: Los modelos analizan las lagunas en la información recuperada y realizan de forma proactiva búsquedas secundarias o terciarias para llenar esas lagunas de conocimiento, en lugar de basarse en una única pasada de recuperación.

- Recuperación multimodal: Integración entre diversos formatos (texto, imágenes, PDF, vídeos e incluso llamadas API) que permite recopilar información contextual más rica.

- Indexación híbrida: Búsqueda combinada BM25 (basada en palabras clave) y vectorial (semántica) para capturar tanto la relevancia léxica como semántica.

- Reordenar capas: Filtrado inteligente de los resultados iniciales de la búsqueda para reducir el ruido y la información irrelevante.

- Adaptación agencial: Selección dinámica de estrategias en la que el sistema elige los métodos de recuperación en función de la complejidad de la consulta y el dominio.

RAG 2.0, combinado con LLM, reduce eficazmente las tasas de alucinación entre un 40 % y un 60 % en los sistemas de producción en comparación con los modelos básicos.

Preguntas avanzadas para entrevistas de máster en Derecho

Comprender los conceptos avanzados de los LLM resulta útil para los profesionales que desean ampliar los límites de lo que estos modelos pueden lograr. En esta sección se analizan temas complejos y retos comunes a los que te enfrentas en este campo.

Explica el concepto de «aprendizaje con pocos ejemplos» en los modelos de lenguaje grande (LLM) y sus ventajas.

El aprendizaje con pocos ejemplos en los LLM se refiere a la capacidad del modelo para aprender y realizar nuevas tareas utilizando solo unos pocos ejemplos. Esta capacidad aprovecha el amplio conocimiento preentrenado del LLM, lo que te permite generalizar a partir de un pequeño número de casos.

Las principales ventajas del aprendizaje con pocos ejemplos incluyen la reducción de los requisitos de datos, ya que se minimiza la necesidad de grandes conjuntos de datos específicos para cada tarea, una mayor flexibilidad, lo que permite que el modelo se adapte a diversas tareas con un ajuste mínimo, y la rentabilidad, ya que los menores requisitos de datos y la reducción de los tiempos de formación se traducen en un ahorro significativo de costes en la recopilación de datos y los recursos computacionales.

¿Cuáles son las diferencias entre los modelos de lenguaje autorregresivos y los modelos de lenguaje enmascarados?

Los modelos de lenguaje autorregresivos y enmascarados difieren principalmente en su enfoque de predicción y en su idoneidad para las tareas. Los modelos autorregresivos, como GPT-5.2, Claude 4.5 Opus y Gemini 3, predicen la siguiente palabra de una secuencia basándose en las palabras anteriores, generando texto un token cada vez.

Estos modelos son especialmente adecuados para tareas de generación de texto. Por el contrario, los modelos de lenguaje enmascarados, como BERT, enmascaran aleatoriamente palabras en una frase y entrenan el modelo para predecir estas palabras enmascaradas basándose en el contexto circundante. Este enfoque bidireccional ayuda al modelo a comprender el contexto desde ambas direcciones, lo que lo hace ideal para tareas de clasificación de texto y respuesta a preguntas.

¿Cómo puedes incorporar conocimientos externos en un máster en Derecho?

La incorporación de conocimientos externos en un LLM puede lograrse mediante varios métodos:

- Integración del gráfico de conocimiento: Ampliar la información de entrada del modelo con datos procedentes de grafos de conocimiento estructurados para proporcionar información contextual.

- Generación aumentada por recuperación (RAG): Combina métodos de recuperación con modelos generativos para obtener información relevante de fuentes externas durante la generación de texto. Los sistemas RAG 2.0 modernos utilizan la recuperación recursiva, la indexación híbrida y la reclasificación para lograr una integración del conocimiento superior en comparación con los enfoques de recuperación simples.

- Ajuste fino con datos específicos del dominio: Entrenar el modelo con conjuntos de datos adicionales que contengan los conocimientos necesarios para especializarlo en tareas o ámbitos específicos.

- Ingeniería rápida: Diseñar indicaciones que guíen al modelo para utilizar eficazmente el conocimiento externo durante la inferencia.

¿Cuáles son algunos de los retos asociados al despliegue de los LLM en producción?

La implementación de LLM en producción plantea varios retos:

- Escalabilidad: Garantizar que el modelo pueda gestionar grandes volúmenes de solicitudes de manera eficiente a menudo requiere importantes recursos computacionales y una infraestructura optimizada.

- Latencia: Minimizar el tiempo de respuesta para proporcionar resultados en tiempo real o casi real es fundamental para aplicaciones como los chatbots y los asistentes virtuales.

- Supervisión y mantenimiento: La supervisión continua del rendimiento del modelo y su actualización para gestionar datos y tareas en constante evolución requieren sistemas de supervisión robustos y actualizaciones periódicas.

- Consideraciones éticas y legales: Abordar cuestiones relacionadas con los sesgos, la privacidad y el cumplimiento de las normativas es esencial para evitar problemas éticos y repercusiones legales.

- Gestión de recursos: La gestión de los importantes recursos computacionales necesarios para la inferencia garantiza la rentabilidad e implica la optimización de las configuraciones de hardware y software.

¿Cómo gestionas la degradación de los modelos a lo largo del tiempo en los LLM implementados?

La degradación del modelo se produce cuando el rendimiento de un LLM disminuye con el tiempo debido a cambios en la distribución de los datos subyacentes. El manejo de la degradación del modelo implica un reentrenamiento periódico con datos actualizados para mantener el rendimiento. Es necesario realizar un seguimiento continuo para controlar el rendimiento del modelo y detectar signos de degradación.

Las técnicas de aprendizaje incremental permiten que el modelo aprenda a partir de datos nuevos sin olvidar la información aprendida anteriormente. Además, las pruebas A/B comparan el rendimiento del modelo actual con las nuevas versiones y ayudan a identificar posibles mejoras antes de la implementación completa.

¿Cuáles son algunas técnicas para garantizar el uso ético de los LLM?

Para garantizar el uso ético de los LLM, se pueden implementar varias técnicas:

- Mitigación del sesgo: Aplicación de estrategias para identificar y reducir los sesgos en los datos de entrenamiento y los resultados de los modelos, como el uso de conjuntos de datos equilibrados y herramientas de detección de sesgos.

- Transparencia y explicabilidad: Desarrollar modelos que proporcionen resultados interpretables y explicables para fomentar la confianza y la responsabilidad, incluyendo el uso de visualización de la atención y mapas de relevancia.

- Consentimiento del usuario y privacidad: Garantizar que los datos utilizados para el entrenamiento y la inferencia cumplan con las normas de privacidad y obtener el consentimiento de los usuarios cuando sea necesario.

- Auditorías de equidad: Realizar auditorías periódicas para evaluar la equidad y las implicaciones éticas del comportamiento del modelo.

- Despliegue responsable: Establecimiento de directrices y políticas para el despliegue responsable de la IA, incluido el manejo de contenidos nocivos o inapropiados generados por el modelo.

¿Cómo puedes garantizar la seguridad de los datos utilizados con los LLM?

Para proteger los datos utilizados con los LLM es necesario implementar diversas medidas. Esto incluye el uso de técnicas de cifrado para los datos en reposo y en tránsito con el fin de protegerlos contra el acceso no autorizado. Es necesario aplicar controles de acceso estrictos para garantizar que solo el personal autorizado pueda acceder a los datos confidenciales.

También es fundamental anonimizar los datos para eliminar la información de identificación personal (PII) antes de utilizarlos para el entrenamiento o la inferencia. Además, el cumplimiento de las normativas de protección de datos, como el RGPD o la CCPA, es esencial para evitar problemas legales.

Estas medidas ayudan a proteger la integridad, confidencialidad y disponibilidad de los datos. Esta protección es fundamental para mantener la confianza de los usuarios y cumplir con las normas reglamentarias.

¿Cómo mejora el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) la calidad y la seguridad de los resultados del LLM, y cómo se compara con métodos de alineación más recientes como DPO y RLAIF?

RLHF ( ) es una técnica que consiste en entrenar un LLM para alinear sus resultados con las preferencias humanas mediante la incorporación de comentarios de evaluadores humanos. Este proceso iterativo ayuda al modelo a aprender a generar respuestas que no solo son precisas, sino también seguras, imparciales y útiles.

Sin embargo, RLHF plantea algunos retos. Un reto es la posibilidad de sesgo en la retroalimentación humana, ya que diferentes evaluadores pueden tener preferencias e interpretaciones diferentes.

Otro reto es la escalabilidad del proceso de retroalimentación, ya que recopilar e incorporar grandes cantidades de retroalimentación humana puede llevar mucho tiempo y resultar costoso. Además, garantizar que el modelo de recompensa utilizado en RLHF refleje con precisión los comportamientos y valores deseados puede resultar complicado. El paso de optimización PPO (optimización de políticas proximales) añade complejidad y puede introducir inestabilidad durante el entrenamiento.

Han surgido alternativas modernas que abordan muchas de las limitaciones de RLHF:

- DPO (Optimización directa de preferencias): Elimina por completo el modelo de recompensa independiente, utilizando señales de recompensa implícitas derivadas directamente de pares de preferencias. Este enfoque es más sencillo, más estable y más eficiente desde el punto de vista computacional que el RLHF basado en PPO. El DPO está siendo ampliamente adoptado por los principales laboratorios de IA como alternativa o complemento al RLHF tradicional.

- GRPO (Optimización de políticas de recompensa basada en gradientes): Una variante que combina las ventajas de la simplicidad del DPO con aspectos del aprendizaje al estilo PPO, ofreciendo soluciones intermedias.

- RLAIF (Aprendizaje por refuerzo a partir de la retroalimentación de la IA): Reemplaza a los evaluadores humanos con comentarios de IA (como calificaciones de modelos más sólidos o evaluadores especializados). Este enfoque reduce drásticamente los retos y los costes relacionados con la escalabilidad, ya que generar comentarios mediante IA es más barato y rápido que recopilar comentarios humanos.

La mayoría de los modelos de producción utilizan DPO, RLAIF o combinaciones híbridas en lugar de RLHF basado exclusivamente en PPO.

Compara los modelos de espacio de estados (como Mamba) con los transformadores. ¿Cuáles son las ventajas y desventajas, y cuándo se utilizaría cada una?

Las alucinaciones basadas en el conocimiento se producen cuando el modelo no dispone de los datos correctos (o tiene datos obsoletos), por lo que inventa información que parece plausible. Las correcciones suelen incluir:

- Fundamentación del modelo con recuperación (RAG)

- Añadir fuentes verificadas

- Ajuste específico para cada dominio

Las alucinaciones basadas en la lógica se producen cuando el modelo dispone de información relevante, pero razona de forma incorrecta o genera inconsistencias. Las soluciones más comunes son:

- Sugerencias estructuradas

- Pasos de verificación/autocomprobación (a menudo a través de flujos de trabajo de agentes

- Evaluación específica

¿Cuál es la diferencia entre las alucinaciones basadas en el conocimiento y las basadas en la lógica en los LLM, y cómo se aborda cada una de ellas?

Aunque los transformadores dominan los LLM en la actualidad, los modelos de espacio de estado (SSM), como Mamba, han surgido como un paradigma arquitectónico competitivo con propiedades computacionales y de rendimiento fundamentalmente diferentes. Comprender ambos aspectos es cada vez más importante para los profesionales modernos del LLM.

Transformers:

- Puntos fuertes: Excelente en la recuperación de información, tareas de copiar/pegar y aprendizaje contextual. Arquitectura probada a gran escala con amplias herramientas e infraestructura. Sólido rendimiento empírico en la generación de código y diversos puntos de referencia.

- Debilidades: La complejidad de atención O(N²) genera requisitos computacionales y de memoria cuadráticos. Esto se manifiesta en una degradación del rendimiento en secuencias muy largas (>100 000 tokens) y una alta latencia para aplicaciones de contexto largo.

- Casos de uso y recomendaciones: La mayoría de los LLM de producción actuales (GPT, Claude, Gemini, Llama). Recomendado para aplicaciones actuales en el mundo real y para el futuro previsible.

Modelos de espacio de estados (Mamba, Mamba-2):

- Puntos fuertes: Complejidad O(N) con escalado lineal de la memoria. Inferencia entre 5 y 10 veces más rápida en secuencias largas (>50 000 tokens). Mejores fundamentos teóricos para el procesamiento de señales. Comportamiento de escalado más predecible.

- Debilidades: Requiere 10 veces más datos de entrenamiento que Transformers para lograr un rendimiento comparable. Más débil en tareas de recuperación y copia de información. Ecosistema menos maduro, con menos herramientas, bibliotecas y modelos entrenados.

- Casos de uso y recomendaciones: Aparece para aplicaciones especializadas: procesamiento de documentos largos, sistemas en tiempo real con restricciones de latencia, aplicaciones de streaming y, potencialmente, dominios especializados en los que el escalado O(N) es fundamental.

Investigaciones recientes demuestran que los transformadores y los SSM son complementarios en lugar de directamente competitivos, con diferentes casos de uso y limitaciones que favorecen diferentes arquitecturas. Los transformadores siguen siendo la opción más práctica para los LLM de uso general y probablemente seguirán dominando el mercado por ahora. Es probable que el futuro sea híbrido, con modelos especializados para diferentes requisitos computacionales y tareas.

Preguntas de entrevista de LLM para ingenieros de Prompt

La ingeniería de prompts es un aspecto importante de la utilización de los LLM. Implica la elaboración de indicaciones precisas y eficaces para generar las respuestas deseadas del modelo. En esta sección se examinan cuestiones clave que pueden surgir a los ingenieros.

¿Qué es la ingeniería de prompts y por qué es fundamental para trabajar con LLM?

La ingeniería de indicaciones consiste en diseñar y perfeccionar indicaciones para guiar a los LLM en la generación de resultados precisos y relevantes. Es fundamental para trabajar con LLM, ya que la calidad de la indicación influye directamente en el rendimiento del modelo.

Las indicaciones eficaces pueden mejorar la capacidad del modelo para comprender la tarea, generar respuestas precisas y relevantes, y reducir la probabilidad de errores.

La ingeniería de prompts es esencial para maximizar la utilidad de los LLM en diversas aplicaciones, desde la generación de texto hasta tareas complejas de resolución de problemas.

¿Puedes proporcionar ejemplos de diferentes técnicas de sugerencia (zero-shot, few-shot, chain-of-thought) y explicar cuándo utilizarlas?

- Sugerencias sin disparo: Proporciona al modelo una descripción de la tarea sin ejemplos. Se suele utilizar cuando no hay ejemplos disponibles o cuando se quiere comprobar la comprensión general y la flexibilidad del modelo.

- Sugerencias con pocos ejemplos: Proporciona algunos ejemplos junto con la descripción de la tarea para guiar el modelo. Esto resulta útil cuando el modelo necesita contexto o ejemplos para comprender mejor la tarea.

- Cadena de pensamientos sugeridos: Divide una tarea compleja en pasos más pequeños y secuenciales que el modelo puede seguir. Esto puede resultar beneficioso para tareas que requieren razonamiento lógico y resolución de problemas en varios pasos.

- Solicitud de acción: La estructura permite que los modelos actúen como agentes autónomos que invocan herramientas/API, recopilan información y razonan a lo largo de múltiples pasos. Las indicaciones incluyen definiciones del espacio de acción, descripciones de herramientas y requisitos de razonamiento explícito.

¿Cómo evalúas la eficacia de una indicación?

Evaluar la eficacia de una indicación implica:

- Calidad de salida: Evaluación de la relevancia, coherencia y precisión de las respuestas del modelo.

- Coherencia: Comprobar si el modelo produce resultados de alta calidad de forma consistente con diferentes entradas.

- Métricas específicas de tareas: Utilizar métricas de evaluación específicas para cada tarea, como BLEU para la traducción o ROUGE para la síntesis, con el fin de medir el rendimiento.

- Evaluación humana: Involucrar a revisores humanos para que proporcionen comentarios cualitativos sobre los resultados del modelo.

- Pruebas A/B: Comparar diferentes indicaciones para determinar cuál ofrece un mejor rendimiento.

¿Cuáles son algunas estrategias para evitar errores comunes en el diseño de preguntas (por ejemplo, preguntas capciosas, instrucciones ambiguas)?

- Evita las preguntas capciosas: Asegúrate de que las indicaciones no impliquen una respuesta específica, ya que esto puede sesgar la respuesta del modelo.

- Instrucciones claras y concisas: Proporciona instrucciones claras y directas para reducir la confusión.

- Provisión de contexto: Incluye contexto relevante para ayudar al modelo a comprender la tarea sin sobrecargarlo con información innecesaria.

- Pruebas iterativas: Prueba y perfecciona continuamente las indicaciones basándote en los resultados y el rendimiento del modelo.

¿Cómo abordas el refinamiento iterativo de las indicaciones para mejorar el rendimiento del LLM?

El refinamiento iterativo de las indicaciones implica:

- Diseño inicial: Comienza con una indicación básica basada en los requisitos de la tarea.

- Pruebas y evaluación: Evalúa el rendimiento de la indicación utilizando diversas métricas y obtén comentarios.

- Análisis: Identifica las debilidades o áreas de mejora en la indicación.

- Refinamiento: Realiza ajustes en el mensaje para resolver los problemas identificados.

- Repite: Repite el proceso de prueba y perfeccionamiento hasta que se logre el rendimiento deseado.

¿Qué herramientas o marcos utilizas para optimizar el proceso de ingeniería de prompts?

Existen varias herramientas y marcos que pueden agilizar el proceso de ingeniería de prompts:

- Plataformas específicas para LLM: LangChain y LlamaIndex para el encadenamiento rápido y la creación de sistemas agenticos; Vercel AI SDK para la creación rápida de prototipos y la implementación.

- Pruebas y optimización rápidas: PromptFoo (pruebas automatizadas de indicaciones en distintos escenarios), DSPy (optimización programática de indicaciones), Haystack (construcción de canalizaciones RAG).

- Entornos de desarrollo interactivos (IDE): Jupyter Notebook para experimentación, VS Code con extensiones LLM (GitHub Copilot, Cursor), Streamlit para crear prototipos de interfaz de usuario interactivos.

- API y SDK: API de OpenAI, SDK de Anthropic, Together AI y LM Studio para la implementación de modelos locales.

- Control de versiones y colaboración: Control de versiones basado en Git, Weights & Biases para el seguimiento y la comparación de experimentos, HuggingFace Hub para compartir modelos y prompts.

- Marcos agenticos: AutoGPT, OpenAI Assistants API y LangGraph para crear flujos de trabajo complejos de varios pasos con agentes.

- Evaluación y seguimiento: Ragas (métricas de evaluación RAG), LangSmith (seguimiento, depuración y supervisión de la producción), Braintrust (observabilidad LLM de extremo a extremo).

¿Cómo gestionas retos como las alucinaciones o los sesgos en los resultados de LLM mediante la ingeniería de prompts?

Esta pregunta aborda las cuestiones éticas y prácticas del contenido generado por LLM. Una respuesta sólida demostraría que eres consciente de estos problemas y abordaría técnicas como las siguientes.

Técnicas para mitigar las alucinaciones:

- Indicaciones para la verificación de datos: Incorpora indicaciones que animen al modelo a verificar su información con fuentes fiables y a citar explícitamente las pruebas.

- Integración de la recuperación: Utiliza los sistemas RAG o RAG 2.0 para basar las respuestas en documentos reales, reduciendo los datos inventados al exigir que el modelo haga referencia a la información recuperada.

- Bucles de verificación agenciales: La estructura solicita que el modelo realice una verificación en varios pasos, en la que comprueba su propio trabajo antes de responder, creando esencialmente agentes de autoverificación.

- Indicaciones basadas en restricciones: Define el formato de salida y las restricciones lógicas que hacen evidentes las inconsistencias o las afirmaciones no respaldadas.

Técnicas de mitigación del sesgo:

- Pistas para una perspectiva diversa: Guía al modelo para que tenga en cuenta múltiples puntos de vista y perspectivas de las partes interesadas antes de llegar a una conclusión.

- Mensajes de detección de sesgos: Pide al modelo que identifique posibles sesgos en su propio razonamiento y resultados.

- Indicaciones contrafactuales: Solicita escenarios o perspectivas alternativos para cuestionar las hipótesis iniciales y poner a prueba la solidez del razonamiento.

- Claridad de las instrucciones: Especificar explícitamente que las respuestas deben ser equilibradas, reconocer las limitaciones y evitar el lenguaje discriminatorio.

¿Podrías explicar la función de las plantillas de indicaciones y cómo se utilizan en la ingeniería de indicaciones?

Las plantillas de indicaciones proporcionan un formato estructurado para las indicaciones, que a menudo incluyen marcadores de posición para información o instrucciones específicas. Se pueden reutilizar en diferentes tareas y escenarios, lo que mejora la coherencia y la eficiencia en el diseño de mensajes.

Una buena respuesta explicaría cómo se pueden utilizar las plantillas de indicaciones para resumir las mejores prácticas, incorporar conocimientos específicos del ámbito y optimizar el proceso de generación de indicaciones eficaces para diversas aplicaciones.

¿Cómo afecta la elección del tokenizador al diseño de las indicaciones y al rendimiento del modelo?

El tokenizador desempeña un papel crucial en la forma en que el LLM interpreta y procesa la entrada. Los diferentes tokenizadores tienen distintos tamaños de vocabulario y tratan las palabras fuera del vocabulario (OOV) de manera diferente. Un tokenizador de subpalabras como Byte Pair Encoding (BPE) puede manejar palabras OOV dividiéndolas en unidades de subpalabras más pequeñas, mientras que un tokenizador basado en palabras podría tratarlas como tokens desconocidos.

La elección del tokenizador puede afectar al rendimiento del modelo de varias maneras. Por ejemplo, un tokenizador de subpalabras puede ser más eficaz para captar el significado de términos poco comunes o técnicos, mientras que un tokenizador basado en palabras puede ser más sencillo y rápido para tareas lingüísticas de uso general.

En la ingeniería de prompts, la elección del tokenizador puede influir en la forma en que estructuras tus prompts. Por ejemplo, si utilizas un tokenizador de subpalabras, es posible que debas prestar más atención a cómo se dividen las palabras en subpalabras para garantizar que el modelo capte el significado deseado.

¿Qué es la sugerencia agencial y en qué se diferencia de la ingeniería de sugerencias tradicional?

La incitación agencial es un enfoque de diseño de incitaciones en el que se instruye al modelo para que actúe como un «agente» capaz de planificar, realizar acciones (por ejemplo, llamar a herramientas/API o recuperar documentos), observar los resultados y repetir el proceso hasta completar un objetivo.

A diferencia de la ingeniería de indicaciones tradicional, que principalmente intenta obtener la mejor respuesta posible de una sola vez mediante instrucciones claras, ejemplos y restricciones de formato, las indicaciones agentivas hacen hincapié en un bucle de control de varios pasos (planificar → actuar → observar → perfeccionar).

Es especialmente útil para tareas en las que la corrección depende de la interacción con sistemas externos (bases de datos, búsquedas, ejecución de código) o de la verificación de resultados intermedios, en lugar de basarse únicamente en el conocimiento interno del modelo.

Las buenas indicaciones de agencia suelen definir el objetivo, las herramientas/acciones disponibles, cómo decidir qué acción tomar y cuándo detenerte. También es habitual añadir pasos de verificación explícitos (por ejemplo, «comprobar las fuentes recuperadas» o «recalcular antes de dar la respuesta definitiva») para reducir las alucinaciones y mejorar la fiabilidad.

Obtén una certificación superior en IA

Conclusión

Esta guía proporciona una serie de preguntas para entrevistas que te ayudarán a prepararte para debates sobre los LLM, desde los principios básicos hasta las estrategias avanzadas.

Tanto si te estás preparando para una entrevista como si deseas consolidar tus conocimientos, estas ideas te proporcionarán la información necesaria para desenvolverte y destacar en el campo de la inteligencia artificial.

Si deseas leer sobre las últimas novedades en IA y LLM, te recomiendo estos temas: