Cursus

L'intelligence artificielle générative (également appelée IA générative ou GenAI) est une sous-catégorie de l'IA qui se concentre sur la création de nouveaux contenus, tels que du texte, des images ou des vidéos, à l'aide de diverses technologies d'IA.

À mesure que l'IA générique progresse, elle s'étend à de nombreux autres domaines technologiques, tels que le développement de logiciels. Une connaissance approfondie de ses principes fondamentaux continuera d'être de plus en plus pertinente dans ces domaines.

Pour des postes tels que les scientifiques des donnéeset praticiens du machine learninget ingénieurs en intelligence artificielle, l'IA générative est un sujet essentiel à maîtriser.

Voici 30 questions d'entretien GenAI qui pourraient vous être posées lors d'un entretien.

Obtenez une certification de haut niveau en matière d'IA

Questions d'entretien de base sur l'IA générative

Commençons par quelques questions fondamentales relatives à l'intelligence artificielle générative. Ces exercices évalueront votre compréhension des concepts et principes fondamentaux.

Quelles sont les principales différences entre les modèles discriminatifs et génératifs ?

Les modèles discriminatifs apprennent la frontière de décision entre les classes et les modèles qui les différencient. Ils estiment la probabilité P(y|x), qui est la probabilité d'une étiquette particulière y, étant donné les données d'entrée x. Ces modèles se concentrent sur la distinction entre différentes catégories (par exemple, «Ce courriel est-il un spam ? »).

Les modèles génératifs apprennent la distribution des données elles-mêmes en modélisant la probabilité conjointe P(x,y), ce qui implique l'échantillonnage de points de données à partir de cette distribution. Après avoir été entraîné sur des milliers d'images de chiffres, cet échantillonnage pourrait générer une nouvelle image d'un chiffre.

Pour en savoir plus, veuillez consulter ce blog sur Modèles génératifs vs modèles discriminatifs : Différences et cas d'utilisation.

Que sont les jetons et les intégrations dans le contexte des grands modèles linguistiques (LLM)?

Les tokens sont les unités fondamentales de texte traitées par un LLM ; il peut s'agir de mots entiers, de syllabes ou même de lettres individuelles (par exemple, le mot « generative » peut être divisé en « gener », « at » et « ive »).

Les encastrements sont les représentations vectorielles numériques de ces jetons qui les placent dans un espace multidimensionnel en fonction de leur signification. Cette conversion permet au modèle de saisir le sens sémantique et de comprendre les relations entre les mots, par exemple en reconnaissant que « roi » est proche de « reine ».

Pourriez-vous expliquer les principes fondamentaux des réseaux antagonistes génératifs (GAN) ?

Les GAN sont constitués de deux réseaux neuronaux en concurrence (d'où le terme « adversaires ») : un générateur et un discriminateur.

Le générateur crée de faux échantillons de données tandis que le discriminateur les évalue par rapport aux données d'apprentissage réelles. Les deux réseaux sont entraînés simultanément :

- Le générateur vise à produire des images si proches des données réelles que le discriminateur ne peut pas faire la différence.

- Le discriminateur vise à déterminer avec précision si une image donnée est réelle ou générée.

Grâce à cet apprentissage compétitif, le générateur acquiert la capacité de produire des données hautement réalistes, similaires aux données d'entraînement.

Quelles sont les applications courantes de l'IA générative dans le monde réel ?

- Génération de texte : Utilisé dans les chatbots, la création de contenu ou la traduction (chatGPT, Claude, Gemini).

- Génération d'images : Production d'images réalistes pour l'art ou le design (par exemple, chatGPT Images, Nano Banana Pro, Stable Diffusion).

- Agents de codage : Écrire des modules de code complets, utilisés en génie logiciel.

- Génération augmentée par la récupération (RAG): Récupération des connaissances d'entreprise, utilisée dans le service client ou pour les wikis internes.

- Découverte de médicaments : Conception de nouvelles structures moléculaires pour les médicaments.

- Augmentation des données : Développement d'ensembles de données à faible volume pour l'apprentissage automatique.

Quels sont les défis associés à la formation et à l'évaluation des modèles d'IA générative ?

- Coût de calcul : Puissance de calcul élevée puissance de calcul et exigences matérielles pour former des modèles plus complexes.

- Complexité de la formation : La formation des modèles génératifs peut s'avérer complexe et présenter de nombreuses subtilités.

- Indicateurs d'évaluation: Il est difficile d'évaluer quantitativement la qualité et la diversité des résultats du modèle.

- Exigences en matière de données : Les modèles génératifs nécessitent souvent des quantités considérables de données de haute qualité et très variées. La collecte de ces données peut s'avérer longue et coûteuse.

- Parti pris et équité : Les modèles non vérifiés peuvent amplifier les biais présents dans les données d'entraînement, conduisant à des résultats injustes.

Quelles sont les considérations éthiques liées à l'utilisation de l'IA générative ?

L'utilisation généralisée de l'IA générative et ses cas d'application nécessitent une évaluation approfondie de leurs performances en termes d'éthique. éthique. Voici quelques exemples :

- s sur les deepfakes: La création de médias factices mais hyperréalistes peut contribuer à la diffusion de fausses informations ou à la diffamation de personnes.

- de génération biaisée: Amplification des préjugés historiques et sociétaux dans les données d'entraînement.

- s relatives à la propriété intellectuelle: Utilisation non autorisée de matériel protégé par le droit d'auteur dans les données.

Comment l'IA générative peut-elle être utilisée pour augmenter ou améliorer la créativité humaine ?

Bien que les hallucinations des modèles d'IA puissent produire des résultats erronés, ces modèles génératifs sont utiles à bien des égards et dans de nombreuses applications. Ils peuvent servir de source d'inspiration créative aux experts dans divers domaines :

- s sur l'art et le design: Inspirer dans le domaine de l'art et du design.

- Assistance à la rédaction: Proposer des titres et des idées de rédaction ou compléter des textes.

- Musique: Composition de rythmes et d'harmonies.

- s de programmation: Optimisation du code existant ou proposition de solutions pour aborder un problème de mise en œuvre.

Quelle est la différence entre un modèle de base et un modèle optimisé ?

Un modèle de base (tel que GPT-5.2) est formé à partir d'une quantité considérable de données Internet afin d'apprendre les schémas généraux, le raisonnement et la structure du langage.

Un modèle affiné utilise cette base généraliste et la perfectionne à partir d'un ensemble de données plus restreint et sélectionné avec soin afin de maîtriser une tâche spécifique, telle que le diagnostic médical ou l'utilisation d'un langage de programmation particulier. Le perfectionnement privilégie une expertise approfondie dans un domaine spécifique plutôt qu'une grande polyvalence.

Questions d'entretien sur l'IA générative intermédiaire

Maintenant que nous avons abordé les notions de base, examinons quelques questions d'entretien intermédiaires sur l'IA générative.

Qu'est-ce que le « Mode Collapse » dans les GAN, et comment y remédier ?

Tout comme un créateur de contenu qui constate qu'un certain format de vidéos génère davantage de portée et d'interactions, le modèle génératif d'un GAN pourrait se focaliser sur une diversité limitée de résultats qui trompent le modèle discriminateur. Il en résulte que le générateur produit un ensemble restreint de sorties, au détriment de la diversité et de la flexibilité des données générées.

Les solutions possibles à ce problème pourraient consister à se concentrer sur les techniques d'entraînement en ajustant les hyperparamètres et divers algorithmes d'optimisation, à appliquer des régularisations qui favorisent la diversité ou à combiner plusieurs générateurs pour couvrir différents modes de génération de données.

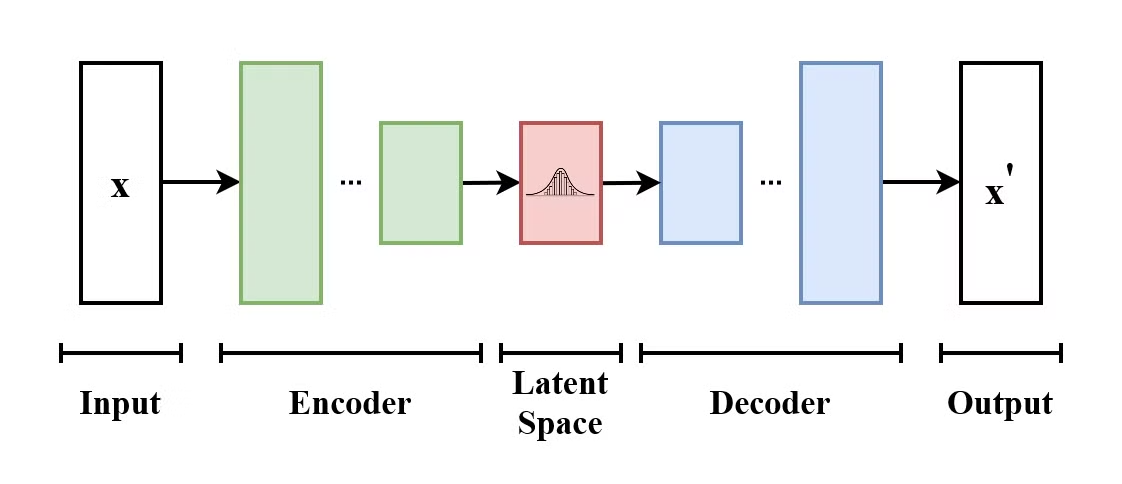

Comment fonctionne un auto-encodeur variationnel (VAE) ?

Un auto-encodeur variationnel (VAE) est un type de modèle génératif qui apprend à encoder les données d'entrée dans un espace latent et à les décoder pour reconstruire les données d'entrée d'origine. Les VAE sont des modèles encodeurs-décodeurs :

- L' encodeur mappe les données d'entrée sur une distribution dans l'espace latent.

- Le décodeur échantillons issus de cette distribution de l'espace latent reconstruisent les données d'entrée.

La structure d'un auto-encodeur variationnel. (Source : Wikimedia Commons)

Ce qui différencie les VAE des auto-encodeurs traditionnels, c'est que les VAE encouragent l'espace latent à suivre une distribution connue (telle que la distribution gaussienne). Cela les rend plus efficaces pour générer de nouvelles données en échantillonnant à partir de cet espace latent.

Veuillez expliquer la différence entre la génération augmentée par la récupération (RAG) et le réglage fin. Dans quelles circonstances préférez-vous utiliser l'un plutôt que l'autre ?

L' RAG connecte un modèle à des sources de données externes (telles que le wiki de votre entreprise) afin de récupérer des informations actualisées sans avoir à réentraîner le modèle. Les paramètres du modèle restent inchangés ; il a simplement accès à des données supplémentaires.

Le réglage fin modifie les pondérations internes du modèle afin de changer sa façon de s'exprimer, de se comporter ou de raisonner, mais il n'est pas adapté à l'ajout de nouvelles connaissances factuelles.

Veuillez utiliser RAG lorsque vous avez besoin d'informations actualisées (actualités, données d'entreprises privées) ou d'une citation spécifique. Utilisez le réglage fin lorsque vous souhaitez que le modèle apprenne un nouveau « comportement », un nouveau langage ou un format de sortie spécifique (par exemple, parler en code SQL).

Comment évalueriez-vous une candidature à un master en droit ? Veuillez expliquer le concept de « LLM en tant que juge ».

L'évaluation des échantillons générés est une tâche complexe qui dépend de la modalité des données (image, texte, vidéo, etc.). e texte traditionnel Les mesures, telles que la précision, sont insuffisantes pour les tâches créatives, car elles ne vérifient que le chevauchement des mots, et non le sens.

Les benchmarks et classements LLM utilisent des tests standardisés pour évaluer la capacité d'un modèle à accomplir une tâche donnée. Ils sont utiles pour comparer les modèles et suivre le cursus au sein d'une même modalité ou entre différentes modalités.

LLM-as-a-Judge est un cadre d'évaluation moderne dans lequel un modèle « enseignant » hautement performant (tel que Gemini 3) évalue les résultats d'un modèle plus petit en fonction de critères spécifiques, notamment la fidélité, l'utilité et le ton. Cela offre un moyen évolutif d'évaluer les préférences humaines sans la lenteur et le coût d'un examen manuel par des personnes.

Quelles sont les techniques permettant d'améliorer la stabilité et la convergence de l'entraînement des réseaux GAN ?

Il est essentiel d'améliorer la stabilité et la convergence de l'entraînement des GAN afin d'éviter l'effondrement des modes, de garantir un entraînement efficace et d'obtenir de bons résultats. Voici quelques techniques permettant d'améliorer la stabilité et la convergence de l'entraînement des GAN :

- GAN de Wasserstein (WGAN) : Utilise la distance de Wasserstein comme fonction de perte, améliorant la stabilité de l'entraînement et fournissant des gradients plus fluides.

- Règle de mise à jour à deux échelles de temps (TTUR) : Utilisation de taux d'apprentissage distincts pour le générateur et le discriminateur.

- Lissage des étiquettes : Adoucit les étiquettes pour éviter tout excès de confiance.

- Taux d'apprentissage adaptatifs : Utilisation d'optimiseurs tels qu'Adam pour faciliter la gestion dynamique du taux d'apprentissage.

- Pénalité de gradient : Pénalise les gradients importants dans le discriminateur afin d'appliquer la continuitéde Lipschitz d' , pour un apprentissage plus stable.

Comment pouvez-vous contrôler le style ou les attributs du contenu généré à l'aide de modèles d'IA générative ?

Il existe plusieurs techniques courantes pour contrôler le style des sorties GenAI :

- Ingénierie rapide: Veuillez préciser le style de sortie souhaité en fournissant des instructions détaillées mettant en évidence le style ou le ton de la génération de contenu. Il s'agit d'une méthode efficace et simple, tant pour les modèles texte-texte que texte-image. Cette méthode est beaucoup plus efficace si elle est appliquée conformément aux exigences spécifiques ou à la documentation du modèle en question.

- Contrôle de la température et de l'échantillonnage : Le paramètred' de température de l' e contrôle le degré de randomisation des sorties. Des températures plus basses impliquent une sélection de jetons plus prudente et prévisible, tandis que des températures plus élevées permettent une génération plus créative. D'autres paramètres, tels que top-k et top-p, peuvent également contrôler la créativité avec laquelle le modèle sélectionne les prochains tokens possibles lors de la génération.

- Résultats structurés : En ce qui concerne la structure, les modèles modernes utilisent le « mode JSON » ou les « sorties structurées », qui contraignent le modèle à générer strictement des schémas JSON ou XML valides plutôt que du texte libre.

- Messages du système : Les invites du système sont envoyées avec chaque nouveau message au modèle. Ils peuvent être utilisés pour définirdes instructions comportementales persistantes d' s qui remplacent les entrées de l'utilisateur afin de maintenir des personas ou des règles spécifiques.

- Transfert de style (images) : Une autre technique pouvant être utilisée lors de l'inférence pour les modèles pris en charge consiste à appliquer le style d'une image (image de référence) à une image d'entrée.

- Réglage: Nous pouvons utiliser un modèle pré-entraîné et l'ajuster sur un ensemble de données spécifique contenant le style ou le ton souhaité. Cela implique de poursuivre la formation du modèle à l'aide de données supplémentaires afin qu'il acquière des styles ou des attributs spécifiques supplémentaires.

- Apprentissage par renforcement : Nous pouvons orienter le modèle afin qu'il privilégie certaines sorties et évite d'autres en lui fournissant des commentaires. Ces commentaires seront utilisés pour modifier le modèle grâce à l'apprentissage par renforcement. Au fil du temps, le modèle sera ajusté en fonction des préférences des utilisateurs et/ou des ensembles de données de préférences. Dans le contexte des LLM, un exemple de cela est l'apprentissage par renforcement à partir du retour d'information humain (RLHF).

Quelles sont les différentes approches pour aborder la question des biais dans les modèles d'IA générative ?

Pour garantir l'impartialité et l'équité du modèle, il est nécessaire de procéder à des ajustements itératifs et à un suivi à chaque étape.

Tout d'abord, il est nécessaire de prévenir la contamination des données en s'assurant qu'aucune donnée de test ne se retrouve dans les données d'entraînement. Dans ce cas, le modèle serait formé pour mémoriser les données plutôt que pour les généraliser.

De plus, nous devons veiller à ce que les données d'entraînement soient aussi variées et inclusives que possible. Au cours de l'entraînement, nous pouvons orienter le modèle vers une génération plus équitable en intégrant des objectifs d'équité dans la fonction de perte.

Les résultats du modèle doivent être régulièrement contrôlés afin de détecter tout biais. Afin de renforcer la confiance du public, il est utile de rendre le processus décisionnel du modèle, les détails de l'ensemble de données et les étapes de prétraitement aussi transparents que possible.

Pourriez-vous nous expliquer le concept d'« espace latent » dans les modèles génératifs et son importance ?

Dans le contexte des modèles génératifs, l'espace latent est un espace de dimension inférieure qui capture les caractéristiques essentielles des données de manière à ce que les entrées similaires soient rapprochées les unes des autres. L'échantillonnage à partir de cet espace latent permet aux modèles de générer de nouvelles données et de manipuler des attributs ou des caractéristiques spécifiques (générant des variations d'images).

Les espaces latents sont essentiels pour générer des résultats contrôlables, fidèles aux données d'entraînement et diversifiés.

Quel est le rôle de l'apprentissage auto-supervisé dans le développement de modèles d'IA générative ?

L'idée principale derrière l'apprentissage auto-supervisé est d'exploiter un vaste corpus de données non étiquetées pour apprendre des représentations utiles sans avoir besoin d'un étiquetage manuel. Les modèles tels que BERT et GPT sont entraînés à l'aide de méthodes auto-supervisées telles que la prédiction du prochain token et l'apprentissage de la structure et de la sémantique des langues. Cela réduit la dépendance vis-à-vis des données étiquetées, dont l'obtention est coûteuse et prend beaucoup de temps, permettant ainsi aux modèles d'exploiter de vastes ensembles de données non étiquetées pour l'entraînement.

Qu'est-ce que l'adaptation de rang faible (LoRA) ?

La formation d'un modèle volumineux de 70 milliards de paramètres est extrêmement coûteuse et lente pour la plupart des organisations. L'adaptation de rang faible (LoRA) résout ce problème en gelant les poids du modèle principal et en ne formant qu'une minuscule couche « adaptatrice » (souvent moins de 1 % du total des paramètres) qui se trouve au-dessus. Cela vous permet de proposer plusieurs modèles « personnalisés » à partir d'un seul modèle de base, ce qui réduit considérablement les coûts de calcul et les besoins de stockage.

Questions d'entretien avancées sur l'IA générative

Pour ceux qui recherchent des postes plus élevés ou qui souhaitent démontrer une compréhension approfondie de l'IA générative, nous allons examiner quelques questions d'entretien avancées.

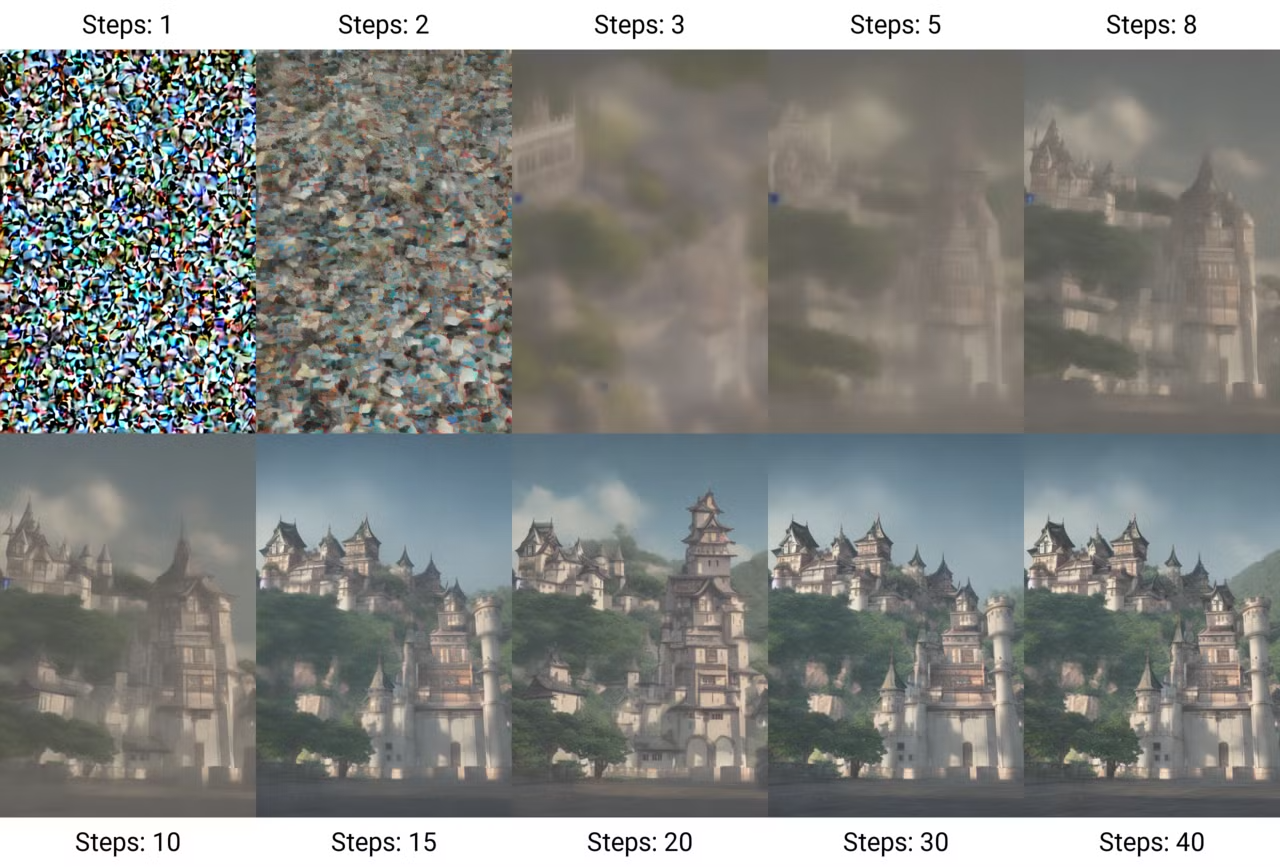

Veuillez expliquer le concept des « modèles de diffusion » et en quoi ils diffèrent des architectures plus anciennes.

Les modèles de diffusion fonctionnent principalement en ajoutant progressivement du bruit à une image jusqu'à ce qu'il ne reste plus que du bruit, puis en apprenant à inverser ce processus pour générer de nouveaux échantillons à partir du bruit. Ce processus est appelédiffusion d' .. Ces modèles ont acquis une grande popularité grâce à leur capacité à produire des images de haute qualité et très détaillées.

Génération d'une image par étapes de diffusion. (Source : Wikimedia Commons)

Le processus d'entraînement de ces modèles comprend deux étapes :

- Le processus direct (diffusion): Prendre une image d'entrée et ajouter progressivement du bruit en plusieurs étapes, jusqu'à ce que les données soient transformées en bruit pur.

- Le processus inverse (débruitage): Apprendre à extraire les données originales à partir du bruit. Pour ce faire, on entraîne un réseau neuronal à prédire la nature du bruit, puis on supprime le bruit de l'image étape par étape jusqu'à ce que les données d'origine soient récupérées.

Contrairement aux anciens GAN, qui souffraient souvent d'instabilité lors de l'entraînement, les modèles de diffusion sont plus stables et évolutifs, bien qu'ils puissent être plus lents en raison de leur nature itérative.

Les variantes modernes telles que la diffusion latente fonctionnent dans un « espace latent » compressé afin d'accélérer la génération, et les architectures de correspondance de flux remplacent désormais la diffusion standard pour des performances encore meilleures.

Comment fonctionne l'architecture Transformer et quel est son principal obstacle ?

L'architecture du architecture du transformateur présentée dans l'article « Attention is All You Need »a révolutionné le domaine de l'IA générative, en particulier dans le traitement du langage naturel (NLP).

Contrairement aux réseaux neuronaux récurrents (RNN) traditionnels, qui traitent les données de manière séquentielle, les transformateurs utilisent le mécanisme d'auto-attention pour attribuer simultanément des poids à différentes parties des données d'entrée. Cela permet au modèle de saisir efficacement les relations contextuelles et autorise le traitement parallèle des séquences, ce qui accélère considérablement l'apprentissage.

Le principal obstacle réside dans le fait que ce mécanisme d'attention évolue de manière quadratique avec la longueur de la séquence : doubler la fenêtre contextuelle nécessite quatre fois plus de puissance de calcul. Cela rend le « contexte infini » théoriquement possible, mais coûteux en termes de calcul, ce qui stimule la recherche vers des méthodes d'attention plus efficaces.

Qu'est-ce qu'un « modèle de raisonnement » (pensée du système 2) et en quoi diffère-t-il d'un LLM standard ?

Les LLM standard fonctionnent comme des penseurs de « type 1 », prédisant immédiatement le mot suivant en se basant sur des modèles superficiels.

Les modèles de raisonnement (tels que Gemini 3 ou DeepSeek-R1) sont formés pour générer une « chaîne de pensée » cachée avant de fournir une réponse, ce qui leur permet de « réfléchir », de planifier et de corriger eux-mêmes leurs erreurs. Cela les rend nettement plus performants pour les calculs mathématiques complexes, le codage et les casse-têtes logiques, bien qu'ils soient plus lents et plus coûteux à exploiter.

Pourriez-vous nous parler des défis liés à la création de contenu haute résolution ou long format à l'aide de l'IA générative ?

À mesure que vous augmentez la complexité de la génération d'IA, vous devriez également vous attaquer aux aspects suivants :

- Coût de calcul : Les sorties haute résolution nécessitent des réseaux plus importants et une plus grande puissance de calcul.

- Formation multi-GPU : Les modèles plus volumineux peuvent ne pas être compatibles avec un seul GPU, ce qui nécessite un entraînement multi-GPU. Les plateformes en ligne peuvent réduire la complexité liée à la mise en œuvre de tels systèmes.

- Stabilité de la formation : Les réseaux plus vastes et les architectures plus complexes rendent plus difficile le maintien d'une procédure de formation stable.

- Qualité des données : Une résolution plus élevée et un contenu plus long nécessitent des données de meilleure qualité.

Quelles sont les tendances émergentes et les axes de recherche dans le domaine de l'IA générative ?

Le domaine de l'IA générative évolue et se transforme à un rythme soutenu. Cela comprend :

- Modèles multimodaux: Intégration de plusieurs formats de données, tels que du texte, de l'audio et des images.

- Modèles linguistiques de petite taille (SLM) : Contrairement aux grands modèles linguistiques, les SLM gagnent en popularité en raison de leur efficacité et de leur adaptabilité. Ces modèles nécessitent moins de ressources informatiques, ce qui les rend adaptés à un déploiement dans des environnements aux capacités limitées. Pour en savoir plus, veuillez consulter cet article de blog sur l'IA de pointe.

- s éthiques en matière d'IA: Développer des cadres pour garantir la performance harmonisée des modèles génératifs.

- Modèles génératifs pour l'vidéo: Progrès dans la création de vidéos ultra-réalistes et cohérentes grâce à GenAI. Parmi les exemples les plus récents, on peut citer Sora AI, Meta Movie Genet Runway Act-One.

Comment concevriez-vous un système utilisant l'IA générative pour créer du contenu personnalisé dans un secteur spécifique, tel que celui de la santé ?

La conception d'un système utilisant l'IA générative pour des cas d'utilisation spécifiques à l'industrie constitue une approche approfondie. Les directives générales peuvent également être adaptées et modifiées pour d'autres secteurs.

- Comprendre les besoins du secteur : La connaissance du domaine d'une industrie a un effet majeur sur les décisions qui mènent à la conception d'un tel système. La première étape consiste à acquérir des connaissances générales et pratiques sur le secteur, ses principes fondamentaux, ses concepts, ses objectifs et ses exigences.

- Collecte et gestion des données : Veuillez identifier les fournisseurs de données potentiels. Dans le domaine des soins de santé, cela implique la collecte de données auprès des prestataires de soins concernant les détails des traitements, les informations sur les patients, les directives médicales, etc. Les garde-fous spécifiques à l'industrie dela protection des données et de la sécurité des données doivent être identifiés et respectés. Veuillez vous assurer que les données sont de haute qualité, précises, à jour et représentatives de la diversité des groupes.

- Sélection du modèle : Déterminez s'il est préférable d'ajuster les modèles pré-entraînés ou de concevoir vos architectures à partir de zéro. Selon le type de projet, les modèles d'IA générative optimaux peuvent varier. Un modèle tel que GPT-4o pourrait constituer un choix prêt à l'emploi approprié. Certains domaines peuvent nécessiter des modèles hébergés localement pour des raisons de confidentialité. Dans ce cas, les modèles open source constituent la solution idéale. Veuillez envisager d'affiner ces modèles à partir des données spécifiques à votre secteur que vous avez précédemment recueillies.

- Validation des résultats : Mettre en place un processus d'évaluation approfondi dans lequel les experts et les professionnels valident le contenu généré avant sa mise en pratique.

- Évolutivité : Concevez une infrastructure cloud évolutive capable de gérer les charges requises sans compromettre les performances.

- Considérations juridiques et éthiques : Définissez des directives éthiques claires pour l'utilisation de l'IA et communiquez de manière transparente les limites éventuelles de votre modèle. Veuillez respecter les droits de propriété intellectuelle et traiter toute question qui s'y rapporte.

- Amélioration continue : Veuillez examiner régulièrement les performances du système et l'évaluation des experts concernant le contenu généré. Recueillez davantage d'informations et de données afin d'améliorer le modèle.

Veuillez expliquer le concept d'« apprentissage en contexte » dans le cadre des modèles d'apprentissage automatique à grande échelle (LLM).

L'apprentissage contextuel fait référence à la capacité des LLM à adapter leur style et leurs résultats en fonction du contexte fourni, sans nécessiter de réglage supplémentaire.

On pourrait également parler de apprentissage en quelques essais ou ingénierie de prompt. Cela pourrait être réalisé en spécifiant un ou plusieurs exemples de la réponse souhaitée ou en décrivant clairement comment le modèle devrait se comporter.

L'apprentissage en contexte présente également certaines limites. Il s'agit d'une approche à court terme et spécifique à une tâche, car le modèle ne conserve pas réellement les connaissances acquises lors d'autres sessions utilisant cette technique.

De plus, si le résultat requis est complexe, le modèle pourrait nécessiter un grand nombre d'exemples. Si les exemples fournis ne sont pas suffisamment clairs ou si la tâche est plus complexe que ce que le modèle peut gérer, il peut parfois générer des résultats incorrects ou incohérents.

Comment concevoir stratégiquement des invites afin d'obtenir les comportements ou les résultats souhaités du modèle ? Quelles sont les meilleures pratiques pour une ingénierie efficace des invites ?

Il est essentiel de fournir des instructions pour guider les modèles d'apprentissage automatique (LLM) dans l'exécution de tâches spécifiques. Des invites efficaces peuvent même réduire le besoin d'ajuster les modèles en utilisant des techniques telles que l'apprentissage en quelques essais, la décomposition des tâches et les modèles d'invites.

Certaines meilleures pratiques pour une ingénierie efficace et rapide comprennent :

- Soyez clair et concis: Veuillez fournir des instructions précises afin que le modèle sache exactement quelle tâche vous souhaitez qu'il accomplisse. Soyez franc et allez droit au but.

- Exemples d'utilisation: Pour l'apprentissage en contexte, présenter quelques paires d'entrées-sorties aide le modèle à comprendre la tâche comme vous le souhaitez.

- Décomposez les tâches complexes: Si la tâche est complexe, la diviser en étapes plus petites peut améliorer la qualité de la réponse.

- Définir des contraintes ou des formats: Si vous avez besoin d'un style, d'un format ou d'une longueur de sortie spécifiques, veuillez indiquer clairement ces exigences dans la demande.

Pour en savoir plus, veuillez consulter ce blog sur les Techniques d'optimisation rapide.

Quelles sont les techniques permettant d'optimiser la vitesse d'inférence des modèles d'IA générative ?

- Élagage du modèle : Suppression des poids/couches inutiles afin de réduire la taille du modèle.

- Quantification: Réduire la précision des poids du modèle à fp16/int8.

- Distillation des connaissances: Former un modèle plus petit pour reproduire un modèle plus grand.

- Accélération GPU : Utilisation de matériel spécialisé.

Pourriez-vous expliquer le concept de « génération conditionnelle » et comment il est appliqué dans des modèles tels que les GAN conditionnels (cGAN) ?

La génération conditionnelle implique que le modèle génère des résultats en fonction de certaines conditions ou contextes. Cela permet un meilleur contrôle sur le contenu généré. Dans les GAN conditionnels (cGAN), le générateur et le discriminateur sont tous deux conditionnés par des informations supplémentaires, telles que les étiquettes de classe. Voici comment cela fonctionne :

- Générateur : Reçoit à la fois des informations sur le bruit et des informations conditionnelles (par exemple, une étiquette de classe) afin de produire des données qui correspondent à la condition.

- Discriminateur : Évalue l'authenticité des données générées tout en tenant compte des informations conditionnelles.

Pourriez-vous expliquer l'architecture Mixture of Experts (MoE) ? Pourquoi est-il préféré pour les modèles de grande taille ?

Le mélange d'experts (MoE) remplace un réseau neuronal dense unique par de nombreux sous-réseaux « experts » spécialisés. Pour chaque jeton, un routeur sélectionne uniquement les experts les plus pertinents pour traiter les données, ce qui signifie qu'un modèle peut avoir 100 milliards de paramètres, mais n'en utiliser que 10 milliards pour l'inférence.

Cette architecture permet aux modèles d'être extrêmement intelligents (nombre total de paramètres élevé) tout en restant rapides et peu coûteux à exécuter (nombre de paramètres actifs faible).

Questions d'entretien sur l'IA générative pour un ingénieur en IA

Si vous postulez pour un poste d'ingénieur en IA spécialisé dans l'IA générative, attendez-vous à des questions visant à évaluer votre capacité à concevoir, mettre en œuvre et déployer des modèles génératifs.

Qu'est-ce qu'un workflow agentique par rapport à un chatbot standard ?

Un chatbot standard est passif : il reçoit une requête et fournit une réponse textuelle basée sur son apprentissage.

Un flux de travail agentique permet au LLM d'accéder à des outils (tels qu'un navigateur Web, un interpréteur de code ou une API) et lui confère l'autonomie nécessaire pour planifier un processus en plusieurs étapes afin d'atteindre un objectif. L'agent pourrait envisager d'effectuer des recherches sur le Web, d'analyser les données à l'aide du code Python, puis de rédiger un rapport, en répétant ces opérations jusqu'à ce que la tâche soit terminée.

Comment garantissez-vous la sécurité et la robustesse du déploiement de LLM à l'aide de Guardrails ?

Garantir la sécurité et la robustesse des LLM présente plusieurs défis. L'un des principaux défis réside dans le risque de générer des résultats préjudiciables ou biaisés, car ces modèles sont entraînés à partir de sources de données volumineuses, voire non filtrées, et peuvent produire des contenus toxiques ou trompeurs.

Un autre problème majeur lié au contenu généré par les modèles LLM est le risque d'hallucination, c'est-à-dire lorsque le modèle génère un contenu qui semble fiable, mais qui contient en réalité des informations incorrectes. Un autre défi concerne la sécurité contre les invites malveillantes qui enfreignent les mesures de sécurité du modèle et produisent des réponses nuisibles ou contraires à l'éthique, comme cela a été démontré à maintes reprises pour divers modèles.

L'intégration de filtres de sécurité et de niveaux de modération peut contribuer à identifier et à supprimer les contenus préjudiciables qui sont générés. La surveillance continue par l'intervention humaine renforce encore davantage la sécurité du modèle.

De plus, les ingénieurs doivent mettre en place des garde-fous explicites (tels que NeMo Guardrails ou Llama Guard) qui se situent entre l'utilisateur et le modèle. Ces systèmes analysent les entrées afin de bloquer les tentatives d'injection de commandes ou les fuites d'informations personnelles identifiables (PII) et analysent les sorties afin de détecter les réponses toxiques ou inappropriées avant qu'elles n'atteignent l'utilisateur. Cela crée une couche de sécurité déterministe qui fonctionne indépendamment de la nature probabiliste du modèle.

Veuillez décrire un projet ambitieux impliquant l'IA générative auquel vous avez participé. Quels ont été les principaux défis rencontrés et comment les avez-vous surmontés ?

La réponse à cette question dépend fortement de vos projets et de vos expériences. Vous pouvez toutefois garder ces points à l'esprit lorsque vous répondez à des questions de ce type :

- Veuillez sélectionner un projet spécifique présentant des défis clairs en matière d'IA, tels que les biais, la précision des modèles ou les hallucinations.

- Veuillez clarifier le défi et expliquez la difficulté technique ou opérationnelle.

- Veuillez présenter votre approche en mentionnant les stratégies clés que vous avez mises en œuvre, telles que l'augmentation des données, l'ajustement des modèles ou la collaboration avec des experts.

- Mettre en évidence les résultats et quantifier l'impact : amélioration de la précision, meilleur engagement des utilisateurs ou résolution d'un problème commercial.

Pourriez-vous nous faire part de votre expérience en matière de mise en œuvre et de déploiement de modèles d'IA générative dans des environnements de production ?

Tout comme la question précédente, vous pouvez répondre à cette question en vous basant sur votre expérience, mais en gardant également à l'esprit les points suivants :

- Veuillez vous concentrer sur l'du déploiement: Veuillez mentionner les infrastructures (cloud services, MLOps ) et les tâches de déploiement clés (mise à l'échelle, optimisation à faible latence). Il n'est pas nécessaire d'entrer dans les détails. Il suffit de démontrer que vous maîtrisez parfaitement la situation.

- Veuillez mentionner un défi: Il est utile de mentionner un ou deux défis courants à éviter, afin de démontrer votre expertise.

- Couverture de l'post-déploiement: Intégrer des stratégies de surveillance et de maintenance afin de garantir des performances constantes.

- Adresse de l' s de sécurité: Veuillez mentionner toutes les mesures prises pour gérer les préjugés ou la sécurité pendant le déploiement.

Comment gérez-vous le phénomène de « perte au milieu » dans les fenêtres de texte long ?

Même avec des fenêtres contextuelles de grande taille (par exemple, 1 million de tokens), les LLM ont souvent des difficultés à extraire les informations enfouies au milieu de l'invite, privilégiant le début et la fin.

Les ingénieurs atténuent ce problème en utilisant des algorithmes de reclassement intelligents qui déplacent les fragments les plus importants vers le début ou la fin de la fenêtre contextuelle. Une autre stratégie consiste à utiliser l'algorithme « map-reduce », dans lequel le modèle résume indépendamment les sections du long document avant de les combiner pour obtenir une réponse finale.

Comment aborderiez-vous la tâche de construire un système RAG de bout en bout ?

La mise en place d'un système RAG nécessite une approche systématique. Voici à quoi pourrait ressembler le pipeline :

- Découpage efficace : Utilisez des stratégies sémantiques ou récursives pour diviser les documents en segments significatifs (plutôt que par nombre arbitraire de caractères) afin de garantir la préservation du contexte.

- Stockage vectoriel : Intégrez ces fragments à l'aide d'un modèle d'intégration hautement performant et stockez-les dans une base de données vectorielle, en y joignant des métadonnées riches (telles que des dates ou des auteurs) pour le pré-filtrage.

- Recherche hybride : Mettre en œuvre une couche de récupération qui combine la recherche par mot-clé (BM25) pour les correspondances exactes avec la recherche vectorielle (similarité sémantique) afin de capturer à la fois des termes spécifiques et des concepts plus larges.

- Nouveau classement : Appliquez un modèle d'encodeur croisé pour réévaluer les meilleurs résultats récupérés, en filtrant de manière proactive les éléments non pertinents avant qu'ils n'atteignent le LLM.

- Citation et génération : Veuillez demander au LLM de générer des réponses strictement basées sur le contexte fourni et exigez qu'il cite des documents sources spécifiques afin d'éviter toute hallucination.

Quelles sont les questions ou les domaines de recherche ouverts qui vous intéressent le plus dans le domaine de l'IA générative ?

La réponse dépend ici également de vos préférences personnelles, mais voici quelques sujets que vous pouvez aborder :

- Amélioration de l'interprétabilité des modèles : Rendre les modèles génératifs plus transparents et plus faciles à interpréter.

- Cadres éthiques : Élaboration de lignes directrices pour une IA responsable.

- Génération intermodale : Création de contenu à partir de plusieurs types de données (images, texte, etc.).

- Robustesse face à l'adversité : Rendre les modèles résistants aux attaques adversaires.

- Capacités de raisonnement : Améliorer la capacité de raisonnement des modèles d'apprentissage profond.

Conclusion

Alors que l'IA générative influence de plus en plus divers aspects de notre vie et de notre carrière, il est essentiel de rester attentif aux sujets essentiels. Bien que les questions potentielles relatives à l'IA générique pouvant être posées lors d'un entretien dépendent du poste et de l'entreprise concernés, j'ai sélectionné 30 questions et réponses afin de vous aider à préparer votre entretien.

Pour découvrir d'autres questions d'entretien, je vous recommande les blogs suivants :

- Les 30 questions et réponses les plus fréquentes lors des entretiens pour les masters en droit (LLM) en 2026

- Les 30 questions et réponses les plus fréquentes lors des entretiens RAG pour 2026

- Les 30 questions et réponses les plus fréquentes lors d'entretiens d'embauche dans le domaine de l'IA, pour tous les niveaux de compétence

Étudiante en master d'intelligence artificielle et rédactrice technique en intelligence artificielle. Je partage mes connaissances sur les dernières technologies de l'IA, en rendant la recherche en ML accessible et en simplifiant les sujets complexes liés à l'IA afin que vous restiez à la pointe du progrès.