Programa

Geração aumentada por recuperação (RAG) combina grandes modelos de linguagem (LLMs) com sistemas de recuperação para trazer informações externas relevantes durante o processo de geração de texto.

Nos últimos anos, o RAG ganhou bastante força e virou um assunto comum nas perguntas de entrevistas para cargos como engenheiro de IA. engenheiro de IA, engenheiro de machine learning, engenheiro de prompte cientista de dados.

Este artigo quer te ajudar a se preparar para perguntas relacionadas ao RAG em entrevistas, oferecendo uma visão geral completa de 30 perguntas importantes, que vão desde conceitos básicos até assuntos mais avançados.

Mesmo que você não esteja se preparando para uma entrevista em breve, este artigo pode ser uma boa chance de testar seus conhecimentos sobre RAG.

Torne-se um cientista de ML

Perguntas básicas para entrevistas RAG

Vamos começar com uma série de perguntas fundamentais sobre o RAG.

Explique as principais partes de um sistema RAG e como elas funcionam.

Um sistema RAG (geração aumentada por recuperação) tem dois componentes principais: o recuperador e o gerador.

O recuperador procura e coleta informações relevantes de fontes externas, como bancos de dados. bancos de dados, documentos ou sites.

O gerador, geralmente um modelo de linguagem avançado, usa essas informações para criar um texto claro e preciso.

O recuperador garante que o sistema receba as informações mais atualizadas, enquanto o gerador combina isso com seu próprio conhecimento para produzir respostas melhores.

Juntos, eles dão respostas mais precisas do que o gerador conseguiria sozinho.

Quais são as principais vantagens de usar o RAG em vez de só contar com o conhecimento interno de um LLM?

Se você confiar só no conhecimento que vem no LLM, o sistema vai ficar limitado ao que foi treinado, o que pode estar desatualizado ou sem detalhes.

Os sistemas RAG oferecem uma grande vantagem ao obter informações atualizadas de fontes externas, resultando em respostas mais precisas e oportunas.

Essa abordagem também reduz as “alucinações” — erros em que o modelo inventa fatos — porque as respostas são baseadas em dados reais. O RAG é especialmente útil para áreas específicas como direito, medicinaou tecnologia, onde é necessário ter conhecimento atualizado e especializado.

Quais são algumas das aplicações mais comuns do RAG?

O RAG é usado em várias aplicações de IA do mundo real em diferentes áreas:

-

Sistemas de perguntas e respostas e de suporte: O RAG ajuda os chatbots de suporte ao cliente e os assistentes da base de conhecimento a pegar documentação atualizada ou perguntas frequentes e gerar respostas precisas para os usuários. Isso garante que as dúvidas dos clientes sejam resolvidas com as informações mais recentes (por exemplo, pegando informações atuais sobre políticas ou detalhes de produtos).

-

Agentes conversacionais: Muitos chatbots e assistentes virtuais usam RAG para dar respostas factuais e que entendem o contexto. Ao buscar informações relevantes na hora, um agente conversacional (como um chatbot de saúde ou finanças) pode dar respostas bem informadas, baseadas em fontes confiáveis.

-

Criação e resumo de conteúdo: O RAG ajuda a criar ou resumir conteúdo com precisão factual. Por exemplo, ele pode pegar partes de notícias ou artigos de pesquisa e criar resumos ou relatórios que são coerentes e verificados com base nos dados originais.

-

Pesquisa específica do domínio: Em áreas especializadas, como direito ou medicina, os sistemas RAG ajudam a responder perguntas complexas usando bancos de dados específicos do domínio (jurisprudência, revistas médicas, etc.). Assim, o resultado do modelo é baseado em conhecimento confiável e atualizado sobre o assunto, o que é importante para casos de uso profissional.

Que tipos de fontes de conhecimento externas o RAG pode usar?

Os sistemas RAG podem coletar informações de fontes externas estruturadas e não estruturadas:

- Fontes estruturadas incluem bancos de dados, APIs ou gráficos de conhecimento, onde os dados são organizados e fáceis de pesquisar.

- Fontes não estruturadas são grandes coleções de texto, como documentos, sites ou arquivos, onde as informações precisam ser processadas usando compreensão de linguagem natural.

Essa flexibilidade permite que os sistemas RAG sejam adaptados a diferentes áreas, como uso jurídico ou médico, usando bancos de dados de jurisprudência, revistas científicas ou dados de ensaios clínicos.

A engenharia de prompt é importante no RAG?

A engenharia de prompts ajuda os modelos de linguagem a fornecer respostas de alta qualidade usando as informações recuperadas. A forma como você cria um prompt pode afetar a relevância e a clareza do resultado.

- Modelos específicos de prompts do sistema ajudam a orientar o modelo. Por exemplo, em vez de ter um prompt simples e pronto para uso como “Responda à pergunta”, você pode ter “Responda à pergunta com base apenas no contexto fornecido”. Isso dá ao modelo instruções claras para usar só o contexto fornecido para responder à pergunta, o que pode diminuir a chance de alucinações.

- O prompting de poucos exemplos é quando você dá alguns exemplos de respostas pro modelo antes de pedir pra ele gerar as próprias, pra que ele saiba o tipo de resposta que você tá procurando.

- O prompting da cadeia de pensamento ajuda a decompor questões complexas, incentivando o modelo a explicar seu raciocínio passo a passo antes de responder.

Como o recuperador funciona em um sistema RAG? Quais são os métodos comuns de recuperação?

Num sistema RAG, o recuperador junta informações relevantes de fontes externas para o gerador usar. Tem várias maneiras de pegar informações.

Um método é a recuperação esparsa, que combina palavras-chave (por exemplo, TF-IDF ou BM25). Isso é simples, mas pode não captar o significado mais profundo por trás das palavras.

Outra abordagem é a recuperação densa, que usa embeddings neurais para entender o significado de documentos e consultas. Métodos como BERT ou Dense Passage Retrieval (DPR) mostram documentos como vetores num espaço compartilhado, tornando a recuperação mais precisa.

A escolha entre esses métodos pode afetar bastante o funcionamento do sistema RAG.

Quais são os desafios de juntar as informações recuperadas com a geração de LLM?

Combinar as informações recuperadas com a geração de um LLM traz alguns desafios. Por exemplo, os dados recuperados precisam ser bem relevantes para a consulta, porque dados irrelevantes podem confundir o modelo e diminuir a qualidade da resposta.

Além disso, se as informações recuperadas entrarem em conflito com o conhecimento interno do modelo, isso pode gerar respostas confusas ou imprecisas. Por isso, resolver esses conflitos sem confundir o usuário é super importante.

Por fim, o estilo e o formato dos dados recuperados podem nem sempre combinar com a escrita ou formatação normal do modelo, dificultando a integração suave das informações pelo modelo.

Qual é o papel de um banco de dados vetorial no RAG?

Em um sistema RAG, um banco de dados vetorial ajuda a gerenciar e armazenar de texto. Essas incorporações são representações numéricas que capturam o significado de palavras e frases, criadas por modelos como BERT ou OpenAI.

Quando alguém faz uma consulta, a incorporação dela é comparada com as que estão guardadas no banco de dados pra achar documentos parecidos. Isso torna mais rápido e preciso recuperar as informações certas. Esse processo ajuda o sistema a localizar e acessar rapidamente as informações mais relevantes, melhorando tanto a velocidade quanto a precisão da recuperação.

Quais são algumas maneiras comuns de avaliar os sistemas RAG?

Para avaliar um sistema RAG, você precisa analisar os componentes de recuperação e geração.

- Para o recuperador, você avalia a precisão e a relevância dos documentos recuperados. Métricas comoprecisão ( ) (quantos documentos recuperados são relevantes) e recall (quantos do total de documentos relevantes foram encontrados) podem ser usadas aqui.

- Para o gerador, métricas como BLEU e ROUGE podem ser usadas pra comparar o texto gerado com exemplos escritos por humanos pra avaliar a qualidade.

Para tarefas a jusante, como responder perguntas, métricas como pontuação F1e precisãoe recall também podem ser usados para avaliar o sistema RAG como um todo.

Como você lida com consultas ambíguas ou incompletas em um sistema RAG para garantir resultados relevantes?

Lidar com consultas ambíguas ou incompletas em um sistema RAG precisa de estratégias para garantir que informações relevantes e precisas sejam recuperadas, mesmo que a entrada do usuário não seja muito clara.

Uma abordagem é implementar técnicas de refinamento de consulta, em que o sistema automaticamente sugere esclarecimentos ou reformula a consulta ambígua em uma mais precisa, com base em padrões conhecidos ou interações anteriores. Isso pode envolver fazer perguntas complementares ou dar várias opções para o usuário, pra ajudar a entender melhor o que ele quer.

Outro jeito é pegar um conjunto variado de documentos que abranjam várias interpretações possíveis da consulta. Ao buscar vários resultados, o sistema garante que, mesmo que a consulta seja meio vaga, algumas informações relevantes provavelmente vão aparecer.

Por fim, podemos usar modelos de compreensão de linguagem natural (NLU) para entender o que o usuário quer mesmo quando a consulta está incompleta e melhorar o processo de busca.

Perguntas para entrevistas RAG intermediárias

Agora que já falamos sobre algumas perguntas básicas, é hora de passar para as perguntas intermediárias da entrevista RAG.

Como escolher o recuperador certo para uma aplicação RAG?

Escolher o recuperador certo depende do tipo de dados com que você está trabalhando, da natureza das consultas e da capacidade de computação que você tem.

Para consultas complexas que exigem uma compreensão profunda do significado por trás das palavras, métodos de recuperação densos como BERT ou DPR são melhores. Esses métodos capturam o contexto e são ideais para tarefas como suporte ao cliente ou pesquisa, onde entender os significados subjacentes é importante.

Se a tarefa for mais simples e girar em torno da correspondência de palavras-chave, ou se você tiver recursos computacionais limitados, métodos de recuperação esparsos, como BM25 ou TF-IDF, podem ser mais adequados. Esses métodos são mais rápidos e fáceis de configurar, mas podem não encontrar documentos que não correspondam exatamente às palavras-chave.

A principal diferença entre os métodos de recuperação densa e esparsa é a precisão versus o custo computacional. Às vezes, juntar as duas abordagens num sistema híbrido de recuperação pode ajudar a equilibrar a precisão com a eficiência computacional. eficiência computacional. Assim, você aproveita os benefícios dos métodos densos e esparsos, dependendo do que precisar.

Explique o que é uma pesquisa híbrida.

A pesquisa híbrida junta o que há de melhor nos métodos de recuperação densa e esparsa.

Por exemplo, você pode começar com um método esparso como o BM25 para encontrar rapidamente documentos com base em palavras-chave. Então, um método denso como o BERT reclassifica esses documentos, entendendo seu contexto e significado. Isso te dá a velocidade da pesquisa esparsa com a precisão dos métodos densos, o que é ótimo para consultas complexas e grandes conjuntos de dados.

Você precisa de um banco de dados vetorial para implementar o RAG? Se não, quais são as alternativas?

Um banco de dados vetorial é ótimo para gerenciar embeddings densos, mas nem sempre é necessário. As alternativas incluem:

- Bancos de dados tradicionais: Se você estiver usando métodos esparsos ou dados estruturados, bancos de dados relacionais regulares ou nosql podem ser suficientes. Eles funcionam bem para pesquisas por palavras-chave. Bancos de dados como MongoDB ou Elasticsearch são bons para lidar com dados não estruturados e pesquisas de texto completo, mas não têm pesquisa semântica profunda.

- Índices invertidos: Essas palavras-chave mapeiam documentos para pesquisas rápidas, mas não capturam o significado por trás das palavras.

- Sistemas de arquivos: Para sistemas menores, documentos organizados e guardados em arquivos podem funcionar, mas têm recursos de pesquisa limitados.

A escolha certa depende das suas necessidades específicas, como o tamanho dos seus dados e se você precisa de um entendimento semântico profundo.

Como você pode garantir que as informações recuperadas sejam relevantes e precisas?

Para garantir que as informações recuperadas sejam relevantes e precisas, você pode usar várias abordagens:

- Crie bases de conhecimento de alta qualidade: Certifique-se de que as informações em seu banco de dados sejam confiáveis e atendam às necessidades de sua aplicação.

- Ajustar o recuperador: Ajuste o modelo do recuperador para que ele se adapte melhor às suas tarefas e necessidades específicas. Isso ajuda a melhorar a relevância dos resultados.

- Use a reclassificação: Depois de pegar os primeiros resultados, organize-os com base na relevância detalhada para conseguir as informações mais precisas. Essa etapa envolve verificar com mais profundidade se os resultados correspondem à consulta.

- Implementar ciclos de feedback: Pede a opinião dos usuários ou modelos sobre a utilidade dos resultados. Esse feedback pode ajudar a refinar e melhorar o recuperador ao longo do tempo. Um exemplo disso é o RAG corretivo (CRAG).

- Avaliação regular: Mede sempre o desempenho do sistema usando métricas como precisão, recall ou pontuação F1 para continuar melhorando a exatidão e a relevância.

Quais são algumas técnicas para lidar com documentos longos ou grandes bases de conhecimento no RAG?

Quando você estiver lidando com documentos longos ou grandes bases de conhecimento, aqui vão algumas dicas úteis:

- Chunking: Divida documentos longos em seções menores e mais fáceis de lidar. Isso facilita a pesquisa e a recuperação de partes relevantes sem precisar processar o documento inteiro.

- Resumo: Crie versões resumidas de documentos longos. Isso permite que o sistema trabalhe com resumos mais curtos em vez do texto completo, acelerando a recuperação.

- Recuperação hierárquica: Use uma abordagem em duas etapas, na qual você primeiro procura categorias amplas de informações e depois restringe a pesquisa a detalhes específicos. Isso ajuda a gerenciar grandes quantidades de dados de forma mais eficaz.

- Incorporações eficientes em termos de memória: Use representações vetoriais compactas para reduzir a quantidade de memória e poder computacional necessários. Otimizar o tamanho das incorporações pode facilitar o manuseio de grandes conjuntos de dados.

- Indexação e fragmentação: Divida a base de conhecimento em partes menores e guarde-as em vários sistemas. Isso permite o processamento paralelo e uma recuperação mais rápida, especialmente em sistemas de grande escala.

Como você pode otimizar o desempenho de um sistema RAG em termos de precisão e eficiência?

Para obter o melhor desempenho de um sistema RAG em termos de precisão e eficiência, você pode usar várias estratégias:

- Ajustar modelos: Ajuste os modelos do recuperador e do gerador usando dados específicos para sua tarefa. Isso ajuda a melhorar o desempenho em consultas específicas.

- Indexação eficiente: Organize sua base de conhecimento usando estruturas de dados rápidas, como índices invertidos ou hash. Isso agiliza o processo de encontrar informações relevantes.

- Use o cache: Guarde os dados que você usa sempre pra não precisar ficar pegando eles de novo. Isso melhora a eficiência e agiliza as respostas.

- Reduza as etapas de recuperação: Tenta não ficar procurando informações o tempo todo. Melhore a precisão do recuperador ou use a reclassificação para garantir que apenas os melhores resultados sejam passados para o gerador, reduzindo o processamento desnecessário.

- Pesquisa híbrida: Junte métodos de recuperação esparsos e densos. Por exemplo, use a recuperação esparsa para encontrar rapidamente um conjunto amplo de documentos relevantes e, em seguida, aplique a recuperação densa para refinar e classificar esses resultados com mais precisão.

Como um sistema RAG mantém o contexto em uma conversa com várias respostas?

Em conversas com várias rodadas (por exemplo, um diálogo com um chatbot), um sistema RAG precisa levar em conta o contexto relevante das rodadas anteriores para responder corretamente às perguntas posteriores. Para conseguir isso, o RAG pode incluir o histórico de conversas em cada nova consulta:

-

Refinamento da consulta: O sistema pode reescrever ou aumentar automaticamente a pergunta do usuário usando informações de conversas anteriores. Ao adicionar detalhes de turnos anteriores, o recuperador obtém uma consulta mais rica em contexto, para que possa buscar documentos relevantes para a discussão em andamento.

-

Incluindo o histórico de conversas: Outra abordagem é dar ao modelo um resumo ou uma lista das conversas anteriores como parte do contexto de entrada. Muitas arquiteturas RAG permitem passar uma sequência de mensagens (histórico do usuário e do assistente) junto com a nova pergunta. Assim, quando o recuperador procura informações, ele leva em conta o contexto estabelecido, e o gerador pode usar o contexto anterior para manter uma conversa coerente.

Usando esses métodos, o sistema RAG fica de olho em “quem disse o quê” e o que já foi resolvido. Isso evita que ele esqueça detalhes ou se repita.

Perguntas avançadas para entrevistas RAG

Até agora, falamos sobre perguntas básicas e intermediárias de entrevistas RAG, e agora vamos abordar conceitos mais avançados, como técnicas de chunking ou contextualização.

Quais são as diferentes técnicas de fragmentação para dividir documentos e quais são suas vantagens e desvantagens?

Tem várias maneiras de dividir documentos para recuperação e processamento:

- Comprimento fixo: Dividindo documentos em partes de tamanho fixo. É fácil de fazer, mas às vezes os trechos podem não se alinhar com as quebras lógicas, então você pode acabar dividindo informações importantes ou incluindo conteúdo irrelevante.

- Baseado em frases: Dividir documentos em frases mantém as frases intactas, o que é ótimo para análises detalhadas. Mas, isso pode acabar com muitos pedaços ou perder o contexto quando as frases são curtas demais pra capturar as ideias completas.

- Baseado em parágrafos: Dividir por parágrafos ajuda a manter o contexto intacto, mas os parágrafos podem ser muito longos, tornando a recuperação e o processamento menos eficientes.

- Divisão semântica: Os blocos são criados com base no significado, como seções ou tópicos. Isso mantém o contexto claro, mas é mais difícil de implementar, pois requer uma análise de texto avançada.

- Janela deslizante: Os pedaços se sobrepõem ao deslizar sobre o texto. Isso garante que informações importantes não sejam perdidas, mas pode ser computacionalmente caro e resultar em informações repetidas.

Quais são as vantagens e desvantagens de dividir documentos em partes maiores ou menores?

Pedaços menores, tipo frases ou parágrafos curtos, ajudam a evitar que informações contextuais importantes se percam quando comprimidas em um único vetor. Mas isso pode fazer com que a gente perca dependências de longo alcance entre blocos, dificultando para os modelos entenderem referências que se estendem por vários blocos.

Pedaços maiores mantêm mais contexto, o que permite informações contextuais mais ricas, mas podem ser menos focados e as informações podem se perder ao tentar codificar todas as informações em um único vetor.

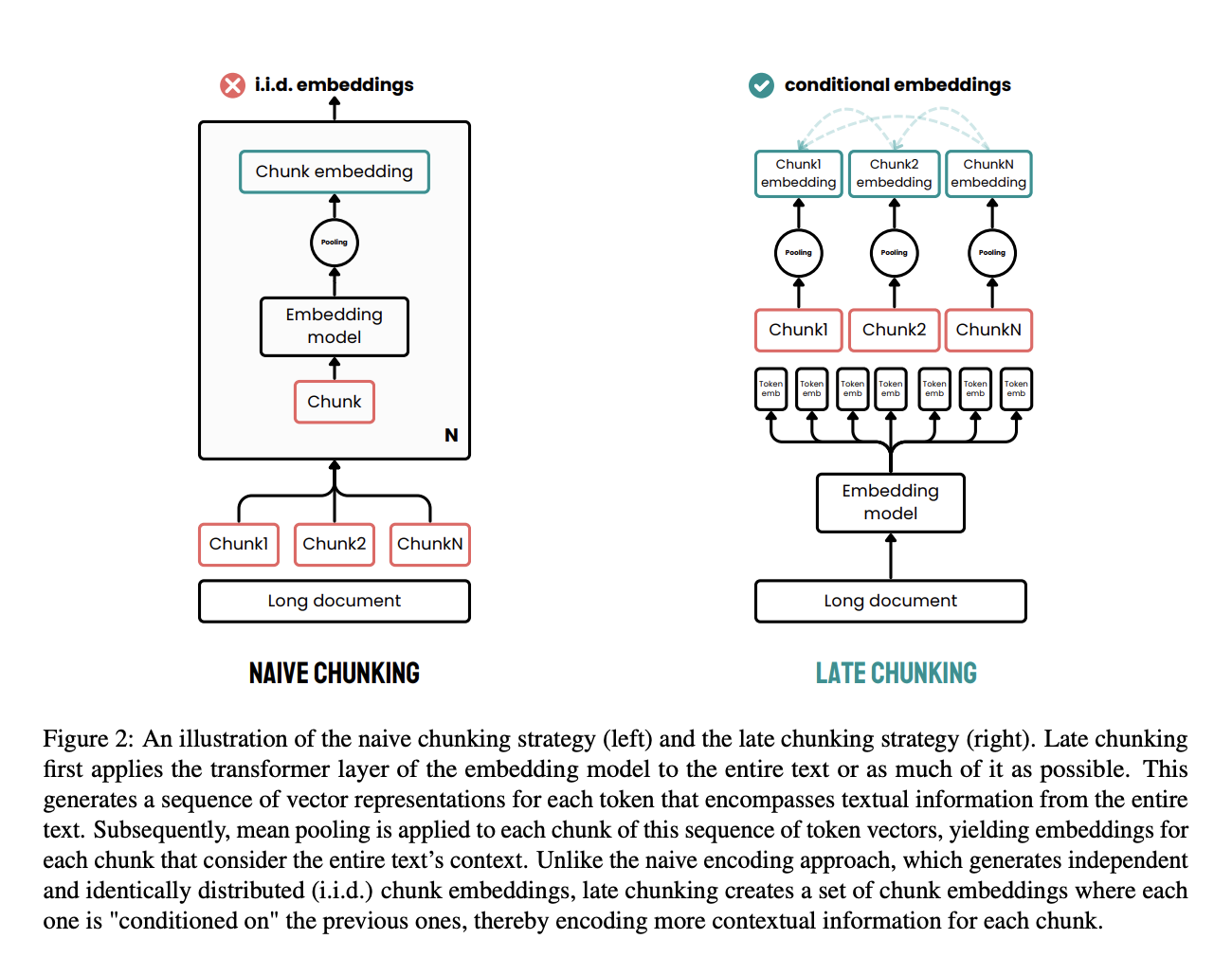

O que é o chunking tardio e como ele é diferente dos métodos tradicionais de chunking?

O chunking tardio é uma abordagem eficaz criada para resolver as limitações dos métodos tradicionais de chunking no processamento de documentos.

Nos métodos tradicionais, os documentos são primeiro divididos em partes, como frases ou parágrafos, antes de aplicar um modelo de incorporação. Esses pedaços são então codificados individualmente em vetores, muitas vezes usando agrupamento médio para criar uma única incorporação para cada pedaço. Essa abordagem pode levar à perda de dependências contextuais de longo alcance, porque as incorporações são geradas de forma independente, sem levar em conta todo o contexto do documento.

O chunking tardio usa uma abordagem diferente. Primeiro, aplica a camada transformadora do modelo de incorporação a todo o documento ou ao máximo possível dele, criando uma sequência de representações vetoriais para cada token. Esse método capta todo o contexto do texto nessas incorporações em nível de token.

Depois, a média é aplicada aos pedaços dessa sequência de vetores de tokens, produzindo incorporações para cada pedaço que são informadas pelo contexto de todo o documento. Diferente do método tradicional, o chunking tardio gera embeddings de chunks que dependem uns dos outros, mantendo mais informações contextuais e resolvendo dependências de longo alcance.

Ao aplicar o chunking mais tarde no processo, isso garante que a incorporação de cada chunk aproveite o contexto rico fornecido por todo o documento, em vez de ficar isolada. Essa abordagem resolve o problema da perda de contexto e melhora a qualidade das incorporações usadas para tarefas de recuperação e geração.

Fonte: Günther et al., 2024

Explique o conceito de “contextualização” no RAG e como isso afeta o desempenho.

Contextualização em RAG significa garantir que as informações recuperadas sejam relevantes para a consulta. Ao alinhar os dados recuperados com a consulta, o sistema gera respostas melhores e mais relevantes.

Isso diminui as chances de resultados errados ou sem sentido e garante que o resultado final seja do jeito que o usuário quer. Uma abordagem é usar um LLM para verificar se os documentos recuperados são relevantes antes de enviá-los para o modelo gerador, como demonstrado pelo Corrective RAG (CRAG).

Como você pode lidar com possíveis vieses nas informações recuperadas ou na geração do LLM?

Primeiro, é essencial construir a base de conhecimento de forma a filtrar conteúdos tendenciosos, garantindo que as informações sejam o mais objetivas possível. Você também pode treinar de novo o sistema de busca pra priorizar fontes equilibradas e imparciais.

Outra coisa importante seria contratar alguém só para ficar de olho em possíveis vieses e garantir que o resultado do modelo continue sendo objetivo.

Discuta os desafios de lidar com bases de conhecimento dinâmicas ou em evolução no RAG.

Uma questão importante é manter os dados indexados atualizados com as informações mais recentes, o que exige um mecanismo de atualização confiável. Por isso, o controle de versão é super importante pra gerenciar as diferentes versões das informações e garantir que tudo fique consistente.

Além disso, o modelo precisa ser capaz de se adaptar a novas informações em tempo real, sem precisar ser treinado de novo com frequência, o que pode consumir muitos recursos. Esses desafios exigem soluções sofisticadas para garantir que o sistema continue preciso e relevante à medida que a base de conhecimento evolui.

O que é CAG e como ele difere do RAG tradicional? Quando você prefere usar CAG em vez de RAG na produção?

CAG (Cache-Augmented Generation) é uma evolução do RAG, onde os documentos recuperados são resumidos ou compactados antes de serem passados para o LLM. Isso melhora a relevância, reduz o uso de tokens e ajuda a encaixar mais informações na janela de contexto do modelo.

A principal diferença é que, no CAG, o conteúdo recuperado passa por uma etapa intermediária, como um resumidor ou refinador de contexto, antes de ser enviado para o gerador. Já o RAG tradicional passa os documentos brutos direto para o prompt.

O CAG é especialmente útil quando:

-

Você está trabalhando com conjuntos de dados estáticos (por exemplo, catálogos de produtos, artigos acadêmicos) que podem ser pré-compactados e armazenados em cache.

-

A eficiência do token é super importante (por exemplo, APIs sensíveis ao custo ou inferência móvel/no dispositivo).

-

Os documentos recuperados são longos ou confusos e precisam ser resumidos.

Já o RAG é melhor quando:

-

Os dados de base são dinâmicos ou atualizados com frequência (por exemplo, tickets de suporte em tempo real, documentação ao vivo).

-

Você quer usar o conhecimento mais recente na hora da consulta, sem precisar refazer toda a base de conhecimento.

Resumindo, use CAG para domínios estáveis, onde você pode otimizar o contexto com antecedência, e RAG para cenários dinâmicos, onde a atualização e a recuperação sob demanda são mais importantes.

Dá uma olhada nesse artigo sobre RAG versus CAG pra ver uma comparação mais detalhada.

Quais são alguns sistemas RAG avançados?

Tem vários sistemas RAG avançados.

Um desses sistemas é o Adaptive RAG (), onde o sistema não só pega as informações, mas também ajusta sua abordagem em tempo real com base na consulta. O RAG adaptativo pode decidir não fazer nenhuma recuperação, fazer uma única recuperação RAG ou fazer uma recuperação RAG iterativa. Esse jeito dinâmico de agir deixa o sistema RAG mais robusto e relevante para o que o usuário quer.

Outro sistema RAG avançado é o Agentic RAG, que traz os agentes de recuperação () — ferramentas que decidem se vão ou não pegar informações de uma fonte. Ao dar essa capacidade a um modelo de linguagem, ele pode decidir sozinho se precisa de mais informações, tornando o processo mais tranquilo.

O RAG corretivo (CRAG) também está ficando popular. Nessa abordagem, o sistema analisa os documentos que recupera, verificando sua relevância. Só os documentos que forem considerados relevantes vão ser enviados para o gerador. Essa etapa de autocorreção ajuda a garantir que informações precisas e relevantes sejam usadas. Para saber mais, dá uma olhada neste tutorial sobre Implementação do RAG corretivo (CRAG) com o LangGraph.

O Self-RAG vai além, avaliando não só os documentos encontrados, mas também as respostas finais geradas, garantindo que ambos estejam alinhados com a consulta do usuário. Isso leva a resultados mais confiáveis e consistentes.

Como você pode diminuir a latência em um sistema RAG em tempo real sem perder a precisão?

Uma abordagem eficaz é pré-buscar informações relevantes e comumente solicitadas para que estejam prontas quando precisar. Além disso, refinar seus algoritmos de indexação e consulta pode fazer uma grande diferença na rapidez com que os dados são recuperados e processados.

Quais são algumas das limitações ou desafios dos sistemas RAG?

Embora o RAG seja poderoso, ele tem várias limitações e desafios:

-

Dependência da qualidade dos dados recuperados: Um sistema RAG é tão bom quanto as informações que ele consegue. Se o recuperador puxar documentos irrelevantes ou incorretos, a resposta do gerador vai ser prejudicada. Garantir fontes de dados confiáveis e de alta qualidade (e ajustar o recuperador) é um desafio constante para evitar problemas de “lixo entra, lixo sai”.

-

Maior complexidade e latência: O RAG adiciona uma etapa extra de recuperação além da geração, o que torna todo o sistema mais complexo e pesado em termos computacionais do que um LLM independente. Pesquisar em uma base de conhecimento grande pode aumentar a latência e exigir muitos recursos de computação, então os sistemas RAG precisam equilibrar precisão e eficiência.

-

Precisa manter a base de conhecimento atualizada: Diferente dos LLMs estáticos, o RAG depende de um repositório de conhecimento externo que precisa ser atualizado e cuidado com frequência. As organizações precisam sempre pegar novos dados, tirar as informações que já não servem mais e cuidar dos índices. Sem fontes de dados confiáveis e atualizadas, um sistema RAG pode rapidamente se tornar menos eficaz ou até mesmo fornecer respostas desatualizadas.

-

Dificuldade de integração e ajuste: Juntar recuperação e geração significa mais coisas para ajustar e monitorar (o banco de dados vetorial, o modelo de recuperação e o LLM). Resolver erros pode ser mais complicado porque os problemas podem vir tanto do lado da recuperação quanto do lado da geração. Essa complexidade pode aumentar o esforço de desenvolvimento e manutenção em comparação com o uso exclusivo de um LLM.

Também vale a pena notar que, se os dados de um domínio forem bem estáticos e se encaixarem no treinamento do modelo, um LLM bem ajustado pode ser bom o suficiente no lugar do RAG. Mas, o ajuste fino não tem a capacidade do RAG de pegar novas informações na hora e pode ser mais caro treinar de novo a cada atualização de conhecimento.

Perguntas da entrevista RAG para engenheiros de IA

Agora, vamos abordar algumas questões específicas destinadas àqueles que estão se candidatando a vagas de engenheiro de IA.

Obtenha uma das melhores certificações de IA

Como você avaliaria e melhoraria o desempenho de um sistema RAG em um ambiente de produção?

Primeiro, você vai precisar de um programa para acompanhar o feedback dos usuários para ver como o sistema está funcionando e se ele é relevante.

Você também vai querer monitorar a latência para garantir que as respostas sejam rápidas e avaliar a qualidade dos documentos recuperados e dos resultados gerados. É importante ter métricas importantes como precisão de resposta, satisfação do usuário e rendimento do sistema são importantes.

Para melhorar o desempenho, você pode treinar de novo partes do sistema com dados atualizados ou ajustar os parâmetros. Você também pode refinar os algoritmos de recuperação para melhorar a relevância e a eficiência, além de atualizar regularmente as fontes de conhecimento para mantê-las atualizadas.

Avaliações contínuas de desempenho e testes A/B podem fornecer insights para melhorias contínuas.

Como você garante a confiabilidade e a robustez de um sistema RAG em produção, especialmente diante de possíveis falhas ou entradas inesperadas?

Criar um sistema RAG pronto para produção exige lidar com vários desafios. Algumas soluções possíveis podem ser:

- Redundância e failover: Implementar componentes redundantes ou sistemas de backup para garantir a operação contínua em caso de falhas.

- Tratamento de erros e registro de erros: Implementar mecanismos de tratamento de erros para detectar e registrar erros, permitindo um diagnóstico rápido e a resolução de problemas.

- Validação e sanitização de entradas: Validar e limpar as entradas do usuário para evitar possíveis vulnerabilidades e ataques como injeções de prompt.

- Monitoramento e alertas: Configurando sistemas de monitoramento e alerta para detectar e resolver problemas de desempenho ou possíveis ameaças.

Como você criaria um sistema RAG para uma tarefa específica (por exemplo, resposta a perguntas, resumo)?

Para um sistema de resposta a perguntas, você pode começar escolhendo um recuperador que consiga encontrar e buscar documentos relevantes com base na consulta do usuário. Isso pode ser algo tradicional, como pesquisas por palavras-chave, ou mais avançado, como usar embeddings densos para uma melhor recuperação. Depois, você precisa escolher ou ajustar um gerador que consiga criar respostas precisas e coerentes usando os documentos recuperados.

Quando se trata de resumir, o trabalho do recuperador é juntar conteúdo completo relacionado ao documento ou tópico em questão. Já o gerador precisa conseguir transformar esse conteúdo em resumos curtos e cheios de sentido.

A engenharia de prompt é super importante aqui. Dependendo da tarefa a ser realizada, precisamos criar prompts que orientem o modelo a incorporar as informações recuperadas para produzir o resultado relevante.

Você pode explicar os detalhes técnicos de como você ajustaria um LLM para uma tarefa RAG?

Começa com a coleta e preparação de dados específicos para a tarefa. Podem ser exemplos anotados de pares de perguntas e respostas ou conjuntos de dados de resumos.

Você pode usar técnicas como a modelagem de linguagem aumentada por recuperação (REALM), que ajuda o modelo a integrar melhor os documentos recuperados em suas respostas. Isso geralmente significa ajustar a arquitetura do modelo ou os métodos de treinamento para melhorar o tratamento do contexto dos documentos recuperados.

Você também pode usar Retrieval-Augmented Fine-Tuning (RAFT), que combina os pontos fortes do RAG com o ajuste fino, permitindo que o modelo aprenda tanto o conhecimento específico do domínio quanto a forma eficaz de recuperar e usar informações externas.

Como você lida com informações desatualizadas ou irrelevantes em um sistema RAG, especialmente em áreas que mudam rápido?

Uma abordagem é fazer atualizações regulares na base de conhecimento ou no índice de documentos, para que as novas informações sejam adicionadas assim que estiverem disponíveis. Isso pode envolver a configuração de fluxos de trabalho automatizados que periodicamente coletam ou importam conteúdo atualizado, garantindo que o recuperador esteja sempre trabalhando com os dados mais recentes.

Além disso, a marcação de metadados pode ser usada para sinalizar informações desatualizadas, permitindo que o sistema priorize documentos mais recentes e relevantes durante a recuperação.

Em áreas que mudam rápido, também é importante integrar mecanismos que filtram ou reclassificam os resultados de pesquisa com base na atualidade deles. Por exemplo, dar mais peso a artigos ou documentos mais recentes durante a recuperação ajuda a garantir que as respostas geradas sejam baseadas em fontes atualizadas.

Outra técnica é usar loops de feedback ou sistemas com intervenção humana, onde as imprecisões sinalizadas podem ser corrigidas rapidamente e o recuperador pode ser ajustado para evitar a recuperação de informações obsoletas.

Como você equilibra a relevância e a diversidade da recuperação em um sistema RAG para garantir respostas completas?

Equilibrar relevância e diversidade em um sistema RAG tem tudo a ver com dar respostas precisas e completas. A relevância garante que os documentos encontrados sejam bem parecidos com o que você procurou, enquanto a diversidade faz com que o sistema não se concentre só em uma única fonte ou ponto de vista.

Uma maneira de equilibrar isso é usar estratégias de reclassificação que priorizam tanto a relevância quanto a diversidade. Você também pode aumentar a diversidade pegando documentos de várias fontes ou seções dentro da base de conhecimento.

Agrupar resultados parecidos e escolher documentos de diferentes grupos também pode ajudar.

Ajustar o recuperador com foco na relevância e na diversidade também pode garantir que o sistema recupere um conjunto abrangente de documentos.

Como você garante que a saída gerada em um sistema RAG continue consistente com as informações recuperadas?

Uma abordagem importante é a ligação estreita entre a recuperação e a geração por meio da engenharia de prompts. Prompts cuidadosamente elaborados que instruem explicitamente o modelo de linguagem a basear suas respostas nos documentos recuperados ajudam a garantir que a geração permaneça fundamentada nos dados fornecidos pelo recuperador.

Além disso, técnicas como a geração de citações, em que o modelo é solicitado a referenciar ou justificar suas respostas com as fontes recuperadas, podem ajudar a manter a consistência.

Outra abordagem é fazer verificações ou validações depois da geração, onde a saída é comparada com os documentos recuperados para garantir que tudo esteja alinhado. Isso pode ser feito usando métricas de similaridade ou empregando modelos de verificação menores que validam a consistência factual entre os dados recuperados e o texto gerado.

Às vezes, dá pra usar métodos de refinamento iterativo, onde o modelo primeiro gera uma resposta e depois volta nos documentos recuperados pra conferir e refinar a resposta. Os ciclos de feedback e as correções dos usuários também podem ser usados para melhorar a consistência ao longo do tempo, já que o sistema aprende com as inconsistências do passado e ajusta seus mecanismos de recuperação e geração de acordo com isso.

Como você garante a privacidade e a segurança dos dados em um sistema RAG, especialmente quando se trata de informações confidenciais?

Garantir a privacidade e a segurança nos sistemas RAG é super importante quando os dados recuperados ou as consultas dos usuários têm informações confidenciais ou pessoais. As principais estratégias incluem:

-

Redação e anonimização de dados: Antes que os dados entrem no pipeline do RAG, tire ou esconda as informações pessoais identificáveis (PII) e outros detalhes confidenciais. Por exemplo, os documentos podem ser digitalizados e qualquer informação pessoal identificável pode ser editada no momento da ingestão. Essa abordagem de confiança zero significa que, mesmo que os dados sejam recuperados, eles não vão expor informações confidenciais, porque foram limpos antes.

-

Armazenamento e transferência seguros de dados: Use criptografia para dados em repouso (em bancos de dados ou armazenamentos vetoriais) e em trânsito quando o recuperador se comunicar com o armazenamento. Garantir que o banco de dados vetorial e as fontes de conhecimento tenham controle de acesso (com autenticação e autorização adequadas) evita o acesso não autorizado. Só aplicativos ou serviços confiáveis devem poder ler a base de conhecimento.

-

Controles de acesso baseados em funções: Coloque filtros de acesso bem rígidos nos resultados das pesquisas. Você pode marcar partes do conhecimento com metadados sobre quem tem permissão para vê-las (por exemplo, administrador x usuário) e fazer com que o sistema RAG aplique essas regras durante a recuperação. Por exemplo, um assistente RAG na área da saúde pode permitir que os médicos recuperem informações de identificação dos pacientes, mas nunca as mostre a outros usuários.

-

Filtragem rápida e monitoramento de saída: Incorpore proteções de IA para impedir que o LLM divulgue dados privados. Técnicas como defesa contra injeção de prompt, varredura de saída ou políticas (como as diretrizes OWASP para LLMs) podem ajudar a detectar e remover conteúdo confidencial das respostas. A revisão humana também pode ser usada para áreas de alto risco.

-

Conformidade e auditoria: Garanta que o sistema RAG esteja de acordo com as regras de proteção de dados (RGPD, HIPAA, etc.) desde o começo. Isso inclui manter registros de auditoria sobre quais dados foram recuperados e quando, obter o consentimento adequado dos usuários para usar seus dados e auditar regularmente as fontes de conhecimento para informações confidenciais.

Ao juntar essas medidas, um sistema RAG consegue lidar com dados confidenciais de forma segura. Em uma entrevista, você deve mencionar que proteger os dados dos usuários não é só uma ideia de última hora – isso faz parte de como o pipeline RAG ingere, armazena, recupera e gera informações.

Conclusão

Este guia forneceu 30 perguntas-chave para entrevistas para ajudá-lo a se preparar para discussões sobre RAG, desde conceitos básicos até sistemas RAG avançados.

Se você quiser saber mais sobre os sistemas RAG, recomendo estes blogs:

Ryan é um cientista de dados líder, especializado na criação de aplicativos de IA usando LLMs. Ele é candidato a PhD em Processamento de Linguagem Natural e Gráficos de Conhecimento no Imperial College London, onde também concluiu seu mestrado em Ciência da Computação. Fora da ciência de dados, ele escreve um boletim informativo semanal da Substack, The Limitless Playbook, no qual compartilha uma ideia prática dos principais pensadores do mundo e, ocasionalmente, escreve sobre os principais conceitos de IA.