Lernpfad

Retrieval-augmented generation (RAG) kombiniert große Sprachmodelle (LLMs) mit Abrufsystemen, um während der Textgenerierung relevante Infos von außen einzubringen.

In den letzten Jahren hat RAG richtig an Bedeutung gewonnen und ist jetzt ein häufiges Thema in Bewerbungsgesprächen für Jobs wie KI-Ingenieuroder Machine-Learning-Ingenieur, Prompt Engineerund Datenwissenschaftler.

Dieser Artikel soll dich auf RAG-bezogene Interviewfragen vorbereiten, indem er einen umfassenden Überblick über 30 wichtige Fragen gibt, die von grundlegenden Konzepten bis hin zu fortgeschritteneren Themen reichen.

Auch wenn du dich gerade nicht auf ein Vorstellungsgespräch vorbereitest, könnte dieser Artikel eine gute Gelegenheit sein, dein RAG-Wissen zu testen.

Werde ein ML-Wissenschaftler

Grundlegende RAG-Interviewfragen

Fangen wir mit ein paar grundlegenden Interviewfragen zu RAG an.

Erkläre die wichtigsten Teile eines RAG-Systems und wie sie funktionieren.

Ein RAG-System (Retrieval-Augmented Generation) hat zwei Hauptkomponenten: den Retriever und den Generator.

Der Retriever sucht und sammelt relevante Infos aus externen Quellen, wie zum Beispiel Datenbanken, Dokumenten oder Websites.

Der Generator, meistens ein fortschrittliches Sprachmodell, nutzt diese Infos, um einen klaren und genauen Text zu erstellen.

Der Retriever sorgt dafür, dass das System die aktuellsten Infos bekommt, während der Generator diese mit seinem eigenen Wissen kombiniert, um bessere Antworten zu liefern.

Zusammen liefern sie genauere Antworten, als der Generator alleine könnte.

Was sind die Hauptvorteile von RAG, wenn man nicht nur auf das interne Wissen eines LLM setzt?

Wenn du dich nur auf das eingebaute Wissen eines LLM verlässt, ist das System auf das beschränkt, worauf es trainiert wurde, was veraltet sein oder Details vermissen lassen könnte.

RAG-Systeme haben den großen Vorteil, dass sie neue Infos von externen Quellen holen, was zu genaueren und schnelleren Antworten führt.

Dieser Ansatz reduziert auch „Halluzinationen“ – Fehler, bei denen das Modell Fakten erfindet –, weil die Antworten auf echten Daten basieren. RAG ist besonders nützlich für bestimmte Bereiche wie Recht, Medizinoder Technik, wo man immer auf dem neuesten Stand sein muss.

Was sind ein paar typische Anwendungen von RAG?

RAG wird in vielen echten KI-Anwendungen in verschiedenen Bereichen eingesetzt:

-

Frage-Antwort- und Supportsysteme: RAG macht Chatbots für den Kundensupport und Assistenten für Wissensdatenbanken möglich, indem es aktuelle Infos oder FAQs abruft und genaue Antworten für die Nutzer zusammenstellt. So stellen wir sicher, dass Kundenfragen mit den aktuellsten Infos beantwortet werden (z. B. durch Abrufen der aktuellen Versicherungsdaten oder Produktdetails).

-

Dialogagenten: Viele Chatbots und virtuelle Assistenten nutzen RAG, um sachliche, kontextbezogene Antworten zu geben. Durch das Abrufen relevanter Fakten in Echtzeit kann ein Gesprächsagent (wie ein Chatbot im Gesundheits- oder Finanzbereich) fundierte Antworten geben, die auf glaubwürdigen Quellen basieren.

-

Erstellung und Zusammenfassung von Inhalten: RAG hilft dabei, Inhalte mit korrekten Fakten zu erstellen oder zusammenzufassen. Zum Beispiel kann es Teile von Nachrichtenartikeln oder Forschungsarbeiten abrufen und dann Zusammenfassungen oder Berichte erstellen, die sowohl zusammenhängend sind als auch anhand der Quelldaten auf ihre Richtigkeit überprüft wurden.

-

Forschung in bestimmten Bereichen: In Fachgebieten wie Jura oder Medizin helfen RAG-Systeme, indem sie aus speziellen Datenbanken (Rechtsprechung, medizinische Fachzeitschriften usw.) ziehen, um komplizierte Fragen zu beantworten. So basiert das Ergebnis des Modells auf zuverlässigem, aktuellem Fachwissen, was für professionelle Anwendungen echt wichtig ist.

Welche externen Wissensquellen kann RAG nutzen?

RAG-Systeme können Infos aus strukturierten und unstrukturierten externen Quellen sammeln:

- Strukturierte Quellen sind zum Beispiel Datenbanken, APIs oder Wissensgraphen, in denen die Daten gut organisiert und leicht zu durchsuchen sind.

- Unstrukturierte Quellen sind riesige Textmengen wie Dokumente, Websites oder Archive, wo die Infos mit Verständnis natürlicher Spracheverarbeitet werden müssen.

Dank dieser Flexibilität können RAG-Systeme auf verschiedene Bereiche wie den rechtlichen oder medizinischen Einsatz zugeschnitten werden, indem sie auf Datenbanken mit Präzedenzfällen, Forschungszeitschriften oder Daten aus klinischen Studien zugreifen.

Ist Prompt Engineering bei RAG wichtig?

Prompt Engineering hilft Sprachmodellen dabei, mit den gefundenen Infos echt gute Antworten zu geben. Wie du eine Eingabeaufforderung gestaltest, kann die Relevanz und Klarheit der Ausgabe beeinflussen.

- Spezifische Vorlagen für Systemaufforderungen helfen dabei, das Modell zu steuern. Statt einer einfachen Standardaufforderung wie „Beantworte die Frage“ könntest du zum Beispiel sagen: „Beantworte die Frage nur anhand des gegebenen Kontexts.“ Dadurch bekommt das Modell die klare Anweisung, nur den gegebenen Kontext zu nutzen, um die Frage zu beantworten, was die Wahrscheinlichkeit von Halluzinationen verringern kann.

- Few-Shot-Prompting bedeutet, dass man dem Modell ein paar Beispielantworten gibt, bevor man es bittet, eigene Antworten zu generieren, damit es weiß, welche Art von Antwort man haben will.

- Gedankenkette hilft dabei, komplizierte Fragen zu zerlegen, indem das Modell dazu gebracht wird, seine Überlegungen Schritt für Schritt zu erklären, bevor es antwortet.

Wie funktioniert der Retriever in einem RAG-System? Was sind gängige Abrufmethoden?

In einem RAG-System sammelt der Retriever relevante Infos aus externen Quellen, die der Generator dann nutzen kann. Es gibt verschiedene Möglichkeiten, Infos zu finden.

Eine Methode ist das Sparse Retrieval, das Schlüsselwörter abgleicht (z. B. TF-IDF oder BM25). Das ist zwar einfach, gibt aber vielleicht nicht die tiefere Bedeutung der Worte wieder.

Ein anderer Ansatz ist das Dense Retrieval, das neuronale Einbettungen nutzt, um die Bedeutung von Dokumenten und Suchanfragen zu verstehen. Methoden wie BERT oder Dense Passage Retrieval (DPR) zeigen Dokumente als Vektoren in einem gemeinsamen Raum, was das Auffinden genauer macht.

Die Wahl zwischen diesen Methoden kann echt einen großen Einfluss darauf haben, wie gut das RAG-System funktioniert.

Was sind die Herausforderungen, wenn man gefundene Infos mit der LLM-Generierung kombiniert?

Die Kombination von gefundenen Infos mit der Generierung durch ein LLM bringt ein paar Herausforderungen mit sich. Zum Beispiel müssen die gefundenen Daten echt relevant für die Anfrage sein, weil irrelevante Daten das Modell verwirren und die Qualität der Antwort beeinträchtigen können.

Außerdem kann es zu verwirrenden oder falschen Antworten kommen, wenn die gefundenen Infos nicht mit dem, was das Modell schon weiß, übereinstimmen. Deshalb ist es echt wichtig, diese Konflikte zu lösen, ohne die Nutzer zu verwirren.

Schließlich können Stil und Format der abgerufenen Daten nicht immer mit der üblichen Schreibweise oder Formatierung des Modells übereinstimmen, was es für das Modell schwierig macht, die Informationen reibungslos zu integrieren.

Was macht eine Vektordatenbank in RAG?

In einem RAG-System ist eine Vektordatenbank dabei, dichte Einbettungen von Text. Diese Einbettungen sind numerische Darstellungen, die die Bedeutung von Wörtern und Phrasen erfassen und von Modellen wie BERT oder OpenAI erstellt werden.

Wenn eine Anfrage kommt, wird ihre Einbettung mit den in der Datenbank gespeicherten verglichen, um ähnliche Dokumente zu finden. Dadurch kann man die richtigen Infos schneller und genauer finden. Dieser Prozess hilft dem System, die relevantesten Infos schnell zu finden und abzurufen, was sowohl die Geschwindigkeit als auch die Genauigkeit der Suche verbessert.

Wie kann man RAG-Systeme normalerweise bewerten?

Um ein RAG-System zu bewerten, musst du sowohl die Abruf- als auch die Generierungskomponenten anschauen.

- Für den Retriever checkst du, wie genau und relevant die gefundenen Dokumente sind. Hier kann man Metriken wiedie Präzision ( , wie viele der gefundenen Dokumente relevant sind) und den Recall (wie viele der insgesamt relevanten Dokumente gefunden wurden) nutzen.

- Für den Generator sind Metriken wie BLEU und ROUGE verwendet werden, um den generierten Text mit von Menschen geschriebenen Beispielen zu vergleichen und so die Qualität zu beurteilen.

Für nachgelagerte Aufgaben wie das Beantworten von Fragen sind Metriken wie F1-Score, Präzisionund Recall können auch zur Bewertung des gesamten RAG-Systems verwendet werden.

Wie gehst du mit unklaren oder unvollständigen Suchanfragen in einem RAG-System um, um relevante Ergebnisse zu bekommen?

Um mit unklaren oder unvollständigen Suchanfragen in einem RAG-System klarzukommen, braucht man Strategien, die sicherstellen, dass trotz der unklaren Eingabe des Nutzers relevante und genaue Infos gefunden werden.

Ein Ansatz ist, Techniken zur Verfeinerung von Suchanfragen zu nutzen, bei denen das System automatisch Klarstellungen vorschlägt oder die unklare Anfrage anhand bekannter Muster oder früherer Interaktionen präziser formuliert. Das kann bedeuten, dass man Folgefragen stellt oder dem Nutzer mehrere Optionen anbietet, um seine Absicht genauer zu bestimmen.

Eine andere Möglichkeit ist, verschiedene Dokumente zu finden, die mehrere mögliche Interpretationen der Suchanfrage abdecken. Durch das Abrufen einer Reihe von Ergebnissen stellt das System sicher, dass selbst bei einer vagen Suchanfrage wahrscheinlich einige relevante Informationen enthalten sind.

Schließlich können wir Modelle zum Verständnis natürlicher Sprache (NLU) Modelle, um die Absicht des Benutzers aus unvollständigen Suchanfragen zu ermitteln und den Suchvorgang zu verfeinern.

Fragen für das RAG-Interview für Fortgeschrittene

Nachdem wir jetzt ein paar grundlegende Fragen geklärt haben, ist es Zeit, zu den mittleren RAG-Interviewfragen überzugehen.

Wie wählst du den richtigen Retriever für eine RAG-Anwendung aus?

Die Wahl des richtigen Retrievers hängt davon ab, mit welcher Art von Daten du arbeitest, wie die Abfragen aussehen und wie viel Rechenleistung du hast.

Für komplizierte Suchanfragen, die ein tiefes Verständnis der Bedeutung hinter den Wörtern erfordern, sind Methoden wie BERT oder DPR besser geeignet. Diese Methoden erfassen den Kontext und sind super für Aufgaben wie Kundensupport oder Forschung, wo es wichtig ist, die zugrunde liegenden Bedeutungen zu verstehen.

Wenn die Aufgabe einfacher ist und sich um die Übereinstimmung von Schlüsselwörtern dreht oder wenn du nur begrenzte Rechenressourcen hast, könnten spärliche Suchmethoden wie BM25 oder TF-IDF besser passen. Diese Methoden sind schneller und einfacher einzurichten, finden aber möglicherweise keine Dokumente, die nicht genau den Suchbegriffen entsprechen.

Der Hauptkompromiss zwischen dichten und spärlichen Suchmethoden ist die Genauigkeit gegenüber den Rechenkosten. Manchmal kann es helfen, beide Ansätze in einem hybriden Abrufsystem zu kombinieren, um Genauigkeit und Rechenleistung unter einen Hut zu bringen. Recheneffizienzauszugleichen. So kannst du je nach Bedarf die Vorteile sowohl der dichten als auch der spärlichen Methode nutzen.

Erklär mal, was eine hybride Suche ist.

Die hybride Suche bringt die Vorteile von dichten und spärlichen Suchmethoden zusammen.

Du kannst zum Beispiel mit einer spärlichen Methode wie BM25 anfangen, um Dokumente anhand von Stichwörtern schnell zu finden. Dann wird eine komplexe Methode wie BERT die Dokumente neu sortiert diese Dokumente neu, indem sie den Kontext und die Bedeutung versteht. Damit kriegst du die Geschwindigkeit einer spärlichen Suche mit der Genauigkeit dichter Methoden, was super für komplexe Abfragen und große Datensätze ist.

Brauchst du eine Vektordatenbank, um RAG zu nutzen? Wenn nicht, was sind die Alternativen?

Eine Vektordatenbank ist super, um dichte Einbettungen zu verwalten, aber sie ist nicht immer nötig. Alternativen sind:

- Traditionelle Datenbanken: Wenn du spärliche Methoden oder strukturierte Daten verwendest, können normale relationale oder nosql-Datenbanken ausreichen. Sie funktionieren gut für die Stichwortsuche. Datenbanken wie MongoDB oder Elasticsearch sind super für unstrukturierte Daten und Volltextsuchen, aber sie können keine tiefgehende semantische Suche machen.

- Invertierte Indizes: Diese ordnen Schlüsselwörter Dokumenten zu, um die Suche zu beschleunigen, erfassen aber nicht die Bedeutung hinter den Wörtern.

- Dateisystem-: Für kleinere Systeme können gut sortierte Dokumente in Ordnern funktionieren, aber die Suchfunktionen sind da eher eingeschränkt.

Die richtige Wahl hängt von deinen spezifischen Anforderungen ab, wie zum Beispiel dem Umfang deiner Daten und ob du ein tiefes semantisches Verständnis brauchst.

Wie kannst du sicherstellen, dass die gefundenen Infos relevant und richtig sind?

Um sicherzugehen, dass die gefundenen Infos relevant und richtig sind, kannst du verschiedene Methoden anwenden:

- Stell hochwertige Wissensdatenbanken zusammen: Stell sicher, dass die Infos in deiner Datenbank zuverlässig sind und zu den Anforderungen deiner Anwendung passen.

- en für den Retriever optimieren: Passe das Retriever-Modell an deine spezifischen Aufgaben und Anforderungen an. Das hilft dabei, die Relevanz der Ergebnisse zu verbessern.

- Verwende die Re-Ranking-: Nachdem du die ersten Ergebnisse hast, sortier sie nach ihrer Relevanz, um die genauesten Infos zu kriegen. Bei diesem Schritt wird genauer geschaut, wie gut die Ergebnisse zur Suchanfrage passen.

- Implementiere Feedback-Schleifen: Hol dir Feedback von Nutzern oder Modellen zur Nützlichkeit der Ergebnisse. Dieses Feedback kann dabei helfen, den Retriever mit der Zeit zu verfeinern und zu verbessern. Ein Beispiel dafür ist das Korrektive RAG (CRAG).

- Regelmäßige Bewertung: Mess die Leistung des Systems ständig mit Kennzahlen wie Präzision, Recall oder F1-Score, um die Genauigkeit und Relevanz immer weiter zu verbessern.

Welche Techniken gibt es für den Umgang mit langen Dokumenten oder großen Wissensdatenbanken in RAG?

Hier sind ein paar nützliche Tipps für den Umgang mit langen Dokumenten oder großen Wissensdatenbanken:

- Chunking: Teile lange Dokumente in kleinere, übersichtlichere Abschnitte auf. Das macht es einfacher, relevante Teile zu suchen und zu finden, ohne das ganze Dokument durchgehen zu müssen.

- Zusammenfassung: Mach kurze Versionen von langen Dokumenten. Dadurch kann das System mit kürzeren Zusammenfassungen statt mit dem ganzen Text arbeiten, was das Abrufen beschleunigt.

- Hierarchisches Abruf: Mach's in zwei Schritten: Such erst nach groben Kategorien von Infos und dann such nach den genauen Details. Das hilft dabei, große Datenmengen besser zu verwalten.

- Speichereffiziente Einbettungen: Verwende kompakte Vektordarstellungen, um den Speicherbedarf und die benötigte Rechenleistung zu reduzieren. Die Größe der Einbettungen zu optimieren, kann die Arbeit mit großen Datensätzen vereinfachen.

- Indexierung und Sharding-: Teile die Wissensdatenbank in kleinere Teile auf und speichere sie auf mehreren Systemen. Das macht es möglich, Sachen parallel zu bearbeiten und schneller zu finden, vor allem in großen Systemen.

Wie kann man die Leistung eines RAG-Systems sowohl in Bezug auf Genauigkeit als auch Effizienz verbessern?

Um die beste Leistung eines RAG-Systems in Sachen Genauigkeit und Effizienz zu kriegen, kannst du verschiedene Strategien anwenden:

- Modelle optimieren: Passe die Retriever- und Generator-Modelle mit den Daten an, die für deine Aufgabe wichtig sind. Das hilft ihnen, bei speziellen Suchanfragen besser abzuschneiden.

- Effiziente Indizierungs: Organisiere deine Wissensdatenbank mit schnellen Datenstrukturen wie invertierten Indizes oder Hashing. Das macht die Suche nach wichtigen Infos schneller.

- Caching-: Speichere oft genutzte Daten, damit sie nicht immer wieder abgerufen werden müssen. Das macht die Sache effizienter und beschleunigt die Antworten.

- Suchschritte reduzieren: Such so selten wie möglich nach Infos. Mach den Retriever genauer oder nutze das Re-Ranking, damit nur die besten Ergebnisse an den Generator weitergeleitet werden und unnötige Verarbeitungsschritte vermieden werden.

- Hybride Such: Kombiniere spärliche und dichte Suchmethoden. Man kann zum Beispiel die spärliche Suche nutzen, um schnell eine große Menge relevanter Dokumente zu finden, und dann die dichte Suche anwenden, um diese Ergebnisse genauer zu verfeinern und zu ordnen.

Wie behält ein RAG-System den Überblick in einem Gespräch mit mehreren Runden?

Bei Gesprächen mit mehreren Runden (z. B. einem Chatbot-Dialog) muss ein RAG-System den relevanten Kontext aus früheren Runden übernehmen, um spätere Fragen richtig beantworten zu können. Um das zu schaffen, kann RAG den Gesprächsverlauf in jede neue Anfrage einbauen:

-

Verfeinerung der Suchanfrage: Das System kann die Frage des Benutzers automatisch umschreiben oder ergänzen, indem es Infos aus früheren Unterhaltungen nutzt. Durch das Hinzufügen von Details aus früheren Runden bekommt der Retriever eine kontextreichere Anfrage, sodass er Dokumente finden kann, die für die aktuelle Diskussion relevant sind.

-

Einschließlich Gesprächsverlauf: Ein anderer Ansatz ist, dem Modell eine Zusammenfassung oder Liste der vorherigen Dialogrunden als Teil seines Eingabekontexts zu geben. Viele RAG-Architekturen können eine Reihe von Nachrichten (Benutzer- und Assistentengeschichte) zusammen mit der neuen Frage weiterleiten. So berücksichtigt der Retriever bei der Suche nach Infos den festgelegten Kontext, und der Generator kann den bisherigen Kontext nutzen, um ein zusammenhängendes Gespräch zu führen.

Mit diesen Methoden behält das RAG-System den Überblick darüber, wer was gesagt hat und was schon geklärt ist. So wird verhindert, dass es Details vergisst oder sich wiederholt.

Fortgeschrittene RAG-Interviewfragen

Bis jetzt haben wir grundlegende und mittelschwere RAG-Interviewfragen behandelt, und jetzt werden wir uns mit fortgeschritteneren Konzepten wie Chunking-Techniken oder Kontextualisierung beschäftigen.

Welche verschiedenen Chunking-Techniken gibt's, um Dokumente zu zerlegen, und was sind ihre Vor- und Nachteile?

Es gibt verschiedene Möglichkeiten, Dokumente für die Suche und Verarbeitung zu zerlegen:

- Feste Länge: Dokumente in Teile mit fester Größe aufteilen. Das ist einfach, aber manchmal stimmen die Abschnitte nicht mit logischen Unterbrechungen überein, sodass du wichtige Infos trennen oder irrelevante Inhalte einfügen könntest.

- Auf Sätzen basierend: Das Aufteilen von Dokumenten in Sätze hält die Sätze zusammen, was super für detaillierte Analysen ist. Allerdings kann es zu vielen Brocken führen oder den Zusammenhang verlieren, wenn die Sätze zu kurz sind, um die ganzen Ideen zu erfassen.

- Absatzbasiert: Durch die Aufteilung in Absätze bleibt der Kontext erhalten, aber die Absätze können zu lang sein, was das Auffinden und Verarbeiten weniger effizient macht.

- Semantisches Chunking: Chunks werden nach ihrer Bedeutung gebildet, wie Abschnitte oder Themen. Das macht den Kontext klar, ist aber schwieriger umzusetzen, weil man dafür eine fortgeschrittene Textanalyse braucht.

- Schiebefenster: Die Blöcke überlappen sich, indem sie über den Text rutschen. So wird sichergestellt, dass wichtige Infos nicht übersehen werden, aber das kann ziemlich rechenintensiv sein und zu doppelten Infos führen.

Was sind die Vor- und Nachteile, wenn man Dokumente in größere oder kleinere Teile aufteilt?

Kleinere Teile, wie Sätze oder kurze Absätze, helfen dabei, dass wichtige Infos im Kontext nicht verloren gehen, wenn sie zu einem einzigen Vektor zusammengefasst werden. Das kann aber dazu führen, dass man langfristige Abhängigkeiten zwischen den Blöcken verliert, was es für Modelle schwierig macht, Referenzen zu verstehen, die sich über mehrere Blöcke erstrecken.

Größere Teile behalten mehr Kontext, was reichhaltigere Kontextinfos ermöglicht, aber weniger fokussiert sein kann und Infos verloren gehen können, wenn man versucht, alle Infos in einen einzigen Vektor zu packen.

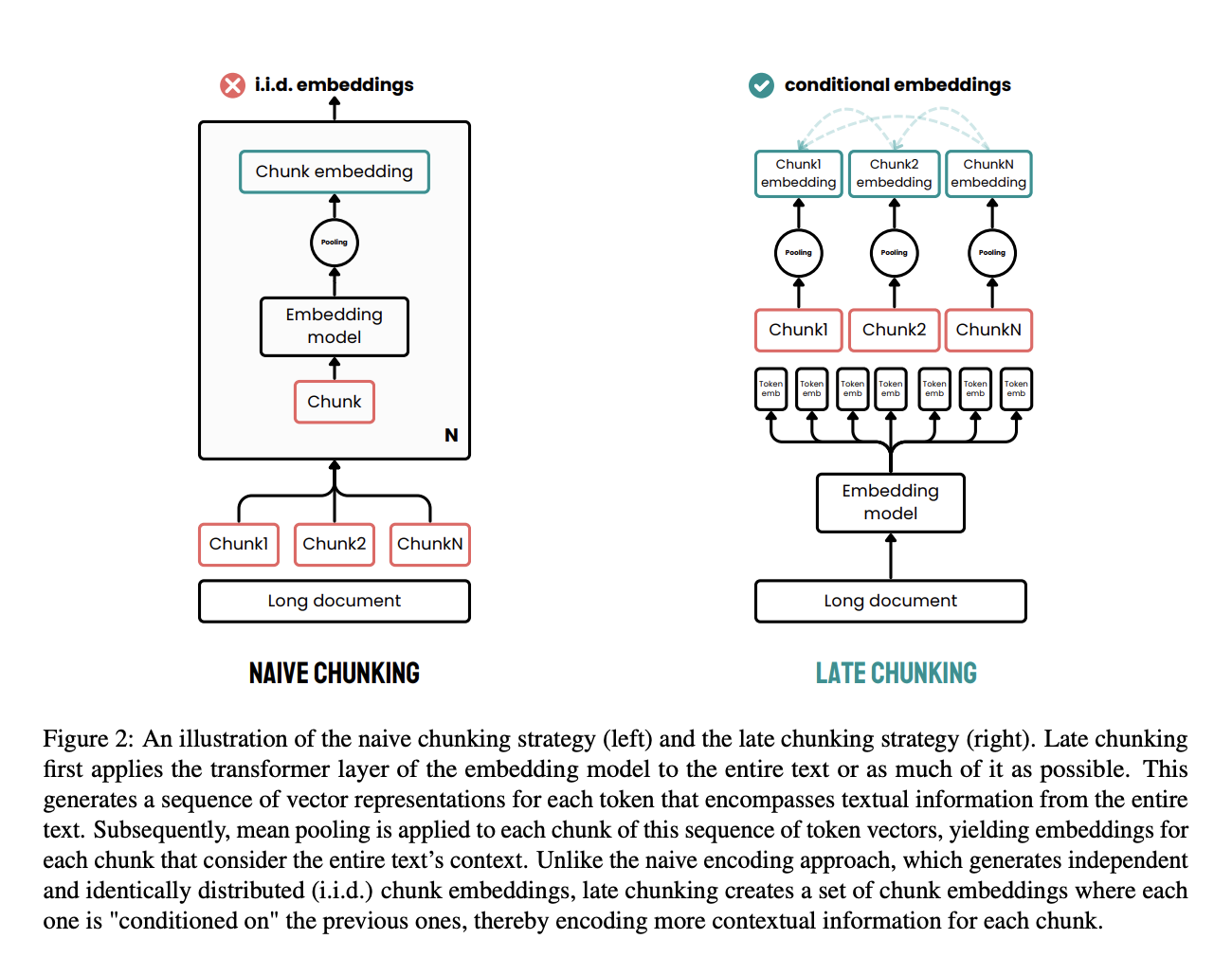

Was ist Late Chunking und wie unterscheidet es sich von den üblichen Chunking-Methoden?

Spätes Chunking ist ein cooler Ansatz, der entwickelt wurde, um die Einschränkungen traditioneller Chunking-Methoden bei der Dokumentverarbeitung zu umgehen.

Bei den klassischen Methoden werden Dokumente erst in Teile wie Sätze oder Absätze aufgeteilt, bevor man ein Einbettungsmodell anwendet. Diese Teile werden dann einzeln in Vektoren umgewandelt, oft mit Hilfe von Mean Pooling, um für jedes Teil eine einzige Einbettung zu erstellen. Dieser Ansatz kann dazu führen, dass kontextuelle Abhängigkeiten über große Entfernungen verloren gehen, weil die Einbettungen unabhängig voneinander generiert werden, ohne den gesamten Dokumentkontext zu berücksichtigen.

Late Chunking geht anders ran. Zuerst wird die Transformatorschicht des Einbettungsmodells auf das ganze Dokument oder so viel wie möglich davon angewendet, wodurch eine Folge von Vektordarstellungen für jedes Token erstellt wird. Diese Methode fängt den ganzen Kontext des Textes in diesen Einbettungen auf Token-Ebene ein.

Danach wird ein Mittelwertpooling auf die Teile dieser Folge von Token-Vektoren angewendet, wodurch für jeden Teil Einbettungen erzeugt werden, die durch den Kontext des gesamten Dokuments beeinflusst werden. Anders als bei der herkömmlichen Methode erzeugt Late Chunking Chunk-Einbettungen, die voneinander abhängig sind, wodurch mehr Kontextinformationen erhalten bleiben und weitreichende Abhängigkeiten aufgelöst werden.

Wenn man das Chunking später im Prozess macht, stellt man sicher, dass jedes Chunk von dem ganzen Kontext des Dokuments profitiert und nicht isoliert ist. Dieser Ansatz löst das Problem des verlorenen Kontexts und verbessert die Qualität der Einbettungen, die für Such- und Generierungsaufgaben verwendet werden.

Quelle: Günther et al., 2024

Erkläre mal das Konzept der „Kontextualisierung“ in RAG und wie es die Leistung beeinflusst.

Bei der Kontextualisierung in RAG geht's darum, sicherzustellen, dass die gefundenen Infos für die Anfrage relevant sind. Indem die abgerufenen Daten mit der Abfrage abgeglichen werden, liefert das System bessere und relevantere Antworten.

Das verringert die Wahrscheinlichkeit von falschen oder irrelevanten Ergebnissen und stellt sicher, dass die Ausgabe den Bedürfnissen des Benutzers entspricht. Ein Ansatz besteht darin, mit einem LLM zu checken, ob die gefundenen Dokumente relevant sind, bevor sie an das Generator-Modell geschickt werden, wie bei Corrective RAG (CRAG).

Wie kannst du mit möglichen Verzerrungen in den gefundenen Infos oder bei der Generierung durch das LLM umgehen?

Zuerst muss man die Wissensdatenbank so aufbauen, dass voreingenommene Inhalte rausgefiltert werden, damit die Infos so objektiv wie möglich sind. Du kannst das Suchsystem auch so umprogrammieren, dass es ausgewogene, unvoreingenommene Quellen bevorzugt.

Ein weiterer wichtiger Schritt könnte sein, einen Agenten einzusetzen, der speziell nach möglichen Verzerrungen sucht und sicherstellt, dass die Ergebnisse des Modells objektiv bleiben.

Reden wir mal über die Herausforderungen beim Umgang mit dynamischen oder sich ständig ändernden Wissensdatenbanken in RAG.

Ein großes Problem ist, die indizierten Daten mit den neuesten Infos auf dem Laufenden zu halten, was einen zuverlässigen Aktualisierungsmechanismus braucht. Deshalb ist die Versionskontrolle echt wichtig, um verschiedene Versionen von Infos zu verwalten und dafür zu sorgen, dass alles einheitlich bleibt.

Außerdem muss das Modell in Echtzeit auf neue Infos reagieren können, ohne dass man es ständig neu trainieren muss, was echt ressourcenintensiv sein kann. Diese Herausforderungen brauchen ausgeklügelte Lösungen, damit das System auch bei Weiterentwicklungen der Wissensdatenbank genau und relevant bleibt.

Was ist CAG und wie unterscheidet es sich von herkömmlichem RAG? Wann würdest du CAG gegenüber RAG in der Produktion bevorzugen?

CAG (Cache-Augmented Generation) ist eine Weiterentwicklung von RAG, bei der die gefundenen Dokumente zusammengefasst oder komprimiert werden, bevor sie an das LLM weitergeleitet werden. Das macht die Sachen relevanter, braucht weniger Token und sorgt dafür, dass mehr Infos ins Kontextfenster des Modells passen.

Der Hauptunterschied ist, dass bei CAG der gefundene Inhalt erst mal einen Zwischenschritt macht, wie zum Beispiel einen Summarizer oder einen Context Refiner, bevor er an den Generator weitergeleitet wird. Im Gegensatz dazu gibt traditionelles RAG die Rohdokumente direkt in die Eingabeaufforderung weiter.

CAG ist besonders nützlich, wenn:

-

Du arbeitest mit statischen Datensätzen (z. B. Produktkatalogen, wissenschaftlichen Arbeiten), die vorab komprimiert und zwischengespeichert werden können.

-

Die Effizienz der Token ist echt wichtig (z. B. bei kostensensiblen APIs oder mobilen/geräteinternen Inferenzprozessen).

-

Die gefundenen Dokumente sind lang oder unübersichtlich und müssen gekürzt werden.

RAG ist dagegen besser, wenn:

-

Die zugrunde liegenden Daten sind dynamisch oder werden oft aktualisiert (z. B. Support-Tickets in Echtzeit, Live-Dokumentation).

-

Du willst die aktuellsten Infos bei der Abfrage nutzen, ohne die ganze Wissensdatenbank neu zu verarbeiten.

Kurz gesagt: Nutze CAG für stabile Bereiche, wo du den Kontext im Voraus optimieren kannst, und RAG für dynamische Szenarien, wo Aktualität und Abrufbarkeit auf Abruf wichtiger sind.

Schau dir diesen Artikel über RAG versus CAG an, um einen genaueren Vergleich zu kriegen.

Was sind einige fortgeschrittene RAG-Systeme?

Es gibt viele moderne RAG-Systeme.

Ein solches System ist das Adaptive RAG-, bei dem das System nicht nur Infos abruft, sondern auch seine Vorgehensweise in Echtzeit basierend auf der Anfrage anpasst. Das adaptive RAG kann entscheiden, ob es gar nichts abruft, einen einmaligen RAG oder einen iterativen RAG macht. Dieses dynamische Verhalten macht das RAG-System robuster und relevanter für die Anfrage des Benutzers.

Ein weiteres fortschrittliches RAG-System ist Agentic RAG, das Retrieval Agents einführt – also Tools, die entscheiden, ob Infos aus einer Quelle geholt werden sollen oder nicht. Wenn man einem Sprachmodell diese Fähigkeit gibt, kann es selbst entscheiden, ob es zusätzliche Infos braucht, was den Prozess reibungsloser macht.

Korrektive RAG (CRAG) wird auch immer beliebter. Bei diesem Ansatz schaut das System die gefundenen Dokumente an und prüft, ob sie relevant sind. Nur Dokumente, die als relevant eingestuft werden, werden in den Generator eingespeist. Dieser Schritt zur Selbstkorrektur hilft dabei, dass genaue und relevante Infos verwendet werden. Mehr Infos findest du in diesem Tutorial zum Thema Implementierung von Corrective RAG (CRAG) mit LangGraph.

Self-RAG geht noch einen Schritt weiter, indem es nicht nur die gefundenen Dokumente, sondern auch die generierten Antworten checkt und sicherstellt, dass beides mit der Anfrage des Nutzers übereinstimmt. Das sorgt für zuverlässigere und einheitlichere Ergebnisse.

Wie kann man die Latenz in einem Echtzeit-RAG-System verringern, ohne die Genauigkeit zu beeinträchtigen?

Ein guter Trick ist, wichtige und oft nachgefragte Infos schon vorher zu laden, damit sie bereitstehen, wenn man sie braucht. Außerdem kann es echt einen Unterschied machen, wie schnell Daten abgerufen und verarbeitet werden, wenn du deine Indizierungs- und Abfragealgorithmen optimierst.

Was sind die Einschränkungen oder Herausforderungen von RAG-Systemen?

RAG ist zwar leistungsstark, hat aber ein paar Einschränkungen und Herausforderungen:

-

Abhängigkeit von der Qualität der abgerufenen Daten: Ein RAG-System ist nur so gut wie die Infos, die es findet. Wenn der Retriever irrelevante oder falsche Dokumente findet, wird die Antwort des Generators darunter leiden. Die Sicherstellung hochwertiger, vertrauenswürdiger Datenquellen (und die Feinabstimmung des Retrievers) ist eine ständige Herausforderung, um Probleme mit fehlerhaften Eingaben und fehlerhaften Ausgaben zu vermeiden.

-

Mehr Komplexität und Verzögerung: RAG fügt nach der Generierung noch einen zusätzlichen Abrufschritt ein, was das ganze System komplexer und rechenintensiver macht als ein eigenständiges LLM. Das Durchsuchen einer großen Wissensdatenbank kann zu Verzögerungen führen und viel Rechenleistung brauchen, deshalb müssen RAG-Systeme Genauigkeit und Effizienz gut ausbalancieren.

-

Notwendigkeit der Pflege der Wissensdatenbank: Anders als statische LLMs braucht RAG ein externes Wissensrepository, das regelmäßig aktualisiert und gepflegt werden muss. Unternehmen müssen ständig neue Daten einlesen, alte Infos löschen und Indizes verwalten. Ohne zuverlässige und aktuelle Datenquellen kann ein RAG-System schnell an Effektivität verlieren oder sogar veraltete Antworten liefern.

-

Schwierigkeiten bei der Integration und Abstimmung: Die Kombination von Abruf und Generierung bedeutet, dass mehr Komponenten abgestimmt und überwacht werden müssen (die Vektordatenbank, das Abrufmodell und das LLM). Fehler zu beheben kann schwieriger sein, weil die Probleme sowohl beim Abrufen als auch beim Erstellen auftreten können. Diese Komplexität kann den Entwicklungs- und Wartungsaufwand im Vergleich zur alleinigen Verwendung eines LLM erhöhen.

Es ist auch zu beachten, dass, wenn die Daten einer Domain weitgehend statisch sind und zum Training des Modells passen, ein fein abgestimmtes LLM anstelle von RAG ausreichend sein könnte. Allerdings fehlt bei der Feinabstimmung die Fähigkeit von RAG, neue Infos spontan einzubauen, und es kann teurer sein, das System bei jeder Wissensaktualisierung neu zu trainieren.

RAG-Interviewfragen für KI-Ingenieure

Jetzt wollen wir uns ein paar Fragen anschauen, die speziell für Leute gedacht sind, die sich für Stellen als KI-Ingenieur bewerben.

Verdiene eine Top-KI-Zertifizierung

Wie würdest du die Leistung eines RAG-Systems in einer Produktionsumgebung bewerten und verbessern?

Zuerst musst du das Feedback der Nutzer verfolgen, um zu sehen, wie gut das System läuft und ob es relevant ist.

Du solltest auch die Latenzzeit im Auge behalten, um sicherzustellen, dass die Antworten rechtzeitig kommen, und die Qualität der abgerufenen Dokumente und generierten Ergebnisse checken. Wichtige Kennzahlen wie Antwortgenauigkeit, Benutzerzufriedenheit und Systemdurchsatz sind wichtig.

Um die Leistung zu verbessern, kannst du Teile des Systems mit neuen Daten trainieren oder die Parameter anpassen. Du könntest auch die Suchalgorithmen optimieren, um die Relevanz und Effizienz zu verbessern, und die Wissensquellen regelmäßig aktualisieren, damit sie auf dem neuesten Stand bleiben.

Regelmäßige Leistungsbewertungen und A/B-Tests können dir Ideen für ständige Verbesserungen geben.

Wie stellst du sicher, dass ein RAG-System in der Produktion zuverlässig und robust ist, vor allem wenn es zu Ausfällen oder unerwarteten Eingaben kommen kann?

Ein produktionsreifes RAG-System aufzubauen, bringt einige Herausforderungen mit sich. Mögliche Lösungen könnten sein:

- Redundanz und Failover-: Redundante Teile oder Backup-Systeme einbauen, damit alles auch bei Ausfällen weiterläuft.

- Fehlerbehandlung und Protokollierung: Einbau von Mechanismen zur Fehlerbehandlung, um Fehler zu erkennen und zu protokollieren, damit man schnell Diagnosen stellen und Probleme lösen kann.

- Eingabevalidierung und -bereinigung: Überprüfe und bereinige Benutzereingaben, um mögliche Schwachstellen und Angriffe wie Prompt-Injektionen.

- Überwachungs- und Warn: Einrichtung von Überwachungs- und Warnsysteme, um Probleme mit der Leistung oder mögliche Gefahren zu erkennen und zu beheben.

Wie würdest du ein RAG-System für eine bestimmte Aufgabe (z. B. Beantwortung von Fragen, Zusammenfassung) gestalten?

Für ein Frage-Antwort-System kannst du damit anfangen, einen Retriever auszuwählen, der relevante Dokumente anhand der Anfrage des Benutzers effizient finden und abrufen kann. Das kann was Traditionelles sein, wie die Stichwortsuche, oder auch was Fortgeschritteneres, wie die Verwendung von dichten Einbettungen für ein besseres Abrufen. Als Nächstes musst du einen Generator auswählen oder optimieren, der anhand der abgerufenen Dokumente genaue und schlüssige Antworten erstellen kann.

Beim Zusammenfassen ist es die Aufgabe des Retrievers, umfassende Inhalte zum aktuellen Dokument oder Thema zu sammeln. Der Generator hingegen sollte in der Lage sein, diese Inhalte in prägnante, aussagekräftige Zusammenfassungen zu destillieren.

Prompt Engineering ist hier echt wichtig. Je nachdem, was als Nächstes ansteht, müssen wir Eingabeaufforderungen erstellen, die das Modell dabei unterstützen, die gefundenen Infos zu nutzen, um die passenden Ergebnisse zu liefern.

Kannst du mal die technischen Details erklären, wie du ein LLM für eine RAG-Aufgabe optimieren würdest?

Es fängt damit an, dass man die für die Aufgabe wichtigen Daten sammelt und vorbereitet. Das könnten kommentierte Beispiele von Frage-Antwort-Paaren oder Zusammenfassungsdatensätze sein.

Dann könntest du Techniken wie das abrufverstärkte Sprachmodell (REALM) nutzen, das dem Modell hilft, die abgerufenen Dokumente besser in seine Antworten zu integrieren. Das heißt oft, dass man die Architektur des Modells oder die Trainingsmethoden anpassen muss, damit es besser mit dem Kontext aus den gefundenen Dokumenten klarkommt.

Du kannst auch Retrieval-Augmented Fine-Tuning (RAFT)verwenden, das die Stärken von RAG mit Feinabstimmung kombiniert, sodass das Modell sowohl domänenspezifisches Wissen als auch das effektive Abrufen und Verwenden externer Informationen lernt.

Wie gehst du mit veralteten oder irrelevanten Infos in einem RAG-System um, vor allem in Bereichen, die sich schnell ändern?

Ein Ansatz besteht darin, die Wissensdatenbank oder den Dokumentenindex regelmäßig zu aktualisieren, damit neue Infos gleich eingebaut werden, sobald sie verfügbar sind. Dazu kann man automatisierte Abläufe einrichten, die regelmäßig aktualisierte Inhalte sammeln oder einlesen, damit der Retriever immer mit den neuesten Daten arbeitet.

Außerdem kann man Metadaten-Tags nutzen, um alte Infos zu markieren, damit das System beim Abrufen die neueren und relevanten Dokumente zuerst anzeigt.

In Bereichen, die sich schnell ändern, ist es auch wichtig, Mechanismen einzubauen, die Suchergebnisse nach ihrer Aktualität filtern oder neu sortieren. Wenn man zum Beispiel neueren Artikeln oder Dokumenten beim Abrufen mehr Gewicht gibt, kann man sicherstellen, dass die generierten Antworten auf aktuellen Quellen basieren.

Eine andere Technik sind Feedbackschleifen oder Human-in-the-Loop-Systeme, bei denen gemeldete Ungenauigkeiten schnell korrigiert werden können und der Retriever angepasst werden kann, um das Abrufen veralteter Informationen zu vermeiden.

Wie bringst du die Relevanz und Vielfalt der Suchergebnisse in einem RAG-System unter einen Hut, um umfassende Antworten zu bekommen?

Bei einem RAG-System geht's darum, relevante und abwechslungsreiche Antworten zu geben, die genau und gut durchdacht sind. Relevanz sorgt dafür, dass die gefundenen Dokumente gut zur Suchanfrage passen, während Vielfalt sicherstellt, dass sich das System nicht zu sehr auf eine einzige Quelle oder Sichtweise konzentriert.

Eine Möglichkeit, das auszugleichen, ist, Strategien zum erneuten Ranking zu nutzen, die sowohl Relevanz als auch Vielfalt wichtig nehmen. Du kannst die Vielfalt auch erhöhen, indem du Dokumente aus verschiedenen Quellen oder Abschnitten der Wissensdatenbank holst.

Das Gruppieren ähnlicher Ergebnisse und das Auswählen von Dokumenten aus verschiedenen Gruppen kann auch helfen.

Wenn man den Retriever so einstellt, dass er sowohl auf Relevanz als auch auf Vielfalt achtet, kann man auch sicherstellen, dass das System eine umfassende Auswahl an Dokumenten findet.

Wie stellst du sicher, dass die Ergebnisse, die ein RAG-System liefert, mit den gefundenen Infos übereinstimmen?

Ein wichtiger Ansatz ist die enge Verbindung zwischen Abruf und Generierung durch Prompt Engineering. Sorgfältig gestaltete Eingabeaufforderungen, die das Sprachmodell ausdrücklich anweisen, seine Antworten auf die abgerufenen Dokumente zu stützen, tragen dazu bei, dass die Generierung auf den vom Retriever bereitgestellten Daten basiert.

Außerdem können Techniken wie die Zitiergenerierung, bei der das Modell aufgefordert wird, seine Antworten mit den gefundenen Quellen zu belegen oder zu begründen, dabei helfen, die Konsistenz zu wahren.

Ein anderer Ansatz ist, nach der Generierung Checks oder Validierungen zu machen, bei denen die Ausgabe mit den gefundenen Dokumenten verglichen wird, um sicherzustellen, dass alles stimmt. Das kann man mit Ähnlichkeitsmetriken machen oder indem man kleinere Verifizierungsmodelle benutzt, die die faktische Übereinstimmung zwischen den gefundenen Daten und dem erstellten Text überprüfen.

Manchmal kann man iterative Verfeinerungsmethoden nutzen, bei denen das Modell erst mal eine Antwort gibt und dann die gefundenen Dokumente nochmal anschaut, um die Antwort zu checken und zu verbessern. Feedback-Schleifen und Benutzerkorrekturen können auch genutzt werden, um die Konsistenz im Laufe der Zeit zu verbessern, da das System aus früheren Inkonsistenzen lernt und seine Abruf- und Generierungsmechanismen entsprechend anpasst.

Wie stellst du den Datenschutz und die Datensicherheit in einem RAG-System sicher, vor allem wenn es um sensible Informationen geht?

Die Gewährleistung von Datenschutz und Sicherheit in RAG-Systemen ist super wichtig, wenn die abgerufenen Daten oder Benutzeranfragen sensible oder persönliche Informationen enthalten. Die wichtigsten Strategien sind:

-

Datenbearbeitung und Anonymisierung: Bevor Daten überhaupt in die RAG-Pipeline gelangen, solltest du personenbezogene Daten (PII) und andere sensible Details entfernen oder maskieren. Zum Beispiel können Dokumente gescannt werden, und alle personenbezogenen Daten können beim Einlesen unkenntlich gemacht werden. Dieser Zero-Trust-Ansatz bedeutet, dass selbst wenn Daten abgerufen werden, keine vertraulichen Infos preisgegeben werden, weil sie vorher bereinigt wurden.

-

Sichere Datenspeicherung und -übertragung: Verschlüssele Daten, die gespeichert sind (in Datenbanken oder Vektorspeichern) und übertragen werden, wenn der Abrufer mit dem Speicher kommuniziert. Wenn man sicherstellt, dass die Vektordatenbank und die Wissensquellen zugriffskontrolliert sind (mit ordentlicher Authentifizierung und Autorisierung), verhindert man unbefugten Zugriff. Nur vertrauenswürdige Anwendungen oder Dienste sollten Zugriff auf die Wissensdatenbank haben.

-

Rollenbasierte Zugriffskontrollen: Setz strenge Zugriffsfilter für Suchergebnisse ein. Du kannst Wissensbausteine mit Metadaten versehen, die angeben, wer sie sehen darf (z. B. Admin vs. Benutzer), und das RAG-System dazu bringen, diese Regeln beim Abruf durchzusetzen. Ein RAG-Assistent im Gesundheitswesen könnte zum Beispiel Ärzten erlauben, Infos zur Identifizierung von Patienten abzurufen, diese aber niemals anderen Nutzern zeigen.

-

Schnelle Filterung und Überwachung der Ausgabe: Integriere KI-Sicherheitsvorkehrungen, um zu verhindern, dass das LLM private Daten rausgibt. Techniken wie Prompt-Injection-Abwehr, Output-Scanning oder Richtlinien (wie die OWASP-Richtlinien für LLMs) können dabei helfen, sensible Inhalte in Antworten zu erkennen und zu entfernen. Die Überprüfung durch Menschen kann auch in Bereichen mit hohem Risiko eingesetzt werden.

-

Compliance und Audits: Stell sicher, dass das RAG-System von Anfang an die Datenschutzbestimmungen (DSGVO, HIPAA usw.) erfüllt. Dazu gehört, dass man Protokolle darüber führt, welche Daten wann abgerufen wurden, dass man die richtige Zustimmung der Nutzer für die Verwendung ihrer Daten einholt und dass man die Wissensquellen regelmäßig auf sensible Informationen überprüft.

Durch die Kombination dieser Maßnahmen kann ein RAG-System sensible Daten sicher verarbeiten. In einem Interview solltest du erwähnen, dass der Schutz von Nutzerdaten nicht nur eine Nebensache ist, sondern in die Art und Weise integriert ist, wie die RAG-Pipeline Informationen aufnimmt, speichert, abruft und generiert.

Fazit

Dieser Leitfaden hat dir 30 wichtige Interviewfragen gegeben, die dir helfen, dich auf Gespräche über RAG vorzubereiten, von den Grundkonzepten bis hin zu fortgeschrittenen RAG-Systemen.

Wenn du mehr über RAG-Systeme erfahren willst, empfehle ich dir diese Blogs:

Ryan ist ein führender Datenwissenschaftler, der sich auf die Entwicklung von KI-Anwendungen mit LLMs spezialisiert hat. Er ist Doktorand für natürliche Sprachverarbeitung und Wissensgraphen am Imperial College London, wo er auch seinen Master in Informatik gemacht hat. Außerhalb der Datenwissenschaft schreibt er einen wöchentlichen Substack-Newsletter, The Limitless Playbook, in dem er eine umsetzbare Idee von den besten Denkern der Welt teilt und gelegentlich über zentrale KI-Konzepte schreibt.