Lernpfad

Große Sprachmodelle (LLMs) werden in der künstlichen Intelligenz immer wichtiger und finden in vielen Branchen Anwendung.

Da immer mehr Leute mit LLM-Kenntnissen gesucht werden, gibt's in diesem Artikel eine ganze Reihe von Interviewfragen und Antworten, die grundlegende Konzepte, fortgeschrittene Techniken und praktische Anwendungen abdecken.

Wenn du dich auf ein Vorstellungsgespräch vorbereitest oder einfach nur dein Wissen erweitern möchtest, ist dieser Artikel genau das Richtige für dich.

Grundlegende Fragen für das LLM-Vorstellungsgespräch

Um LLMs zu verstehen, sollte man mit den grundlegenden Konzepten anfangen. Diese grundlegenden Fragen decken wichtige Sachen wie Architektur, Schlüsselmechanismen und typische Herausforderungen ab und bieten eine solide Basis, um fortgeschrittenere Themen zu lernen.

Was ist die Transformer-Architektur und wie wird sie in LLMs genutzt?

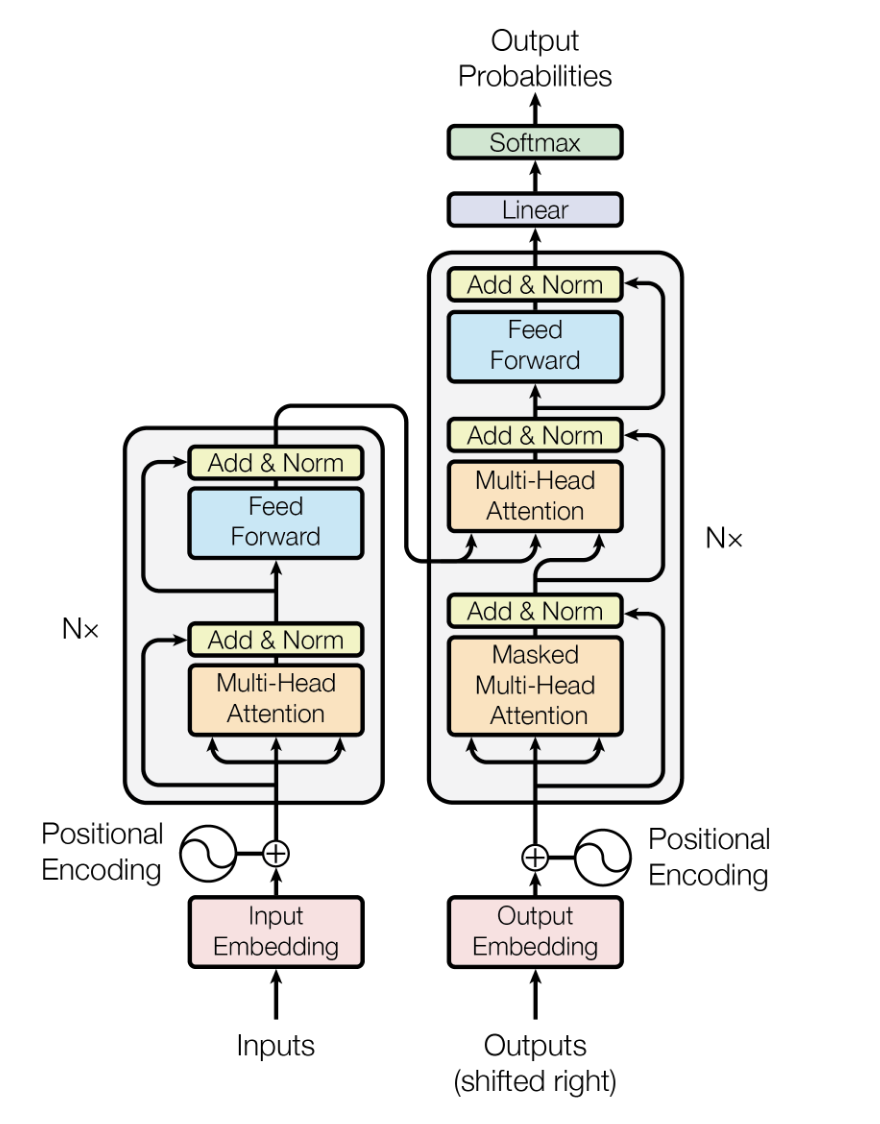

Die Transformer-Architektur ist ein Deep-Learning-Modell, das von 20172017 vorgestellt wurde. Es ist dafür gedacht, sequenzielle Daten effizienter und besser zu verarbeiten als frühere Modelle wie rekurrenten neuronalen Netzen (RNNs) und Long Short-Term Memory (LSTMs).

Es setzt auf Selbstaufmerksamkeitsmechanismen , um Eingabedaten parallel zu verarbeiten, was es super skalierbar macht und es ihm ermöglicht, weitreichende Abhängigkeiten zu erfassen.

Bei LLMs ist die Transformer-Architektur das Herzstück. Sie sorgt dafür, dass die Modelle große Mengen an Textdaten effizient verarbeiten und kontextbezogene, zusammenhängende Text-Outputs erstellen können.

Die Architektur des Transformer-Modells. Quelle

Erkläre mal das Konzept des „Kontextfensters“ in LLMs und warum es wichtig ist.

Das Kontextfenster in LLMs ist der Textbereich (in Form von Tokens oder Wörtern), den das Modell auf einmal berücksichtigen kann, wenn es Sprache generiert oder versteht. Das Kontextfenster ist wichtig, weil es beeinflusst, wie gut das Modell logische und passende Antworten machen kann.

Im Allgemeinen kann das Modell mit einem größeren Kontextfenster mehr Kontext berücksichtigen, was zu einem besseren Verständnis und einer besseren Textgenerierung führt, vor allem bei komplizierten oder langen Gesprächen. Allerdings braucht man dafür auch mehr Rechenleistung, sodass man einen Mittelweg zwischen Leistung und Effizienz finden muss.

Außerdem zeigen aktuelle Studien, dass die meisten Modelle von m-Ost schon weit vor ihren angegebenen Grenzen an Leistung verlieren. Modelle können ein „Lost in the Middle“-Phänomen zeigen, bei dem Infos im Kontextzentrum einfach ignoriert oder als weniger wichtig angesehen werden. Deshalb ist einkuratierter, relevanter Inhalt in kleineren Fenstern oft besser als große Fenster, die mit Lärm vollgestopft sind.

Was sind ein paar typische Ziele vor dem Training für LLMs und wie funktionieren sie?

Zu den üblichen Vorbereitungszielen für LLMs gehören masked language modeling (MLM) und autoregressive language modeling. Bei MLM werden zufällige Wörter in einem Satz verdeckt, und das Modell lernt, die verdeckten Wörter anhand des umgebenden Kontexts vorherzusagen. Das hilft dem Modell, den bidirektionalen Kontext zu verstehen.

Beim autoregressiven Sprachmodell geht's darum, das nächste Wort in einer Sequenz vorherzusagen und das Modell so zu trainieren, dass es Text Zeichen für Zeichen generiert. Beide Ziele helfen dem Modell, Sprachmuster und Semantik aus großen Textkorpora zu lernen, und bieten so eine solide Basis für die Feinabstimmung bestimmter Aufgaben.

Willst du mit generativer KI beginnen?

Lerne, wie du mit LLMs in Python direkt in deinem Browser arbeiten kannst

Was ist Fine-Tuning bei großen Sprachmodellen und warum ist es wichtig?

Feinabstimmung im Zusammenhang mit LLMs bedeutet, dass man ein vortrainiertes Modell nimmt und es mit einem kleineren, auf bestimmte Aufgaben zugeschnittenen Datensatz weiter trainiert. Dieser Prozess hilft dem Modell, sein allgemeines Sprachverständnis an die Feinheiten der jeweiligen Anwendung anzupassen und so die Leistung zu verbessern.

Das ist echt wichtig, weil es die Sprachkenntnisse nutzt, die man schon vorher gelernt hat, und gleichzeitig das Modell so anpasst, dass es bei bestimmten Sachen wie Stimmungsanalyse, Textzusammenfassung oder Fragen beantworten gut funktioniert.

Was sind die typischen Probleme bei der Nutzung von LLMs?

Der Einsatz von LLMs bringt ein paar Herausforderungen mit sich, darunter:

- Rechenressourcen: LLMs brauchen echt viel Rechenleistung und Speicherplatz, was das Training und den Einsatz ziemlich ressourcenintensiv macht.

- Voreingenommenheit und Fairness: LLMs können ungewollt Vorurteile aus den Trainingsdaten lernen und weitergeben, was zu unfairen oder voreingenommenen Ergebnissen führt.

- Interpretierbarkeit: Die Entscheidungen von LLMs zu verstehen und zu erklären, kann echt schwierig sein, weil sie so komplex und undurchsichtig sind.

- Datenschutz: Die Verwendung großer Datensätze für Trainingszwecke kann Bedenken hinsichtlich des Datenschutzes und der Datensicherheit aufwerfen.

- Kosten: Die Entwicklung, das Training und der Einsatz von LLMs können teuer sein, was sie für kleinere Unternehmen schwer zugänglich macht.

Wie gehen LLMs mit Wörtern oder Tokens um, die nicht im Vokabular sind (OOV)?

LLMs gehen mit Wörtern oder Tokens, die nicht im Vokabular sind (OOV), um, indem sie Techniken wie die Subword-Tokenisierung nutzen (z. B. Byte Pair Encoding oder BPE und WordPiece). Diese Techniken zerlegen unbekannte Wörter in kleinere, bekannte Unterwörtereinheiten, die das Modell verarbeiten kann.

Dieser Ansatz sorgt dafür, dass das Modell auch dann, wenn ein Wort während des Trainings nicht vorkommt, den Text anhand seiner Bestandteile verstehen und generieren kann, was die Flexibilität und Robustheit verbessert.

Was sind Einbettungsschichten und warum sind sie in LLMs wichtig?

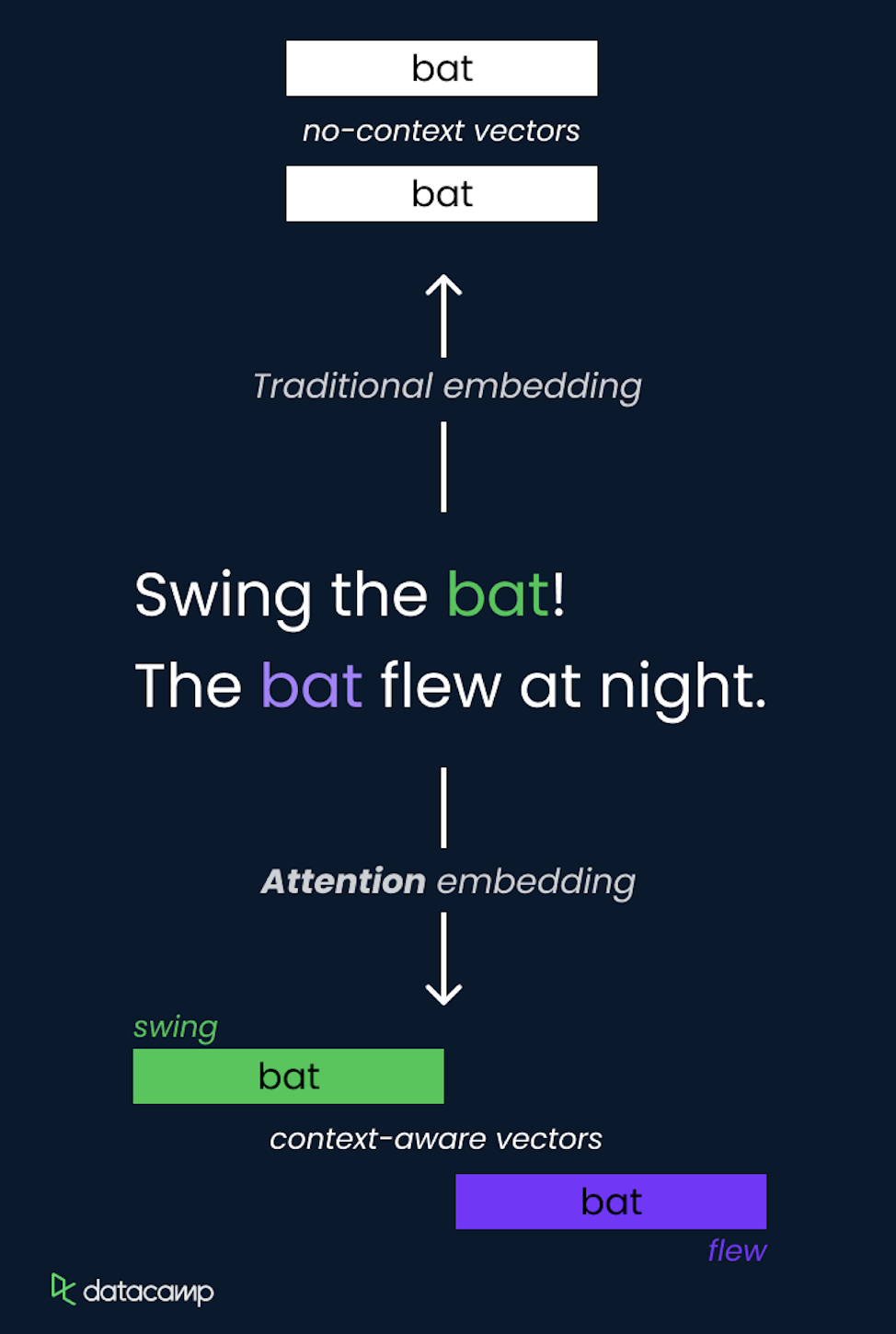

Einbettungsschichten sind ein wichtiger Teil von LLMs, die dazu dienen, kategoriale Daten wie Wörter in dichte Vektordarstellungen umzuwandeln. Diese Einbettungen fangen die semantischen Beziehungen zwischen Wörtern ein, indem sie sie in einem kontinuierlichen Vektorraum darstellen, in dem ähnliche Wörter näher beieinander liegen. Die Bedeutung der Einbettung von Schichten in LLMs umfasst:

- Dimensionsreduktion: Sie machen die Eingabedaten überschaubarer, sodass das Modell sie besser verarbeiten kann.

- Semantisches Verständnis: Einbettungen erfassen feine semantische Bedeutungen und Beziehungen zwischen Wörtern und verbessern so die Fähigkeit des Modells, menschenähnliche Texte zu verstehen und zu generieren.

- Transferlernen: Vortrainierte Einbettungen können für verschiedene Modelle und Aufgaben genutzt werden und bieten eine solide Basis für das Sprachverständnis, die für bestimmte Anwendungen angepasst werden kann.

Wie funktionieren moderne LLM-Positionskodierungen und warum sind Rotary Position Embeddings (RoPE) zum Standard geworden?

Positionskodierungen sagen Transformatoren, wo sich jedes Token in der Sequenz befindet.

Traditionelle sinusförmige Positionskodierungen (von Vaswani et al. 2017) haben feste mathematische Funktionen benutzt, um Positionen statisch zu kodieren. Rotary Position Embeddings (RoPE), die erst kürzlich eingeführt wurden, sind mittlerweile der Standard in modernen LLMs, weil sie einfach bessere Eigenschaften haben.

RoPE funktioniert so, dass es Positionen als Drehwinkel in einem komplexen Vektorraum darstellt und Token-Einbettungen um einen Winkel dreht, der proportional zu ihrer Position ist. Dieser geometrische Ansatz ist effizienter und unterstützt ganz natürlich die Interpolation zu längeren Sequenzen als denen, die während des Trainings gesehen wurden. Das ist eine wichtige Funktion für die Erweiterung von Kontextfenstern. Modelle wie GPT-5.2 und Gemini 3 nutzen RoPE als ihre Positionskodierung.

Fragen für das Vorstellungsgespräch für den Master of Laws (LLM) für Fortgeschrittene

Auf der Basis von Grundkonzepten beschäftigen sich die Fragen für Fortgeschrittene mit den praktischen Techniken, die man benutzt, um die Leistung von LLM zu verbessern und Probleme im Zusammenhang mit der Recheneffizienz und der Interpretierbarkeit von Modellen anzugehen.

Erkläre mal das Konzept der Aufmerksamkeit in LLMs und wie es umgesetzt wird.

Das Konzept der Aufmerksamkeit in LLMs ist eine Methode, mit der sich das Modell bei der Erstellung von Vorhersagen auf verschiedene Teile der Eingabesequenz konzentrieren kann. Es gibt anderen Tokens in der Eingabe dynamisch Gewichte und hebt die relevantesten für die aktuelle Aufgabe hervor.

Das wird mit Selbstaufmerksamkeit gemacht, wo das Modell für jedes Token Aufmerksamswerte im Verhältnis zu allen anderen Tokens in der Sequenz berechnet, sodass es Abhängigkeiten unabhängig von ihrer Entfernung erfassen kann.

Der Selbstaufmerksamkeitsmechanismus ist ein wichtiger Teil der Transformer-Architektur, der es ihr ermöglicht, Infos effizient zu verarbeiten und weitreichende Beziehungen zu erfassen.

Was macht die Tokenisierung bei der LLM-Verarbeitung?

Tokenisierung Das heißt, man zerlegt einen Text in kleinere Teile, die man „Token” nennt. Das können Wörter, Teile von Wörtern oder einfach Zeichen sein.

Die Tokenisierung ist super wichtig bei der Verarbeitung von LLM, weil sie Text in ein Format umwandelt, das das Modell verstehen und verarbeiten kann.

Effektive Tokenisierung sorgt dafür, dass das Modell mit einer Vielzahl von Eingaben klarkommt, auch mit seltenen Wörtern und verschiedenen Sprachen, indem es sie in überschaubare Teile zerlegt. Dieser Schritt ist wichtig für ein optimales Training und eine optimale Inferenz, weil er die Eingaben standardisiert und dem Modell hilft, sinnvolle Muster in den Daten zu lernen.

Wie misst man die Leistung eines LLM?

Forscher und Praktiker haben viele Bewertungsmetriken entwickelt, um die Leistung eines LLM zu messen. Zu den klassischen Kennzahlen gehören:

- Verwirrung: Misst, wie gut das Modell eine Stichprobe vorhersagt, und wird oft bei Sprachmodellierungsaufgaben benutzt.

- Genauigkeit: Wird für Sachen wie Textklassifizierung benutzt, um zu sehen, wie oft die Vorhersagen richtig sind.

- F1-Punktestand: Ein harmonischer Mittelwert aus Präzision und Recall, der für Aufgaben wie die Erkennung benannter Entitäten verwendet wird.

- BLEU-Wert (Bilingual Evaluation Understudy): Misst die Qualität von maschinell erstellten Texten anhand von Referenzübersetzungen, die oft bei maschinellen Übersetzungen verwendet werden.

- ROUGE (Recall-Oriented Understudy for Gisting Evaluation): Ein Satz von Metriken, die die Überschneidung zwischen generiertem Text und Referenztext bewerten und oft bei Zusammenfassungsaufgaben verwendet werden. Sie helfen dabei, die Effektivität des Modells zu messen und zeigen, wie man es noch besser machen kann.

Über die üblichen Messgrößen hinaus nutzen Fachleute jetzt standardisierte Benchmarks für verschiedene Zwecke, wie zum Beispiel MMLU (57-Aufgaben-Wissenstest), MMMU-Pro (multimodales Denken) und HumanEval (Code-Generierung). Außerdem bewerten Ranglisten wie LMArena LLMs nach menschlicher Präferenz. Bei eingesetzten Systemen ist es jetzt echt wichtig, die tatsächlichen Halluzinationsraten, Latenzzeiten und die Token-Effizienz zu messen.

Welche Techniken gibt es, um die Ausgabe eines LLM zu steuern?

Es gibt ein paar Techniken, mit denen man die Ausgabe eines LLM steuern kann, zum Beispiel:

- Temperatur: Wenn du diesen Parameter während der Abtastung anpasst, kannst du die Zufälligkeit der Ausgabe steuern. Niedrigere Temperaturen führen zu deterministischeren Ergebnissen, während höhere Werte zu vielfältigeren Ergebnissen führen.

- Top-K-Stichproben: Schränkt den Stichprobenpool auf die K wahrscheinlichsten Token ein und verringert so die Wahrscheinlichkeit, dass weniger relevante oder unsinnige Texte erzeugt werden.

- Top-P (Kern)-Probenahme: Wählt Token aus dem kleinsten Satz aus, dessen kumulative Wahrscheinlichkeit einen Schwellenwert P überschreitet, und sorgt so für ein Gleichgewicht zwischen Vielfalt und Kohärenz.

- Prompt Engineering: Erstellen von spezifischen Eingabeaufforderungen, um das Modell durch Bereitstellung von Kontext oder Beispielen zur Erzeugung der gewünschten Ergebnisse anzuleiten.

- Kontrollmarken: Mit speziellen Tokens kann man dem Modell sagen, dass es Text in einem bestimmten Stil, Format oder Inhaltstyp erstellen soll.

Wie kann man die Rechenkosten von LLMs senken?

Um die Rechenkosten von LLMs zu senken, können wir Folgendes nutzen:

- Modellbeschneidung: Entferne weniger wichtige Gewichte oder Neuronen aus dem Modell, um es kleiner zu machen und weniger Rechenleistung zu brauchen.

- Quantisierung: Wenn du die Modellgewichte von einer höheren Genauigkeit (z. B. 32-Bit-Gleitkomma) in eine niedrigere Genauigkeit (z. B. 8-Bit-Ganzzahl) umwandelst, sparst du Speicherplatz und machst die Inferenz schneller.

- Destillation: Ein kleineres Modell (Schüler) trainieren, damit es das Verhalten eines größeren, schon trainierten Modells (Lehrer) nachmacht, um mit weniger Ressourcen eine ähnliche Leistung zu erreichen.

- Wenig Aufmerksamkeit: Techniken wie Sparse Transformer, die den Aufmerksamkeitsmechanismus auf eine Untergruppe von Tokens beschränken, reduzieren die Rechenlast.

- Effiziente Architekturen: Entwickle und nutze effiziente Modellarchitekturen, die speziell dafür gemacht sind, den Rechenaufwand zu minimieren und gleichzeitig die Leistung zu halten, wie zum Beispiel Reformer oder Longformer.

Wie wichtig ist die Interpretierbarkeit von Modellen in LLMs und wie kann man das erreichen?

Die Interpretierbarkeit von Modellen ist wichtig, um zu verstehen, wie ein LLM Entscheidungen trifft. Das ist wichtig, um Vertrauen aufzubauen, Verantwortlichkeit sicherzustellen und Verzerrungen zu erkennen und zu verringern. Um Interpretierbarkeit zu erreichen, kann man verschiedene Wege gehen, zum Beispiel:

- Achtung, Visualisierung: Analyse der Aufmerksamkeitsgewichte, um zu sehen, auf welche Teile der Eingabe sich das Modell konzentriert.

- Salienz-Karten: Die Eingabefunktionen hervorheben, die den größten Einfluss auf die Ausgabe des Modells haben.

- Modellunabhängige Methoden: Verwendung von Techniken wie LIME (Local Interpretable Model-agnostic Explanations) zur Erklärung einzelner Vorhersagen.

- Schichtweise Relevanzausbreitung: Die Vorhersagen des Modells in die Beiträge der einzelnen Schichten oder Neuronen aufschlüsseln.

Wie gehen LLMs mit langfristigen Abhängigkeiten im Text um?

LLMs können mit langfristigen Abhängigkeiten im Text umgehen, weil sie so aufgebaut sind, vor allem wegen dem Selbstaufmerksamkeitsmechanismus, der es ihnen ermöglicht, alle Token in der Eingabesequenz gleichzeitig zu berücksichtigen. Diese Fähigkeit, auf entfernte Token zu achten, hilft LLMs dabei, Beziehungen und Abhängigkeiten über lange Kontexte hinweg zu erfassen.

Außerdem sind fortgeschrittene Modelle wie Transformer-XL und Longformer extra dafür gemacht, das Kontextfenster zu erweitern und längere Sequenzen besser zu verwalten, damit langfristige Abhängigkeiten besser geklärt werden können.

Moderne Produktionsmodelle nutzen ausgeklügeltere Strategien, um mit langfristigen Abhängigkeiten umzugehen und Leistungseinbußen durch erweiterte Kontextfenster auszugleichen, wie zum Beispiel:

- Rotary Position Embeddings (RoPE) für eine bessere Längenextrapolation und eine bessere Positionskodierung.

- Aufmerksamkeitsmuster, die für lange Sequenzen optimiert sind, einschließlich Varianten für gruppierte Abfragen und Multi-Head-Aufmerksamkeit.

- Sorgfältige Wissensintegration über RAG, statt sich nur auf die Kapazität des Kontextfensters zu verlassen.

Was ist Retrieval-Augmented Generation (RAG) und wie hat es sich entwickelt?

RAG mischt Suchmechanismen mit generativen Modellen, um während der Textgenerierung relevante Infos aus externen Quellen zu holen. Dieser Ansatz geht direkt auf zwei wichtige Einschränkungen von LLM ein: Halluzinationen und Aktualität des Wissens. Das klassische RAG nutzt ziemlich einfache Abruf- und Generierungspipelines, aber mit der Weiterentwicklung zu „RAG 2.0” ist es deutlich komplexer geworden.

Die wichtigsten Features von RAG 2.0 sind:

- Rekursives Abrufen: Modelle denken über Lücken in den gefundenen Infos nach und machen proaktiv weitere Suchen, um Wissenslücken zu schließen, anstatt sich nur auf einen einzigen Suchlauf zu verlassen.

- Multimodale Suche: Integration über verschiedene Formate hinweg – Text, Bilder, PDFs, Videos und sogar API-Aufrufe – für eine umfassendere Kontextbeschaffung

- Hybride Indizierung: Kombinierte BM25-Suche (basierend auf Schlüsselwörtern) und Vektorsuche (semantisch), um sowohl lexikalische als auch semantische Relevanz zu erfassen.

- Ebenen neu ordnen: Intelligente Filterung der ersten Suchergebnisse, um Störsignale und unwichtige Infos zu reduzieren

- Agentische Anpassung: Dynamische Strategieauswahl, bei der das System die Abrufmethoden je nach Komplexität der Anfrage und Bereich auswählt.

RAG 2.0 zusammen mit LLMs senkt die Halluzinationsrate in Produktionssystemen im Vergleich zu Basismodellen um 40 bis 60 %.

Fragen für das Vorstellungsgespräch für den Master of Laws (LLM)

Das Verständnis fortgeschrittener Konzepte in LLMs ist nützlich für Fachleute, die die Grenzen dessen, was diese Modelle leisten können, erweitern wollen. Hier geht's um schwierige Themen und typische Probleme, die in diesem Bereich auftauchen.

Erkläre mal das Konzept des „Few-Shot-Lernens“ in LLMs und was daran so gut ist.

Few-Shot-Lernen in LLMs bedeutet, dass das Modell neue Aufgaben mit nur wenigen Beispielen lernen und ausführen kann. Diese Funktion nutzt das umfangreiche, vorab trainierte Wissen des LLM und lässt es aus wenigen Beispielen Schlussfolgerungen ziehen.

Die Hauptvorteile des Few-Shot-Lernens sind weniger Daten, weil man keine riesigen aufgabenbezogenen Datensätze braucht, mehr Flexibilität, weil sich das Modell mit wenig Feintuning an verschiedene Aufgaben anpassen kann, und Kosteneffizienz, weil man mit weniger Daten und kürzeren Trainingszeiten bei der Datenerfassung und den Rechenressourcen viel Geld sparen kann.

Was sind die Unterschiede zwischen autoregressiven und maskierten Sprachmodellen?

Autoregressive und maskierte Sprachmodelle unterscheiden sich hauptsächlich in ihrem Vorhersageansatz und ihrer Eignung für bestimmte Aufgaben. Autoregressive Modelle wie GPT-5.2, Claude 4.5 Opus und Gemini 3 sagen das nächste Wort in einer Sequenz voraus, basierend auf den vorherigen Wörtern, und machen so einen Text Token für Token.

Diese Modelle sind besonders gut für Aufgaben zur Textgenerierung geeignet. Im Gegensatz dazu gibt's maskierte Sprachmodelle wie BERT, maskieren Wörter in einem Satz nach dem Zufallsprinzip und trainieren das Modell, diese maskierten Wörter anhand des umgebenden Kontexts vorherzusagen. Dieser bidirektionale Ansatz hilft dem Modell, den Kontext aus beiden Richtungen zu verstehen, was es super für Textklassifizierungs- und Frage-Antwort-Aufgaben macht.

Wie kannst du externes Wissen in einen LLM einbauen?

Externes Wissen in einen LLM einbauen kann man auf verschiedene Arten:

- Integration von Wissensgraphen: Ergänzung der Modelleingaben mit Infos aus strukturierten Wissensgraphen, um Kontextinfos zu liefern.

- Retrieval-Augmented Generation (RAG): Kombiniert Suchmethoden mit generativen Modellen, um während der Textgenerierung relevante Infos aus externen Quellen zu holen. Moderne RAG 2.0-Systeme nutzen rekursives Retrieval, hybride Indizierung und Re-Ranking für eine bessere Wissensintegration im Vergleich zu einfachen Retrieval-Ansätzen.

- Feinabstimmung mit domänenspezifischen Daten: Das Modell mit zusätzlichen Datensätzen trainieren, die das nötige Wissen haben, um es für bestimmte Aufgaben oder Bereiche zu spezialisieren.

- Schnelle Entwicklung: Entwerfen von Eingabeaufforderungen, die das Modell dabei unterstützen, externes Wissen während der Inferenz effektiv zu nutzen.

Was sind die Herausforderungen beim Einsatz von LLMs in der Produktion?

Der Einsatz von LLMs in der Produktion bringt verschiedene Herausforderungen mit sich:

- Skalierbarkeit: Damit das Modell viele Anfragen gut verarbeiten kann, braucht man oft viel Rechenleistung und eine gut optimierte Infrastruktur.

- Latenz: Bei Anwendungen wie Chatbots und virtuellen Assistenten ist es super wichtig, die Reaktionszeit so kurz wie möglich zu halten, um Ergebnisse in Echtzeit oder fast in Echtzeit zu liefern.

- Überwachung und Wartung: Um die Leistung von Modellen ständig im Auge zu behalten und sie für neue Daten und Aufgaben anzupassen, braucht man zuverlässige Überwachungssysteme und regelmäßige Updates.

- Ethische und rechtliche Überlegungen: Um ethische Probleme und rechtliche Konsequenzen zu vermeiden, ist es wichtig, sich mit Fragen wie Voreingenommenheit, Datenschutz und der Einhaltung von Vorschriften auseinanderzusetzen.

- Ressourcenmanagement: Die Verwaltung der für die Inferenz erforderlichen umfangreichen Rechenressourcen sorgt für Kosteneffizienz und umfasst die Optimierung der Hardware- und Softwarekonfigurationen.

Wie gehst du mit der Modellverschlechterung im Laufe der Zeit bei eingesetzten LLMs um?

Modellverschlechterung passiert, wenn die Leistung eines LLM mit der Zeit nachlässt, weil sich die zugrunde liegende Datenverteilung ändert. Um die Verschlechterung des Modells zu vermeiden, muss man es regelmäßig mit neuen Daten trainieren, damit es gut läuft. Man muss das Modell ständig im Auge behalten, um zu sehen, wie es läuft und ob es Anzeichen für Probleme gibt.

Mit inkrementellen Lerntechniken kann das Modell aus neuen Daten lernen, ohne vorher gelernte Infos zu vergessen. Außerdem vergleicht das A/B-Testing die Leistung des aktuellen Modells mit neuen Versionen und hilft dabei, mögliche Verbesserungen vor der vollständigen Einführung zu erkennen.

Was sind ein paar Techniken, um sicherzustellen, dass LLMs ethisch genutzt werden?

Um den ethische Nutzung von LLMskönnen verschiedene Techniken eingesetzt werden:

- Verringerung von Voreingenommenheit: Strategien anwenden, um Verzerrungen in Trainingsdaten und Modellergebnissen zu erkennen und zu reduzieren, z. B. durch die Verwendung ausgewogener Datensätze und Tools zur Erkennung von Verzerrungen.

- Transparenz und Erklärbarkeit: Entwicklung von Modellen, die verständliche und erklärbare Ergebnisse liefern, um Vertrauen und Verantwortlichkeit zu fördern, einschließlich der Verwendung von Aufmerksamkeitsvisualisierung und Salienz-Karten.

- Zustimmung und Datenschutz: Sicherstellen, dass die für Training und Inferenz verwendeten Daten den Datenschutzbestimmungen entsprechen, und bei Bedarf die Zustimmung der Nutzer einholen.

- Fairness-Prüfungen: Mach regelmäßig Audits, um zu checken, ob das Verhalten des Modells fair ist und keine ethischen Probleme hat.

- Verantwortungsbewusster Einsatz: Richtlinien und Strategien für verantwortungsvollen Einsatz von KI, einschließlich des Umgangs mit schädlichen oder unangemessenen Inhalten, die vom Modell generiert werden.

Wie kannst du die Sicherheit von Daten gewährleisten, die mit LLMs verwendet werden?

Um die mit LLMs verwendeten Daten zu schützen, muss man verschiedene Maßnahmen umsetzen. Dazu gehört, dass man Verschlüsselungstechniken für gespeicherte und übertragene Daten nutzt, um sie vor unbefugtem Zugriff zu schützen. Es braucht strenge Zugriffskontrollen, damit nur Leute, die das dürfen, an sensible Daten rankommen.

Es ist auch super wichtig, Daten zu anonymisieren, um persönliche Infos (PII) zu entfernen, bevor man sie für Training oder Schlussfolgerungen nutzt. Außerdem ist es wichtig, Datenschutzbestimmungen wie die DSGVO oder den CCPA einzuhalten, um rechtliche Probleme zu vermeiden.

Diese Maßnahmen helfen dabei, die Datenintegrität, Vertraulichkeit und Verfügbarkeit zu schützen. Dieser Schutz ist super wichtig, um das Vertrauen der Nutzer zu behalten und die gesetzlichen Standards einzuhalten.

Wie verbessert das Reinforcement Learning aus menschlichem Feedback (RLHF) die Qualität und Sicherheit der LLM-Ausgabe und wie sieht es im Vergleich zu neueren Alignment-Methoden wie DPO und RLAIF aus?

RLHF ( ) ist eine Technik, bei der ein LLM trainiert wird, seine Ergebnisse an menschlichen Präferenzen auszurichten, indem Feedback von menschlichen Bewertern einfließt. Dieser wiederholte Prozess hilft dem Modell dabei, Antworten zu lernen, die nicht nur genau, sondern auch sicher, unvoreingenommen und hilfreich sind.

Allerdings bringt RLHF auch Herausforderungen mit sich. Eine Herausforderung ist, dass menschliches Feedback voreingenommen sein kann, weil verschiedene Bewerter unterschiedliche Vorlieben und Interpretationen haben können.

Eine weitere Herausforderung ist die Skalierbarkeit des Feedback-Prozesses, da das Sammeln und Einarbeiten großer Mengen an menschlichem Feedback zeitaufwändig und teuer sein kann. Außerdem kann es schwierig sein, sicherzustellen, dass das in RLHF verwendete Belohnungsmodell die gewünschten Verhaltensweisen und Werte genau erfasst. Der Optimierungsschritt PPO (Proximal Policy Optimization) macht die Sache komplizierter und kann während des Trainings zu Instabilität führen.

Es gibt jetzt moderne Alternativen, die viele der Einschränkungen von RLHF lösen:

- DPO (Direkte Präferenzoptimierung): Das separate Belohnungsmodell wird komplett abgeschafft, stattdessen werden implizite Belohnungssignale genutzt, die direkt aus Präferenzpaaren abgeleitet werden. Dieser Ansatz ist einfacher, stabiler und rechnerisch effizienter als das PPO-basierte RLHF. DPO wird jetzt von vielen großen KI-Labors als Alternative oder Ergänzung zum herkömmlichen RLHF eingesetzt.

- GRPO (Gradientenbasierte Belohnungsrichtlinienoptimierung): Eine Variante, die die Vorteile der Einfachheit von DPO mit Elementen des PPO-Lernens kombiniert und so einen guten Mittelweg bietet.

- RLAIF (Verstärkendes Lernen durch KI-Feedback): Ersetzt menschliche Bewerter durch KI-Feedback (wie Bewertungen von leistungsstärkeren Modellen oder spezialisierten Bewertern). Dieser Ansatz macht die Probleme und Kosten der Skalierbarkeit viel kleiner, weil es billiger und schneller ist, KI-Feedback zu generieren, als Feedback von Menschen zu sammeln.

Die meisten Serienmodelle nutzen DPO, RLAIF oder hybride Kombinationen statt reinem PPO-basiertem RLHF.

Vergleich mal Zustandsraummodelle (wie Mamba) mit Transformers. Was sind die Vor- und Nachteile, und wann würdest du was davon nehmen?

Wissensbasierte Halluzinationen treten auf, wenn das Modell nicht die richtigen Fakten hat (oder veraltete Fakten hat), sodass es sich plausible Informationen ausdenkt. Korrekturen umfassen normalerweise:

- Das Modell mit Abruf (RAG) erden

- Verifizierte Quellen hinzufügen

- Domänenspezifische Feinabstimmung

Logikbasierte Halluzinationen treten auf, wenn das Modell zwar über relevante Infos verfügt, aber falsch argumentiert oder Unstimmigkeiten erzeugt. Häufige Lösungen sind:

- Strukturierte Aufforderung

- Schritte zur Überprüfung/Selbstkontrolle (oft über automatisierte Abläufe)

- Gezielte Bewertung

Was ist der Unterschied zwischen wissensbasierten und logikbasierten Halluzinationen in LLMs und wie geht man mit den beiden um?

Während Transformers heute die LLMs dominieren, haben sich Zustandsraummodelle (SSMs) wie Mamba als konkurrenzfähiges Architekturparadigma mit ganz anderen Rechen- und Leistungseigenschaften durchgesetzt. Für moderne LLM-Profis wird es immer wichtiger, beides zu verstehen.

Transformatoren:

- Stärken: Super beim Abrufen von Infos, beim Kopieren/Einfügen und beim Lernen im Kontext. Bewährte Architektur in großem Maßstab mit umfangreichen Tools und Infrastruktur. Tolle Ergebnisse bei der Codegenerierung und verschiedenen Benchmarks.

- Schwächen: Die O(N²) Aufmerksamkeitskomplexität führt zu quadratischen Speicher- und Rechenanforderungen. Das zeigt sich in einer schlechteren Leistung bei richtig langen Sequenzen (>100.000 Token) und einer hohen Latenz bei Anwendungen mit langem Kontext.

- Anwendungsfälle und Empfehlungen: Die meisten LLM-Modelle, die heute produziert werden (GPT, Claude, Gemini, Llama). Empfohlen für aktuelle reale Anwendungen und die nächste Zeit.

Zustandsraummodelle (Mamba, Mamba-2):

- Stärken: O(N)-Komplexität mit linearer Speicherskalierung. 5-10x schnellere Inferenz bei langen Sequenzen (>50.000 Token). Bessere theoretische Grundlagen für die Signalverarbeitung. Besser vorhersehbares Skalierungsverhalten.

- Schwächen: Brauchen 10 Mal mehr Trainingsdaten als Transformers, um die gleiche Leistung zu bringen. Nicht so stark bei der Informationsbeschaffung und beim Kopieren. Ein noch nicht so ausgereiftes Ökosystem mit weniger Tools, Bibliotheken und trainierten Modellen.

- Anwendungsfälle und Empfehlungen: Für spezielle Anwendungen – Verarbeitung langer Dokumente, Echtzeitsysteme mit Latenzbeschränkungen, Streaming-Anwendungen und möglicherweise spezielle Bereiche, in denen eine O(N)-Skalierung wichtig ist.

Neueste Studien zeigen, dass Transformers und SSMs sich eher ergänzen als direkt miteinander konkurrieren, da unterschiedliche Anwendungsfälle und Einschränkungen verschiedene Architekturen begünstigen. Transformatoren sind immer noch die beste Wahl für allgemeine LLMs und werden wahrscheinlich vorerst weiter dominieren. Eine hybride Zukunft ist wahrscheinlich, mit speziellen Modellen für unterschiedliche Rechen- und Aufgabenanforderungen.

LLM-Interviewfragen für Prompt-Ingenieure

Prompt Engineering ist ein wichtiger Teil bei der Nutzung von LLMs. Es geht darum, genaue und effektive Eingabeaufforderungen zu erstellen, um die gewünschten Antworten vom Modell zu bekommen. Hier geht's um wichtige Fragen, die Ingenieure vielleicht haben.

Was ist Prompt Engineering und warum ist es so wichtig für die Arbeit mit LLMs?

Prompt Engineering bedeutet, Prompts zu entwerfen und zu verfeinern, um LLMs dabei zu helfen, genaue und relevante Ergebnisse zu liefern. Das ist super wichtig für die Arbeit mit LLMs, weil die Qualität der Eingabe direkt die Leistung des Modells beeinflusst.

Effektive Eingabeaufforderungen können das Modell dabei unterstützen, die Aufgabe besser zu verstehen, genaue und relevante Antworten zu generieren und die Fehlerwahrscheinlichkeit zu verringern.

Prompt Engineering ist super wichtig, um den Nutzen von LLMs in verschiedenen Anwendungen zu maximieren, von der Textgenerierung bis hin zu komplexen Problemlösungsaufgaben.

Kannst du Beispiele für verschiedene Prompting-Techniken (Zero-Shot, Few-Shot, Chain-of-Thought) nennen und erklären, wann man sie einsetzt?

- Zero-Shot-Prompting: Gibt dem Modell eine Aufgabenbeschreibung ohne Beispiele. Wird normalerweise benutzt, wenn keine Beispiele da sind oder wenn wir das allgemeine Verständnis und die Flexibilität des Modells testen wollen.

- Few-Shot-Prompting: Liefert ein paar Beispiele zusammen mit der Aufgabenbeschreibung, um das Modell anzuleiten. Das ist nützlich, wenn das Modell Kontext oder Beispiele braucht, um die Aufgabe besser zu verstehen.

- Gedankenkette anregen: Teilt eine komplizierte Aufgabe in kleinere, aufeinanderfolgende Schritte auf, die das Modell befolgen kann. Das kann bei Aufgaben, die logisches Denken und mehrstufige Problemlösungen erfordern, echt hilfreich sein.

- Agentische Aufforderung: Strukturiert die Aufforderungen, damit Modelle wie autonome Agenten funktionieren, die Tools/APIs aufrufen, Infos sammeln und über mehrere Schritte hinweg Schlussfolgerungen ziehen. Die Anweisungen umfassen Definitionen des Aktionsraums, Beschreibungen der Werkzeuge und klare Anforderungen an die Argumentation.

Wie beurteilst du die Wirksamkeit einer Aufforderung?

Die Wirksamkeit einer Aufforderung zu checken, bedeutet:

- Ausgabequalität: Die Relevanz, Kohärenz und Genauigkeit der Antworten des Modells checken.

- Konsistenz: Überprüfen, ob das Modell bei verschiedenen Eingaben immer gute Ergebnisse liefert.

- Aufgabenspezifische Kennzahlen: Verwendung aufgabenspezifischer Bewertungsmetriken wie BLEU für Übersetzungen oder ROUGE für Zusammenfassungen, um die Leistung zu messen.

- Menschliche Bewertung: Menschen einbeziehen, um qualitatives Feedback zu den Ergebnissen des Modells zu geben.

- A/B-Test: Verschiedene Eingabeaufforderungen vergleichen, um zu sehen, welche besser funktioniert.

Was sind ein paar Strategien, um häufige Fallstricke beim Entwerfen von Aufforderungen zu vermeiden (z. B. Suggestivfragen, unklare Anweisungen)?

- Vermeide Suggestivfragen: Stell sicher, dass die Eingabeaufforderungen keine bestimmte Antwort vorgeben, da das die Antwort des Modells beeinflussen könnte.

- Klare und knappe Anweisungen: Gib klare und einfache Anweisungen, um Verwirrung zu vermeiden.

- Kontextangabe: Füge relevanten Kontext hinzu, damit das Modell die Aufgabe versteht, ohne es mit unnötigen Infos zu überladen.

- Iteratives Testen: Probier die Eingabeaufforderungen immer wieder aus und mach sie besser, basierend auf den Ergebnissen und der Leistung des Modells.

Wie gehst du bei der iterativen Verfeinerung von Eingabeaufforderungen vor, um die Leistung von LLM zu verbessern?

Die iterative Verfeinerung von Eingabeaufforderungen umfasst:

- Erstes Design: Fang mit einer einfachen Eingabeaufforderung an, die auf den Aufgabenanforderungen basiert.

- Testen und Bewerten: Schau dir die Leistung der Eingabeaufforderung mit verschiedenen Metriken an und hol dir Feedback dazu.

- Analyse: Finde Schwachstellen oder Bereiche, die in der Aufforderung verbessert werden können.

- Verfeinerung: Passe die Eingabeaufforderung an, um die gefundenen Probleme zu beheben.

- Wiederhole: Mach den Test- und Optimierungsprozess so oft, bis du die gewünschte Leistung hast.

Welche Tools oder Frameworks benutzt du, um den Prompt-Engineering-Prozess zu optimieren?

Es gibt ein paar Tools und Frameworks, die den Prozess des Prompt Engineerings vereinfachen können:

- LLM-spezifische Plattformen: LangChain und LlamaIndex für Prompt Chaining und den Aufbau agentenbasierter Systeme; Vercel AI SDK für schnelles Prototyping und schnelle Bereitstellung.

- Schnelle Tests und Optimierung: PromptFoo (automatisiertes Testen von Eingabeaufforderungen in verschiedenen Szenarien), DSPy (programmatische Optimierung von Eingabeaufforderungen), Haystack (Aufbau einer RAG-Pipeline).

- Interaktive Entwicklungsumgebungen (IDEs): Jupyter Notebook zum Experimentieren, VS Code mit LLM-Erweiterungen (GitHub Copilot, Cursor), Streamlit zum Erstellen interaktiver UI-Prototypen.

- APIs und SDKs: OpenAI API, Anthropic SDK, Together AI und LM Studio für die lokale Modellbereitstellung.

- Versionskontrolle & Zusammenarbeit: Git-basierte Prompt-Versionierung, Weights & Biases zum Verfolgen und Vergleichen von Experimenten, HuggingFace Hub zum Teilen von Modellen und Prompts.

- Agentische Rahmenbedingungen: AutoGPT, OpenAI Assistants API, LangGraph zum Erstellen von komplexen mehrstufigen agentenbasierten Workflows.

- Bewertung und Überwachung: Ragas (RAG-Bewertungsmetriken), LangSmith (Tracing, Debugging und Produktionsüberwachung), Braintrust (End-to-End-LLM-Beobachtbarkeit).

Wie gehst du mit Problemen wie Halluzinationen oder Verzerrungen in LLM-Ausgaben durch Prompt Engineering um?

Diese Frage geht um die ethischen und praktischen Probleme von Inhalten, die von LLM erzeugt werden. Eine gute Antwort würde zeigen, dass du dir dieser Probleme bewusst bist, und Techniken wie die folgenden ansprechen.

Techniken zur Linderung von Halluzinationen:

- Fragen zur Faktenüberprüfung: Füge Aufforderungen ein, die das Modell dazu bringen, seine Infos mit zuverlässigen Quellen zu vergleichen und Beweise klar zu nennen.

- Integration der Abfrage: Benutze RAG- oder RAG 2.0-Systeme, um Antworten auf echte Dokumente zu stützen. So werden erfundene Fakten reduziert, weil das Modell auf abgerufene Infos verweisen muss.

- Agentische Verifizierungsschleifen: Strukturiert die Aufforderungen, damit das Modell eine mehrstufige Überprüfung durchführt, bei der es seine eigene Arbeit überprüft, bevor es antwortet – im Grunde genommen werden so Selbstüberprüfungsagenten geschaffen.

- Einschränkungsbasierte Eingabeaufforderungen: Lass uns das Ausgabeformat und die logischen Einschränkungen festlegen, die Unstimmigkeiten oder nicht unterstützte Behauptungen aufzeigen.

Techniken zur Verringerung von Verzerrungen:

- Verschiedene Perspektiven regen zum Nachdenken an: Hilf dem Modell, verschiedene Standpunkte und die Sichtweisen der Beteiligten zu berücksichtigen, bevor es zu einem Schluss kommt.

- Hinweise zur Erkennung von Voreingenommenheit: Frag das Modell, ob es irgendwelche möglichen Verzerrungen in seiner Argumentation und seinen Ergebnissen gibt.

- Kontrafaktische Aufforderungen: Frag nach alternativen Szenarien oder Perspektiven, um die ersten Annahmen zu hinterfragen und die Robustheit der Argumentation zu testen.

- Klarheit der Anweisungen: Sag klar, dass die Antworten ausgewogen sein sollen, gib Einschränkungen zu und vermeide diskriminierende Formulierungen.

Kannst du mal erklären, was Prompt-Vorlagen sind und wie man sie beim Prompt Engineering benutzt?

Prompt-Vorlagen bieten ein strukturiertes Format für Eingabeaufforderungen und haben oft Platzhalter für bestimmte Infos oder Anweisungen. Sie können für verschiedene Aufgaben und Situationen wiederverwendet werden, was die Konsistenz und Effizienz beim Entwerfen von Eingabeaufforderungen verbessert.

Eine gute Antwort würde erklären, wie man mit Prompt-Vorlagen bewährte Verfahren zusammenfassen, fachspezifisches Wissen einbauen und den Prozess der Erstellung effektiver Prompts für verschiedene Anwendungen optimieren kann.

Wie wirkt sich die Wahl eines Tokenizers auf das Prompt Engineering und die Modellleistung aus?

Der Tokenizer ist echt wichtig dafür, wie das LLM die Eingabe interpretiert und verarbeitet. Verschiedene Tokenizer haben unterschiedliche Vokabulargrößen und gehen anders mit Wörtern um, die nicht im Vokabular sind (OOV-Wörter). Ein Subword-Tokenizer wie Byte Pair Encoding (BPE) kann OOV-Wörter verarbeiten, indem er sie in kleinere Subword-Einheiten aufteilt, während ein wortbasierter Tokenizer sie vielleicht als unbekannte Tokens behandelt.

Die Wahl des Tokenizers kann die Leistung des Modells auf verschiedene Arten beeinflussen. Zum Beispiel kann ein Subword-Tokenizer besser sein, um die Bedeutung von seltenen oder technischen Begriffen zu erfassen, während ein wortbasierter Tokenizer für allgemeine Sprachaufgaben einfacher und schneller sein kann.

Bei der Prompt-Entwicklung kann die Wahl des Tokenizers beeinflussen, wie du deine Prompts aufbaust. Wenn du zum Beispiel einen Subword-Tokenizer benutzt, solltest du vielleicht genauer drauf achten, wie Wörter in Subwords aufgeteilt werden, damit das Modell die beabsichtigte Bedeutung richtig erfasst.

Was ist agentenbasiertes Prompting und wie unterscheidet es sich vom herkömmlichen Prompt Engineering?

Agentisches Prompting ist ein Ansatz zum Entwerfen von Prompts, bei dem das Modell so programmiert wird, dass es wie ein „Agent” agiert, der planen, Maßnahmen ergreifen (z. B. Tools/APIs aufrufen oder Dokumente abrufen), die Ergebnisse beobachten und so lange wiederholen kann, bis ein Ziel erreicht ist.

Im Gegensatz zum traditionellen Prompt Engineering, bei dem man vor allem versucht, mit klaren Anweisungen, Beispielen und Formatierungsvorgaben auf Anhieb die bestmögliche Antwort zu kriegen, setzt das agentenbasierte Prompting auf einen mehrstufigen Regelkreis (Planen → Ausführen → Beobachten → Verfeinern).

Das ist besonders nützlich für Aufgaben, bei denen es darauf ankommt, mit externen Systemen (Datenbanken, Suche, Codeausführung) zu interagieren oder Zwischenergebnisse zu überprüfen, anstatt sich nur auf das interne Wissen des Modells zu verlassen.

Gute Handlungsaufforderungen sagen normalerweise, was das Ziel ist, welche Tools/Aktionen man nutzen kann, wie man entscheidet, was man macht, und wann man aufhören sollte. Es ist auch üblich, explizite Verifizierungsschritte hinzuzufügen (z. B. „abgerufene Quellen überprüfen“ oder „vor der endgültigen Antwort neu berechnen“), um Halluzinationen zu reduzieren und die Zuverlässigkeit zu verbessern.

Verdiene eine Top-KI-Zertifizierung

Fazit

Dieser Leitfaden enthält eine Reihe von Interviewfragen, die dir helfen sollen, dich auf Gespräche über LLMs vorzubereiten, von den Grundlagen bis hin zu fortgeschrittenen Strategien.

Egal, ob du dich auf ein Vorstellungsgespräch vorbereitest oder dein Wissen vertiefen möchtest – mit diesen Einblicken bekommst du das nötige Wissen, um dich im Bereich der künstlichen Intelligenz zurechtzufinden und erfolgreich zu sein.

Wenn du dich über die neuesten Entwicklungen im Bereich KI und LLMs informieren möchtest, empfehle ich dir diese Themen: