Cursus

Les grands modèles linguistiques (LLM) ont pris une importance croissante dans le domaine de l'intelligence artificielle, avec des applications dans divers secteurs.

Alors que la demande en professionnels possédant une expertise en LLM augmente, cet article fournit un ensemble complet de questions et réponses d'entretien, couvrant les concepts fondamentaux, les techniques avancées et les applications pratiques.

Si vous vous préparez à un entretien d'embauche ou si vous souhaitez simplement élargir vos connaissances, cet article vous sera utile.

Questions d'entretien de base pour le LLM

Pour appréhender les LLM, il est essentiel de commencer par les concepts fondamentaux. Ces questions fondamentales couvrent des aspects essentiels tels que l'architecture, les mécanismes clés et les défis typiques, fournissant ainsi une base solide pour l'apprentissage de sujets plus avancés.

Qu'est-ce que l'architecture Transformer et comment est-elle utilisée dans les LLM ?

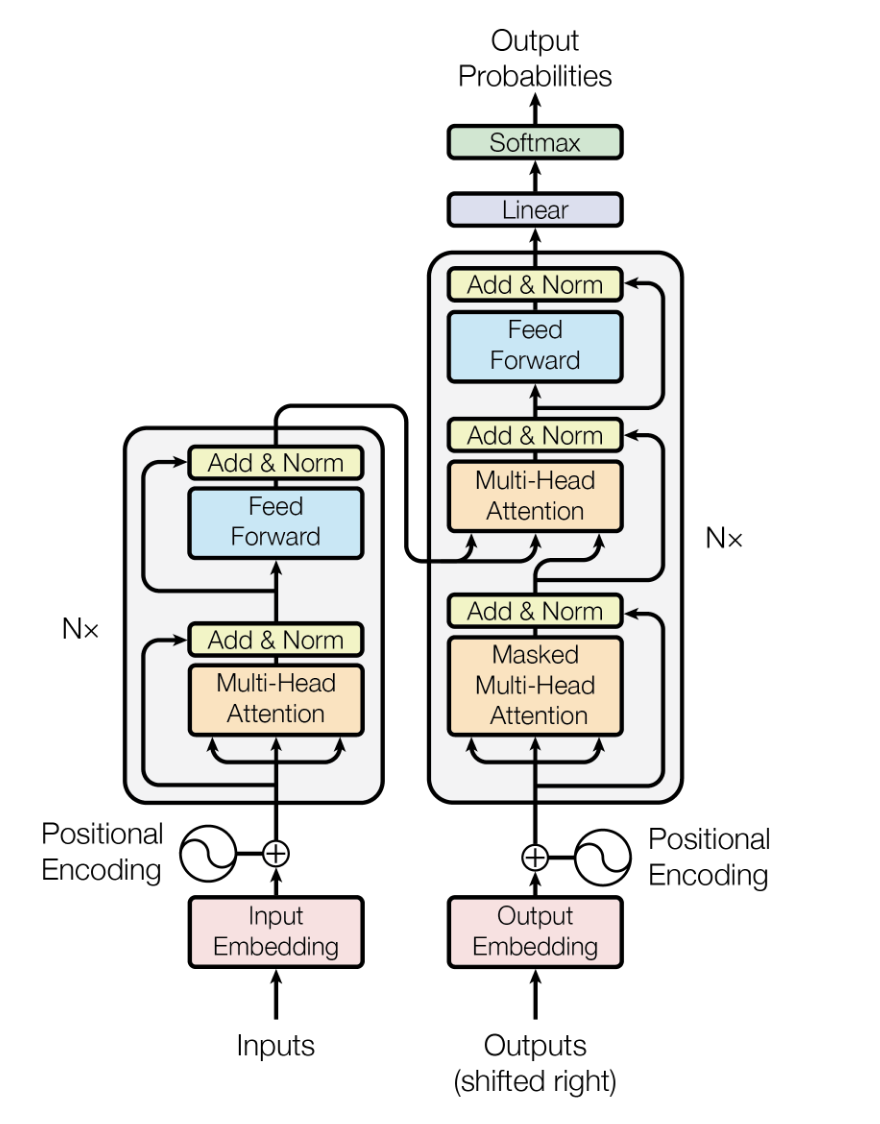

L' architecture Transformer est un modèle d'apprentissage profond présenté par Vaswani et alen 2017. Elle est conçue pour traiter des données séquentielles avec une efficacité et des performances améliorées par rapport aux modèles précédents, tels que les réseaux neuronaux récurrents (RNN) et les réseaux neuronaux à mémoire à court terme (LSTM).

Il repose sur des mécanismes d'auto-attention pour traiter les données d'entrée en parallèle, ce qui le rend hautement évolutif et capable de capturer des dépendances à longue portée.

Dans les LLM, l'architecture Transformer constitue la colonne vertébrale, permettant aux modèles de traiter efficacement de grandes quantités de données textuelles et de générer des sorties textuelles cohérentes et pertinentes sur le plan contextuel.

L'architecture du modèle Transformer. Source

Veuillez expliquer le concept de « fenêtre contextuelle » dans les modèles d'apprentissage profond (LLM) et son importance.

La fenêtre contextuelle dans les LLM fait référence à la plage de texte (en termes de tokens ou de mots) que le modèle peut prendre en compte simultanément lors de la génération ou de la compréhension du langage. L'importance de la fenêtre contextuelle réside dans son impact sur la capacité du modèle à générer des réponses logiques et pertinentes.

En règle générale, une fenêtre contextuelle plus large permet au modèle de prendre en compte davantage de contexte, ce qui améliore la compréhension et la génération de texte, en particulier dans les conversations complexes ou longues. Cependant, cela augmente également les exigences en matière de calcul, ce qui nécessite de trouver un équilibre entre performance et efficacité.

De plus, des recherches récentes indiquent que les modèles de most présentent une dégradation de leurs performances bien avant d'atteindre les limites annoncées. Les modèles peuvent présenter un phénomène de « perte au milieu » où les informations situées au centre du contexte sont ignorées ou reléguées au second plan. Par conséquent, uncontexte pertinent et soigneusement sélectionné dans des fenêtres plus petites est souvent plus efficace que de remplir de bruit des fenêtres plus grandes.

Quels sont les objectifs courants avant la formation pour les LLM et comment fonctionnent-ils ?

Les objectifs courants avant formation pour les LLM comprennent la modélisation linguistique masquée (MLM) et la modélisation linguistique autorégressive. Dans le MLM, des mots aléatoires dans une phrase sont masqués, et le modèle est entraîné à prédire les mots masqués en fonction du contexte environnant. Cela permet au modèle de mieux appréhender le contexte bidirectionnel.

La modélisation autorégressive du langage consiste à prédire le mot suivant dans une séquence et à entraîner le modèle à générer du texte un token à la fois. Ces deux objectifs permettent au modèle d'apprendre les schémas linguistiques et la sémantique à partir de vastes corpus, fournissant ainsi une base solide pour affiner des tâches spécifiques.

Vous souhaitez vous lancer dans l'IA générative ?

Apprenez à travailler avec des LLM en Python directement dans votre navigateur

Qu'est-ce que le réglage fin dans le contexte des LLM, et pourquoi est-il important ?

Le réglage fin dans le contexte des LLM consiste à prendre un modèle pré-entraîné et à le perfectionner à l'aide d'un ensemble de données plus restreint et spécifique à une tâche. Ce processus aide le modèle à adapter sa compréhension générale du langage aux nuances de l'application spécifique, améliorant ainsi ses performances.

Il s'agit d'une technique importante, car elle exploite les connaissances linguistiques générales acquises lors de la pré-formation tout en modifiant le modèle afin qu'il fonctionne efficacement dans des applications spécifiques, telles que l'analyse des sentiments, la synthèse de texte ou les questions-réponses.

Quels sont les défis courants associés à l'utilisation des LLM ?

L'utilisation des LLM présente plusieurs défis, notamment :

- Ressources informatiques : Les LLM nécessitent une puissance de calcul et une mémoire importantes, ce qui rend leur formation et leur déploiement très gourmands en ressources.

- Parti pris et équité : Les LLM peuvent involontairement apprendre et propager les biais présents dans les données d'entraînement, ce qui conduit à des résultats injustes ou biaisés.

- Interprétabilité : Il peut être difficile de comprendre et d'expliquer les décisions prises par les LLM en raison de leur nature complexe et opaque.

- Confidentialité des données : L'utilisation de grands ensembles de données pour la formation peut soulever des questions relatives à la confidentialité et à la sécurité des données.

- Coût : Le développement, la formation et le déploiement des LLM peuvent s'avérer coûteux, ce qui limite leur accessibilité pour les petites organisations.

Comment les LLM gèrent-ils les mots ou les tokens hors vocabulaire (OOV) ?

Les LLM traitent les mots ou les tokens hors vocabulaire (OOV) à l'aide de techniques telles que la tokenisation des sous-mots (par exemple, le codage par paires d'octets ou BPE, et WordPiece). Ces techniques décomposent les mots inconnus en unités plus petites et connues, que le modèle peut traiter.

Cette approche garantit que même si un mot n'apparaît pas pendant l'entraînement, le modèle peut tout de même comprendre et générer du texte à partir de ses éléments constitutifs, ce qui améliore sa flexibilité et sa robustesse.

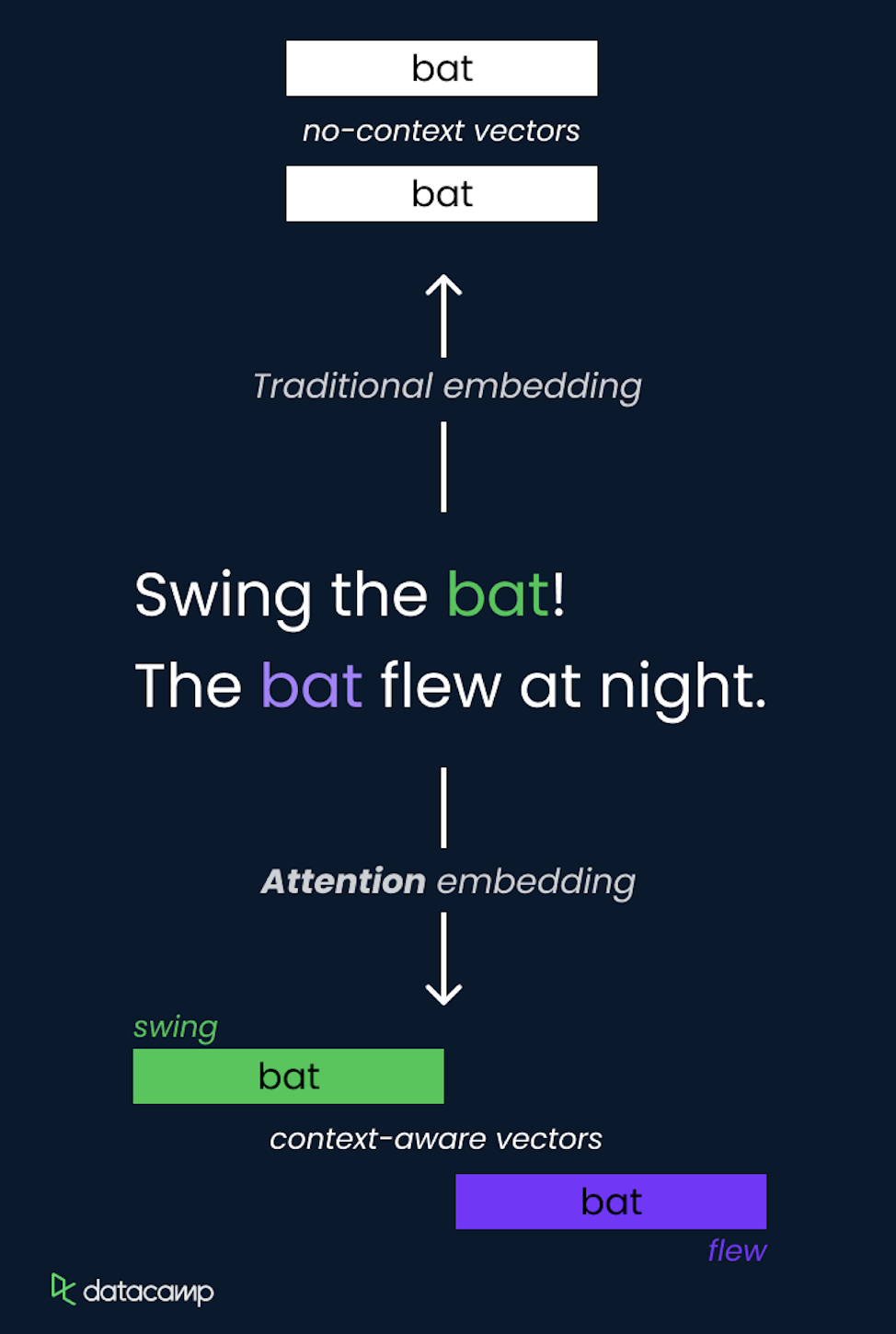

Que sont les couches d'intégration et pourquoi sont-elles importantes dans les modèles d'apprentissage profond (LLM) ?

Les couches d'intégration constituent un élément important des modèles d'apprentissage profond (LLM) utilisés pour convertir des données catégorielles, telles que des mots, en représentations vectorielles denses. Ces intégrations capturent les relations sémantiques entre les mots en les représentant dans un espace vectoriel continu où les mots similaires présentent une plus grande proximité. L'importance de l'intégration des couches dans les LLM comprend :

- Réduction de la dimensionnalité : Ils réduisent la dimensionnalité des données d'entrée, ce qui facilite leur traitement par le modèle.

- Compréhension sémantique : Les intégrations capturent les nuances sémantiques et les relations entre les mots, améliorant ainsi la capacité du modèle à comprendre et à générer des textes semblables à ceux rédigés par des humains.

- Apprentissage par transfert : Les intégrations pré-entraînées peuvent être utilisées dans différents modèles et tâches, fournissant une base solide pour la compréhension du langage qui peut être affinée pour des applications spécifiques.

Comment fonctionnent les encodages positionnels LLM modernes et pourquoi les encodages de position rotatifs (RoPE) sont-ils devenus la norme ?

Les encodages positionnels indiquent aux transformateurs où chaque token se trouve dans la séquence.

Codages de position sinusoïdaux traditionnels (d'après Vaswani et al. 2017) ont utilisé des fonctions mathématiques fixes pour coder les positions de manière statique. Les intégrations de position rotative (RoPE), introduites plus récemment, sont devenues la norme dans les LLM modernes car elles offrent des propriétés fondamentalement supérieures.

RoPE fonctionne en représentant les positions sous forme d'angles de rotation dans un espace vectoriel complexe, en faisant pivoter les intégrations de jetons selon un angle proportionnel à leur position. Cette approche géométrique est plus efficace et prend naturellement en charge l'interpolation vers des séquences plus longues que celles observées pendant l'entraînement, ce qui est une capacité essentielle pour étendre les fenêtres contextuelles. Des modèles tels que GPT-5.2 et Gemini 3 utilisent RoPE comme codage positionnel.

Questions d'entretien pour le LLM intermédiaire

S'appuyant sur des concepts fondamentaux, les questions de niveau intermédiaire explorent les techniques pratiques utilisées pour optimiser les performances des modèles LLM et relever les défis liés à l'efficacité computationnelle et à l'interprétabilité des modèles.

Veuillez expliquer le concept d'attention dans les modèles d'apprentissage profond (LLM) et comment il est mis en œuvre.

Le concept d'attention dans les LLM est une méthode qui permet au modèle de se concentrer sur différentes parties de la séquence d'entrée lorsqu'il effectue des prédictions. Il attribue de manière dynamique des pondérations aux autres tokens de l'entrée, en mettant en évidence ceux qui sont les plus pertinents pour la tâche en cours.

Ceci est réalisé à l'aide de l'auto-attention, où le modèle calcule des scores d'attention pour chaque token par rapport à tous les autres tokens de la séquence, ce qui lui permet de capturer les dépendances indépendamment de leur distance.

Le mécanisme d'auto-attention est un élément central de l'architecture Transformer, lui permettant de traiter efficacement les informations et de saisir les relations à long terme.

Quel est le rôle de la tokenisation dans le traitement LLM ?

La tokenisation convertit le texte brut en unités plus petites appelées jetons, qui peuvent être des mots, des sous-mots ou des caractères.

Le rôle de la tokenisation dans le traitement LLM est essentiel, car elle transforme le texte en un format que le modèle peut comprendre et traiter.

Une tokenisation efficace garantit que le modèle peut traiter une grande diversité d'entrées, y compris des mots rares et différentes langues, en les décomposant en éléments gérables. Cette étape est essentielle pour optimiser l'entraînement et l'inférence, car elle permet de normaliser les données d'entrée et aide le modèle à identifier des modèles significatifs dans les données.

Comment évaluez-vous les performances d'un LLM ?

Les chercheurs et les praticiens ont développé de nombreux indicateurs d'évaluation pour mesurer les performances d'un LLM. Les indicateurs classiques comprennent :

- Perplexité : Mesure la capacité du modèle à prédire un échantillon, couramment utilisée dans les tâches de modélisation linguistique.

- Précision : Utilisé pour des tâches telles que la classification de texte afin de mesurer la proportion de prédictions correctes.

- F1 Score : Moyenne harmonique de la précision et du rappel, utilisée pour des tâches telles que la reconnaissance d'entités nommées.

- Score BLEU (Bilingual Evaluation Understudy) : Évalue la qualité d'un texte généré par ordinateur par rapport à des traductions de référence, couramment utilisé dans le domaine de la traduction automatique.

- ROUGE (Rappel orienté vers l'évaluation sommaire) : Ensemble de mesures qui évaluent le chevauchement entre le texte généré et le texte de référence, souvent utilisé dans les tâches de synthèse. Ils contribuent à quantifier l'efficacité du modèle et à orienter les améliorations futures.

Au-delà des mesures traditionnelles, les praticiens utilisent désormais des benchmarks standardisés à des fins diverses, tels que MMLU (test de connaissances en 57 tâches), MMMU-Pro (raisonnement multimodal) et HumanEval (génération de code). De plus, des classements tels que LMArena évaluent les LLM en fonction des préférences humaines. Pour les systèmes déployés, il est devenu essentiel de mesurer les taux d'hallucination, la latence et l'efficacité des jetons dans le monde réel.

Quelles sont les techniques permettant de contrôler la sortie d'un LLM ?

Plusieurs techniques peuvent être utilisées pour contrôler la sortie d'un LLM, notamment :

- Température : Le réglage de ce paramètre pendant l'échantillonnage permet de contrôler le caractère aléatoire de la sortie. Des températures plus basses produisent des résultats plus déterministes, tandis que des valeurs plus élevées donnent des résultats plus variés.

- Échantillonnage Top-K : Limite l'échantillon aux K tokens les plus probables, réduisant ainsi le risque de générer un texte moins pertinent ou incohérent.

- Échantillonnage Top-P (noyau) : Sélectionne les jetons du plus petit ensemble dont la probabilité cumulative dépasse un seuil P, en équilibrant diversité et cohérence.

- Ingénierie rapide: Élaborer des consignes spécifiques pour orienter le modèle vers la génération des résultats souhaités en fournissant un contexte ou des exemples.

- Jetons de contrôle : Utilisation de jetons spéciaux pour indiquer au modèle de générer du texte dans un style, un format ou un type de contenu spécifique.

Quelles sont les approches permettant de réduire le coût informatique des modèles linguistiques à grande échelle (LLM) ?

Afin de réduire le coût de calcul des LLM, nous pouvons utiliser :

- Élagage du modèle : Supprimer les poids ou les neurones moins importants du modèle afin de réduire sa taille et ses besoins en calcul.

- Quantification : La conversion des poids du modèle d'une précision supérieure (par exemple, virgule flottante 32 bits) à une précision inférieure (par exemple, entier 8 bits) réduit l'utilisation de la mémoire et accélère l'inférence.

- Distillation: Former un modèle plus petit (élève) à imiter le comportement d'un modèle plus grand et pré-formé (enseignant) afin d'obtenir des performances similaires avec moins de ressources.

- Attention limitée : L'utilisation de techniques telles que les transformateurs clairsemés pour limiter le mécanisme d'attention à un sous-ensemble de jetons réduit la charge de calcul.

- Architectures efficaces : Développer et utiliser des architectures de modèles efficaces spécialement conçues pour minimiser les exigences informatiques tout en maintenant les performances, telles que Reformer ou Longformer.

Quelle est l'importance de l'interprétabilité des modèles dans les LLM, et comment peut-on y parvenir ?

L'interprétabilité des modèles est essentielle pour comprendre comment un LLM prend ses décisions, ce qui est important pour instaurer la confiance, garantir la responsabilité et identifier et atténuer les biais. L'interprétabilité peut être obtenue par différentes approches, telles que :

- Veuillez noter la visualisation suivante : Analyse des pondérations d'attention afin de déterminer les parties de l'entrée sur lesquelles le modèle se concentre.

- Cartes de saillance : Mise en évidence des caractéristiques d'entrée qui ont la plus grande influence sur la sortie du modèle.

- Méthodes indépendantes du modèle : Utilisation de techniques telles que LIME (Local Interpretable Model-agnostic Explanations) pour expliquer les prédictions individuelles.

- Propagation de la pertinence par couches : Décomposition des prédictions du modèle en contributions de chaque couche ou neurone.

Comment les modèles linguistiques à grande échelle (LLM) gèrent-ils les dépendances à long terme dans le texte ?

Les LLM gèrent les dépendances à long terme dans le texte grâce à leur architecture, en particulier le mécanisme d'auto-attention, qui leur permet de prendre en compte simultanément tous les tokens de la séquence d'entrée. Cette capacité à prendre en compte des éléments distants aide les LLM à saisir les relations et les dépendances dans des contextes étendus.

De plus, des modèles avancés tels que Transformer-XL et Longformer sont spécialement conçus pour élargir la fenêtre contextuelle et gérer plus efficacement les séquences plus longues, garantissant ainsi une meilleure prise en charge des dépendances à long terme.

Les modèles de production modernes utilisent des stratégies plus avancées pour gérer les dépendances à long terme et contrer la dégradation des performances avec des fenêtres contextuelles en expansion, telles que :

- Intégrations de position rotative (RoPE) pour une extrapolation de longueur améliorée et un codage de position supérieur.

- Modèles d'attention optimisés pour les séquences longues, y compris les variantes d'attention groupée et multi-têtes.

- Intégration minutieuse des connaissances via RAG plutôt que de se fier uniquement à la capacité de la fenêtre contextuelle.

Qu'est-ce que la génération augmentée par la récupération (RAG) et comment a-t-elle évolué ?

RAG combine des mécanismes de récupération avec des modèles génératifs afin d'extraire des informations pertinentes à partir de sources externes pendant la génération de texte. Cette approche répond directement à deux limitations critiques des LLM : l'hallucination et l'actualité des connaissances. Le RAG traditionnel utilise des pipelines de récupération et de génération relativement simples, mais dans son évolution vers le « RAG 2.0 », il est devenu nettement plus sophistiqué.

Les principales fonctionnalités de RAG 2.0 comprennent :

- Récupération récursive : Les modèles analysent les lacunes dans les informations récupérées et effectuent de manière proactive des recherches secondaires ou tertiaires afin de combler les lacunes en matière de connaissances, plutôt que de se fier à une seule recherche.

- Récupération multimodale: Intégration de divers formats (texte, images, PDF, vidéos et même appels API) permettant une collecte de contexte plus riche.

- Indexation hybride : Recherche combinée BM25 (basée sur des mots-clés) et vectorielle (sémantique) pour capturer à la fois la pertinence lexicale et sémantique.

- Réorganisation des couches : Filtrage intelligent des résultats de recherche initiaux afin de réduire le bruit et les informations non pertinentes

- Adaptation agentique : Sélection dynamique de stratégie où le système choisit des approches de recherche en fonction de la complexité de la requête et du domaine.

RAG 2.0, associé aux LLM, réduit efficacement les taux d'hallucination de 40 à 60 % dans les systèmes de production par rapport aux modèles de base.

Questions d'entretien avancées pour le LLM

La compréhension des concepts avancés des LLM est utile pour les professionnels qui souhaitent repousser les limites de ce que ces modèles peuvent accomplir. Cette section explore des sujets complexes et les défis courants rencontrés dans ce domaine.

Veuillez expliquer le concept d'« apprentissage en quelques essais » dans les modèles linguistiques à grande échelle (LLM) et ses avantages.

L'apprentissage en quelques essais dans les LLM fait référence à la capacité du modèle à apprendre et à effectuer de nouvelles tâches en utilisant seulement quelques exemples. Cette fonctionnalité exploite les connaissances approfondies pré-entraînées du LLM, lui permettant de généraliser à partir d'un petit nombre d'exemples.

Les principaux avantages de l'apprentissage en quelques essais comprennent une réduction des besoins en données, car le besoin de grands ensembles de données spécifiques à une tâche est minimisé, une flexibilité accrue, permettant au modèle de s'adapter à diverses tâches avec un réglage minimal, et une rentabilité, car la réduction des besoins en données et des temps de formation se traduit par des économies significatives en matière de collecte de données et de ressources informatiques.

Quelles sont les différences entre les modèles autorégressifs et les modèles linguistiques masqués ?

Les modèles autorégressifs et les modèles linguistiques masqués se distinguent principalement par leur approche de prédiction et leur adéquation à la tâche. Les modèles autorégressifs, tels que GPT-5.2, Claude 4.5 Opus et Gemini 3, prédisent le mot suivant dans une séquence en se basant sur les mots précédents, générant ainsi du texte un token à la fois. prédisent le mot suivant dans une séquence en se basant sur les mots précédents, générant ainsi le texte un token à la fois.

Ces modèles sont particulièrement adaptés aux tâches de génération de texte. En revanche, les modèles linguistiques masqués, tels que BERT, masquent de manière aléatoire des mots dans une phrase et entraînent le modèle à prédire ces mots masqués en fonction du contexte environnant. Cette approche bidirectionnelle permet au modèle de comprendre le contexte dans les deux sens, ce qui le rend idéal pour les tâches de classification de texte et de réponse à des questions.

Comment intégrer des connaissances externes dans un LLM ?

L'intégration de connaissances externes dans un LLM peut être réalisée de plusieurs manières :

- Intégration du graphe de connaissances: Enrichir les données d'entrée du modèle avec des informations provenant de graphes de connaissances structurés afin de fournir des informations contextuelles.

- Génération augmentée par la récupération (RAG): Combine des méthodes de recherche avec des modèles génératifs pour extraire des informations pertinentes à partir de sources externes lors de la génération de texte. Les systèmes RAG 2.0 modernes utilisent la recherche récursive, l'indexation hybride et le reclassement pour une intégration des connaissances supérieure à celle des approches de recherche simples.

- Ajustement avec des données spécifiques au domaine : Former le modèle à l'aide de jeux de données supplémentaires contenant les connaissances nécessaires pour le spécialiser dans des tâches ou des domaines spécifiques.

- Ingénierie rapide : Concevoir des invites qui guident le modèle afin qu'il utilise efficacement les connaissances externes lors de l'inférence.

Quels sont les défis associés au déploiement des LLM en production ?

Le déploiement des LLM en production implique divers défis :

- Évolutivité : Pour garantir que le modèle puisse traiter efficacement de grands volumes de requêtes, il est souvent nécessaire de disposer de ressources informatiques importantes et d'une infrastructure optimisée.

- Latence : Il est essentiel de réduire au minimum le temps de réponse afin de fournir des résultats en temps réel ou quasi réel pour des applications telles que les chatbots et les assistants virtuels.

- Surveillance et entretien : La surveillance continue des performances du modèle et sa mise à jour pour traiter les données et les tâches en constante évolution nécessitent des systèmes de surveillance robustes et des mises à jour régulières.

- Considérations éthiques et juridiques : Il est essentiel de traiter les questions liées aux préjugés, à la confidentialité et au respect des réglementations afin d'éviter les écueils éthiques et les répercussions juridiques.

- Gestion des ressources : La gestion des ressources informatiques importantes nécessaires à l'inférence garantit la rentabilité et implique l'optimisation des configurations matérielles et logicielles.

Comment gérez-vous la dégradation des modèles au fil du temps dans les LLM déployés ?

La dégradation du modèle se produit lorsque les performances d'un LLM diminuent au fil du temps en raison de changements dans la distribution des données sous-jacentes. La gestion de la dégradation du modèle implique un réentraînement régulier avec des données mises à jour afin de maintenir les performances. Une surveillance continue est nécessaire pour suivre les performances du modèle et détecter les signes de dégradation.

Les techniques d'apprentissage incrémental permettent au modèle d'apprendre à partir de nouvelles données sans oublier les informations apprises précédemment. De plus, les tests A/B permettent de comparer les performances du modèle actuel avec celles des nouvelles versions et contribuent à identifier les améliorations potentielles avant le déploiement complet.

Quelles sont les techniques permettant de garantir une utilisation éthique des LLM ?

Afin de garantir une utilisation éthique des modèles d'apprentissage automatique (LLM), il est essentiel de mettre en place des mesures de utilisation éthique des LLM, plusieurs techniques peuvent être mises en œuvre :

- Atténuation des biais : Mettre en œuvre des stratégies visant à identifier et à réduire les biais dans les données d'entraînement et les résultats des modèles, par exemple en utilisant des ensembles de données équilibrés et des outils de détection des biais.

- Transparence et explicabilité : Développer des modèles qui fournissent des résultats interprétables et explicables afin de favoriser la confiance et la responsabilité, notamment en utilisant la visualisation de l'attention et les cartes de saillance.

- Consentement de l'utilisateur et confidentialité : Garantir que les données utilisées pour la formation et l'inférence sont conformes aux réglementations en matière de confidentialité et obtenir le consentement des utilisateurs lorsque cela est nécessaire.

- Audits d'équité : Effectuer régulièrement des audits afin d'évaluer l'équité et les implications éthiques du comportement du modèle.

- Déploiement responsable: Définition de lignes directrices et de politiques pour une déploiement responsable de l'IA, y compris la gestion des contenus préjudiciables ou inappropriés générés par le modèle.

Comment garantir la sécurité des données utilisées avec les LLM ?

La sécurisation des données utilisées avec les LLM nécessite la mise en œuvre de diverses mesures. Il s'agit notamment d'utiliser des techniques de chiffrement pour les données au repos et en transit afin de les protéger contre tout accès non autorisé. Des contrôles d'accès rigoureux sont nécessaires pour garantir que seul le personnel autorisé puisse accéder aux données sensibles.

Il est également essentiel d'anonymiser les données afin de supprimer les informations personnelles identifiables (PII) avant de les utiliser à des fins de formation ou d'inférence. De plus, il est essentiel de respecter les réglementations en matière de protection des données, telles que le RGPD ou le CCPA, afin d'éviter tout problème juridique.

Ces mesures contribuent à protéger l'intégrité, la confidentialité et la disponibilité des données. Cette protection est essentielle pour maintenir la confiance des utilisateurs et respecter les normes réglementaires.

Comment l'apprentissage par renforcement à partir du retour d'information humain (RLHF) améliore-t-il la qualité et la sécurité des résultats des LLM, et comment se compare-t-il aux nouvelles méthodes d'alignement telles que le DPO et le RLAIF ?

L'apprentissage par rétroaction (, RLHF) est une technique qui consiste à former un modèle LLM afin d'aligner ses résultats sur les préférences humaines en intégrant les commentaires d'évaluateurs humains. Ce processus itératif aide le modèle à apprendre à générer des réponses qui sont non seulement précises, mais également sûres, impartiales et utiles.

Cependant, le RLHF présente des défis. L'un des défis réside dans le risque de partialité des commentaires humains, car différents évaluateurs peuvent avoir des préférences et des interprétations variées.

Un autre défi réside dans l'évolutivité du processus de rétroaction, car la collecte et l'intégration d'un grand nombre de commentaires humains peuvent s'avérer longues et coûteuses. De plus, il peut être difficile de s'assurer que le modèle de récompense utilisé dans le RLHF reflète fidèlement les comportements et les valeurs souhaités. L'étape d'optimisation PPO (Proximal Policy Optimization) ajoute de la complexité et peut entraîner une certaine instabilité pendant l'entraînement.

Des alternatives modernes ont vu le jour pour pallier bon nombre des limites du RLHF :

- DPO (optimisation directe des préférences) : Élimine complètement le modèle de récompense distinct, en utilisant des signaux de récompense implicites dérivés directement des paires de préférences. Cette approche est plus simple, plus stable et plus efficace sur le plan informatique que la RLHF basée sur le PPO. Le DPO est désormais largement adopté par les principaux laboratoires d'IA comme alternative ou complément au RLHF traditionnel.

- GRPO (optimisation de la politique de récompense basée sur le gradient): Une variante qui combine les avantages de la simplicité du DPO avec certains aspects de l'apprentissage de type PPO, offrant ainsi un compromis intermédiaire.

- RLAIF (apprentissage par renforcement à partir du retour d'information de l'IA): Remplace les évaluateurs humains par des commentaires générés par l'intelligence artificielle (tels que les notes attribuées par des modèles plus performants ou des évaluateurs spécialisés). Cette approche réduit considérablement les défis et les coûts liés à l'évolutivité, car générer des commentaires à partir de l'IA est moins coûteux et plus rapide que de recueillir des commentaires humains.

La plupart des modèles de production utilisent le DPO, le RLAIF ou des combinaisons hybrides plutôt que le RLHF basé uniquement sur le PPO.

Veuillez comparer les modèles d'espace d'état (tels que Mamba) avec les Transformers. Quels sont les compromis et dans quelles circonstances les utiliseriez-vous ?

Les hallucinations basées sur les connaissances surviennent lorsque le modèle ne dispose pas des faits corrects (ou dispose de faits obsolètes), et invente donc des informations qui semblent plausibles. Les corrections impliquent généralement :

- Ancrage du modèle avec récupération (RAG)

- Ajouter des sources vérifiées

- Ajustement spécifique au domaine

Les hallucinations logiques surviennent lorsque le modèle dispose d'informations pertinentes, mais raisonne de manière incorrecte ou produit des incohérences. Les solutions courantes sont les suivantes :

- Invitation structurée

- Étapes de vérification/auto-vérification (souvent via des workflows agentiels)

- Évaluation ciblée

Quelle est la différence entre les hallucinations basées sur les connaissances et celles basées sur la logique dans les modèles linguistiques à grande échelle (LLM), et comment traitez-vous chacune d'entre elles ?

Alors que les Transformers dominent actuellement le domaine des LLM, les modèles d'espace d'état (SSM) tels que Mamba se sont imposés comme un paradigme architectural compétitif, avec des propriétés de calcul et de performance fondamentalement différentes. Il est de plus en plus important pour les professionnels modernes du droit de comprendre ces deux aspects.

Transformateurs :

- Points forts : Excellente pour la recherche d'informations, les tâches de copier-coller et l'apprentissage contextuel. Architecture éprouvée à grande échelle avec des outils et une infrastructure complets. Performances empiriques solides en matière de génération de code et de benchmarks diversifiés.

- Points faibles : La complexité de l'attention O(N²) entraîne des besoins quadratiques en mémoire et en calcul. Cela se traduit par une baisse des performances sur les séquences très longues (>100 000 tokens) et une latence élevée pour les applications à contexte long.

- Cas d'utilisation et recommandations : La plupart des LLM de production actuels (GPT, Claude, Gemini, Llama). Recommandé pour les applications actuelles dans le monde réel et dans un avenir proche.

Modèles d'espace d'état (Mamba, Mamba-2) :

- Points forts : Complexité O(N) avec mise à l'échelle linéaire de la mémoire. Inference 5 à 10 fois plus rapide sur les séquences longues (> 50 000 tokens). Amélioration des fondements théoriques du traitement du signal. Comportement de mise à l'échelle plus prévisible.

- Points faibles : Nécessite 10 fois plus de données d'entraînement que les Transformers pour atteindre des performances comparables. Moins performant pour les tâches de recherche et de copie d'informations. Écosystème moins mature avec moins d'outils, de bibliothèques et de modèles entraînés.

- Cas d'utilisation et recommandations : Apparaissant pour des applications spécialisées : traitement de documents longs, systèmes en temps réel avec contraintes de latence, applications de streaming et domaines potentiellement spécialisés où la mise à l'échelle O(N) est essentielle.

Des recherches récentes démontrent que les transformateurs et les SSM sont complémentaires plutôt que directement concurrents, avec des cas d'utilisation et des contraintes différents favorisant des architectures différentes. Les transformateurs restent le choix le plus pratique pour les LLM à usage général et devraient continuer à dominer le marché pour le moment. Un avenir hybride est probable, avec des modèles spécialisés pour différentes exigences en matière de calcul et de tâches.

Questions d'entretien LLM pour les ingénieurs Prompt

L'ingénierie des invites est un aspect important de l'utilisation des LLM. Il s'agit de créer des invites précises et efficaces afin de générer les réponses souhaitées du modèle. Cette section examine les questions clés auxquelles les ingénieurs peuvent être confrontés.

Qu'est-ce que l'ingénierie rapide et pourquoi est-elle essentielle pour travailler avec les LLM ?

L'ingénierie des invites consiste à concevoir et à perfectionner des invites afin de guider les modèles d'apprentissage automatique (LLM) dans la génération de résultats précis et pertinents. Il est essentiel de travailler avec des LLM, car la qualité de l'invite a un impact direct sur les performances du modèle.

Des invites efficaces peuvent améliorer la capacité du modèle à comprendre la tâche, générer des réponses précises et pertinentes, et réduire le risque d'erreurs.

L'ingénierie des invites est essentielle pour maximiser l'utilité des LLM dans diverses applications, de la génération de texte aux tâches complexes de résolution de problèmes.

Pourriez-vous fournir des exemples de différentes techniques d'invite (zero-shot, few-shot, chain-of-thought) et expliquer quand les utiliser ?

- Invitation sans apprentissage préalable: Fournit au modèle une description de la tâche sans aucun exemple. Généralement utilisé lorsqu'il n'y a pas d'exemples disponibles ou lorsque nous souhaitons évaluer la compréhension générale et la flexibilité du modèle.

- Invitation en quelques étapes: Fournit quelques exemples accompagnés d'une description de la tâche afin de guider le modèle. Ceci est utile lorsque le modèle a besoin de contexte ou d'exemples pour mieux appréhender la tâche.

- Chaîne de pensée incitative: Décompose une tâche complexe en étapes plus petites et séquentielles que le modèle peut suivre. Cela peut être avantageux pour les tâches qui nécessitent un raisonnement logique et la résolution de problèmes en plusieurs étapes.

- Invitation à agir : La structure incite les modèles à agir en tant qu'agents autonomes qui appellent des outils/API, collectent des informations et raisonnent en plusieurs étapes. Les consignes comprennent les définitions de l'espace d'action, les descriptions des outils et les exigences explicites en matière de raisonnement.

Comment évaluez-vous l'efficacité d'une invite ?

L'évaluation de l'efficacité d'une invite implique :

- Qualité de sortie : Évaluer la pertinence, la cohérence et l'exactitude des réponses du modèle.

- Cohérence : Vérifier si le modèle produit systématiquement des résultats de haute qualité pour différentes entrées.

- Indicateurs spécifiques à la tâche : Utilisation de mesures d'évaluation spécifiques à chaque tâche, telles que BLEU pour la traduction ou ROUGE pour la synthèse, afin d'évaluer les performances.

- Évaluation humaine : Faire appel à des évaluateurs humains pour fournir des commentaires qualitatifs sur les résultats du modèle.

- Test A/B : Comparer différentes invites afin de déterminer laquelle offre les meilleures performances.

Quelles sont les stratégies permettant d'éviter les pièges courants dans la conception des questions (par exemple, les questions suggestives, les instructions ambiguës) ?

- Évitez les questions suggestives : Veuillez vous assurer que les invites ne suggèrent pas une réponse spécifique, ce qui pourrait influencer la réponse du modèle.

- Instructions claires et concises : Veuillez fournir des instructions claires et précises afin de réduire toute confusion.

- Fourniture du contexte : Veuillez inclure le contexte pertinent afin d'aider le modèle à comprendre la tâche sans le surcharger d'informations inutiles.

- Tests itératifs : Tester et affiner en permanence les invites en fonction des résultats et des performances du modèle.

Comment abordez-vous le raffinement itératif des invites afin d'améliorer les performances des modèles d'apprentissage automatique à grande échelle (LLM) ?

Le raffinement itératif des invites implique :

- Conception initiale : Commencez par une invite de base en fonction des exigences de la tâche.

- Essais et évaluation : Évaluer les performances de l'invite à l'aide de divers indicateurs et recueillir des commentaires.

- Analyse : Veuillez identifier les points faibles ou les aspects à améliorer dans la consigne.

- Raffinement : Veuillez apporter les modifications nécessaires à l'invite afin de résoudre les problèmes identifiés.

- Veuillez répéter : Veuillez répéter le processus de test et d'amélioration jusqu'à ce que les performances souhaitées soient atteintes.

Quels outils ou cadres utilisez-vous pour optimiser le processus d'ingénierie des invites ?

Plusieurs outils et cadres peuvent rationaliser le processus d'ingénierie rapide :

- Plateformes spécifiques au LLM : LangChain et LlamaIndex pour le chaînage rapide et la création de systèmes agentifs ; Vercel AI SDK pour le prototypage et le déploiement rapides.

- Test et optimisation rapides : PromptFoo (tests automatisés de prompts dans différents scénarios), DSPy (optimisation programmatique des prompts), Haystack (construction de pipelines RAG).

- Environnements de développement interactifs (IDE) : Jupyter Notebook pour l'expérimentation, VS Code avec extensions LLM (GitHub Copilot, Cursor), Streamlit pour la création de prototypes d'interface utilisateur interactifs.

- API et SDK : API OpenAI, SDK Anthropic, Together AI et LM Studio pour le déploiement de modèles locaux.

- Contrôle de version et collaboration : Gestion des versions des invites basée sur Git, Weights & Biases pour le suivi et la comparaison des expériences, HuggingFace Hub pour le partage de modèles et d'invites.

- Cadres d'action : AutoGPT, API OpenAI Assistants, LangGraph pour la création de workflows complexes à plusieurs étapes.

- Évaluation et suivi : Ragas (indicateurs d'évaluation RAG), LangSmith (suivi, débogage et surveillance de la production), Braintrust (observabilité LLM de bout en bout).

Comment gérez-vous les défis tels que les hallucinations ou les biais dans les résultats des modèles LLM grâce à l'ingénierie des invites ?

Cette question aborde les aspects éthiques et pratiques du contenu généré par les LLM. Une réponse convaincante démontrerait une prise de conscience de ces problèmes et aborderait des techniques telles que celles décrites ci-dessous.

Techniques d'atténuation des hallucinations :

- Messages de vérification des faits : Intégrez des invites qui encouragent le modèle à vérifier ses informations à l'aide de sources fiables et à citer explicitement ses sources.

- Intégration de la récupération : Utilisez les systèmes RAG ou RAG 2.0 pour ancrer les réponses dans des documents réels, réduisant ainsi les faits inventés en exigeant que le modèle fasse référence aux informations récupérées.

- Boucles de vérification agentique : La structure invite le modèle à effectuer une vérification en plusieurs étapes, au cours de laquelle il vérifie son propre travail avant de répondre, créant ainsi des agents d'auto-vérification.

- Messages basés sur des contraintes : Définissez le format de sortie et les contraintes logiques qui mettent en évidence les incohérences ou les affirmations non fondées.

Techniques d'atténuation des biais :

- Suggestions pour une perspective diversifiée : Veuillez guider le modèle afin qu'il prenne en considération plusieurs points de vue et perspectives des parties prenantes avant de conclure.

- Messages de détection de biais : Veuillez demander au modèle d'identifier les biais potentiels dans son propre raisonnement et ses résultats.

- Messages contrefactuels : Demandez des scénarios ou des perspectives alternatifs afin de remettre en question les hypothèses initiales et de tester la solidité du raisonnement.

- Clarté des instructions : Veuillez indiquer explicitement que les réponses doivent être équilibrées, reconnaître les limites et éviter tout langage discriminatoire.

Pourriez-vous expliquer le rôle des modèles de prompt et comment ils sont utilisés dans l'ingénierie des prompts ?

Les modèles d'invites fournissent un format structuré pour les invites, comprenant souvent des espaces réservés pour des informations ou des instructions spécifiques. Ils peuvent être réutilisés dans différentes tâches et différents scénarios, améliorant ainsi la cohérence et l'efficacité de la conception des invites.

Une réponse appropriée expliquerait comment les modèles de prompts peuvent être utilisés pour intégrer les meilleures pratiques, incorporer des connaissances spécifiques à un domaine et rationaliser le processus de génération de prompts efficaces pour diverses applications.

En quoi le choix d'un tokeniseur influe-t-il sur l'ingénierie des invites et les performances du modèle ?

Le tokeniseur joue un rôle crucial dans la manière dont le LLM interprète et traite la commande d'entrée. Les différents tokeniseurs ont des tailles de vocabulaire variables et traitent différemment les mots hors vocabulaire (OOV). Un tokeniseur de sous-mots tel que le Byte Pair Encoding (BPE) peut traiter les mots OOV en les divisant en unités de sous-mots plus petites, tandis qu'un tokeniseur basé sur les mots peut les traiter comme des tokens inconnus.

Le choix du tokeniseur peut influencer les performances du modèle de plusieurs manières. Par exemple, un tokeniseur de sous-mots peut être plus efficace pour saisir le sens de termes rares ou techniques, tandis qu'un tokeniseur basé sur les mots peut être plus simple et plus rapide pour les tâches linguistiques générales.

Dans l'ingénierie des invites, le choix du tokeniseur peut influencer la manière dont vous structurez vos invites. Par exemple, si vous utilisez un tokeniseur de sous-mots, il pourrait être nécessaire de prêter davantage attention à la manière dont les mots sont divisés en sous-mots afin de garantir que le modèle capture le sens souhaité.

Qu'est-ce que l'incitation agentique et en quoi diffère-t-elle de l'ingénierie traditionnelle des incitations ?

L'incitation agentique est une approche de conception d'incitation dans laquelle le modèle est programmé pour agir comme un « agent » capable de planifier, d'agir (par exemple, appeler des outils/API ou récupérer des documents), d'observer les résultats et d'itérer jusqu'à ce qu'il atteigne un objectif.

Contrairement à l'ingénierie traditionnelle des invites, qui vise principalement à obtenir la meilleure réponse possible en une seule fois grâce à des instructions claires, des exemples et des contraintes de formatage, les invites agencées mettent l'accent sur une boucle de contrôle en plusieurs étapes (planifier → agir → observer → affiner).

Il est particulièrement utile pour les tâches dont l'exactitude dépend de l'interaction avec des systèmes externes (bases de données, recherche, exécution de code) ou de la vérification des résultats intermédiaires plutôt que de se fier uniquement aux connaissances internes du modèle.

Les bonnes invites agentiques définissent généralement l'objectif, les outils/actions disponibles, la manière de décider quelle action entreprendre et quand s'arrêter. Il est également courant d'ajouter des étapes de vérification explicites (par exemple, « vérifier les sources récupérées » ou « recalculer avant la réponse finale ») afin de réduire les erreurs et d'améliorer la fiabilité.

Obtenez une certification de haut niveau en matière d'IA

Conclusion

Ce guide fournit une série de questions d'entretien pour vous aider à préparer vos discussions sur les LLM, allant des principes de base aux stratégies avancées.

Que vous vous prépariez à un entretien ou que vous cherchiez à approfondir vos connaissances, ces informations vous fourniront les connaissances nécessaires pour vous orienter et exceller dans le domaine de l'intelligence artificielle.

Si vous souhaitez vous informer sur les dernières avancées en matière d'IA et de LLM, je vous recommande les sujets suivants :

Récemment diplômé d'une maîtrise en sciences, spécialisé dans l'intelligence artificielle