Programa

Modelos de linguagem grandes (LLMs) têm se tornado cada vez mais importantes na inteligência artificial, com aplicações em vários setores.

Com a crescente demanda por profissionais com experiência em LLM, este artigo traz um conjunto completo de perguntas e respostas para entrevistas, cobrindo conceitos básicos, técnicas avançadas e aplicações práticas.

Se você está se preparando para uma entrevista de emprego ou simplesmente quer expandir seus conhecimentos, este artigo vai ser útil.

Perguntas básicas para entrevistas de mestrado em Direito

Pra entender os LLMs, é importante começar com os conceitos básicos. Essas questões básicas cobrem aspectos essenciais, como arquitetura, mecanismos principais e desafios típicos, oferecendo uma base sólida para aprender tópicos mais avançados.

O que é a arquitetura Transformer e como ela é usada em LLMs?

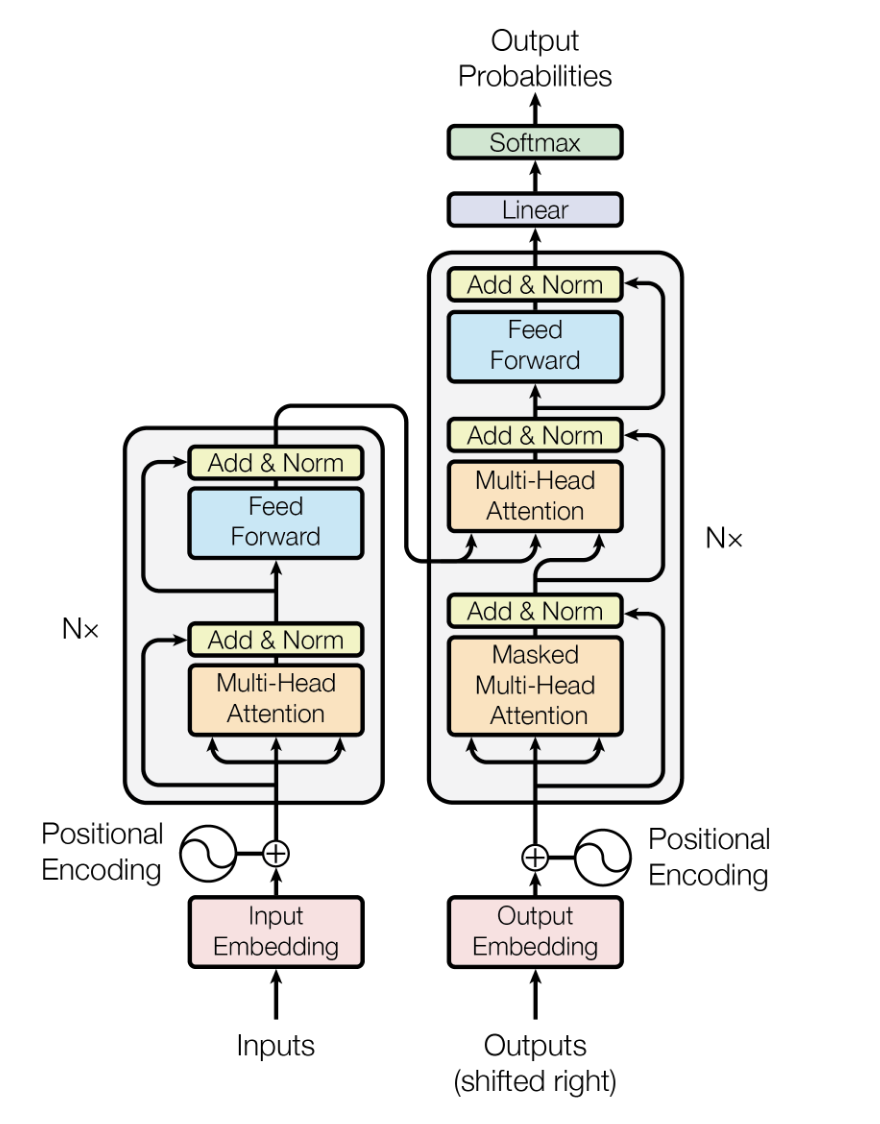

A arquitetura Transformer é um modelo de aprendizado profundo apresentado por Vaswani et alem 2017, feito pra lidar com dados sequenciais com mais eficiência e desempenho do que os modelos anteriores, como redes neurais recorrentes (RNNs) e memórias de curto prazo longas (LSTMs).

Depende de mecanismos de autoatenção para processar dados de entrada em paralelo, tornando-o altamente escalável e capaz de capturar dependências de longo alcance.

Nos LLMs, a arquitetura Transformer é tipo a espinha dorsal, permitindo que os modelos processem grandes quantidades de dados de texto de forma eficiente e gerem resultados de texto contextualmente relevantes e coerentes.

A arquitetura do modelo Transformer. Fonte

Explique o conceito de “janela de contexto” em LLMs e sua importância.

A janela de contexto nos LLMs é o trecho de texto (em termos de tokens ou palavras) que o modelo pode considerar de uma vez só ao gerar ou entender a linguagem. A importância da janela de contexto está no impacto que ela tem na capacidade do modelo de gerar respostas lógicas e relevantes.

Geralmente, uma janela de contexto maior permite que o modelo considere mais contexto, levando a uma melhor compreensão e geração de texto, especialmente em conversas complexas ou longas. Mas isso também aumenta os requisitos computacionais, o que faz com que seja preciso encontrar um equilíbrio entre desempenho e eficiência.

Além disso, pesquisas recentes mostram que os modelos de most apresentam desempenho ruim bem antes dos limites anunciados. Os modelos podem apresentar um fenômeno de “perda no meio”, em que as informações no centro do contexto são ignoradas ou deixadas de lado. Então,contexto relevante e selecionado em janelas menores costuma ter um desempenho melhor do que preencher janelas maiores com ruído.

Quais são alguns objetivos comuns de pré-treinamento para LLMs e como eles funcionam?

Os objetivos comuns de pré-treinamento para LLMs incluem modelagem de linguagem mascarada (MLM) e modelagem de linguagem autorregressiva. No MLM, palavras aleatórias em uma frase são mascaradas, e o modelo é treinado para prever as palavras mascaradas com base no contexto ao redor. Isso ajuda o modelo a entender o contexto bidirecional.

A modelagem autorregressiva de linguagem envolve prever a próxima palavra em uma sequência e treinar o modelo para gerar texto um token de cada vez. Os dois objetivos permitem que o modelo aprenda padrões linguísticos e semânticos a partir de grandes corpora, dando uma base sólida para ajustar tarefas específicas.

Você quer começar a usar a IA generativa?

Saiba como trabalhar com LLMs em Python diretamente em seu navegador

O que é o ajuste fino no contexto dos LLMs e por que é importante?

O ajuste fino no contexto dos LLMs envolve pegar um modelo pré-treinado e treiná-lo ainda mais em um conjunto de dados menor e específico para a tarefa. Esse processo ajuda o modelo a adaptar sua compreensão geral da linguagem às nuances da aplicação específica, melhorando assim o desempenho.

Essa é uma técnica importante porque aproveita o amplo conhecimento linguístico adquirido durante o pré-treinamento, ao mesmo tempo em que modifica o modelo para ter um bom desempenho em aplicações específicas, como análise de sentimentos, resumo de textos ou perguntas e respostas.

Quais são alguns dos desafios comuns associados ao uso de LLMs?

Usar LLMs traz vários desafios, incluindo:

- Recursos computacionais: Os LLMs precisam de bastante poder computacional e memória, o que faz com que o treinamento e a implantação exijam muitos recursos.

- Preconceito e justiça: Os LLMs podem, sem querer, aprender e espalhar preconceitos que estão nos dados de treinamento, levando a resultados injustos ou tendenciosos.

- Interpretabilidade: Entender e explicar as decisões tomadas pelos LLMs pode ser complicado por causa da natureza complexa e meio obscura deles.

- Privacidade dos dados: Usar grandes conjuntos de dados para treinamento pode levantar preocupações sobre privacidade e segurança dos dados.

- Custo: O desenvolvimento, o treinamento e a implantação de LLMs podem ser caros, o que limita o acesso a eles por organizações menores.

Como os LLMs lidam com palavras ou tokens fora do vocabulário (OOV)?

Os LLMs lidam com palavras ou tokens fora do vocabulário (OOV) usando técnicas como tokenização de subpalavras (por exemplo, Byte Pair Encoding ou BPE e WordPiece). Essas técnicas dividem palavras desconhecidas em unidades menores e conhecidas, que o modelo consegue processar.

Essa abordagem garante que, mesmo que uma palavra não seja vista durante o treinamento, o modelo ainda consiga entender e gerar texto com base em suas partes constituintes, melhorando a flexibilidade e a robustez.

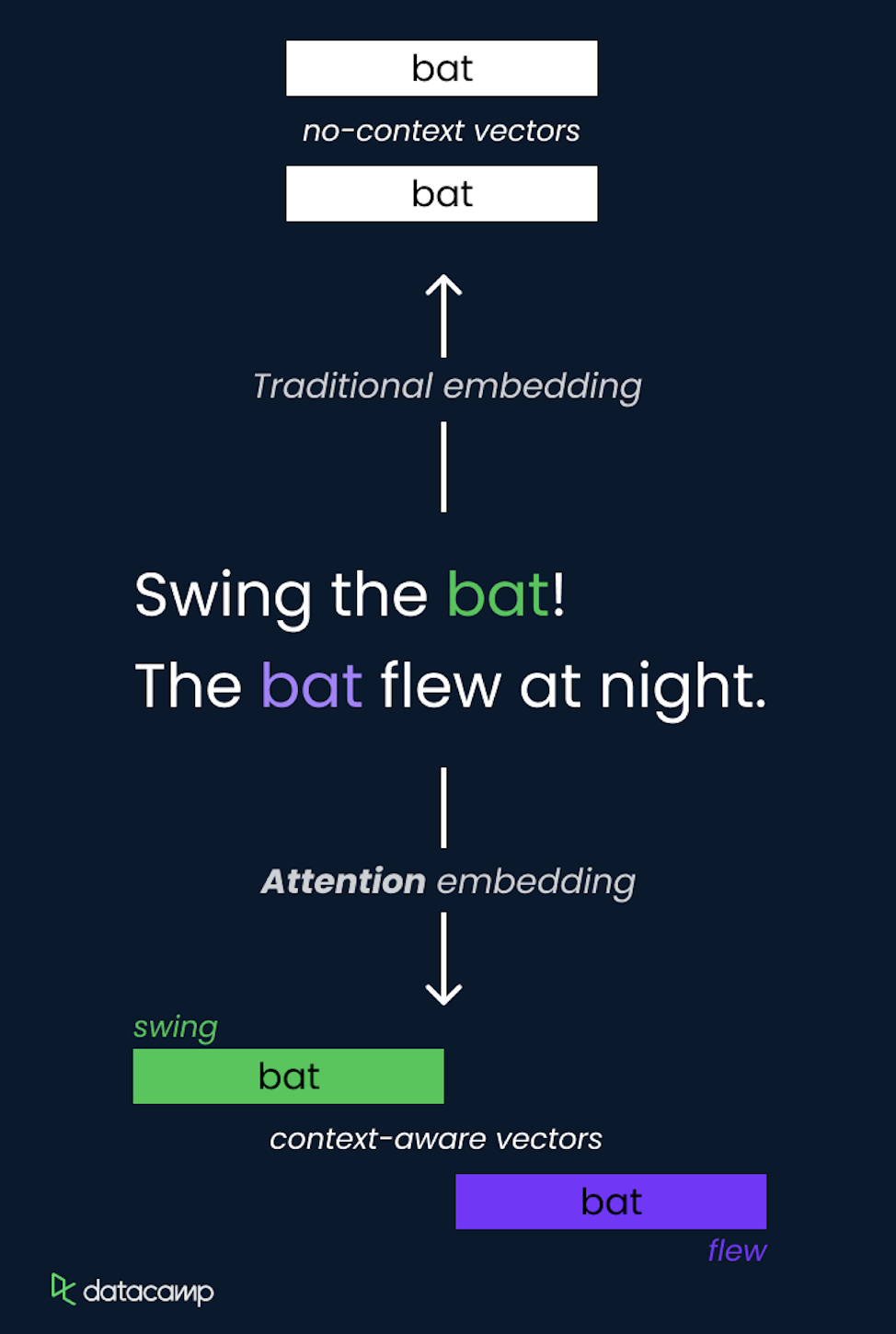

O que são camadas de incorporação e por que são importantes nos LLMs?

As camadas de incorporação são um componente importante nos LLMs, que são usados para transformar dados categóricos, como palavras, em representações vetoriais densas. Essas incorporações capturam as relações semânticas entre as palavras, representando-as em um espaço vetorial contínuo, onde palavras parecidas ficam mais próximas. A importância de incorporar camadas em LLMs inclui:

- Redução da dimensionalidade: Eles diminuem a dimensão dos dados de entrada, tornando-os mais fáceis de processar pelo modelo.

- Compreensão semântica: As incorporações capturam significados semânticos e relações sutis entre as palavras, melhorando a capacidade do modelo de entender e gerar textos parecidos com os humanos.

- Aprendizado por transferência: As incorporações pré-treinadas podem ser usadas em diferentes modelos e tarefas, oferecendo uma base sólida de compreensão da linguagem que pode ser ajustada para aplicações específicas.

Como funcionam as codificações posicionais LLM modernas e por que as incorporações de posição rotativa (RoPE) se tornaram padrão?

As codificações posicionais dizem aos transformadores onde cada token está localizado na sequência.

Codificações posicionais sinusoidais tradicionais (de Vaswani et al. 2017) usaram funções matemáticas fixas para codificar posições de forma estática. Os Rotary Position Embeddings (RoPE), que surgiram mais recentemente, viraram o padrão nos LLMs modernos porque têm propriedades bem melhores.

O RoPE funciona representando posições como ângulos de rotação em um espaço vetorial complexo, girando as incorporações de tokens por um ângulo proporcional à sua posição. Essa abordagem geométrica é mais eficiente e naturalmente suporta a interpolação para sequências mais longas do que as vistas durante o treinamento, o que é uma capacidade crítica para estender as janelas de contexto. Modelos como GPT-5.2 e Gemini 3 usam RoPE como sua codificação posicional.

Perguntas para entrevistas de mestrado em Direito (LLM) de nível intermediário

Com base nos conceitos básicos, as perguntas de nível intermediário exploram as técnicas práticas usadas para otimizar o desempenho do LLM e lidar com os desafios relacionados à eficiência computacional e à interpretabilidade do modelo.

Explique o conceito de atenção em LLMs e como ele é implementado.

O conceito de atenção em LLMs é um jeito que permite que o modelo se concentre em diferentes partes da sequência de entrada ao fazer previsões. Ele atribui pesos dinamicamente a outros tokens na entrada, destacando os mais relevantes para a tarefa atual.

Isso é feito usando autoatenção, onde o modelo calcula pontuações de atenção para cada token em relação a todos os outros tokens na sequência, permitindo capturar dependências independentemente da distância entre elas.

O mecanismo de autoatenção é um componente essencial da arquitetura Transformer, que permite processar informações de forma eficiente e capturar relações de longo alcance.

Qual é o papel da tokenização no processamento de LLM?

Tokenização é quando a gente transforma um texto bruto em partes menores chamadas tokens, que podem ser palavras, partes de palavras ou caracteres.

O papel da tokenização no processamento de LLM é super importante, porque transforma o texto num formato que o modelo consegue entender e processar.

A tokenização eficaz garante que o modelo possa lidar com uma gama diversificada de entradas, incluindo palavras raras e diferentes idiomas, dividindo-as em partes gerenciáveis. Essa etapa é importante para um treinamento e uma inferência legais, porque padroniza a entrada e ajuda o modelo a aprender padrões significativos nos dados.

Como você mede o desempenho de um LLM?

Pesquisadores e profissionais desenvolveram várias métricas de avaliação para medir o desempenho de um LLM. As métricas clássicas incluem:

- Perplexidade: Mede o quão bem o modelo prevê uma amostra, geralmente usado em tarefas de modelagem de linguagem.

- Precisão: Usado em tarefas como classificação de texto para medir a proporção de previsões corretas.

- Pontuação F1: Uma média harmônica de precisão e recuperação, usada para tarefas como reconhecimento de entidades nomeadas.

- Pontuação BLEU (Avaliação Bilíngue Substituta): Mede a qualidade do texto gerado por máquina em relação às traduções de referência, comumente usadas na tradução automática.

- ROUGE (Recall-Oriented Understudy for Gisting Evaluation): Um conjunto de métricas que avaliam a sobreposição entre o texto gerado e o texto de referência, frequentemente usado em tarefas de resumo. Eles ajudam a ver se o modelo tá funcionando e a pensar em melhorias.

Além das métricas tradicionais, os profissionais agora usam referências padronizadas para diferentes fins, como MMLU (teste de conhecimento de 57 tarefas), MMMU-Pro (raciocínio multimodal) e HumanEval (geração de código). Além disso, tabelas de classificação como a LMArena classificam os LLMs de acordo com a preferência humana. Para sistemas implantados, medir as taxas reais de alucinação, latência e eficiência de tokens tornou-se essencial.

Quais são algumas técnicas para controlar a saída de um LLM?

Várias técnicas podem ser usadas para controlar a saída de um LLM, incluindo:

- Temperatura: Ajustar esse parâmetro durante a amostragem controla a aleatoriedade da saída. Temperaturas mais baixas geram resultados mais previsíveis, enquanto valores mais altos trazem resultados mais variados.

- Amostragem Top-K: Limita o conjunto de amostras aos K tokens mais prováveis, diminuindo a chance de gerar textos menos relevantes ou sem sentido.

- Amostragem Top-P (núcleo): Escolhe tokens do menor conjunto cuja probabilidade acumulada ultrapassa um limite P, equilibrando diversidade e coerência.

- Engenharia rápida: Criar prompts específicos para orientar o modelo na geração dos resultados desejados, fornecendo contexto ou exemplos.

- Fichas de controle: Usar tokens especiais pra sinalizar pro modelo gerar texto num estilo, formato ou tipo de conteúdo específico.

Quais são algumas maneiras de diminuir o custo computacional dos LLMs?

Para reduzir o custo computacional dos LLMs, podemos usar:

- Poda do modelo: Tirando pesos ou neurônios menos importantes do modelo pra diminuir o tamanho e os requisitos de computação.

- Quantização: Converter os pesos do modelo de uma precisão mais alta (por exemplo, ponto flutuante de 32 bits) para uma precisão mais baixa (por exemplo, inteiro de 8 bits) reduz o uso de memória e acelera a inferência.

- Destilação: Treinar um modelo menor (aluno) para imitar o comportamento de um modelo maior e pré-treinado (professor) para conseguir um desempenho parecido com menos recursos.

- Pouca atenção: Usar técnicas como transformadores esparsos para limitar o mecanismo de atenção a um subconjunto de tokens reduz a carga computacional.

- Arquiteturas eficientes: Desenvolver e usar arquiteturas de modelo eficientes, feitas especialmente para minimizar as demandas computacionais e, ao mesmo tempo, manter o desempenho, como o Reformer ou o Longformer.

Qual é a importância da interpretabilidade do modelo em LLMs e como ela pode ser alcançada?

A interpretabilidade do modelo é essencial para entender como um LLM toma decisões, o que é importante para construir confiança, garantir a responsabilidade e identificar e mitigar preconceitos. Alcançar a interpretabilidade pode envolver diferentes abordagens, tais como:

- Visualização da atenção: Analisando os pesos de atenção para ver em quais partes da entrada o modelo se concentra.

- Mapas de saliência: Destacando os recursos de entrada que têm maior influência na saída do modelo.

- Métodos independentes do modelo: Usando técnicas como LIME (Explicações Interpretáveis Locais Independentes do Modelo) para explicar previsões individuais.

- Propagação de relevância por camadas: Dividindo as previsões do modelo em contribuições de cada camada ou neurônio.

Como os LLMs lidam com dependências de longo prazo no texto?

Os LLMs lidam com dependências de longo prazo no texto por meio de sua arquitetura, principalmente o mecanismo de autoatenção, que permite que eles considerem todos os tokens na sequência de entrada ao mesmo tempo. Essa capacidade de prestar atenção a tokens distantes ajuda os LLMs a capturar relações e dependências em contextos longos.

Além disso, modelos avançados como o Transformer-XL e o Longformer foram criados especialmente para ampliar a janela de contexto e lidar com sequências mais longas de forma mais eficiente, garantindo um melhor tratamento das dependências de longo prazo.

Os modelos de produção modernos usam estratégias mais avançadas para lidar com dependências de longo prazo e combater a degradação do desempenho com janelas de contexto em expansão, tais como:

- Incorporação de posição rotativa (RoPE) para uma melhor extrapolação do comprimento e codificação de posição superior.

- Padrões de atenção otimizados para sequências longas, incluindo variantes de atenção agrupada e multi-head.

- Integração cuidadosa do conhecimento por meio do RAG, em vez de depender só da capacidade da janela de contexto.

O que é a Geração Aumentada por Recuperação (RAG) e como ela evoluiu?

O RAG junta mecanismos de recuperação com modelos generativos para pegar informações relevantes de fontes externas durante a geração de texto. Essa abordagem resolve diretamente duas limitações importantes do LLM: alucinação e atualização do conhecimento. O RAG tradicional usa pipelines de recuperação e geração relativamente simples, mas, na sua evolução para o “RAG 2.0”, ficou bem mais sofisticado.

As principais características do RAG 2.0 incluem:

- Recuperação recursiva: Os modelos analisam as lacunas nas informações recuperadas e fazem buscas secundárias ou terciárias de forma proativa para preencher as lacunas de conhecimento, em vez de depender de uma única recuperação.

- Multimodal retrieval: Integração entre vários formatos — texto, imagens, PDFs, vídeos e até chamadas de API — permitindo uma coleta de contexto mais rica

- Indexação híbrida: Pesquisa combinada BM25 (baseada em palavras-chave) e vetorial (semântica) para capturar tanto a relevância lexical quanto a semântica.

- Reordenando as camadas: Filtragem inteligente dos resultados iniciais da pesquisa para reduzir ruídos e informações irrelevantes

- Adaptação agênica: Seleção dinâmica de estratégia, em que o sistema escolhe abordagens de recuperação com base na complexidade da consulta e no domínio.

O RAG 2.0, junto com os LLMs, reduz bem as taxas de alucinação em 40-60% nos sistemas de produção, comparado com os modelos básicos.

Perguntas avançadas para entrevistas de mestrado em Direito

Entender conceitos avançados em LLMs é útil para profissionais que querem ir além do que esses modelos podem fazer. Essa seção fala sobre assuntos complexos e desafios comuns que a gente enfrenta na área.

Explique o conceito de “aprendizado com poucos exemplos” em LLMs e suas vantagens.

Aprendizado com poucos exemplos em LLMs é quando o modelo consegue aprender e fazer novas tarefas usando só alguns exemplos. Essa capacidade aproveita o amplo conhecimento pré-treinado do LLM, permitindo que ele generalize a partir de um pequeno número de instâncias.

As principais vantagens do aprendizado com poucos exemplos incluem requisitos de dados reduzidos, já que a necessidade de grandes conjuntos de dados específicos para tarefas é minimizada, maior flexibilidade, permitindo que o modelo se adapte a várias tarefas com um mínimo de ajustes, e eficiência de custos, já que requisitos de dados mais baixos e tempos de treinamento reduzidos se traduzem em economias significativas na coleta de dados e recursos computacionais.

Quais são as diferenças entre modelos de linguagem autorregressivos e mascarados?

Os modelos autorregressivos e os modelos de linguagem mascarados diferem principalmente na sua abordagem de previsão e adequação à tarefa. Modelos autoregressivos, como GPT-5.2, Claude 4.5 Opus e Gemini 3, preveem a próxima palavra em uma sequência com base nas palavras anteriores, gerando texto um token de cada vez.

Esses modelos são especialmente bons para tarefas de geração de texto. Por outro lado, modelos de linguagem mascarados, como o BERT, mascaram aleatoriamente palavras em uma frase e treinam o modelo para prever essas palavras mascaradas com base no contexto ao redor. Essa abordagem bidirecional ajuda o modelo a entender o contexto das duas maneiras, o que é ótimo para classificar textos e responder perguntas.

Como você pode incluir conhecimento externo em um LLM?

Incorporar conhecimento externo em um LLM pode ser feito de várias maneiras:

- Integração do gráfico de conhecimento: Aumentando a entrada do modelo com informações de gráficos de conhecimento estruturados para fornecer informações contextuais.

- Geração Aumentada por Recuperação (RAG): Combina métodos de recuperação com modelos generativos para buscar informações relevantes de fontes externas durante a geração de texto. Os sistemas RAG 2.0 modernos usam recuperação recursiva, indexação híbrida e reclassificação para uma integração de conhecimento superior em comparação com abordagens de recuperação simples.

- Ajustes finos com dados específicos do domínio: Treinar o modelo em conjuntos de dados adicionais que têm o conhecimento necessário para especializá-lo em tarefas ou domínios específicos.

- Engenharia rápida: Criar prompts que orientem o modelo a usar o conhecimento externo de forma eficaz durante a inferência.

Quais são alguns dos desafios associados à implantação de LLMs em produção?

Implantar LLMs na produção tem vários desafios:

- Escalabilidade: Garantir que o modelo consiga lidar com um monte de solicitações de forma eficiente geralmente precisa de muitos recursos computacionais e uma infraestrutura otimizada.

- Latência: Minimizar o tempo de resposta para fornecer resultados em tempo real ou quase real é fundamental para aplicações como chatbots e assistentes virtuais.

- Monitoramento e manutenção: Monitorar o desempenho do modelo o tempo todo e atualizá-lo para lidar com dados e tarefas em constante mudança exige sistemas de monitoramento robustos e atualizações regulares.

- Considerações éticas e legais: É essencial resolver questões relacionadas a preconceitos, privacidade e conformidade com regulamentos para evitar problemas éticos e repercussões legais.

- Gestão de recursos: Gerenciar os recursos computacionais necessários para a inferência garante a relação custo-benefício e envolve a otimização das configurações de hardware e software.

Como você lida com a degradação do modelo ao longo do tempo em LLMs implantados?

A degradação do modelo acontece quando o desempenho de um LLM cai com o tempo por causa de mudanças na distribuição dos dados de base. Lidar com a degradação do modelo envolve retreinamento regular com dados atualizados para manter o desempenho. É preciso ficar de olho no desempenho do modelo e ver se tem algum sinal de problema.

As técnicas de aprendizagem incremental permitem que o modelo aprenda com novos dados sem esquecer as informações aprendidas anteriormente. Além disso, o teste A/B compara o desempenho do modelo atual com as novas versões e ajuda a identificar possíveis melhorias antes da implantação completa.

Quais são algumas técnicas para garantir o uso ético dos LLMs?

Para garantir o uso ético dos LLMs, várias técnicas podem ser implementadas:

- Redução do viés: Usar estratégias para identificar e reduzir vieses nos dados de treinamento e nos resultados dos modelos, como usar conjuntos de dados equilibrados e ferramentas de detecção de vieses.

- Transparência e explicabilidade: Desenvolver modelos que ofereçam resultados interpretáveis e explicáveis para promover a confiança e a responsabilidade, incluindo o uso de visualização de atenção e mapas de saliência.

- Consentimento do usuário e privacidade: Garantir que os dados usados para treinamento e inferência estejam de acordo com as regras de privacidade e conseguir o consentimento do usuário quando for preciso.

- Auditorias de equidade: Faça auditorias regulares para ver se o comportamento do modelo é justo e se não tem problemas éticos.

- Implantação responsável: Definindo diretrizes e políticas para implantação responsável da IA, incluindo o tratamento de conteúdo prejudicial ou inadequado gerado pelo modelo.

Como você pode garantir a segurança dos dados usados com LLMs?

Proteger os dados usados com LLMs exige várias medidas. Isso inclui usar técnicas de criptografia para dados em repouso e em trânsito, pra proteger contra acesso não autorizado. É preciso ter controles de acesso bem rígidos pra garantir que só quem tem autorização possa acessar dados confidenciais.

Tornar os dados anônimos pra tirar informações pessoais identificáveis (PII) antes de usá-los pra treinamento ou inferência também é super importante. Além disso, seguir as regras de proteção de dados, como o GDPR ou o CCPA, é essencial pra evitar problemas legais.

Essas medidas ajudam a proteger a integridade, a confidencialidade e a disponibilidade dos dados. Essa proteção é essencial para manter a confiança dos usuários e seguir as normas regulatórias.

Como o aprendizado por reforço a partir do feedback humano (RLHF) melhora a qualidade e a segurança da saída do LLM, e como ele se compara a métodos de alinhamento mais recentes, como DPO e RLAIF?

RLHF ( ) é uma técnica que envolve treinar um LLM para alinhar seus resultados com as preferências humanas, usando o feedback de avaliadores humanos. Esse processo iterativo ajuda o modelo a aprender a gerar respostas que não são só precisas, mas também seguras, imparciais e úteis.

Mas, o RLHF também tem seus desafios. Um desafio é a possibilidade de parcialidade no feedback humano, já que diferentes avaliadores podem ter preferências e interpretações diferentes.

Outro desafio é a escalabilidade do processo de feedback, já que coletar e incorporar grandes quantidades de feedback humano pode ser demorado e caro. Além disso, garantir que o modelo de recompensa usado na RLHF capte com precisão os comportamentos e valores desejados pode ser complicado. A etapa de otimização PPO (Proximal Policy Optimization) adiciona complexidade e pode causar instabilidade durante o treinamento.

Surgiram alternativas modernas que resolvem muitas das limitações do RLHF:

- DPO (Otimização Direta de Preferências): Acaba com o modelo de recompensa separado, usando sinais de recompensa implícitos que vêm direto dos pares de preferências. Essa abordagem é mais simples, mais estável e computacionalmente eficiente do que o RLHF baseado em PPO. O DPO agora é bem usado pelos principais laboratórios de IA como uma alternativa ou complemento ao RLHF tradicional.

- GRPO (Otimização da Política de Recompensa Baseada em Gradiente): Uma variante que junta as vantagens da simplicidade do DPO com aspectos do aprendizado do tipo PPO, oferecendo um meio-termo.

- RLAIF (Aprendizado por Reforço a partir do Feedback da IA): Troca os avaliadores humanos por feedback de IA (como classificações de modelos mais fortes ou avaliadores especializados). Essa abordagem reduz bastante os desafios e custos de escalabilidade, já que gerar feedback de IA é mais barato e rápido do que coletar feedback humano.

A maioria dos modelos de produção usa DPO, RLAIF ou combinações híbridas em vez de RLHF baseado exclusivamente em PPO.

Compare modelos de espaço de estado (como Mamba) com Transformers. Quais são as vantagens e desvantagens, e quando você usaria cada uma delas?

As alucinações baseadas no conhecimento acontecem quando o modelo não tem os fatos certos (ou tem fatos desatualizados), então inventa informações que parecem plausíveis. As correções geralmente envolvem:

- Fundamentando o modelo com recuperação (RAG)

- Adicionando fontes verificadas

- Ajuste específico para cada domínio

As alucinações baseadas na lógica acontecem quando o modelo tem informações relevantes, mas raciocina de forma errada ou cria inconsistências. As correções mais comuns são:

- Sugestões estruturadas

- Etapas de verificação/autoverificação (geralmente por meio de fluxos de trabalho de agentes)

- Avaliação direcionada

Qual é a diferença entre alucinações baseadas em conhecimento e alucinações baseadas em lógica em LLMs, e como você lida com cada uma delas?

Embora os Transformers dominem os LLMs hoje em dia, modelos de espaço de estado (SSMs), como o Mamba, surgiram como um paradigma arquitetônico competitivo com propriedades computacionais e de desempenho fundamentalmente diferentes. Entender os dois é cada vez mais importante para os profissionais modernos de LLM.

Transformers:

- Pontos fortes: Ótimo pra pegar informações, copiar/colar e aprender no contexto. Arquitetura comprovada em escala com ferramentas e infraestrutura abrangentes. Ótimo desempenho empírico na geração de código e em vários benchmarks.

- Pontos fracos: A complexidade da atenção O(N²) cria requisitos quadráticos de memória e computação. Isso aparece como uma queda no desempenho em sequências bem longas (>100 mil tokens) e alta latência para aplicativos de contexto longo.

- Casos de uso e recomendações: A maioria dos LLMs de produção hoje em dia (GPT, Claude, Gemini, Llama). Recomendado para aplicações atuais no mundo real e no futuro próximo.

Modelos de espaço de estado (Mamba, Mamba-2):

- Pontos fortes: Complexidade O(N) com escalonamento linear da memória. Inferência 5 a 10 vezes mais rápida em sequências longas (>50 mil tokens). Melhores fundamentos teóricos para o processamento de sinais. Comportamento de escalonamento mais previsível.

- Pontos fracos: Precisa de 10 vezes mais dados de treinamento do que os Transformers pra ter um desempenho parecido. Mais fraco em tarefas de recuperação e cópia de informações. Um ecossistema menos maduro, com menos ferramentas, bibliotecas e modelos treinados.

- Casos de uso e recomendações: Aparecendo para aplicações especializadas — processamento de documentos longos, sistemas em tempo real com restrições de latência, aplicações de streaming e domínios potencialmente especializados onde o escalonamento O(N) é essencial.

Pesquisas recentes mostram que Transformers e SSMs são mais complementares do que concorrentes diretos, com diferentes casos de uso e restrições que favorecem diferentes arquiteturas. Os transformadores continuam sendo a escolha prática para LLMs de uso geral e provavelmente continuarão dominando por enquanto. É provável que tenhamos um futuro híbrido, com modelos especializados para diferentes requisitos computacionais e tarefas.

Perguntas da entrevista LLM para engenheiros de prompt

A engenharia de prompts é um aspecto importante da utilização de LLMs. Isso envolve criar prompts precisos e eficazes para gerar as respostas desejadas do modelo. Essa seção fala sobre as principais questões que os engenheiros podem encontrar.

O que é engenharia de prompt e por que ela é tão importante pra trabalhar com LLMs?

A engenharia de prompts envolve projetar e refinar prompts para orientar os LLMs na geração de resultados precisos e relevantes. Isso é super importante pra trabalhar com LLMs, porque a qualidade do prompt afeta diretamente o desempenho do modelo.

Sugestões eficazes podem melhorar a capacidade do modelo de entender a tarefa, gerar respostas precisas e relevantes e reduzir a probabilidade de erros.

A engenharia de prompts é essencial para maximizar a utilidade dos LLMs em várias aplicações, desde a geração de texto até tarefas complexas de resolução de problemas.

Você pode dar exemplos de diferentes técnicas de prompt (zero-shot, few-shot, chain-of-thought) e explicar quando usá-las?

- Prompting zero-shot: Dá ao modelo uma descrição da tarefa sem nenhum exemplo. Normalmente usado quando não há exemplos disponíveis ou quando queremos testar a compreensão geral e a flexibilidade do modelo.

- Sugestão de poucos tiros: Fornece alguns exemplos junto com a descrição da tarefa para orientar o modelo. Isso é útil quando o modelo precisa de contexto ou exemplos para entender melhor a tarefa.

- Prompting da cadeia de pensamentos: Divide uma tarefa complexa em etapas menores e sequenciais que o modelo pode seguir. Isso pode ser útil para tarefas que exigem raciocínio lógico e resolução de problemas em várias etapas.

- Sugestão de agente: A estrutura faz com que os modelos funcionem como agentes autônomos que chamam ferramentas/APIs, juntam informações e raciocinam em várias etapas. As instruções incluem definições de espaço de ação, descrições de ferramentas e requisitos de raciocínio explícito.

Como você avalia a eficácia de um prompt?

Avaliar a eficácia de um aviso envolve:

- Qualidade da saída: Avaliar a relevância, coerência e precisão das respostas do modelo.

- Consistência: Verificar se o modelo produz resultados de alta qualidade de forma consistente em diferentes entradas.

- Métricas específicas para cada tarefa: Usar métricas de avaliação específicas para cada tarefa, como BLEU para tradução ou ROUGE para resumo, para medir o desempenho.

- Avaliação humana: Envolver revisores humanos para fornecer feedback qualitativo sobre os resultados do modelo.

- Teste A/B: Comparando diferentes prompts para ver qual deles funciona melhor.

Quais são algumas estratégias para evitar erros comuns no design de perguntas (por exemplo, perguntas tendenciosas, instruções confusas)?

- Evite perguntas tendenciosas: Certifique-se de que as perguntas não sugiram uma resposta específica, o que pode influenciar a resposta do modelo.

- Instruções claras e diretas: Dê instruções claras e diretas pra evitar confusão.

- Fornecimento de contexto: Inclua o contexto relevante para ajudar o modelo a entender a tarefa sem sobrecarregá-lo com informações desnecessárias.

- Testes iterativos: Teste e refine continuamente as sugestões com base nos resultados e no desempenho do modelo.

Como você faz o refinamento iterativo de prompts para melhorar o desempenho do LLM?

O refinamento iterativo do prompt envolve:

- Projeto inicial: Comece com uma solicitação básica com base nos requisitos da tarefa.

- Testes e avaliação: Avalie o desempenho do prompt usando várias métricas e receba feedback.

- Análise: Identifique os pontos fracos ou áreas que precisam melhorar na solicitação.

- Refinamento: Faça ajustes na solicitação para resolver os problemas identificados.

- Repita: Repita o processo de teste e aperfeiçoamento até conseguir o desempenho que você quer.

Que ferramentas ou estruturas você usa pra otimizar o processo de engenharia de prompts?

Várias ferramentas e estruturas podem simplificar o processo de engenharia de prompts:

- Plataformas específicas para LLM: LangChain e LlamaIndex para encadeamento rápido e construção de sistemas agenticos; Vercel AI SDK para prototipagem e implantação rápidas.

- Testes e otimização rápidos: PromptFoo (teste automatizado de prompts em vários cenários), DSPy (otimização programática de prompts), Haystack (construção de pipeline RAG).

- Ambientes de desenvolvimento interativos (IDEs): Jupyter Notebook para experimentação, VS Code com extensões LLM (GitHub Copilot, Cursor), Streamlit para criar protótipos de interface do usuário interativos.

- APIs e SDKs: API OpenAI, SDK Anthropic, Together AI e LM Studio para implantação de modelos locais.

- Controle de versão e colaboração: Controle de versão baseado em Git, Weights & Biases para acompanhar e comparar experimentos, HuggingFace Hub para compartilhar modelos e prompts.

- Estruturas agênicas: AutoGPT, API OpenAI Assistants, LangGraph para criar fluxos de trabalho complexos com várias etapas.

- Avaliação e monitoramento: Ragas (métricas de avaliação RAG), LangSmith (rastreamento, depuração e monitoramento de produção), Braintrust (observabilidade LLM de ponta a ponta).

Como você lida com desafios como alucinações ou preconceitos nas saídas do LLM por meio da engenharia de prompts?

Essa questão aborda os problemas éticos e práticos do conteúdo gerado pelo LLM. Uma resposta forte mostraria que você tá ligado nesses problemas e falaria sobre técnicas como as que vêm a seguir.

Técnicas para diminuir as alucinações:

- Solicitações de verificação de fatos: Inclua instruções que incentivem o modelo a verificar suas informações com fontes confiáveis e citar evidências explicitamente.

- Integração de recuperação: Use os sistemas RAG ou RAG 2.0 para basear as respostas em documentos reais, reduzindo fatos inventados ao exigir que o modelo faça referência às informações recuperadas.

- Loops de verificação agênica: A estrutura faz com que o modelo faça uma verificação em várias etapas, onde ele verifica seu próprio trabalho antes de responder — basicamente criando agentes de autoverificação.

- Solicitações baseadas em restrições: Defina o formato de saída e as restrições lógicas que deixam claras as inconsistências ou alegações sem fundamento.

Técnicas de redução de viés:

- Sugestões para perspectivas diferentes: Ajude o modelo a pensar em vários pontos de vista e perspectivas das partes interessadas antes de chegar a uma conclusão.

- Sugestões para detecção de preconceitos: Peça ao modelo para identificar possíveis vieses em seu próprio raciocínio e resultados.

- Sugestões contrafactuais: Peça cenários ou pontos de vista diferentes para questionar as suposições iniciais e testar a solidez do raciocínio.

- Clareza das instruções: Diga claramente que as respostas devem ser equilibradas, reconheça as limitações e evite linguagem discriminatória.

Você pode explicar o papel dos modelos de prompt e como eles são usados na engenharia de prompt?

Os modelos de prompt oferecem um formato estruturado para prompts, geralmente com espaços reservados para informações ou instruções específicas. Eles podem ser reutilizados em diferentes tarefas e cenários, melhorando a consistência e a eficiência no design de prompts.

Uma boa resposta explicaria como os modelos de prompts podem ser usados para resumir as melhores práticas, incorporar conhecimento específico do domínio e simplificar o processo de geração de prompts eficazes para várias aplicações.

Como a escolha de um tokenizador afeta a engenharia de prompts e o desempenho do modelo?

O tokenizador é super importante na forma como o LLM entende e processa o prompt de entrada. Diferentes tokenizadores têm tamanhos de vocabulário diferentes e lidam com palavras fora do vocabulário (OOV) de maneiras diferentes. Um tokenizador de subpalavras como o Byte Pair Encoding (BPE) consegue lidar com palavras OOV (Out Of Vocabulary, fora do vocabulário) dividindo-as em unidades menores de subpalavras, enquanto um tokenizador baseado em palavras pode tratá-las como tokens desconhecidos.

A escolha do tokenizador pode afetar o desempenho do modelo de várias maneiras. Por exemplo, um tokenizador de subpalavras pode ser mais eficaz para capturar o significado de termos raros ou técnicos, enquanto um tokenizador baseado em palavras pode ser mais simples e rápido para tarefas linguísticas de uso geral.

Na engenharia de prompts, a escolha do tokenizador pode influenciar a forma como você estrutura seus prompts. Por exemplo, se você estiver usando um tokenizador de subpalavras, talvez precise prestar mais atenção em como as palavras são divididas em subpalavras para garantir que o modelo capte o significado pretendido.

O que é o prompting agênico e como ele difere da engenharia de prompts tradicional?

O prompt agênico é uma abordagem de design de prompt em que o modelo é instruído a agir como um “agente” que pode planejar, tomar medidas (por exemplo, chamar ferramentas/APIs ou recuperar documentos), observar os resultados e iterar até completar um objetivo.

Diferente da engenharia de prompts tradicional, que tenta principalmente obter a melhor resposta possível de uma só vez por meio de instruções claras, exemplos e restrições de formatação, o prompting agênico enfatiza um ciclo de controle em várias etapas (planejar → agir → observar → refinar).

É especialmente útil para tarefas em que a correção depende da interação com sistemas externos (bancos de dados, pesquisa, execução de código) ou da verificação de resultados intermediários, em vez de depender apenas do conhecimento interno do modelo.

Boas instruções de agente geralmente definem o objetivo, as ferramentas/ações disponíveis, como decidir qual ação tomar e quando parar. Também é comum adicionar etapas de verificação explícitas (por exemplo, “verificar fontes recuperadas” ou “recalcular antes da resposta final”) para reduzir alucinações e melhorar a confiabilidade.

Obtenha uma das melhores certificações de IA

Conclusão

Este guia forneceu um conjunto de perguntas para entrevistas para ajudá-lo a se preparar para discussões sobre LLMs, desde princípios básicos até estratégias avançadas.

Se você está se preparando para uma entrevista ou quer entender melhor o assunto, essas dicas vão te dar o conhecimento necessário para se dar bem e se destacar na área de inteligência artificial.

Se você quiser ler sobre as últimas novidades em IA e LLMs, recomendo estes tópicos: